تحت القانون: تشريح المخاطر الأساسية للذكاء الاصطناعي وتدابيرها المضادة

نشرت: 2023-09-25تغوص المؤسسات بسرعة في عالم الذكاء الاصطناعي لتعزيز عملياتها واكتساب ميزة تنافسية. ومع ذلك، من المهم أن نفهم أن رحلة الذكاء الاصطناعي الخاصة بهم لن تكون دائمًا مشرقة وقوس قزح، وقد تكون مصحوبة ببعض المخاطر والتحديات. مع تطور تكنولوجيا الذكاء الاصطناعي بسرعة غير مسبوقة، يجب أن تكون المؤسسات مستعدة للتكيف عالميًا. ومن أجل تحقيق النجاح في هذا النظام البيئي الرقمي المتشدد، من الضروري فهم المخاطر المحتملة وتبني أفضل الممارسات للتنقل في الكون المتعدد للذكاء الاصطناعي.

مع استمرار تقدم الذكاء الاصطناعي، هناك قلق متزايد بشأن مخاطره المحتملة. حذر جيفري هينتون، "الأب الروحي للذكاء الاصطناعي"، المعروف بعمله الجدير بالثناء في مجال التعلم الآلي والشبكات العصبية، من أن أنظمة الذكاء الاصطناعي تتقدم بوتيرة غير مسبوقة وقد تشكل خطر السيطرة، إذا لم يتم التعامل معها بإشراف مناسب. وأكد كذلك على الحاجة الماسة لمعالجة هذه القضايا ذات الصلة بشكل استباقي.

وفي حالة أخرى، دعا إيلون ماسك أيضًا إلى التوقف مؤقتًا عن تجارب الذكاء الاصطناعي واسعة النطاق. تعكس هذه المخاوف التي أبداها قادة العالم بشأن المخاطر المحتملة للذكاء الاصطناعي أن مجتمع التكنولوجيا يحتاج إلى النظر بعناية في الآثار المترتبة والتحديات الأخلاقية التي قد تنشأ مع التقدم في قدرات الذكاء الاصطناعي.

الآن، مع تقدم العالم، يميل الذكاء الاصطناعي التوليدي إلى أن يصبح شائعًا على نطاق واسع. ونظرًا لأن القوى العظمى غالبًا ما تجتذب مسؤوليات غير مشروطة، فإن تنفيذ الذكاء الاصطناعي التوليدي يأتي أيضًا بدرجة من المخاطر الأخلاقية.

لذا، كصاحب عمل، فقد حان الوقت لفهم أن الذكاء الاصطناعي يمكن أن يحقق فوائد كبيرة، ولكنه يأتي أيضًا مع بعض التحديات المألوفة التي تظهر عند إدخال أي تقنية جديدة في عملياتك اليومية.

يجب على المؤسسات إعطاء الأولوية للاستخدام المسؤول من خلال ضمان الدقة والسلامة والصدق والتمكين والاستدامة. وعندما يواجهون بعض التحديات والمخاطر، يمكنهم الاعتماد على أفضل الممارسات المجربة والمختبرة التي أثبتت فعاليتها في اعتماد تقنيات أخرى بنجاح. يمكن أن تكون هذه الاستراتيجيات بمثابة أساس متين لدمج الذكاء الاصطناعي في عمليات عملك وتخفيف مخاطر الذكاء الاصطناعي على طول الطريق.

ستساعدك هذه المدونة على فهم كل ما يتعلق بمخاطر الذكاء الاصطناعي لعملك وكيفية التخفيف منها. لذلك، دون مزيد من اللغط، دعونا نتعمق في التفاصيل.

فهم مخاطر الذكاء الاصطناعي

وفقًا لـ AI RMF 1.0، إطار إدارة مخاطر الذكاء الاصطناعي، الصادر عن المعهد الوطني للمعايير والتكنولوجيا (NIST)، تشمل مخاطر الذكاء الاصطناعي الضرر المحتمل للأفراد أو المنظمات أو الأنظمة الناشئة عن تطوير ونشر أنظمة الذكاء الاصطناعي. يمكن أن تنجم هذه المخاطر عن عوامل مختلفة، بما في ذلك البيانات المستخدمة لتدريب الذكاء الاصطناعي، وخوارزمية الذكاء الاصطناعي، واستخدامها لأغراض متعددة، والتفاعلات مع الأشخاص. تختلف أمثلة مخاطر الذكاء الاصطناعي وضوابطه من أدوات التوظيف المتحيزة إلى الخوارزميات التي تسبب انهيارات في السوق.

تعد المراقبة الاستباقية للمنتجات والخدمات القائمة على الذكاء الاصطناعي أمرًا بالغ الأهمية لضمان سلامة وأمن البيانات والأفراد. وبالتالي، تؤمن المنظمة بأهمية استخدام حل لإدارة المخاطر يمكن أن يساعد في فرز هذه المخاطر والتحقق منها والتخفيف من حدتها بشكل فعال.

تحديد مخاطر وتحديات الذكاء الاصطناعي للشركات

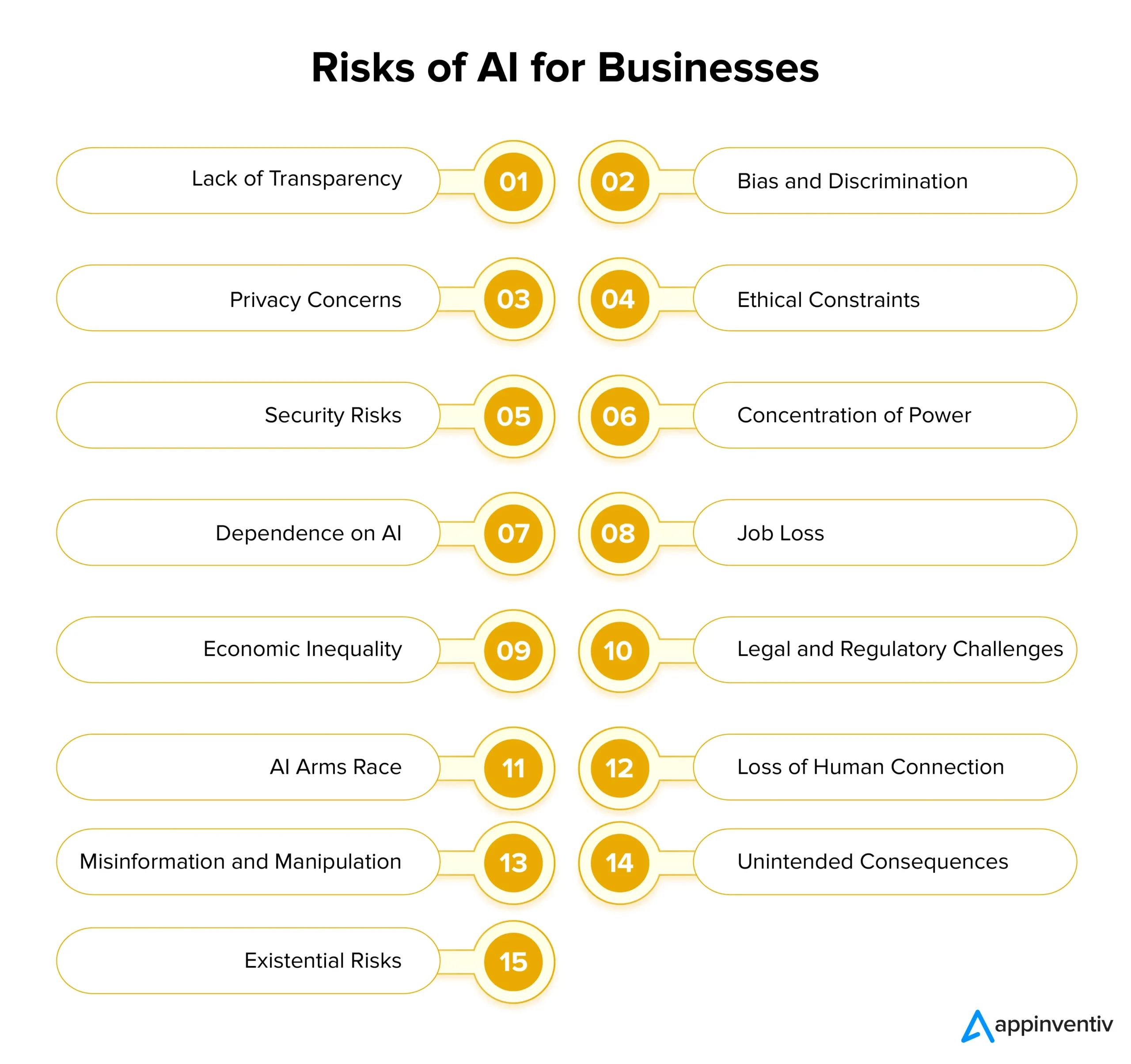

يوفر الذكاء الاصطناعي إمكانات هائلة للشركات ولكنه يجلب أيضًا مخاطر كبيرة عند تنفيذه. ولضمان اعتماد الذكاء الاصطناعي بشكل مسؤول، من الضروري فهم هذه التحديات ومعالجتها في الوقت المناسب. دعونا نلقي نظرة على مخاطر الذكاء الاصطناعي وحلولها للشركات بالتفصيل أدناه:

انعدام الشفافية

غالبًا ما تعمل أنظمة الذكاء الاصطناعي بطريقة غير شفافة، مما يجعل من الصعب فهم كيفية اتخاذها للعديد من القرارات. يمكن أن يؤدي هذا النقص في الشفافية إلى انعدام الثقة بين المستخدمين وأصحاب المصلحة. ولمعالجة هذه المشكلة، يجب على الشركات إعطاء الأولوية للشفافية من خلال تصميم نماذج وخوارزميات الذكاء الاصطناعي التي توفر رؤى حول عمليات صنع القرار الخاصة بها.

ويمكن تسهيل ذلك ببساطة عن طريق استخدام وثائق واضحة، وتقنيات الذكاء الاصطناعي القابلة للتفسير، وأدوات لتصور النتائج المعتمدة على الذكاء الاصطناعي. من المهم أن ندرك أن الذكاء الاصطناعي الشفاف يعزز الثقة العامة بين الأطراف وقراراتهم ويساعد في الامتثال التنظيمي.

التحيز والتمييز

تتمتع أنظمة الذكاء الاصطناعي بالقدرة على الحفاظ بسهولة على التحيزات المجتمعية الموجودة في بيانات التدريب الخاصة بها. وهذا يمكن أن يؤدي إلى اتخاذ قرارات متحيزة، والتمييز، والمعاملة غير العادلة لمجموعات معينة. ولمعالجة مخاطر الذكاء الاصطناعي هذه، يجب على المؤسسات إعطاء الأولوية للاستثمار في بيانات التدريب المتنوعة والتمثيلية التي يمكنها تحليلها.

علاوة على ذلك، فإن تنفيذ خوارزميات كشف التحيز وتصحيحه وإجراء عمليات تدقيق منتظمة لنماذج الذكاء الاصطناعي يمكن أن يساعد في تحديد وإزالة التحيزات من الأنظمة الحالية. يجب أن يعطي تطوير الذكاء الاصطناعي الأخلاقي الأولوية للعدالة والحياد كمبادئ أساسية.

مخاوف الخصوصية

أحد أكبر مخاطر وتحديات الذكاء الاصطناعي هو تهديد الخصوصية. غالبًا ما يتطلب الذكاء الاصطناعي جمع وتحليل كميات هائلة من البيانات الشخصية، مما يثير مخاوف الخصوصية والأمن. يجب على الشركات إعطاء الأولوية لحماية البيانات من خلال الالتزام بأنظمة الخصوصية الصارمة، وتنفيذ تدابير قوية للأمن السيبراني، واعتماد تقنيات تشفير البيانات. يمكن أن يساعد هذا في حماية خصوصية المستخدم والحفاظ على الثقة.

القيود الأخلاقية

غالبًا ما تواجه أنظمة الذكاء الاصطناعي التي تشارك في اتخاذ القرارات الحاسمة معضلات أخلاقية قد يكون لها تأثيرات مجتمعية ضارة. يجب على المنظمات وضع مبادئ توجيهية ومبادئ أخلاقية لتطوير الذكاء الاصطناعي ونشره لمعالجة هذه المخاطر. يجب أن تكون الاعتبارات الأخلاقية أحد المكونات الأساسية لمشاريع الذكاء الاصطناعي، مما يضمن توافق الذكاء الاصطناعي مع القيم المجتمعية والأعراف الأخلاقية.

أخطار أمنية

مع تقدم تقنيات الذكاء الاصطناعي، تتزايد أيضًا المخاطر الأمنية. يمكن للأنشطة الضارة استغلال أنظمة الذكاء الاصطناعي وإنشاء هجمات إلكترونية أكثر خطورة، مما يشكل تهديدًا كبيرًا للشركات. يجب على المؤسسات تنفيذ تدابير أمنية قوية للتخفيف من المخاطر الأمنية، بما في ذلك التشفير وبروتوكولات المصادقة وأنظمة الكشف عن التهديدات المستندة إلى الذكاء الاصطناعي. تعد المراقبة المستمرة وفحوصات الثغرات الأمنية المنتظمة أمرًا بالغ الأهمية لحماية نشر أنظمة الذكاء الاصطناعي.

تركيز القوة

عندما يتحكم عدد قليل من الشركات الكبرى والحكومات في تطوير الذكاء الاصطناعي، فإن ذلك قد يجعل الأمور غير عادلة ويقلل من تنوع استخدامات الذكاء الاصطناعي. ولمنع حدوث ذلك، يجب على الشركات العمل على مشاركة تطوير الذكاء الاصطناعي على نطاق أوسع عبر مجموعات متعددة. ويمكنهم القيام بذلك من خلال دعم الشركات الناشئة الصغيرة، وتشجيع الأفكار الجديدة، ومساعدة مشاريع الذكاء الاصطناعي مفتوحة المصدر. بهذه الطريقة، يصبح الذكاء الاصطناعي في متناول الجميع.

الاعتماد على الذكاء الاصطناعي

يمكن أن يؤدي الاعتماد المفرط على أنظمة الذكاء الاصطناعي إلى فقدان الإبداع والتفكير النقدي والحدس البشري. من الضروري تحقيق التوازن بين عملية صنع القرار بمساعدة الذكاء الاصطناعي والحكم البشري. على سبيل المثال، سلط الباحثون الضوء على قضية "انهيار النموذج" حيث قد تؤدي نماذج الذكاء الاصطناعي التوليدية التي يتم تدريبها على البيانات الاصطناعية إلى نتائج أقل جودة لأنها تعطي الأولوية ببساطة لاختيار الكلمات الشائعة على البدائل الإبداعية.

يجب على الشركات تدريب موظفيها على العمل جنبًا إلى جنب مع الذكاء الاصطناعي لتجنب المخاطر المحتملة للذكاء الاصطناعي. إن تشجيع التعلم المستمر يمكن أن يساعد المؤسسات على تسخير إمكانات الذكاء الاصطناعي مع الحفاظ على المهارات البشرية في نفس الوقت. بالإضافة إلى ذلك، فإن استخدام بيانات التدريب المتنوعة وتقنيات التنظيم يمكن أن يساعد أيضًا في تخفيف هذه التحديات المرتبطة بانهيار النموذج.

فقدان الوظيفة

إن الأتمتة التي تعتمد على الذكاء الاصطناعي لديها القدرة على إزاحة الوظائف في مختلف الصناعات، مع كون العمال ذوي المهارات المنخفضة هم أهم الأهداف. يجب على المؤسسات معالجة هذا التحدي بشكل استباقي من خلال توفير الفرص للقوى العاملة لديها لتعلم تدابير جديدة والنمو مع التقدم التكنولوجي. يعد تعزيز التعلم مدى الحياة والقدرة على التكيف أمرًا ضروريًا للتخفيف من المخاوف المتعلقة بفقدان الوظائف في قطاعات متعددة.

عدم المساواة الاقتصادية

يعد عدم المساواة الاقتصادية أحد المخاطر والتحديات البارزة الأخرى التي يجب على الشركات أن تكون على دراية بها. من المحتمل أن يؤدي الذكاء الاصطناعي إلى تفاقم عدم المساواة الاقتصادية لأنه غالبا ما يفيد الأثرياء والشركات الكبرى. ولجعل الذكاء الاصطناعي أكثر عدالة، يجب على صناع السياسات والشركات التفكير في طرق لإشراك المزيد من الأشخاص في تطوير الذكاء الاصطناعي. يمكنهم القيام بذلك عن طريق إنشاء برامج تتيح لعدد أكبر من الأشخاص استخدام أدوات الذكاء الاصطناعي.

التحديات القانونية والتنظيمية

يقدم الذكاء الاصطناعي تعقيدات قانونية وتنظيمية جديدة، بما في ذلك قضايا المسؤولية وحقوق الملكية الفكرية. تحتاج الأطر القانونية إلى التطور حتى تتمكن من العمل بالتوازي مع التقدم التكنولوجي. يجب على المؤسسات أن تظل مطلعة على اللوائح المتعلقة بالذكاء الاصطناعي وأن تشارك بنشاط مع صانعي السياسات لتشكيل حوكمة وممارسات مسؤولة للذكاء الاصطناعي. يمكن للشركات استخدام الذكاء الاصطناعي لحلول المخاطر والامتثال لتحليل كميات هائلة من المعلومات والبيانات بسهولة مع تحديد المخاطر المحتملة المرتبطة بالامتثال.

[اقرأ أيضًا: كيفية تجنب انتهاكات الامتثال أثناء تطوير منتجات الذكاء الاصطناعي]

سباق التسلح بالذكاء الاصطناعي

عندما تندفع الدول إلى سباق تسلح للذكاء الاصطناعي، فقد يعني ذلك أن تكنولوجيا الذكاء الاصطناعي تتطور بسرعة كبيرة، وقد يكون ذلك خطيرًا. ولمنع مخاطر الذكاء الاصطناعي هذه، من المهم تشجيع التطوير المسؤول للذكاء الاصطناعي. يجب على الدول أن تعمل معًا وتبرم اتفاقيات حول كيفية استخدام الذكاء الاصطناعي في الدفاع. وبهذه الطريقة، يمكننا تقليل خطر تسبب الذكاء الاصطناعي في إحداث الضرر في السباق للحصول على تكنولوجيا أكثر تقدمًا مقارنة بالدول الأخرى.

فقدان الاتصال البشري

قد يؤدي الاعتماد المتزايد على التواصل والتفاعلات المعتمدة على الذكاء الاصطناعي إلى تناقص التعاطف والمهارات الاجتماعية والعلاقات الإنسانية. يجب على المؤسسات إعطاء الأولوية للتصميم الذي يركز على الإنسان، مع التركيز على أهمية الحفاظ على التفاعلات البشرية الهادفة بالإضافة إلى تكامل الذكاء الاصطناعي.

التضليل والتلاعب

يشكل المحتوى الناتج عن الذكاء الاصطناعي، مثل التزييف العميق، خطرًا كبيرًا من خلال المساهمة في نشر معلومات كاذبة والتلاعب بالرأي العام. يمكن أن يساعد تنفيذ الأدوات المعتمدة على الذكاء الاصطناعي للكشف عن المعلومات الخاطئة وحملات التوعية العامة في الحفاظ على سلامة المعلومات في هذا العصر الرقمي سريع التطور.

العواقب غير المقصودة

نظرًا لتعقيدها، قد تظهر أنظمة الذكاء الاصطناعي سلوكيات غير متوقعة أو تتخذ قرارات ذات عواقب غير متوقعة. تعد عمليات الاختبار الصارمة والتحقق من الصحة والمراقبة المستمرة ضرورية لتحديد هذه المشكلات ومعالجتها قبل أن تتصاعد وتسبب الضرر.

المخاطر الوجودية

إن إنشاء ذكاء اصطناعي عام (AGI) أكثر ذكاءً من البشر يثير مخاوف كبيرة. يجب على المؤسسات التأكد من مشاركة AGI لقيمها وأهدافها لتجنب العواقب الوخيمة. ويحتاج هذا إلى تخطيط دقيق طويل الأمد، وقواعد أخلاقية قوية، والعمل معًا على مستوى العالم للتعامل مع المخاطر الكبيرة التي تصاحب الذكاء الاصطناعي العام.

بعد النظر في التحديات والمخاطر المتعددة التي تفرضها تكنولوجيا الذكاء الاصطناعي وكيف يمكن تنفيذ إدارة معينة لمخاطر الذكاء الاصطناعي، دعونا نمضي قدمًا وننظر إلى حوكمة الذكاء الاصطناعي بالتفصيل.

حوكمة الذكاء الاصطناعي لإدارة المخاطر

تتضمن الحوكمة الفعالة للذكاء الاصطناعي تحديد مخاطر الذكاء الاصطناعي وإدارتها من خلال ثلاثة أساليب رئيسية:

المبادئ: تتضمن مبادئ توجيهية تسهل تطوير أنظمة الذكاء الاصطناعي واستخدامها. وغالبًا ما تتماشى هذه المعايير مع المعايير التشريعية والأعراف المجتمعية.

العمليات: معالجة المخاطر والأضرار المحتملة التي تنشأ عن عيوب التصميم وعدم كفاية هياكل الإدارة.

الوعي الأخلاقي: هذا النهج مدفوع بإحساس ما هو صواب وصالح. ويتضمن اتباع القواعد، والتأكد من تنفيذ الأمور بشكل صحيح، والتفكير في سمعة الفرد، والمسؤولية الاجتماعية، ومطابقة قيم المنظمة ومعتقداتها.

التخفيف من مخاطر الذكاء الاصطناعي: كيفية الحفاظ على الأمان باستخدام الذكاء الاصطناعي

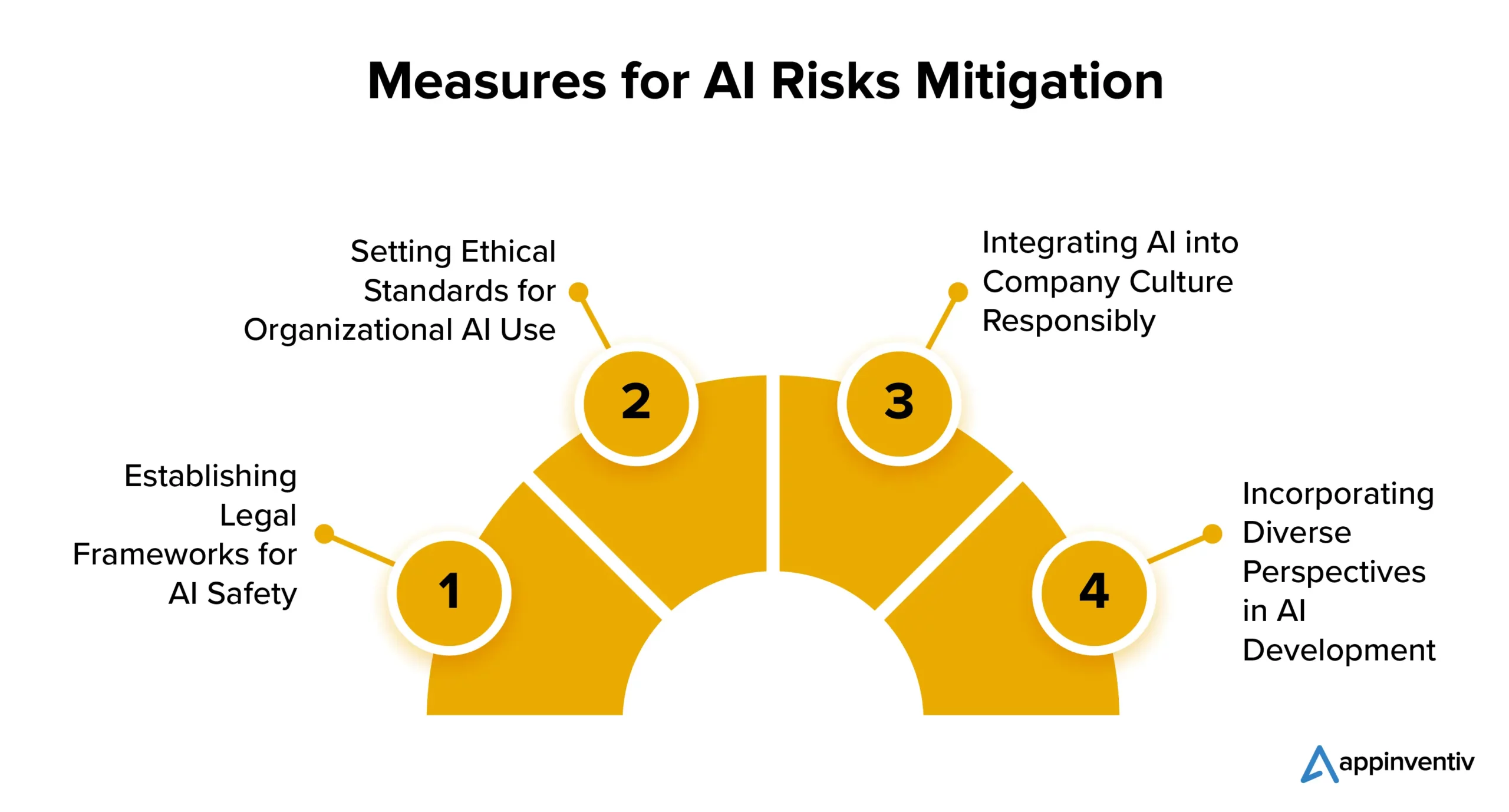

فيما يلي العديد من الاستراتيجيات التي يمكن للشركات تنفيذها من أجل التخفيف من مخاطر تنفيذ الذكاء الاصطناعي:

إنشاء أطر قانونية لسلامة الذكاء الاصطناعي

تركز العديد من البلدان على لوائح الذكاء الاصطناعي. تعمل الولايات المتحدة والاتحاد الأوروبي على مجموعة واضحة من القواعد للسيطرة على انتشار واستخدام الذكاء الاصطناعي. في حين أن بعض تقنيات الذكاء الاصطناعي قد تواجه قيودا، فلا ينبغي أن يمنع ذلك الشركات من استكشاف إمكانات الذكاء الاصطناعي لصالحها.

وضع المعايير الأخلاقية لاستخدام الذكاء الاصطناعي التنظيمي

من الضروري تحقيق التوازن بين التنظيم والابتكار. يعد الذكاء الاصطناعي أمرًا حيويًا لتحقيق التقدم، لذلك يجب على المؤسسات وضع معايير لتطوير واستخدام الذكاء الاصطناعي الأخلاقي. وينبغي أن يشمل ذلك تنفيذ خوارزميات المراقبة، واستخدام بيانات عالية الجودة، والشفافية بشأن قرارات الذكاء الاصطناعي.

دمج الذكاء الاصطناعي في ثقافة الشركة بطريقة مسؤولة

تتضمن إحدى الاستراتيجيات المرغوبة للتخفيف من مخاطر الذكاء الاصطناعي إدخال الذكاء الاصطناعي في ثقافة الشركة نفسها. يمكن للشركات دمج الذكاء الاصطناعي في ثقافتها من خلال وضع إرشادات مقبولة لتقنيات وعمليات الذكاء الاصطناعي. وهذا يضمن استخدام الذكاء الاصطناعي بشكل أخلاقي ومسؤول داخل المنظمة، وبالتالي التخفيف من مخاطر الذكاء الاصطناعي المحتملة.

دمج وجهات نظر متنوعة في تطوير الذكاء الاصطناعي

يجب على مطوري الذكاء الاصطناعي النظر في وجهات نظر متنوعة، بما في ذلك تلك التي تنتمي إلى خلفيات ومجالات مختلفة مثل القانون والفلسفة وعلم الاجتماع. يساعد هذا النهج الشامل على إنشاء ذكاء اصطناعي مسؤول يفيد الجميع.

كيف يمكن لـ Appinventiv المساعدة في ضمان أفضل الممارسات لتطوير الذكاء الاصطناعي

حتى مع استمرار ارتفاع اعتماد الذكاء الاصطناعي، فإن الإدارة الفعالة للمخاطر لا تزال متخلفة. ويكمن التحدي في أن الشركات في كثير من الأحيان لا تدرك الحاجة إلى التدخل وكذلك ممارسات تطوير الذكاء الاصطناعي المستدام.

وفقًا لتقرير صادر عن MIT Sloan Management Review وBoston Consulting Group، اعتبر 42% من المشاركين أن الذكاء الاصطناعي يمثل أولوية استراتيجية قصوى، بينما أكد 19% فقط أن مؤسساتهم قد وضعت برنامجًا مسؤولًا للذكاء الاصطناعي. وتزيد هذه الفجوة من خطر الفشل وتترك الشركات عرضة للمشكلات التنظيمية والمالية والمتعلقة بالسمعة الناجمة عن تطبيق الذكاء الاصطناعي.

في حين أن إدارة مخاطر الذكاء الاصطناعي يمكن أن تبدأ في أي مرحلة من مراحل المشروع، فمن الضروري إنشاء إطار لإدارة المخاطر عاجلاً وليس آجلاً. وهذا يمكن أن يعزز الثقة ويمكّن الشركات من التوسع بثقة.

باعتبارنا شركة متخصصة في تطوير الذكاء الاصطناعي، يتمتع فريقنا بسنوات من الخبرة في إنشاء حلول الذكاء الاصطناعي مدعومة بتركيز قوي على الأخلاق والمسؤولية. يصور سجلنا الحافل عبر مختلف مجالات الصناعة التزامنا بمواءمة حلول الذكاء الاصطناعي مع القيم الأساسية والمبادئ الأخلاقية.

نحن مجهزون جيدًا لمساعدتك في تنفيذ تدابير العدالة لضمان أن حلول الأعمال القائمة على الذكاء الاصطناعي تتخذ قرارات محايدة وغير متحيزة باستمرار.

لقد قمنا مؤخرًا بتطوير YouComm، وهو تطبيق رعاية صحية قائم على الذكاء الاصطناعي يسمح للمرضى بالتواصل مع موظفي المستشفى من خلال لفتات اليد والأوامر الصوتية فقط. ويتم الآن تنفيذ الحل عبر أكثر من 5 سلاسل مستشفيات في جميع أنحاء الولايات المتحدة.

تواصل مع خبرائنا لفهم إدارة مخاطر الذكاء الاصطناعي المرتبطة بمشروعك بشكل كامل وكيف يمكنك التخفيف منها بسهولة.

الأسئلة الشائعة

س: ما هي مخاطر الذكاء الاصطناعي؟

ج: يحمل الذكاء الاصطناعي مخاطر كامنة، بما في ذلك التحيز، ومخاوف الخصوصية، والمعضلات الأخلاقية، والتهديدات الأمنية. ويمكن أن يؤدي أيضًا إلى إزاحة الوظائف، وتفاقم عدم المساواة الاقتصادية، وفرض تحديات قانونية وتنظيمية. بالإضافة إلى ذلك، فإن التقدم في الذكاء الاصطناعي الفائق يثير مخاوف وجودية بشأن التوافق مع القيم الإنسانية. ولضمان الاستخدام المسؤول والمفيد للتكنولوجيا ولتجنب المخاطر المرتبطة بالذكاء الاصطناعي، من الضروري تنفيذ الإدارة الدقيقة والاعتبارات الأخلاقية والتدابير التنظيمية.

س: كيف يمكن استخدام الذكاء الاصطناعي للتخفيف من مخاطر الذكاء الاصطناعي؟

ج: يلعب الذكاء الاصطناعي دورًا مهمًا في التخفيف من مخاطر الذكاء الاصطناعي من خلال تسهيل اكتشاف التحيز وتصحيحه، والتحليلات التنبؤية، ومراقبة الأمن، ودعم القرار الأخلاقي، وما إلى ذلك. دعونا نلقي نظرة على كيف يمكننا المساعدة في التخفيف من مخاطر الذكاء الاصطناعي بالتفصيل:

- يمكن لخوارزميات الذكاء الاصطناعي تحديد وتصحيح التحيزات في البيانات، مما يقلل من نتائج الذكاء الاصطناعي المتحيزة.

- يمكن للتحليلات التنبؤية توقع المخاطر وتمكين التدابير الوقائية.

- يمكن لأدوات الأمن السيبراني المعتمدة على الذكاء الاصطناعي اكتشاف التهديدات القائمة على الذكاء الاصطناعي ومواجهتها.

- يمكن للذكاء الاصطناعي أن يرشدك في اتخاذ الخيارات الأخلاقية.

- يمكن أن تضمن الأتمتة الامتثال للوائح، مما يقلل من المخاطر المرتبطة بالامتثال.