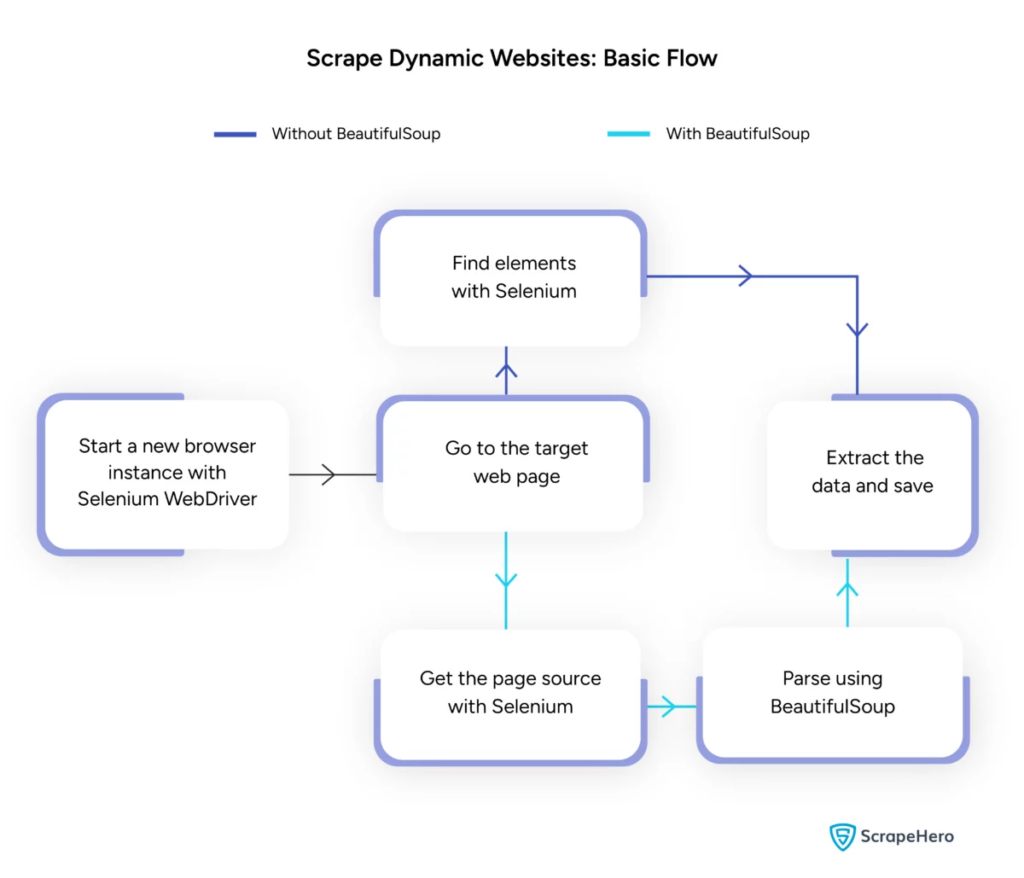

تجريف صفحة الويب الديناميكية باستخدام Python – الدليل الإرشادي

نشرت: 2024-06-08يتضمن تجريف الويب الديناميكي استرداد البيانات من مواقع الويب التي تنشئ محتوى في الوقت الفعلي من خلال JavaScript أو Python. على عكس صفحات الويب الثابتة، يتم تحميل المحتوى الديناميكي بشكل غير متزامن، مما يجعل تقنيات المسح التقليدية غير فعالة.

استخدامات تجريف الويب الديناميكية:

- المواقع المعتمدة على AJAX

- تطبيقات الصفحة الواحدة (SPA)

- المواقع التي تحتوي على عناصر متأخرة التحميل

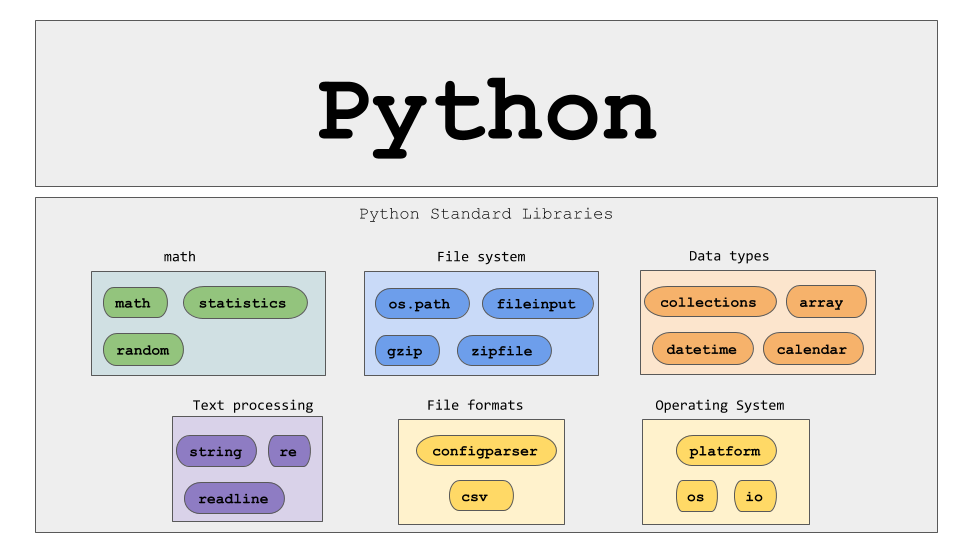

الأدوات والتقنيات الرئيسية:

- السيلينيوم – أتمتة تفاعلات المتصفح.

- BeautifulSoup – يوزع محتوى HTML.

- الطلبات – جلب محتوى صفحة الويب.

- lxml - يوزع XML وHTML.

يتطلب تجريف الويب الديناميكي بايثون فهمًا أعمق لتقنيات الويب لجمع البيانات في الوقت الفعلي بشكل فعال.

مصدر الصورة: https://www.scrapehero.com/scrape-a-dynamic-website/

إعداد بيئة بايثون

لبدء عملية تجريف الويب الديناميكية لـ Python، من الضروري إعداد البيئة بشكل صحيح. اتبع الخطوات التالية:

- تثبيت Python : تأكد من تثبيت Python على الجهاز. يمكن تنزيل أحدث إصدار من موقع بايثون الرسمي.

- إنشاء بيئة افتراضية :

تفعيل البيئة الافتراضية:

- تثبيت المكتبات المطلوبة :

- إعداد محرر الأكواد : استخدم IDE مثل PyCharm أو VSCode أو Jupyter Notebook لكتابة البرامج النصية وتشغيلها.

- التعرف على HTML/CSS : يساعد فهم بنية صفحة الويب في التنقل واستخراج البيانات بشكل فعال.

تنشئ هذه الخطوات أساسًا متينًا لمشاريع بايثون لتجريد الويب الديناميكي.

فهم أساسيات طلبات HTTP

مصدر الصورة: https://developer.mozilla.org/en-US/docs/Web/HTTP/Overview

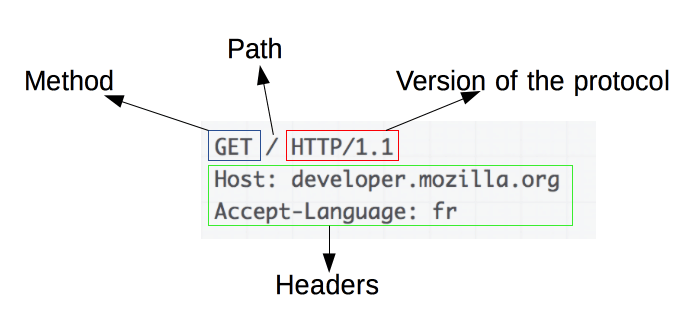

طلبات HTTP هي أساس تجريف الويب. عندما يريد عميل، مثل متصفح الويب أو أداة استخراج الويب، استرداد معلومات من خادم، فإنه يرسل طلب HTTP. تتبع هذه الطلبات بنية محددة:

- الطريقة : الإجراء المطلوب تنفيذه، مثل GET أو POST.

- URL : عنوان المورد على الخادم.

- الرؤوس : البيانات الوصفية حول الطلب، مثل نوع المحتوى ووكيل المستخدم.

- النص : البيانات الاختيارية المرسلة مع الطلب، وتُستخدم عادةً مع POST.

يعد فهم كيفية تفسير وبناء هذه المكونات أمرًا ضروريًا لتجميع الويب بشكل فعال. تعمل مكتبات بايثون مثل الطلبات على تبسيط هذه العملية، مما يسمح بالتحكم الدقيق في الطلبات.

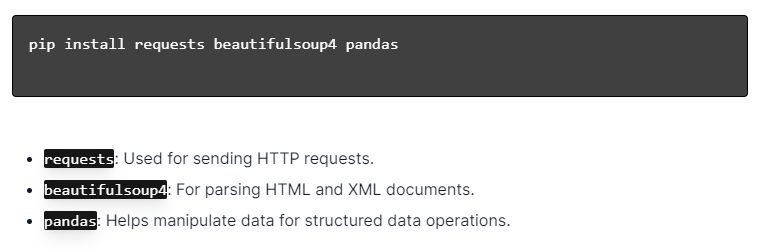

تثبيت مكتبات بايثون

مصدر الصورة: https://ajaytech.co/what-are-python-libraries/

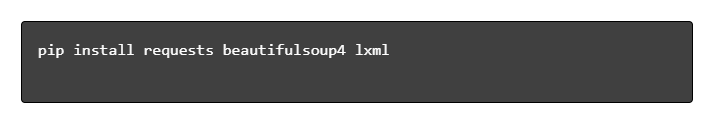

لتجميع الويب الديناميكي باستخدام Python، تأكد من تثبيت Python. افتح الوحدة الطرفية أو موجه الأوامر وقم بتثبيت المكتبات الضرورية باستخدام النقطة:

بعد ذلك، قم باستيراد هذه المكتبات إلى البرنامج النصي الخاص بك:

ومن خلال القيام بذلك، ستكون كل مكتبة متاحة لمهام استخراج البيانات من الويب، مثل إرسال الطلبات، وتحليل HTML، وإدارة البيانات بكفاءة.

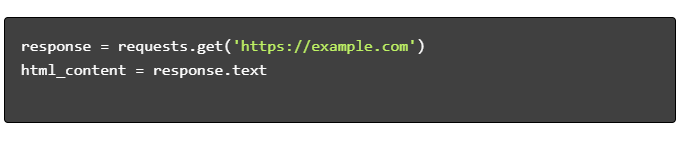

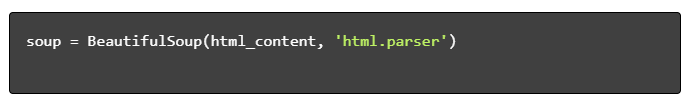

بناء برنامج نصي بسيط لكشط الويب

لإنشاء برنامج نصي أساسي لاستخلاص الويب الديناميكي في بايثون، يجب على المرء أولاً تثبيت المكتبات الضرورية. تتعامل مكتبة "الطلبات" مع طلبات HTTP، بينما تقوم "BeautifulSoup" بتحليل محتوى HTML.

الخطوات لمتابعة:

- تثبيت التبعيات:

- مكتبات الاستيراد:

- الحصول على محتوى HTML:

- تحليل HTML:

- استخراج البيانات:

التعامل مع تجريف الويب الديناميكي باستخدام بايثون

تقوم مواقع الويب الديناميكية بإنشاء محتوى سريعًا، وغالبًا ما يتطلب تقنيات أكثر تعقيدًا.

خذ بعين الاعتبار الخطوات التالية:

- تحديد العناصر المستهدفة : افحص صفحة الويب لتحديد المحتوى الديناميكي.

- اختر إطار عمل Python : استخدم المكتبات مثل السيلينيوم أو الكاتب المسرحي.

- تثبيت الحزم المطلوبة :

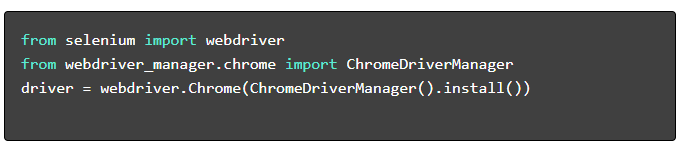

- إعداد برنامج تشغيل الويب :

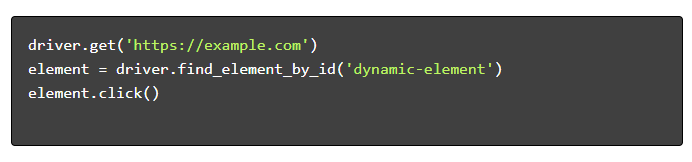

- التنقل والتفاعل :

أفضل ممارسات تجريف الويب

يوصى باتباع أفضل ممارسات تجريف الويب لضمان الكفاءة والشرعية. فيما يلي الإرشادات الأساسية واستراتيجيات التعامل مع الأخطاء:

- احترام Robots.txt : تحقق دائمًا من ملف robots.txt الخاص بالموقع المستهدف.

- الاختناق : قم بتنفيذ التأخيرات لمنع التحميل الزائد على الخادم.

- وكيل المستخدم : استخدم سلسلة وكيل مستخدم مخصصة لتجنب عمليات الحظر المحتملة.

- منطق إعادة المحاولة : استخدم كتل المحاولة باستثناء وقم بإعداد منطق إعادة المحاولة للتعامل مع مهلات الخادم.

- التسجيل : الاحتفاظ بسجلات شاملة لتصحيح الأخطاء.

- معالجة الاستثناءات : اكتشاف أخطاء الشبكة وأخطاء HTTP وأخطاء التحليل على وجه التحديد.

- اكتشاف اختبار CAPTCHA : دمج استراتيجيات للكشف عن اختبارات CAPTCHA وحلها أو تجاوزها.

تحديات تجريف الويب الديناميكية الشائعة

كلمة التحقق

تستخدم العديد من مواقع الويب اختبارات CAPTCHA لمنع الروبوتات الآلية. لتجاوز هذا:

- استخدم خدمات حل اختبار CAPTCHA مثل 2Captcha.

- تنفيذ التدخل البشري لحل اختبار CAPTCHA.

- استخدم الوكلاء للحد من معدلات الطلب.

حظر IP

قد تحظر المواقع عناوين IP التي تقدم عددًا كبيرًا جدًا من الطلبات. مواجهة هذا عن طريق:

- باستخدام الوكلاء الدورية.

- تنفيذ اختناق الطلب.

- توظيف استراتيجيات تناوب وكيل المستخدم.

عرض جافا سكريبت

تقوم بعض المواقع بتحميل المحتوى عبر JavaScript. مواجهة هذا التحدي من خلال:

- استخدام السيلينيوم أو محرك الدمى لأتمتة المتصفح.

- استخدام Scrapy-splash لعرض المحتوى الديناميكي.

- استكشاف المتصفحات مقطوعة الرأس للتفاعل مع JavaScript.

قضايا قانونية

يمكن أن يؤدي تجريف الويب في بعض الأحيان إلى انتهاك شروط الخدمة. ضمان الامتثال عن طريق:

- استشارات قانونية.

- كشط البيانات المتاحة للجمهور.

- احترام توجيهات robots.txt.

تحليل البيانات

قد يكون التعامل مع هياكل البيانات غير المتناسقة أمرًا صعبًا. تشمل الحلول ما يلي:

- استخدام مكتبات مثل BeautifulSoup لتحليل HTML.

- توظيف التعبيرات النمطية في استخراج النص.

- استخدام موزعي JSON وXML للبيانات المنظمة.

تخزين وتحليل البيانات المسروقة

يعد تخزين البيانات المسروقة وتحليلها خطوات حاسمة في عملية تجريف الويب. يعتمد تحديد مكان تخزين البيانات على الحجم والتنسيق. تتضمن خيارات التخزين الشائعة ما يلي:

- ملفات CSV : سهلة لمجموعات البيانات الصغيرة والتحليلات البسيطة.

- قواعد البيانات : قواعد بيانات SQL للبيانات المنظمة؛ NoSQL للغير منظم.

بمجرد تخزينها، يمكن إجراء تحليل البيانات باستخدام مكتبات بايثون:

- الباندا : مثالية لمعالجة البيانات وتنظيفها.

- NumPy : فعال للعمليات العددية.

- Matplotlib وSeaborn : مناسبان لتصور البيانات.

- Scikit-learn : يوفر أدوات للتعلم الآلي.

يؤدي تخزين البيانات وتحليلها بشكل صحيح إلى تحسين إمكانية الوصول إلى البيانات والرؤى.

الخلاصة والخطوات التالية

بعد أن تجولت عبر الويب الديناميكي الذي يقوم بتجميع لغة بايثون، فمن الضروري تحسين فهم الأدوات والمكتبات المميزة.

- مراجعة الكود : راجع النص النهائي وقم بتقسيمه إلى وحدات حيثما أمكن ذلك لتعزيز إمكانية إعادة الاستخدام.

- المكتبات الإضافية : استكشف المكتبات المتقدمة مثل Scrapy أو Splash لتلبية الاحتياجات الأكثر تعقيدًا.

- تخزين البيانات : فكر في خيارات التخزين القوية — قواعد بيانات SQL أو التخزين السحابي لإدارة مجموعات البيانات الكبيرة.

- الاعتبارات القانونية والأخلاقية : ابق على اطلاع دائم بالإرشادات القانونية حول تجريف الويب لتجنب الانتهاكات المحتملة.

- المشاريع التالية : سيؤدي التعامل مع مشاريع تجريف الويب الجديدة ذات التعقيدات المختلفة إلى تعزيز هذه المهارات بشكل أكبر.

هل تتطلع إلى دمج تجريف الويب الديناميكي الاحترافي مع Python في مشروعك؟ بالنسبة لتلك الفرق التي تحتاج إلى استخراج بيانات واسعة النطاق دون تعقيد التعامل معها داخليًا، تقدم PromptCloud حلولاً مخصصة. استكشف خدمات PromptCloud للحصول على حل قوي وموثوق. اتصل بنا اليوم!