كيفية تجنب انتهاكات الامتثال أثناء تطوير منتجات الذكاء الاصطناعي

نشرت: 2023-06-12ظل الذكاء الاصطناعي هو الاتجاه التكنولوجي الأعلى لعدة سنوات من خلال مساهماته في قطاعات البيانات والآلات كثيفة مثل التصنيع والرعاية الصحية والتمويل. ومع ذلك ، في العامين الماضيين فقط ، شهدت التكنولوجيا اهتمامًا كبيرًا من المستخدمين النهائيين. باستخدام تطبيقات مثل برامج إنشاء الصور والنصوص ، أصبح بإمكان الأشخاص الآن إنتاج عناصر مرئية ونصوص بنقرة واحدة.

بينما يبدو أن منصات الذكاء الاصطناعي هذه تنتج موادًا من الصفر ، إلا أن هذا ليس هو الحال تمامًا - فقد تم تدريب منصات الذكاء الاصطناعي هذه على مقتطفات الأسئلة وبحيرات البيانات التي تعمل من خلال معالجة أرشيفات النصوص والصور من الإنترنت. على الرغم من أن هذا النهج مفيد للمستخدمين النهائيين ، إلا أنه يأتي مع مخاطر قانونية مثل انتهاك حقوق الطبع والنشر ، وعدم الالتزام بتراخيص المصادر المفتوحة ، وانتهاك الملكية الفكرية ، وما إلى ذلك. هذه المخاطر التي يشكلها الذكاء الاصطناعي التوليدي ليست غير مرئية من قبل الحكومات في جميع أنحاء العالم التي تأتي باستمرار مع قواعد وعقوبات جديدة حول نماذج الذكاء الاصطناعي غير الأخلاقية.

بالنسبة لشركة تستعد لإطلاق مشروع الذكاء الاصطناعي الخاص بها ، من الأهمية بمكان أن تفهم المخاطر وأن تبني نظامًا لا يقع تحت الرادار القانوني في الجزء الخلفي من هذه القضايا الأخلاقية. في هذه المقالة ، سوف نتعمق في الجوانب العديدة للامتثال للذكاء الاصطناعي أثناء تطوير البرامج - أنواع القضايا القانونية ، وطرق الاستعداد لتنظيم الذكاء الاصطناعي ، وأفعال الذكاء الاصطناعي التي تتبعها مناطق مختلفة.

ما هو التوافق مع الذكاء الاصطناعي؟

إنها عملية تضمن أن التطبيقات التي تعمل بالذكاء الاصطناعي متوافقة مع لوائح وقوانين المنطقة التي تعمل فيها. إليك العوامل المختلفة التي يتكون منها فحص الامتثال لمنظمة العفو الدولية -

القضايا القانونية مع الذكاء الاصطناعي

بينما على المستوى الجزئي ، قد يبدو أن المشكلات المتعلقة باستخدام المستخدمين النهائيين للذكاء الاصطناعي تقتصر على الانتحال أو الوصول إلى البيانات غير القابلة للمشاركة ، على المستوى الكلي ، يتسبب عدم الامتثال للذكاء الاصطناعي في تحديات أكبر.

يمكن أن تؤثر التهديدات الناشئة عن استخدام نظام ذكاء اصطناعي سيئ البناء على المنافسة العادلة والأمن السيبراني وحماية المستهلك وحتى الحقوق المدنية. لذلك ، من الأهمية بمكان للشركات والحكومات بناء نموذج أخلاقي عادل.

حقوق النشر

مع بداية الذكاء الاصطناعي التوليدي ، بدأت الشركات في إنشاء مواد محمية بحقوق الطبع والنشر من خلال التكنولوجيا. تكمن المشكلة في هذا في عدم القدرة على فهم ما إذا كانت البيانات قد تم إنشاؤها بإبداع المؤلف أو ما إذا كان الذكاء الاصطناعي هو المؤلف.

لإعطاء هذا الالتزام القانوني ، أصدر مكتب حقوق الطبع والنشر إرشادات حول فحص وتسجيل المصنفات التي تحتوي على مواد تم إنشاؤها بواسطة الذكاء الاصطناعي. تنص على ما يلي -

- حقوق النشر يمكن أن تحمي فقط المواد التي ينتجها الإبداع البشري.

- في حالة الأعمال التي تحتوي على مواد قائمة على الذكاء الاصطناعي ، سيتم النظر في ما إذا كانت مساهمات الذكاء الاصطناعي ناتجة عن "إعادة إنتاج ميكانيكية" أم أنها "تصور أصلي خاص بالمؤلف ، والذي أعطوا له شكلًا مرئيًا من خلال الذكاء الاصطناعي.

- يتحمل مقدمو الطلبات واجب الكشف عن مشاركة المحتوى القائم على الذكاء الاصطناعي في المواد المقدمة للتسجيل.

اقرأ أيضًا: تكلفة تطوير أداة الكشف عن المحتوى بالذكاء الاصطناعي في عام 2023

المصدر المفتوح

غالبًا ما تستخدم مولدات الأكواد التي تعتمد على الذكاء الاصطناعي الذكاء الاصطناعي لمساعدة المطورين في الإكمال التلقائي أو اقتراح التعليمات البرمجية في الجزء الخلفي من اختبارات أو مدخلات المطور. فيما يلي بعض التحديات المرتبطة بتطوير نماذج ذكاء اصطناعي متوافقة حول مولدات الأكواد -

- هل يعني تدريب نماذج الذكاء الاصطناعي بشفرة مفتوحة المصدر انتهاكًا؟

- من المسؤول عن استيفاء معايير الامتثال مفتوحة المصدر - مطور أم مستخدم؟

- هل سيتطلب استخدام التعليمات البرمجية المستندة إلى الذكاء الاصطناعي من قبل المطورين الذين ينشئون برامج جديدة أن يكون التطبيق مرخصًا بموجب مصدر مفتوح؟

التعدي على IP

على الصعيد العالمي ، تم رفع دعاوى قضائية متعددة ضد أدوات الذكاء الاصطناعي ، متهمة إياها بأنها تدرب نماذجها أو تنتج مخرجات على أساس محتوى محمي ببروتوكول IP لطرف ثالث.

التحيز الأخلاقي

كانت هناك العديد من الحوادث التي أدت فيها تقنية التعرف على الوجه بالذكاء الاصطناعي إلى التمييز العنصري. سواء كان الأمر كذلك في عام 2020 ، حيث تم إلقاء القبض على السود بسبب خطأ في الكمبيوتر أو تصنيف صور Google للأشخاص السود على أنهم "غوريلا". بغض النظر عن مدى ذكاء التكنولوجيا ، لا يمكن تجاهل أنها بنيت من قبل بشر متحيزين

بالنسبة للشركات التي تتطلع إلى بناء حلول مماثلة ، فمن الأهمية بمكان ألا تسمح لهذه التحيزات بالظهور في النظام.

الامتثال للقانون العام لحماية البيانات (GDPR) لمشاريع الذكاء الاصطناعي

مع هذا ، من الضروري فهم سبب فشل الشركات في بناء نماذج ذكاء اصطناعي متوافقة على الرغم من اللوائح الصارمة. يمكن أن يكون هناك عدة أسباب وراء ذلك ، تتراوح من عدم القدرة على معرفة الامتثال ، وعدم فهم المطورين ، وأحيانًا الجهل البسيط. ومع ذلك ، يمكن أن يكون هناك بعض الأسباب الوظيفية وراء ذلك أيضًا.

دعونا نلقي نظرة على عدد قليل منها من منظور الامتثال للقانون العام لحماية البيانات (GDPR) لمشاريع الذكاء الاصطناعي.

تحديد الغرض

يُلزم مبدأ القانون العام لحماية البيانات (GDPR) الشركات بإبلاغ موضوعات البيانات بالغرض الذي يتم من أجله جمع معلوماتهم ومعالجتها. التحدي في هذا هو أن التكنولوجيا تستخدم البيانات للعثور على أنماط والحصول على رؤى جديدة ، ولكن قد لا يكون هذا هو الغرض الحقيقي من تلك البيانات.

تمييز

تتطلب اللائحة العامة لحماية البيانات (GDPR) من مطوري الذكاء الاصطناعي اتخاذ خطوات ضد التأثير التمييزي الذي يمكن أن تحمله التكنولوجيا. في حين أنها حاجة أخلاقية للساعة ، بالنسبة للمطور الذي يقوم بتشغيل سيناريو اجتماعي سريع التغير ، فإن إعداد نموذج الذكاء الاصطناعي ضد كل تمييز ومخرجات غير أخلاقية يمكن أن يصبح أمرًا صعبًا.

تصغير البيانات

تقول اللائحة العامة لحماية البيانات (GDPR) أن المعلومات التي تم جمعها يجب أن تكون "كافية ومحدودة وذات صلة". هذا يعني أن فرق تطوير الذكاء الاصطناعي يجب أن تكون حذرة للغاية عند استخدام البيانات لنماذجها ويجب أن تكون واضحة بشأن كمية البيانات المطلوبة لمشروعهم.

ومع ذلك ، لا يمكن التنبؤ بهذا ، لذلك يجب على الفرق تقييم نوع البيانات ومقدارها بانتظام لتلبية متطلبات تقليل البيانات.

الشفافية

أخيرًا ، يجب أن يكون للمستخدمين رأي في كيفية استخدام الأطراف الثالثة لبياناتهم ، ولهذا ، ستحتاج الشركات إلى توضيح البيانات التي يستخدمونها وكيف.

تكمن المشكلة في ذلك في أن غالبية نماذج الذكاء الاصطناعي تعمل في الصناديق السوداء ، وليس من الواضح كيف يتخذون القرارات ، خاصة عندما نتحدث عن البرامج المتقدمة.

على الرغم من أن هذه كلها مشكلات تقنية حقيقية ، عندما يتعلق الأمر بأخلاقيات تكنولوجيا المعلومات ، فمن الأهمية بمكان ألا تستخدمها الشركات كدروع لتطوير نموذج ذكاء اصطناعي معيب. لضمان عدم تعميم هذه الممارسة ، تم وضع العديد من قوانين الذكاء الاصطناعي على نطاق عالمي.

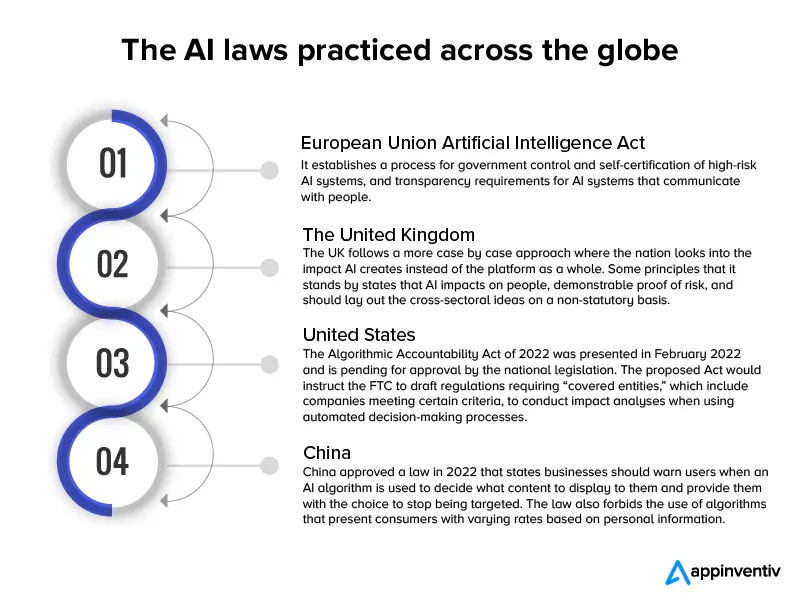

أدخلت ما يقرب من 60 دولة قوانين ولوائح الذكاء الاصطناعي منذ عام 2017 ، وهو مسار عمل يتناسب مع السرعة التي يتم بها تنفيذ نماذج الذكاء الاصطناعي الجديدة.

إليك مخطط معلوماتي يعطي نظرة موجزة عن تلك القوانين.

الآن بعد أن نظرنا في تحديات تطوير الذكاء الاصطناعي من وجهة النظر القانونية والمسودة الأولية للقوانين المعمول بها على المستوى العالمي ، دعنا ننتقل إلى الطرق التي يمكنك من خلالها إنشاء تطبيق ذكاء اصطناعي متوافق.

اقرأ أيضًا: كم يكلف تطوير روبوت محادثة متوافق قانونيًا مثل ChatGPT

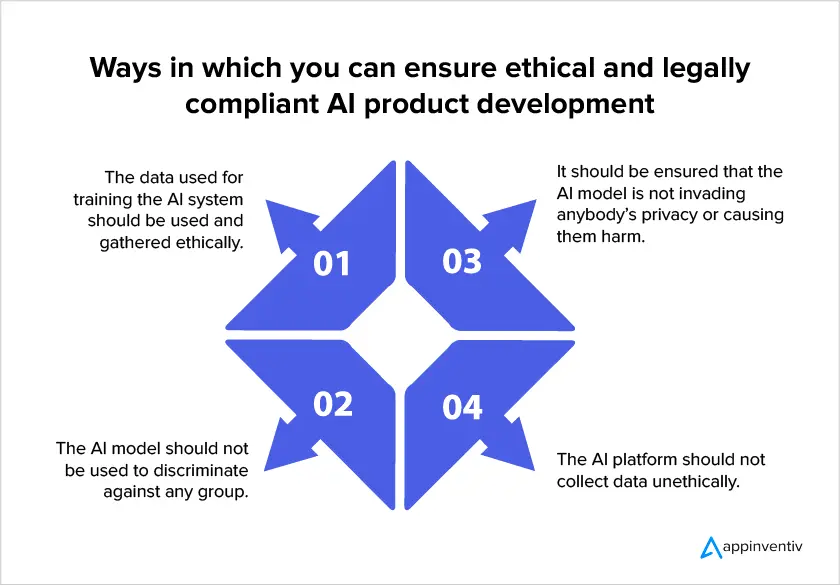

كيفية تطوير نموذج ذكاء اصطناعي صديق للامتثال

نظرًا لارتفاع لوائح الذكاء الاصطناعي على المستوى العالمي ، فقد أصبح من الضروري للشركات التركيز على الامتثال القانوني عند قيامها ببناء نماذج الذكاء الاصطناعي. فيما يلي بعض الطرق التي يمكن للشركات أن تضمن أن مشروعها متوافق قانونيًا عند الاستثمار في خدمات تطوير الذكاء الاصطناعي.

- تأكد من أنه مسموح لك باستخدام البيانات

ينص توافق الذكاء الاصطناعي على أن خصوصية المستخدمين يجب أن تكون هي المبدأ التوجيهي لتصميم النموذج. هذا يعني أنه يجب عليك الاحتفاظ بكمية البيانات التي تحتاج إلى جمعها إلى الحد الأدنى ، وتحديد السبب الدقيق لجمع البيانات ، جنبًا إلى جنب مع الوقت حتى متى ستستخدم بياناتهم. في النهاية ، من المهم ملاحظة أنه يجب على المستخدمين منح موافقتهم على جمع البيانات.

- طرق الذكاء الاصطناعي القابلة للتفسير

يساعد هذا النهج في حل تأثير الصندوق الأسود من خلال مساعدة البشر على فهم ما بداخل أنظمة الذكاء الاصطناعي وكيف يتخذ النموذج القرارات. وهذا بدوره يساعد الباحثين على معرفة الكمية الدقيقة للبيانات التي سيحتاجون إليها لتحسين دقة النموذج لتلبية متطلبات تقليل البيانات.

- تتبع البيانات التي تم جمعها

تتطلب امتثالات الذكاء الاصطناعي أن تعرف الشركات موقع واستخدام معلومات تحديد الهوية الشخصية التي تم جمعها. التصنيف الصحيح للبيانات ضروري للامتثال لحق المستخدمين في المعلومات المحمية. علاوة على ذلك ، يجب أن يكون لدى الشركات نهج لمعرفة المعلومات المخزنة في أي مجموعة بيانات لإعداد تدابير أمنية دقيقة.

- فهم قواعد نقل البيانات بين البلدان

عندما يكون هناك نقل بيانات عبر الحدود في نظام ذكاء اصطناعي ، يجب على المطورين مراعاة اللوائح التي سيتم تطبيقها في البلدان المستقبلة وبناء آليات نقل البيانات المناسبة وفقًا لذلك. على سبيل المثال ، إذا كانت اللائحة العامة لحماية البيانات قابلة للتطبيق على معالجة البيانات وتم نقل البيانات الشخصية إلى بلد خارج المنطقة الاقتصادية الأوروبية ، فيجب إجراء تقييم مناسب لتأثير النقل.

إن استخدام مثل هذه الأساليب عند تطوير تطبيقات الذكاء الاصطناعي يقطع شوطًا طويلاً في ضمان معالجة المخاطر المرتبطة بالتكنولوجيا بشكل صحيح. ومع ذلك ، يجب على الشركات والجهات التنظيمية أن تضع في اعتبارها حقيقة أنه من المستحيل حماية التطبيق من كل مخاطر محتملة حيث يعمل سياق الصناعة على نموذج حالة بحالة. لهذا السبب ، سيظل دور مديري مخاطر الذكاء الاصطناعي مهمًا لأنهم سيكونون قادرين على قياس وقت الحاجة إلى التدخل.

نأمل أن تساعدك المقالة في فهم ما يمكن توقعه من الهيكل القانوني المحيط بتكنولوجيا الذكاء الاصطناعي في المرة القادمة وطرق تحضير نفسك لنموذج الذكاء الاصطناعي المتوافق.

أسئلة وأجوبة

س: هل هناك مشاكل قانونية تتعلق بالذكاء الاصطناعي؟

ج: نعم. يمكن أن يكون هناك عدد من القضايا القانونية والأخلاقية المرتبطة بنموذج الذكاء الاصطناعي السيئ البناء.

- حقوق النشر

- إساءة استخدام ترخيص المصدر المفتوح

- التعدي على IP

- التحيز الأخلاقي مثل التمييز العنصري.

س: لماذا يصعب عمل نموذج ذكاء اصطناعي متوافق مع القانون؟

ج: من الناحية الفنية ، قد يكون من الصعب بناء ذكاء اصطناعي متوافق قانونيًا لأنه بينما تستخدم التكنولوجيا بيانات العملاء للعثور على أنماط والحصول على رؤى جديدة ، يصعب التأكد من الغرض الحقيقي من تلك البيانات. بعد ذلك ، لا يمكن أبدًا لفرق تطوير الذكاء الاصطناعي التأكد من كمية البيانات المطلوبة لمشروعهم. أخيرًا ، تعمل غالبية نماذج الذكاء الاصطناعي في الصناديق السوداء ، وليس من الواضح كيف يتخذون القرارات ، خاصة عندما نتحدث عن البرامج المتقدمة.

س: كيف نضمن الامتثال القانوني في الذكاء الاصطناعي؟

ج: على الرغم من أن القوانين واللوائح المتعلقة بالامتثال القانوني للذكاء الاصطناعي تتطور باستمرار ، فإليك بعض الأشياء التي يمكنك القيام بها للتأكد من أن نموذجك هو الأقرب للامتثال -

- تأكد من أنه مسموح لك باستخدام البيانات

- طرق الذكاء الاصطناعي القابلة للتفسير

- تتبع البيانات التي تم جمعها

- فهم قواعد نقل البيانات بين البلدان