الذكاء الاصطناعي المسؤول - مواجهة تحديات التبني من خلال المبادئ التوجيهية والاستراتيجيات

نشرت: 2023-09-08في عصر يهيمن عليه اعتماد حلول الذكاء الاصطناعي على نطاق واسع، أصبح من الضروري إعطاء الأولوية لعملية تطوير مسؤولة مع الالتزام بمبادئ السلامة والمبادئ الأخلاقية. ومع استمرار نمو قدرات أنظمة الذكاء الاصطناعي هذه والعثور على تطبيقات عبر مختلف المجالات الصناعية، فإن ضمان توافق إنشائها مع تدابير السلامة الصارمة يجب أن يكون أحد أهم أولويات المنظمة.

إذًا، كيف يمكن للمرء التأكد من أن أنظمته القائمة على الذكاء الاصطناعي أخلاقية ولن تسبب أي عواقب غير مقصودة؟ الإجابة البسيطة على هذا اللغز هي الالتزام بمبادئ الذكاء الاصطناعي المسؤول.

يشير الذكاء الاصطناعي المسؤول (RAI) إلى إطار عمل شامل في الذكاء الاصطناعي، حيث تأخذ الاعتبارات الأخلاقية والرفاهية المجتمعية مركز الصدارة. ويتميز بالتطوير والتطبيق المسؤول لأنظمة الذكاء الاصطناعي المصممة للتوافق مع المبادئ الأساسية.

تسمح مبادئ الذكاء الاصطناعي المسؤول للمؤسسات بالتركيز بقوة على الشفافية، مما يمكّن المستخدمين وأصحاب المصلحة من فهم الأعمال الداخلية لأنظمة الذكاء الاصطناعي. تمهد هذه الشفافية الطريق لزيادة الثقة والمساءلة، مما يسمح للأفراد بفهم كيفية اتخاذ قرارات الذكاء الاصطناعي. تتعامل RAI أيضًا بنشاط مع التحيز داخل خوارزميات الذكاء الاصطناعي من خلال إدارة البيانات بذكاء ودمج تدابير العدالة لضمان أن تكون النتائج محايدة وغير متحيزة.

ستساعدك هذه المدونة على فهم المبادئ الخمسة المسؤولة للذكاء الاصطناعي وكيف أن الالتزام بها يمكن أن يجعل نظام الذكاء الاصطناعي الخاص بك عادلاً ومخصصًا للمستخدمين فقط. بالإضافة إلى النظر في فوائد اعتماد الذكاء الاصطناعي المسؤول للشركات، سنساعدك أيضًا على فهم التحديات المختلفة التي يمكن معالجتها من خلال اعتماد النهج المبسط.

الحاجة إلى اعتماد استراتيجيات مسؤولة للذكاء الاصطناعي: التخفيف من مخاطر الذكاء الاصطناعي

في مارس 2016، أطلقت مايكروسوفت روبوت محادثة يعمل بالذكاء الاصطناعي يسمى Tay على تويتر. كان غرض تاي هو التعلم من تفاعلاته مع المستخدمين. ولسوء الحظ، بدأ بعض الأفراد في نشر محتوى مسيء على الروبوت، مما أدى إلى رد تاي باستخدام لغة مسيئة. وفي غضون ساعات، تحول تاي إلى روبوت يروج لخطاب الكراهية والتمييز. قامت Microsoft بسرعة بإيقاف Tay عن الاتصال بالإنترنت واعتذرت عن تغريدات الروبوت غير المناسبة. وتعد هذه الحادثة مثالا واضحا على الكيفية التي يمكن أن يخطئ بها الذكاء الاصطناعي، وقد حدثت العديد من الحالات المماثلة منذ ذلك الحين.

يحمل الذكاء الاصطناعي إمكانات هائلة لإفادة المجتمع، ولكن كما قال العم بن: "مع القوة العظيمة تأتي مسؤولية كبيرة".

عند استخدام الذكاء الاصطناعي لاتخاذ قرارات عمل مهمة تتضمن بيانات حساسة، فمن المهم معرفة ما يلي:

- ماذا يفعل الذكاء الاصطناعي ولماذا؟

- هل تقوم باختيارات دقيقة وعادلة؟

- هل هو احترام خصوصية الناس؟

- هل يمكنك التحكم في هذه التكنولوجيا القوية ومراقبتها؟

تدرك المؤسسات في جميع أنحاء العالم أهمية استراتيجيات الذكاء الاصطناعي المسؤول، لكنها تمر بمراحل مختلفة في رحلتها لاعتمادها. إن تبني مبادئ الذكاء الاصطناعي المسؤول (RAI) هو الإستراتيجية الأكثر فعالية للتخفيف من المخاطر المرتبطة بالذكاء الاصطناعي.

وبالتالي، فقد حان الوقت لتقييم ممارساتك الحالية والتأكد من استخدام البيانات بطريقة مسؤولة وأخلاقية. لن يؤدي الاعتماد المبكر لـ RAI إلى تقليل المخاطر المرتبطة بالممارسات فحسب، بل سيضع المؤسسات أيضًا في مقدمة المنافسين، مما يوفر لهم ميزة تنافسية قد يكون من الصعب تجاوزها في المستقبل.

وفقًا لمسح معهد ماساتشوستس للتكنولوجيا سلون، فإن 52% من الشركات تتخذ خطوات نحو ممارسات مسؤولة في مجال الذكاء الاصطناعي. ومع ذلك، فإن أكثر من 79% من هذه الشركات تعترف بأن جهودها محدودة من حيث الحجم والنطاق. يسلط التقرير الضوء على الأهمية المتزايدة للشركات لمواجهة التحديات وإعطاء الأولوية للذكاء الاصطناعي المسؤول (RAI) مع استمرار تزايد دور الذكاء الاصطناعي في الشركات. ولتشكيل مستقبل مستدام ومسؤول يعتمد على الذكاء الاصطناعي، فإن إنشاء إطار أخلاقي قوي ليس مجرد خيار ولكنه ضروري.

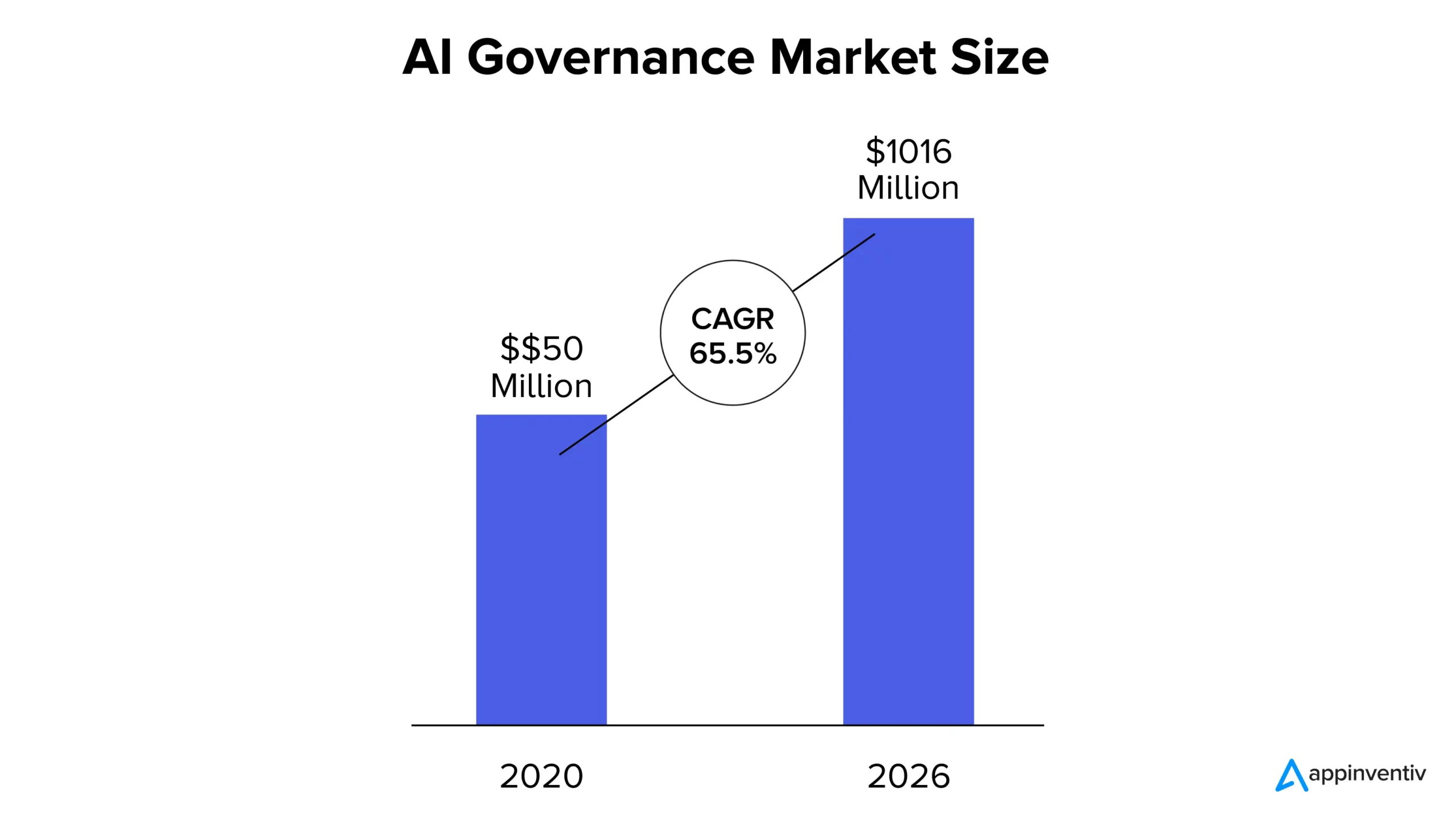

الآن، وفقًا لتقرير MarketsandMarkets، بلغت قيمة سوق حوكمة الذكاء الاصطناعي 50 مليون دولار في عام 2020، ومن المتوقع أن تصل إلى 1,016 مليون دولار بحلول عام 2026، بمعدل نمو سنوي مركب قدره 65.5%. ويمكن أن تعزى الحصة السوقية المتزايدة إلى النمو المتزايد للشفافية في أنظمة الذكاء الاصطناعي، والالتزام بالامتثال التنظيمي، والحاجة المتزايدة للثقة في الحلول القائمة على الذكاء الاصطناعي.

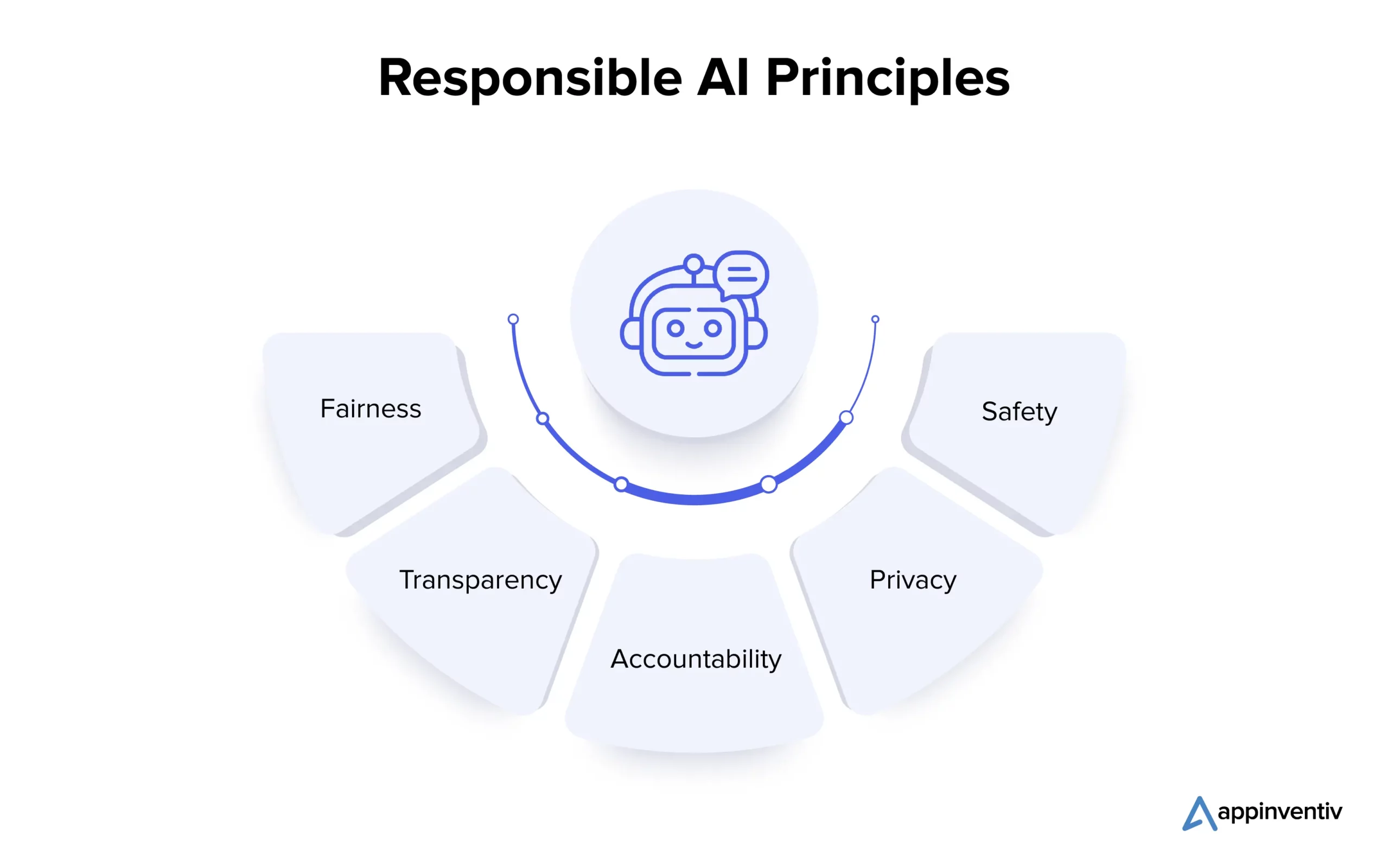

ما هي مبادئ الذكاء الاصطناعي المسؤول؟

يعد فهم المبادئ الأساسية للذكاء الاصطناعي المسؤول أمرًا حيويًا للمؤسسات التي تتطلع إلى التنقل في مشهد الذكاء الاصطناعي المعقد بشكل أخلاقي. دعونا نلقي نظرة على المبادئ المتعددة بالتفصيل أدناه:

1. الإنصاف

تعد العدالة في الذكاء الاصطناعي مبدأ أساسيًا يعالج التحيزات في أنظمة الذكاء الاصطناعي. يمكن أن تحدث التحيزات أثناء إنشاء الخوارزمية أو بسبب بيانات التدريب المشوهة. يستخدم علماء البيانات تقنيات مثل تحليل البيانات لاكتشاف التحيز وتصحيحه، مما يضمن أن أنظمة الذكاء الاصطناعي تتخذ قرارات غير متحيزة وتعزز النتائج المتساوية.

2. الشفافية

تتضمن الشفافية في الذكاء الاصطناعي توثيق وشرح الخطوات المتخذة في تطويره ونشره، مما يجعله مفهومًا لأصحاب المصلحة. وتكشف تقنيات مثل التعلم الآلي القابل للتفسير عن المنطق الكامن وراء قرارات الذكاء الاصطناعي، في حين تضمن الرقابة البشرية التوافق الأخلاقي والتبرير.

3. المساءلة

ترتبط المساءلة ارتباطًا وثيقًا بالشفافية وتشمل إنشاء آليات لمساءلة مطوري ومستخدمي الذكاء الاصطناعي عن نتائج وتأثيرات أنظمة الذكاء الاصطناعي. يتضمن ذلك تنفيذ المبادئ التوجيهية الأخلاقية، واستخدام أدوات المراقبة، وإجراء التدقيق. وتضمن هذه التدابير أن تحقق أنظمة الذكاء الاصطناعي النتائج المرجوة، وتمنع الضرر غير المقصود، وتحافظ على الجدارة بالثقة.

4. الخصوصية

الخصوصية أمر بالغ الأهمية لحماية المعلومات الشخصية للأفراد. يتضمن النظام البيئي للذكاء الاصطناعي الحصول على الموافقة لجمع البيانات، وجمع البيانات الضرورية فقط، واستخدامها للأغراض المقصودة فقط. يتم استخدام تقنيات الحفاظ على الخصوصية مثل الخصوصية التفاضلية وتقنيات التشفير لحماية البيانات الشخصية أثناء تطوير نموذج الذكاء الاصطناعي وإنتاجه.

5. السلامة

يجب على المطورين إعطاء الأولوية للسلامة في الذكاء الاصطناعي المسؤول، بما في ذلك الرفاهية الجسدية وغير الجسدية. ولتحقيق ذلك، ينبغي دمج اعتبارات السلامة في كل مرحلة من مراحل تطوير نظام الذكاء الاصطناعي. في مرحلة التصميم، يعد إشراك أصحاب المصلحة المتنوعين لتحديد وفهم المخاطر المحتملة أمرًا بالغ الأهمية. تعد تقييمات المخاطر والاختبار في ظل ظروف مختلفة والإشراف البشري والمراقبة المستمرة والتحسين أثناء الإنتاج ضرورية لمنع الضرر والحفاظ على الموثوقية في أنظمة الذكاء الاصطناعي.

بعد النظر في المبادئ المتعددة للذكاء الاصطناعي المسؤول، دعونا نمضي قدمًا ونفهم التحديات المرتبطة بتبني الحل.

ما هي التحديات التي تواجه اعتماد حلول الذكاء الاصطناعي المسؤولة؟

يعد اعتماد الذكاء الاصطناعي المسؤول رحلة واعدة ذات مكافآت كبيرة للشركات، ولكن تحدياتها الحاسمة تتطلب دراسة متأنية وحلول استباقية. دعونا نلقي نظرة عليها بالتفصيل أدناه:

الشرح والشفافية

يجب أن تكون أنظمة الذكاء الاصطناعي قادرة على توضيح كيف ولماذا تنتج نتائج محددة للحفاظ على الثقة. ومن الممكن أن يؤدي الافتقار إلى الشفافية إلى تقليل الثقة في هذه الأنظمة.

السلامة الشخصية والعامة

يمكن للأنظمة ذاتية القيادة مثل السيارات ذاتية القيادة والروبوتات أن تسبب مخاطر على سلامة الإنسان. ويعد ضمان رفاهية الإنسان في مثل هذه السياقات أمرًا بالغ الأهمية.

الأتمتة والتحكم البشري

وفي حين يمكن للذكاء الاصطناعي أن يعزز الإنتاجية، فإنه قد يقلل من المشاركة البشرية والخبرة. إن تحقيق التوازن لضمان السيطرة البشرية والرقابة يمثل تحديًا.

التحيز والتمييز

على الرغم من أن أنظمة الذكاء الاصطناعي مصممة لتكون محايدة، إلا أنها لا تزال قادرة على وراثة التحيزات من بيانات التدريب، مما قد يؤدي إلى تمييز غير مقصود. إن منع مثل هذه التحيزات أمر حيوي.

المساءلة والتنظيم

مع نمو الحضور الإجمالي للذكاء الاصطناعي، قد تنشأ أسئلة حول المسؤولية والمسؤولية. يعد تحديد المسؤول عن استخدام نظام الذكاء الاصطناعي وإساءة استخدامه أمرًا معقدًا.

الأمن والخصوصية

يتطلب الذكاء الاصطناعي الوصول إلى البيانات على نطاق واسع، الأمر الذي يمكن أن يثير المزيد من المخاوف بشأن خصوصية البيانات والانتهاكات الأمنية. تعد حماية البيانات المستخدمة في التدريب على الذكاء الاصطناعي أمرًا ضروريًا لحماية الخصوصية العامة للفرد.

الآن، الشراكة مع شركة تطوير تطبيقات الذكاء الاصطناعي ذات السمعة الطيبة (مثل Appinventiv) التي تلتزم بمبادئ الذكاء الاصطناعي المسؤول أثناء عملية التطوير يمكن أن تساعد الشركات في التخفيف بشكل فعال من التحديات والمخاطر المرتبطة بها.

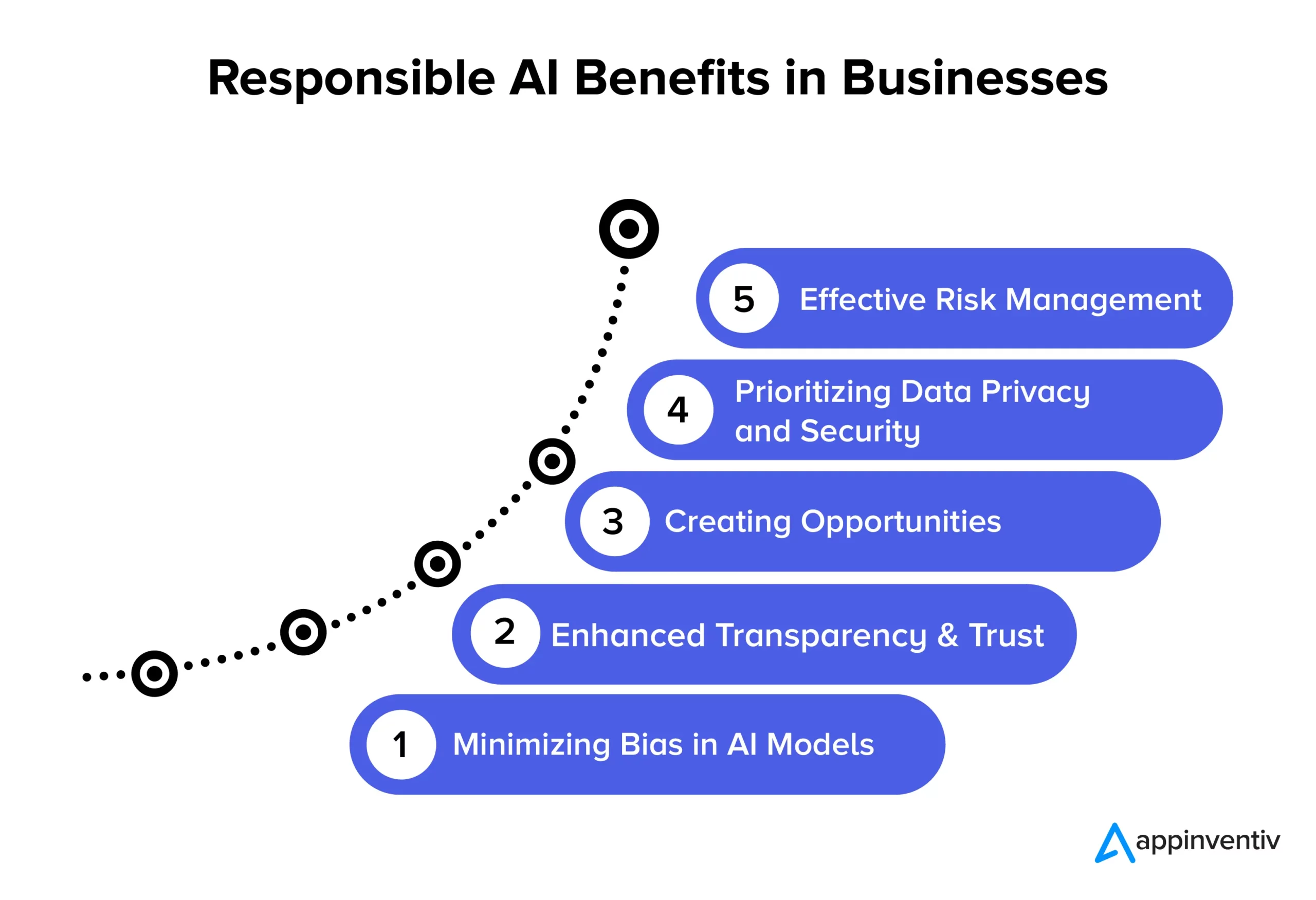

فوائد الذكاء الاصطناعي المسؤول للشركات

إن اعتماد مبادئ الذكاء الاصطناعي المسؤول يمهد الطريق لمزايا هامة متعددة للشركات والمجتمع. دعنا نستكشفها بالتفصيل أدناه:

تقليل التحيز في نماذج الذكاء الاصطناعي

ومن خلال الالتزام بمبادئ الذكاء الاصطناعي المسؤول، يمكن للشركات أن تقلل بشكل فعال من التحيزات في نماذج الذكاء الاصطناعي الخاصة بها والبيانات الأساسية المستخدمة لتدريبها. ويضمن هذا الانخفاض في التحيز أن توفر أنظمة الذكاء الاصطناعي نتائج أكثر دقة وعدالة، وصحيحة من الناحية الأخلاقية وتقلل من مخاطر تغير البيانات بمرور الوقت. بالإضافة إلى ذلك، يساعد تقليل التحيز المؤسسات على تجنب الضرر المحتمل للمستخدمين الذي قد ينشأ عن نتائج نموذج الذكاء الاصطناعي المتحيز، مما يعزز سمعتهم ويقلل المسؤولية.

تعزيز الشفافية والثقة

تعمل ممارسات الذكاء الاصطناعي المسؤولة على تعزيز وضوح وشفافية نماذج الذكاء الاصطناعي. وهذا يساعد في تعزيز الثقة بين الشركات وعملائها. بالإضافة إلى ذلك، أصبح الذكاء الاصطناعي متاحًا ومفهومًا بشكل أكبر لجمهور أوسع، مما يفيد المؤسسات والمستخدمين النهائيين من خلال تمكين مجموعة واسعة من التطبيقات وتعزيز الاستخدام الفعال لتقنيات الذكاء الاصطناعي.

خلق الفرص

إن الالتزام بمبادئ الذكاء الاصطناعي المسؤول يمكّن المطورين والمستخدمين من إجراء محادثات مفتوحة حول أنظمة الذكاء الاصطناعي. إنها واحدة من فوائد الذكاء الاصطناعي المسؤولة الأكثر رواجًا في الشركات. فهو يخلق مساحة حيث يمكن للأشخاص التعبير عن أسئلتهم ومخاوفهم بشأن تكنولوجيا الذكاء الاصطناعي، مما يسمح للشركات بمعالجة هذه القضايا بشكل استباقي. ويؤدي هذا النهج التعاوني لتطوير الذكاء الاصطناعي إلى إنشاء حلول ذكاء اصطناعي سليمة أخلاقيا ومسؤولة اجتماعيا، والتي يمكن أن تعزز سمعة الشركة وقدرتها التنافسية.

إعطاء الأولوية لخصوصية البيانات وأمنها

تسمح حلول الذكاء الاصطناعي المسؤولة للشركات بالتركيز بشكل كبير على حماية خصوصية البيانات وأمنها. وهذا يعني أنه يتم التعامل مع البيانات الشخصية أو الحساسة بعناية، وحماية حقوق الأفراد ومنع خروقات البيانات. عندما تتبع الشركات مبادئ الذكاء الاصطناعي المسؤول، فإنها تقلل من فرص إساءة استخدام البيانات، وانتهاك اللوائح، والإضرار بسمعتها. إنها طريقة ذكية للحفاظ على أمان البيانات والحفاظ على ثقة العملاء.

الإدارة الفعالة للمخاطر

تحدد ممارسات الذكاء الاصطناعي المسؤولة قواعد أخلاقية وقانونية واضحة لأنظمة الذكاء الاصطناعي، مما يساعد على تقليل فرص النتائج الضارة. يفيد الحد من المخاطر كيانات متعددة، مثل الشركات والموظفين والمجتمع. يمكن للمؤسسات تجنب الدعاوى القضائية الباهظة الثمن والإضرار بسمعتها عند معالجة المشكلات الأخلاقية والقانونية المحتملة.

أمثلة على التنفيذ المسؤول الناجح للذكاء الاصطناعي

فيما يلي بعض الأمثلة الواقعية الجديرة بالملاحظة للمؤسسات التي تعطي الأولوية لممارسات الذكاء الاصطناعي الأخلاقية وغير المتحيزة:

أداة توظيف الذكاء الاصطناعي الجديرة بالثقة من IBM

تعاونت إحدى الشركات الأمريكية الكبرى مع شركة IBM لأتمتة عمليات التوظيف وإعطاء الأولوية للعدالة في عمليات التوظيف المعتمدة على الذكاء الاصطناعي. كان هدفهم هو تسهيل التنوع والشمول مع الحفاظ على سلامة نماذج التعلم الآلي الخاصة بهم. ومن خلال استخدام IBM Watson Studio، وهي أداة لمراقبة وإدارة الذكاء الاصطناعي، نجحوا في تحديد ومعالجة التحيز في التوظيف مع اكتساب رؤى قيمة في عملية صنع القرار في مجال الذكاء الاصطناعي.

إطار عمل الذكاء الاصطناعي المسؤول لشركة State Farm

قامت شركة State Farm، إحدى أكبر شركات التأمين في الولايات المتحدة، بدمج الذكاء الاصطناعي في عملية التعامل مع المطالبات ونفذت استراتيجية مسؤولة للذكاء الاصطناعي. لقد أنشأوا نظام حوكمة لتعيين المساءلة عن الذكاء الاصطناعي، مما أدى إلى اتخاذ قرارات أسرع وأكثر استنارة. نموذج التقييم الديناميكي للمركبة (DVAM) التابع لشركة State Farm يتنبأ بشكل فعال بالخسائر الإجمالية ويضفي الشفافية على معالجة مطالبات التأمين.

فريق الذكاء الاصطناعي المسؤول وقائمة المراجعة في H&M Group

قامت مجموعة H&M، وهي شركة عالمية لبيع الأزياء بالتجزئة، بدمج الذكاء الاصطناعي في عملياتها لتحقيق الاستدامة وتحسين سلاسل التوريد وتعزيز تجارب العملاء الشخصية. أنشأت الشركة فريقًا مخصصًا للذكاء الاصطناعي المسؤول في عام 2018 لضمان الاستخدام المسؤول للذكاء الاصطناعي. قام هذا الفريق بتطوير قائمة مرجعية عملية تحدد الأضرار المحتملة المتعلقة بالذكاء الاصطناعي وتخفف منها وتلتزم تمامًا بمبادئ الذكاء الاصطناعي المسؤول.

عدالة Google في التعلم الآلي

عملت Google أيضًا بنشاط على تضمين تدابير العدالة في الذكاء الاصطناعي والتعلم الآلي. لقد طوروا أدوات وموارد لمساعدة المطورين على تحديد وتخفيف التحيز في نماذج التعلم الآلي الخاصة بهم.

OpenAI GPT-3

وكانت OpenAI، الشركة التي تقف وراء GPT-3، أيضًا رائدة رئيسية في اتباع نهج مسؤول لنشر الذكاء الاصطناعي. لقد طبقوا آليات ضبط دقيقة لتجنب النتائج الضارة والمتحيزة التي تثبت التزامهم بالذكاء الاصطناعي الأخلاقي، حتى في نماذج البرمجة اللغوية العصبية المتقدمة.

مستقبل الذكاء الاصطناعي المسؤول مع Appinventiv

إن مستقبل الذكاء الاصطناعي المسؤول هو رحلة مستمرة، حيث تمر المنظمات بمراحل مختلفة من التطور الأخلاقي فيما يتعلق بالتكنولوجيا واستخدام البيانات. إنه مجال ديناميكي يركز على وضع مبادئ توجيهية موحدة للصناعات المتنوعة. للتنقل بين مبادئ الذكاء الاصطناعي المسؤول لشركتك، تعد الشراكة مع Appinventiv أفضل خيار يمكن أن تتخذه الشركة. يمكننا مساعدتك في إنشاء حلول ذكاء اصطناعي أخلاقية وغير متحيزة ودقيقة ومصممة خصيصًا لتلبية احتياجاتك.

نظرًا لكوننا شركة متخصصة في تطوير الذكاء الاصطناعي، يتمتع مطورونا بسنوات من الخبرة في تطوير حلول الذكاء الاصطناعي، مع إعطاء الأولوية للأخلاقيات والمسؤولية. بفضل سجل حافل من مشاريع الذكاء الاصطناعي الناجحة التي تغطي العديد من المجالات الصناعية، فإننا ندرك أهمية مواءمة حلول الذكاء الاصطناعي مع القيم الأساسية والمبادئ الأخلاقية المطلوبة. يمكننا مساعدتك في تنفيذ تدابير العدالة لضمان اتخاذ حلول الأعمال القائمة على الذكاء الاصطناعي قرارات محايدة.

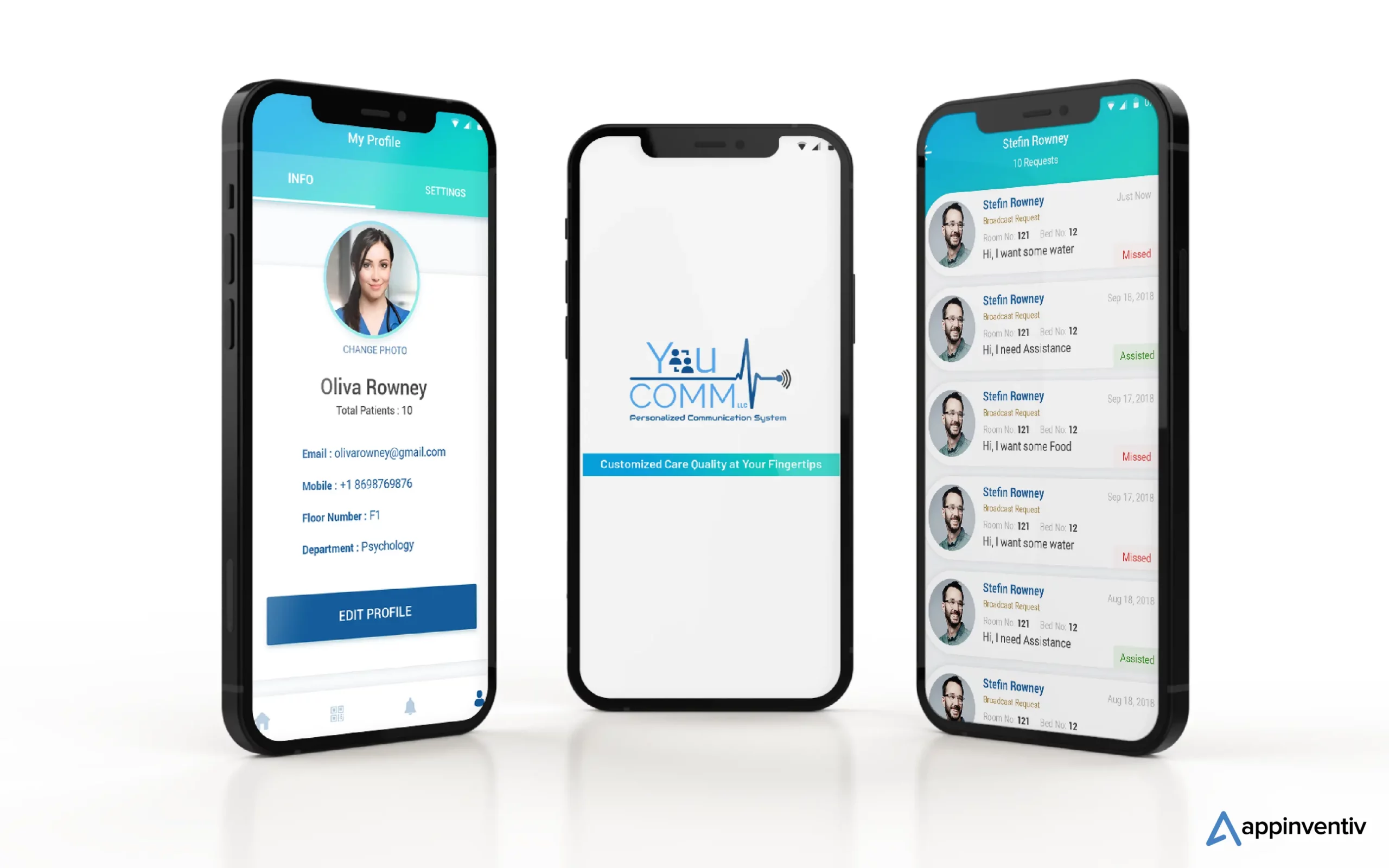

لقد قمنا مؤخرًا بتطوير YouComm، وهو تطبيق رعاية صحية قائم على الذكاء الاصطناعي يربط المرضى بممرضات المستشفى من خلال حركات اليد والأوامر الصوتية. ويتم الآن تنفيذ الحل عبر أكثر من 5 سلاسل مستشفيات في جميع أنحاء الولايات المتحدة.

تواصل مع خبراء الذكاء الاصطناعي لدينا لبناء حلول الذكاء الاصطناعي التي تقدم نتائج دقيقة وتلتزم بالمعايير الأخلاقية.

الأسئلة الشائعة

س: ما هي بعض الأمثلة على الذكاء الاصطناعي المسؤول؟

ج: فيما يلي بعض الأمثلة على الذكاء الاصطناعي المسؤول عبر مجالات صناعية متعددة:

- الخوارزميات العادلة: أنظمة الذكاء الاصطناعي مصممة لتكون عادلة وتقلل من تحيزات القرار.

- الذكاء الاصطناعي القابل للتفسير (XAI): جعل قرارات الذكاء الاصطناعي مفهومة.

- تخفيف التحيز: المراقبة المستمرة وتقليل التحيز في الذكاء الاصطناعي.

- لجان أخلاقيات الذكاء الاصطناعي: إنشاء مجالس مراجعة داخلية للذكاء الاصطناعي الأخلاقي.

- الذكاء الاصطناعي الذي يحافظ على الخصوصية: حماية البيانات الحساسة أثناء استخدامها للذكاء الاصطناعي.

- تقارير الشفافية: مشاركة كيفية عمل أنظمة الذكاء الاصطناعي واتخاذ القرارات.

- التعليم المسؤول للذكاء الاصطناعي: تدريب المتخصصين في الذكاء الاصطناعي على الأخلاقيات والمسؤولية.

س. ما هي بعض حالات الاستخدام المسؤول للذكاء الاصطناعي؟

ج : فيما يلي بعض حالات استخدام الذكاء الاصطناعي المسؤول الناجحة:

- تشخيص الرعاية الصحية: يتم استخدامه لتعزيز النتائج الطبية بعدالة وخصوصية المريض.

- الخدمات المالية: قادرة على القضاء على المخاطر المرتبطة بالاحتيال والبرامج الضارة. يمكن للحلول المسؤولة القائمة على الذكاء الاصطناعي أن تزيد من حماية بيانات العملاء وتضمن الإقراض العادل.

- التوظيف: يساعد في تقليل التحيز مع تمهيد الطريق لاعتماد التنوع وتكافؤ الفرص بين المستخدمين.

- المركبات ذاتية القيادة: تساعد في إعطاء الأولوية للسلامة والالتزام بالمعايير الأخلاقية.

س. هل الذكاء الاصطناعي المسؤول عملية مستمرة، أم يمكن للشركات تنفيذها مرة واحدة ونسيانها؟

ج: الذكاء الاصطناعي المسؤول هو عملية مستمرة تتطلب مراقبة مستمرة وتحديثًا وتكيفًا مع المعايير واللوائح الأخلاقية المتغيرة. لذلك، يُنصح بالشراكة مع شركة متخصصة في تطوير الذكاء الاصطناعي يمكنها مساعدتك في اجتياز المياه بعناية.