تجريف بيانات الويب في عصر البيانات الضخمة: الفرص والمعضلات الأخلاقية

نشرت: 2024-05-29تجريف بيانات الويب وتحليلات البيانات الضخمة

لقد برز استخراج بيانات الويب كآلية محورية لجمع البيانات عبر الإنترنت. تتضمن هذه العملية الاسترداد الآلي للمعلومات من مواقع الويب، وتحويل الويب غير المنظم إلى ثروة من البيانات المنظمة الجاهزة للتحليل.

مصدر الصورة: https://www.sas.com/

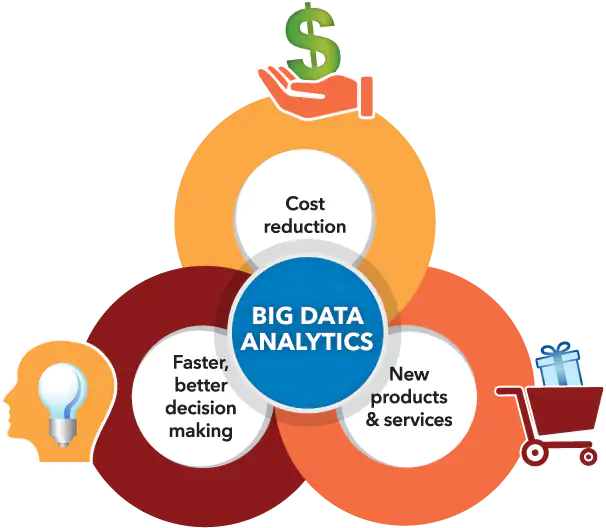

وفي الوقت نفسه، رسخت تحليلات البيانات الضخمة مكانتها في تمييز الأنماط والاتجاهات والرؤى من مجموعات البيانات الضخمة المتراكمة، غالبًا من خلال استخراج بيانات الويب. نظرًا لأن كميات هائلة من البيانات (حوالي 2.5 كوينتيليون بايت من البيانات التي يتم إنشاؤها يوميًا) أصبحت أكثر سهولة في الوصول إليها، فإن تجميع بيانات الويب مع تحليلات البيانات الضخمة يفتح عددًا لا يحصى من الاحتمالات للشركات والباحثين وصانعي السياسات.

ومن خلال الجمع بين هذه القدرات التكنولوجية بمهارة، فإنهم يضعون أنفسهم في موقع يسمح لهم بالاستفادة من عملية صنع القرار الموجهة بالبيانات، وتحفيز الابتكارات الخدمية، وصياغة المشاريع الاستراتيجية المصممة خصيصًا لتحقيق أهدافهم. ومع ذلك، فمن الضروري الاعتراف بظهور المعضلات الأخلاقية الناتجة عن العلاقة التآزرية بين هذه الأدوات المتقدمة.

يجب أن يتم السير على خط رفيع بعناية فيما يتعلق بالتوازن الحاسم بين تعظيم قيمة البيانات والحفاظ على حقوق خصوصية الأفراد، مما يضمن ألا يطغى أي جانب على الجانب الآخر.

فوائد تجريف بيانات الويب لمشاريع البيانات الضخمة

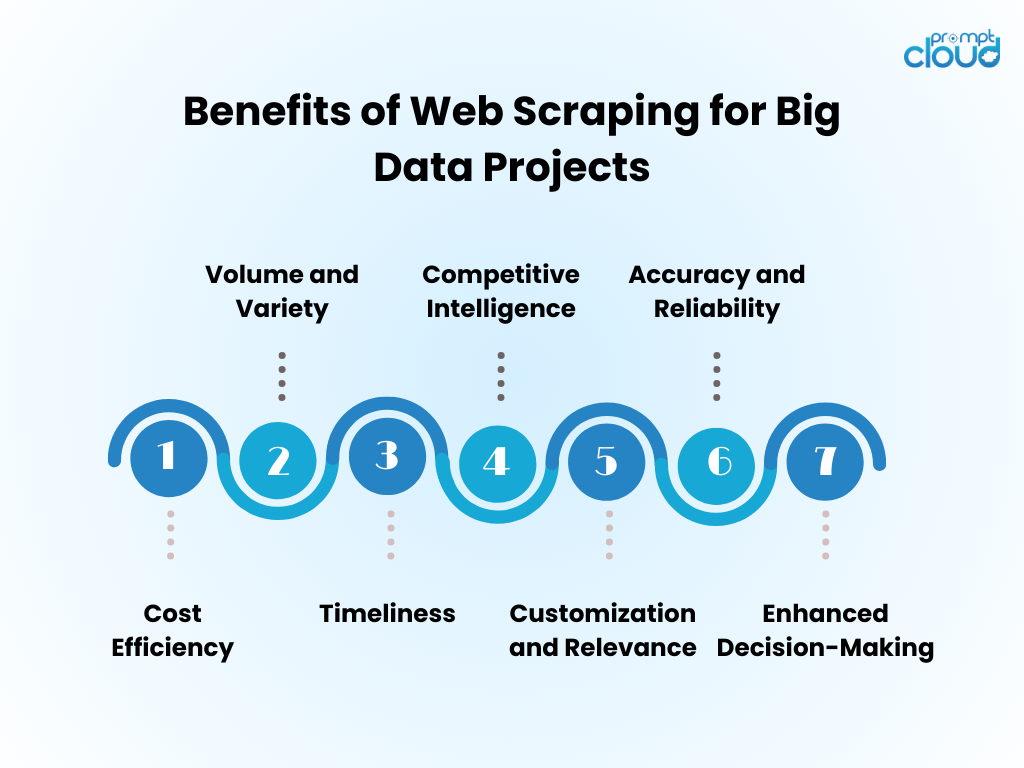

- كفاءة التكلفة : تعمل أتمتة جمع البيانات من خلال تجريف الويب على تقليل تكاليف العمالة البشرية بشكل كبير وتسريع وقت الحصول على الرؤى.

- الحجم والتنوع : يتيح التقاط كميات هائلة من البيانات من مصادر متنوعة، وهو أمر بالغ الأهمية لتغذية تحليلات البيانات الضخمة.

- التوقيت المناسب : يوفر استخراج البيانات من الويب بيانات في الوقت الفعلي أو في الوقت الفعلي تقريبًا، مما يسمح باستجابات أكثر مرونة لاتجاهات السوق.

- الذكاء التنافسي : يمكّن المؤسسات من القدرة على مراقبة المنافسين وتغيرات الصناعة عن كثب.

- التخصيص والملاءمة : يمكن تصميم البيانات وفقًا لاحتياجات محددة، مما يضمن أن التحليل ملائم ومركّز.

- الدقة والموثوقية : يقلل الاستخراج الآلي من الأخطاء البشرية، مما يؤدي إلى مجموعات بيانات أكثر دقة.

- تعزيز عملية صنع القرار : الوصول إلى البيانات ذات الصلة في الوقت المناسب يدعم اتخاذ القرارات المستنيرة والتخطيط الاستراتيجي.

تقنيات تجريف الويب: من الأساسي إلى المتقدم

مصدر الصورة: تسجيل الدخول

لقد تطور استخراج بيانات الويب مع التكنولوجيا، بدءًا من التقنيات الأساسية التي تتقدم مع تزايد تعقيد البيانات.

- التقنيات الأساسية : في البداية، تقوم أدوات الكشط باسترداد البيانات باستخدام طلبات HTTP البسيطة للحصول على صفحات HTML، وتحليل المحتوى من خلال مكتبات مثل Beautiful Soup في Python. يمكن لهذه الأدوات التعامل بشكل مناسب مع مواقع الويب غير المعقدة.

- التقنيات الوسيطة : بالنسبة للمحتوى الديناميكي، تتطور التقنيات لتشمل أدوات التشغيل الآلي مثل السيلينيوم، والتي يمكنها التفاعل مع JavaScript وتقليد سلوك المتصفح.

- التقنيات المتقدمة : الانتقال نحو التجريد المتقدم، تتضمن الأساليب متصفحات مقطوعة الرأس، وخوادم بروكسي للتنقل حول تدابير مكافحة التجريد. يصبح استخراج البيانات معقدًا باستخدام خوارزميات التعلم الآلي، ومعالجة اللغة الطبيعية والصور لاسترجاع المعلومات.

- الاعتبارات الأخلاقية : بغض النظر عن مدى تعقيد التقنية، لا تزال المعضلات الأخلاقية قائمة، مما يستلزم إيجاد توازن بين الوصول إلى البيانات واحترام الخصوصية والملكية.

دمج البيانات المحذوفة من الويب في تحليلات البيانات الضخمة

يمكن للبيانات المستخرجة من الويب، عند دمجها في تحليلات البيانات الضخمة، أن تكشف عن رؤى شاملة للسوق واتجاهات المستهلك. يقوم المحللون بدمج المعلومات المحذوفة من الويب مع مجموعات البيانات الموجودة، مما يعزز عمق واتساع النتائج التحليلية. وينتج عن هذا الدمج نماذج تنبؤية محسنة، واستراتيجيات تسويقية مخصصة، وملفات تعريفية محسّنة للمستهلكين.

- تنظيف البيانات: تتطلب البيانات المحذوفة تنظيفًا دقيقًا لضمان الدقة في التحليلات.

- تكامل البيانات: يتطلب الجمع بين البيانات المسروقة ومصادر أخرى تقنيات متقدمة لتكامل البيانات.

- تحسين التحليل: مع البيانات الإضافية، يمكن لخوارزميات التعلم الآلي أن تكشف عن أنماط أكثر دقة.

- الاعتبارات الأخلاقية: يجب على المحللين التأكد من أن استخدام بيانات الويب يتوافق مع المعايير القانونية والأخلاقية.

إن مجمع البيانات المعزز يحفز الابتكار، ولكنه يتطلب منهجية صارمة ورقابة أخلاقية.

أفضل الممارسات لتخريب الويب بكفاءة

- احترام بروتوكولات robots.txt؛ لا تتخلص من المواقع التي لا تسمح بذلك عبر ملف الروبوتات الخاص بها.

- قم بجدولة أنشطة النسخ خارج أوقات الذروة لتقليل التأثير على أداء الخادم المستهدف.

- استخدم التخزين المؤقت لتجنب إعادة استخراج نفس المحتوى، مع احترام بيانات موقع الويب وتوفير النطاق الترددي.

- قم بتنفيذ المعالجة المناسبة للأخطاء لمنع مكشطة البيانات الخاصة بك من التعطل ولتجنب إرسال عدد كبير جدًا من الطلبات في حالة حدوث أخطاء.

- قم بتدوير وكلاء المستخدم وعناوين IP لمنع حظرهم، ومحاكاة سلوك التصفح الأكثر طبيعية.

- كن على علم بالممارسات القانونية والأخلاقية لاستخراج البيانات من الويب، مما يضمن أن أنشطة الاستخراج الخاصة بك لا تنتهك حقوق الطبع والنشر أو قوانين الخصوصية.

- قم بتحسين التعليمات البرمجية لتكون فعالة وتقليل الحمل على كل من نظام الكشط ومواقع الويب المستهدفة.

- قم بتحديث كود النسخ بانتظام للتكيف مع أي تغييرات في تخطيط موقع الويب أو التكنولوجيا، والحفاظ على فعالية ودقة استرجاع البيانات الخاصة بك.

- تخزين البيانات التي تم جمعها بشكل آمن وإدارتها بما يتوافق مع جميع لوائح حماية البيانات ذات الصلة.

مستقبل تجريف الويب في عصر البيانات الضخمة

مع استمرار توسع البيانات الضخمة، من المتوقع أن يصبح استخراج بيانات الويب أكثر تكاملاً مع تحليل البيانات وذكاء الأعمال. ومن المرجح أن يشهد المستقبل:

- تم تدريب نماذج التعلم الآلي المحسنة باستخدام مجموعات بيانات ضخمة تم الحصول عليها من خلال عملية الاستخراج، مما أدى إلى تحسين الدقة والرؤى.

- زيادة الطلب على استخراج البيانات في الوقت الفعلي، مما يسمح للشركات باتخاذ قرارات أسرع تعتمد على البيانات.

- تطوير أدوات تجريف أكثر تطوراً للتنقل بين تقنيات مكافحة التجريف والحفاظ على ممارسات جمع البيانات الأخلاقية.

- لوائح وقوانين خصوصية أكثر صرامة تشكل منهجيات جمع بيانات الويب، مما يضمن جمع البيانات بطريقة مسؤولة وبموافقة.

- ظهور منصات استخراج البيانات كخدمة، والتي توفر استخراجًا مخصصًا للبيانات للشركات من جميع الأحجام.

ومع هذه التطورات، سيظل استخراج البيانات من الويب أداة بالغة الأهمية في مجموعة أدوات البيانات الضخمة.

إذا كان المسح اليدوي للويب أمرًا شاقًا أو إذا كانت هناك حاجة للمساعدة لكشف التحديات المعقدة المتعلقة بالحصول على بيانات قيمة، فكن مطمئنًا إلى أن PromptCloud على استعداد للمساعدة!

نحن متخصصون في تقديم حلول شاملة لتجميع الويب مصممة خصيصًا لمبادرات البيانات الضخمة، مما يضمن استخراج البيانات على نطاق واسع ويمكن الاعتماد عليه.

ثق بنا لمعالجة الجوانب الصعبة، مما يتيح لك التركيز على إنشاء خيارات مستنيرة باستخدام مجموعات بيانات قوية وذات مغزى. تواصل معنا على sales@promptcloud.com لاكتشاف كيف يمكن لخبرتنا أن تعزز خطة لعبة البيانات الضخمة الخاصة بك!