Verhinderung des Zusammenbruchs von KI-Modellen: Bewältigung des inhärenten Risikos synthetischer Datensätze

Veröffentlicht: 2023-10-05Künstliche Intelligenz (KI) hat unseren Alltag erheblich verändert, indem sie personalisierte Inhalte auf Streaming-Plattformen vorschlägt und digitale Assistenten auf Smartphones ermöglicht. Möglich werden diese Fortschritte nun durch hochentwickelte KI-Modelle, die aus riesigen Datenmengen lernen.

Verschiedenen Berichten zufolge sind KI-generierte Inhalte im Internet immer häufiger anzutreffen und könnten in den kommenden Jahren bis zu 90 % der Online-Informationen ausmachen.

Bei einem solchen Zustrom an Informationen kann man leicht sagen, dass die KI in der heutigen datenreichen Welt vor einer einzigartigen Herausforderung steht, und zwar darin, an der Fülle an Daten zu ersticken.

Die Berichte deuten außerdem darauf hin, dass die erhebliche Menge dieser KI-generierten Inhalte die Menschen mit einer Fülle von Informationen überfordern kann, was es für sie schwierig macht, zu entscheiden, was vertrauenswürdig und von Menschen erstellt ist. Darüber hinaus bestehen Bedenken hinsichtlich des möglichen Verlusts von Arbeitsplätzen in kreativen Bereichen wie Kunst, Journalismus und Schreiben, weil KI zunehmend in der Lage ist, Inhalte zu produzieren, die traditionell von Menschen erstellt wurden.

Was die KI-Systeme selbst betrifft, gibt es neue Probleme wie den „Modellkollaps“, der sich auf ein Problem bezieht, bei dem KI-Modelle, die auf großen Datensätzen trainiert werden, qualitativ minderwertige Ergebnisse erzeugen, indem sie gängige Wortwahlen gegenüber kreativen Alternativen priorisieren. „Modell-Autophagie-Störung“ oder „Habsburg-KI“ ist ein weiteres Problem, bei dem KI-Systeme, die übermäßig auf die Ergebnisse anderer KI-Modelle trainiert werden, unerwünschte Merkmale aufweisen oder Vorurteile aufweisen können.

Diese Herausforderungen können möglicherweise die Qualität und Zuverlässigkeit von KI-generierten Inhalten beeinträchtigen, das Vertrauen in solche Systeme zerstören und die Informationsüberflutung verschlimmern.

Unser Blog hilft Ihnen dabei, alles zu verstehen, was mit der Verhinderung des Zusammenbruchs von KI-Modellen zu tun hat. Mit dem Fortschreiten der generativen KI-Revolution bringt sie erhebliche Herausforderungen und Unsicherheiten für die Online-Informationslandschaft mit sich. Lassen Sie uns also direkt in die Details eintauchen.

Den Zusammenbruch des KI-Modells verstehen

Beim maschinellen Lernen bezieht sich „Modellkollaps“ auf eine Situation, in der das KI-Modell keine Vielzahl nützlicher Ergebnisse liefert. Stattdessen wird eine begrenzte Anzahl sich wiederholender oder minderwertiger Ergebnisse erzeugt. Dieses Problem kann bei verschiedenen Modellen auftreten, wird jedoch häufig beim Training komplexer Modelle wie Generative Adversarial Networks (GANs) beobachtet. Ein Modellkollaps kann die Fähigkeit des Modells, vielfältige und wertvolle Ergebnisse zu generieren, beeinträchtigen und sich auf seine Gesamtleistung auswirken.

Lassen Sie uns ein Beispiel für einen Modellzusammenbruch veranschaulichen. Stellen Sie sich einen äußerst enthusiastischen Kunststudenten vor, der unser KI-Modell vertritt und die Aufgabe hat, Gemälde von Zebras zu schaffen. Ihre Kunstwerke sind zunächst beeindruckend und ähneln deutlich Zebras. Allerdings verlieren ihre Gemälde im Laufe der Zeit immer mehr ihre Ähnlichkeit mit Zebras und die Qualität nimmt ab. Dies ähnelt dem „Modellkollaps“ beim maschinellen Lernen, bei dem das KI-Modell, wie unser Kunststudent, zunächst eine gute Leistung erbringt, dann aber Schwierigkeiten hat, die wesentlichen Eigenschaften beizubehalten, für die es entwickelt wurde.

Aufgrund der jüngsten Fortschritte in der KI sind Forscher sehr daran interessiert, künstliche oder synthetische Daten zu verwenden, um neue KI-Modelle für die Generierung von Bildern und Texten zu trainieren. Ein Konzept namens „Model Autophagy Disorder“ (MAD) vergleicht diesen Prozess jedoch mit einer selbstzerstörerischen Schleife.

Wenn wir nicht regelmäßig neue reale Daten hinzufügen, könnte sich die Qualität und Vielfalt der KI-Modelle, die wir mithilfe synthetischer Daten erstellen, mit der Zeit verschlechtern. Daher ist es wichtig, ein Gleichgewicht zwischen synthetischen und realen Daten zu finden, damit KI-Modelle weiterhin gut funktionieren.

Dieses Gleichgewicht ist entscheidend, um zu verhindern, dass die Qualität und Vielfalt der Modelle während des Lernens abnimmt. Herauszufinden, wie synthetische Daten effektiv zur Verhinderung des Zusammenbruchs von KI-Modellen genutzt werden können, ist eine ständige Herausforderung, wenn es um die Entwicklung generativer KI und die Verwendung synthetischer Daten geht.

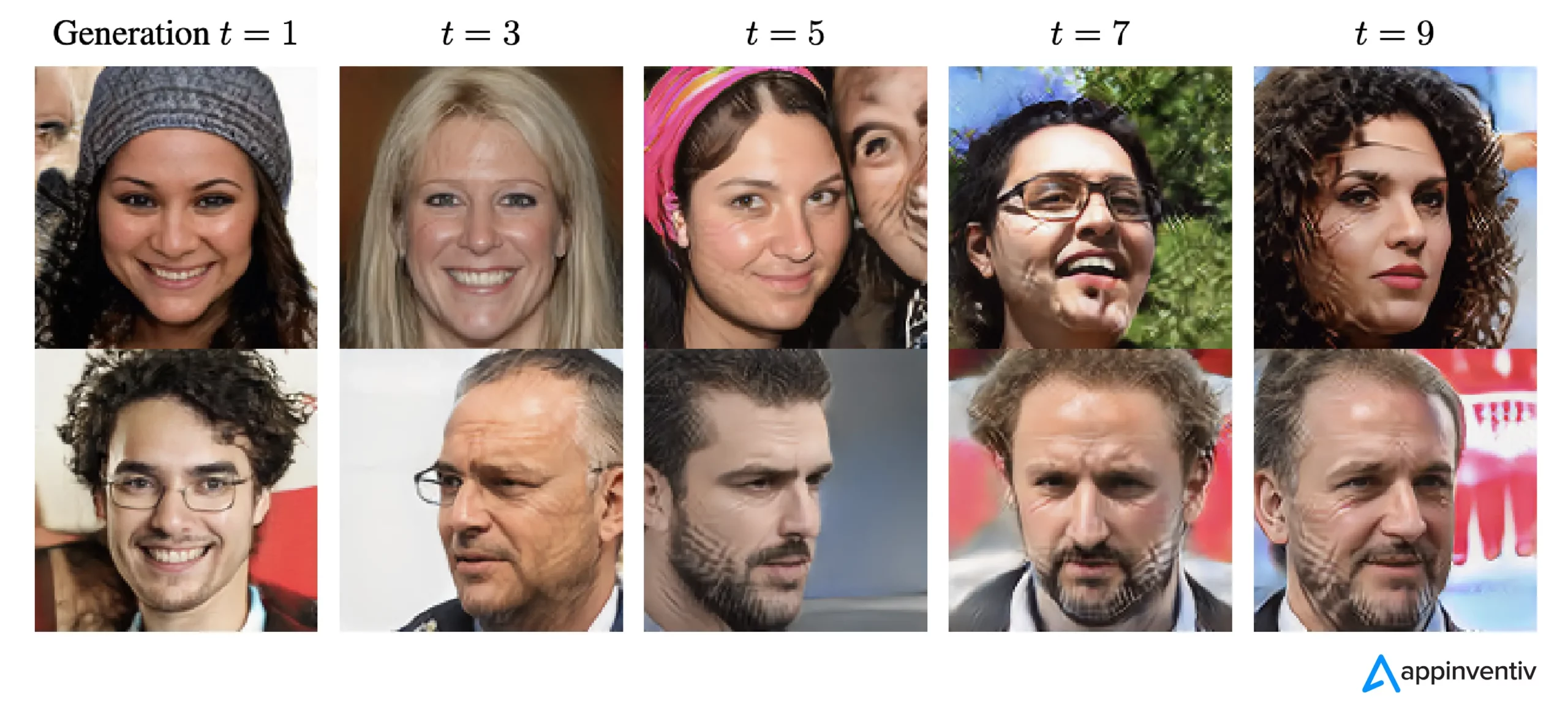

Wenn ChatGPT laut The New Yorker als eine kompakte Version des Internets betrachtet wird, ähnlich der einer JPEG-Datei, die ein Foto komprimiert, dann ist das Training der zukünftigen Chatbots anhand der Ergebnisse von ChatGPTs digital gleichbedeutend damit, wiederholt Fotokopien von Fotokopien anzufertigen, genau wie das Früher. Die Bildqualität wird einfach mit jeder Iteration schlechter.

Um diese Herausforderung zu meistern, müssen sich Unternehmen daher auf die Verfeinerung ihrer Ansätze konzentrieren, um sicherzustellen, dass diese generativen KI-Produkte in dieser digitalen Landschaft weiterhin genaue Antworten liefern.

[Lesen Sie auch: Verantwortungsvolle KI – Herausforderungen bei der Einführung mit Leitprinzipien und Strategien angehen]

Wie kommt es zum Zusammenbruch des KI-Modells?

Ein Modellkollaps tritt auf, wenn neue KI-Modelle mithilfe von Daten trainiert werden, die von älteren Modellen generiert wurden. Diese neuen Modelle basieren auf den Mustern, die in den generierten Daten erkennbar sind. Der Modellkollaps beruht auf der Idee, dass generative Modelle dazu neigen, Muster zu wiederholen, die sie bereits gelernt haben, und dass die Informationen, die sie aus diesen Mustern extrahieren können, begrenzt sind.

Bei einem Modellkollaps werden wahrscheinlich eintretende Ereignisse übertrieben, während weniger wahrscheinliche Ereignisse unterschätzt werden. Über mehrere Generationen dominieren wahrscheinliche Ereignisse die Daten, und die weniger häufigen, aber dennoch wichtigen Teile der Daten, sogenannte Tails, nehmen ab. Diese Ausläufer sind für die Aufrechterhaltung der Genauigkeit und Vielfalt der Modellausgaben von entscheidender Bedeutung. Im Laufe der Generationen überwältigen Fehler die Daten und das Modell interpretiert sie zunehmend falsch.

Den Untersuchungen zufolge gibt es zwei Arten des Modellkollapses: den frühen und den späten. Beim frühen Zusammenbruch des Modells verliert das Modell Informationen über seltene Ereignisse. Beim späten Modellkollaps verwischt das Modell deutliche Muster in den Daten, was zu Ausgaben führt, die wenig Ähnlichkeit mit den Originaldaten haben.

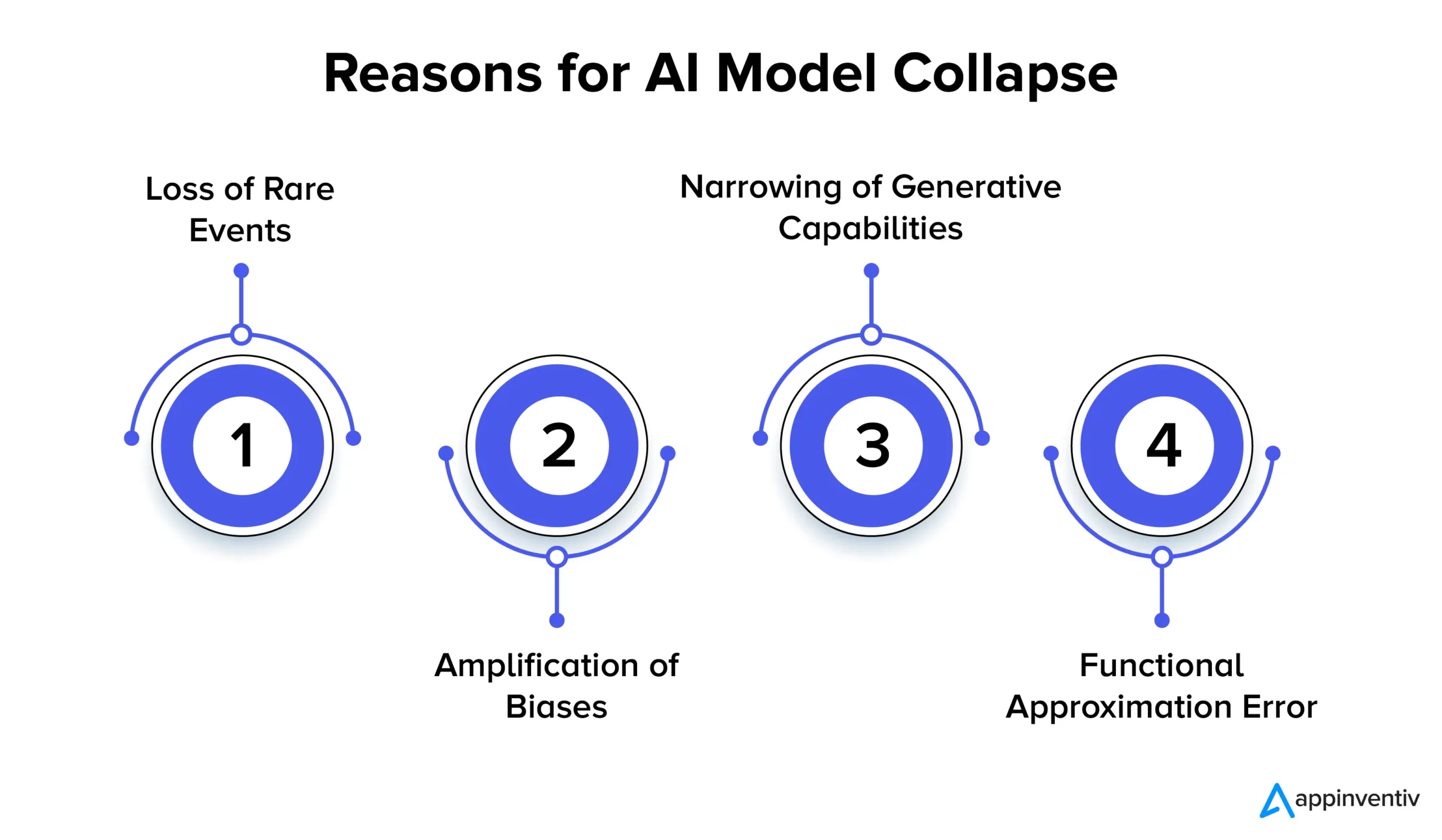

Schauen wir uns im Folgenden mehrere Gründe für den Zusammenbruch des KI-Modells im Detail an:

Verlust seltener Ereignisse

Wenn KI-Modelle wiederholt auf Daten trainiert werden, die von ihren Vorgängerversionen generiert wurden, versuchen sie, sich auf gemeinsame Muster zu konzentrieren und seltene Ereignisse zu vergessen. Dieses Phänomen ähnelt dem Verlust des Langzeitgedächtnisses der Modelle. Seltene Ereignisse sind oft von großer Bedeutung, etwa die Erkennung von Anomalien in Herstellungsprozessen oder die Erkennung betrügerischer Transaktionen. Wenn es beispielsweise um die Betrugserkennung geht, können bestimmte Sprachmuster auf betrügerisches Verhalten hinweisen. Daher ist es wichtig, diese seltenen Muster zu behalten und zu erlernen.

Verstärkung von Vorurteilen

Jede Trainingsiteration auf KI-generierten Daten kann die vorhandenen Verzerrungen in den Trainingsdaten verstärken. Da die Ausgabe des Modells in der Regel die Daten widerspiegelt, auf denen es trainiert wurde, können etwaige Verzerrungen innerhalb dieser Daten mit der Zeit übertrieben werden. Dies kann in verschiedenen KI-Anwendungen zu einer Bias-Verstärkung führen. Die Ergebnisse können beispielsweise zu Problemen wie Diskriminierung, rassistischer Voreingenommenheit und voreingenommenen Social-Media-Inhalten führen. Daher ist die Implementierung von Kontrollen zur Erkennung und Abschwächung von Verzerrungen äußerst wichtig.

Einengung der generativen Fähigkeiten

Da KI-Modelle weiterhin aus ihren generierten Daten lernen, können sich ihre generativen Fähigkeiten verringern. Das Modell wird eher von seinen eigenen Interpretationen der Realität beeinflusst und produziert zunehmend ähnliche Inhalte, denen es an Vielfalt und Darstellung seltener Ereignisse mangelt. Dies kann zu einem Verlust der Originalität führen. Wenn es beispielsweise um Large Language Models (LLMs) geht, verleiht die Variation jedem Autor oder Künstler seinen eigenen Ton und Stil.

Forschungsergebnisse deuten lediglich darauf hin, dass künftige KI-Modelle möglicherweise weniger genau sind oder im Laufe der Zeit weniger unterschiedliche Ergebnisse liefern, wenn während des Trainingsprozesses nicht regelmäßig neue Daten hinzugefügt werden.

Funktioneller Approximationsfehler

Ein funktionaler Approximationsfehler kann auftreten, wenn die im Modell verwendeten Funktionsnäherungen nicht aussagekräftig genug sind. Während dieser Fehler durch die Verwendung ausdrucksstärkerer Modelle gemildert werden kann, kann er auch zu Rauschen führen und zu einer Überanpassung führen. Um diese Fehler zu vermeiden, ist es entscheidend, die richtige Balance zwischen Modellausdruck und Rauschunterdrückung zu finden.

Auswirkungen des Modellkollapses: Warum ist die Stabilität von KI-Modellen wichtig?

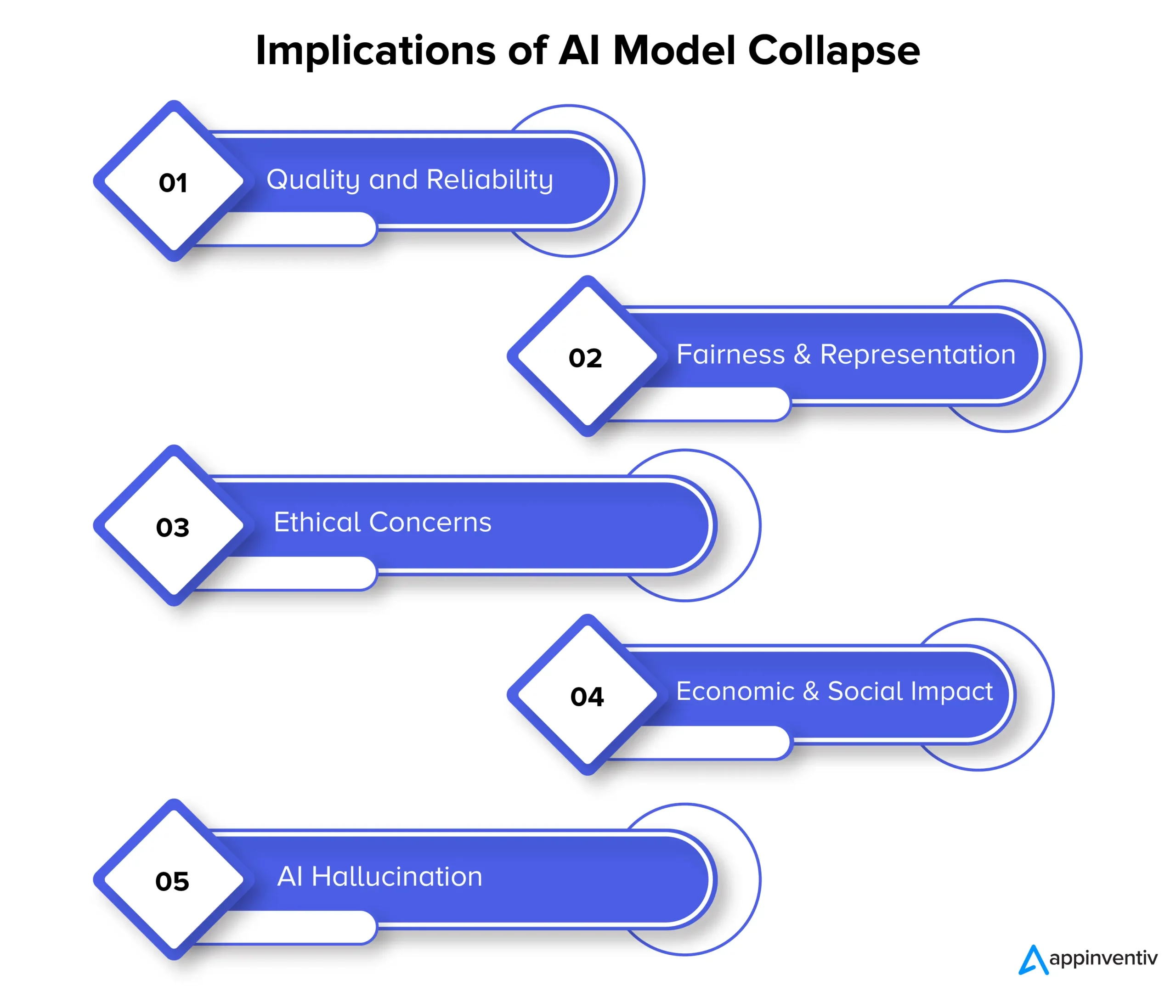

Der Zusammenbruch des Modells kann sich letztendlich auf die Qualität, Zuverlässigkeit und Fairness von KI-generierten Inhalten auswirken, was darüber hinaus mehrere Risiken für Unternehmen mit sich bringen kann. Schauen wir uns die Auswirkungen des Modellkollapses im Folgenden im Detail an:

Qualität und Zuverlässigkeit

Da die Lernfähigkeit von KI-Modellen nachlässt, werden die von ihnen generierten Inhalte weniger zuverlässig und ihre Qualität nimmt ab. Dies geschieht, wenn sich die Modelle von der ursprünglichen Datenverteilung lösen und sich stärker auf ihre eigenen Interpretationen der Realität verlassen. Beispielsweise kann ein für die Nachrichtenerstellung konzipiertes KI-Modell ungenaue oder sogar vollständig erfundene Nachrichtenartikel produzieren.

Fairness und Repräsentation

Der Modellkollaps gibt auch Anlass zur Sorge, wenn es um Fairness und Darstellung der generierten Inhalte geht. Wenn Modelle seltene Ereignisse vergessen und ihre generativen Fähigkeiten einschränken, werden Inhalte zu weniger verbreiteten Themen möglicherweise unzureichend dargestellt. Dies führt zu Vorurteilen, Stereotypen und dem Ausschluss bestimmter Perspektiven.

Ethische Bedenken

Der Zusammenbruch eines Modells wirft erhebliche ethische Bedenken auf, insbesondere wenn KI-generierte Inhalte die Macht haben, die Entscheidungsfindung zu beeinflussen. Zu den Folgen des Zusammenbruchs des Modells gehört die Verbreitung voreingenommener und ungenauer Inhalte, die das Leben, die Meinungen und den Zugang der Menschen zu Chancen erheblich beeinträchtigen können.

Wirtschaftliche und soziale Auswirkungen

Auf wirtschaftlicher und sozialer Ebene kann der Zusammenbruch von Modellen das Vertrauen und die Akzeptanz von KI-Technologien beeinflussen. Wenn man sich nicht auf KI-generierte Inhalte verlassen kann, zögern Unternehmen und Verbraucher möglicherweise, diese Technologien zu nutzen. Dies kann wirtschaftliche Auswirkungen haben und das Vertrauen in KI-Technologien kann dadurch beeinträchtigt werden.

KI-Halluzination

Von einer KI-Halluzination spricht man, wenn KI-Modelle fantasievolle oder unrealistische Inhalte erzeugen, die nicht mit den Fakten übereinstimmen oder in irgendeiner Weise kohärent sind. Dies kann zu ungenauen Informationen führen und möglicherweise zu Fehlinformationen oder Verwirrung führen. Besonders problematisch ist dies bei Anwendungen wie der Generierung von Nachrichten, der Diagnose von Erkrankungen oder der Erstellung von Rechtsdokumenten, bei denen Genauigkeit und Zuverlässigkeit äußerst wichtig sind.

Lassen Sie uns den Kontext anhand eines KI-Halluzinationsbeispiels erklären. Angenommen, es gibt ein KI-Modell, das darauf trainiert ist, Bilder von Tieren zu erzeugen. Wenn das Modell nun ein Bild eines Tieres anfordert, könnte es ein Bild eines „Zebroids“ produzieren, einer Hybride aus einem Zebra und einem Pferd. Obwohl dieses Bild optisch realistisch erscheinen mag, ist es wichtig zu verstehen, dass es nur eine Schöpfung der Fantasie des KI-Modells ist, da es in der realen Welt kein solches Tier gibt.

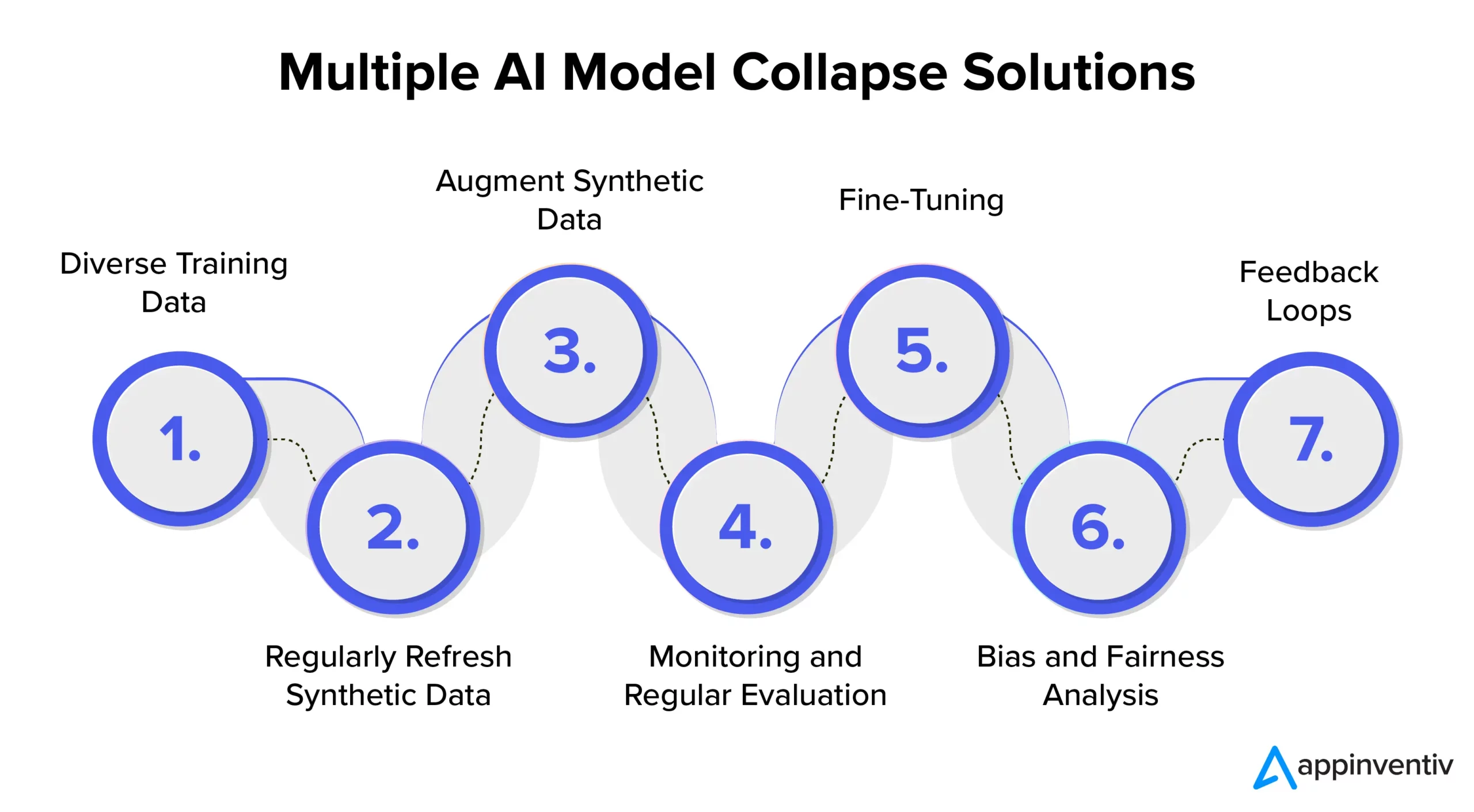

Verhinderung des Zusammenbruchs von KI-Modellen: Verständnis der Lösungen für den Zusammenbruch von KI-Modellen

Um die Stabilität und Zuverlässigkeit des KI-Modells zu gewährleisten, ist es wichtig, Strategien und Best Practices für die wirksame Verhinderung des Zusammenbruchs des KI-Modells zu untersuchen. Daher wird empfohlen, mit einem engagierten KI-Entwicklungsunternehmen wie Appinventiv zusammenzuarbeiten, das Fachwissen und Anleitung bei der Umsetzung dieser vorbeugenden Maßnahmen bietet und gleichzeitig sicherstellt, dass Ihre KI-Systeme stets qualitativ hochwertige Ergebnisse liefern.

Vielfältige Trainingsdaten

Um den Zusammenbruch des KI-Modells wirksam zu bekämpfen und unerwünschte Ausgaben zu verhindern, ist es entscheidend, einen Trainingsdatensatz zu kuratieren, der eine Vielzahl von Datenquellen und -typen umfasst. Dieser Datensatz sollte sowohl aus vom Modell generierten synthetischen Daten als auch aus realen Daten bestehen, die die Komplexität des Problems genau darstellen. Es ist wichtig, diesen Datensatz regelmäßig mit neuen und relevanten Informationen zu aktualisieren. Durch die Einbeziehung verschiedener Trainingsdaten wird das Modell einer Vielzahl von Mustern ausgesetzt. Dies trägt dazu bei, eine Datenstagnation zu verhindern.

Synthetische Daten regelmäßig aktualisieren

Ein Modellkollaps ist ein Risiko, wenn KI-Modelle stark auf ihre eigenen generierten Daten angewiesen sind. Für eine wirksame Risikominderung in der KI ist es wichtig, regelmäßig neue, authentische, reale Daten in die Trainingspipeline einzuführen. Diese Vorgehensweise stellt sicher, dass das Modell anpassungsfähig bleibt und verhindert, dass es in einer Wiederholungsschleife stecken bleibt. Dies kann dazu beitragen, vielfältige und relevante Ergebnisse zu generieren.

Synthetische Daten erweitern

Die Verbesserung synthetischer Daten durch Datenerweiterungstechniken ist eine bewährte Methode, um einen Modellkollaps zu verhindern. Diese Techniken führen zu Variabilität in den synthetischen Daten, indem sie die natürlichen Variationen in realen Daten nutzen. Durch das Hinzufügen von kontrolliertem Rauschen zu den generierten Daten wird das Modell dazu angeregt, eine größere Bandbreite an Mustern zu lernen, wodurch die Wahrscheinlichkeit verringert wird, dass sich wiederholende Ausgaben generiert werden.

Überwachung und regelmäßige Bewertung

Die regelmäßige Überwachung und Bewertung der Leistung von KI-Modellen ist entscheidend für die Früherkennung von Modellkollaps. Die Implementierung eines MLOps-Frameworks gewährleistet eine kontinuierliche Überwachung und Ausrichtung an den Zielen einer Organisation und ermöglicht so zeitnahe Interventionen und Anpassungen.

[Lesen Sie auch: So vermeiden Sie Compliance-Verstöße bei der Entwicklung von KI-Produkten]

Feinabstimmung

Es ist wichtig, die Implementierung von Feinabstimmungsstrategien in Betracht zu ziehen, um die Stabilität des Modells aufrechtzuerhalten und einen Zusammenbruch zu verhindern. Diese Strategien zur Verhinderung von KI-Modellfehlern ermöglichen es dem Modell, sich an neue Daten anzupassen und gleichzeitig sein bisheriges Wissen zu bewahren.

Bias- und Fairness-Analyse

Eine strenge Voreingenommenheits- und Fairnessanalyse ist von entscheidender Bedeutung, um den Zusammenbruch des Modells und ethische Probleme zu verhindern. Es ist wichtig, Verzerrungen in den Modellergebnissen zu identifizieren und zu beheben. Sie können zuverlässige und unvoreingenommene Modellergebnisse aufrechterhalten, indem Sie diese Bedenken aktiv angehen.

Rückkopplungsschleifen

Die Implementierung von Feedbackschleifen, die Benutzerfeedback einbeziehen, ist entscheidend, um einen Modellkollaps zu verhindern. Durch das kontinuierliche Sammeln von Benutzereinblicken können fundierte Anpassungen an den Modellergebnissen vorgenommen werden. Dieser Verfeinerungsprozess garantiert, dass das Modell relevant, zuverlässig und an den Benutzererwartungen ausgerichtet bleibt.

Wie kann Appinventiv bei der Risikominderung in KI-Modellen helfen?

In der sich entwickelnden KI-Landschaft bereiten die Herausforderungen, die der Zusammenbruch von Modellen mit sich bringt, sowohl Technologiegiganten als auch Innovatoren Sorge. Der langfristige Verfall von Sprachmodelldatensätzen und die Manipulation von Inhalten haben in diesem digitalen Ökosystem ihre Spuren hinterlassen.

Mit fortschreitender KI ist es wichtig, zwischen künstlich generierten Daten und von Menschen generierten Inhalten zu unterscheiden. Die Grenze zwischen echten Inhalten und dem, was von einer Maschine generiert wird, verschwimmt immer mehr.

Angesichts dieser Herausforderungen und der Verhinderung des Scheiterns von KI-Modellen kann Ihnen die Partnerschaft mit einem engagierten KI-Entwicklungsunternehmen wie Appinventiv den dringend benötigten Trost spenden. Mit Fachwissen in der KI-Modellentwicklung und einem engagierten Engagement für ethische KI-Praktiken können wir Ihnen helfen, die Komplexität der KI zu bewältigen und gleichzeitig die Zuverlässigkeit und Integrität Ihrer KI-Systeme sicherzustellen.

Unsere Experten können mit Ihnen zusammenarbeiten, um den Zusammenbruch von KI-Modellen effektiv zu verhindern, Transparenz zu fördern und eine Zukunft mit authentischen Inhalten aufzubauen, die die Authentizität von von Menschen erstellten Inhalten nicht gefährden.

Wir verstehen, dass das Training von KI-Modellen mit frischen, vielfältigen Daten unerlässlich ist, um eine Modellverschlechterung zu verhindern. Die Bewertung von KI-Modellen ist ein entscheidender Schritt in unserem Modellentwicklungsprozess, der Metriken verwendet, um die Leistung zu bewerten, Schwachstellen zu lokalisieren und effektive Zukunftsvorhersagen sicherzustellen.

Unser Expertenteam kann dazu beitragen, dass Ihre KI-Systeme weiterhin lernen und sich an die sich entwickelnde digitale Landschaft anpassen. Nehmen Sie Kontakt mit unseren Experten auf, um die mit dem Zusammenbruch von Modellen verbundenen Risiken zu mindern und deren Wirksamkeit sicherzustellen.

FAQs

F. Was ist der Zusammenbruch eines KI-Modells?

A. Der Zusammenbruch des KI-Modells beim maschinellen Lernen bezieht sich darauf, dass das KI-Modell nicht in der Lage ist, vielfältige nützliche Ergebnisse zu erzeugen. Stattdessen werden sich wiederholende Ergebnisse oder Ergebnisse von geringer Qualität generiert. Dieses Problem kann bei verschiedenen Modelltypen auftreten, wird jedoch insbesondere beim Training komplexer Modelle wie Generative Adversarial Networks (GANs) beobachtet.

F. Was sind die häufigsten Ursachen für den Zusammenbruch von KI-Modellen?

A. Häufige Ursachen für den Zusammenbruch von KI-Modellen sind der Verlust seltener Ereignisse, die Verstärkung von Verzerrungen, die Einschränkung der generativen Fähigkeiten, funktionale Approximationsfehler usw. Diese Faktoren können dazu führen, dass Modelle suboptimale Ergebnisse liefern.

F. Wie kann ich den Zusammenbruch des KI-Modells verhindern?

A. Für eine wirksame Verhinderung des Zusammenbruchs von KI-Modellen ist die Verwendung unterschiedlicher und realitätsnaher Trainingsdaten, die kontinuierliche Überwachung und Auswertung der Daten, die Beseitigung etwaiger Vorurteile sowie die Implementierung strenger Tests und Qualitätskontrollen von entscheidender Bedeutung. Durch die Zusammenarbeit mit den KI-Experten von Appinventiv können Sie wertvolle Erkenntnisse und Lösungen zur Minderung des Risikos eines Modellzusammenbruchs gewinnen.