Bewertung von Web-Scraping-Tools: Was Unternehmen wissen müssen

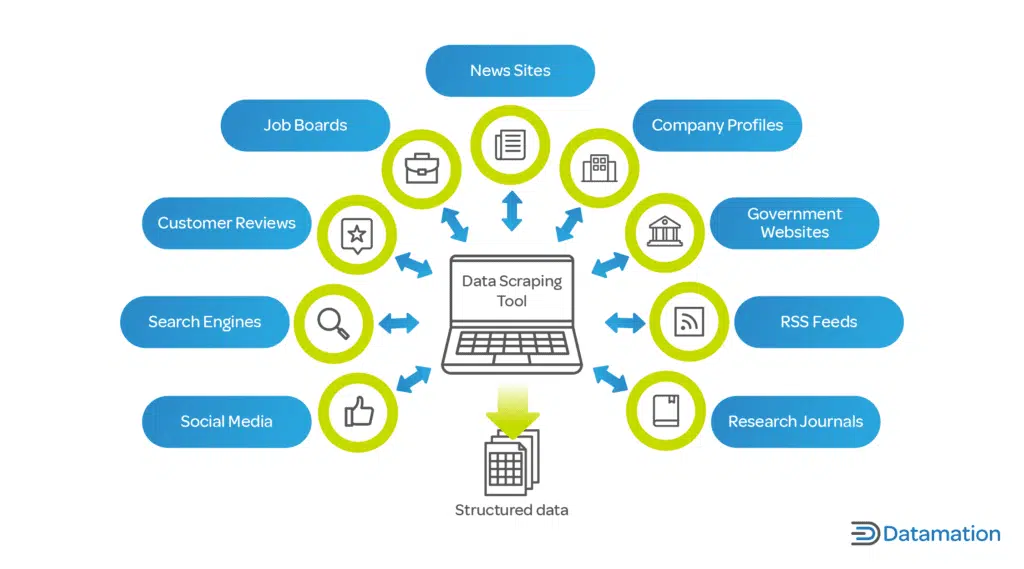

Veröffentlicht: 2024-05-15Web Scraping mithilfe automatisierter Web Scraping-Tools ist für Unternehmen, die Big Data nutzen möchten, von entscheidender Bedeutung. Es ermöglicht das automatisierte Scraping relevanter Informationen aus verschiedenen Webquellen, was für eine datengesteuerte Analyse unerlässlich ist.

Durch die Extraktion aktueller Markttrends, Verbraucherpräferenzen und Wettbewerbserkenntnisse können Unternehmen:

- Treffen Sie fundierte strategische Entscheidungen

- Passen Sie Produkte an die Kundenbedürfnisse an

- Optimieren Sie die Preisgestaltung für die Wettbewerbsfähigkeit am Markt

- Erhöhen Sie die betriebliche Effizienz

Darüber hinaus unterstützen Scraping-Daten bei Zusammenführung mit Analysetools Vorhersagemodelle und bereichern Entscheidungsprozesse. Diese Wettbewerbsinformationen versetzen Unternehmen in die Lage, Marktveränderungen zu antizipieren und proaktiv zu handeln, um sich einen entscheidenden Vorsprung in ihren jeweiligen Sektoren zu sichern.

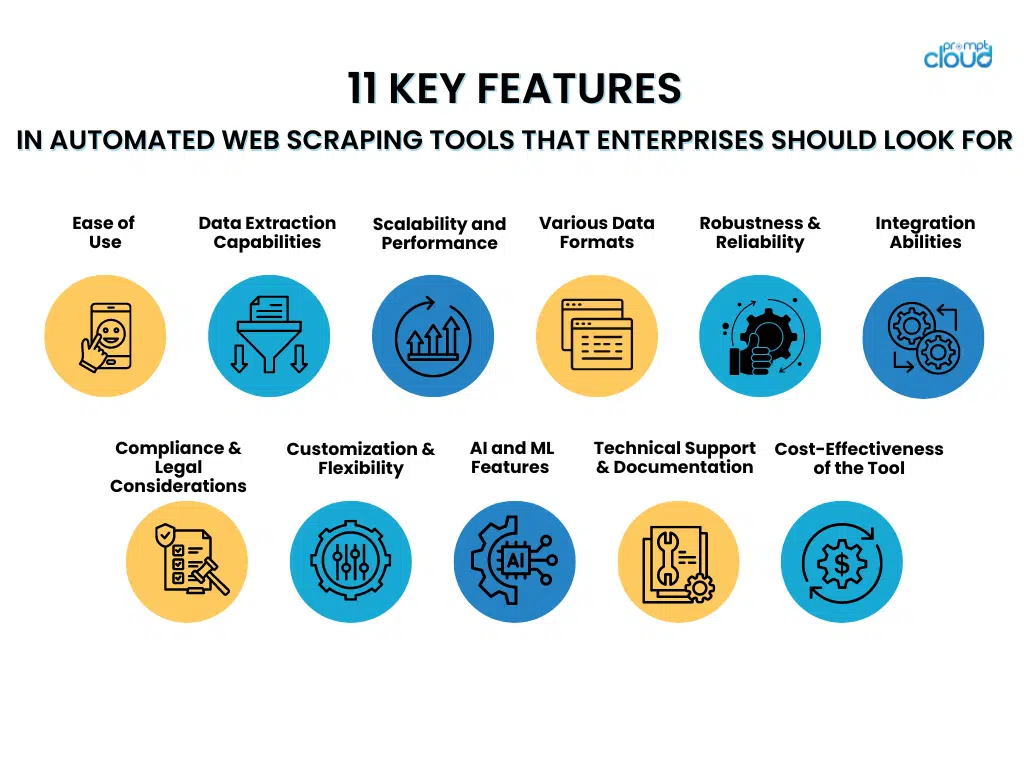

11 Hauptfunktionen automatisierter Web-Scraping-Tools, auf die Unternehmen achten sollten

- Benutzerfreundlichkeit

Bei der Auswahl automatisierter Web-Scraping-Tools sollten Unternehmen solchen den Vorzug geben, die über benutzerfreundliche Schnittstellen und mühelose Einrichtungsschritte verfügen. Tools mit intuitiven Schnittstellen ermöglichen es den Mitarbeitern, sie ohne umfangreiche Schulung effizient zu nutzen, sodass sie sich mehr auf den Datenabruf konzentrieren können, anstatt komplizierte Systeme zu beherrschen.

Andererseits erleichtern unkomplizierte Einrichtungsmethoden die schnelle Bereitstellung dieser Tools, minimieren Verzögerungen und beschleunigen den Weg zu wertvollen Erkenntnissen. Zu den Funktionen, die zur Benutzerfreundlichkeit beitragen, gehören:

- Klare und unkomplizierte Navigationsmenüs

- Drag-and-Drop-Funktionalitäten für die Workflow-Gestaltung

- Vorgefertigte Vorlagen für häufige Scraping-Aufgaben

- Schritt-für-Schritt-Assistenten führen die Erstkonfiguration durch

- Umfassende Dokumentation und Tutorials erleichtern das Lernen

Ein benutzerfreundliches Tool maximiert die Effizienz der Mitarbeiter und trägt zur Aufrechterhaltung eines hohen Produktivitätsniveaus bei.

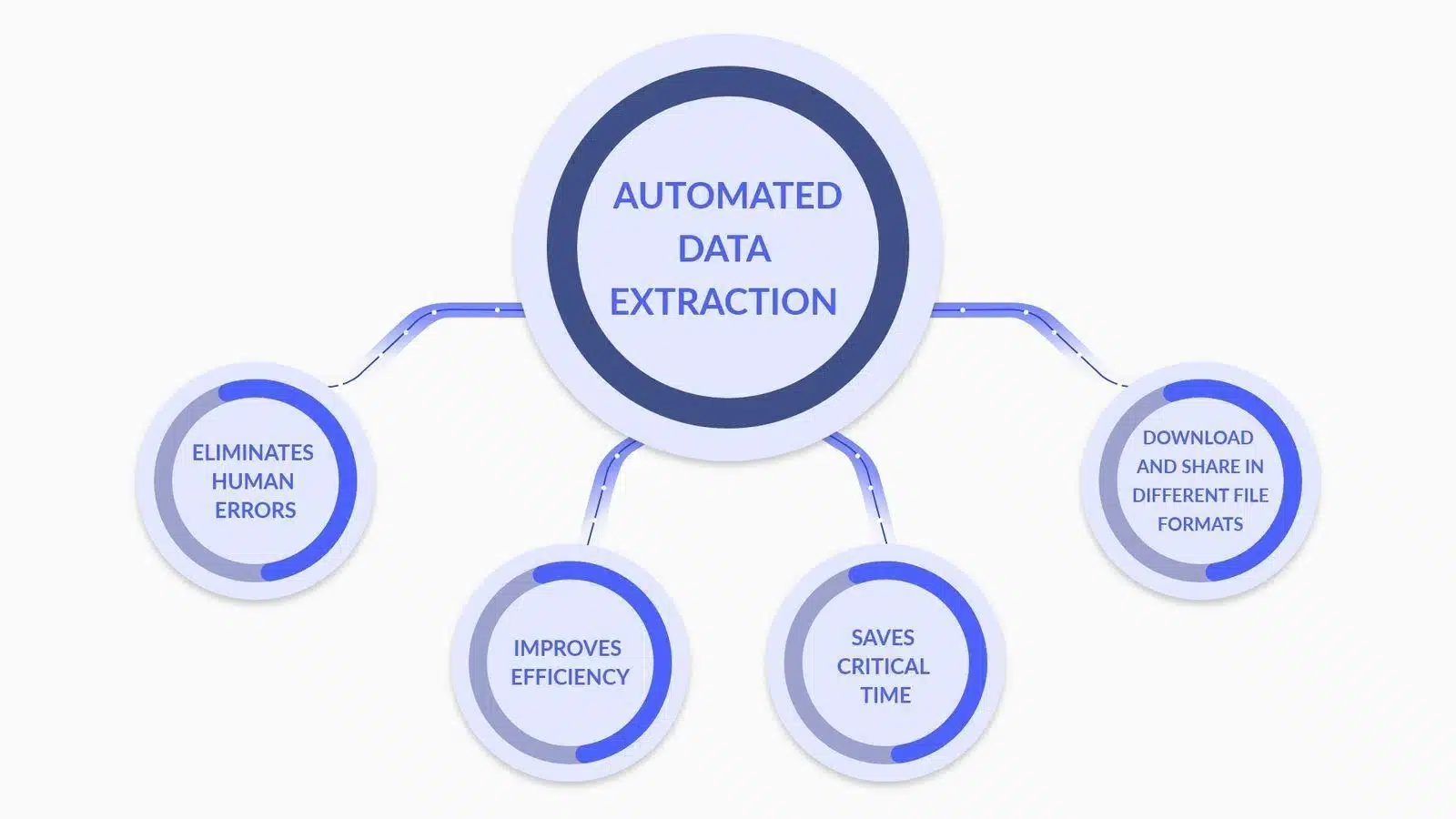

- Datenextraktionsfunktionen

Bildquelle: Was ist Datenextraktion? Hier ist, was Sie wissen müssen

Bei der Evaluierung automatisierter Web-Scraping-Tools sollten Unternehmen erweiterte Datenanalyse- und Transformationsfunktionen priorisieren, wie zum Beispiel:

- Benutzerdefinierte Datenanalyse : Die Möglichkeit, Parser anzupassen, um komplexe Datenstrukturen, einschließlich verschachtelter und dynamischer Inhalte, genau zu interpretieren.

- Datentypkonvertierung : Tools, die extrahierte Daten automatisch in verwendbare Formate (z. B. Datumsangaben, Zahlen, Zeichenfolgen) konvertieren, um eine effizientere Datenverarbeitung zu ermöglichen.

- Unterstützung regulärer Ausdrücke : Einbeziehung von Regex-Funktionen für einen anspruchsvollen Mustervergleich, der eine präzise Datenextraktion ermöglicht.

- Bedingte Transformation : Die Fähigkeit, bedingte Logik auf extrahierte Daten anzuwenden und so eine Transformation basierend auf bestimmten Kriterien oder Datenmustern zu ermöglichen.

- Datenbereinigung : Funktionen, die Daten in der Nachextraktionsphase bereinigen und standardisieren, um Datenqualität und -konsistenz sicherzustellen.

- API-Integration : Einrichtungen zur nahtlosen Integration mit APIs zur weiteren Verarbeitung und Analyse der extrahierten Daten, wodurch die Entscheidungsfähigkeit verbessert wird.

Jede Funktion trägt zu einem robusteren und genaueren Datenextraktionsprozess bei, der für Web-Scraping-Bemühungen auf Unternehmensebene von entscheidender Bedeutung ist.

- Skalierbarkeit und Leistung

Bei der Bewertung automatisierter Web-Scraping-Tools sollten Unternehmen Skalierbarkeit und Leistungsattribute priorisieren, die die effiziente Verarbeitung großer Datenmengen unterstützen.

Ein ideales Werkzeug kann einen erheblichen Anstieg der Arbeitsbelastung gekonnt bewältigen, ohne Kompromisse bei Geschwindigkeit oder Genauigkeit einzugehen. Unternehmen müssen nach Funktionen suchen wie:

- Multithreading-Funktionen ermöglichen die gleichzeitige Datenverarbeitung

- Effiziente Speicherverwaltung zur Bewältigung umfangreicher Scraping-Aufgaben

- Dynamische Zuweisung von Ressourcen basierend auf Echtzeitanforderungen

- Robuste Infrastruktur, die horizontal oder vertikal skaliert werden kann

- Erweiterte Caching-Mechanismen zur Beschleunigung des Datenabrufs

Die Fähigkeit des Tools, die Leistung unter Last aufrechtzuerhalten, gewährleistet eine zuverlässige Datenextraktion, selbst in Spitzenzeiten oder bei der Ausweitung des Betriebs.

- Unterstützung für verschiedene Datenformate

Bildquelle: Was ist Data Scraping? Definition und Verwendung

Ein automatisiertes Web-Scraping-Tool muss verschiedene Datenformate kompetent verarbeiten. Unternehmen arbeiten oft mit verschiedenen Datentypen und Flexibilität bei der Datenextraktion ist entscheidend:

- JSON: Ein leichtes Datenaustauschformat, das für Menschen leicht zu lesen und zu schreiben und für Maschinen leicht zu analysieren und zu generieren ist.

- CSV: Das durch Kommas getrennte Werteformat ist ein gängiges, einfaches Dateiformat für Tabellendaten. Die meisten Scraping-Tools sollten eine CSV-Exportoption bieten.

- XML: Extensible Markup Language, ein komplexeres Format, das Metadaten enthält und in einer Vielzahl von Branchen verwendet werden kann.

Die Möglichkeit, Daten in diesen Formaten zu extrahieren und zu exportieren, gewährleistet die Kompatibilität mit verschiedenen Datenanalysetools und -systemen und bietet eine vielseitige Lösung für Unternehmensanforderungen.

- Robustheit und Zuverlässigkeit

Wenn Unternehmen sich für automatisierte Web-Scraping-Tools entscheiden, müssen sie Robustheit und Zuverlässigkeit in den Vordergrund stellen. Zu den wichtigsten zu berücksichtigenden Merkmalen gehören:

- Umfassende Fehlerbehandlung : Ein überlegenes Tool sollte in der Lage sein, Fehler automatisch zu erkennen und zu beheben. Es sollte Probleme protokollieren und, wenn möglich, fehlgeschlagene Anfragen ohne manuelles Eingreifen wiederholen.

- Strategien zur Minimierung von Ausfallzeiten : Das Tool sollte Failover-Mechanismen wie Backup-Server oder alternative Datenquellen umfassen, um den Betrieb aufrechtzuerhalten, wenn Primärquellen ausfallen.

- Kontinuierliche Überwachungssysteme : Echtzeitüberwachung stellt sicher, dass Ausfallzeiten sofort erkannt und behoben werden, wodurch Datenlücken minimiert werden.

- Vorausschauende Wartung : Der Einsatz von maschinellem Lernen zur Vorhersage potenzieller Fehlerquellen kann Ausfallzeiten präventiv verhindern und das System zuverlässiger machen.

Die Investition in Tools, die diese Aspekte der Robustheit und Zuverlässigkeit hervorheben, kann die mit Web Scraping verbundenen Betriebsrisiken erheblich reduzieren.

- Integrationsfähigkeiten

Bei der Bewertung automatisierter Web-Scraping-Tools müssen Unternehmen ihre Fähigkeit zur reibungslosen Integration in aktuelle Datenpipelines gewährleisten. Dies ist wichtig, um die Kontinuität des Datenflusses aufrechtzuerhalten und den Prozess zu optimieren. Das Tool sollte:

- Bieten Sie APIs oder Konnektoren an, die mit vorhandenen Datenbanken und Analyseplattformen kompatibel sind.

- Unterstützt verschiedene Datenformate für nahtlosen Import/Export und sorgt so für minimale Unterbrechungen.

- Stellen Sie Automatisierungsfunktionen bereit, die durch Ereignisse innerhalb der Datenpipeline ausgelöst werden können.

- Ermöglichen Sie eine einfache Skalierung ohne umfangreiche Neukonfiguration, wenn sich die Datenanforderungen ändern.

- Compliance und rechtliche Überlegungen

Bei der Integration eines automatisierten Web-Scraping-Tools in den Unternehmensbetrieb ist es entscheidend, sicherzustellen, dass das Tool den rechtlichen Rahmenbedingungen entspricht. Zu den zu berücksichtigenden Funktionen gehören:

- Respekt vor Robots.txt : Das Tool sollte die robots.txt-Datei der Website, in der die Scraping-Berechtigungen aufgeführt sind, automatisch erkennen und befolgen.

- Ratenbegrenzung : Um eine störende Belastung der Host-Server zu vermeiden, müssen Tools über eine einstellbare Ratenbegrenzung verfügen, um die Häufigkeit von Anfragen zu steuern.

- Datenschutzkonformität : Das Tool sollte im Einklang mit globalen Datenschutzbestimmungen wie DSGVO oder CCPA entwickelt werden, um sicherzustellen, dass personenbezogene Daten rechtmäßig behandelt werden.

- Bewusstsein für geistiges Eigentum : Das Tool sollte über Mechanismen verfügen, um die Verletzung von Urheberrechten beim Scrapen urheberrechtlich geschützter Inhalte zu vermeiden.

- Benutzer-Agent-Transparenz : Die Fähigkeit des Scraping-Tools, sich gegenüber Zielwebsites genau und transparent zu identifizieren und so das Risiko betrügerischer Praktiken zu verringern.

Die Einbeziehung dieser Funktionen kann dazu beitragen, rechtliche Risiken zu mindern und eine verantwortungsvolle Scraping-Strategie zu ermöglichen, die sowohl proprietäre Inhalte als auch die Privatsphäre der Benutzer respektiert.

- Anpassung und Flexibilität

Um ihre individuellen Datenerfassungsanforderungen effektiv zu erfüllen, müssen Unternehmen die Anpassungsfähigkeiten und Flexibilität eines automatisierten Web-Scraping-Tools als entscheidende Faktoren bei der Bewertung berücksichtigen. Ein überlegenes Werkzeug sollte:

- Bieten Sie technisch nicht versierten Benutzern eine benutzerfreundliche Oberfläche zum Anpassen der Datenextraktionsparameter.

- Bieten Sie Entwicklern erweiterte Optionen zum Schreiben benutzerdefinierter Skripts oder zur Verwendung von APIs.

- Ermöglichen Sie eine einfache Integration in bestehende Systeme und Arbeitsabläufe im Unternehmen.

- Ermöglichen Sie die Planung von Scraping-Aktivitäten für die Ausführung außerhalb der Hauptverkehrszeiten, wodurch die Belastung der Server verringert und eine mögliche Drosselung der Website vermieden wird.

- Passen Sie sich an unterschiedliche Website-Strukturen und Datentypen an und stellen Sie sicher, dass ein breites Spektrum an Anwendungsfällen bearbeitet werden kann.

Anpassung und Flexibilität stellen sicher, dass sich das Tool mit den sich ändernden Anforderungen des Unternehmens weiterentwickeln kann, wodurch der Wert und die Wirksamkeit von Web-Scraping-Bemühungen maximiert werden.

- Erweiterte KI- und maschinelle Lernfunktionen

Bei der Auswahl eines automatisierten Web-Scraping-Tools müssen Unternehmen die Integration fortschrittlicher KI und maschinellem Lernen in Betracht ziehen, um die Datengenauigkeit zu verbessern. Zu diesen Funktionen gehören:

- Kontextbezogenes Verständnis : Die Anwendung der Verarbeitung natürlicher Sprache (NLP) ermöglicht es dem Tool, Kontexte zu erkennen und so Fehler in geschabten Inhalten zu reduzieren.

- Mustererkennung : Algorithmen für maschinelles Lernen identifizieren Datenmuster und erleichtern so die genaue Extraktion von Informationen.

- Adaptives Lernen : Das Tool lernt aus früheren Scraping-Aufgaben, um Datenerfassungsprozesse für zukünftige Aufgaben zu optimieren.

- Anomalieerkennung : KI-Systeme können Ausreißer oder Anomalien in den erfassten Daten erkennen und korrigieren und so die Zuverlässigkeit gewährleisten.

- Datenvalidierung : Der Einsatz von KI zur Gegenüberprüfung von Scraped-Daten mit mehreren Quellen erhöht die Gültigkeit von Informationen.

Durch die Nutzung dieser Fähigkeiten können Unternehmen Ungenauigkeiten in ihren Datensätzen erheblich verringern und so fundiertere Entscheidungen treffen.

- Technischer Support und Dokumentation

Für Unternehmen ist es ratsam, automatisierten Web-Scraping-Tools den Vorzug zu geben, die umfassende technische Unterstützung und eine gründliche Dokumentation bieten. Dies ist entscheidend für:

- Ausfallzeiten minimieren : Schneller, professioneller Support stellt sicher, dass alle Probleme schnell gelöst werden.

- Benutzerfreundlichkeit : Eine gut organisierte Dokumentation hilft bei der Benutzerschulung und der Werkzeugbeherrschung.

- Fehlerbehebung : Zugängliche Leitfäden und Ressourcen ermöglichen es Benutzern, häufig auftretende Probleme selbstständig zu beheben.

- Updates und Upgrades : Konsistenter Support und klare Dokumentation sind für die effektive Navigation durch Systemaktualisierungen und neue Funktionen von entscheidender Bedeutung.

Die Wahl eines Tools mit robustem technischen Support und klarer Dokumentation ist für einen reibungslosen Betrieb und eine effiziente Problemlösung von entscheidender Bedeutung.

- Bewertung der Kosteneffizienz des Tools

Unternehmen sollten bei der Bewertung von Automatisierungssoftware für Web Scraping sowohl die anfänglichen Kosten als auch den möglichen ROI berücksichtigen. Zu den wichtigsten Preisfaktoren gehören:

- Lizenzgebühren oder Abonnementkosten

- Wartungs- und Supportkosten

- Mögliche Kosteneinsparungen durch Automatisierung

- Skalierbarkeit und Anpassungsfähigkeit an zukünftige Anforderungen

Bei einer gründlichen ROI-Bewertung (Return on Investment) eines Tools sollte dessen Potenzial berücksichtigt werden, die manuelle Arbeit zu verringern, die Datengenauigkeit zu verbessern und den Prozess der Gewinnung von Erkenntnissen zu beschleunigen. Darüber hinaus sollten Unternehmen dauerhafte Vorteile wie eine verbesserte Wettbewerbsfähigkeit bewerten, die sich aus datenbasierten Entscheidungen ergeben. Wenn man diese Messungen mit den Kosten des Werkzeugs vergleicht, erhält man einen klaren Überblick über seine Kosteneffizienz.

Abschluss

Bei der Auswahl eines automatisierten Web-Scraping-Tools sollten Unternehmen jede Funktion sorgfältig im Hinblick auf ihre spezifischen Anforderungen abwägen. Es ist wichtig, Aspekte wie Skalierbarkeit, Datengenauigkeit, Geschwindigkeit, Legalität und Kosteneffizienz hervorzuheben. Das ideale Tool unterstützt die Unternehmensziele und lässt sich reibungslos in bestehende Systeme integrieren. Letztendlich ist eine fundierte Entscheidung das Ergebnis einer gründlichen Prüfung der Funktionen des Tools und eines soliden Verständnisses der zukünftigen Datenanforderungen des Unternehmens.