Das „Warum“ hinter großen SERP-Traffic-Einbrüchen in SaaS und darüber hinaus

Veröffentlicht: 2024-05-31Inhalt des Artikels

Ein Rückgang des Website-Traffics kann verschiedene Ursachen haben, darunter Keyword-Trends, Rebranding-Bemühungen und Strafen.

Einige Rückgänge werden jedoch durch schwer fassbare Änderungen des Suchalgorithmus ausgelöst, die Unternehmen vor allem im SaaS-Bereich nach Antworten ringen lassen. Diese Algorithmusaktualisierungen können tiefgreifende Auswirkungen haben und die Stabilität organischer Marketingstrategien erschüttern. Aktuelle Diskussionen wie dieser Tweet, der den spürbaren Traffic-Rückgang von ClickUp in den letzten Monaten hervorhebt, unterstreichen diese Bedenken.

Laut Ahrefs hat @clickup in zwei Monaten rund 50 % seines organischen Traffics verloren.

Sie stiegen von 1,9 Mio. Anfang Februar auf derzeit 900.000.

pic.twitter.com/xUDOKkNieo

– Nico Cerdeira (Failory.com) (@nicocerdeira) 2. Mai 2024

SaaS-Unternehmen und andere müssen wachsam und anpassungsfähig bleiben, um diese unvorhersehbaren Änderungen in den Suchmaschinenalgorithmen zu bewältigen und ihre Online-Sichtbarkeit aufrechtzuerhalten. Um das Wachstum aufrechtzuerhalten und die Fallstricke algorithmusbedingter Rückgänge zu vermeiden, ist es von entscheidender Bedeutung, die Feinheiten hinter diesen Verkehrsrückgängen zu verstehen.

Unsicherheit (und Kontroverse) in SEOland

Heutzutage herrscht im SEOland viel Unsicherheit und mehr als nur eine kleine Kontroverse. Dies ist nicht zuletzt darauf zurückzuführen, dass branchenübergreifend ein spürbarer Rückgang des gesamten Web-Traffics zu verzeichnen ist.

Laut dem 2024 Digital Experience Benchmark Report von Contentsquare betrug die gesamte Verkehrsveränderung im Jahresvergleich im vergangenen Jahr -3,6 %. Der Rückgang war in Branchen wie Dienstleistungen (-9,4 %), Energie, Versorgung und Baugewerbe (-8,3 %) sowie Software (-7,8 %) sogar noch ausgeprägter.

![Verkehrsveränderung im Jahresvergleich nach Branche [Contentsquare]](/uploads/article/23621/NXsGWAwvlNFBBqzK.png)

Von sozialen Plattformen und Foren bis hin zu Branchenveranstaltungen sind Vermarkter besonders besorgt über die goldene Gans des Web-Traffic-Wachstums: die organische Suche.

Marktanalysten und Forschungsunternehmen schätzen den Wert der globalen SEO-Branche auf etwa 70 bis 80 Milliarden US-Dollar . Große Softwareunternehmen, Agenturen und unzählige Fachleute sind in diesem Bereich tätig – ganz zu schweigen von all den Unternehmen, die auf diese Praxis angewiesen sind.

Es ist verständlich, dass die Menschen über die Entwicklung dieser Branche so besorgt sind.

Erforschen Sie das „Warum“ hinter großen Verkehrsverlusten im Technologiebereich und darüber hinaus

Eine der größten Herausforderungen für die SEO-Branche (und eigentlich jedes Unternehmen, das einen digitalen Fußabdruck benötigt) besteht darin, dass Suchmaschinen wie Google eine Black Box sind.

Wir können die Eingaben (die Abfragen, Websites und Webseiten) analysieren und die Ausgaben (die SERP-Position) verfolgen, aber es gibt für niemanden von außen die Möglichkeit, alles, was in Ranking-Entscheidungen einfließt, vollständig zu wissen. Und tausenden durchgesickerten Google Search API-Dokumenten zufolge ist der Technologieriese bei Ranking-Faktoren nicht ehrlich.

Google versucht, mit Feedback von Search Central oder Aussagen seines Verbindungspartners für die Suche und von Sprechern wie John Mueller Klarheit zu schaffen. Aber es gibt noch so viel, was wir nicht wissen. Glücklicherweise ist es bei Hunderttausenden von SEOs möglich, Informationen per Crowdsourcing zu sammeln.

Es gibt mehrere Hauptgründe, warum große Websites in der Technologie-, Medien- und anderen Branchen so große Störungen im organischen und allgemeinen Webverkehr erleben, die alle entweder mit den Maßnahmen von Google oder dem Aufkommen von KI zusammenhängen:

- Hilfreiche Inhalte, Reputationsmissbrauch und Google Core-Updates

- Die zunehmende Präsenz von benutzergenerierten Diskussions- und Foreninhalten

- Der Aufstieg KI-generierter Inhalte

- Das suchgenerative Erlebnis

Werfen wir jetzt einen Blick auf jedes davon.

Google Core-Updates

Laut Seach Central nimmt Google im Laufe eines Jahres mehrere „bedeutende, umfassende Änderungen an [ihren] Suchalgorithmen und -systemen“ vor. Es ist nicht ungewöhnlich, dass hochrangige Websites nach einem Core-Update SERP-Volatilität erfahren – selbst wenn „sie weder gegen die Spam-Richtlinien von [Google] verstoßen haben noch manuellen oder algorithmischen Maßnahmen unterzogen wurden“.

Erfahrene SEOs wissen seit über einem Jahrzehnt, dass es nach einem Core-Update oder einer anderen bedeutenden Änderung eine Phase der Korrektur gibt und dass sie nicht überreagieren sollten. Der Kollateralschaden korrigiert sich typischerweise im Laufe der Zeit (zumindest theoretisch) wieder.

Aber die Updates der letzten Jahre waren eine andere Geschichte.

Hilfreiche Inhaltsaktualisierung

Das erste „Hilfreiche Content Update“ (HCU) wurde im August 2022 ins Leben gerufen als Versuch, Inhalte, die hauptsächlich für ein gutes Ranking in Suchmaschinen erstellt wurden, anstatt den Benutzern zu helfen, automatisch zu identifizieren und gezielt darauf auszurichten. Dieses Update wurde Ende 2022 über die englischen Websites hinaus auf alle Sprachen ausgeweitet.

Im September 2023 aktualisierte Google das HCU erneut in einem zweiwöchigen Rollout, der einen „verbesserten Klassifikator“ mit wenigen Einzelheiten ermöglichte. Dieses Update führte zu erheblichen Ranking-Rückgängen für Websites in allen Branchen, von denen sich viele noch nicht erholt haben.

Kurzes Update zu Websites, die vom HCU(X) im September betroffen sind: Da wir nun zwei Wochen nach Beginn des Kernupdates vom März sind, habe ich die Sichtbarkeitszahlen für mehrere hundert Websites überprüft, die vom HCU(X) im September betroffen waren. Ich habe noch keinen gesehen, der sich erholt hat. Tatsächlich waren die meisten sogar noch stärker im Minus (siehe… pic.twitter.com/MPFPGZdu9u).

– Glenn Gabe (@glenngabe) 21. März 2024

Im März dieses Jahres hat Google das HCU in die zentralen Ranking-Systeme integriert, mit dem Ziel, nicht hilfreiche Inhalte von geringer Qualität um 40 % zu reduzieren. Berichten zufolge hat Google diesen Maßstab erreicht, aber es ist klar, dass auch viele unschuldige Zuschauer davon betroffen sind.

Spam-Update

Um die Analyse des Problems noch komplexer zu machen, fiel die Integration von HCU im März 2024 mit einer weiteren damit verbundenen Änderung am Google-Algorithmus zusammen: dem Spam-Update. Google hat dieses Update eingeführt, um „Spam-Inhalte von geringer Qualität“ zu bekämpfen, indem es auf drei manipulative Taktiken abzielt :

- Skalierter Inhaltsmissbrauch – Verwendung von Automatisierung (auch bekannt als KI oder Content Mills), um Inhalte massenhaft zu produzieren, die auf beliebte Suchanfragen abzielen.

- Missbrauch abgelaufener Domains – Kauf abgelaufener Domains und deren Umnutzung, um die Sichtbarkeit minderwertiger Inhalte zu erhöhen.

- Missbrauch der Site-Reputation – Nutzung hoher Site-Autorität und Markenreputation, um minderwertige Inhalte von Dritten für Ranking-Zwecke zu hosten.

Das Update zum Thema „Site Reputation Abuse“ hat im letzten Monat große Aufmerksamkeit erregt, insbesondere weil es eine Reihe angesehener Websites wie Reuters, The Washington Post, GQ und das Wall Street Journal betraf.

Glen Allsopp skizzierte in diesem Tweet das Ausmaß der ersten Auswirkungen des Updates:

Seit März habe ich 2.500 Coupon-bezogene Begriffe überwacht, um zu sehen, was Google mit seinem Update zum Website-Reputationsmissbrauch ändert.

Heute haben die manuellen Maßnahmen begonnen, und hier sind einige erste Erkenntnisse.

Ich habe viele Inhalte von Drittanbietern ohne Gutscheine verfolgt, die ich veröffentlichen wollte … pic.twitter.com/dCbPgOTD9Q

– Glen Allsopp (@ViperChill) 7. Mai 2024

Da die Volatilität nach dem Update in den letzten Jahren neue Höhen erreicht hat, ist es von entscheidender Bedeutung, dass Marken die Web- und SERP-Leistung aufmerksam überwachen.

Diskussionen und Foruminhalte

Der Aufbau einer Präsenz auf Forenplattformen wie Reddit und Quora ist ein wichtiger Bestandteil von Marketingaktivitäten wie Recherche, Inhaltsverteilung und Community-Engagement. Nun können Sie dieser Liste SERP-Sichtbarkeit hinzufügen.

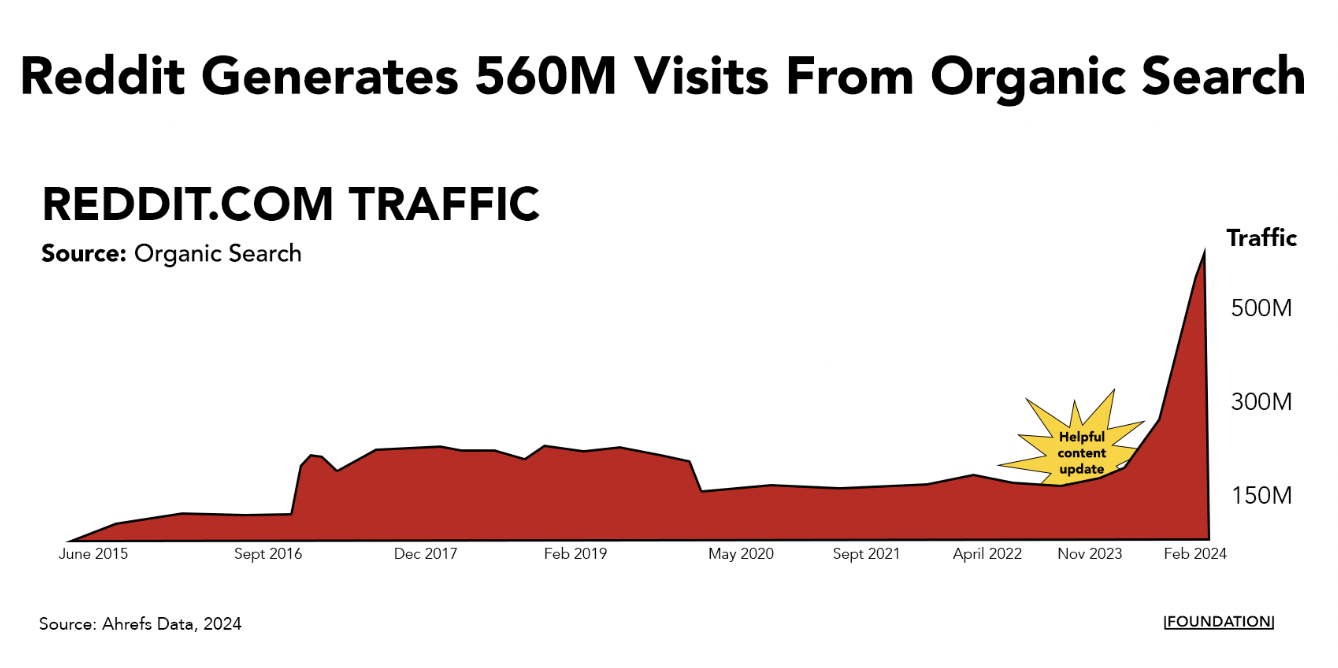

In den letzten Jahren haben Reddit und Quora begonnen, die Top-SERP-Positionen für verschiedene Suchanfragen zu dominieren. Während der organische Traffic für Unternehmens- und Medienseiten im letzten Jahr zurückgegangen ist, verzeichneten Reddit und Quora einen exponentiellen Anstieg des Traffics.

Allein Reddit generiert jeden Monat über 560 Millionen Besuche aus der organischen Suche und belegt mittlerweile bei fast 11 Millionen Keywords einen der ersten drei Plätze.

Dieser steile Anstieg deutet darauf hin, dass für diese Art beliebter Foren ein algorithmischer Vorteil im Spiel ist. Mike Sullivan, Verbindungsmann der Google-Suche, gab dies in einem Austausch mit Lily Ray auf X zu:

Diese Einheit wird automatisch angezeigt, wenn die Systeme sie für relevant und nützlich halten. Ich bin nicht so, als hätte jemand gesagt: „Stellen Sie es bei dieser bestimmten Abfrage an die erste Stelle“ – was Sie sicher verstehen, aber andere, die dies lesen, vielleicht nicht. Dennoch verstehe ich die Besorgnis und das Problem und habe …

– Google SearchLiaison (@searchliaison) 3. April 2024

Es ist sicherlich richtig, dass die Leute sich zu Forendiskussionen auf diesen Plattformen hingezogen fühlen, insbesondere wenn sie nach ungefilterten Meinungen zu Produkten und Dienstleistungen suchen. (Ich verwende Reddit und Quora ständig auf diese Weise.)

Allerdings gibt es viele Beispiele für Fälle, in denen das betreffende Thema eine erfahrenere Antwort verdient, als man sie in (meist) anonymen Reddit-Diskussionen erhält. Your Money or Your Life (YMYL)-Anfragen zum Beispiel zu wichtigen Gesundheits- und Finanzthemen.

Es ist auch möglich, dass kleinere Anpassungen des Algorithmus, der diese Art von Inhalten priorisiert, Reddit und Quora zugute kommen, weil sie über so große Websites und hohe Domain-Autorität verfügen.

Was auch immer der Grund sein mag, es sieht nicht so aus, als würde Google in naher Zukunft vor Foren zurückschrecken – sie haben gerade einen großen Deal mit Reddit angekündigt, bei dem sie die Daten der Plattform zum Trainieren ihrer KI nutzen werden. Dies ist nur einer von vielen Gründen , warum Sie auf der Plattform präsent sein müssen.

KI-generierte Inhalte

KI-generierte Inhalte eroberten die Welt im Sturm, kurz nachdem ChatGPT vor einigen Jahren den generativen KI-Boom auslöste. Sogar einige große SaaS-Marken wie CNET haben diese Strategie genutzt.

In dieser Zeit gab es alle möglichen Marketing- und Business-Gurus, die versuchten, SEO-Inhalte als Growth-Hacking-Taktik in Massen zu produzieren. Auf LinkedIn und

Eines der größten Beispiele hierfür war der SEO-Raub, bei dem jemand die Sitemap von einer Website namens Exceljet nahm, die URL-Liste in Artikeltitel umwandelte und dann mithilfe von KI über 1.800 Seiten zu genau denselben Themen generierte. Diese Strategie funktionierte überraschend gut, da die Raubseite auf Kosten von Exceljet Hunderttausende monatliche Besuche einbrachte.

Experten, die diese Strategie verfolgt haben, haben jedoch herausgefunden, dass die anfänglichen Gewinne, die Unternehmen durch KI-Inhalte erzielen, oft verschwinden.

Mark Williams-Cook hat beispielsweise den Aufstieg und Fall einer Reihe von Websites verfolgt, die SEO-Heist- oder KI-Skalierungsstrategien betrieben haben. Die meisten dieser Websites verzeichnen kurzfristig einen deutlichen Anstieg des organischen Traffics – normalerweise einige Monate, in einigen Fällen kann es aber auch länger dauern –, bevor ein starker Rückgang zu verzeichnen ist, der darauf hinweist, dass der Algorithmus erkannt hat.

Schönes @sistrix-Update der „SEO-Heist“-Website, die KI zur Erstellung von Inhalten verwendet hat. Es sieht so aus, als würde es bald an einem schlimmeren Ort enden als zu Beginn. pic.twitter.com/SKY2ViXiwV

— Mark Williams-Cook (@markcandour) 4. Dezember 2023

Wenn Sie also einen erheblichen Rückgang des Suchverkehrs feststellen, sollten Sie Folgendes berücksichtigen:

- Verwendet Ihr Unternehmen KI, um viele (wahrscheinlich minderwertige) SEO-Inhalte in großem Maßstab zu generieren?

- Tauchen genau in den SERPs, die Sie ansprechen möchten, neue Websites auf?

Wenn ersteres der Fall ist und Sie bereits in die Erstellung qualitativ hochwertiger Inhalte investieren, wird sich das Problem höchstwahrscheinlich mit der Zeit von selbst lösen. Wenn letzteres der Fall ist, ist es an der Zeit, Ihren KI-Content-Workflow zu verbessern .

Sie können die Inhaltsproduktion mit KI skalieren, aber es sollte darum gehen, Ihr Teamzu verstärkenund nicht zu ersetzen. Autoren können Tools wie ChatGPT, Jasper oder Gemini verwenden, um Ideenfindung, Recherche und Zwischenschritte zu optimieren und so mehr Zeit für kreatives Geschichtenerzählen zu haben.

Um potenzielle Strafen zu vermeiden und ein langfristiges Traffic-Wachstum aufrechtzuerhalten, stellen Sie sicher, dass Ihre KI-gestützten Inhalte einen echten Mehrwert bieten, einzigartige Erkenntnisse bieten und einen hohen Qualitätsstandard aufrechterhalten.

Sehen Sie sich unsere Checkliste zur KI-gestützten Inhaltserweiterung an , um eine Schritt-für-Schritt-Anleitung zur Erstellung hochwertiger Inhalte in großem Maßstab zu erhalten.

Generative Sucherfahrung

Spam-Inhalte und SEO-Raubangriffe sind nicht die einzigen Auswirkungen, die KI auf die SERPs hat. Die generative Engine-Optimierung wird sich voraussichtlich auf die Traffic-Zahlen auswirken, da die Menschen beginnen, KI anstelle herkömmlicher Suchmaschinen zu verwenden.

Google hat sich darauf bereits vorbereitet. Das Unternehmen kündigte eine neue KI-generierte Zusammenfassungsfunktion an, AI Overviews, die auf seinem eigenen LLM basiert. Die Markteinführung in den USA stößt derzeit auf sehr gemischte Kritiken .

Ein früher Bericht von Tomasz Rudzki und Ziptie.dev zeigt, dass die KI-Übersichten von Google im Durchschnitt in über 80 % der Suchanfragen auftauchen.

Die Studie hebt insbesondere hervor, dass einige Nischen wie FinTech möglicherweise sicherer vor AIOs sind als andere. Aber größtenteils dominieren die SGE-Antworten. Diese KI-generierten Antworten erscheinen automatisch in etwa einem Drittel der SERPs, während in der restlichen Zeit Benutzer darauf klicken müssen, um sie zu generieren.

Was bedeutet das alles für Marken? Es ist an der Zeit, dem Search Generative Experience (SGE) Priorität einzuräumen – Suchreisen, die dank KI immersiver und personalisierter sind als herkömmliche Reisen.

Obwohl sie sich stark von den herkömmlichen Google SERPs unterscheiden, enthalten Tools wie ChatGPT, Gemini und Perplexity die URLs der Websites, die sie zur Generierung von Ergebnissen verwenden.

Es ist noch zu früh, um genau zu sagen,wie sehrsich SGE/GEO vom traditionellen SEO unterscheiden wird, aber es gibt definitiv einige Ähnlichkeiten. Um SGE zu optimieren, sollten sich Unternehmen auf die Bereitstellung klarer, prägnanter und genauer Informationen konzentrieren, die von KI-Systemen leicht analysiert werden können. Dazu gehören strukturierte Daten, gut formatierte Antworten auf häufig gestellte Fragen und Inhalte, die direkt auf die Benutzerabsicht eingehen.

Seien Sie versichert, wir bei Foundation und der Rest der Branche werden dies in Zukunft genau beobachten.

Erweitern Sie Ihre Reichweite über die Suche hinaus mit einer Vertriebsmaschine

Die Landschaft der organischen Suche unterliegt aufgrund von Algorithmusaktualisierungen und dem Aufstieg der KI erheblichen Veränderungen – und die Besorgnis ist verständlich. Aber was noch wichtiger ist: Handeln.

Einerseits müssen sich Unternehmen anpassen, indem sie sich auf hochwertige, benutzerzentrierte Inhalte konzentrieren und die neuen Möglichkeiten nutzen, die KI-Technologien bieten. Obwohl die Auswirkungen der neuen KI-Overivews gerade erst zu spüren sind, ist es wichtig, Ihre Reichweite über herkömmliche Suchmethoden hinaus zu erweitern.

Investieren Sie in ein umfassendes Vertriebs-Playbook, um sicherzustellen, dass Sie Ihre Online-Präsenz in diesem sich entwickelnden Umfeld aufrechterhalten und ausbauen können.