Core Web Vitals „Keine Daten verfügbar“: Was es ist und nächste Schritte

Veröffentlicht: 2023-09-15Wenn Sie die Core Web Vitals Ihrer Website in PageSpeed Insights oder der Search Console überprüfen und statt farbenfroher Diagramme einen leeren Abschnitt sehen, ist das, als würden Sie gegen eine Mauer stoßen.

Das liegt daran, dass die Core Web Vitals von Google für Websitebesitzer unverzichtbar geworden sind, die nichtratenwollen, wie Nutzer eine Website erleben, sondern lieber Zahlen zur Untermauerung haben möchten.

Und genauer gesagt, die Nutzung von Daten über entscheidende Momente, wie zum Beispiel:

- Ladeleistung : gemessen am Largest Contentful Paint (LCP)

- Seiteninteraktivität : gemessen anhand der First Input Delay (FID)

- Layoutstabilität : gemessen durch Cumulative Layout Shift (CLS)

Darüber hinaus ist die Seitenerfahrung offiziell ein Ranking-Signal in der Google-Suche, sodass Sie mit einer bestandenen Core Web Vitals-Bewertung nicht nur mehr Menschen erreichen, sondern auch besser und schneller mit ihnen interagieren und sie konvertieren können.

Inwieweit wirken sich die fehlenden Core Web Vitals-Daten also auf Ihr Online-Geschäft aus? Um dieses Rätsel zu lösen, müssen Sie zunächst die Methodik hinter der Datenbeschaffung von Core Web Vitals verstehen.

Wie werden die Daten von Core Web Vitals bezogen?

Google verlässt sich beim Sammeln dieser wertvollen Daten hauptsächlich auf zwei Quellen: den Chrome User Experience (CrUX) Report und Lighthouse-Audits. Diese Quellen bieten Einblicke darüber, was Websitebesitzer tun können, um das Benutzererlebnis weiter zu verbessern.

CrUX Report vs. Lighthouse

DerCrUX-Bericht (Chrome User Experience) ist eine reichhaltige Quelle realer Benutzererfahrungsdaten.Es sammelt Felddaten von Millionen von Chrome-Nutzern, während sie im Internet navigieren. Dieser umfangreiche Datensatz umfasst ein breites Spektrum von über 16 Millionen Ursprüngen und ist somit eine wertvolle Ressource für das Verständnis der breiteren Web-Performance-Landschaft.

Im Gegensatz dazu istLighthouse ein von Google entwickeltes Open-Source-Tool, mit dem Labortests zur Webleistung durchgeführt werden.Es simuliert Benutzerinteraktionen in einer kontrollierten Umgebung und liefert detaillierte Leistungsmetriken.

Felddaten vs. Labordaten

Sowohl Feld- als auch Labordaten werden in Ihrem Google PageSpeed Insights-Bericht dargestellt.

Felddaten werden aus den Erfahrungen realer Benutzer abgeleitet, wenn diese Ihre Website im Rahmen ihrer täglichen Online-Aktivitäten besuchen. Diese Daten spiegeln die tatsächliche Leistung der Benutzer wider und bieten eine echte Einschätzung der Benutzererfahrung einer Website.

Die fehlenden Felddaten, dargestellt durch die Core Web Vitals-Bewertung in Ihrem Bericht, sind der Grund, warum Sie diesen Artikel lesen.

Labordaten werden in kontrollierten Testumgebungen generiert. Zwar ermöglicht es Website-Eigentümern, spezifische Leistungsengpässe zu identifizieren und zu beheben, es erfasst jedoch nicht die Variationen und Nuancen der realen Nutzung.

Vor- und Nachteile von Felddaten

Felddaten, die aus dem CrUX-Bericht stammen, bieten mehrere Vorteile, aber auch einige Einschränkungen.

Ein wesentlicher Vorteil ist seine Authentizität. Da es tatsächliche Benutzererfahrungen darstellt, bietet es eine realistische Sicht auf die Leistung einer Website aus Benutzerperspektive. Dies kann von unschätzbarem Wert sein, um kritische Probleme zu identifizieren, die sich auf die Benutzerzufriedenheit auswirken.

Das Nichtbestehen Ihrer Core Web Vitals-Bewertung ist ein verräterisches Zeichen dafür, dass Sie Ihre Aufmerksamkeit auf die Leistung Ihrer Website richten müssen, wenn Sie Vorteile wie die folgenden nutzen möchten:

- 8,6 % mehr Seiten, die in einer Sitzung aufgerufen wurden

- 5,2 % Verbesserung der Kundenbindung

- 8,4 % mehr Conversions

- Steigerung des durchschnittlichen Bestellwerts (AOV) um 9,2 %

Sehen Sie sich das Vorher und Nachher einer leistungsstarken Geschwindigkeitsoptimierung an. Testen Sie Ihre Website kostenlos mit NitroPack →

Zu den Nachteilen von Felddaten auf Core Web Vitals gehören:

- Möglicherweise keine aggregierten Daten (duh)

- Unzureichende Granularität, um die Grundursachen von Leistungsproblemen zu ermitteln (sofern nicht mit einer weiteren Analyse gekoppelt)

- Kleines Optimierungsfenster, da die Ergebnisse von Core Web Vitals alle 28 Tage aktualisiert werden

Dennoch überwiegen die Vorteile der Analyse von Felddaten und der Optimierung von Core Web Vitals für Ihr Unternehmen die Nachteile deutlich.

Warum sind die Felddaten von Core Web Vitals für meine Website nicht verfügbar?

Wenn Sie in der Google Search Console keine Daten für Ihre Core Web Vitals sehen, kann es sein, dass Ihre Property neu ist und die Konsole noch die CrUX-Datenbank überprüft.

Nicht Ihr Fall? Nun, lassen Sie uns genauer nachforschen.

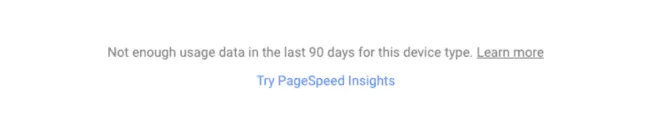

Wenn Sie auf den Tooltip neben der Meldung „Keine Daten verfügbar“ in Ihrer Google Search Console oder Ihrem Google PSI-Bericht klicken, wird Folgendes angezeigt:

„Der Chrome User Experience Report verfügt nicht über genügend reale Geschwindigkeitsdaten für diese Seite.“

Einfach ausgedrückt: Sie sehen keine Felddaten, weil Ihre Website nicht genügend Traffic auf dem Desktopund/oder Mobilgerät generiert hat.Es lohnt sich immer, beide Instanzen zu prüfen, da sie separat bezogen werden.

Sie denken also vielleicht, dass die Steigerung Ihres Website-Traffics das Problem beheben sollte, oder?

Ganz so einfach ist es nicht.

Der CrUX-Bericht aggregiert reale Geschwindigkeitsdaten für Herkunftsorte unter Einhaltung mehrerer wesentlicher Anforderungen:

- Benutzer haben der Synchronisierung ihres Browserverlaufs zugestimmt, keine Synchronisierungs-Passphrase eingerichtet und die Nutzungsstatistikberichte aktiviert;

- Die URLs Ihrer Website sind öffentlich (crawlbar und indexierbar);

- Ihre Website ist ausreichend beliebt (sie hat auf allen Seiten eine Mindestanzahl an Besuchern) und verfügt über eindeutige Beispiele, die einen repräsentativen, anonymisierten Überblick über die Leistung der URL oder des Ursprungs bieten.

Bereits im Jahr 2021 stellte Martin Splitt von Google weiter klar:

Und selbst wenn wir über einige Daten verfügen, reicht es möglicherweise nicht aus, mit Sicherheit zu sagen, dass dies die Daten sind, von denen wir glauben, dass sie das tatsächliche Signal darstellen. Daher könnten wir uns dafür entscheiden, tatsächlich kein Signal dafür zu haben, wenn die Datenquelle zu unbeständig oder die Daten zu verrauscht sind.

… Mehr Verkehr führt eher dazu, dass Daten schnell generiert werden, aber das ist keine Garantie.“

Soviel zum Hoffen auf konkrete Zahlen.

Sie sollten auch bedenken, dass eine Website möglicherweise niemals Teil des CrUX-Datensatzes wird. Wenn Sie darüber nachdenken, verfolgt CrUX 16 Millionen Ursprünge. Scheint viel zu sein, oder?

Allerdings ist der CrUX-Datensatz im Vergleich zu den 1,13 Milliarden Websites im heutigen Internet nur ein kleiner Bruchteil.

Zusammenfassen:

- Die Google Search Console benötigt möglicherweise mehr Zeit, um einen Core Web Vitals-Bericht für neue Eigenschaften zu erstellen (wenn Ihre Website im CrUX-Bericht erscheint).

- Brandneue Websites mit wenig bis gar keinem Traffic haben die geringste Chance, in den CrUX-Datensatz aufgenommen zu werden

- Um für den CrUX-Bericht in Frage zu kommen, müssen Websites bestimmte Anforderungen an Benutzer und URL-Auffindbarkeit erfüllen

- Seiten und Ursprünge, die den Beliebtheitsschwellenwert nicht erreichen, werden nicht in den CrUX-Datensatz aufgenommen

Obwohl Google nicht garantieren kann, dass Ihre Website in den CrUX-Datensatz aufgenommen wird, sodass Sie Ihre Core Web Vitals anhand von Felddaten analysieren können, bedeutet dies nicht, dass Ihnen die Hände gebunden sind.

Optimieren Sie die Seitengeschwindigkeit und verbessern Sie die Benutzererfahrung mit einem einzigen Tool. Beginnen Sie noch heute mit NitroPack →

So verbessern Sie die wichtigsten Web-Vitalwerte und die Leistung ohne Felddaten

Bis der CrUX-Bericht lesbare Daten liefert, können Sie sich auf alternative Methoden wie die Überwachung anderer Leistungs-, Server- und Netzwerkmetriken, Leistungsprüfungen mit GTmetrix und die Analyse von Benutzerfeedback und -verhalten konzentrieren.

Finden Sie am Ende einen Bonustipp, den die meisten Websitebesitzer nicht nutzen ;)

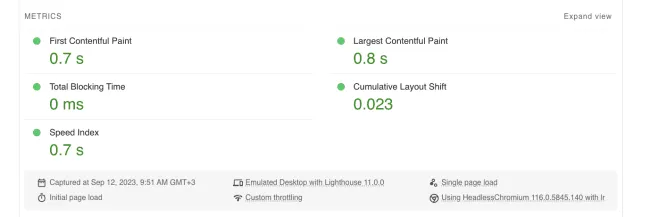

1. Überwachen Sie die Laborleistungsmetriken in Google PageSpeed Insights

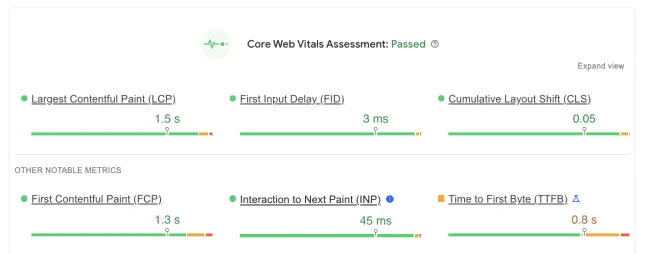

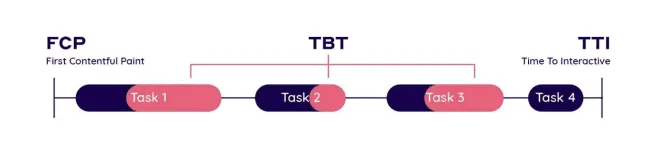

Wenn Felddaten fehlen, besteht Ihr nächstbester Schritt darin, in Ihrem Google PSI-Bericht nach unten zu scrollen und mit den laborbasierten Äquivalenten von Largest Contentul Paint (LCP) und Cumulative Layout Shift (CLS) zu beginnen. Da es für die First Input Delay kein laborbasiertes Äquivalent gibt, ist die Total Blocking Time neben First Contentful Paint (FCP) und Speed Index (SI) eine weitere Kennzahl, auf die man sich konzentrieren sollte.

- Total Blocking Time (TBT):TBT misst die Gesamtzeit, während der der Hauptthread einer Webseite blockiert ist und nicht auf Benutzereingaben reagieren kann. Es hilft dabei, Probleme zu identifizieren und zu beheben, die die Interaktivität beeinträchtigen können, wie z. B. verzögerte Klicks oder Tastatureingaben. Um ein reibungsloses Benutzererlebnis zu gewährleisten, sollte die TBT unter 300 Millisekunden (ms) gehalten werden.

Um TBT zu reduzieren, können Sie:

– Minimieren oder verschieben Sie nicht unbedingt erforderliches JavaScript;

— Optimieren und begrenzen Sie die Verwendung von Skripten Dritter;

— Nutzen Sie Web-Worker, um schwere Aufgaben auszulagern;

— Implementieren Sie asynchrones Laden für Skripte.

- First Contentful Paint (FCP):FCP misst die Zeit, die es dauert, bis der erste Inhalt auf einer Webseite erscheint, wenn diese geladen wird. Es handelt sich um eine wichtige benutzerorientierte Kennzahl, da sie angibt, wann Benutzer zum ersten Mal etwas auf Ihrer Seite sehen. Für eine gute Benutzererfahrung sollte FCP normalerweise innerhalb von 1 bis 2 Sekunden nach Beginn des Seitenladevorgangs erfolgen.

Um First Contentful Paint zu verbessern, sollten Sie:

— Reduzieren Sie die Antwortzeiten des Servers;

– Rendering-blockierende Ressourcen minimieren;

– Verwenden Sie Lazy Loading für nicht unbedingt erforderliche Ressourcen.

— Reduzieren Sie die Ausführungszeit von JavaScript.

- Geschwindigkeitsindex: Diese Metrik quantifiziert, wie schnell der Inhalt einer Webseite sichtbar bevölkert wird. Ein niedrigerer Geschwindigkeitsindex weist auf schnellere Seitenladezeiten hin, und Sie sollten einen Geschwindigkeitsindexwert von weniger als 1.000 anstreben.

So verbessern Sie den Geschwindigkeitsindex Ihrer Website:

— Bilder und andere Mediendateien optimieren und komprimieren;

— Minimieren Sie die Verwendung großer Bilder, die über dem Falz liegen.

— Implementieren Sie die Codeaufteilung, um beim ersten Laden der Seite nur das erforderliche JavaScript zu laden.

Erzielen Sie einen Leistungswert von über 90 in Google PSI. NitroPack wendet für Sie über 35 Optimierungen auf den Autopiloten an →

2. Führen Sie eine Leistungsanalyse mit GTmetrix durch

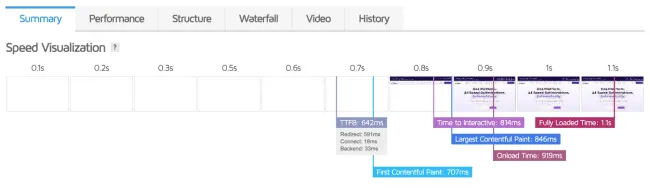

GTmetrix bietet einen umfangreicheren Satz an Leistungsmetriken und Anpassungsoptionen, die Ihnen beim Aufbau einer besseren Optimierungsstrategie helfen.

- Time to First Byte (TTFB):TTFB misst die Zeit, die der Browser benötigt, um nach einer HTTP-Anfrage das erste Byte an Daten vom Webserver zu empfangen. Dies ist eine entscheidende Kennzahl, da sie die Antwortzeiten des Servers widerspiegelt, einschließlich DNS-Auflösung, Serververarbeitung und Netzwerklatenz. Für ein gutes Benutzererlebnis sollten Sie eine TTFB von unter 100 bis 200 Millisekunden anstreben.

Um TTFB zu reduzieren:

— Optimieren Sie die Server- und Datenbankleistung;

— Content Delivery Networks (CDNs) nutzen;

— Minimieren Sie die Anzahl der HTTP-Anfragen;

— Implementieren Sie Browser-Caching für häufig angeforderte Ressourcen.

- Time to Interactive (TTI):Der TTI misst, wann eine Webseite vollständig interaktiv wird und auf Benutzereingaben reagiert, d. h. wenn eine Seite für Benutzer zur Interaktion bereit ist. TTI sollte idealerweise innerhalb von 3 bis 5 Sekunden erfolgen, um ein nahtloses Benutzererlebnis zu gewährleisten.

Im Allgemeinen sollten Sie bei der Implementierung von Techniken zur Verbesserung der TBT auch deutliche Verbesserungen bei der TTI feststellen.

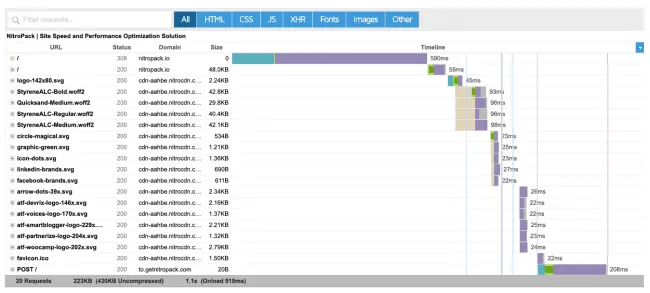

Ressourcenlademetriken (Wasserfall): Diese Metriken umfassen die Ladezeiten bestimmter Ressourcen wie Bilder, Stylesheets, Schriftarten und Skripte. Die Überwachung dieser Daten in einem Wasserfalldiagramm hilft, Engpässe in der Ladesequenz zu erkennen.

Obwohl es keine spezifischen Schwellenwerte gibt, sollten Sie versuchen, die Ladezeiten kritischer Ressourcen, die über dem Falz erscheinen, zu minimieren, um insgesamt einen schnelleren Seitenladevorgang zu erreichen.

So verbessern Sie die Ladezeiten von Ressourcen:

— Bilder komprimieren und moderne Bildformate wie WebP verwenden;

— CSS- und JavaScript-Dateien optimieren und konsolidieren;

— Beschleunigen Sie das Laden von Ressourcen mit Prioritätshinweisen, fetchpriority und link=rel_preload

- Onload-Zeit: Die Onload-Zeit markiert den Punkt, an dem alle Seitenressourcen, einschließlich Bilder und Skripte, geladen werden. Streben Sie für ein optimales Benutzererlebnis eine Ladezeit von bis zu 3 Sekunden an. Die Onload-Zeit wird durch Ihre Optimierungsbemühungen bei allen anderen bisher besprochenen Metriken beeinflusst und spiegelt wider, wie gut Sie abschneiden.

- Vollständig geladene Zeit: Die vollständig geladene Zeit misst den vollständigen Ladevorgang, dh wann alle Ressourcen auf einer Webseite, einschließlich Bildern, Skriptenund externen Inhalten, vollständig geladen sind. Ähnlich wie bei der Onload-Zeit handelt es sich hierbei um die Summe aller anderen vorangehenden Metriken und deren Optimierung.

Lazy Loading, WebP-Konvertierung, integriertes CDN, Caching und mehr! Finden Sie in NitroPack → alles, was Sie für schnellere Ladezeiten benötigen

3. Achten Sie auf Server- und Netzwerkmetriken

- Servermetriken: Serverseitige Metriken wie CPU-Auslastung, Speichernutzung und Serverantwortzeiten bieten Einblicke in den Zustand und die Leistung Ihrer Hosting-Infrastruktur. Diese Metriken sind wichtig, um zu verstehen, wie effizient Ihr Server eingehende Anfragen verarbeitet und Daten verarbeitet.

Verbesserungen wie Servercode- und Skriptoptimierung, effiziente Algorithmen und Caching-Mechanismen sowie die Skalierung Ihrer Hosting-Infrastruktur tragen dazu bei, die CPU-Auslastung zu reduzieren. Regelmäßige Serverkonfiguration und Anwendungsoptimierungen minimieren den Speicherverbrauch. - Netzwerkmetriken: Netzwerkmetriken beziehen sich auf die Leistung der Datenübertragung über Netzwerke, einschließlich Metriken wie der Umlaufzeit (RTT). Sie helfen bei der Diagnose von Problemen im Zusammenhang mit dem Serverstandort, der Netzwerklatenz und der Datenübertragungseffizienz.

Wählen Sie Hosting-Anbieter mit Rechenzentren, die näher an Ihrer Zielgruppe liegen, implementieren Sie Content-Caching, optimieren Sie die Ressourcen Ihrer Website und investieren Sie in einen CDN-Anbieter, um die Netzwerklatenz zu reduzieren und die Effizienz der Datenübertragung zu verbessern

Optimieren Sie die Ressourcennutzung und eliminieren Sie den Server-Overhead mit den All-in-One-Geschwindigkeitsoptimierungen von NitroPack →

4. Analysieren Sie Benutzerfeedback und -verhalten

- Umfragen und Feedback-Formulare: Erstellen Sie benutzerfreundliche Umfragen und Feedback-Formulare, um strukturiertes Feedback zu sammeln. Stellen Sie spezifische Fragen zur Benutzererfahrung, Zufriedenheit und Schwachstellen. Verwenden Sie Tools wie Google Forms, SurveyMonkey oder spezielle Website-Feedback-Plugins.

- Heatmaps: Verwenden Sie Heatmapping-Tools wie Hotjar oder Crazy Egg, um Benutzerinteraktionen zu visualisieren. Identifizieren Sie, wo Benutzer klicken, ihren Cursor bewegen oder die meiste Zeit auf Ihrer Website verbringen. Heatmaps zeigen beliebte und problematische Bereiche auf Webseiten.

- Sitzungsaufzeichnung: Zeichnen Sie Benutzersitzungen auf, um zu sehen, wie Besucher auf Ihrer Website navigieren und mit ihr interagieren. Sehen Sie sich Aufzeichnungen an, um Usability-Probleme, Verwirrung oder Frustrationspunkte zu erkennen. Tools wie FullStory bieten Sitzungsaufzeichnungsfunktionen.

- Interaktionen mit dem Kundensupport: Ihre Kundendienstmitarbeiter sind oft der erste Ansprechpartner und die Quelle unschätzbarer Erkenntnisse. Überprüfen Sie CS-Interaktionen, einschließlich E-Mails, Chats und Telefonanrufe, um wiederkehrende Probleme, Benutzerbeschwerden und häufige Fragen zu identifizieren.

5. Bonus: Starten Sie Ihr erstes Web-Performance-Budget

Ein Web-Performance-Budget ist eine vorgegebene Grenze für verschiedene Leistungsmetriken, die Ihre Website einhalten sollte. Zu diesen Kennzahlen können Ladezeiten, Seitengröße, Anzahl der HTTP-Anfragen und mehr gehören. Das Budget dient als Maßstab und legt klare Grenzen für die Leistung Ihrer Website fest, um ein optimales Benutzererlebnis zu gewährleisten.

Hier sind ein paar einfache Schritte, die Ihnen den Einstieg in Ihr erstes Web-Performance-Budget erleichtern:

- Definieren Sie Schlüsselmetriken: Identifizieren Sie die Leistungsmetriken, die für Ihre Website am wichtigsten sind (beginnen Sie mit einer der bisher besprochenen Labormetriken).

- Setzen Sie Maßstäbe: Listen Sie zunächst Ihre aktuellen Ergebnisse auf und versuchen Sie, diese zu senken, um die Erwartungen Ihrer Benutzer und Branchenstandards zu erfüllen.

- Regelmäßig überwachen: Verwenden Sie Google PSI und GTmetrix, um die Leistung Ihrer Website regelmäßig im Vergleich zu Ihrem festgelegten Budget zu messen und zu verfolgen.

- Effektiv optimieren: Wenn Ihre Website die budgetierten Schwellenwerte überschreitet, verwenden Sie die zuvor beschriebenen Techniken oder sehen Sie sich den Abschnitt „Diagnose“ in PageSpeed Insights an.

Optimierung der Website-Leistung mit NitroPack

Mit oder ohne Felddaten bleibt die Suche nach einer schnelleren und reaktionsfähigeren Benutzererfahrung ein lohnenswerter Weg.

Sie müssen es jedoch nicht alleine schaffen. Über 180.000 Websitebesitzer wie Sie delegieren die Leistungsoptimierung an das umfassendste Tool auf dem Markt – NitroPack.

Mit erweiterten Funktionen, die per Autopilot arbeiten, können Sie Bilder, Code und Schriftarten optimieren, um ein blitzschnelles Benutzererlebnis zu bieten und Ihr Unternehmen nachhaltig auszubauen.