Effektive Web-Crawling-Techniken für Big-Data-Anwendungen

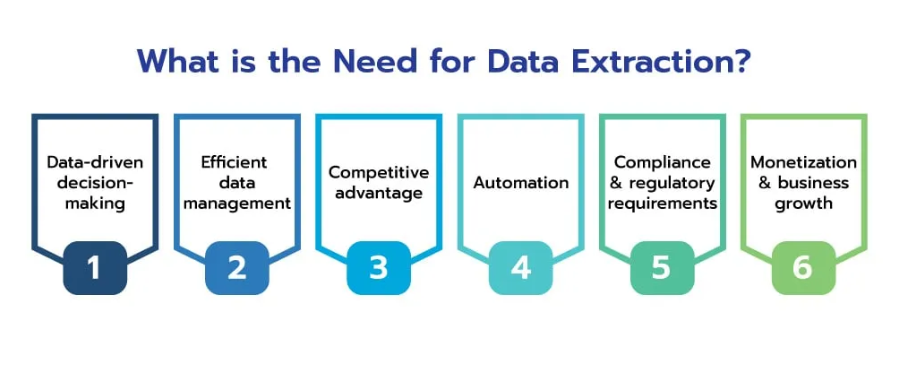

Veröffentlicht: 2024-06-06Im Zeitalter von Big Data hat sich das Crawlen von Websites zu einem unverzichtbaren Prozess für Unternehmen entwickelt, die die enorme Fülle an online verfügbaren Informationen nutzen möchten. Durch die effiziente Erfassung, Verarbeitung und Analyse von Webdaten in großem Maßstab können Unternehmen wertvolle Erkenntnisse gewinnen und sich branchenübergreifend einen Wettbewerbsvorteil verschaffen.

Webdaten bergen ein enormes Potenzial und bieten tiefe Einblicke in Markttrends, Verbraucherverhalten und Wettbewerbslandschaften. Die Fähigkeit, diese Daten effizient zu sammeln und zu analysieren, kann Rohinformationen in verwertbare Informationen umwandeln und so die strategische Entscheidungsfindung und das Geschäftswachstum vorantreiben.

Quelle: scrapehero

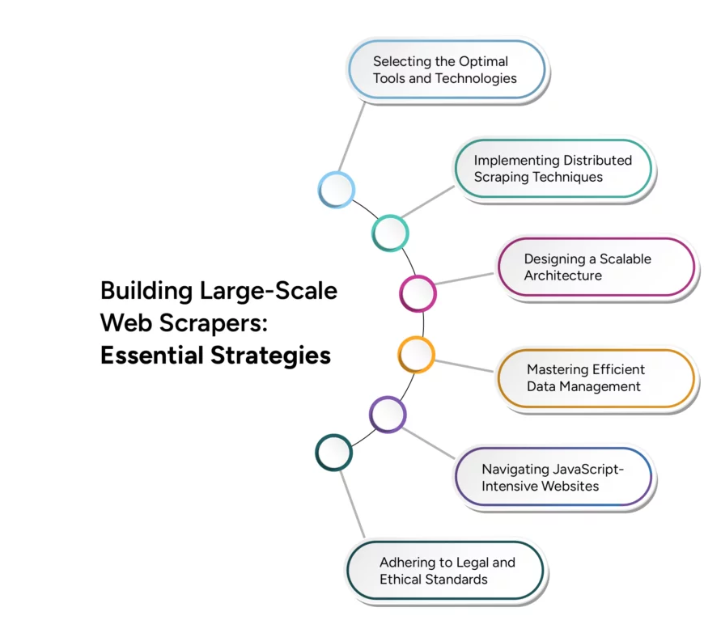

Der Übergang vom Web-Scraping im kleinen Maßstab zum Web-Crawling im großen Maßstab bringt jedoch erhebliche technische Herausforderungen mit sich. Eine effektive Skalierung erfordert die sorgfältige Berücksichtigung verschiedener Faktoren, einschließlich Infrastruktur, Datenverwaltung und Verarbeitungseffizienz. Dieser Artikel befasst sich mit fortgeschrittenen Techniken und Strategien, die zur Bewältigung dieser Herausforderungen erforderlich sind, um sicherzustellen, dass Ihre Web-Crawling-Vorgänge wachsen können, um den Anforderungen von Big-Data-Anwendungen gerecht zu werden.

Herausforderungen beim Crawlen von Websites für Big-Data-Anwendungen

Das Crawlen von Websites für Big-Data-Anwendungen stellt mehrere erhebliche Herausforderungen dar, die Unternehmen bewältigen müssen, um die Leistungsfähigkeit umfangreicher Online-Informationen effektiv zu nutzen. Das Verständnis und die Bewältigung dieser Herausforderungen ist für den Aufbau einer robusten und skalierbaren Web-Crawling-Infrastruktur von entscheidender Bedeutung.

Eine der größten Herausforderungen ist die schiere Menge und Vielfalt der Daten im Internet, die weiterhin exponentiell wachsen. Darüber hinaus erhöht die Vielfalt der Datentypen, von Text und Bildern bis hin zu Videos und dynamischen Inhalten, die Komplexität des Crawling-Prozesses für Websites. Moderne Websites verwenden häufig dynamische Inhalte, die durch JavaScript und AJAX generiert werden, was es schwierig macht

herkömmliche Crawler, um alle relevanten Informationen zu erfassen. Darüber hinaus können Websites Geschwindigkeitsbegrenzungen festlegen oder IP-Adressen blockieren, um übermäßiges Crawlen zu verhindern, was die Datenerfassung beeinträchtigen kann.

Die Gewährleistung der Datengenauigkeit und -konsistenz der aus verschiedenen Quellen gesammelten Daten kann schwierig sein, insbesondere beim Umgang mit großen Datensätzen. Die Skalierung von Web-Crawling-Vorgängen zur Bewältigung steigender Datenmengen ohne Leistungseinbußen ist eine große technische Herausforderung. Darüber hinaus ist die Einhaltung rechtlicher und ethischer Richtlinien beim Crawlen von Websites von entscheidender Bedeutung, um potenzielle rechtliche Probleme zu vermeiden und einen guten Ruf zu wahren. Eine effiziente Verwaltung der Rechenressourcen, um Crawling-Geschwindigkeit und Kosteneffizienz in Einklang zu bringen, ist ebenfalls von entscheidender Bedeutung.

Techniken zur effizienten Datenextraktion

Durch die Implementierung fortschrittlicher Datenextraktionstechniken wird sichergestellt, dass die gesammelten Daten relevant, genau und für die Analyse bereit sind. Hier sind einige Schlüsseltechniken zur Verbesserung der Effizienz der Datenextraktion:

- Parallele Verarbeitung : Nutzen Sie die parallele Verarbeitung, um Datenextraktionsaufgaben auf mehrere Threads oder Maschinen zu verteilen. Dadurch wird die Geschwindigkeit der Datenextraktion erhöht, indem mehrere Anfragen gleichzeitig verarbeitet werden, und die Gesamtzeit für die Datenerfassung wird reduziert.

- Inkrementelles Crawling : Implementieren Sie inkrementelles Crawling, um nur die Teile des Datensatzes zu aktualisieren, die sich seit dem letzten Crawl geändert haben, wodurch die Menge der verarbeiteten Daten und die Belastung der Webserver reduziert werden, wodurch der Crawling-Prozess effizienter und weniger ressourcenintensiv wird.

- Headless-Browser : Verwenden Sie Headless-Browser wie Puppeteer oder Selenium zum Rendern und Interagieren mit dynamischen Webinhalten. Dies ermöglicht die genaue Extraktion von Daten von Websites, die stark auf JavaScript und AJAX angewiesen sind, und gewährleistet so eine umfassende Datenerfassung.

- Inhaltspriorisierung : Priorisieren Sie Inhalte nach Relevanz und Wichtigkeit, konzentrieren Sie sich zuerst auf hochwertige Daten, stellen Sie sicher, dass die kritischsten Daten zeitnah erfasst werden, und optimieren Sie die Ressourcennutzung und Datenrelevanz.

- URL-Planungs- und Höflichkeitsrichtlinien : Implementieren Sie intelligente URL-Planungs- und Höflichkeitsrichtlinien, um die Häufigkeit von Anfragen an einen einzelnen Server zu verwalten, eine Überlastung von Webservern zu verhindern, das Risiko einer IP-Blockierung zu verringern und einen dauerhaften Zugriff auf Datenquellen sicherzustellen.

- Datendeduplizierung : Nutzen Sie Datendeduplizierungstechniken, um doppelte Einträge während des Extraktionsprozesses zu eliminieren, die Datenqualität zu verbessern und den Speicherbedarf zu reduzieren, indem sichergestellt wird, dass nur eindeutige Daten gespeichert und verarbeitet werden.

Echtzeit-Web-Crawling-Lösungen

Quelle: Mittel

In der heutigen schnelllebigen digitalen Landschaft ist die Fähigkeit, Daten in Echtzeit zu extrahieren und zu verarbeiten, unerlässlich

entscheidend für Unternehmen, die sich einen Wettbewerbsvorteil sichern wollen. Web-Crawling-Lösungen in Echtzeit ermöglichen eine kontinuierliche und sofortige Datenerfassung und ermöglichen sofortige Analysen und Maßnahmen. Durch die Implementierung einer ereignisgesteuerten Architektur können die Echtzeitfunktionen erheblich verbessert werden, wobei Crawler durch bestimmte Ereignisse oder Änderungen im Web ausgelöst werden und so sichergestellt wird, dass Daten erfasst werden, sobald sie verfügbar sind.

Skalierbarkeit beim mehrsprachigen Web-Crawling

Der globale Charakter des Internets erfordert die Fähigkeit, Daten in mehreren Sprachen zu crawlen und zu verarbeiten, was einzigartige Herausforderungen mit sich bringt, die spezielle Lösungen erfordern. Das Crawlen von Websites zur Verarbeitung mehrsprachiger Inhalte erfordert die Implementierung von Spracherkennungsalgorithmen, um die Sprache von Webseiten automatisch zu identifizieren und sicherzustellen, dass die geeigneten sprachspezifischen Verarbeitungstechniken angewendet werden. Die Verwendung von Parsing-Bibliotheken und Frameworks, die mehrere Sprachen unterstützen, wie etwa BeautifulSoup, bietet robuste Tools zum Extrahieren von Inhalten aus verschiedenen Webseiten. Die Integration skalierbarer Übersetzungsdienste wie Google Cloud Translation in die Datenverarbeitungspipeline ermöglicht die Echtzeitübersetzung von Inhalten und ermöglicht so eine nahtlose Analyse in verschiedenen Sprachen.

Abschluss

Quelle: groupbwt

Je weiter wir in das digitale Zeitalter vordringen, desto wichtiger wird das Crawlen von Websites für Big-Data-Anwendungen. Die Zukunft des Webcrawlings liegt in seiner Fähigkeit, effizient zu skalieren, sich an dynamische Webumgebungen anzupassen und Erkenntnisse in Echtzeit bereitzustellen. Fortschritte in der künstlichen Intelligenz und im maschinellen Lernen werden eine entscheidende Rolle dabei spielen, die Fähigkeiten von Webcrawlern zu verbessern und sie bei der Verarbeitung großer Datenmengen intelligenter und effizienter zu machen.

Die Integration verteilter Systeme und Cloud-basierter Infrastrukturen wird die Skalierbarkeit weiter verbessern und es Unternehmen ermöglichen, immer größere Datenmengen problemlos zu verwalten. Da sich Webcrawling-Technologien ständig weiterentwickeln, werden sie nicht nur die Datenerfassungsprozesse verbessern, sondern auch sicherstellen, dass Unternehmen in einer sich ständig verändernden digitalen Landschaft einen Wettbewerbsvorteil behalten können.

Die Nutzung dieser Fortschritte ist nicht nur eine Option, sondern eine Notwendigkeit für Unternehmen, die Big Data effektiv nutzen möchten. Die Zukunft des Web-Crawlings verspricht eine transformative Kraft zu sein, die Innovationen vorantreibt und die Werkzeuge bereitstellt, die erforderlich sind, um das volle Potenzial des riesigen Web-Daten-Ökosystems auszuschöpfen.

Bringen Sie Ihre Big-Data-Anwendungen mit den anpassbaren Web-Scraping-Diensten von PromptCloud mit nahtloser Integration und Skalierbarkeit auf die nächste Stufe. Kontaktieren Sie uns noch heute, um die Leistungsfähigkeit des erweiterten Web-Crawlings für Ihr Unternehmen zu nutzen.