Wie GPT-3-Schreibwerkzeuge funktionieren und 4 Dinge, auf die Sie bei ihrer Verwendung achten sollten

Veröffentlicht: 2022-10-24Seit dem Aufkommen von GPT-3 kämpft eine Flut von Startups um die Aufmerksamkeit von Nutzern, die KI-Copywriting-Dienste für verschiedene Formate verkaufen.

E-Mails, Blogposts, Landingpages, Anzeigentexte, Verkaufskommunikation...

Erinnern Sie sich noch an die Zeit, als der Großteil der Übersetzungs- und Korrekturarbeit noch von Menschen erledigt wurde?

Dann kamen DeepL, Google Translate und Grammarly.

Demokratisierung und Beschleunigung der Alphabetisierung und Sprache für alle.

Erraten Sie, was?

Was dort geschah, geschieht jetzt mit der Texterstellung.

Die Quellschicht der gesamten Wertschöpfungskette.

Lassen Sie uns diskutieren, was mit KI-Texterstellung passiert, warum GPT-3 nur der Anfang ist und warum die meisten dieser KI-Texterstellungstools nicht viel mehr tun, als ein hübsches Gesicht auf demselben Kern zu bauen.

Jarvis, Copy AI, CopySmith, CopyShark, Writesonic, Anyword...

Sie kamen, sahen GPT-3 und versuchen nun, Sie als Interessenten zu gewinnen.

Einige KI-Werbetexter sind unglaublich schnell gewachsen, haben starke Einnahmen erzielt und sich von ausgefallenen Investoren erholt.

Oft übertrieben mit Hunderten von Vorlagen, die nicht wirklich das liefern, was sie versprochen haben, und wenn sie auf den Punkt gebracht werden, sind sie alle gleich und haben keine Macht, ihre eigentliche Textqualität zu beeinflussen und zu verbessern.

Sie alle sind abhängig von...

GPT-3 von OpenAI.

Zu viel fähig, ein wahres generalistisches Kraftpaket der künstlichen Intelligenz und ein Leuchtturm für viele neugierige Köpfe, die sich jetzt auf das Gebiet der Erzeugung natürlicher Sprache begeben haben.

Aber GPT-3 ist nur der Anfang eines sich unglaublich schnell entwickelnden Technologiezweigs.

Plötzlich gab es GPT-3 und die Gefahr wurde zur Chance. Die Geschichte von OpenAI

Bare mit mir für eine kurze technische Einführung. Lassen Sie mich Ihnen mehr über die Bedeutung dieser scheinbar geheimnisvollen Briefe erzählen.

GPT-3 steht für Generative Pre-Trained Transformer v3 .

Lassen Sie mich es Ihnen erklären – Wort für Wort.

Einfach „generativ“ zu beginnen bedeutet, dass das KI-Modell erstellen soll.

Bei „Transformer“ handelt es sich nicht um Autobots in der Größe eines 3-stöckigen Gebäudes, wie wir sie aus Filmen kennen.

Transformer sind eine relativ neue Entwicklung im Bereich Deep Learning und künstliche Intelligenz.

Eine Technik, die einer Maschine die Fähigkeit verleiht, die Muster der menschlichen Sprache zu lernen und fortzusetzen, indem sie Sätze Wort für Wort bildet.

Ein Trafo-Modell allein ist wie ein Neugeborenes, das nicht viel kann, bis es von seinen Eltern lernt.

Transformers lernen durch das Lesen von Milliarden von Beispielen, kreativ zu werden.

Aus diesem Grund wird es in einem großen Teil der menschlichen Sprache als „vortrainiert“ bezeichnet.

Wir sprechen über Billionen von Wörtern.

Ich werde auch hier und da über Modelle sprechen.

Wir machen hier keine Haute Couture, versuchen Sie daher, sich ein Modell als eine Momentaufnahme von etwas vorzustellen.

Einschließlich aller Erfahrungen, Erkenntnisse und Entwicklungen, die es durchlaufen hat.

Denken Sie daran, wie Sie heute Morgen aufgewacht sind, dieser einzelne Moment, der Ihr ganzes Leben voller Erfahrungen und Lernen widerspiegelt und einschließt, das Sie zu der Person gemacht hat, die Sie heute sind.

Stellen Sie sich vor, Sie machen eine Momentaufnahme von diesem Moment mit all den vorher einflussreichen Ereignissen. Dies ist ein Modell, das anhand Ihrer Erfahrungen vortrainiert wurde.

Lassen Sie mich in den Kommentaren oder in einer DM wissen, ob das GPT-3-Modell dadurch für Sie etwas verständlicher geworden ist.

Wir sind TextCortex, ein KI-Startup, das Ihnen 80 % Ihrer Schreibarbeit abnimmt.

Die Geschichte von OpenAI

Warum ist OpenAI in diesem Zusammenhang wichtig?

Sie waren der Leuchtturm, der in der Lage war, entscheidendes Interesse auf diesem Gebiet zu wecken.

Menschen mit unterschiedlichem Hintergrund in den Raum ziehen, von neugierigen Akademikern, seriösen Unternehmen, kreativen Unternehmern bis hin zu Einzelpersonen, die alle dabei sein wollen, wenn die Transformatortechnologie Geschichte schreibt.

Beginnen wir diese Geschichte mit denen, die GPT-3 erstellt haben.

Ende 2015 – Die Geschichte beginnt wie bei so vielen innovativen Entwicklungen, die wir heute sehen, mit dem Technoking selbst, Elon Musk.

Zusammen mit Sam Altman und einigen anderen Investorenfreunden sagten sie satte 1 Milliarde US-Dollar zu, um eine gemeinnützige Organisation aufzubauen, die frei mit der Forschungsgemeinschaft zusammenarbeiten und die ethische Entwicklung von KI vorantreiben würde.

2019 war ein wirklich ereignisreiches Jahr für OpenAI.

Nachdem Elon Musk die Organisation verlassen hatte, engagierte sich M icrosoft mit einer weiteren Milliarde US-Dollar, um das Unternehmen in eine kommerziell orientierte, gewinnorientierte Organisation zu verwandeln.

Während sich OpenAI auf den Markt vorbereitete, fing eines ihrer Modelle an, Wellen zu schlagen - - damals verkündete es, es sei zu gefährlich, um es auf die Welt zu bringen.

Nebenbemerkung: Die oben genannten Gefahren waren einer der Gründe für mich, in den Weltraum zu ziehen, während ich noch Maschinelles Lernen an der Universität studierte.

Im Jahr 2020 veröffentlichten sie GPT-3 für die Welt.

Ein KI-Modell, das mit 175 Mrd. fast 116-mal größer ist als sein Vorgänger. Parameter *.

Anfangs hatten nur wenige ausgewählte Institutionen Zugang, um damit zu experimentieren, bis sie GPT-3 vor kurzem für alle zugänglich machten, die bereit waren, das teure Geld für seine Fähigkeiten zu zahlen.

- Stellen Sie sich Parameter als die Größe des KI-Gehirns vor, das Sie ergänzt und Ihnen hilft.

Die Entstehung des KI-Copywritings

GPT-3 hat viele Produktentwickler dazu motiviert, eine angenehm aussehende Benutzeroberfläche auf der Grundlage von GPT-3 zu erstellen. Ich habe nur ein paar von ihnen am Anfang erwähnt.

Wir beobachten jedoch wöchentlich neue Markteinführungen des immer noch identischen Produkts.

Nachdem ich das 40. Tool gesehen hatte, habe ich aufgehört, Informationen darüber in meiner Wissensdatenbank zu sammeln ...

Ich habe einige von ihnen gesehen, die behaupteten, sie würden sich dadurch differenzieren, dass sie der bessere „Kommunikator für die API von GPT-3“ seien.

Was bedeutet das? Ist es ein echtes Unterscheidungsmerkmal?

API ist die Abkürzung für eine Anwendungsprogrammierschnittstelle.

Klingt komplex, aber erinnern Sie sich, wie die großen Orakel in Filmen immer einen Torwächter hatten, der für sie sprach?

Die API ist so etwas für Computer.

Alle diese KI-Copywriting-Unternehmen pilgern zum Gatekeeper von GPT-3, um die Wünsche ihrer Benutzer zu senden und eine Antwort darauf zu erhalten.

Zurück zu dem Punkt, der beste Kommunikator für die Gatekeeper-API von GPT-3 zu sein.

Während Kommunikation entscheidend ist, beeinflusst sie den Prozess des Orakels beim Erstellen nicht.

Nur OpenAI kann die für Sie erstellte künstliche Intelligenz verbessern.

GPT-3 ist jedoch nicht mehr das einzige Orakel auf dem Block.

Mit dem gestiegenen Interesse steht eine Vielzahl verschiedener Orakel zur Verfügung und bei TextCortex ist es unser tägliches Brot, sie auf unseren eigenen Daten zu trainieren, um für ihren jeweiligen Zweck das Beste zu erreichen.

4 Dinge, auf die Sie bei der Verwendung von GPT-3-Schreibwerkzeugen achten sollten

Wie ich bereits sagte, haben wir gesehen, wie diese KI-Tools zum Verfassen von Texten wie Pilze auf einem regnerischen Waldboden auftauchen.

Die meisten von ihnen mit der einzigen Motivation – schnelles Geld verdienen.

Das wird zum Problem, wenn es um die Stabilität des Unternehmens hinter der Software geht.

Wir haben einige Schätzungen vorgenommen und ein Beispiel bei unseren Power-Usern genommen, deren Betrieb für einen einzelnen Benutzer etwa 100 USD pro Monat kosten würde.

Mein Beileid an diejenigen, die mit lebenslangen Verträgen begonnen haben, nur um festzustellen, dass GPT-3 nicht umsonst ist.

Traurig für die Kunden, die diese gekauft haben, jetzt vor der verschlossenen Tür mit Software zu stehen, die nicht antwortet.

Auch große KI-Begleitunternehmen wie Replika AI mit ihren 7 Millionen Benutzern haben sich von GPT-3 entfernt, weil sie die Qualität nicht beeinflussen können und gleichzeitig hohe Betriebskosten zahlen, um in Abhängigkeiten gefangen zu sein.

1. Springen Sie nicht auf das billigste (lebenslange) Angebot

Wie bei vielen Dingen im Leben ist billig kaufen teuer.

So sind lebenslange Angebote.

Ich habe viele Benutzer gesehen, die sich an uns gewandt haben, weil die Software, mit der sie früher gearbeitet haben, entweder den Kundensupport eingestellt hat oder an sich nicht mehr funktionierte, weil sie einen grundlegenden Betriebsfehler aufwies.

Seien Sie vorsichtig ... wenn Sie jemandem mit Dollarzeichen in den Augen das schnelle Geld zahlen.

2. Fallen Sie nicht auf den #-Vorlagen-Trick herein

Viele beworbene Vorlagen sind lediglich Platzhalter, um sich ein Bild davon zu machen, was Sie interessieren könnte.

Dies ist eine häufige Beschwerde, die wir beobachten. Eine schlechte „Anleitung zur Schöpfungsrelevanz“ oder ein sich ständig wiederholendes Schöpfungsmuster.

Wir fragen unsere Nutzer aktiv im engen Gespräch innerhalb unserer Communities nach ihren Wünschen.

Wenn wir genug Interesse an einem Format sehen, graben wir tief, wir sammeln Daten, wir trainieren unsere eigenen KI-Transformatormodelle und bieten unseren Communities etwas Nachhaltiges.

3. Wenn alle dasselbe verwenden, kann dies Ihren Rankings schaden

Während wir hier sprechen, wird all diese regelbasierte Software, die vorgibt, KI zu sein, aber letztendlich nur Ihre Eingaben durch einen Cookie-Cutter-Prozess schiebt und dreht, getroffen.

Auch wenn sich moderne KI-Technologien wie GPT-3 unglaublich kreativ und natürlich anfühlen, gibt es Ihnen ein Gefühl der Sicherheit, wenn Sie davon ausgehen, dass das Erkennen ihrer Kreationen eine Herausforderung wäre.

Wenn jedoch zu viele Personen ein einziges Muster verwenden, um es zu erstellen, kann es rückentwickelt werden.

Wir sehen Anbieter, die GPT-3 ausführen und Ihnen anbieten, 10.000 Blog-Artikel pro Monat zu schreiben.

Diese schlechten Schauspieler werden nur mehr Spuren herausholen, um eine Lösung zu finden.

Derzeit glauben wir, dass eine Metrik für Relevanz durch Inhalt (RTC) genutzt werden könnte, um die Nutzung von KI-generierten Inhalten zu erkennen.

Lassen Sie mich Ihnen eine vergleichbare Situation auf dem Markt für Mobiltelefone geben.

Wenn Sie einen Service anbieten, eine App erstellen oder ein System angreifen würden, für welches würden Sie sich entscheiden?

Apples iOS mit apx. 27,5 % oder Androids 71 % globaler Anteil an mobilen Betriebssystemen?

Denken Sie also darüber nach, was das erste Ziel von Google sein wird, wenn es um KI-generierte Inhalte geht.

Es wird zu Ihrem Vorteil sein, zweckorientierte Modelle zu verwenden, die Experten auf ihrem Gebiet sind.

Daneben sollten Sie nach so viel Anpassbarkeit wie möglich suchen. Wir bieten Ihnen zum Beispiel an, verschiedene Kreativitäts-Engines zu nutzen.

4. Instabilität, wenn die Infrastruktur aktualisiert wird

Diese großen Sprachmodelle entwickeln sich kontinuierlich weiter.

Jedes Update und Training der zugrunde liegenden Infrastruktur wirkt sich auf die Ausgabe der Textqualität aus.

Da die meisten KI-Texterstellungstools auf die vielen Variationen von GPT-3 angewiesen und abhängig sind, beeinträchtigt eine Änderung ihrer Infrastruktur die Qualität.

Es dauert, bis sie „ihre Kommunikation zum Orakel wiedergefunden“ haben. ;)

Warum GPT-3 erst der Anfang der Generierung natürlicher Sprache ist und wie wir bei TextCortex Dinge anders machen

Ich habe es jetzt schon ein paar Mal gespoilert und Sie können meine Antwort darauf erraten, ob wir mit GPT-3 den Olymp der natürlichen Sprachgenerierung erreicht haben?

Es ist ein Nein, haben wir nicht.

Ohne zu zögern sage ich es noch einmal: GPT-3 war der mutige Schritt, der Wellen schlug und Einzelpersonen, Akademiker, Unternehmen und Regierungen ins Feld rief.

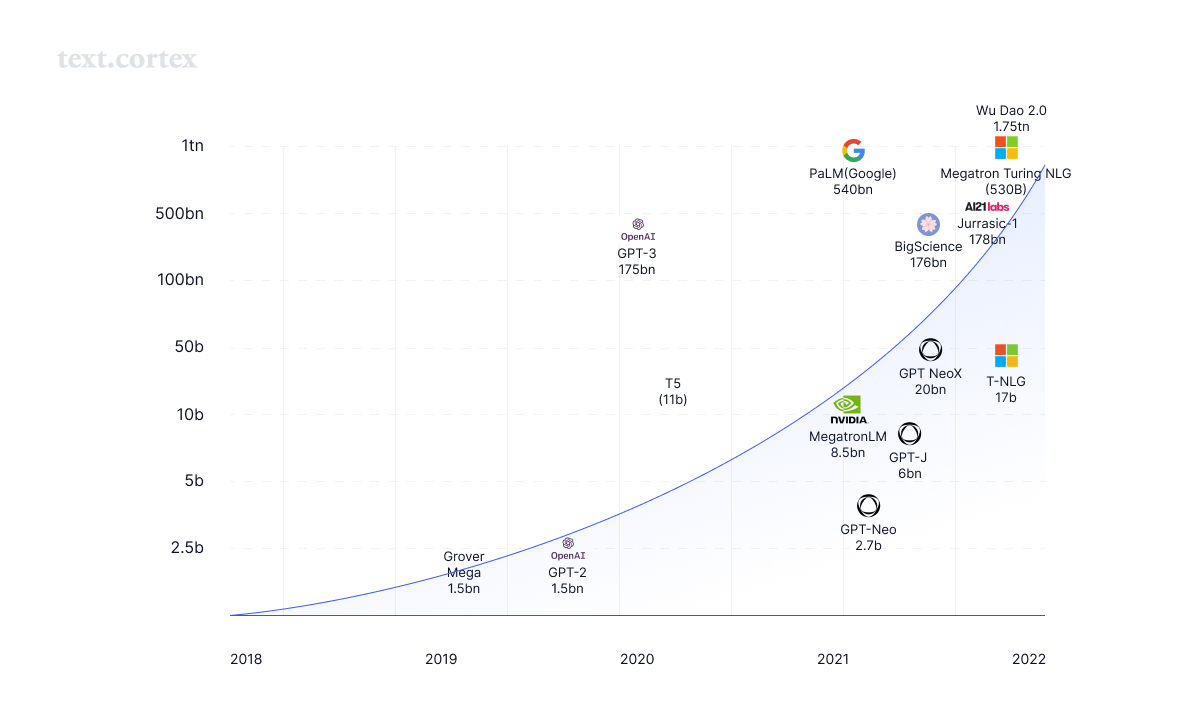

Nichtsdestotrotz ist es der Beginn einer neuen Ära. Derzeit sehen wir ein Wettrüsten bei der Schaffung von KIs mit immer mehr Parametern und immer größeren Gehirnen.

Kommen wir zurück zu meiner Transformatoren (dem Film) Erzählung Microsofts Megatron-Turing-Modell.

Ein Modell mit einem Gehirn, das dreimal so groß ist wie GPT-3.

Mit seinen 530 Mrd. Parameter, um eine Beschreibung für Ihr Produkt oder Ihren Blogartikel zu schreiben, ist wie der Bau eines Kohlekraftwerks, nur um Ihr Smartphone aufzuladen.

Es hört hier nicht auf.

Gerüchte tauchten auf, dass GPT-4 in Billionen Parametern enthalten sein wird.

Google kündigte an, bereits ein Modell in Billionenhöhe erreicht zu haben.

Auch das chinesische Modell Wu Dao ist dabei.

Bedeutet das, dass sie 10x besser sind als GPT-3?

Geht eine größere Parametergröße mit einer besseren Erstellung einher?

Bringt große Macht große Verantwortung mit sich?

Eines ist sicher: Mit großen Parametergrößen geht sicherlich auch ein großer Stromverbrauch einher.

Das Erstellen, Trainieren und Betreiben solch großer Sprachmodelle ist eine Katastrophe für die Umwelt.

Erinnern Sie sich, wie ich vorhin über „vortrainierte“ Modelle gesprochen habe? Es hilft nicht, ein Gehirn zu schaffen, das die Menge übersteigt, von der es lernen kann. Das klügste Kleinkind beschränkt sich darauf, zu lernen, was es in seiner Umgebung beobachten kann.

Wir haben großen Respekt vor den OGs des NLG-Bereichs von OpenAI über DeepMind bis hin zu EleutherAI und AI21 Labs.

Alle stecken massive Anstrengungen und Ressourcen, um die Menschheit einen Schritt nach vorne zu bringen.

Wir möchten uns ihnen bei ihrer Suche anschließen und verachten diejenigen, die nach dem schnellen Geld für die Verdienste ihrer Arbeit dürsten.

Bei TextCortex machen wir gerne die harte Arbeit.

Denn es entsteht kein dauerhafter und konkurrenzfähiger Wert, wenn man die Abkürzung nimmt, wenn es um den eigenen Kern geht.

Die Qualität der Schöpfung.

Und während GPT-3 ein Generalist ist, ein wahrer Alleskönner, ist es für den Anwendungsfall des KI-Copywritings bereits immens groß.

So wie die Menschheit von der Verallgemeinerung zur Spezialisierung gegangen ist, um sich zu entwickeln und dort anzukommen, wo wir heute sind.

Dies wird auch für die Generierung natürlicher Sprache gelten.

Deshalb entwickeln wir bei TextCortex kein Einheitsmodell. Wir bauen kleine zweckorientierte Modelle, die ein Netzwerk aufbauen und orchestrieren.

Denn eine Einheitsgröße passt einfach nicht allen.

Anstelle eines massiven KI-Modells mit Billionen Parametern bauen wir ein Netzwerk von 100 und 1000 Modellen auf, die Ihnen als fachkundiger KI-Schreibbegleiter dienen.

Wir trainieren, bauen, testen, entwickeln, experimentieren und setzen unsere eigenen KI-Modelle auf der Grundlage unseres eigenen sorgfältig ausgewählten Wissens und unserer eigenen Daten ein.

Sie zu Spezialisten in einer Welt der Generalisten zu machen.

Anstatt Hunderte von vorgefertigten Vorlagen anzubieten, die oft die Relevanz für Ihre Bedürfnisse verfehlen, veröffentlichen wir Vorlagen, die wir speziell erforscht, Wissen gesammelt und unsere KIs für deren Beherrschung trainiert haben.

Wählen Sie das richtige KI-Schreibwerkzeug für sich selbst aus

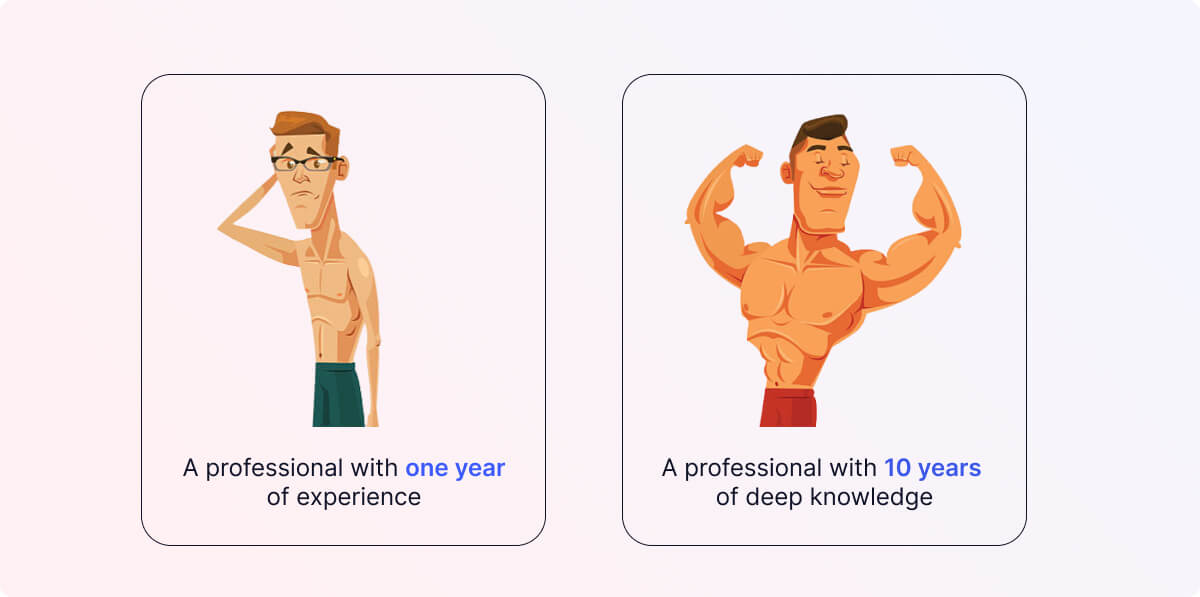

Es ist eine einfache Frage, was würden Sie bevorzugen?

Ein Profi mit einem Jahr Erfahrung oder einer mit 10 Jahren fundiertem Wissen auf dem Gebiet, das Sie benötigen?

Muss ein Anwalt, der verlässliche Verträge schreiben sollte, auch wissen, wie man die ansprechendsten Blogs über Rezepte für Muffins mit Schokoladensplittern schreibt?

Mit unserer Methodik für kleinere zweckorientierte KI-Modelle können wir ihnen beibringen, warum, wie und wie bestimmte Formate und Schreibstile aussehen.

Zum Beispiel wurde unser Langformmodell auf mehr als 10 Millionen hochinteressanten Blogs trainiert.

Sie verstehen, dass Langform-Content aus einem ansprechenden Intro zu einem informativen Hauptteil mit einem Schluss besteht, der alles auf den Punkt bringt.

Die Anpassung von KI-Modellen an unsere Nutzerbedürfnisse ist unser tägliches Brot.

Jeden Tag bemühen wir uns, dieses Netzwerk von KI-Experten zu erweitern, und wir bringen sie in jedes Textfeld, das Sie brauchen.

Sie sind ein begeisterter Schriftsteller?

Schauen Sie sich unsere Chrome-Erweiterung an, die Ihre Kreation in jedem Textfeld auflädt.

Sie sind Entwickler auf der Suche nach einer NLG-KI-Lösung? Wenden Sie sich an uns, um unsere API zu testen.

Sie möchten Daten zu unserer Sache beitragen? Bitte seien Sie unser Gast.

Lassen Sie uns kreative KIs mit Sinn entwickeln!