Was ist technisches SEO?

Veröffentlicht: 2023-09-01Wenn Sie anfangen, SEO zu erlernen, werden Sie schnell erkennen, dass es viele verschiedene Aspekte gibt, die Sie verstehen müssen, um erfolgreich zu sein.

Von On-Page-SEO bis hin zu On-Page-SEO und Content-Erstellung. Sie müssen alles genau im Blick haben, unabhängig von Ihrer spezifischen Rolle im SEO, um das Ranking Ihrer Website dort zu erreichen, wo es sein muss.

In diesem Artikel befassen wir uns mit technischem SEO. Sie erfahren genau, was es ist, warum es für Websites wichtig ist und welche Merkmale eine technisch optimierte Website ausmacht.

Außerdem geben wir Ihnen einen Überblick darüber, wie technisches SEO funktioniert, vom Crawlen und Indexieren bis zum Ranking, und was Sie benötigen, damit diese drei Schritte gut zusammenarbeiten.

Bildnachweis: https://tsh.io/

Was ist technisches SEO?

Technisches SEO ist der Prozess der Optimierung der „hinter den Kulissen“-Elemente einer Website, um ihre Leistung in Suchmaschinen wie Google und Bing zu verbessern. Dieser Prozess umfasst Schritte wie die Verbesserung des Markups und der Struktur der Website, um ein einfaches Crawlen, Indexieren und Ranking (wir werden später mehr darüber sprechen) durch Suchmaschinen-Bots wie Googlebot zu gewährleisten. Zu den Aufgaben gehören die Verbesserung der Website-Geschwindigkeit, die Erstellung einer einfachen und leicht verständlichen Website-Architektur, die Verwendung „SEO-freundlicher“ URLs und die Anwendung von Schema-Markup für angereicherte Suchergebnisse.

Im Wesentlichen schafft technisches SEO eine starke Basis, die Suchmaschinen dabei unterstützt, das Ranking einer Website zu verbessern. Dies wird letztendlich zu mehr organischem Traffic und einem verbesserten Benutzererlebnis führen.

Stellen Sie sich Ihre Website als eine gut organisierte Bibliothek vor. Beim technischen SEO geht es darum, Bücher ordentlich mit klaren Tags (Ihrer URL-Struktur) aufzubewahren, Schilder für eine reibungslose Navigation einzurichten (Ihre internen Links) und eine einladende Atmosphäre zu schaffen (Geschwindigkeit der Website). Wenn die Bibliothek aufgeräumt und einladend ist, können mehr Besucher die Bücher finden, die sie benötigen (Benutzer entdecken Inhalte), und Bibliothekare (Suchmaschinen-Bots) können Bücher kategorisieren und vorschlagen (Indexierung und Ranking).

Warum ist technisches SEO wichtig?

Technisches SEO ist für die überwiegende Mehrheit der Websites unglaublich wichtig, da es die Grundlage für die Sichtbarkeit der Website in Suchmaschinen und die Gesamtleistung bildet. Natürlich sind die von Ihnen veröffentlichten Inhalte von entscheidender Bedeutung, doch mangelnde technische Optimierung könnte Suchmaschinen daran hindern, diese Inhalte effektiv zu entdecken, zu indizieren und zu bewerten.

Die Bedeutung von technischem SEO lässt sich wie folgt zusammenfassen:

Erstens stellt es sicher, dass Suchmaschinen Ihre Inhalte effektiv crawlen und indizieren können. Durch die Optimierung von Elementen wie der Struktur und Navigation Ihrer Website erleichtert technisches SEO das reibungslose Crawlen Ihrer Website durch Suchmaschinen-Bots. Diese Zugänglichkeit ist entscheidend, um sicherzustellen, dass Ihre Inhalte wahrgenommen und angemessen indiziert werden.

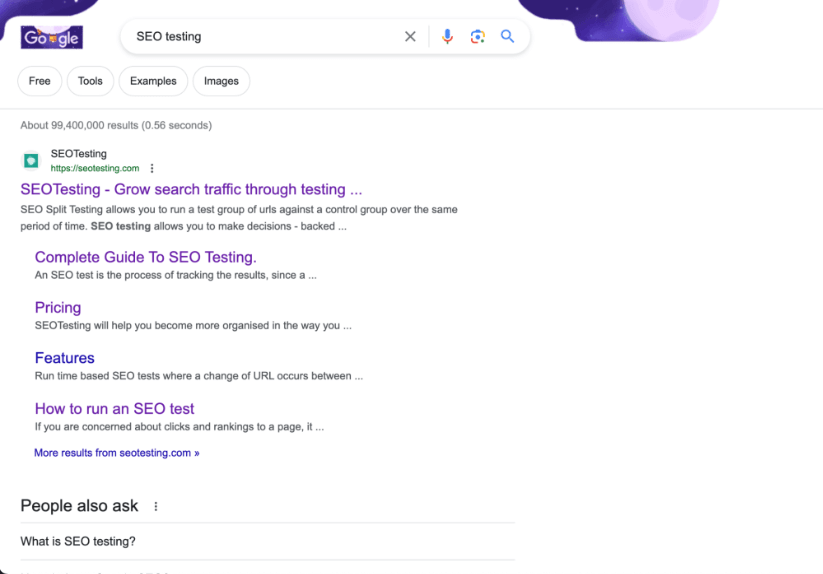

Wir sind vielleicht etwas voreingenommen, aber wir glauben, dass unsere Website ein großartiges Beispiel für eine Website mit großartiger Architektur ist!

Zweitens hat technisches SEO direkten Einfluss auf Ihr Suchmaschinenranking. Website-Geschwindigkeit und mobile Reaktionsfähigkeit sind bestätigte Ranking-Faktoren innerhalb des Suchalgorithmus von Google. Darüber hinaus spielt ein gut strukturiertes HTML-Markup eine entscheidende Rolle bei der Bewertung der Qualität und Relevanz Ihrer Website durch Suchmaschinen. Eine gut optimierte Website hat eine höhere Wahrscheinlichkeit, in Suchmaschinen einen höheren Rang zu erreichen.

Schließlich trägt technisches SEO dazu bei, dass Ihre Website ein großartiges Benutzererlebnis bietet. Während Sie an Ihrem technischen SEO arbeiten, steigern Maßnahmen wie die Optimierung der Seitenladezeiten und die Verbesserung von URLs auch die Benutzerzufriedenheit. Eine verbesserte Benutzererfahrung führt zu geringeren Absprungraten und höheren Engagement-Raten, was indirekt die Leistung Ihrer Website bei der Suche verbessert.

Letztendlich dient technisches SEO als Eckpfeiler, auf dem effektive SEO-Strategien aufbauen! Dies garantiert, dass Ihre Inhalte nicht nur erstklassig, sondern auch auffindbar und zugänglich sind. Dies wird sowohl Suchmaschinen als auch, was noch wichtiger ist, Benutzer ansprechen.

Was sind die Merkmale einer technisch optimierten Website?

Ganz gleich, um welche Website es sich handelt, ob es sich um eine E-Commerce-Website handelt, die Einnahmen in Millionenhöhe erwirtschaftet, oder um eine Broschüren-Website, die die Dienstleistungen eines örtlichen Sanitärunternehmens präsentiert, alle Websites weisen die gleichen Merkmale auf, wenn es darum geht, aus technischer SEO-Sicht gut optimiert zu sein .

Es ist schnell

Eine gut optimierte Website wird auf allen Geräten (Desktop, Tablet und Mobilgerät) und bei allen Netzwerkbedingungen schnell geladen. Schnell ladende Seiten verbessern das Erlebnis eines Benutzers auf Ihrer Website und werden von Suchmaschinen bevorzugt, was möglicherweise zu höheren Rankings führt.

Wir wissen, dass Google das Bestehen der wichtigsten Web-Vital-Tests als bestätigten Ranking-Faktor angibt, was bei Google selten vorkommt. Daher ist es von entscheidender Bedeutung, sicherzustellen, dass Ihre Website schnell ist und die CWV-Tests besteht.

Es ist crawlbar

Dies sollte eine Selbstverständlichkeit sein, aber Websites sollten von Suchmaschinen gecrawlt werden können. Wenn ein Suchmaschinen-Bot (wie Googlebot) Ihre Website nicht effektiv crawlen kann, werden Sie Probleme mit dem Ranking Ihrer Seite in den SERPs feststellen.

Robots.txt-Dateien und Meta-Robots-Tags sollten ordnungsgemäß konfiguriert sein. Dies hilft Suchmaschinen-Bots dabei, zu erkennen, welche Seiten sie crawlen und indizieren und welche Seiten sie in Ruhe lassen sollten. Nicht jede Seite Ihrer Website sollte gecrawlt werden. Insbesondere Admin-Seiten und Seiten mit Kundendaten.

Es bewahrt das Link-Eigenkapital

Technisch gut optimierte Websites tun alles, um möglichst viel Link-Equity zu erhalten.

Erstens verwendet die Website interne Links, die Benutzer (und Suchmaschinen-Bots) zu relevanten Inhalten auf der Website führen. Dies verbessert die Website-Navigation, hilft bei der Verteilung von Link-Equity auf andere Seiten und hält Benutzer länger auf der Website.

Zweitens ist die Website (idealerweise) völlig frei von defekten Links und unnötigen Weiterleitungsketten. Dies gewährleistet ein nahtloses Benutzererlebnis und ein effizientes Crawling durch Suchmaschinen.

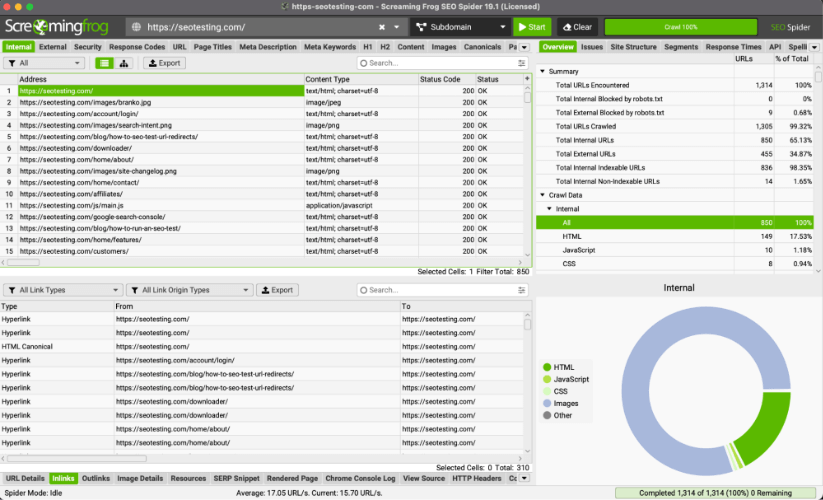

Profi-Tipp: Sie können ScreamingFrog verwenden, um defekte Links zu identifizieren und Ketten umzuleiten, die nicht vorhanden sein müssen.

Es ist mobilfreundlich

Alle Websites sollten so gestaltet sein, dass sie auf Mobilgeräten responsiv und funktionsfähig sind. Angesichts der immer stärkeren Nutzung von Smartphones zum Surfen (Stand 2023 stammen 63 % des organischen Suchverkehrs von Google in den USA von Mobilgeräten) ist die Mobilfreundlichkeit ein entscheidender Faktor sowohl für das Nutzererlebnis als auch für das Ranking.

Es ist sicher

Alle Websites sollten sicherstellen, dass ihre Website das sichere HTTPS-Protokoll verwendet.

Dadurch wird sichergestellt, dass Ihre Website über eine angemessene Datenverschlüsselung verfügt, und das Vertrauen der Benutzer bei der Nutzung Ihrer Website gestärkt. Dieses Vertrauen ist besonders wichtig, wenn auf Websites Finanzdaten weitergegeben werden, beispielsweise Kreditkarteninformationen.

Auch Google hat bestätigt, dass die Nutzung des HTTPS-Protokolls ein Rankingfaktor ist. Wir wissen nicht, welches Gewicht der Algorithmus darauf legt, aber wir können vermuten, dass dies eher ein Faktor ist, wenn es um YMYL-Websites (Your Money Your Life) geht.

Es verwendet strukturierte Daten

Schema-Markup wird auf Websites implementiert, um zusätzlichen Kontext zum Inhalt bereitzustellen. Dadurch können Suchmaschinen beim Anzeigen Ihrer Website Rich Snippets in den SERPs anzeigen, was die Klickraten erhöht und mehr Verkehr auf Ihre Website bringt.

Krabbeln

Wir haben dieses Thema in unserem Artikel zum Erlernen von SEO im Jahr 2023 kurz behandelt, aber jetzt werden wir die vier Phasen der technischen Suchmaschinenoptimierung durchgehen, die Ihre Website von Seiten mit HTML, CSS und JavaScript zu Rankings in den SERP führen. Crawling, Rendering, Indizierung und Ranking.

Der erste Schritt auf dieser Reise ist das Krabbeln.

Unter Crawling versteht man den Vorgang, bei dem Suchmaschinen wie Google und Bing systematisch den Inhalt von Websites im Internet durchsuchen und mehr darüber erfahren. Das Ziel des Crawlings besteht darin, Informationen über Webseiten zu sammeln. Dazu gehören:

- Ihr Inhalt.

- Ihre Struktur.

- Andere wichtige Informationen.

Suchmaschinen können diese Daten dann nutzen, um Ihre Webseiten effektiv zu indizieren und zu bewerten (wir werden später darüber sprechen) und Ihre Webseiten in den SERPs anzuzeigen.

Suchmaschinen nutzen Bots, sogenannte Crawler, um durch die riesige Menge an Webseiten im Internet zu navigieren. Die Crawler besuchen zunächst einige bekannte Webseiten, oft beliebte oder häufig aktualisierte Seiten. Von dort aus folgen sie den Links auf diesen Seiten, um neue Seiten zu „entdecken“, die sie dann rendern, indizieren und bewerten können.

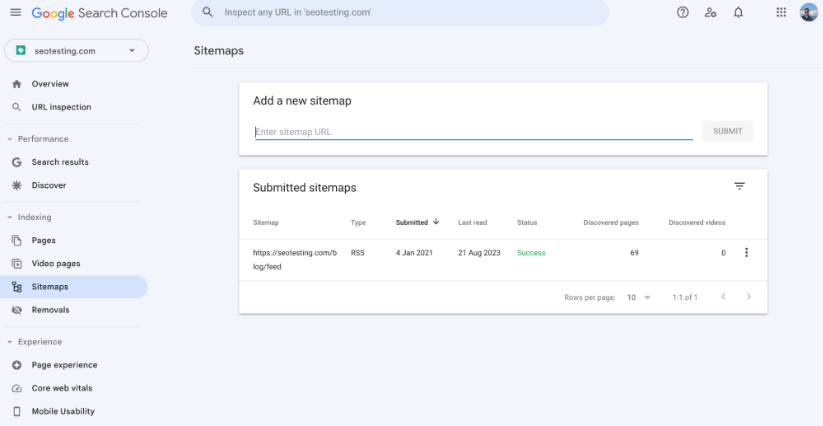

XML-Sitemap

Eine XML-Sitemap ist eine Datei, die Suchmaschinen eine strukturierte Liste aller URLs auf Ihrer Website bereitstellt. Es handelt sich um ein Tool, das Suchmaschinen-Crawlern hilft, die Organisation des Inhalts Ihrer Website zu verstehen und sicherzustellen, dass sie alle wichtigen Seiten effektiv entdecken und indizieren können.

Wenn es um Ihre technische SEO geht, ist die Sicherstellung einer XML-Sitemap auf Ihrer Website unerlässlich, da sie das Crawlen Ihrer Seiten auf verschiedene Weise erleichtert:

Wenn Sie eine XML-Sitemap auf Ihrer Website haben, erhalten Suchmaschinen-Bots eine zentralisierte Liste von URLs, die sie crawlen und indizieren sollen. Dadurch können Sie sicherstellen, dass alle Ihre wesentlichen Seiten, wie Produktlistenseiten und Produktanzeigeseiten, in Suchmaschinenindizes und hoffentlich auch in Suchmaschinen-Ergebnisseiten enthalten sind.

Sie können Ihre Sitemap auch verwenden, um die Priorität festzulegen und die Häufigkeit jeder URL auf Ihrer Website zu ändern. Es ist wichtig zu beachten, dass Suchmaschinen diese Regeln möglicherweise nicht genau befolgen. Dadurch können Crawler jedoch eine Vorstellung davon bekommen, wie wichtig verschiedene Seiten Ihrer Website sind und wie oft sie aktualisiert werden.

Während Suchmaschinen verschiedene Faktoren nutzen, um zu entscheiden, welche Seiten zuerst gecrawlt und indiziert werden sollen, kann Ihre Sitemap dabei helfen, wichtige (oder neu aktualisierte) Seiten hervorzuheben. Dies kann Suchmaschinen-Bots zu diesen Seiten führen und dazu beitragen, dass sie schnell gecrawlt und indiziert werden. Wenn Sie keine Sitemap hätten, wären Sie darauf angewiesen, dass Crawler diese Seiten automatisch über interne und externe Links usw. finden. Das ist ein viel längerer Prozess.

Große Websites mit Hunderttausenden (oder sogar Millionen) URLs und Sitemaps (und mehreren Sitemaps) helfen Crawlern dabei, jede Seite, die Sie indexieren möchten, effizienter zu finden. Dies ist eine großartige Sache, da Sie dadurch Ihr Crawling-Budget viel effizienter verwalten können. Für kleinere Websites stellt dies kein Problem dar, da diese kleinen Websites keine Probleme mit ihrem Crawling-Budget haben.

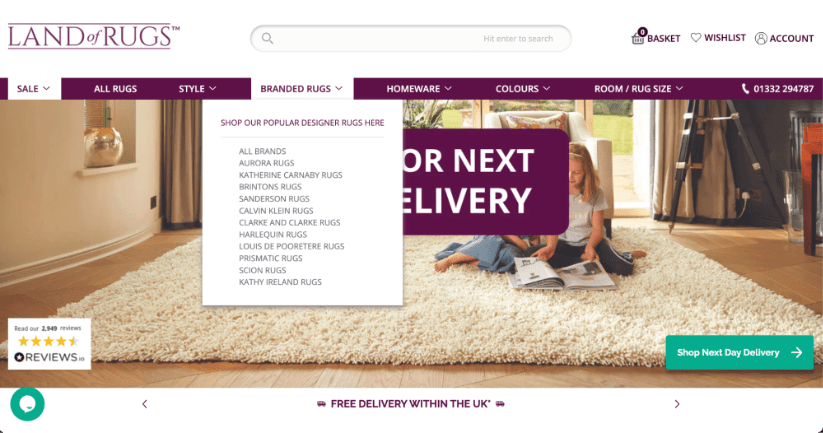

Site-Struktur

Die Struktur Ihrer Website spielt eine entscheidende Rolle dabei, wie Suchmaschinen-Bots durch den Inhalt navigieren und ihn indizieren. Eine gut organisierte Website-Struktur erleichtert nicht nur das effiziente Crawlen durch Suchmaschinen-Bots, sondern verbessert auch das Gesamterlebnis, das echte Benutzer auf Ihrer Website haben.

Hier ist ein Beispiel einer E-Commerce-Website mit einer guten Seitenstruktur. Auf alle wichtigen Seiten (Produktlistenseiten) in diesem Beispiel kann problemlos über die Homepage-Navigationsleiste zugegriffen werden, wodurch so viel Link-Equity wie möglich an diese Seiten weitergegeben wird und sichergestellt wird, dass Crawler sie leicht finden können.

Wenn Seiten in einfache, leicht verständliche Kategorien und Unterkategorien organisiert sind, wird es für Crawler viel einfacher, Links zu folgen und Inhalte systematisch zu indizieren. Diese hierarchische Anordnung stellt sicher, dass wichtige Seiten näher an der Startseite liegen und erhöht so ihre Chancen, schnell entdeckt und indiziert zu werden.

Interne Links innerhalb der Struktur einer Website führen Suchmaschinen-Crawler effektiver durch verschiedene Abschnitte Ihrer Website. Gut platzierte und relevante interne Links tragen dazu bei, die Link-Equity auf den Seiten zu verteilen, sodass Crawler ein viel breiteres Spektrum an Inhalten aufdecken können, als dies ohne die Platzierung interner Links in Ihren Inhalten möglich wäre.

Verwaiste Seiten (Seiten, auf die keine Links verweisen) sollten vermieden werden, da sie eine große Herausforderung für Crawler darstellen. Eine robuste Site-Struktur mit ordnungsgemäßer interner Verlinkung vermeidet dies.

Insgesamt dient die Struktur Ihrer Website als entscheidender Rahmen, der bestimmt, wie Suchmaschinen Ihre Inhalte crawlen und indizieren. Durch die Implementierung einer klaren Website-Hierarchie, das Hinzufügen relevanter kontextbezogener Links und die Optimierung der Crawling-Budgetzuweisung (falls erforderlich) können Websitebesitzer und Vermarkter positiv beeinflussen, wie Suchmaschinen ihre Websites crawlen.

URL-Struktur

Die URL-Struktur Ihrer Website hat einen direkten Einfluss auf das Crawling Ihrer Website. Wenn Sie sicherstellen, dass Sie über eine gut organisierte (und beschreibende) URL-Struktur verfügen, können Crawler den Inhalt jeder Seite effizienter verstehen. Klare (und kurze) URLs bieten wertvollen Kontext zum Thema und zur Hierarchie der Position der Seite innerhalb der Website.

Beispielsweise teilt eine URL wie https://example.com/blog/head-topic-1 einem Suchmaschinen-Crawler mit, dass es sich bei dieser Seite um eine wesentliche Seite innerhalb des Blogs handelt, die sich mit einem der Schlüsselthemen der Website befasst.

Andererseits können URLs, die verworren oder unsinnig sind (ein gutes Beispiel ist https://example.com/12642/test-category/test-page125253/), Crawler verwirren, wenn sie auf Ihrer Website navigieren. Dies beeinträchtigt ihre Fähigkeit, den Inhalt zu interpretieren, sowie die Relevanz und Wichtigkeit der Seite innerhalb Ihrer Website. Eine saubere URL-Struktur ohne unnötige Parameter und Symbole erhöht die Chancen, dass Ihre Seiten effektiv gecrawlt werden.

Darüber hinaus hat Ihre URL-Struktur einen direkten Einfluss auf das Benutzererlebnis und die Klickraten Ihrer Website, auch wenn dies nicht direkt mit dem Crawlen zusammenhängt. Eine prägnante und relevante URL zieht mit viel größerer Wahrscheinlichkeit Benutzerklicks in den Suchergebnissen an, was sich (indirekt) auf das allgemeine Suchmaschinenranking Ihrer Website auswirken kann.

Robots.txt-Dateien

Ihre robots.txt-Datei hat enormen Einfluss darauf, wie Suchmaschinen auf Ihrer Website navigieren und sie crawlen. Dieses Dokument, das sich im Kern Ihrer Website befindet, enthält detaillierte Richtlinien für Suchmaschinen-Crawler und legt fest, wie Ihre Website gecrawlt werden soll. Einschließlich, welche Seiten gecrawlt werden können und welche Seiten in Ruhe gelassen werden sollten.

Beachten Sie an dieser Stelle, dass Ihre robots.txt-Datei zwar den Zugriff von Crawlern auf bestimmte Seiten oder Abschnitte Ihrer Website stoppen kann, jedoch nicht garantiert, dass Ihre Seiten nicht über alternative Wege gecrawlt werden. Einige Suchmaschinen registrieren möglicherweise dennoch Seiten, die vom Crawling ausgeschlossen sind, wenn sie über andere Wege gefunden werden, beispielsweise über interne Links auf Ihrer Website.

Wenn Ihre robots.txt-Datei voller Fehler oder strenger Regeln ist, werden Sie möglicherweise feststellen, dass dies Suchmaschinen daran hindert, wichtige Inhalte zu crawlen, was einen „Schatten“ auf die Leistung Ihrer Website in den SERPs werfen kann. Es ist wichtig, dass Sie Ihre robots.txt-Datei regelmäßig im Auge behalten, um sicherzustellen, dass alle Regeln ordnungsgemäß funktionieren.

Protokolldateianalyse

Die Analyse der Protokolldateien Ihrer Website kann einen großen Einfluss darauf haben, wie Suchmaschinen Ihre Website crawlen, und dies können Vermarkter mit den richtigen Tools selbst tun! Bei Protokolldateien handelt es sich im Wesentlichen um Aufzeichnungen, die zeigen, welche Teile Ihrer Website von Suchmaschinen besucht werden und wie oft Suchmaschinen-Crawler diese Teile Ihrer Website besuchen. Im Wesentlichen können Sie so feststellen, welche Seiten Ihrer Website von Suchmaschinen als wichtig angesehen werden, und sich dadurch einen Vorteil verschaffen.

Dies hilft Vermarktern bei der Entscheidung, welche Seiten es wert sind, mehr Zeit (und möglicherweise auch Geld) aufzuwenden, und stellt sicher, dass Suchmaschinen den richtigen Inhalten Aufmerksamkeit schenken. Außerdem kann die Protokolldateianalyse zeigen, ob Suchmaschinen Ihre Website für leicht verständlich und leicht zu navigieren halten oder ob sie Probleme haben. Dies kann zu Änderungen führen, z. B. zur Korrektur der Verknüpfung von Seiten (im Allgemeinen durch interne Verlinkung) oder zur besseren Organisation von Webadressen.

Einer meiner Lieblingsvorträge zu diesem Thema stammt von Matthew Barby aus dem Jahr 2018, als er Vizepräsident für organisches Wachstum bei HubSpot war. Den genauen Ausschnitt des Vortrags finden Sie bei 25:07:

Rendern

Unter Rendering versteht man den Prozess, wie Suchmaschinen den Inhalt und die Struktur Ihrer Website analysieren und verstehen, um deren Ranking in den SERPs zu bestimmen. Dieser Prozess umfasst zwei Hauptschritte: Crawling (das wir bereits behandelt haben) und Indizierung (worüber wir bald sprechen werden).

Beim Crawlen durchqueren Suchmaschinen-Bots das Web, besuchen Webseiten und sammeln HTML-Daten. Allerdings sind nicht alle Inhalte sofort im HTML-Markup sichtbar. Hier kommt das Rendern ins Spiel.

Das Rendern geht über die einfache HTML-Analyse hinaus und berücksichtigt die dynamischen Elemente, die häufig auf modernen Websites vorkommen und im Roh-HTML möglicherweise nicht sichtbar sind. Dazu gehören Inhalte, die über JavaScript, AJAX oder andere Skriptsprachen geladen werden, sowie das CSS-Stylesheet der Seite. Suchmaschinen-Bots führen bei ihrem Versuch, die Benutzererfahrung zu simulieren, JavaScript aus und sammeln den vollständig gerenderten Inhalt. Dieser Inhalt wird dann verwendet, um einen Index, eine Datenbank mit Informationen über die Webseite, zu erstellen.

Für optimale SEO-Ergebnisse ist es wichtig sicherzustellen, dass Ihre Website von Suchmaschinen-Bots problemlos dargestellt werden kann. Dabei kommen Techniken wie serverseitiges Rendering (SSR) oder Pre-Rendering für JavaScript-lastige Websites zum Einsatz. Die Bereitstellung von Metadaten (wie Meta-Tags und Beschreibungen) hilft Suchmaschinen, den Kontext und die Bedeutung des Inhalts zu verstehen. Der ordnungsgemäße Umgang mit Canonical-Tags und die Verwaltung von Weiterleitungen ist ebenfalls wichtig, um Probleme mit doppeltem Inhalt zu vermeiden.

Indizierung

Unter Indexierung versteht man den Prozess des Sammelns, Organisierens und Speicherns von Informationen über Webseiten, damit diese schnell abgerufen und in den Suchergebnissen angezeigt werden können, wenn ein Benutzer eine relevante Suchanfrage durchsucht. Sobald ein Webcrawler eine Webseite gecrawlt und ihren Inhalt gerendert hat, werden die Informationen dem Index der Suchmaschine hinzugefügt.

Der Index ist im Wesentlichen eine riesige Datenbank, die Informationen über Website-Inhalte und die Struktur von Webseiten im Internet enthält. Durch den Zugriff auf diese umfangreiche Informationsdatenbank können Suchmaschinen schnell auf Benutzeranfragen reagieren, indem sie relevante Seiten aus dem Index finden und in den SERPs anzeigen.

Während des Indexierungsprozesses extrahieren Suchmaschinen wichtige Informationen aus den gecrawlten und gerenderten Webseiten, wie z. B. Inhalte, Metadaten, Bilder und Links. Diese Informationen werden dann strukturiert gespeichert, sodass Suchmaschinen Benutzeranfragen schnell relevanten Seiten zuordnen können.

Es gibt ein paar Dinge, die Sie beachten sollten, damit Ihre Seiten effizient indexiert werden.

Beheben Sie Probleme mit doppelten Inhalten und der Kannibalisierung von Schlüsselwörtern

Die Behebung von Problemen mit doppelten Inhalten und der Kannibalisierung von Schlüsselwörtern bietet erhebliche Vorteile, wenn es darum geht, Ihre Seiten schnell zu indexieren.

Indem Sie doppelte Inhalte entfernen, vermeiden Sie Verwirrung für Suchmaschinen und können die primäre Version Ihrer Inhalte genau identifizieren.

Darüber hinaus liefert die Lösung von Keyword-Kannibalisierungsproblemen – bei denen mehrere Seiten auf dieselben Keywords abzielen – klare Signale für Suchmaschinen über den Fokus jeder Seite. Diese Klarheit hilft bei der effizienten Indexierung und dem Ranking, da Suchmaschinen den genauen Zweck all Ihrer Seiten verstehen können.

Ein Bild, das den Keyword-Kannibalisierungsbericht in SEOTesting zeigt. Dieser Bericht kann Ihnen dabei helfen, Probleme mit der Kannibalisierung von Keywords auf Ihrer Website schnell zu erkennen und zu beheben.

Auch die Optimierung von Metadaten (z. B. Titel-Tags und Meta-Beschreibungen) sowie die Anpassung interner Verlinkungsstrukturen tragen zu einer schnellen und einfachen Indexierung bei. Wenn diese Aktionen richtig durchgeführt werden, leiten sie Suchmaschinen zu den relevantesten und wichtigsten Seiten.

Darüber hinaus wird durch die Konsolidierung von Inhalten und die Vermeidung der Kannibalisierung von Schlüsselwörtern die Autorität Ihres Inhalts auf einer einzigen Seite konzentriert. Dies führt zu einer höheren Seitenautorität und ermutigt Suchmaschinen, diese maßgebliche Seite in den SERPs zu priorisieren und prominenter einzustufen.

Audit-Weiterleitungen

Wenn Sie untersuchen, wie die Weiterleitungen Ihrer Website funktionieren, können Sie die Indexierung Ihrer Inhalte durch Suchmaschinen verbessern. Es kann auch dazu beitragen, die Gesamtleistung Ihrer Website zu verbessern. Weiterleitungen fungieren wie Märkte und leiten sowohl Benutzer als auch Suchmaschinen bei Bedarf zu verschiedenen Seiten. Wenn sie nicht richtig verwaltet werden, können sie den Indexierungsprozess verlangsamen oder die Indexierung von Seiten ganz verhindern. Durch die Durchführung eines „Redirect-Audits“ können Sie die Indizierung auf verschiedene sinnvolle Weise verbessern.

Erstens hilft die Bekämpfung übermäßiger Weiterleitungen den Suchmaschinen, bei der Indizierung Ihrer Website effektiver zu arbeiten. Manchmal kann es vorkommen, dass sie auf mehrere Weiterleitungen stoßen, was die Indizierung Ihrer Inhalte verlangsamen kann. Indem Sie unnötige Weiterleitungen finden und entfernen, können Sie Suchmaschinen dabei helfen, schnell auf Ihre Inhalte zuzugreifen, und ihnen so eine bessere Chance geben, schnell indiziert (und damit gerankt) zu werden.

Durch die Durchführung eines Redirect-Audits können Sie auch ein häufiges technisches SEO-Problem angehen. Weiterleitungsketten. Solche Ketten können auftreten, wenn eine Weiterleitung zu einer anderen führt, diese zu einer anderen führt, die zu einer anderen führt und so weiter. Sie können Suchmaschinen verwirren und zu viel Zeit in Anspruch nehmen. Wir wissen, dass ein Suchmaschinen-Bot, wenn er zu lange braucht, um eine Seite zu indizieren, weitergeht und diese Seite nicht indiziert. Ein Audit ermöglicht es Ihnen, diese Ketten zu finden und zu beheben, sodass Suchmaschinen problemlos auf Ihre Inhalte zugreifen können.

Schließlich wird ein Audit wie dieses den Suchmaschinen helfen, Ihre Website genau zu verstehen. Wenn Weiterleitungen gut strukturiert sind, können Suchmaschinen die Bedeutung Ihrer Inhalte besser interpretieren. Wenn Suchmaschinen die Bedeutung Ihrer Inhalte besser verstehen, haben Ihre wichtigen Seiten eine bessere Chance, schnell indiziert zu werden.

Beheben Sie HTTP- und HTTPS-Fehler

Das Beheben von HTTP- und HTTPS-Fehlern ist von entscheidender Bedeutung, um sicherzustellen, dass Ihre Seiten ordnungsgemäß indiziert werden. Wenn Suchmaschinen-Bots auf solche Fehler stoßen, fällt es ihnen schwer, auf Ihre Inhalte zuzugreifen und sie zu verstehen. Wenn ein Suchmaschinen-Bot nicht auf Ihre Inhalte zugreifen oder diese nicht verstehen kann, kann er sie nicht indizieren.

Durch die Behebung dieser Probleme wird die Indizierung auf folgende Weise verbessert:

Erstens stellt die Behebung von HTTP-Fehlern wie „404 Not Found“ sicher, dass Ihre Seiten sowohl für Benutzer als auch für Suchmaschinen zugänglich sind. Wenn Seiten diese Fehler zurückgeben, interpretieren Suchmaschinen sie als fehlenden Inhalt, was zum Ausschluss aus den Suchergebnissen führt. Durch die Behebung dieser Fehler erhalten Crawler einen „freien Pfad“ zur Indizierung Ihrer Inhalte und erhöhen so die Chancen, dass diese indiziert und in die Rangliste aufgenommen werden.

Zweitens ist der Übergang von HTTP zu HTTPS für die Sicherheit und Indexierung von entscheidender Bedeutung. Suchmaschinen priorisieren in ihren Ranking-Algorithmen sichere Websites (HTTPS) gegenüber nicht sicheren Websites (HTTP). Google hat dies sogar bestätigt! Durch die Migration zu HTTPS und die Gewährleistung eines sicheren Surferlebnisses für Benutzer erhöhen Sie die Glaubwürdigkeit Ihrer Website und verbessern indirekt deren Indexier- und Rankingfähigkeit.

Schließlich verhindern eine konsistente HTTPS-Implementierung und die Behebung von HTTPS-bezogenen Fehlern, dass Benutzer und Suchmaschinen auf Probleme mit „gemischten Inhalten“ stoßen. Gemischter Inhalt entsteht, wenn sichere und nicht sichere Elemente auf derselben Seite geladen werden. Dies könnte möglicherweise zu Sicherheitswarnungen führen und sich negativ auf die Benutzererfahrung auswirken.

Im Wesentlichen beseitigt die Behebung von HTTP- und HTTPS-Fehlern Hindernisse, die Suchmaschinen daran hindern, auf Ihre Inhalte zuzugreifen und diese zu verstehen. Dieser äußerst proaktive Ansatz optimiert den Indexierungsprozess, erhöht die Sichtbarkeit in Suchergebnissen und verbessert das Benutzererlebnis auf Ihrer Website.

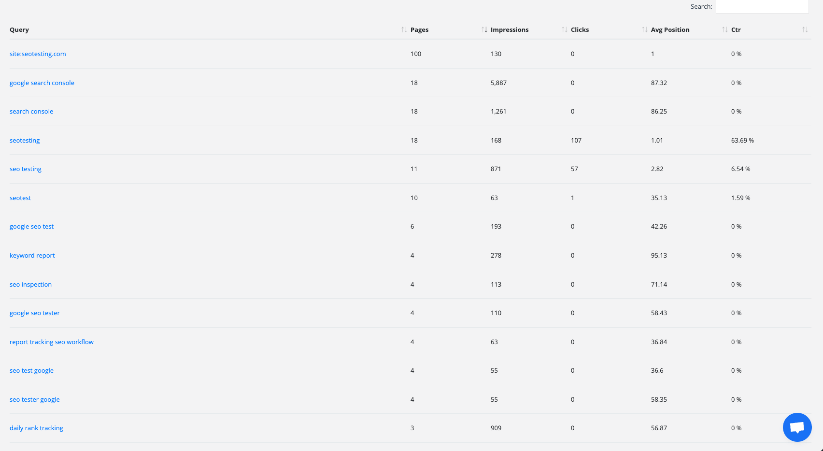

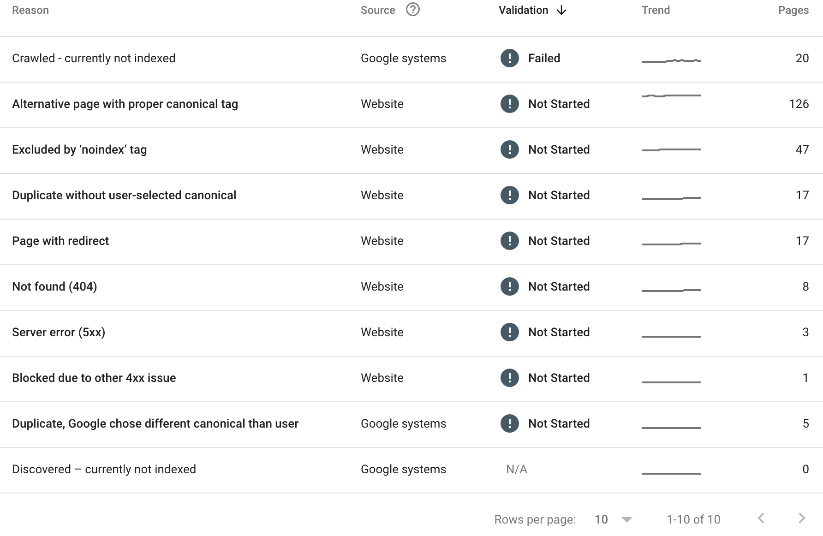

Sehen Sie sich Ihren „Seitenindexierungsbericht“ in der Google Search Console an

Die Google Search Console ist eine Goldgrube für die Beurteilung, wie Ihre Inhalte indiziert werden. In Ihrem Seitenindizierungsbericht können Sie jede einzelne Seite Ihrer Website sehen, die nicht indiziert wurde. Sie können auch den Grund sehen, warum die Seite nicht indiziert wurde.

Hier ist ein Beispiel:

Im obigen Bericht (Seitenindizierungsbericht von SEOTesting) können wir Folgendes sehen:

- 20 Seiten wurden gecrawlt, sind aber derzeit nicht indiziert.

- 126 Seiten haben ein richtiges Canonical-Tag.

- 47 Seiten wurden durch das „noindex“-Tag ausgeschlossen.

- Es wurde festgestellt, dass es sich bei 17 Seiten um Duplikate ohne vom Benutzer ausgewählte kanonische Seiten handelte.

- Auf 17 Seiten ist eine Weiterleitung eingerichtet.

- 8 Seiten haben einen 404-Fehler zurückgegeben.

- 3 Seiten haben einen 5xx-Serverfehler zurückgegeben.

- 1 Seite wurde aufgrund eines anderen 4xx-Problems blockiert.

- 5 Seiten wurden als Duplikate gefunden und Google hat eine andere kanonische Seite gewählt.

Nicht alle der oben genannten Gründe stellen ein Problem dar, aber für uns als Marketingteam lohnt es sich, herauszufinden, warum bestimmte Seiten nicht indiziert wurden, und so viele dieser Probleme wie möglich zu beheben.

Rangfolge

Das Suchmaschinen-Ranking ist der Höhepunkt der Crawling-, Rendering- und Indexierungsprozesse, bei denen Suchmaschinen die Reihenfolge bestimmen, in der Webseiten in den SERPs erscheinen. Ziel ist es, den Nutzern basierend auf ihren Suchanfragen die relevantesten und wertvollsten Inhalte zu präsentieren.

Im Kern basiert das Ranking auf komplexen Algorithmen, die eine Vielzahl von Faktoren bewerten, um die Relevanz und Autorität einer Webseite zu bestimmen. Einer der grundlegenden Aspekte ist die Keyword-Relevanz – wie gut der Inhalt mit den Wörtern und Phrasen übereinstimmt, die Benutzer bei ihrer Suche eingeben. Seiten mit hoher Keyword-Relevanz erzielen tendenziell ein besseres Ranking.

Die Keyword-Relevanz allein reicht jedoch nicht aus. Suchmaschinen berücksichtigen auch die Qualität und Autorität der Website. Backlinks von seriösen, maßgeblichen und relevanten (das ist entscheidend) Websites sind ein starker Indikator für die Glaubwürdigkeit einer Seite. Je mehr hochwertige Backlinks eine Seite hat, desto wahrscheinlicher ist es, dass sie einen höheren Rang erhält.

Auch die Erfahrung, die Nutzer auf Ihrer Website machen, spielt eine große Rolle für das Ranking. Seiten, die schnell laden, für Mobilgeräte geeignet sind und dem Benutzer ein reibungsloses Surferlebnis bieten, werden von Suchmaschinen stark bevorzugt. Ansprechende und wertvolle Inhalte, die dafür sorgen, dass Nutzer länger auf Ihrer Website bleiben und weitersurfen, signalisieren den Suchmaschinen auch, dass Ihre Website möglicherweise einen höheren Rang wert ist.

Personalisierung ist ein weiterer Aspekt des Rankings. Suchmaschinen berücksichtigen den Standort, den Suchverlauf und die Präferenzen des Benutzers, um die Suchergebnisse anzupassen und dem Benutzer das bestmögliche Erlebnis zu bieten. Dies bedeutet, dass dieselbe Abfrage höchstwahrscheinlich für verschiedene Benutzer unterschiedliche Ergebnisse liefert.

Es ist wichtig, sich daran zu erinnern, dass wir unabhängig davon, was in anderen Blogbeiträgen erwähnt wird, nicht wissen, welches Gewicht Google (und andere Suchmaschinen) verschiedenen Faktoren bei verschiedenen Suchanfragen beimessen. Bei einer Frage müssen Sie sich möglicherweise stärker auf maßgebliche und relevante Backlinks verlassen. Zum anderen müssen Sie möglicherweise sicherstellen, dass Ihre Benutzererfahrung stimmt. Dies hängt alles von der Zeit in der Branche ab, vom Erlernen des Algorithmus und von der Verbesserung im Laufe der Zeit.

Das Verständnis verschiedener SEO-Aspekte ist entscheidend für den Erfolg in den SERPs. In diesem Artikel wurden die Bedeutung von technischem SEO, die Merkmale optimierter Websites und die Mechanismen von technischem SEO vom Crawling bis zum Ranking untersucht.

Technisches SEO bildet eine solide Basis für Ihre Website und optimiert Elemente für eine bessere Geschwindigkeit und Struktur. Dies verbessert die Navigation, das Inhaltsverständnis und die Benutzererfahrung.

Kurz gesagt, technisches SEO ist der Schlüssel. Durch die Behebung von Fehlern und die Optimierung der Website-Struktur können Sie Ihre Online-Präsenz verbessern.

Möchten Sie Ihre Nutzung der Google Search Console optimieren und Ihre SEO auf die nächste Stufe heben, indem Sie SEO-Tests in Ihre Routine integrieren? Probieren Sie SEOTesting aus. Wir führen derzeit eine 14-tägige kostenlose Testversion durch, für deren Anmeldung keine Kreditkarte erforderlich ist. Probieren Sie das Tool noch heute aus und teilen Sie uns Ihre Meinung mit!