Die wahren Kosten für die Erstellung Ihres eigenen Webcrawlers

Veröffentlicht: 2023-08-09Web Scraping ist die gebräuchlichste Methode, um Daten aus mehreren Quellen zu sammeln und wichtige Informationen aus dem Internet abzuleiten. Dieser Prozess wird verwendet, um datengestützte Lösungen für alles zu ermöglichen, vom Preisabgleich auf E-Commerce-Websites bis hin zur Entscheidungsfindung an der Börse. Mit der steigenden Nachfrage nach dem Scraping von Daten aus dem Web überschwemmen Tools und Dienste, die das Web-Scraping erleichtern können, auch das Internet. Alle diese gehören jedoch zu einer von drei Unterkategorien:

- Erstellen eines internen Web-Scraping-Tools mithilfe von Bibliotheken wie BeautifulSoup in Python und Bereitstellen in einem Cloud-Service wie AWS.

- Verwendung einer halbautomatischen Scraping-Software, mit der Teile des Bildschirms erfasst werden können. Für die Ersteinrichtung ist ein gewisser menschlicher Eingriff erforderlich, wiederholte Aufgaben können jedoch automatisiert werden. Der Grad der Automatisierung ist jedoch begrenzt, das Produkt- oder Geschäftsteam muss möglicherweise eine steile Lernkurve für die Verwendung des Tools durchlaufen und nicht alle Websites können mit diesen Tools gescrapt werden. Sie werden zusätzliche Schwierigkeiten beim Umgang mit Websites haben, die mithilfe von Technologien wie Javascript dynamische Inhalte generieren.

- DaaS-Anbieter wie PromptCloud stellen Ihnen einen benutzerdefinierten Datenfeed zur Verfügung, der auf den Websites und Datenpunkten basiert, die Sie als Anforderungen einreichen. Diese Dienste berechnen Ihnen in der Regel eine Gebühr basierend auf der von Ihnen verbrauchten Datenmenge – Ihre monatliche Rechnung basiert also nur auf der Menge der gescrapten Daten und eignet sich für Unternehmen jeder Größe.

Nun denken viele Unternehmen möglicherweise, dass die mit den Punkten b oder c verbundenen Kosten zu hoch sind, und beschließen, selbst einen Webcrawler zu entwickeln. Warum nicht? Ich google gerade „Wie baut man einen Webcrawler?“ würde Ihnen Hunderte von Ergebnissen liefern. Einige davon funktionieren möglicherweise sogar für Ihren Anwendungsfall. Aber wie hoch sind die tatsächlichen Kosten für die Entwicklung eines Webcrawlers der Enterprise-Klasse, dessen Bereitstellung in der Cloud und dessen Wartung und Aktualisierung im Laufe der Zeit? Lass es uns herausfinden.

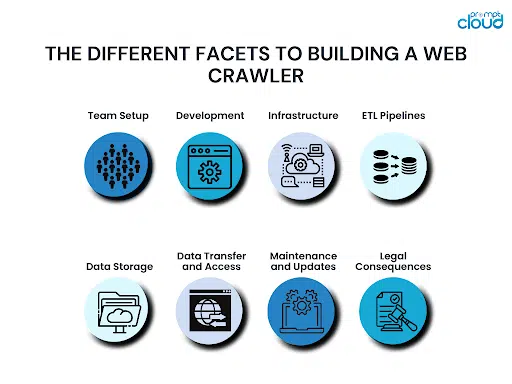

Die verschiedenen Facetten beim Aufbau eines Webcrawlers

Beim Aufbau eines Webcrawlers sind verschiedene Aspekte zu beachten. Wenn Sie all dies nicht berücksichtigen, kann es sein, dass Sie am Ende mehr abbeißen, als Sie kauen können. Das würde Sie schon vor dem Ziel zu viel kosten und Sie stünden vor der Entscheidung, weiterzumachen oder aufzugeben.

Teamaufbau:

Wichtige Voraussetzungen für die Erstellung eines Webcrawlers sind Programmierkenntnisse und Vorkenntnisse in der Erstellung eines Webcrawlers. Selbst wenn Sie über ein technisches Team verfügen, fehlt Ihnen möglicherweise jemand mit Vorkenntnissen, der die Führung übernimmt. Ohne jemanden mit Erfahrung kann es passieren, dass Sie kritische Fehler machen und diese erst erkennen, wenn es zu spät ist.

Entwicklung:

Sobald Sie das Team bereit haben, muss es sich an die Entwicklung Ihres Webcrawlers machen. Dieser Crawler sollte in der Lage sein, alle erforderlichen Datenpunkte von allen Websites in Ihrer Liste zu crawlen. Daher wird es nicht nur viel Zeit in Anspruch nehmen, den Crawler zu erstellen, sondern auch Randfälle zu testen und sicherzustellen, dass er zu keinem Zeitpunkt abstürzt. Je nachdem, wie groß und erfahren Ihr Team ist, kann die Erstellung eines neuen Webcrawlers von Grund auf zwischen einigen Monaten und einigen Quartalen dauern.

Infrastruktur:

Den perfekten Webcrawler zu bauen ist schwierig. Noch schwieriger ist es, sich für eine Cloud-Infrastruktur mit hoher Verfügbarkeit zu entscheiden, die zudem kostenoptimiert ist. Ihre Infrastruktur muss außerdem skalierbar sein, damit sie sich an das Wachstum Ihres Unternehmens anpassen kann und wenn Sie Daten aus mehr Quellen abrufen müssen.

ETL-Pipelines:

Es reicht möglicherweise nicht aus, die benötigten Datenpunkte von den Websites Ihrer Wahl zu extrahieren. Normalerweise müssen die Daten auch normalisiert, formatiert, bereinigt und sortiert werden, bevor sie auf einem Speichermedium gespeichert werden. All dies würde mehr Rechenleistung erfordern. Da diese Pipelines den Datenfluss verzögern würden, wäre es von entscheidender Bedeutung, über die richtige Infrastruktur zum Einrichten Ihrer ETL-Pipelines in der Cloud zu verfügen.

Datenspeicher:

Sobald Ihre Daten gelöscht, bereinigt und bereit sind, müssen Sie sie auf einem geeigneten Speichermedium ablegen. Dies kann eine SQL- oder eine NoSQL-Datenbank sein. Es könnte sich auch um eine Data-Warehousing-Lösung wie Redshift handeln. Die Wahl der Datenbank hängt davon ab, wie viele Daten Sie speichern möchten, wie oft Sie die Daten aktualisieren oder abrufen möchten, ob sich die Anzahl der Spalten in Zukunft ändern kann und mehr. Wie die übrigen Ressourcen muss auch die Datenbank in der Cloud gehostet werden, sodass auch die Preisgestaltung berücksichtigt werden muss.

Datenübertragung und Zugriff:

Nachdem Sie die Daten nun gescrapt und in einer Datenbank gespeichert haben, möchten Sie sie möglicherweise in bestimmten Abständen oder sogar kontinuierlich abrufen. Sie können REST-APIs erstellen, um der Außenwelt Zugriff auf Ihre Daten zu gewähren. Der Aufbau und die Wartung der Datenzugriffsschicht würden Zeit in Anspruch nehmen und Ihnen wird eine Gebühr basierend auf der von Ihnen durchgeführten Datenübertragungsmenge in Rechnung gestellt.

Wartung und Updates:

Ein Webcrawler ist niemals endgültig. Es ist nur eine Version. Sobald eine Website, von der Daten erfasst werden, geändert oder aktualisiert wird, muss eine neuere Version erstellt werden. Das Hinzufügen komplexer Websites zur Liste der zu scannenden Websites erfordert möglicherweise auch eine Aktualisierung Ihres Crawlers. Die regelmäßige Wartung und Überwachung Ihrer Cloud-Ressourcen ist ebenfalls von entscheidender Bedeutung, um sicherzustellen, dass keine Fehler im System auftreten und Ihre Cloud-Computing-Ressourcen fehlerfrei sind.

Rechtliche Konsequenzen:

Wenn Sie Daten aus dem Internet extrahieren, müssen Sie sich an bestimmte Landesgesetze halten. Dabei handelt es sich um die Datenschutzgesetze des Landes, in dem Sie tätig sind, sowie um die Gesetze der Länder, deren Daten Sie extrahieren. Jeder Fehler kann teure Klagen nach sich ziehen. Manchmal reichen die Auszahlungen, Vergleiche oder Anwaltskosten aus, um ein Unternehmen nach Down Under zu bringen.

Die bessere Web-Scraping-Lösung für Unternehmen

Die größten Kosten, die Sie für den Aufbau Ihrer eigenen Web-Scraping-Lösung zahlen, sind nicht einmal Geld. Es ist Zeit – Ihr Unternehmen muss warten, bis die Lösung betriebsbereit ist, neue Quellen hinzugefügt werden und vieles mehr. Stattdessen wäre es eine kluge Wahl, sich für eine voll funktionsfähige DaaS-Lösung zu entscheiden, die Ihnen saubere, gebrauchsfertige Daten und einfache Integrationsoptionen bietet. Aus diesem Grund bietet unser Team bei PromptCloud unseren Benutzern vollständig verwaltete Web-Scraping-Lösungen, die in der Cloud gehostet werden.

Sie können mit der Nutzung von Daten von überall im Web in nur drei Schritten beginnen: Sie übermitteln uns eine Liste von Websites und Datenpunkten, validieren die Ergebnisse eines Demo-Crawlers und fahren dann mit der endgültigen Integration fort. Da es sich um eine cloudbasierte Lösung handelt, berechnen wir Ihnen nur die von Ihnen verbrauchte Datenmenge – daher ist die Lösung für Unternehmen jeder Größe erschwinglich. Eine detaillierte Berechnung zeigt Ihnen, wie Sie tatsächlich Geld sparen, wenn Sie sich für eine verwaltete DaaS-Lösung entscheiden oder einen eigenen Webcrawler erstellen.

Für weitere Informationen kontaktieren Sie unser Vertriebsteam unter [email protected]