Web Scraping-Techniken 2023 – Ein vollständiger Leitfaden

Veröffentlicht: 2023-07-06In der riesigen Welt der Online-Schatzsuche ist Web Scraping zum ultimativen Werkzeug zum Extrahieren wertvoller Informationsschätze geworden. Egal, ob Sie ein einsamer Abenteurer oder ein datenhungriges Unternehmen sind, Web Scraping ist die zuverlässige Spitzhacke in Ihrem digitalen Werkzeugkasten.

Allerdings sind nicht alle Web-Scraping-Techniken gleich. Es ist, als würde man die perfekte Angelrute für die jeweilige Aufgabe auswählen. Schließlich würde man doch keinen winzigen Haken mitbringen, um eine kolossale Kreatur wie Moby Dick zu fangen, oder? In diesem Blog enthüllen wir die Geheimnisse hinter manuellen, automatisierten und fortschrittlichen Web-Scraping-Techniken.

Stellen Sie sich vor, Sie stellen ein Team aus Superhelden zusammen, von denen jeder seine eigenen besonderen Kräfte und Schwächen hat. Ebenso hat jeder Scraping-Ansatz seine Stärken und Grenzen.

Aber vergessen wir nicht, wie wichtig verantwortungsvolles Handeln beim Web Scraping ist. So wie ein Ritter niemals seinen Eid brechen würde, ist es wichtig, ethisch zu handeln und die Nutzungsbedingungen der Websites zu respektieren, die Sie scrapen möchten.

Automatisierte Web-Scraping-Techniken

Unter automatisiertem Web Scraping versteht man den Prozess der Verwendung von Software oder Tools zum automatischen Extrahieren von Daten von Websites. Dieser automatisierte Ansatz macht das manuelle Kopieren und Einfügen von Daten überflüssig und ermöglicht eine effiziente und umfangreiche Datenerfassung aus verschiedenen Online-Quellen.

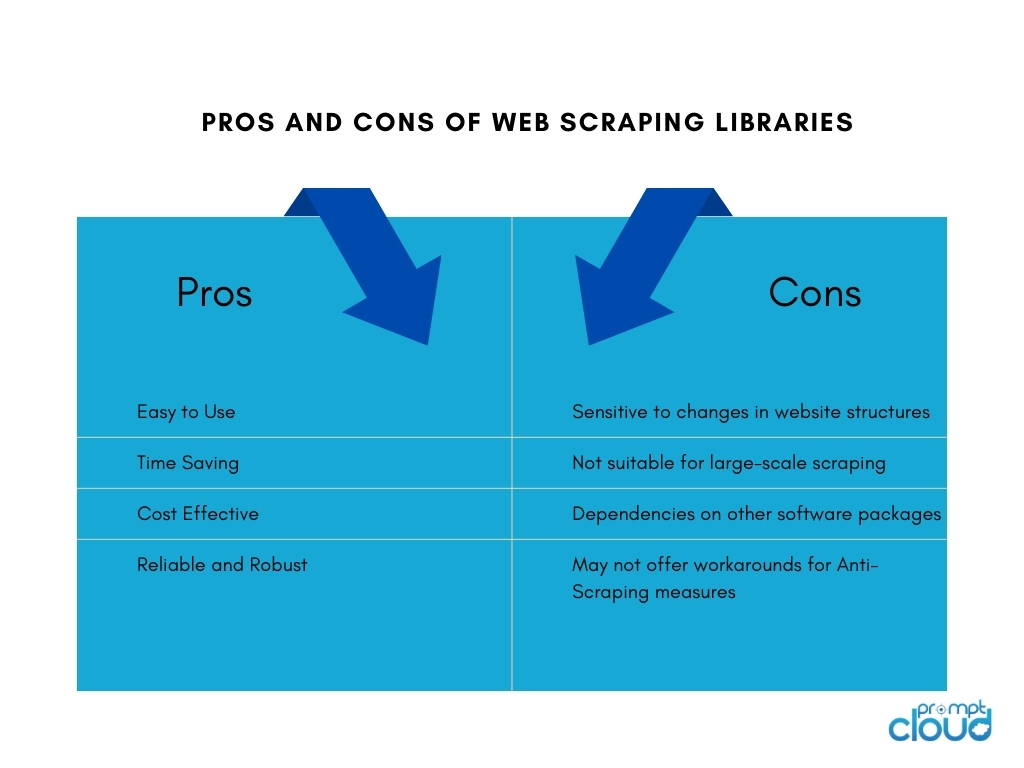

1. Web-Scraping-Bibliotheken

Web-Scraping-Bibliotheken sind Softwaretools oder Frameworks, die vorgefertigte Funktionen und Dienstprogramme zur Erleichterung von Web-Scraping-Aufgaben bereitstellen. Sie bieten eine vereinfachte und effiziente Möglichkeit, Web Scraping durchzuführen, ohne alles von Grund auf neu schreiben zu müssen. Sie sparen Zeit, steigern die Produktivität und ermöglichen eine effizientere Datenerfassung aus verschiedenen Online-Quellen.

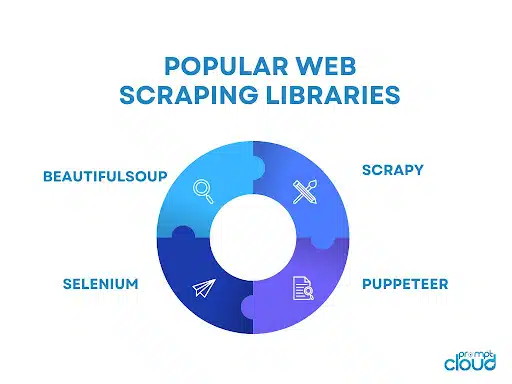

Zu den beliebten Web-Scraping-Bibliotheken gehören:

- BeautifulSoup: Eine weit verbreitete Python-Bibliothek für Web-Scraping, die eine intuitive API zum Parsen von HTML- und XML-Dokumenten bietet und es Benutzern ermöglicht, mühelos zu navigieren und Daten zu extrahieren.

- Scrapy: Ein leistungsstarkes Python-Framework für Web Scraping, das einen umfassenden Satz an Tools zum Erstellen skalierbarer und effizienter Webcrawler mit Funktionen wie automatischer Anforderungsdrosselung, Elementpipelines und integrierter Unterstützung für die Handhabung der Paginierung bereitstellt.

- Selenium: Eine vielseitige Bibliothek, die automatisierte Browserinteraktionen für Web Scraping ermöglicht, besonders nützlich beim Umgang mit dynamischen Inhalten und JavaScript-lastigen Websites.

- Puppeteer: Eine Node.js-Bibliothek, die eine High-Level-API zur Steuerung eines Headless-Chrome- oder Chromium-Browsers bereitstellt und so Web Scraping und Interaktion mit Webseiten mithilfe von JavaScript ermöglicht.

2. Web-Scraping-Tools und -Dienste

Web-Scraping-Tools

Web-Scraping-Tools sind Softwareanwendungen oder Plattformen, die speziell für die Automatisierung und Vereinfachung des Web-Scraping-Prozesses entwickelt wurden. Diese Tools bieten oft eine benutzerfreundliche Oberfläche, die es Benutzern ermöglicht, die Daten anzugeben, die sie von Websites extrahieren möchten, ohne dass umfangreiche Programmierkenntnisse erforderlich sind.

Sie bieten in der Regel Funktionen wie die Point-and-Click-Auswahl von Datenelementen, Planungs- und Überwachungsfunktionen sowie Datenexportoptionen. Web-Scraping-Tools können für Einzelpersonen oder Unternehmen von Vorteil sein, die eine Datenextraktion benötigen, ohne dass umfangreiche Codierungs- oder Entwicklungsressourcen erforderlich sind.

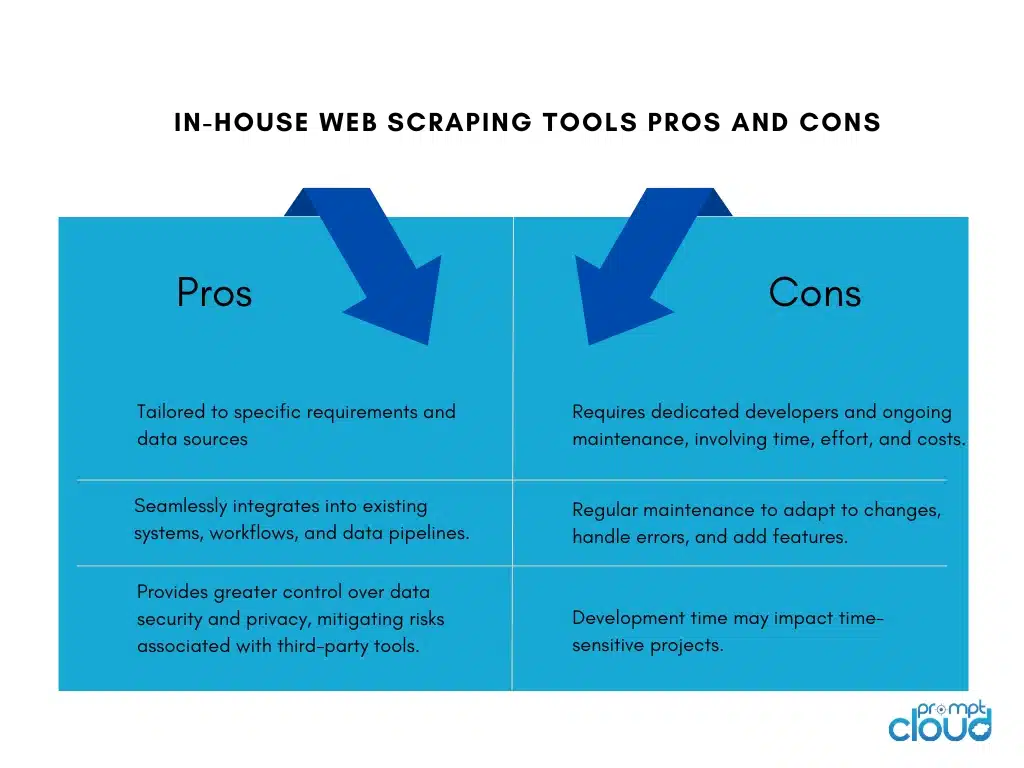

Erstellen interner Web-Scraping-Tools

Der Aufbau eines internen Web-Scraping-Tools für ein Unternehmen hat seine Vor- und Nachteile:

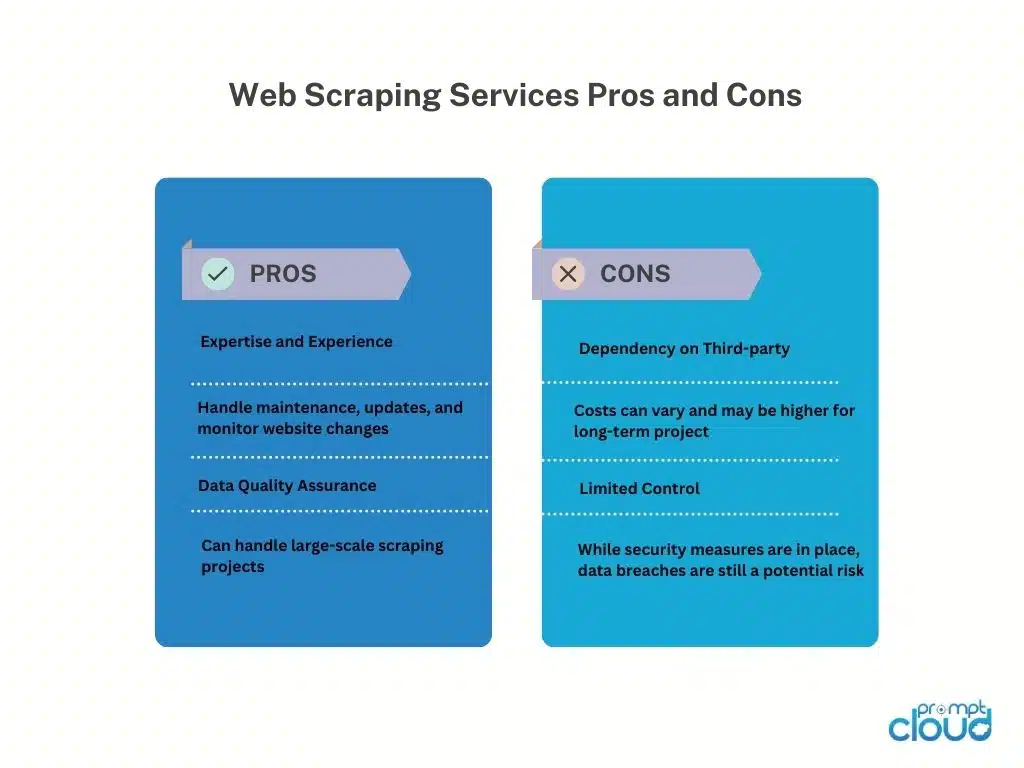

Web-Scraping-Dienste

Web-Scraping-Dienstleister bieten spezielle Dienste zur Datenextraktion von Websites an. Diese Anbieter verfügen in der Regel über Infrastruktur, Tools und Fachwissen zur Abwicklung von Web-Scraping-Aufgaben im Auftrag ihrer Kunden.

Hier sind die Vor- und Nachteile der Nutzung von Web-Scraping-Dienstleistern:

Web-Scraping-APIs

Web-Scraping-APIs bieten eine programmgesteuerte Schnittstelle, die es Entwicklern ermöglicht, mithilfe standardisierter Methoden auf Daten von Websites zuzugreifen und diese abzurufen. Diese APIs bieten im Vergleich zu herkömmlichen Scraping-Techniken einen strukturierteren und kontrollierteren Ansatz für Web Scraping. Entwickler können Anfragen an die API senden, die von ihnen benötigten Daten angeben und die extrahierten Daten in einem strukturierten Format wie JSON oder XML erhalten.

Vorteile

Web-Scraping-APIs vereinfachen den Scraping-Prozess und ermöglichen Entwicklern, sich auf die Integration der API und den Umgang mit den Daten zu konzentrieren. Aufgrund der Wartung durch den Anbieter bieten sie Zuverlässigkeit und Leistung und können Funktionen wie Authentifizierung und Ratenbegrenzung umfassen. APIs unterstützen auch die Einhaltung von Nutzungsbedingungen und gesetzlichen Anforderungen.

Nachteile

Die Verwendung von Web-Scraping-APIs unterliegt Einschränkungen. Datenverfügbarkeit und -funktionen hängen vom API-Anbieter ab, mit möglichen Einschränkungen bei unterstützten Websites und Scraping-Limits. Die Abhängigkeit von externen APIs führt zu einer Abhängigkeit von der Verfügbarkeit und Leistung des Anbieters, was sich auf den Datenabruf auswirkt. Darüber hinaus können Kosten im Zusammenhang mit der großvolumigen oder kommerziellen Nutzung entstehen.

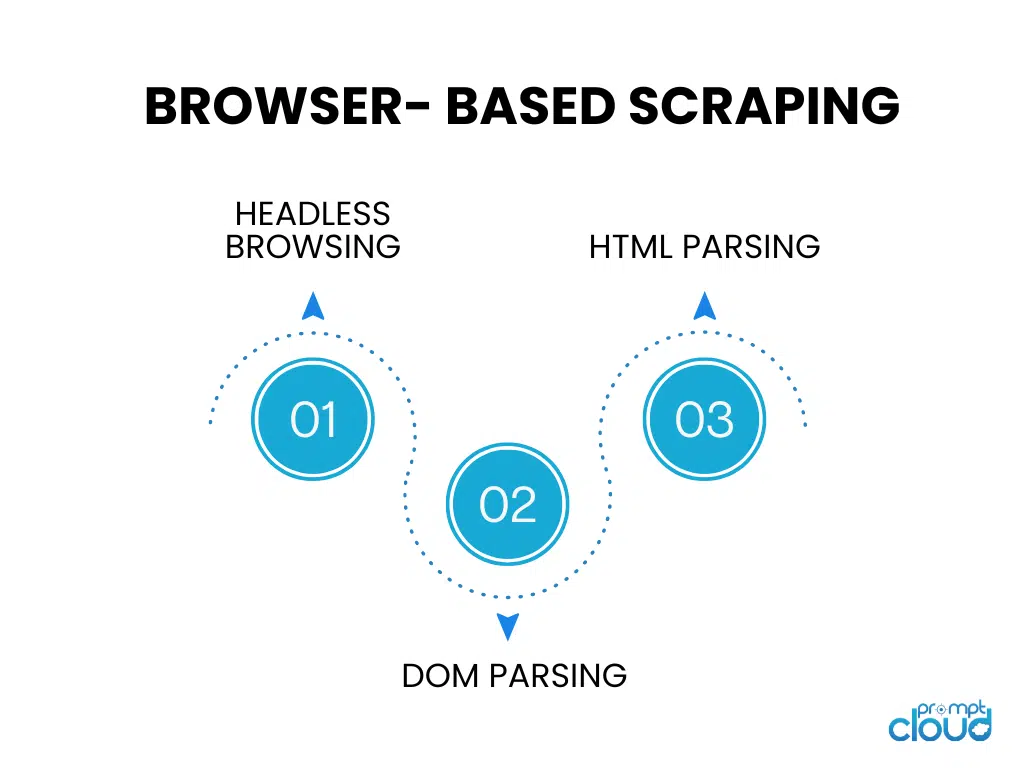

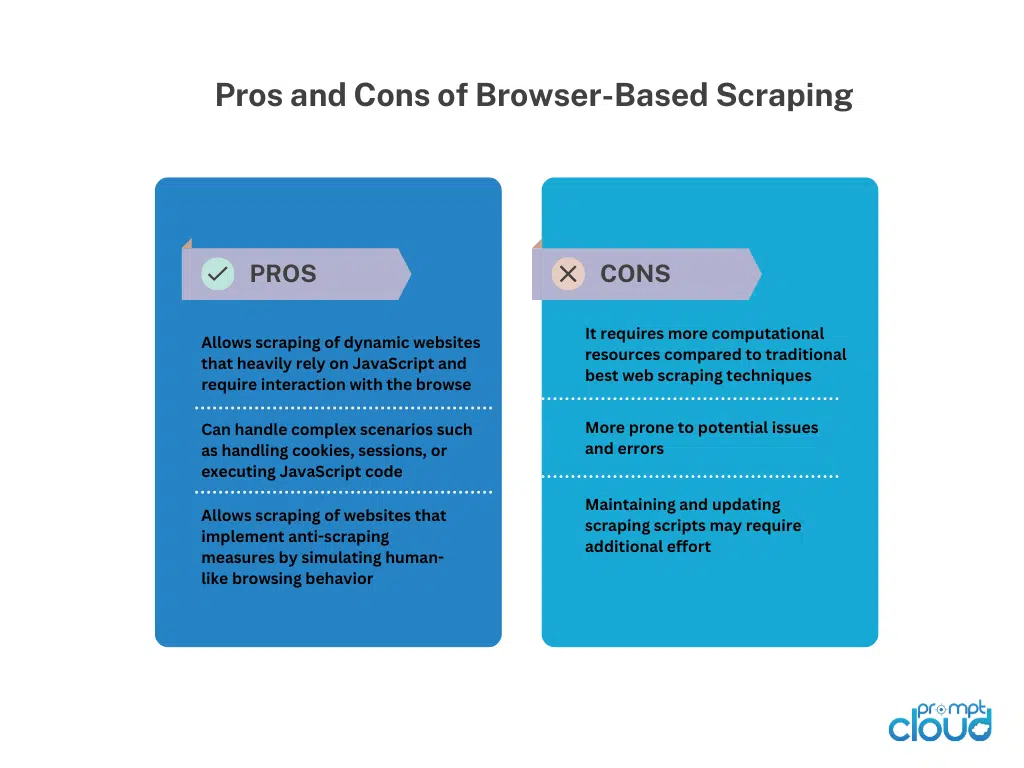

Browserbasiertes Scraping

Kopfloses Surfen

Headless Browsing führt einen Webbrowser ohne grafische Benutzeroberfläche aus und ermöglicht so automatisiertes Surfen und Interaktion mit Websites mithilfe von Code. Es eignet sich ideal zum Scrapen dynamischer Websites, die stark auf clientseitigem Rendering basieren.

DOM-Analyse

Beim DOM-Parsing wird die HTML-Struktur einer Webseite durch Zugriff auf deren Dokumentobjektmodell manipuliert. Dies ermöglicht die gezielte programmgesteuerte Extraktion von Elementen, Attributen oder Texten.

HTML-Parsing

Beim HTML-Parsing wird der HTML-Quellcode einer Webseite analysiert, um die gewünschten Daten zu extrahieren. Es verwendet Bibliotheken oder Parser, um die HTML-Struktur zu interpretieren und bestimmte Tags, Attribute oder Muster für die Datenextraktion zu identifizieren. HTML-Parsing wird häufig zum Scrapen statischer Webseiten ohne JavaScript-Ausführung verwendet.

Manuelle Web-Scraping-Techniken

Manuelle Web-Scraping-Techniken

Beim manuellen Web-Scraping handelt es sich um den Prozess des manuellen Extrahierens von Daten von Websites, ohne den Einsatz automatisierter Tools oder Skripte. Es erfordert menschliches Eingreifen, um auf Websites zu navigieren, nach relevanten Informationen zu suchen und Daten mithilfe verschiedener Techniken zu extrahieren.

Techniken für manuelles Web Scraping:

Bildschirmaufnahme: Bei dieser Technik werden Screenshots oder Videos von Webseiten aufgenommen, um visuelle Daten wie Bilder, Diagramme oder Tabellen zu extrahieren, die programmgesteuert nur schwer zu analysieren sind.Die manuelle Extraktion aus den erfassten Medien ermöglicht den Datenabruf.

Dateneingabe: Bei der Dateneingabe werden erforderliche Informationen manuell von Webseiten kopiert und in ein gewünschtes Format wie Tabellenkalkulationen oder Datenbanken eingegeben.Dazu gehört das Navigieren auf Webseiten, das Auswählen von Daten und deren Eingabe in das Ziel. Die Dateneingabe eignet sich für strukturierte Daten, die einfach kopiert und eingefügt werden können.

Manuelles Web-Scraping bietet Flexibilität beim Umgang mit komplexen Websites, JavaScript-Interaktivität oder Anti-Scraping-Maßnahmen. Allerdings ist es zeitaufwändig, für umfangreiche Aufgaben weniger geeignet und anfällig für menschliche Fehler. Es erfordert menschlichen Einsatz, Liebe zum Detail und eine sorgfältige Ausführung.

Hybride Web-Scraping-Techniken

Hybrides Web Scraping kombiniert automatisierte Tools und manuelle Eingriffe für eine effiziente und genaue Datenextraktion von Websites. Automatisierte Tools übernehmen wiederkehrende Aufgaben wie Navigation und strukturierte Datenextraktion, während manuelle Techniken wie Bildschirmaufnahme oder Dateneingabe komplexe Szenarien und visuelle/nicht strukturierte Daten bewältigen.

Hybrid Web Scraping bietet Skalierbarkeit und Automatisierungsgeschwindigkeit sowie die Flexibilität des menschlichen Urteilsvermögens. Es eignet sich für Websites mit unterschiedlichen Strukturen, dynamischen Inhalten oder Anti-Scraping-Maßnahmen. Die Wahl hängt von der Komplexität der Website, dem Datentyp und den verfügbaren Ressourcen ab und bietet einen ausgewogenen Ansatz für eine umfassende Datenextraktion.