Prevención del colapso del modelo de IA: abordar el riesgo inherente de los conjuntos de datos sintéticos

Publicado: 2023-10-05La Inteligencia Artificial (IA) ha transformado significativamente nuestra vida cotidiana al sugerir contenido personalizado en plataformas de streaming y habilitar asistentes digitales en teléfonos inteligentes. Ahora, estos avances son posibles gracias a sofisticados modelos de IA que aprenden de grandes cantidades de datos.

Según varios informes, el contenido generado por IA es cada vez más frecuente en Internet y podría representar hasta el 90% de la información en línea en los próximos años.

Con tal afluencia de información, se puede decir fácilmente que en el mundo actual, rico en datos, la IA enfrenta un desafío único: ahogarse con su abundancia de datos.

Los informes sugieren además que la cantidad significativa de este contenido generado por IA puede abrumar a las personas con información excesiva, lo que les dificulta determinar qué es confiable y qué es generado por humanos. Además, existe preocupación por la posible pérdida de empleos en campos creativos como el arte, el periodismo y la escritura, todo porque la IA se está volviendo más capaz de producir contenido tradicionalmente creado por humanos.

En cuanto a los sistemas de IA en sí, están surgiendo problemas como el “Colapso del modelo”, que se refiere a un problema en el que los modelos de IA entrenados en grandes conjuntos de datos producen resultados de menor calidad al priorizar la elección de palabras comunes sobre las alternativas creativas. El “trastorno de autofagia del modelo” o “IA de Habsburgo” es otra preocupación en la que los sistemas de IA excesivamente entrenados en los resultados de otros modelos de IA pueden exhibir características indeseables o tener sesgos.

Estos desafíos pueden dañar potencialmente la calidad y confiabilidad del contenido generado por IA, destruyendo la confianza en dichos sistemas y empeorando la sobrecarga de información.

Nuestro blog lo ayudará a comprender todo lo relacionado con abordar la prevención del colapso del modelo de IA. A medida que avanza la revolución de la IA generativa, genera importantes desafíos e incertidumbres para el panorama de la información en línea. Entonces, profundicemos en los detalles de frente.

Comprender el colapso del modelo de IA

En el aprendizaje automático, el “colapso del modelo” se refiere a una situación en la que el modelo de IA no logra proporcionar una variedad de resultados útiles. En cambio, produce un conjunto limitado de resultados repetitivos o de baja calidad. Este problema puede ocurrir en varios modelos, pero a menudo se observa durante el entrenamiento de modelos complejos como las redes generativas adversarias (GAN). El colapso del modelo puede obstaculizar la capacidad del modelo para generar resultados diversos y valiosos, lo que afecta su rendimiento general.

Ilustremos un ejemplo de colapso del modelo. Imaginemos a un estudiante de arte muy entusiasta que representa nuestro modelo de IA y que tiene la tarea de crear pinturas de cebras. Al principio, su obra de arte es impresionante y se parece claramente a las cebras. Sin embargo, sus pinturas pierden gradualmente su parecido con las cebras a medida que avanzan y la calidad disminuye. Esto es similar al "colapso del modelo" en el aprendizaje automático, donde el modelo de IA, como nuestro estudiante de arte, inicialmente funciona bien pero luego lucha por mantener las características esenciales para las que fue diseñado.

Según los avances recientes en IA, los investigadores se han interesado mucho en utilizar datos artificiales o sintéticos para entrenar nuevos modelos de IA cuando se trata de generar imágenes y texto. Sin embargo, un concepto llamado 'Trastorno modelo de autofagia' (MAD) compara este proceso con un bucle autodestructivo.

A menos que sigamos añadiendo datos nuevos del mundo real con regularidad, la calidad y variedad de los modelos de IA que creamos utilizando datos sintéticos podrían empeorar con el tiempo. Por lo tanto, es esencial lograr un equilibrio entre datos sintéticos y reales para que los modelos de IA sigan funcionando bien.

Este equilibrio es crucial para evitar una disminución en la calidad y diversidad de los modelos a medida que continúan aprendiendo. Descubrir cómo utilizar eficazmente los datos sintéticos para prevenir el colapso del modelo de IA es un desafío constante cuando se trata de la evolución de la IA generativa y el uso de datos sintéticos.

Según The New Yorker, si ChatGPT se considera una versión compacta de Internet, similar a la de un archivo JPEG que comprime una fotografía, entonces entrenar a los futuros chatbots con los resultados de ChatGPT equivale digitalmente a hacer fotocopias repetidas de fotocopias como el viejos tiempos. Simplemente, la calidad de la imagen empeorará con cada iteración.

Por lo tanto, para superar este desafío, las organizaciones deben centrarse en perfeccionar sus enfoques para garantizar que estos productos de IA generativa sigan brindando respuestas precisas en este panorama digital.

[Lea también: IA responsable: abordar los desafíos de la adopción con principios rectores y estrategias]

¿Cómo ocurre el colapso del modelo de IA?

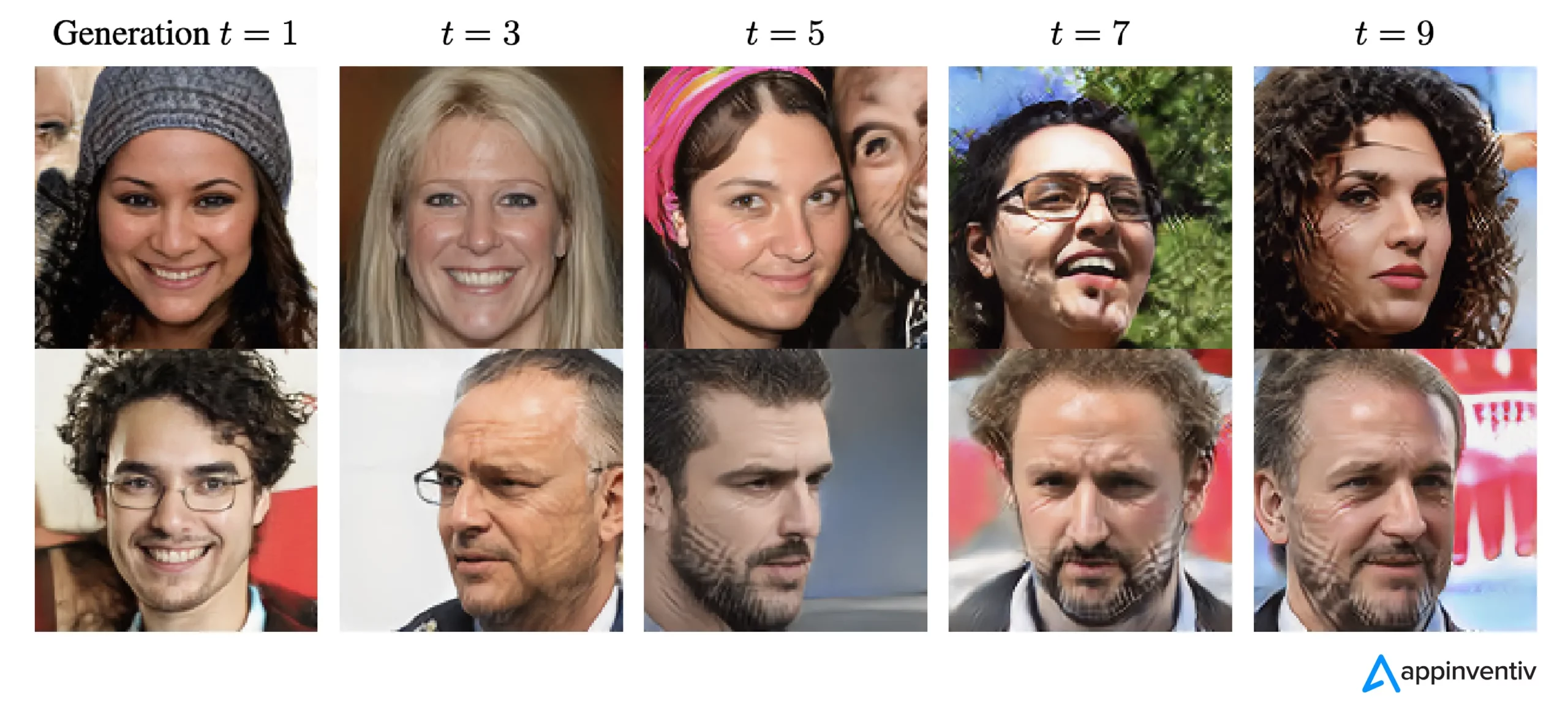

El colapso del modelo ocurre cuando se entrenan nuevos modelos de IA utilizando datos generados por modelos más antiguos. Estos nuevos modelos se basan en los patrones observados en los datos generados. El colapso del modelo tiene sus raíces en la idea de que los modelos generativos tienden a repetir patrones que ya han aprendido, y hay un límite en la información que pueden extraer de estos patrones.

En los casos de colapso del modelo, los eventos que probablemente sucederán se exageran, mientras que los eventos menos probables se subestiman. A lo largo de varias generaciones, los eventos probables dominan los datos, y las partes menos comunes pero aún cruciales de los datos, llamadas colas, disminuyen. Estas colas son esenciales para mantener la precisión y diversidad de los resultados del modelo. A medida que avanzan las generaciones, los errores conquistan los datos y el modelo los malinterpreta cada vez más.

Según la investigación, existen dos tipos de colapso del modelo: temprano y tardío. El colapso temprano del modelo implica que el modelo pierda información sobre eventos raros. En el colapso tardío del modelo, el modelo difumina patrones distintos en los datos, lo que da como resultado resultados que tienen poca semejanza con los datos originales.

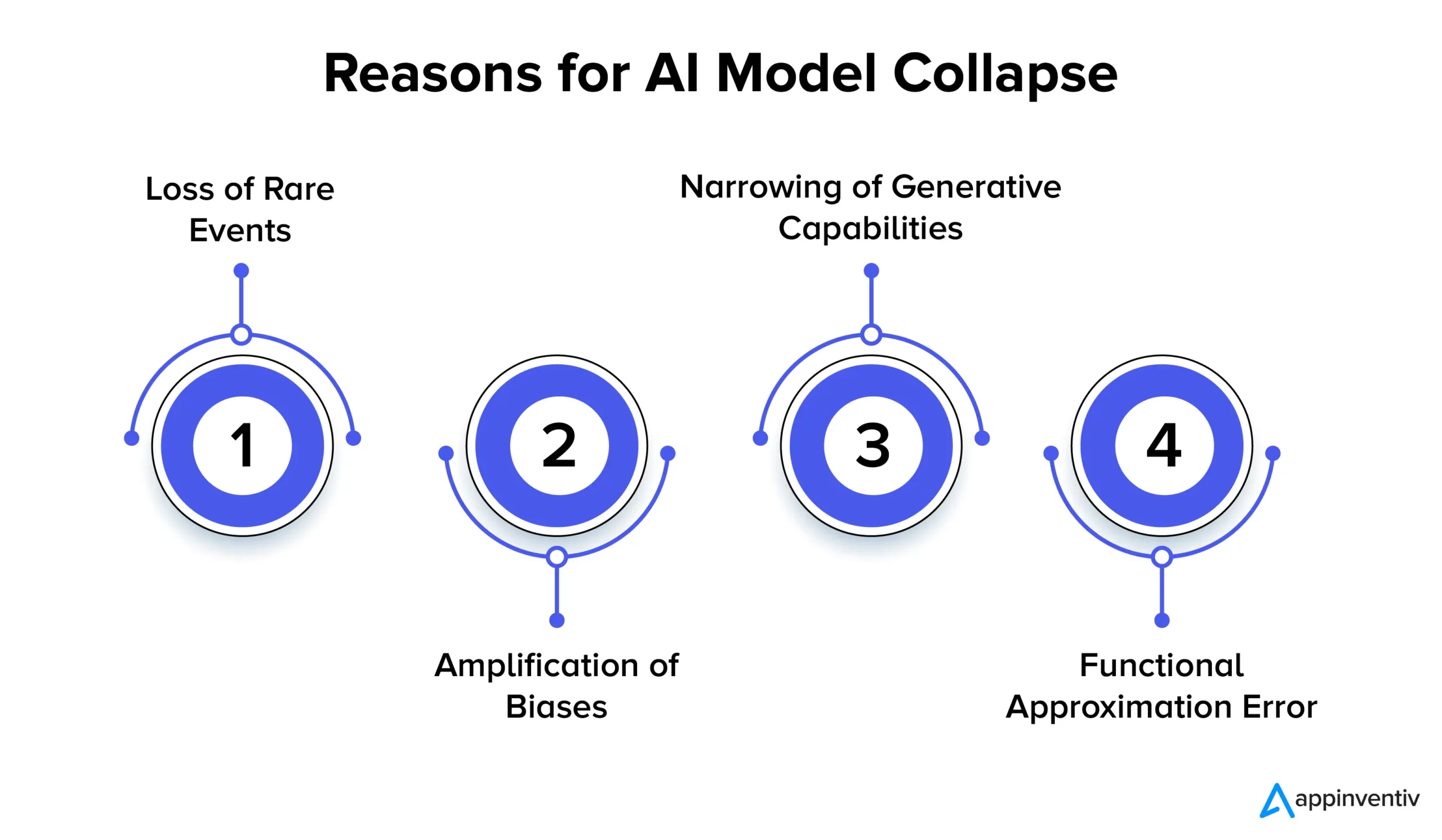

Veamos en detalle varias razones del colapso del modelo de IA a continuación:

Pérdida de eventos raros

Cuando los modelos de IA se entrenan repetidamente con datos generados por sus versiones anteriores, intentan centrarse en patrones comunes y olvidar eventos raros. Este fenómeno es similar a los modelos que pierden su memoria a largo plazo. Los eventos raros suelen tener una importancia significativa, como la identificación de anomalías en los procesos de fabricación o la detección de transacciones fraudulentas. Por ejemplo, cuando se trata de detección de fraude, patrones lingüísticos específicos pueden indicar un comportamiento fraudulento, por lo que es fundamental retener y aprender estos patrones poco comunes.

Amplificación de sesgos

Cada iteración de entrenamiento sobre datos generados por IA puede amplificar los sesgos existentes en los datos de entrenamiento. Dado que la salida del modelo generalmente refleja los datos con los que fue entrenado, cualquier sesgo dentro de esos datos puede exagerarse con el tiempo. Esto puede conducir a una amplificación del sesgo en diversas aplicaciones de IA. Por ejemplo, los resultados pueden generar problemas como discriminación, prejuicios raciales y contenido sesgado en las redes sociales. Por lo tanto, implementar controles para detectar y mitigar los sesgos es extremadamente esencial.

Reducción de las capacidades generativas

A medida que los modelos de IA continúan aprendiendo de los datos generados, sus capacidades generativas pueden reducirse. El modelo queda bastante influenciado por sus propias interpretaciones de la realidad, produciendo contenidos cada vez más similares que carecen de diversidad y representación de eventos raros. Esto puede provocar una pérdida de originalidad. Por ejemplo, cuando se trata de modelos de lenguaje grande (LLM), la variación imparte a cada escritor o artista su tono y estilo distintivos.

Las investigaciones simplemente sugieren que si no se agregan datos nuevos regularmente durante el proceso de entrenamiento, los futuros modelos de IA podrían terminar volviéndose menos precisos o produciendo resultados menos variados con el tiempo.

Error de aproximación funcional

Puede ocurrir un error de aproximación funcional cuando los aproximadores de funciones utilizados en el modelo no son lo suficientemente expresivos. Si bien este error puede mitigarse empleando modelos más expresivos, también puede introducir ruido y provocar un sobreajuste. Lograr el equilibrio adecuado entre la expresividad del modelo y el control del ruido es crucial para evitar estos errores.

Implicaciones del colapso del modelo: ¿Por qué es importante la estabilidad del modelo de IA?

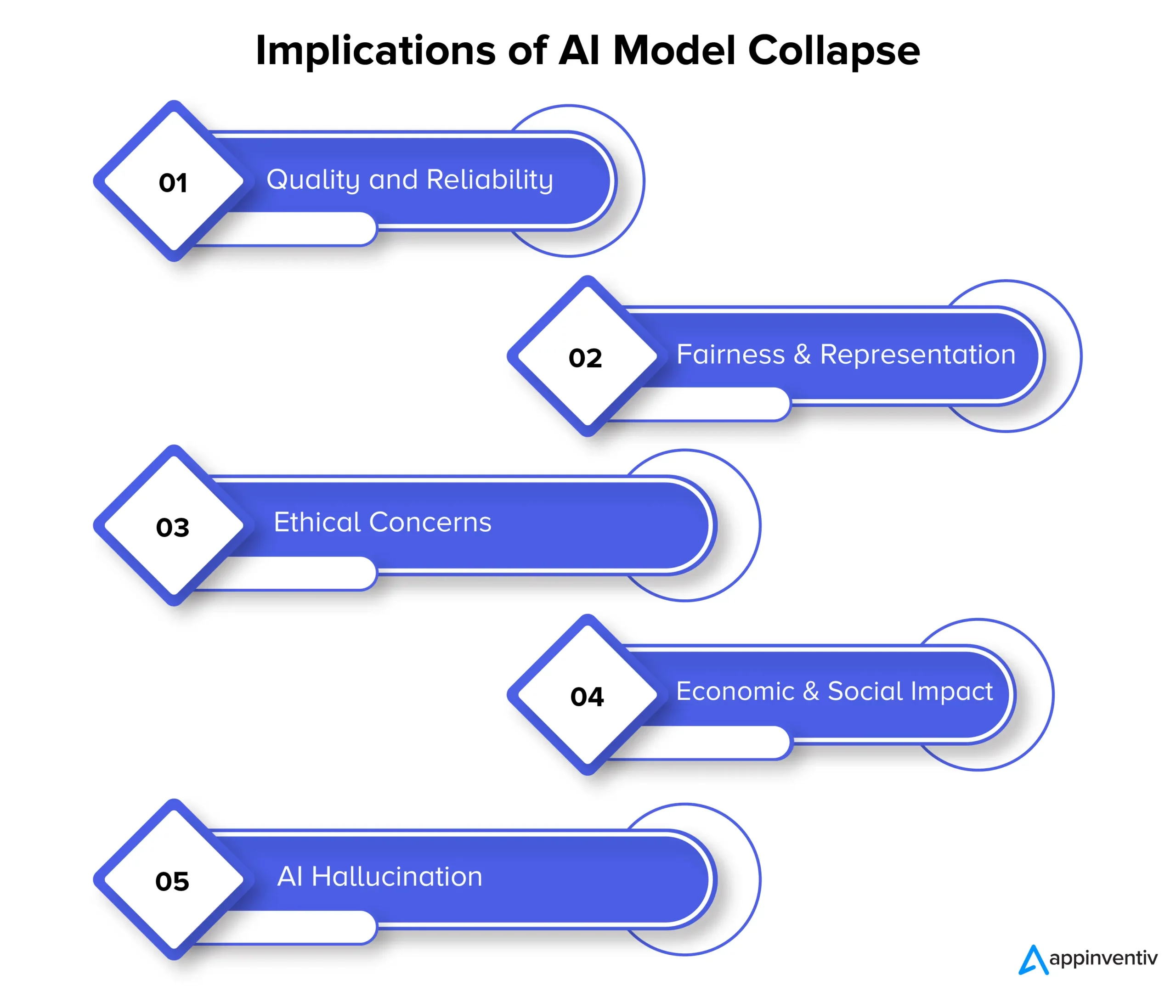

En última instancia, el colapso del modelo puede afectar la calidad, la confiabilidad y la equidad del contenido generado por IA, lo que puede plantear aún más varios riesgos para las organizaciones. Veamos en detalle las implicaciones del colapso del modelo a continuación:

Calidad y fiabilidad

A medida que los modelos de IA degeneran en su aprendizaje, el contenido que generan se vuelve menos confiable y su calidad se degrada. Esto sucede cuando los modelos se separan de la distribución de datos original y se basan más en sus propias interpretaciones de la realidad. Por ejemplo, un modelo de IA diseñado para la generación de noticias puede producir artículos periodísticos inexactos o incluso completamente inventados.

Equidad y representación

El colapso del modelo también es motivo de preocupación cuando se trata de equidad y representación del contenido generado. Cuando los modelos olvidan eventos raros y limitan sus habilidades generativas, el contenido relacionado con temas menos comunes puede estar representado de manera inadecuada. Esto conduce a sesgos, estereotipos y a la exclusión de ciertas perspectivas.

Preocupaciones éticas

El colapso del modelo plantea importantes preocupaciones éticas, específicamente cuando el contenido generado por IA tiene el poder de influir en la toma de decisiones. Las consecuencias del colapso del modelo incluyen la difusión de contenido sesgado e inexacto, que puede afectar significativamente la vida, las opiniones y el acceso a oportunidades de las personas.

Impacto económico y social

A escala económica y social, el colapso del modelo puede influir en la confianza y la adopción de tecnologías de IA. Si no se puede confiar en el contenido generado por IA, las empresas y los consumidores pueden dudar en adoptar estas tecnologías. Esto puede tener implicaciones económicas y, en consecuencia, la confianza en las tecnologías de IA puede obstaculizar.

Alucinación por IA

La alucinación por IA se produce cuando los modelos de IA crean contenido imaginativo o poco realista que no se alinea con los hechos ni es coherente de ninguna manera. Esto puede dar lugar a información inexacta, lo que podría provocar desinformación o confusión. Es significativamente problemático en aplicaciones como generar noticias, diagnosticar condiciones médicas o crear documentos legales donde la precisión y la confiabilidad son extremadamente vitales.

Expliquemos el contexto con un ejemplo de alucinación por IA. Supongamos que hay un modelo de IA entrenado para generar imágenes de animales. Ahora, al solicitar una imagen de un animal, el modelo podría producir una imagen de un "cebroide", un híbrido entre una cebra y un caballo. Si bien esta imagen puede parecer visualmente realista, es vital comprender que es sólo una creación de la imaginación del modelo de IA, ya que tal animal no existe en el mundo real.

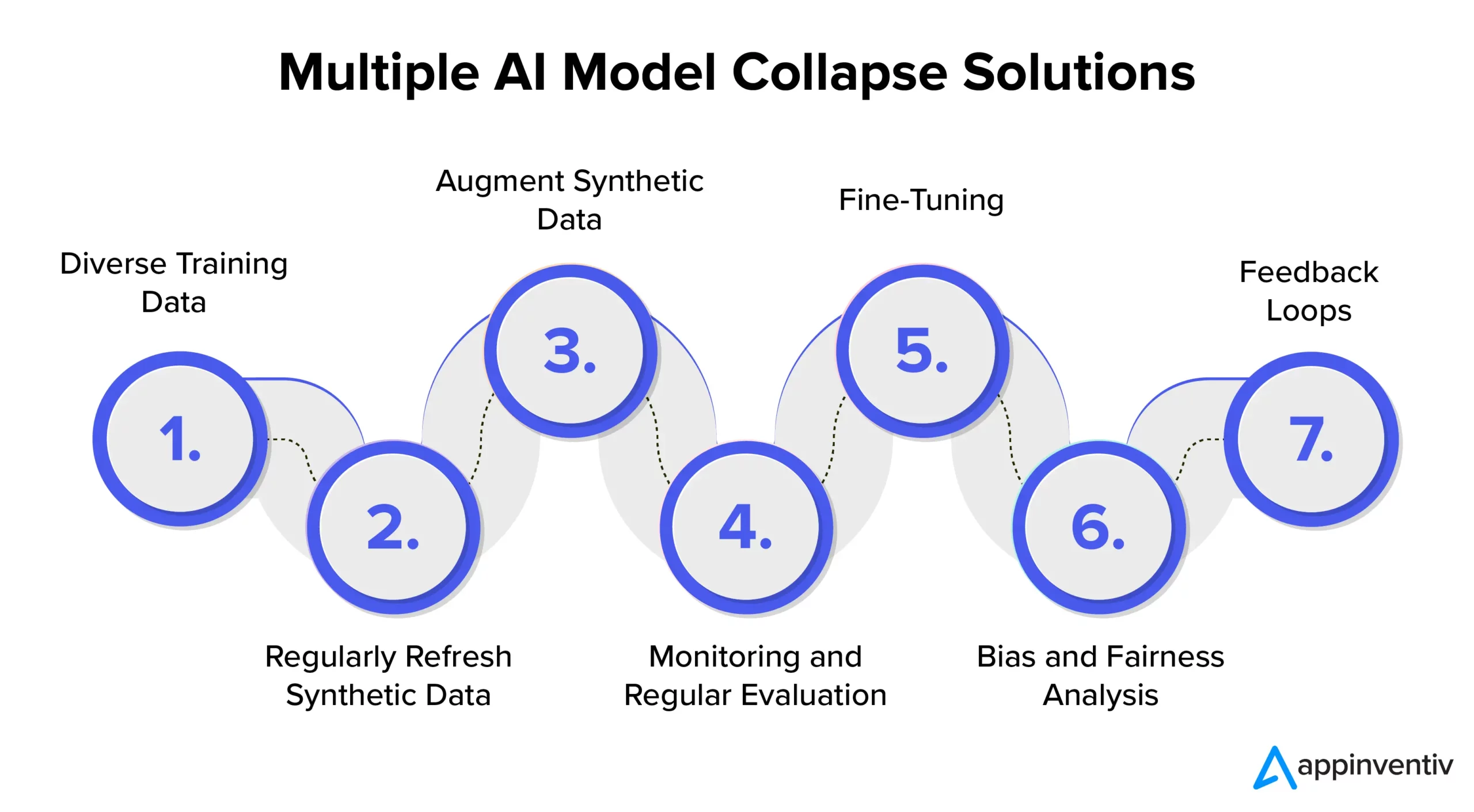

Prevención del colapso del modelo de IA: comprensión de las soluciones del colapso del modelo de IA

Para garantizar la estabilidad y confiabilidad del modelo de IA, es esencial explorar estrategias y mejores prácticas para abordar de manera efectiva la prevención del colapso del modelo de IA. Por lo tanto, se recomienda asociarse con una empresa dedicada al desarrollo de IA como Appinventiv, que puede brindar experiencia y orientación en la implementación de estas medidas preventivas y, al mismo tiempo, garantizar que sus sistemas de IA brinden resultados de alta calidad de manera constante.

Diversos datos de entrenamiento

Para abordar eficazmente el colapso del modelo de IA y prevenir resultados no deseados, es fundamental seleccionar un conjunto de datos de entrenamiento que incluya una variedad de fuentes y tipos de datos. Este conjunto de datos debe consistir tanto en datos sintéticos generados por el modelo como en datos del mundo real que representen con precisión las complejidades del problema. Es importante actualizar periódicamente este conjunto de datos con información nueva y relevante. El modelo está expuesto a una amplia gama de patrones mediante la incorporación de diversos datos de entrenamiento. Esto ayuda a prevenir el estancamiento de datos.

Actualizar periódicamente los datos sintéticos

El colapso del modelo es un riesgo cuando los modelos de IA dependen en gran medida de sus propios datos generados. Para una mitigación eficaz de los riesgos en la IA, es importante introducir periódicamente datos nuevos, auténticos y del mundo real en el proceso de formación. Esta práctica garantiza que el modelo siga siendo adaptable y evita quedarse atrapado en un bucle repetitivo. Esto puede ayudar a generar resultados diversos y relevantes.

Aumentar los datos sintéticos

Mejorar los datos sintéticos mediante técnicas de aumento de datos es un método probado para evitar el colapso del modelo. Estas técnicas introducen variabilidad en los datos sintéticos utilizando las variaciones naturales de los datos del mundo real. Agregar ruido controlado a los datos generados anima al modelo a aprender una gama más amplia de patrones, lo que reduce las posibilidades de generar resultados repetitivos.

Seguimiento y evaluación periódica

Monitorear y evaluar periódicamente el rendimiento del modelo de IA es crucial para la detección temprana del colapso del modelo. La implementación de un marco MLOps garantiza el seguimiento continuo y la alineación con los objetivos de una organización, lo que permite intervenciones y ajustes oportunos.

[Lea también: Cómo evitar infracciones de cumplimiento al desarrollar productos de IA]

Sintonia FINA

Es importante considerar la implementación de estrategias de ajuste para mantener la estabilidad del modelo y evitar el colapso. Estas estrategias para prevenir el fallo del modelo de IA permiten que el modelo se adapte a nuevos datos preservando al mismo tiempo su conocimiento previo.

Análisis de sesgo y equidad

Un análisis riguroso de sesgos y equidad es crucial para prevenir el colapso del modelo y los problemas éticos. Es esencial identificar y abordar los sesgos en los resultados del modelo. Puede mantener resultados de modelo confiables e imparciales abordando activamente estas preocupaciones.

Circuitos de retroalimentacion

La implementación de ciclos de retroalimentación que incorporen los comentarios de los usuarios es crucial para prevenir el colapso del modelo. Al recopilar constantemente información de los usuarios, se pueden realizar ajustes informados en los resultados del modelo. Este proceso de refinamiento garantiza que el modelo siga siendo relevante, confiable y alineado con las expectativas del usuario.

¿Cómo puede ayudar Appinventiv a mitigar los riesgos en los modelos de IA?

En el cambiante panorama de la IA, los desafíos que plantea el colapso del modelo han sido una preocupación tanto para los gigantes tecnológicos como para los innovadores. El deterioro a largo plazo de los conjuntos de datos de los modelos lingüísticos y la manipulación del contenido han dejado su huella en este ecosistema digital.

A medida que avanza la IA, es vital diferenciar entre datos generados artificialmente y contenido generado por humanos. La línea entre el contenido genuino y lo generado por una máquina se está volviendo cada vez más borrosa.

Ahora, en medio de estos desafíos y de prevenir fallas en el modelo de IA, asociarse con una empresa dedicada al desarrollo de IA como Appinventiv puede brindarle el consuelo que tanto necesita. Con experiencia en el desarrollo de modelos de IA y un compromiso dedicado con las prácticas éticas de IA, podemos ayudarlo a navegar por las complejidades de la IA y al mismo tiempo garantizar la confiabilidad e integridad de sus sistemas de IA.

Nuestros expertos pueden trabajar con usted para abordar de manera efectiva la prevención del colapso del modelo de IA, promover la transparencia y construir un futuro con contenido auténtico que no comprometa la autenticidad del contenido generado por humanos.

Entendemos que entrenar modelos de IA con datos nuevos y diversos es esencial para evitar la degradación del modelo. La evaluación del modelo de IA es un paso fundamental en nuestro proceso de desarrollo de modelos que emplea métricas para evaluar el rendimiento, identificar debilidades y garantizar predicciones futuras efectivas.

Nuestro equipo de expertos puede ayudar a garantizar que sus sistemas de IA continúen aprendiendo y adaptándose al panorama digital en evolución. Póngase en contacto con nuestros expertos para mitigar los riesgos asociados al colapso del modelo y garantizar su eficacia.

Preguntas frecuentes

P. ¿Qué es el colapso del modelo de IA?

R. El colapso del modelo de IA en el aprendizaje automático se refiere a la incapacidad del modelo de IA para producir una gama diversa de resultados útiles. Más bien, genera resultados repetitivos o de baja calidad. Este problema puede ocurrir en diferentes tipos de modelos, pero se observa particularmente durante el entrenamiento de modelos complejos como las redes generativas adversarias (GAN).

P. ¿Cuáles son las causas comunes del colapso del modelo de IA?

R. Las causas comunes del colapso del modelo de IA incluyen la pérdida de eventos raros, la amplificación de sesgos, la reducción de las capacidades generativas, los errores de aproximación funcional, etc. Estos factores pueden llevar a que los modelos produzcan resultados subóptimos.

P. ¿Cómo puedo evitar el colapso del modelo de IA?

R. Para una prevención eficaz del colapso del modelo de IA, es vital utilizar datos de entrenamiento diferentes y similares al mundo real, monitorear y evaluar continuamente los datos, corregir cualquier sesgo e implementar pruebas y controles de calidad rigurosos. Asociarse con los expertos en inteligencia artificial de Appinventiv puede ofrecerle información y soluciones valiosas para mitigar los riesgos de colapso del modelo.