Debajo del código: análisis de los riesgos fundamentales de la IA y sus contramedidas

Publicado: 2023-09-25Las organizaciones se están sumergiendo rápidamente en el mundo de la IA para impulsar sus procesos y obtener una ventaja competitiva. Sin embargo, es vital comprender que su viaje hacia la IA no siempre será brillante y podría ir acompañado de ciertos riesgos y desafíos. A medida que la tecnología de IA evoluciona rápidamente a una velocidad sin precedentes, las organizaciones deben estar preparadas para adaptarse globalmente. Para tener éxito en este feroz ecosistema digital, es fundamental comprender los posibles obstáculos y adoptar las mejores prácticas para navegar en el multiverso de la IA.

A medida que la inteligencia artificial continúa avanzando, existe una creciente preocupación por sus peligros potenciales. Geoffrey Hinton, el “padrino de la IA”, conocido por su encomiable trabajo en aprendizaje automático y redes neuronales, ha advertido que los sistemas de IA están avanzando a un ritmo sin precedentes y pueden representar un riesgo de tomar el control, si no se manejan con la supervisión adecuada. Además, destacó la necesidad vital de abordar estas cuestiones conexas de manera proactiva.

En otro caso, Elon Musk también ha abogado por una pausa en los experimentos de IA a gran escala. Estas preocupaciones de los líderes mundiales sobre los riesgos potenciales de la IA reflejan que la comunidad tecnológica necesita considerar cuidadosamente las implicaciones y los desafíos éticos que pueden surgir con el avance de las capacidades de la IA.

Ahora, a medida que el mundo avanza, la IA generativa tiende a volverse muy popular. Dado que un gran poder a menudo atrae responsabilidades incondicionales, la implementación de la IA generativa también conlleva cierto grado de riesgo ético.

Entonces, como propietario de una empresa, ya es hora de comprender que la IA puede brindar grandes beneficios, pero también conlleva algunos desafíos familiares que surgen al introducir cualquier tecnología nueva en sus operaciones diarias.

Las organizaciones deben priorizar el uso responsable garantizando la precisión, la seguridad, la honestidad, el empoderamiento y la sostenibilidad. Cuando se enfrentan a ciertos desafíos y riesgos, pueden confiar en las mejores prácticas probadas y comprobadas que han demostrado ser efectivas para adoptar con éxito otras tecnologías. Estas estrategias pueden actuar como una base sólida para integrar la IA en sus operaciones comerciales y mitigar los riesgos de la IA a lo largo del camino.

Este blog te ayudará a comprender todo lo relacionado con los riesgos de la IA para tu negocio y cómo mitigarlos. Entonces, sin más preámbulos, profundicemos en los detalles.

Comprender los riesgos de la IA

Según AI RMF 1.0, el Marco de Gestión de Riesgos de Inteligencia Artificial, publicado por el Instituto Nacional de Estándares y Tecnología (NIST), los riesgos de IA abarcan daños potenciales a individuos, organizaciones o sistemas que surgen del desarrollo e implementación de sistemas de IA. Estos riesgos pueden deberse a varios factores, incluidos los datos utilizados para entrenar la IA, el algoritmo de la IA, su uso para múltiples propósitos y las interacciones con las personas. Los ejemplos de riesgos y controles de la IA varían desde herramientas de contratación sesgadas hasta algoritmos que provocan caídas del mercado.

El monitoreo proactivo de los productos y servicios basados en IA es crucial para garantizar la seguridad de los datos y de las personas. Por lo tanto, la organización cree en el empleo de una solución de gestión de riesgos que pueda ayudar a clasificar, verificar y mitigar estos riesgos de manera efectiva.

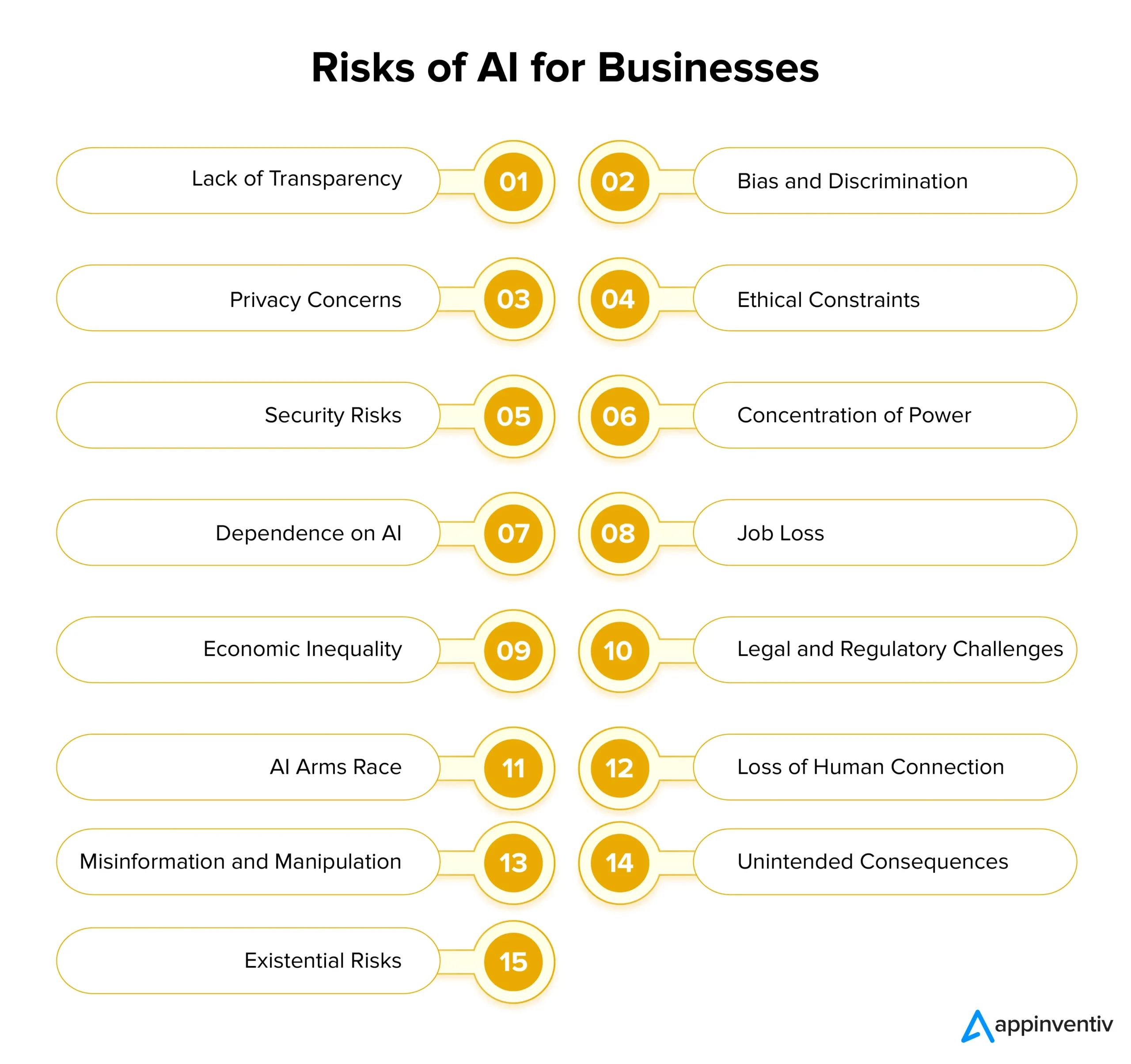

Identificación de los riesgos y desafíos de la IA para las empresas

La IA ofrece un inmenso potencial a las empresas, pero también conlleva importantes riesgos con su implementación. Para garantizar una adopción responsable de la IA, es vital comprender y abordar estos desafíos en el momento adecuado. Veamos en detalle los riesgos y soluciones de IA para empresas a continuación:

Falta de transparencia

Los sistemas de inteligencia artificial a menudo funcionan de manera no transparente, lo que dificulta comprender cómo toman varias decisiones. Esta falta de transparencia puede generar desconfianza entre los usuarios y las partes interesadas. Para abordar esto, las empresas deben priorizar la transparencia mediante el diseño de modelos y algoritmos de IA que brinden información sobre sus procesos de toma de decisiones.

Esto puede facilitarse simplemente utilizando documentación clara, técnicas de IA explicables y herramientas para visualizar resultados impulsados por la IA. Es importante comprender que la IA transparente mejora la confianza general entre las partes y sus decisiones y ayuda al cumplimiento normativo.

Sesgo y discriminación

Los sistemas de inteligencia artificial tienen el potencial de mantener fácilmente los sesgos sociales que se encuentran en sus datos de entrenamiento. Esto puede conducir a una toma de decisiones sesgada, discriminación y trato injusto a ciertos grupos. Para abordar estos riesgos de la IA, las organizaciones deben priorizar la inversión en datos de capacitación diversos y representativos que puedan analizar.

Además, implementar algoritmos de detección y corrección de sesgos y realizar auditorías periódicas de los modelos de IA puede ayudar a identificar y eliminar los sesgos de los sistemas existentes. El desarrollo ético de la IA debe priorizar la justicia y la imparcialidad como principios fundamentales.

Preocupaciones sobre la privacidad

Uno de los mayores riesgos y desafíos de la IA es una amenaza a la privacidad. La IA a menudo requiere recopilar y analizar grandes cantidades de datos personales, lo que genera preocupaciones sobre la privacidad y la seguridad. Las empresas deben priorizar la protección de datos mediante el cumplimiento de estrictas normas de privacidad, la implementación de medidas sólidas de ciberseguridad y la adopción de técnicas de cifrado de datos. Esto puede ayudar a salvaguardar la privacidad del usuario y mantener la confianza.

Restricciones éticas

Los sistemas de IA que participan en la toma de decisiones críticas a menudo enfrentan dilemas éticos que pueden tener impactos sociales aún más perjudiciales. Las organizaciones deben establecer pautas y principios éticos para el desarrollo y la implementación de la IA para abordar este riesgo. Las consideraciones éticas deberían ser uno de los componentes centrales de los proyectos de IA, asegurando que la IA se alinee con los valores sociales y las normas éticas.

Riesgos de seguridad

A medida que avanzan las tecnologías de IA, también lo hacen los riesgos de seguridad. Las actividades maliciosas pueden explotar los sistemas de inteligencia artificial y crear ciberataques más peligrosos, lo que representa una amenaza importante para las empresas. Las organizaciones deben implementar medidas de seguridad sólidas para mitigar los riesgos de seguridad, incluido el cifrado, los protocolos de autenticación y los sistemas de detección de amenazas basados en inteligencia artificial. El monitoreo continuo y los controles periódicos de vulnerabilidad son fundamentales para salvaguardar el despliegue de sistemas de IA.

Concentración de poder

Cuando sólo unas pocas grandes empresas y gobiernos controlan el desarrollo de la IA, las cosas pueden volverse injustas y reducir la variedad de usos de la IA. Para evitar esto, las empresas deberían trabajar para compartir el desarrollo de la IA de manera más amplia entre múltiples grupos. Pueden hacerlo apoyando a pequeñas empresas emergentes, fomentando nuevas ideas y ayudando a proyectos de inteligencia artificial de código abierto. De esta manera, la IA se vuelve más accesible para todos.

Dependencia de la IA

La dependencia excesiva de los sistemas de inteligencia artificial puede provocar una pérdida de creatividad, pensamiento crítico e intuición humana. Es vital lograr un equilibrio entre la toma de decisiones asistida por IA y el juicio humano. Por ejemplo, los investigadores han destacado el problema del "colapso del modelo", donde los modelos generativos de IA que se entrenan con datos sintéticos pueden producir resultados de menor calidad porque simplemente priorizan la elección de palabras comunes sobre las alternativas creativas.

Las empresas deben capacitar a sus empleados para que trabajen junto con la IA a fin de evitar los riesgos potenciales de la IA. Fomentar el aprendizaje continuo puede ayudar a las organizaciones a aprovechar el potencial de la IA y, al mismo tiempo, preservar las habilidades humanas. Además de esto, el uso de diversos datos de entrenamiento y técnicas de regularización también puede ayudar a mitigar estos desafíos asociados con el colapso del modelo.

Perdida de trabajo

La automatización impulsada por la IA tiene el potencial de desplazar empleos en diversas industrias, siendo los trabajadores menos calificados los principales objetivos. Las organizaciones deben abordar este desafío de manera proactiva brindando oportunidades para que su fuerza laboral aprenda nuevas medidas y crezca con los avances tecnológicos. Promover el aprendizaje permanente y la adaptabilidad es esencial para mitigar las preocupaciones sobre la pérdida de empleos en múltiples sectores.

Desigualdad económica

La desigualdad económica es otro de los riesgos y desafíos notables de la IA que las empresas deben tener en cuenta. La IA puede potencialmente empeorar la desigualdad económica porque a menudo beneficia a los ricos y a las grandes empresas. Para que la IA sea más justa, los formuladores de políticas y las empresas deberían pensar en formas de incluir a más personas en el desarrollo de la IA. Pueden hacerlo creando programas que permitan a más personas utilizar herramientas de inteligencia artificial.

Desafíos legales y regulatorios

La IA introduce nuevas complejidades legales y regulatorias, incluidas cuestiones de responsabilidad y derechos de propiedad intelectual. Los marcos legales deben evolucionar para que puedan funcionar en paralelo con los avances tecnológicos. Las organizaciones deben mantenerse informadas sobre las regulaciones relacionadas con la IA y colaborar activamente con los formuladores de políticas para dar forma a una gobernanza y prácticas responsables de la IA. Las empresas pueden utilizar la IA para soluciones de riesgo y cumplimiento para analizar fácilmente grandes cantidades de información y datos al tiempo que identifican posibles riesgos asociados al cumplimiento.

[Lea también: Cómo evitar infracciones de cumplimiento al desarrollar productos de IA]

Carrera armamentista de IA

Cuando los países se lanzan a una carrera armamentista de IA, puede significar que la tecnología de IA se desarrolla demasiado rápido, y eso podría ser peligroso. Para prevenir estos riesgos de la IA, es importante fomentar el desarrollo responsable de la IA. Los países deberían trabajar juntos y llegar a acuerdos sobre cómo se puede utilizar la IA en defensa. De esta manera, podemos reducir el riesgo de que la IA cause daño en la carrera por tener tecnología más avanzada que en otros países.

Pérdida de conexión humana

La creciente dependencia de la comunicación y las interacciones impulsadas por la IA puede conducir a una disminución de la empatía, las habilidades sociales y las conexiones humanas. Las organizaciones deben priorizar el diseño centrado en las personas, enfatizando la importancia de mantener interacciones humanas significativas además de la integración de la IA.

Desinformación y manipulación

El contenido generado por IA, como los deepfakes, plantea un riesgo importante al contribuir a la difusión de información falsa y a manipular la opinión pública. La implementación de herramientas impulsadas por inteligencia artificial para detectar información errónea y campañas de concientización pública puede ayudar a preservar la integridad de la información en esta era digital en rápida evolución.

Consecuencias no deseadas

Debido a su complejidad, los sistemas de IA pueden exhibir comportamientos inesperados o tomar decisiones con consecuencias imprevistas. Los procesos rigurosos de prueba, validación y monitoreo continuo son esenciales para identificar y abordar estos problemas antes de que escale y causen daño.

Riesgos existenciales

La creación de una inteligencia artificial general (AGI) más inteligente que los humanos genera grandes preocupaciones. Las organizaciones deben asegurarse de que AGI comparta sus valores y objetivos para evitar consecuencias terribles. Esto requiere una planificación cuidadosa a largo plazo, normas éticas sólidas y trabajar juntos a nivel mundial para manejar los grandes riesgos que conlleva la AGI.

Después de analizar los múltiples desafíos y riesgos que impone la tecnología de IA y cómo se puede llevar a cabo la gestión de ciertos riesgos de la IA, avancemos y analicemos la gobernanza de la IA en detalle.

Gobernanza de la IA para gestionar riesgos

La gobernanza eficaz de la IA implica identificar y gestionar los riesgos de la IA a través de tres enfoques clave:

Principios: Se trata de directrices que facilitan el desarrollo de sistemas de IA y su uso. Estos suelen estar alineados con estándares legislativos y normas sociales.

Procesos: abordar los riesgos y daños potenciales que surgen de fallas de diseño y estructuras de gobernanza inadecuadas.

Conciencia ética: este enfoque está impulsado por un sentido de lo que es correcto y bueno. Incluye seguir reglas, asegurarse de que las cosas se hagan correctamente, pensar en la propia reputación, ser socialmente responsable y coincidir con los valores y creencias de la organización.

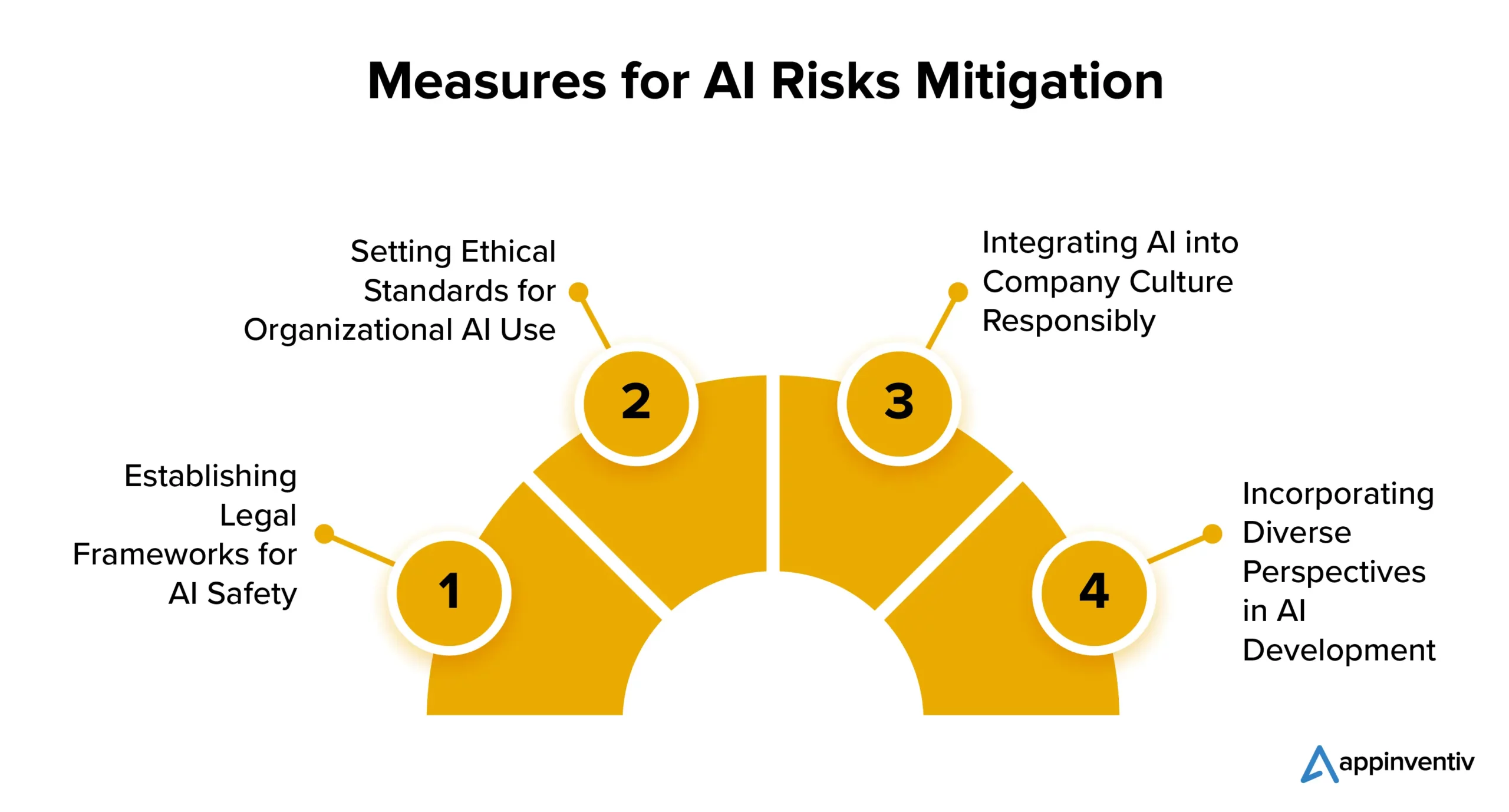

Mitigar los riesgos de la IA: cómo mantenerse seguro con la inteligencia artificial

A continuación se presentan varias estrategias que las empresas pueden llevar a cabo para mitigar los riesgos de la implementación de la IA:

Establecimiento de marcos legales para la seguridad de la IA

Muchos países se están centrando en las regulaciones de IA. Estados Unidos y la Unión Europea están trabajando en un conjunto claro de reglas para controlar la propagación y el uso de la IA. Si bien algunas tecnologías de IA pueden enfrentar restricciones, esto no debería impedir que las empresas exploren el potencial de la IA para su beneficio.

Establecer estándares éticos para el uso de la IA organizacional

Es crucial equilibrar la regulación con la innovación. La IA es vital para el progreso, por lo que las organizaciones deben establecer estándares para el desarrollo y uso ético de la IA. Esto debería incluir la implementación de algoritmos de seguimiento, el uso de datos de alta calidad y la transparencia en las decisiones de IA.

Integrar la IA en la cultura empresarial de forma responsable

Una de las estrategias más buscadas para mitigar los riesgos de la IA incluye la introducción de la IA en la propia cultura de la empresa. Las empresas pueden integrar la IA en su cultura estableciendo directrices de procesos y tecnologías de IA aceptables. Esto garantiza que la IA se utilice de forma ética y responsable dentro de la organización, mitigando así los probables riesgos de la IA.

Incorporación de diversas perspectivas en el desarrollo de la IA

Los desarrolladores de IA deben considerar diversas perspectivas, incluidas aquellas de diferentes orígenes y campos como el derecho, la filosofía y la sociología. Este enfoque inclusivo ayuda a crear una IA responsable que beneficie a todos.

¿Cómo puede Appinventiv ayudar a garantizar las mejores prácticas para el desarrollo de la IA?

A pesar de que la adopción de la IA sigue aumentando, la gestión eficaz de riesgos aún está rezagada. El desafío radica en que las empresas a menudo no reconocen la necesidad de intervención ni de prácticas de desarrollo de IA sostenible.

Según un informe de MIT Sloan Management Review y Boston Consulting Group, el 42% de los encuestados consideraba la IA como una prioridad estratégica principal, mientras que sólo el 19% confirmó que sus organizaciones habían implementado un programa de IA responsable. Esta brecha aumenta el riesgo de fracaso y deja a las empresas vulnerables a problemas regulatorios, financieros y de reputación causados por la implementación de la IA.

Si bien la gestión de riesgos de la IA puede comenzar en cualquier etapa del proyecto, es vital establecer un marco de gestión de riesgos lo antes posible. Esto puede aumentar la confianza y permitir que las empresas crezcan con confianza.

Como empresa dedicada al desarrollo de IA, nuestro equipo tiene años de experiencia en la creación de soluciones de IA respaldadas por un fuerte énfasis en la ética y la responsabilidad. Nuestro historial comprobado en varios dominios de la industria refleja nuestro compromiso de alinear las soluciones de IA con los valores fundamentales y los principios éticos.

Estamos bien equipados para ayudarlo a implementar medidas justas para garantizar que sus soluciones comerciales basadas en IA tomen decisiones imparciales e imparciales de manera constante.

Recientemente desarrollamos YouComm, una aplicación de atención médica basada en inteligencia artificial que permite a los pacientes conectarse con el personal del hospital con solo gestos con las manos y comandos de voz. La solución ahora se implementa en más de cinco cadenas de hospitales en los EE. UU.

Póngase en contacto con nuestros expertos para comprender completamente la gestión de riesgos de IA asociada a su proyecto y cómo puede mitigarlos fácilmente.

Preguntas frecuentes

P. ¿Cuáles son los riesgos de la IA?

R. La IA conlleva riesgos inherentes, incluidos prejuicios, preocupaciones sobre la privacidad, dilemas éticos y amenazas a la seguridad. También puede provocar el desplazamiento de empleos, empeorar la desigualdad económica y plantear desafíos legales y regulatorios. Además, el avance de la IA superinteligente plantea preocupaciones existenciales sobre la alineación con los valores humanos. Para garantizar un uso responsable y beneficioso de la tecnología y evitar los riesgos asociados a la IA, es fundamental implementar una gestión cuidadosa, consideraciones éticas y medidas regulatorias.

P. ¿Cómo se puede utilizar la IA para mitigar los riesgos de la IA?

R. La IA desempeña un papel importante en la mitigación de los riesgos de la IA al facilitar la detección y corrección de sesgos, el análisis predictivo, el monitoreo de la seguridad, el apoyo a las decisiones éticas, etc. Veamos cómo podemos ayudar a mitigar los riesgos de la IA en detalle:

- Los algoritmos de IA pueden identificar y rectificar sesgos en los datos, reduciendo los resultados sesgados de la IA.

- El análisis predictivo puede anticipar riesgos y permitir medidas preventivas.

- Las herramientas de ciberseguridad basadas en IA pueden detectar y contrarrestar las amenazas basadas en IA.

- La IA puede guiarnos en la toma de decisiones éticas.

- La automatización puede garantizar el cumplimiento de las regulaciones, reduciendo los riesgos relacionados con el cumplimiento.