Evaluación de herramientas de web scraping: lo que las empresas necesitan saber

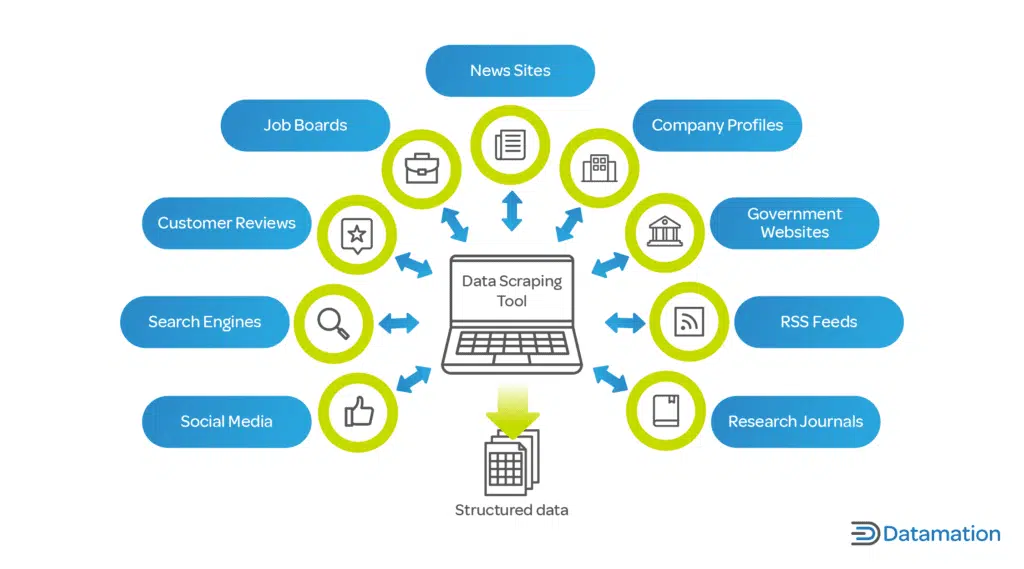

Publicado: 2024-05-15El web scraping a través de herramientas automatizadas de web scraping es fundamental para las organizaciones que buscan aprovechar big data. Permite la extracción automatizada de información relevante de varias fuentes web, lo cual es esencial para el análisis basado en datos.

Al extraer las tendencias actuales del mercado, las preferencias de los consumidores y los conocimientos competitivos, las empresas pueden:

- Tomar decisiones estratégicas informadas

- Adaptar los productos a las necesidades del cliente

- Optimice los precios para la competitividad del mercado

- Aumentar la eficiencia operativa

Además, cuando se combinan con herramientas de análisis, los datos extraídos sustentan los modelos predictivos, enriqueciendo los procesos de toma de decisiones. Esta inteligencia competitiva impulsa a las empresas a anticipar los cambios del mercado y actuar de manera proactiva, manteniendo una ventaja crítica en sus respectivos sectores.

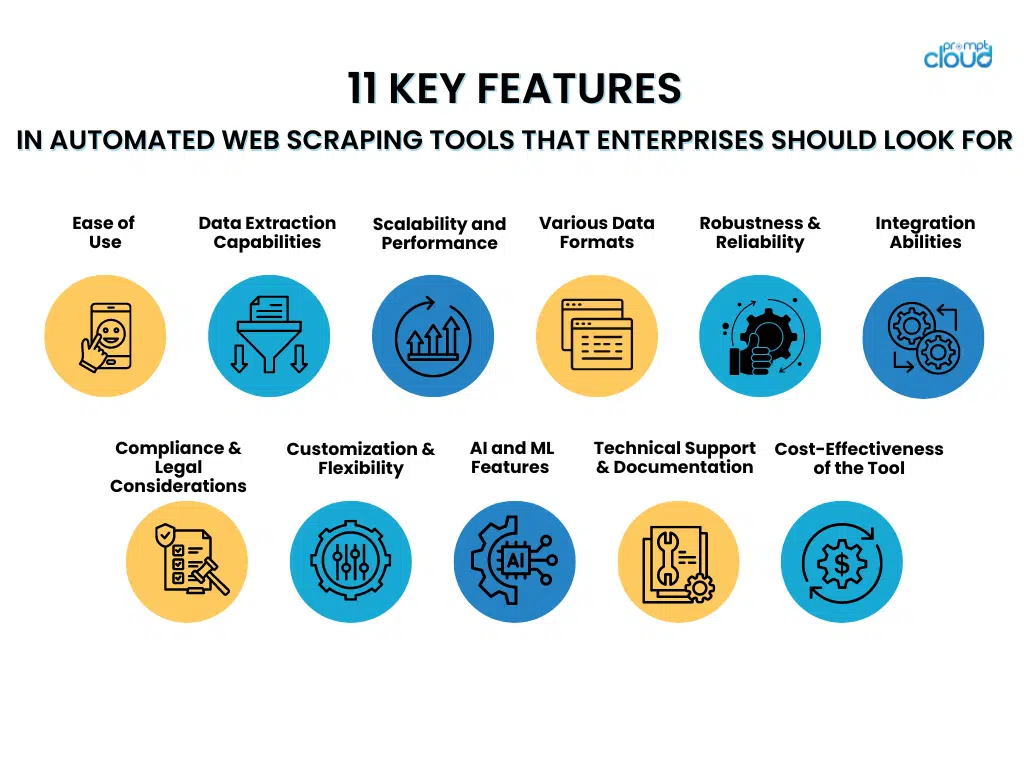

11 características clave de las herramientas de web scraping automatizadas que las empresas deberían buscar

- Facilidad de uso

Al elegir herramientas automatizadas de web scraping, las empresas deben dar preferencia a aquellas que presentan interfaces fáciles de usar y pasos de configuración sencillos. Las herramientas con interfaces intuitivas permiten al personal utilizarlas de manera eficiente sin una capacitación extensa, lo que permite centrarse más en la recuperación de datos en lugar de dominar sistemas complejos.

Por otro lado, los métodos de configuración sencillos facilitan la rápida implementación de estas herramientas, minimizando retrasos y acelerando el camino hacia información valiosa. Las características que contribuyen a la facilidad de uso incluyen:

- Menús de navegación claros y sencillos

- Funcionalidades de arrastrar y soltar para el diseño de flujos de trabajo

- Plantillas prediseñadas para tareas comunes de scraping

- Asistentes paso a paso que guían la configuración inicial

- Documentación completa y tutoriales para facilitar el aprendizaje.

Una herramienta fácil de usar maximiza la eficiencia de los empleados y ayuda a mantener altos niveles de productividad.

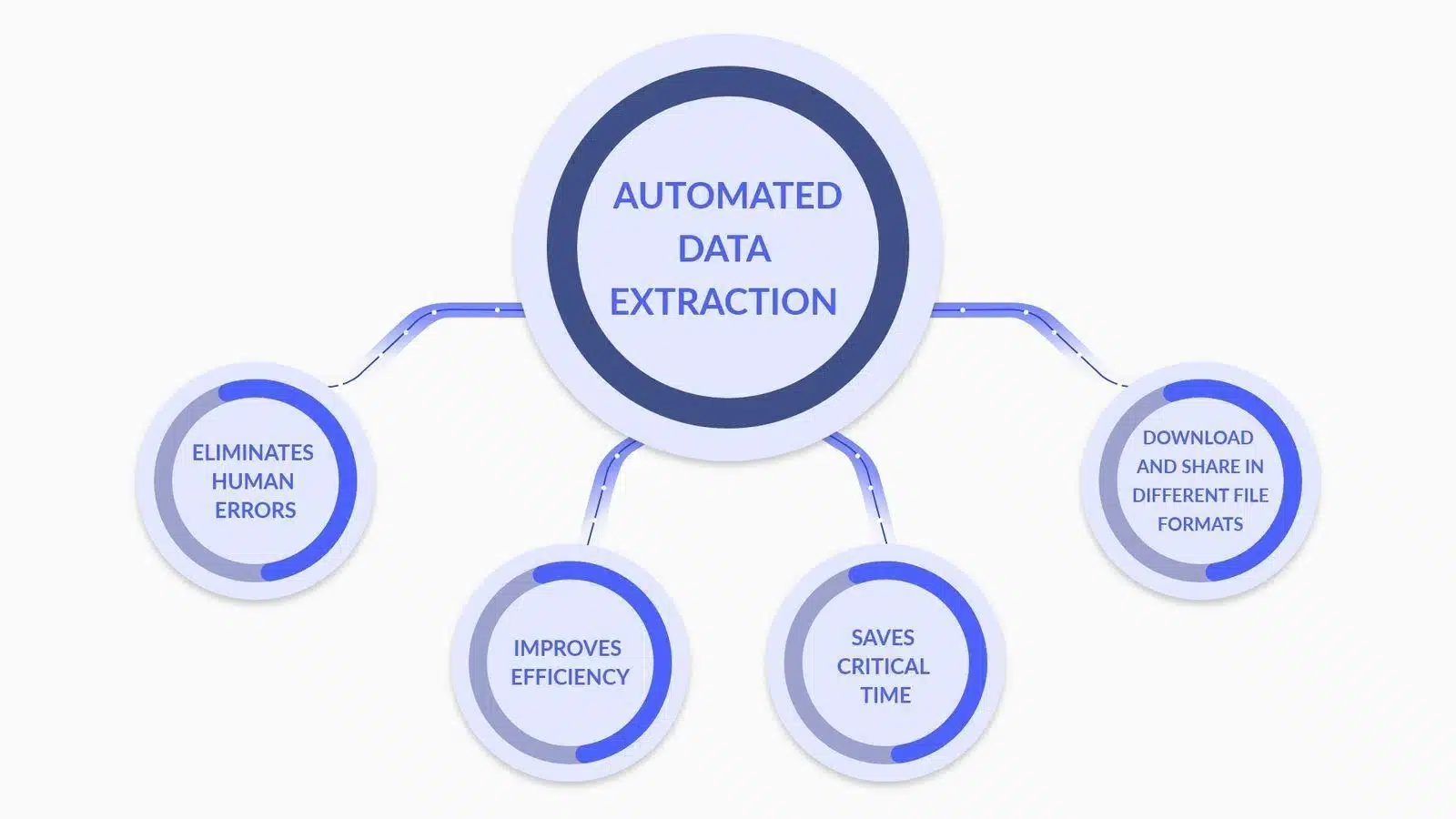

- Capacidades de extracción de datos

Fuente de la imagen: ¿Qué es la extracción de datos? Aquí está lo que necesitas saber

Al evaluar herramientas automatizadas de web scraping, las empresas deben priorizar funciones avanzadas de análisis y transformación de datos, como:

- Análisis de datos personalizado : la capacidad de personalizar analizadores para interpretar con precisión estructuras de datos complejas, incluido el contenido dinámico y anidado.

- Conversión de tipo de datos : herramientas que convierten automáticamente los datos extraídos a formatos utilizables (por ejemplo, fechas, números, cadenas) para un procesamiento de datos más eficiente.

- Compatibilidad con expresiones regulares : inclusión de capacidades de expresiones regulares para una coincidencia de patrones sofisticada, lo que permite una extracción de datos precisa.

- Transformación condicional : la capacidad de aplicar lógica condicional a los datos extraídos, lo que permite la transformación basada en criterios o patrones de datos específicos.

- Limpieza de datos : funciones que limpian y estandarizan los datos en la fase posterior a la extracción para garantizar la calidad y coherencia de los datos.

- Integración API : Instalaciones para una integración perfecta con API para procesar y analizar aún más los datos extraídos, mejorando las capacidades de toma de decisiones.

Cada característica contribuye a un proceso de extracción de datos más sólido y preciso, fundamental para los esfuerzos de web scraping a nivel empresarial.

- Escalabilidad y rendimiento

Al evaluar las herramientas automatizadas de web scraping, las empresas deben priorizar los atributos de escalabilidad y rendimiento que respalden el procesamiento eficiente de grandes conjuntos de datos.

Una herramienta ideal puede gestionar hábilmente un aumento significativo de la carga de trabajo sin comprometer la velocidad o la precisión. Las empresas deben buscar características como:

- Capacidades de subprocesos múltiples que permiten el procesamiento de datos simultáneo

- Gestión eficiente de la memoria para manejar tareas de scraping a gran escala

- Asignación dinámica de recursos basada en demandas en tiempo real.

- Infraestructura robusta que puede escalar horizontal o verticalmente

- Mecanismos de almacenamiento en caché avanzados para acelerar la recuperación de datos

La capacidad de la herramienta para mantener el rendimiento bajo carga garantiza una extracción de datos confiable, incluso durante las horas pico o cuando se amplían las operaciones.

- Soporte para varios formatos de datos

Fuente de la imagen: ¿Qué es el raspado de datos? Definición y cómo usarlo

Una herramienta de web scraping automatizada debe manejar con competencia diversos formatos de datos. Las empresas suelen trabajar con varios tipos de datos y la flexibilidad en la extracción de datos es fundamental:

- JSON: un formato ligero de intercambio de datos que es fácil de leer y escribir para los humanos y fácil de analizar y generar para las máquinas.

- CSV: el formato de valores separados por comas es un formato de archivo simple y común que se utiliza para datos tabulares. La mayoría de las herramientas de scraping deberían ofrecer una opción de exportación CSV.

- XML: lenguaje de marcado extensible, un formato más complejo que incluye metadatos y se puede utilizar en una amplia gama de industrias.

La capacidad de extraer y exportar datos en estos formatos garantiza la compatibilidad con diferentes herramientas y sistemas de análisis de datos, ofreciendo una solución versátil para los requisitos empresariales.

- Robustez y confiabilidad

Cuando las empresas eligen herramientas automatizadas de web scraping, deben priorizar la solidez y la confiabilidad. Las características clave a considerar incluyen:

- Manejo integral de errores : una herramienta superior debe tener la capacidad de detectar y rectificar errores automáticamente. Debería registrar los problemas y, cuando sea posible, volver a intentar las solicitudes fallidas sin intervención manual.

- Estrategias de minimización del tiempo de inactividad : la herramienta debe incluir mecanismos de conmutación por error, como servidores de respaldo u fuentes de datos alternativas, para mantener las operaciones cuando fallan las fuentes primarias.

- Sistemas de monitoreo continuo : el monitoreo en tiempo real garantiza que cualquier tiempo de inactividad se identifique y aborde de inmediato, minimizando las lagunas de datos.

- Mantenimiento predictivo : la utilización del aprendizaje automático para predecir posibles puntos de falla puede prevenir de manera preventiva tiempos de inactividad, lo que hace que el sistema sea más confiable.

Invertir en herramientas que enfaticen estos aspectos de solidez y confiabilidad puede reducir significativamente los riesgos operativos asociados con el web scraping.

- Habilidades de integración

Al evaluar las herramientas automatizadas de web scraping, las empresas deben garantizar su capacidad para integrarse fluidamente con los canales de datos actuales. Esto es esencial para mantener la continuidad del flujo de datos y optimizar el proceso. La herramienta debería:

- Ofrezca API o conectores compatibles con bases de datos y plataformas de análisis existentes.

- Admite varios formatos de datos para una importación/exportación fluida que garantice una interrupción mínima.

- Proporcione funciones de automatización que puedan activarse mediante eventos dentro del canal de datos.

- Facilite un escalamiento sencillo sin una reconfiguración extensa a medida que evolucionan las necesidades de datos.

- Cumplimiento y consideraciones legales

Al integrar una herramienta automatizada de web scraping en las operaciones empresariales, es fundamental garantizar que la herramienta cumpla con los marcos legales. Las características a considerar incluyen:

- Respeto por Robots.txt : la herramienta debe reconocer y cumplir automáticamente con el archivo robots.txt del sitio web, que describe los permisos de raspado.

- Limitación de velocidad : para evitar una carga disruptiva en los servidores host, las herramientas deben incluir una limitación de velocidad ajustable para controlar la frecuencia de las solicitudes.

- Cumplimiento de la privacidad de datos : la herramienta debe diseñarse de acuerdo con las regulaciones globales de protección de datos como GDPR o CCPA, garantizando que los datos personales se manejen legalmente.

- Concientización sobre la propiedad intelectual : la herramienta debe tener mecanismos para evitar la infracción de los derechos de autor al extraer contenido protegido por derechos de autor.

- Transparencia usuario-agente : la capacidad de la herramienta de raspado de identificarse de manera precisa y transparente para dirigirse a sitios web, lo que reduce el riesgo de prácticas engañosas.

Incluir estas características puede ayudar a mitigar los riesgos legales y facilitar una estrategia de scraping responsable que respete tanto el contenido propietario como la privacidad del usuario.

- Personalización y flexibilidad

Para cumplir eficazmente con sus requisitos únicos de recopilación de datos, las empresas deben considerar las capacidades de personalización y la flexibilidad de una herramienta automatizada de web scraping como factores cruciales durante la evaluación. Una herramienta superior debería:

- Ofrezca una interfaz fácil de usar para que usuarios no técnicos personalicen los parámetros de extracción de datos.

- Proporcione opciones avanzadas para que los desarrolladores escriban scripts personalizados o utilicen API.

- Permita una fácil integración con los sistemas y flujos de trabajo existentes dentro de la empresa.

- Habilite la programación de actividades de scraping para que se ejecuten durante las horas de menor actividad, lo que reduce la carga en los servidores y evita una posible limitación del sitio web.

- Adáptese a diferentes estructuras de sitios web y tipos de datos, garantizando que se pueda manejar una amplia gama de casos de uso.

La personalización y la flexibilidad garantizan que la herramienta pueda evolucionar con las necesidades cambiantes de la empresa, maximizando el valor y la eficacia de los esfuerzos de web scraping.

- Funciones avanzadas de inteligencia artificial y aprendizaje automático

Al seleccionar una herramienta de web scraping automatizada, las empresas deben considerar la integración de IA avanzada y aprendizaje automático para mejorar la precisión de los datos. Estas características incluyen:

- Comprensión contextual : la aplicación del procesamiento del lenguaje natural (NLP) permite a la herramienta discernir el contexto, lo que reduce los errores en el contenido extraído.

- Reconocimiento de patrones : los algoritmos de aprendizaje automático identifican patrones de datos, lo que facilita la extracción precisa de información.

- Aprendizaje adaptativo : la herramienta aprende de tareas de scraping anteriores para optimizar los procesos de recopilación de datos para tareas futuras.

- Detección de anomalías : los sistemas de inteligencia artificial pueden detectar y corregir valores atípicos o anomalías en los datos extraídos, lo que garantiza la confiabilidad.

- Validación de datos : el uso de IA para verificar de forma cruzada los datos extraídos con múltiples fuentes mejora la validez de la información.

Al aprovechar estas capacidades, las empresas pueden disminuir sustancialmente las imprecisiones en sus conjuntos de datos, lo que lleva a una toma de decisiones más informada.

- Soporte técnico y documentación

Es aconsejable que las empresas den preferencia a las herramientas automatizadas de web scraping que vienen con una amplia asistencia técnica y documentación exhaustiva. Esto es crucial para:

- Minimizar el tiempo de inactividad : el soporte rápido y profesional garantiza que cualquier problema se resuelva rápidamente.

- Facilidad de uso : una documentación bien organizada ayuda a la formación del usuario y al dominio de las herramientas.

- Solución de problemas : guías y recursos accesibles permiten a los usuarios solucionar problemas comunes de forma independiente.

- Actualizaciones y mejoras : el soporte constante y la documentación clara son vitales para navegar eficazmente por las actualizaciones del sistema y las nuevas funciones.

Elegir una herramienta con soporte técnico sólido y documentación clara es esencial para un funcionamiento perfecto y una resolución eficiente de problemas.

- Evaluación de la rentabilidad de la herramienta

Las empresas deben tener en cuenta tanto los gastos iniciales como el posible retorno de la inversión al evaluar el software de automatización para el web scraping. Los factores clave de precios incluyen:

- Tarifas de licencia o costos de suscripción

- Gastos de mantenimiento y soporte.

- Posibles ahorros de costos gracias a la automatización

- Escalabilidad y adaptabilidad a necesidades futuras.

Una evaluación exhaustiva del retorno de la inversión (ROI) de una herramienta debe tener en cuenta su potencial para disminuir el trabajo manual, mejorar la precisión de los datos y acelerar el proceso de obtención de conocimientos. Además, las empresas deberían evaluar ventajas duraderas, como la mejora de la competitividad resultante de decisiones basadas en datos. Contrastar estas mediciones con el costo de la herramienta ofrecerá una visión distinta de su rentabilidad.

Conclusión

Al elegir una herramienta automatizada de web scraping, las empresas deben considerar meticulosamente cada característica en relación con sus requisitos específicos. Destacar aspectos como la escalabilidad, la precisión de los datos, la velocidad, la legalidad y la rentabilidad es fundamental. La herramienta ideal respaldará los objetivos de la empresa y se integrará sin problemas con los sistemas actuales. Al final, una elección inteligente surge de un examen exhaustivo de las características de la herramienta y de una comprensión sólida de las necesidades futuras de datos de la empresa.