Cómo la IA explicable puede desbloquear el desarrollo ético y responsable de la inteligencia artificial

Publicado: 2023-09-01Con momentos transformadores que combinan innovación e ingenio, como el lanzamiento de ChatGPT de OpenAI en noviembre de 2022, la visión de que la IA controle nuestras vidas ya no es ciencia ficción.

El momento decisivo del lanzamiento de ChatGPT marcó el comienzo de lo que la industria llama la "Explosión Cámbrica de la IA".

Sin embargo, se trata de algo más que utilizar la IA para obtener beneficios empresariales, que es el punto focal actual de esta explosión. En el centro de esta evolución hay un llamado a centrarse en la explicabilidad de la IA. Eso garantizará que los avances en IA sean poderosos y transparentes, lo cual es fundamental para el desarrollo ético de la IA.

La inteligencia artificial ya está tomando decisiones por nosotros en muchos campos. Pero no entender cómo la IA llega a esas decisiones sigue siendo un obstáculo. Este es un beneficio explicable de la IA que los empresarios y expertos en tecnología no pueden permitirse el lujo de ignorar.

A medida que avanza la tecnología, el desafío de los expertos en tecnología es doble: ampliar los límites de lo que la IA puede lograr y al mismo tiempo garantizar que su funcionamiento sea transparente, responsable y éticamente sólido. Esto pone de relieve el papel de la IA explicable en la tecnología moderna.

El potencial económico de la IA

El potencial de la IA generativa para revolucionar la productividad no es sólo teórico; Está previsto que tenga ramificaciones económicas tangibles a escala global. Según un informe de junio de 2023 titulado “El potencial económico de la IA generativa: la próxima frontera de productividad” publicado por McKinsey, la IA generativa podría agregar un valor que oscila entre 2,6 billones de dólares y 4,4 billones de dólares anuales en los 63 casos de uso analizados. También existen casos de uso de IA explicables que pueden beneficiar a las industrias de múltiples formas novedosas.

Lea también: Cómo la IA generativa para empresas está dando forma a las industrias

El Washington Post informó que más de 11.000 empresas han utilizado las herramientas OpenAI proporcionadas por la división de nube de Microsoft, destacando las tendencias de adopción que acompañan a este potencial. Estas cifras representan oportunidades y responsabilidades para los líderes tecnológicos que navegan en este panorama en evolución.

A medida que el potencial transformador de la IA se hace evidente, hay un énfasis cada vez mayor en los principios explicables de la IA, garantizando que estas poderosas herramientas funcionen con claridad, supervisión y consideraciones éticas. Las aplicaciones de IA explicables están destinadas a convertirse en la piedra angular de la industria tecnológica.

Sin embargo, comprender los beneficios explicables de la IA y otras facetas relacionadas es sólo el comienzo. Por lo tanto, antes de discutir en detalle los matices del desarrollo de la IA explicable, primero debemos comprender por qué es esencial.

El misterio de los modelos de IA: navegando por la 'caja negra'

Como ocurre con todos los avances importantes, la IA plantea desafíos, algunos de ellos profundamente relacionados con su estructura. Una de esas facetas de este misterio es una "caja negra". Representa un modelo operativo cerrado que funciona, pero que a veces ni siquiera los desarrolladores pueden explicar cómo funciona. Esto se conoce como el enigma de la caja negra en la industria de la IA.

Esta falta de transparencia es inaceptable para muchos, especialmente para aquellos responsables de decisiones comerciales o sociales cruciales. Una IA que funciona sin explicaciones corre el riesgo de erosionar la confianza, especialmente cuando es posible que se produzcan pérdidas físicas y materiales.

Consecuencias imprevistas: cuando la IA se descarrila

Las consecuencias de decisiones inexplicables de IA pueden variar desde ineficiencias menores hasta implicaciones sociales significativas. Consideremos el sector financiero: un sistema de inteligencia artificial podría denegar un préstamo a un individuo sin proporcionar una justificación clara.

Una decisión así, carente de transparencia, puede generar complicaciones legales y daños a la reputación. A mayor escala, en el ámbito de la atención sanitaria, una IA inescrutable podría priorizar a un paciente sobre otro para el tratamiento, con ramificaciones que alterarían o incluso acabarían con la vida.

Ejemplos del mundo real de resultados y contratiempos inesperados de la IA

Varios incidentes ponen de relieve las consecuencias imprevistas de la IA. El trágico incidente de 2018 que involucró al vehículo autónomo de Uber subraya las nefastas implicaciones que tiene cuando la IA malinterpreta su entorno. Un destacado algoritmo sanitario que presenta un sesgo racial es un claro recordatorio de que la IA, por muy avanzada que sea, puede perpetuar inadvertidamente los prejuicios humanos si no se comprende y supervisa adecuadamente.

La lista continúa, desde Tay de Microsoft, que tuiteó cosas como “Hitler tenía razón”, hasta un ciudadano estadounidense que recibe exuberantes facturas de tarjetas de crédito. Sin barreras de seguridad y sin la capacidad de interpretar las decisiones tomadas por la IA, estos casos seguirán ocurriendo, de ahí el llamado a la explicabilidad.

El caso empresarial: beneficios explicables de la IA

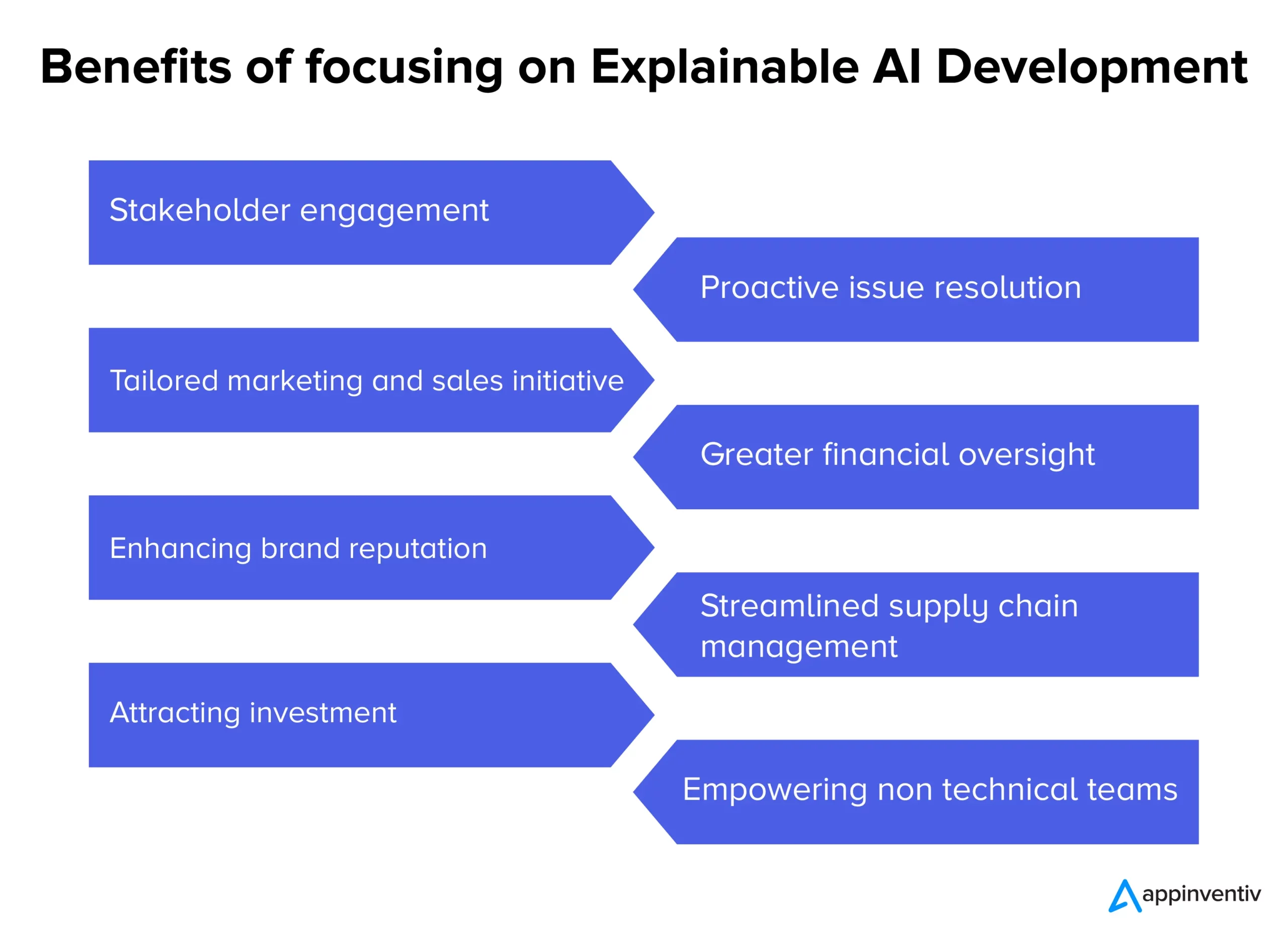

A medida que los sistemas de inteligencia artificial impulsan cada vez más ambiciones, su opacidad inherente ha suscitado conversaciones sobre el imperativo de transparencia. Más allá del discurso técnico, existe una sólida lógica empresarial que sustenta la adopción de una IA explicable. A continuación se detallan los diversos beneficios explicables de la IA para empresas de todos los sectores.

- Compromiso y confianza de las partes interesadas: los procesos transparentes de toma de decisiones de IA pueden fomentar un sentido más profundo de participación y seguridad entre los equipos internos y los socios externos.

- Resolución proactiva de problemas: antes de que los problemas se agraven, la IA explicable puede resaltar áreas potenciales de preocupación, lo que permite intervenciones y soluciones oportunas.

- Iniciativas de marketing y ventas personalizadas: las empresas pueden diseñar campañas más personalizadas y efectivas al comprender el "por qué" detrás de los conocimientos de los consumidores basados en la IA.

- Mayor supervisión financiera: cuando los modelos y pronósticos financieros basados en IA son transparentes, las posibles anomalías o áreas de crecimiento pueden identificarse y abordarse más fácilmente.

- Mejora de la reputación de la marca: las empresas conocidas por sus implementaciones de IA éticas y transparentes probablemente disfrutarán de una mayor reputación de marca.

- Gestión optimizada de la cadena de suministro: con información clara impulsada por la IA, los procesos de la cadena de suministro se pueden optimizar de manera más efectiva, desde la gestión de inventario hasta la logística.

- Atraer inversiones: para los inversores, la transparencia en la IA puede significar el compromiso de una empresa con la innovación responsable, lo que la convierte en una propuesta de inversión más atractiva.

- Empoderar a los equipos no técnicos: la IA explicable garantiza que los conocimientos y las decisiones impulsados por la IA sean accesibles y procesables para equipos sin una experiencia técnica profunda, fomentando la colaboración entre departamentos.

A medida que las empresas navegan por el complejo panorama de la era moderna, confiar en soluciones de caja negra puede ser una apuesta. La infusión de transparencia en los procesos de IA no es sólo una mejora tecnológica; es una necesidad empresarial, que garantiza que cada movimiento respaldado por la IA se alinee con objetivos y valores organizacionales más amplios, lo que significa el papel de la IA explicable. Estos también son casos de uso de IA explicables en los que los empresarios y desarrolladores de IA suelen centrarse.

El plan para un modelo de IA explicable

Ahora que el impacto de la IA en nuestra vida cotidiana se vuelve más evidente cada día que pasa, se vuelve crucial garantizar que las máquinas a las que confiamos decisiones críticas sean precisas y transparentes en su funcionamiento.

Desarrollar un modelo de IA explicable no se trata sólo de codificación; es un proceso que implica planificación estratégica, pruebas rigurosas y refinamiento iterativo basado en principios y herramientas de IA explicables. Aquí hay una guía paso a paso y técnicas de IA explicables que garantizan que los modelos de IA que desarrollamos sean explicables e interpretables y, al mismo tiempo, cumplan con la ley.

- Comprender el dominio del problema: antes de sumergirnos en el desarrollo del modelo, entendemos claramente el dominio del problema y las partes interesadas involucradas. ¿Qué esperan los usuarios? Qué decisiones tomará la IA y qué impacto tendrán esas decisiones son algunas de las preguntas a las que encontramos respuestas.

- Selección de datos apropiados: la calidad y relevancia de los datos influyen directamente en la capacidad de la IA para ser precisa y explicable. En el desarrollo de nuestro modelo de IA, nos aseguramos de que los datos sean limpios, diversos y libres de sesgos.

- Elegir el modelo correcto: si bien algunos modelos, como las redes neuronales profundas, son más complejos y difíciles de interpretar, otros, como los árboles de decisión o la regresión lineal, pueden ofrecer más transparencia. Elegimos un equilibrio entre complejidad y claridad mientras desarrollamos modelos de IA explicables.

- Pruebas iterativas: probamos periódicamente el modelo con diversos conjuntos de datos para garantizar un rendimiento constante. Los comentarios de estas pruebas pueden informar sobre refinamientos y mejoras.

- Integración de herramientas de explicabilidad: herramientas como LIME o SHAP ayudan a desglosar las predicciones del modelo y ofrecen información sobre qué características influyeron en una decisión en particular.

- Documentación: La documentación completa nos ayuda en la verificación, validación e implementación del modelo. Garantiza que todas las partes interesadas comprendan el funcionamiento y las limitaciones de la IA, desde los desarrolladores hasta los usuarios finales.

Equilibrar el rendimiento del modelo con la interpretabilidad

Uno de los desafíos más importantes en el desarrollo de software de IA explicable es equilibrar el rendimiento y la interpretabilidad de un modelo. Si bien los modelos complejos pueden ofrecer una mayor precisión, a menudo lo hacen a costa de la transparencia. Por el contrario, los modelos más simples pueden ser más fáciles de entender, pero es posible que no capturen de manera efectiva los matices de los datos. Para lograr el equilibrio adecuado, consideramos lo siguiente:

- Simplicidad del modelo versus complejidad: Determinamos el nivel mínimo de complejidad requerido para lograr un desempeño satisfactorio. Si un modelo más simple es suficiente, podría ser una mejor opción para garantizar la explicabilidad.

- Uso de técnicas de explicabilidad: técnicas como la clasificación de importancia de las características o los métodos independientes del modelo pueden ayudar a que los modelos complejos sean más interpretables.

- Circuito de retroalimentación: mantenemos un circuito de retroalimentación continuo con los usuarios finales para comprender si las decisiones de la IA son claras y si hay espacio para mejorar la transparencia.

Si bien el camino hacia lograr una IA explicable puede parecer complejo, es necesario. A medida que integremos más la IA en nuestros sistemas y procesos, garantizar estos modelos transparentes y de alto rendimiento será crucial para mantener la confianza y la eficiencia.

¿Cómo puede Appinventiv ayudarle a desarrollar modelos de IA explicables?

Con casi nueve años de experiencia en el desarrollo de productos de IA, en Appinventiv comprendemos las diversas complejidades relacionadas con el desarrollo de modelos de IA y los beneficios explicables de la IA. Habiendo desarrollado numerosas plataformas y aplicaciones basadas en IA, incluida Mudra (una aplicación de finanzas personales impulsada por IA), nuestros ingenieros tienen la experiencia en el campo y la supervisión para avanzar hacia un desarrollo de IA explicable.

Cualquiera que sea su proyecto de IA, nosotros, como empresa líder en desarrollo de IA, podemos desbloquear la interpretabilidad y explicabilidad de su modelo de IA para que pueda confiar con confianza en las decisiones tomadas por los modelos. Póngase en contacto hoy para embarcarse en el viaje hacia una IA responsable .

Preguntas frecuentes

P. ¿Qué es la IA explicable?

R. La IA explicable es un cambio de paradigma en el desarrollo de la IA que exige el desarrollo de modelos de IA de tal manera que las decisiones tomadas por el modelo de IA puedan rastrearse y los usuarios puedan comprender cómo el modelo de IA toma decisiones.

P. ¿Cómo funciona la IA explicable?

R. La IA explicable funciona integrando elementos clave de explicabilidad en los modelos de IA durante el desarrollo que pueden ayudar a determinar cómo un modelo de IA ha llegado a una decisión particular.

P. ¿Por qué es importante la IA explicable?

R. La IA explicable es importante porque no comprender cómo un modelo de IA toma decisiones por nosotros puede tener consecuencias nefastas y, en el peor de los casos, puede significar un daño tangible para las empresas o los usuarios del modelo de IA en cuestión.