Altamente visible y de baja calidad (o inútil): la combinación de SEO más peligrosa

Publicado: 2024-01-08

Mientras ayudaba a empresas que se vieron muy afectadas por la "Caída de actualizaciones de algoritmos locos de 2023", una vez más escuché de varios propietarios de sitios que tenían sus niveles más altos de tráfico justo antes de ser golpeados. Hablaré más sobre eso pronto, pero es algo que he visto durante mucho tiempo. Y ahora que hemos leído el testimonio de Google sobre Navboost y las señales de interacción del usuario del último juicio antimonopolio, varias ideas han estado rondando por mi cabeza.

Si bien ayudamos a las empresas afectadas por actualizaciones importantes de algoritmos (como actualizaciones básicas generales), es muy importante ejecutar lo que yo llamo un "informe delta" para identificar las consultas principales y las páginas de destino que cayeron durante esas actualizaciones. Los informes delta pueden ser potentes y ayudar a los propietarios de sitios a determinar si una caída se debió a ajustes de relevancia, cambios de intención o problemas generales de calidad del sitio. Y si el problema era la calidad, investigar las consultas y las páginas de destino que más cayeron a menudo puede arrojar resultados importantes. Y esos hallazgos podrían ayudar a identificar contenido de baja calidad, contenido delgado, contenido de IA de baja calidad, barreras en la experiencia del usuario, publicidad agresiva, una configuración de afiliado engañosa o agresiva, y más.

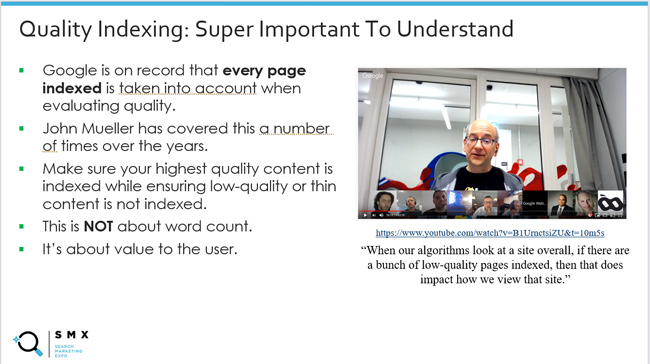

Esto también me hizo pensar una vez más en la "indexación de calidad", que he cubierto muchas veces en mis publicaciones y presentaciones sobre importantes actualizaciones de algoritmos. Esto significa asegurarse de que el contenido de la más alta calidad esté indexado y, al mismo tiempo, garantizar que el contenido de baja calidad o escaso no esté indexado. Esa proporción importa. Esto se debe a que sabemos que Google tiene en cuenta cada página indexada al evaluar la calidad. John Mueller de Google lo ha explicado varias veces y he compartido esos videoclips a lo largo de los años.

Pero, ¿son todas las cosas iguales desde el punto de vista de la calidad? En otras palabras, si encuentra un lote de material de menor calidad en su sitio que no aparece con frecuencia en los resultados de búsqueda, ¿es lo mismo que contenido de menor calidad (o contenido inútil) que es muy visible en los resultados de búsqueda?

Los comentarios de John Mueller sobre la eliminación de contenido de baja calidad han cambiado ligeramente a lo largo de los años en ese frente. Lo noté con el tiempo y siempre despertó mi curiosidad. John pasó de explicar que si un contenido está indexado, se puede evaluar su calidad a explicar que se centraría primero en lo que es muy visible y de baja calidad . Explicaré más acerca de por qué esto tiene mucho sentido (especialmente con información reciente del último juicio antimonopolio de Google).

A continuación, cubriré rápidamente información general sobre las señales de participación del usuario y SEO, luego cubriré algunos comentarios interesantes de John Mueller de Google a lo largo de los años sobre la eliminación de contenido de baja calidad, y luego lo vincularé con Testimonio reciente de Google sobre el aprovechamiento de las señales de interacción del usuario para ayudar con la clasificación (es decir, Navboost).

Primero, demos un paseo por la historia y analicemos las señales de interacción del usuario y el impacto SEO.

Señales de interacción del usuario y SEO y la asombrosa capacidad de Google para comprender la felicidad del usuario:

Con el último juicio antimonopolio de Google, aprendimos mucho sobre cómo Google aprovecha las señales de interacción del usuario para impactar las clasificaciones. Por ejemplo, Pandu Nayak de Google habló sobre Navboost, cómo Google recopila 13 meses de datos de clics (antes 18 meses) y cómo esos datos pueden ayudar a Google a comprender la felicidad del usuario (usuarios de búsqueda satisfechos).

Aunque conocer Navboost sorprendió a muchas personas (con razón), siempre hubo señales de que Google estaba haciendo algo con los datos de participación de los usuarios desde una perspectiva de clasificación. Nadie lo sabía realmente con seguridad, pero era difícil ignorar el concepto mientras se investigaban muchos sitios que desaparecieron con el tiempo debido a importantes actualizaciones de algoritmos (especialmente actualizaciones básicas generales).

Por ejemplo, escribí una publicación en 2014 sobre el siniestro y engañoso aumento del tráfico antes de que apareciera un algoritmo importante. Tenga en cuenta que Search Engine Watch tiene problemas con publicaciones más antiguas, por lo que me vinculé a la versión Wayback Machine de mi publicación. Escribí esa publicación después de que muchas empresas se comunicaran conmigo sobre los grandes éxitos de Panda y me explicaran que acababan de experimentar sus niveles más altos de tráfico hasta que… fallaron con la siguiente actualización.

Para mí, parecía que Google estaba ganando tanta inteligencia en función de cómo los usuarios interactuaban con el contenido de las SERP que terminó contribuyendo a la caída. En otras palabras, Google podría ver usuarios descontentos a gran escala en esos sitios. Y luego boom, se derrumbaron.

Aquí hay una cita de mi artículo de SEW:

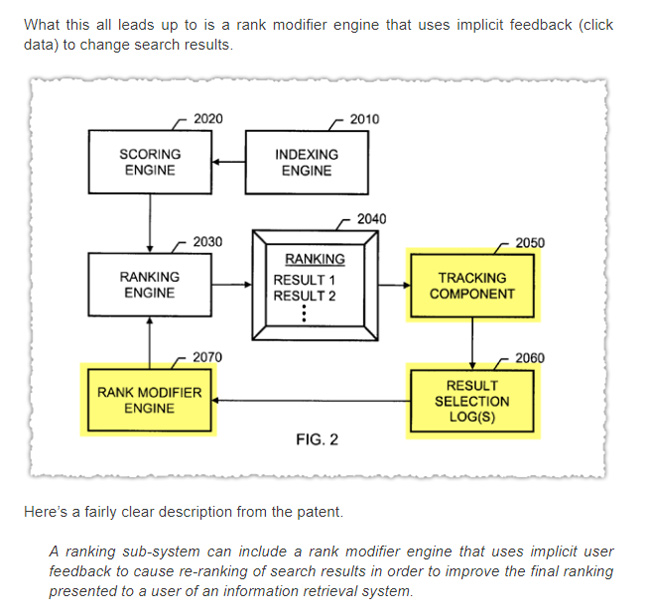

Además, AJ Kohn también escribió un artículo en 2015 sobre el CTR como factor de clasificación. AJ también ha trabajado en muchos sitios a lo largo de los años y tenía el presentimiento de que las señales de interacción del usuario desempeñaban un papel en las clasificaciones. Aquí hay una captura de pantalla de la publicación de AJ que hace referencia a los comentarios implícitos de los usuarios.

También he escrito mucho sobre el peligro de un tiempo de permanencia bajo y cómo implementar algo como una tasa de rebote ajustada podría ayudar a los propietarios de sitios a tener una mejor idea del contenido que no cumple o supera las expectativas del usuario. Esa publicación es de 2012. Y amplié esa idea con otra publicación en 2018 sobre el uso de varios mecanismos de seguimiento como indicador de la felicidad del usuario (incluida la tasa de rebote ajustada, el seguimiento de la profundidad de desplazamiento y el tiempo en la página). Tenga en cuenta que esto fue para GA3, no para GA4.

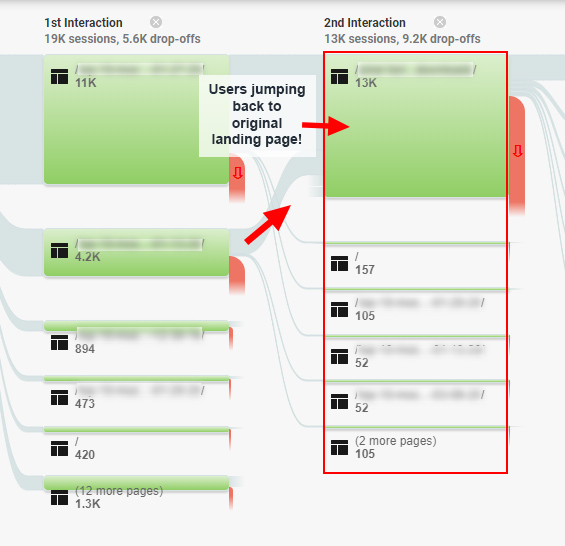

Y como un gran ejemplo de cómo los problemas de participación del usuario podrían afectar el SEO, hubo un estudio de caso que escribí en 2020 sobre la "trampa de la participación del SEO", donde encontré usuarios corriendo en círculos alrededor de un sitio, y estoy seguro de que finalmente volveremos a las SERP, para obtener mejores respuestas. Ese sitio fue golpeado por una amplia actualización central y se recuperó más adelante después de abordar muchos de esos problemas. Así que sí, más señales negativas de interacción del usuario para que Google las evalúe.

Aquí hay una captura de pantalla de esa publicación que muestra informes de flujo de comportamiento para usuarios frustrados:

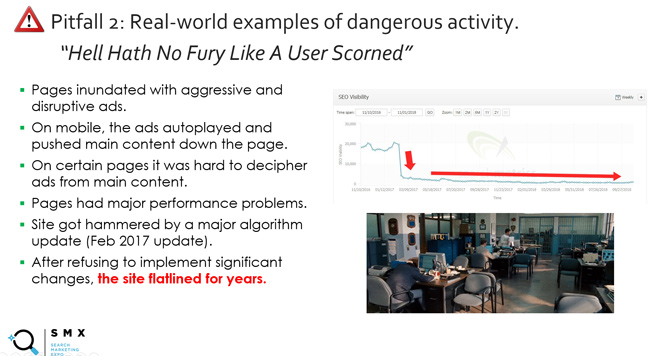

Y está la diapositiva (y el lema) que he estado usando durante mucho tiempo en mis presentaciones sobre actualizaciones principales tituladas "El infierno no tiene furia como la de un usuario despreciado". Esto se relaciona con algo más que la calidad del contenido e incluye publicidad agresiva, barreras en la experiencia del usuario y más. Básicamente, no molestes a los usuarios. Pagarás un alto precio. Y, por cierto, ¿cuál es una excelente manera para que Google comprenda a los usuarios molestos? Bueno, al rastrear las señales de interacción del usuario, como el tiempo de permanencia bajo (alguien regresa rápidamente a las SERP después de visitar un sitio de Google).

Y sobre el tema del tiempo de permanencia, una de mis citas favoritas fue de hace años, cuando Duane Forrester de Bing escribió una publicación de blog explicando cómo un tiempo de permanencia bajo podría afectar la visibilidad de búsqueda. Duane ya no trabaja para Bing, pero fue Matt Cutts de Bing durante varios años. En esa publicación, que ahora ha sido eliminada (pero que se puede encontrar a través de Wayback Machine), Duane explicó lo siguiente:

“Si tu contenido no los anima a quedarse contigo, se irán. Los motores de búsqueda pueden hacerse una idea de esto observando el tiempo de permanencia. El tiempo entre el momento en que un usuario hace clic en nuestro resultado de búsqueda y el momento en que regresa de su sitio web cuenta una historia potencial. Uno o dos minutos es bueno, ya que puede indicar fácilmente que el visitante consumió su contenido. Menos de un par de segundos pueden considerarse un mal resultado. Y si bien ese no es el único factor que revisamos cuando ayudamos a determinar la calidad, es una señal que observamos”.

Luego, en otra publicación en SEJ, Duane continuó diciendo:

"El tiempo de permanencia era uno de esos conceptos que tenía perfecto sentido una vez explicado, y fue inmediatamente obvio que dicha métrica podría ser muy importante para determinar la satisfacción del buscador".

Y finalmente, Duane explicó que se consideró “en una mezcla de factores”, lo cual es importante entender. Explicó que perseguir el tiempo de permanencia era una mala idea. Explicó que debía centrarse en realizar mejoras más amplias para un sitio que aumentara la participación del usuario (y el tiempo de permanencia puede aumentar como resultado de ese trabajo). Esta es también la razón por la que creo que el enfoque de remediación “fregadero de la cocina” es una manera poderosa de hacerlo. Aborde tantos problemas de calidad como pueda y en el futuro podrán suceder grandes cosas.

Tenga en cuenta que no se centre en la cantidad de tiempo que Duane proporcionó en 2011 para un "compromiso breve"... Estoy seguro de que esa es una de las razones por las que se eliminó la publicación. Para algunos tipos de contenido, un período de tiempo más corto está totalmente bien desde el punto de vista de la participación del usuario. Pero es muy importante comprender el punto principal sobre el bajo tiempo de permanencia, especialmente cuando se ve en muchos contenidos de un sitio. Lo fue entonces y seguramente lo será ahora.

El punto principal que intento transmitir es que la interacción del usuario siempre pareció ser un factor de alguna manera... simplemente no sabíamos exactamente cómo. Eso fue hasta que Navboost quedó expuesto. Cubriré más sobre eso pronto.

Por qué es importante "altamente visible": comentarios de John Mueller de Google.

Bien, ahora echemos un vistazo más de cerca a lo que yo llamo "indexación de calidad". Nuevamente, eso significa asegurarse de que solo se indexe el contenido de la más alta calidad que pueda cumplir o superar las expectativas del usuario, y al mismo tiempo garantizar que no se indexe el contenido de baja calidad o escaso contenido.

Google ha explicado a lo largo del tiempo que todas las páginas indexadas se tienen en cuenta a la hora de evaluar la calidad. Lo he cubierto muchas veces en las publicaciones y presentaciones de mi blog sobre actualizaciones importantes de algoritmos (especialmente cuando cubro actualizaciones básicas generales).

Aquí está John de 2017 explicando eso:

Pero con el tiempo, noté un cambio en la respuesta de John cuando se le preguntó acerca de eliminar contenido de menor calidad. John comenzó a explicar que se centraría en contenido que fuera “muy visible” y de menor calidad. Escuché eso en varios videos de Hangouts de Search Central y también lo cubrió en una entrevista con Marie Haynes.

A continuación se muestran varios ejemplos:

Primero, aquí está Juan explicando que no todas las cosas son iguales en cuanto a contenido. Google intentará descubrir las páginas más importantes y centrarse en ellas:

Aquí está John explicando que Google puede entender el contenido principal de un sitio, hacia dónde se dirigen los visitantes, etc.

Y aquí está John explicando que si sabes que la gente está visitando ciertas páginas, entonces tendría sentido abordar primero esas páginas de menor calidad (para que la gente pueda quedarse):

Entonces, ¿por qué es importante? Bueno, ahora que sabemos más sobre cómo Google aprovecha las señales de interacción del usuario para impactar la visibilidad y las clasificaciones a través de Navboost, esa declaración de John tiene mucho sentido. Cuantos más datos de interacción del usuario tenga Google para combinaciones de consultas y páginas de destino, más podrá comprender la felicidad del usuario. Si una página es de baja calidad y no es visible, entonces Google no tiene datos de interacción del usuario. Claro, Google puede usar otras señales, procesamiento del lenguaje natural, etc. para comprender mejor el contenido, pero las señales de interacción del usuario son sorprendentes para comprender la satisfacción del buscador.

Tenga en cuenta que antes de continuar, quería dejar claro que seguiría abordando todos los problemas de calidad del contenido en un sitio (incluso aquellos que no son "altamente visibles"), pero comenzaría con los más visibles. Ese es un punto importante para los propietarios de sitios que se enfrentan a una gran caída de actualizaciones básicas generales, actualizaciones de contenido útil o actualizaciones de reseñas.

El juicio antimonopolio de Google y las señales de participación del usuario influyen en las clasificaciones.

He mencionado Navboost varias veces en esta publicación y quería abordarlo en esta sección. No profundizaré mucho ya que se ha cubierto recientemente en otras publicaciones de la industria, pero es importante comprenderlo.

En el testimonio antimonopolio de Google, Pandu Nayak explicó el uso de Navboost, un sistema para aprovechar los datos de interacción del usuario para ayudar a Google a comprender la felicidad del usuario. Básicamente, permite a Google aprender de sus usuarios a lo largo del tiempo y ajustar las clasificaciones en función de esos aprendizajes. Obviamente, Navboost no es el único factor en juego, pero es un factor importante a la hora de determinar las clasificaciones.

Aquí está Pandu Nayak sobre la importancia de Navboost:

“Quiero decir, es difícil dar una clasificación como esta. Diré que navboost es importante, ¿verdad? Así que no quiero minimizarlo de ninguna manera. Pero también diré que hay muchas otras señales que también son importantes, como las que mencioné. Y realmente no puedes desactivar algunas de estas cosas. No sé qué significaría desactivar el índice de los documentos. En cierto modo, eso es lo más importante, las palabras en la página y demás, ¿verdad? Entonces es un poco difícil juzgar de esa manera. Entonces yo diría que navboost es una de las señales importantes que tenemos. "

Por lo tanto, si las páginas son muy visibles para una consulta, Google recopila activamente señales de participación del usuario para esas URL y combinaciones de consultas (ahora recopila 13 meses de datos de clics). Y Navboost puede utilizar esas señales de interacción del usuario para ayudar a los sistemas de Google a comprender la felicidad del usuario (lo que incluye comprender el tiempo de permanencia, los clics prolongados, los desplazamientos, los desplazamientos y más).

Y, por otro lado, si las páginas no son muy visibles para las consultas, entonces Google no puede aprovechar esas señales de interacción del usuario... o no tiene suficientes señales para tener impacto. Esto no significa que Google no pueda comprender la calidad de la página, pero carecerá de señales reales de usuario para esas combinaciones de consulta y página de destino. Y eso es increíblemente importante.

Tenga en cuenta que si está interesado en obtener más información sobre las señales de interacción del usuario del juicio antimonopolio de Google, AJ Kohn escribió una excelente publicación que cubre esa información basándose en el testimonio de Pandu Nayak. Recomiendo leer la publicación de AJ si aún no lo ha hecho, ya que cubre más sobre Navboost, señales de interacción del usuario, CTR como factor de clasificación, etc.

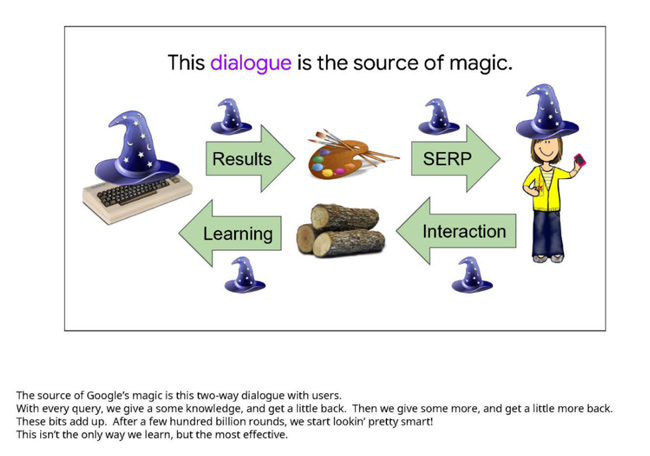

Aquí hay una diapositiva de una presentación de Google que fue evidencia durante el juicio. Subraya la importancia de las señales de interacción del usuario para determinar la satisfacción del buscador. Tenga en cuenta que esta diapositiva fue de hace varios años. Se trata de la “fuente de la magia de Google”:

Y no se olvide de los algoritmos de calidad a nivel de sitio:

Nuevamente, no quiero atascar esta publicación con demasiada información del juicio antimonopolio, pero mi punto central es que el contenido "altamente visible" en las SERP puede obtener un montón de señales de interacción del usuario, que Google puede usar como factor para las clasificaciones. También es posible que Google pueda utilizar esos datos en conjunto para influir en los algoritmos de calidad a nivel del sitio. Y esos algoritmos a nivel de sitio pueden desempeñar un papel muy importante en el desempeño de los sitios durante las actualizaciones principales generales (y otras actualizaciones importantes de algoritmos). También he cubierto eso durante mucho tiempo.

Lo que esto significa para ti. Mi recomendación para los propietarios de sitios afectados por actualizaciones importantes de algoritmos:

Para los propietarios de sitios muy afectados por importantes actualizaciones de algoritmos, es importante dar un paso atrás y analizar un sitio en general desde una perspectiva de calidad. Y como explicó anteriormente John Mueller de Google, “calidad” es más que sólo contenido. También se trata de cuestiones de UX, la situación publicitaria, cómo se presentan las cosas y más.

Y ahora, con la confirmación de que Google aprovecha las señales de interacción del usuario para impactar la visibilidad y las clasificaciones a través de Navboost, subiría las URL "altamente visibles" en la lista al decidir qué abordar. Sí, debe abordar todos los problemas de calidad que surja, incluso aquellos que podrían no ser muy visibles, pero yo daría prioridad a las URL que fueron más visibles antes de una actualización importante del algoritmo. Así que sí, ejecutar un informe delta se ha vuelto aún más importante.

Resumen: muestre todo el contenido de baja calidad, pero comience con lo que es "altamente visible".

A lo largo de los años, siempre he explicado que el contenido debe cumplir o superar las expectativas del usuario según la consulta. Ahora, con el último testimonio del juicio antimonopolio de Google, tenemos pruebas contundentes de que Google está aprovechando las señales de interacción del usuario para ajustar las clasificaciones (y posiblemente influir en los algoritmos de calidad a nivel de sitio). Como propietario de un sitio, no permita que contenido de baja calidad, escaso o inútil permanezca en las SERP para que los usuarios interactúen. Como he visto a lo largo de los años con importantes actualizaciones de algoritmos, eso no terminará bien. Definitivamente aborde todos los posibles problemas de calidad en un sitio, pero no pase por alto lo que es muy visible. Este es un excelente punto de partida para mejorar la calidad general del sitio.

GG