Escalado de operaciones de extracción de datos: consejos de expertos para manejar grandes volúmenes de datos

Publicado: 2024-05-25A medida que crece la demanda de datos, también aumentan los desafíos asociados con la ampliación de las operaciones de extracción de datos. El web scraping a gran escala no se trata sólo de aumentar la cantidad de datos recopilados; se trata de mantener la calidad, garantizar la eficiencia y superar los obstáculos técnicos y legales.

Imagine una empresa minorista que comienza con una modesta operación de extracción de datos, recopilando información sobre precios y productos de algunos sitios web de la competencia. Inicialmente, esta configuración funciona sin problemas y proporciona información valiosa para la toma de decisiones estratégicas. Sin embargo, a medida que la empresa se expande y comienza a apuntar a un mercado más amplio, se hace evidente la necesidad de realizar un web scraping a gran escala de cientos o incluso miles de sitios web. La infraestructura inicial, que era adecuada para operaciones a pequeña escala, ahora tiene problemas con el aumento de carga, lo que genera un rendimiento más lento y posibles imprecisiones en los datos.

Además, el manejo de fuentes web diversas y dinámicas añade otra capa de complejidad. Los sitios web a menudo actualizan sus estructuras, implementan medidas anti-scraping o requieren la extracción de datos de contenido complejo renderizado en JavaScript. Estos desafíos requieren soluciones sólidas y adaptables que puedan escalarse sin problemas sin comprometer la calidad o la legalidad de los datos.

El web scraping a gran escala no se trata solo de manejar más datos, sino de hacerlo de una manera eficiente, confiable y que cumpla con los estándares legales. Implica elegir las herramientas y tecnologías adecuadas, construir una infraestructura sólida e implementar procesos de procesamiento de datos eficientes. Comprender los desafíos del web scraping a gran escala y desarrollar estrategias para superarlos es esencial para las empresas que buscan aprovechar todo el potencial del data scraping.

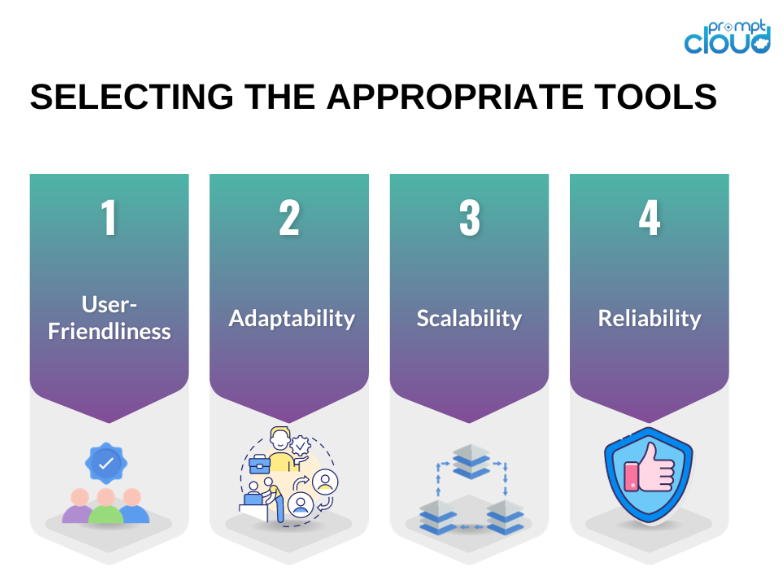

#1: Elegir las herramientas y tecnologías adecuadas

Seleccionar las herramientas y tecnologías adecuadas es la base de las operaciones de web scraping a gran escala. Los marcos de scraping avanzados como Scrapy, Beautiful Soup y Selenium ofrecen funcionalidades sólidas que pueden manejar tareas de scraping complejas. Estas herramientas son excelentes para proyectos más pequeños y manejables, pero a medida que crece la escala y la complejidad de las operaciones de extracción de datos, se requieren soluciones más potentes y flexibles.

Aquí es donde entran en juego los proveedores de servicios de web scraping como PromptCloud. PromptCloud ofrece una solución integral de extracción de datos de extremo a extremo diseñada para escalar sin problemas según las necesidades comerciales. A diferencia de las herramientas tradicionales, PromptCloud proporciona un servicio totalmente administrado que se encarga de todo, desde la configuración de la infraestructura de scraping hasta la entrega de datos.

#2: Construyendo una infraestructura robusta

Una infraestructura sólida es crucial para respaldar operaciones de web scraping a gran escala. Esto incluye servidores potentes, amplias soluciones de almacenamiento y conexiones a Internet de alta velocidad. Aprovechar los servicios de infraestructura en la nube como Amazon Web Services (AWS), Google Cloud Platform (GCP) o Microsoft Azure garantiza escalabilidad y confiabilidad, lo que permite a las empresas escalar sus operaciones según sea necesario.

Configurar y administrar su propia infraestructura puede requerir muchos recursos y ser complejo. PromptCloud ofrece una solución optimizada que elimina estos desafíos. Al proporcionar un servicio de extracción de datos totalmente administrado, PromptCloud se encarga de los requisitos de infraestructura y garantiza que sus operaciones se ejecuten sin problemas y de manera eficiente.

N.º 3: Garantizar la calidad y precisión de los datos a escala

Mantener la calidad y precisión de los datos es un desafío importante cuando se trata de grandes conjuntos de datos. A medida que crece el volumen de datos, aumenta el potencial de errores e inconsistencias, por lo que es crucial implementar procedimientos sólidos de validación y limpieza de datos. Garantizar que los datos recopilados sean confiables y utilizables es esencial para tomar decisiones comerciales informadas y mantener la integridad de sus análisis.

Los sitios web cambian con frecuencia sus estructuras, lo que puede interrumpir las operaciones de extracción de datos y generar imprecisiones. Monitorear y actualizar periódicamente sus scripts de scraping es esencial para adaptarse a estos cambios y garantizar la precisión continua de los datos recopilados.

PromptCloud proporciona una solución integral para mantener la calidad y precisión de los datos a escala. Al aprovechar sus servicios de raspado web a gran escala y raspado de datos administrados, puede asegurarse de que sus procesos de recopilación de datos sigan siendo sólidos y confiables.

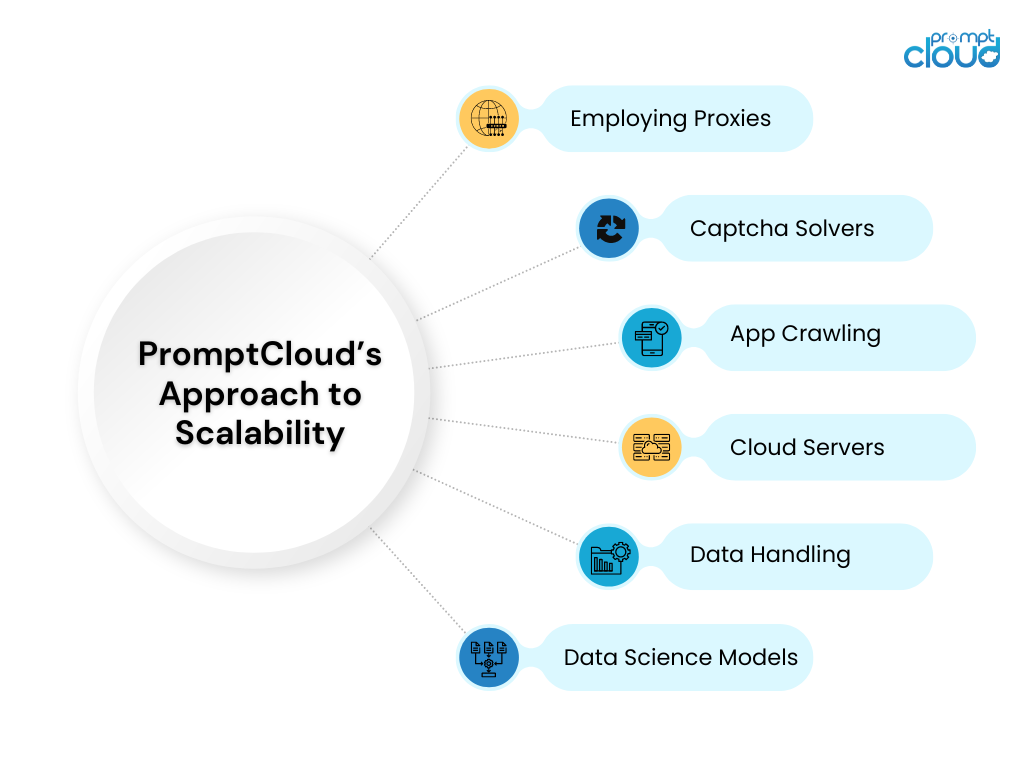

#4: Aprovechar las soluciones en la nube para lograr escalabilidad

Las soluciones en la nube ofrecen una escalabilidad incomparable para las operaciones de extracción de datos. Servicios como AWS EC2 y Google Cloud Compute Engine permiten a las empresas aumentar o reducir sus recursos informáticos según la demanda. Esta flexibilidad garantiza que las operaciones de extracción de datos puedan manejar diferentes cargas de trabajo sin comprometer el rendimiento.

PromptCloud aprovecha al máximo las soluciones en la nube para ofrecer un servicio de web scraping escalable y eficiente a gran escala. Al integrarse con las principales plataformas en la nube, PromptCloud garantiza que sus operaciones de extracción de datos puedan manejar cualquier volumen de datos con facilidad.

#5: Manejo del almacenamiento y la gestión de datos

Las soluciones eficaces de almacenamiento y gestión de datos son vitales para manejar grandes volúmenes de datos extraídos. A medida que crece la cantidad de datos, se vuelve cada vez más importante garantizar que se almacenen de forma segura y que se pueda acceder a ellos rápidamente.

PromptCloud ofrece soluciones integrales de gestión y almacenamiento de datos como parte de sus servicios gestionados de extracción de datos. Al utilizar soluciones de almacenamiento escalables e implementar las mejores prácticas en la gestión de datos, PromptCloud garantiza que sus datos se almacenen de forma segura y se pueda acceder a ellos de manera eficiente.

Ampliación de las operaciones de web scraping con PromptCloud

Ampliar las operaciones de web scraping para manejar grandes volúmenes de datos presenta numerosos desafíos, desde mantener la calidad de los datos y administrar el almacenamiento hasta garantizar una recuperación y un procesamiento eficientes. Sin embargo, con las estrategias y herramientas adecuadas, estos desafíos se pueden abordar de manera efectiva, permitiendo a las empresas aprovechar todo el potencial del web scraping para obtener una ventaja competitiva y una toma de decisiones informada.

PromptCloud ofrece un conjunto completo de soluciones diseñadas para abordar las complejidades del web scraping a gran escala. Al aprovechar tecnologías avanzadas y una infraestructura sólida, garantizamos que sus operaciones de extracción de datos sean escalables, eficientes y confiables. ¿Está listo para escalar sus operaciones de extracción web y desbloquear todo el potencial de sus datos? Asóciese con PromptCloud para aprovechar nuestras soluciones de vanguardia y servicios expertos. Contáctenos hoy para programar una demostración y ver nuestras soluciones en acción.