IA responsable: abordar los desafíos de la adopción con principios y estrategias rectores

Publicado: 2023-09-08En una era dominada por la adopción generalizada de soluciones de IA, se ha vuelto bastante vital priorizar un proceso de desarrollo responsable respetando al mismo tiempo los principios éticos y de seguridad. A medida que estos sistemas de IA continúan creciendo en capacidad y encontrando aplicaciones en varios nichos industriales, garantizar que su creación se alinee con medidas de seguridad rigurosas debe ser una de las principales prioridades de la organización.

Entonces, ¿cómo se puede garantizar que sus sistemas basados en IA sean éticos y no causen consecuencias no deseadas? La respuesta sencilla a este enigma es el cumplimiento de los principios de la IA responsable.

La IA responsable (RAI) se refiere a un marco integral de inteligencia artificial, donde las consideraciones éticas y el bienestar social ocupan un lugar central. Presenta el desarrollo y la aplicación responsables de sistemas de IA diseñados para armonizar con los principios fundamentales.

Los Principios de IA Responsable permiten a las organizaciones centrarse fuertemente en la transparencia, permitiendo a los usuarios y partes interesadas comprender el funcionamiento interno de los sistemas de IA. Esta transparencia allana el camino para una mayor confianza y responsabilidad, permitiendo a las personas comprender cómo se toman las decisiones de IA. RAI también maneja activamente el sesgo dentro de los algoritmos de IA mediante la gestión inteligente de datos e incorporando medidas de equidad para garantizar que los resultados sean imparciales e imparciales.

Este blog lo ayudará a comprender los cinco principios responsables de la IA y cómo su cumplimiento puede hacer que su sistema de IA sea justo y equitativo para los usuarios. Además de analizar los beneficios de adoptar una IA responsable para las empresas, también lo ayudaremos a comprender los diversos desafíos que se pueden abordar al adoptar un enfoque simplificado.

La necesidad de adoptar estrategias de IA responsables: mitigar los riesgos de la IA

En marzo de 2016, Microsoft lanzó un chatbot de IA llamado Tay en Twitter. El propósito de Tay era aprender de sus interacciones con los usuarios. Desafortunadamente, algunas personas comenzaron a publicar contenido ofensivo en el bot, lo que provocó que Tay respondiera con lenguaje ofensivo. En cuestión de horas, Tay se transformó en un robot que promovía el discurso de odio y la discriminación. Microsoft rápidamente desconectó a Tay y se disculpó por los tweets inapropiados del bot. Este incidente es un claro ejemplo de cómo la IA puede salir mal, y desde entonces han ocurrido muchos casos similares.

La IA tiene un enorme potencial para beneficiar a la sociedad, pero, como dice el tío Ben, “un gran poder conlleva una gran responsabilidad”.

Cuando utiliza la IA para tomar decisiones comerciales importantes que involucran datos confidenciales, es fundamental saber:

- ¿Qué está haciendo la IA y por qué?

- ¿Está tomando decisiones precisas y justas?

- ¿Se respeta la privacidad de las personas?

- ¿Podrás controlar y vigilar esta poderosa tecnología?

Las organizaciones de todo el mundo se están dando cuenta de la importancia de las estrategias de IA responsable, pero se encuentran en diferentes puntos de su camino para adoptarlas. Adoptar los principios de la IA responsable (RAI) es la estrategia más eficaz para mitigar los riesgos asociados a la IA.

Por lo tanto, es hora de evaluar sus prácticas actuales y garantizar que los datos se utilicen de manera responsable y ética. La adopción temprana de RAI no sólo reducirá los riesgos asociados con las prácticas, sino que también posicionará a las organizaciones por delante de sus competidores, brindándoles una ventaja competitiva que puede ser difícil de superar en el futuro.

Según una encuesta del MIT Sloan, el 52% de las empresas están tomando medidas hacia prácticas responsables de IA. Sin embargo, más del 79% de estas empresas admiten que sus esfuerzos son limitados en cuanto a escala y alcance. El informe destaca la creciente importancia de que las empresas aborden los desafíos y prioricen la IA responsable (RAI), a medida que el papel de la IA en las empresas sigue aumentando. Para dar forma a un futuro sostenible y responsable impulsado por la IA, establecer un marco ético sólido no es sólo una opción, sino que es esencial.

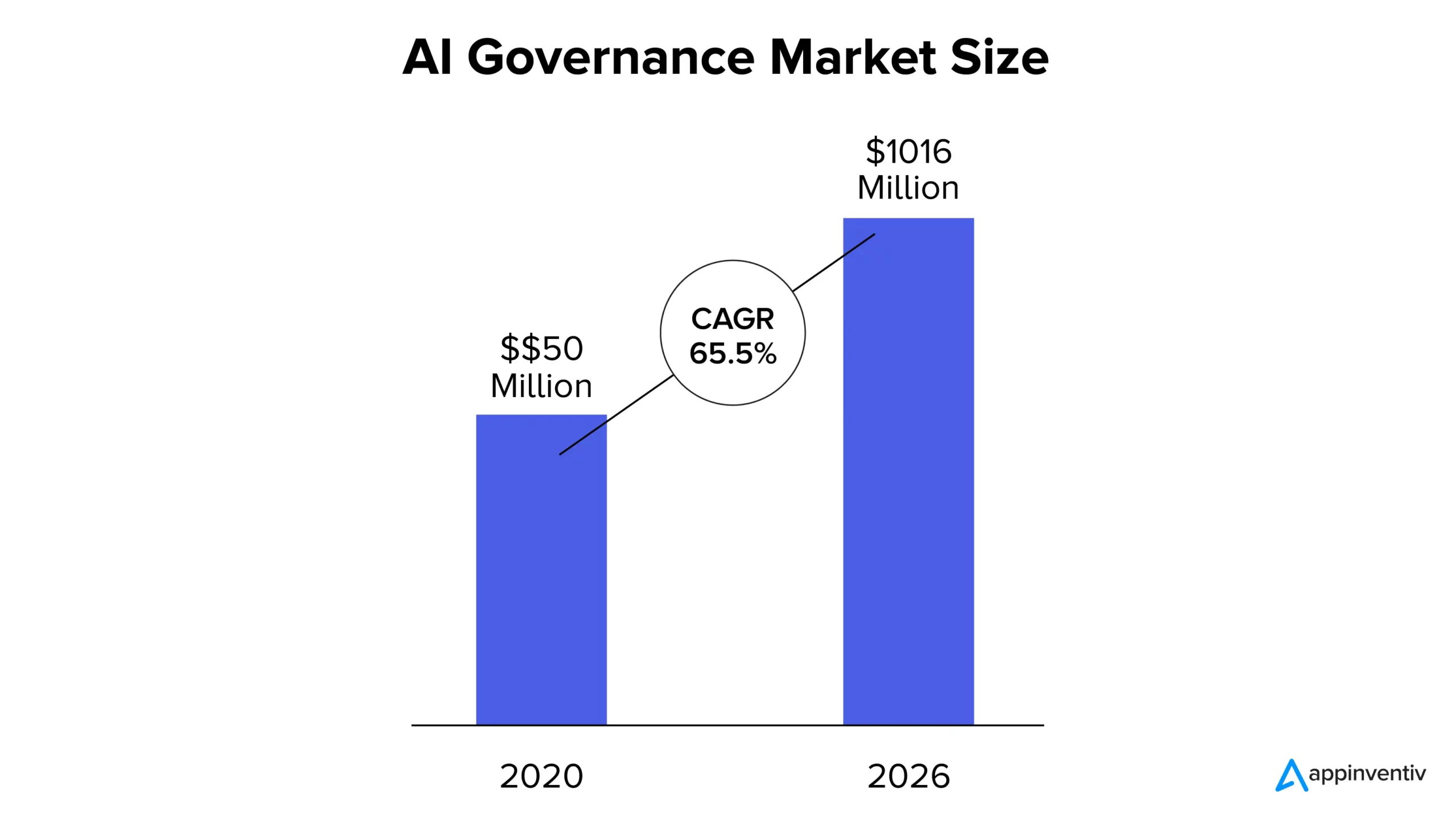

Ahora, según el informe MarketsandMarkets, el mercado de gobernanza de la IA estaba valorado en 50 millones de dólares en 2020 y se espera que alcance los 1.016 millones de dólares en 2026, con una tasa compuesta anual del 65,5%. La creciente participación de mercado se puede atribuir al creciente crecimiento de la transparencia en los sistemas de IA, el cumplimiento de las normativas y la creciente necesidad de confianza en las soluciones basadas en IA.

¿Qué son los principios de IA responsable?

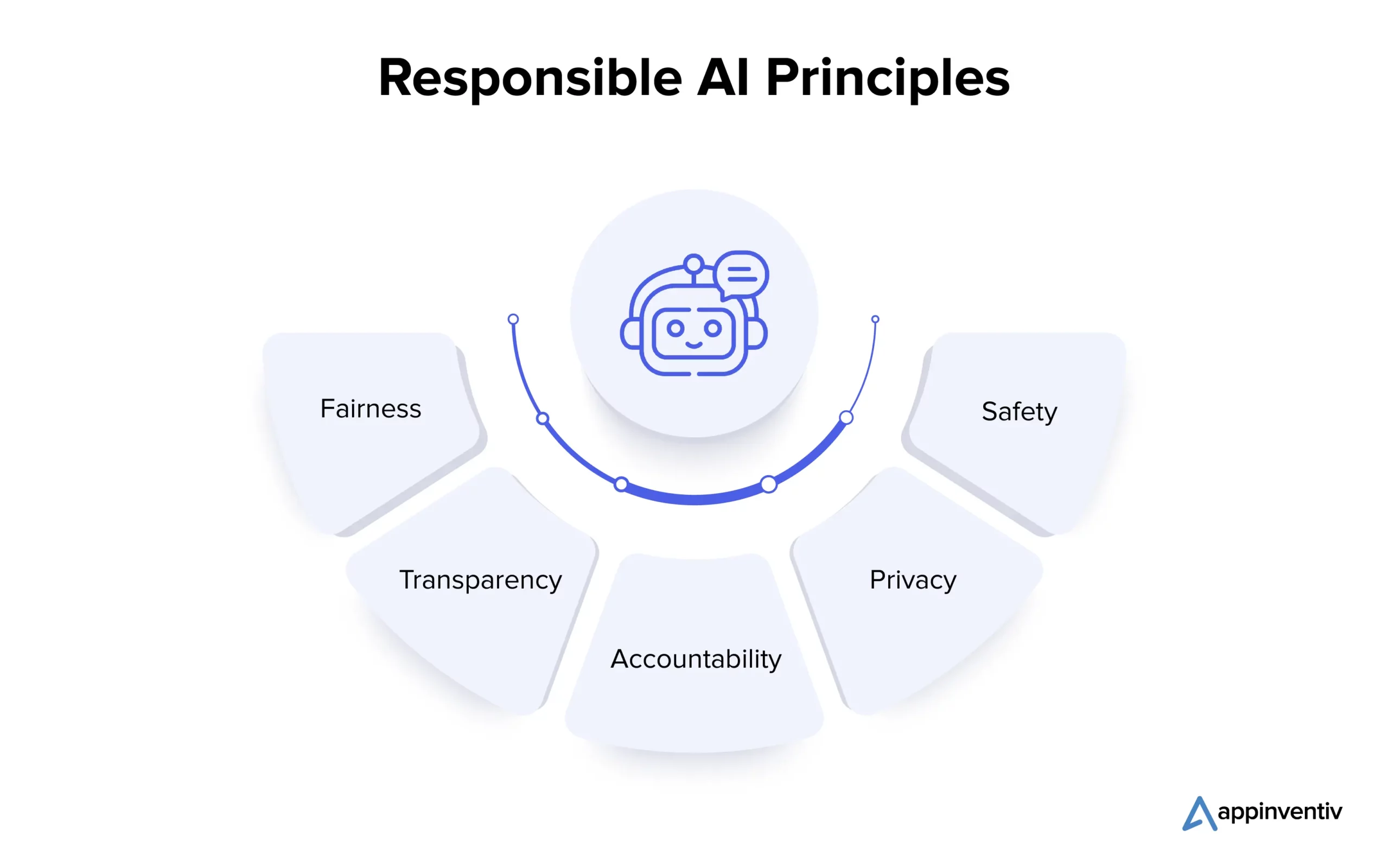

Comprender los principios básicos de la IA responsable es vital para las organizaciones que buscan navegar de forma ética en el complejo panorama de la IA. Veamos los múltiples principios en detalle a continuación:

1. Justicia

La equidad en la IA es un principio fundamental que aborda los sesgos en los sistemas de IA. Pueden ocurrir sesgos durante la creación del algoritmo o debido a datos de entrenamiento tergiversados. Los científicos de datos utilizan técnicas como el análisis de datos para detectar y corregir sesgos, asegurando que los sistemas de inteligencia artificial tomen decisiones imparciales y promuevan resultados igualitarios.

2. Transparencia

La transparencia en la IA implica documentar y explicar los pasos dados en su desarrollo e implementación, haciéndola comprensible para las partes interesadas. Técnicas como el aprendizaje automático interpretable revelan la lógica detrás de las decisiones de la IA, mientras que la supervisión humana garantiza la alineación y la justificabilidad éticas.

3. Responsabilidad

La rendición de cuentas está estrechamente vinculada a la transparencia y abarca el establecimiento de mecanismos para responsabilizar a los desarrolladores y usuarios de la IA por los resultados y los impactos de los sistemas de IA. Esto implica la implementación de lineamientos éticos, el uso de herramientas de monitoreo y la auditoría realizada. Estas medidas garantizan que los sistemas de IA brinden los resultados deseados, eviten daños no deseados y mantengan la confiabilidad.

4. Privacidad

La privacidad es crucial para salvaguardar la información personal de las personas. El ecosistema de IA implica obtener el consentimiento para la recopilación de datos, recopilar solo los datos necesarios y utilizarlos únicamente para los fines previstos. Se emplean técnicas de preservación de la privacidad, como la privacidad diferencial y las técnicas criptográficas, para proteger los datos personales durante el desarrollo y la producción del modelo de IA.

5. Seguridad

Los desarrolladores deben priorizar la seguridad en una IA responsable, incluido el bienestar físico y no físico. Para lograr esto, se deben integrar consideraciones de seguridad en cada etapa del desarrollo del sistema de IA. En la fase de diseño, es fundamental involucrar a diversas partes interesadas para identificar y comprender los riesgos potenciales. Las evaluaciones de riesgos, las pruebas en diferentes condiciones, la supervisión humana y el monitoreo y mejora continuos durante la producción son esenciales para prevenir daños y mantener la confiabilidad en los sistemas de IA.

Después de analizar los múltiples principios de la IA responsable, avancemos y comprendamos los desafíos asociados con la adopción de la solución.

¿Cuáles son los desafíos al adoptar soluciones de IA responsables?

La adopción de una IA responsable es un camino prometedor con grandes recompensas para las empresas, pero sus desafíos críticos exigen una consideración cuidadosa y soluciones proactivas. Veámoslos en detalle a continuación:

Explicabilidad y transparencia

Los sistemas de IA deben poder aclarar cómo y por qué producen resultados específicos para mantener la confianza. La falta de transparencia puede reducir la confianza en estos sistemas.

Seguridad personal y pública

Los sistemas autónomos, como los coches y robots autónomos, pueden suponer riesgos para la seguridad humana. Garantizar el bienestar humano en tales contextos es crucial.

Automatización y Control Humano

Si bien la IA puede mejorar la productividad, puede reducir la participación y la experiencia humana. Lograr un equilibrio para garantizar el control y la supervisión humanos es un desafío.

Sesgo y discriminación

Aunque los sistemas de IA están diseñados para ser neutrales, aún pueden heredar sesgos de los datos de entrenamiento, lo que podría conducir a una discriminación no intencionada. Prevenir tales sesgos es vital.

Responsabilidad y regulación

Con el crecimiento de la presencia general de IA, pueden surgir cuestiones de responsabilidad. Determinar quién es responsable del uso y mal uso del sistema de IA es complejo.

Seguridad y privacidad

La IA requiere un amplio acceso a los datos, lo que puede generar aún más preocupaciones sobre la privacidad de los datos y las violaciones de seguridad. Proteger los datos utilizados para la formación en IA es esencial para proteger la privacidad general de un individuo.

Ahora, asociarse con una empresa de desarrollo de aplicaciones de IA de buena reputación (como Appinventiv) que se adhiera a los principios de IA responsable durante el proceso de desarrollo puede ayudar a las empresas a mitigar de manera efectiva los desafíos y riesgos asociados.

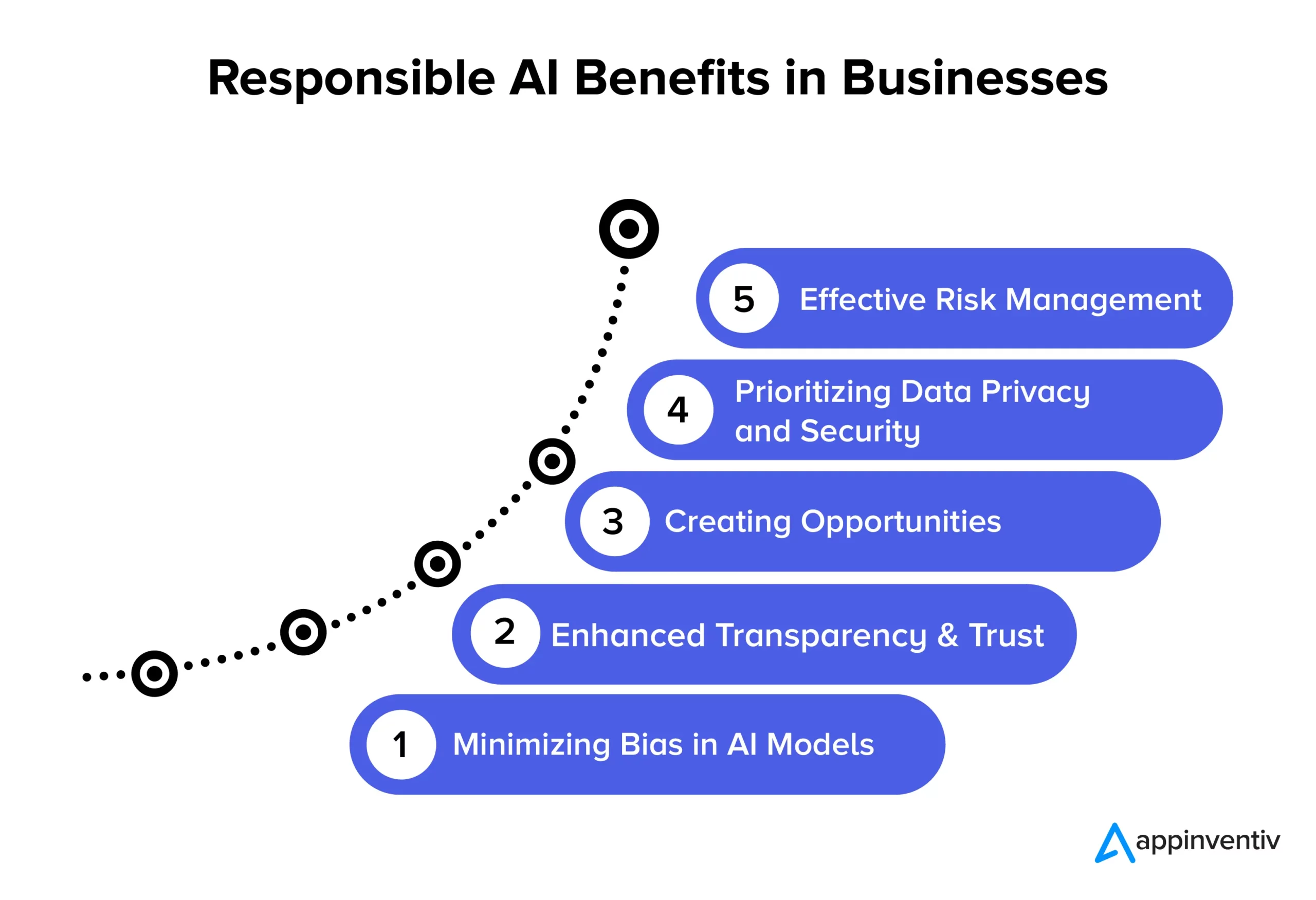

Beneficios de la IA responsable para las empresas

La adopción de principios de IA responsable allana el camino para múltiples ventajas significativas para las empresas y la sociedad. Explorémoslos en detalle a continuación:

Minimizar el sesgo en los modelos de IA

Al adherirse a los principios de la IA responsable, las empresas pueden reducir eficazmente los sesgos en sus modelos de IA y los datos subyacentes utilizados para entrenarlos. Esta reducción del sesgo garantiza que los sistemas de IA proporcionen resultados más precisos y justos, que sean éticamente correctos y reduzcan el riesgo de cambios en los datos con el tiempo. Además, minimizar el sesgo ayuda a las organizaciones a evitar posibles daños a los usuarios que puedan surgir de resultados sesgados del modelo de IA, mejorando su reputación y reduciendo la responsabilidad.

Mayor transparencia y confianza

Las prácticas responsables de IA mejoran la claridad y transparencia de los modelos de IA. Esto ayuda a fortalecer la confianza entre las empresas y sus clientes. Además, la IA se vuelve más disponible y comprensible para un público más amplio, lo que beneficia a las organizaciones y a los usuarios finales al permitir una gama más amplia de aplicaciones y mejorar la utilización efectiva de las tecnologías de IA.

Creando oportunidades

Adherirse a los principios de la IA responsable permite a los desarrolladores y usuarios mantener conversaciones abiertas sobre los sistemas de IA. Es uno de los beneficios de la IA responsable más buscados en las empresas. Crea un espacio donde las personas pueden expresar sus preguntas y preocupaciones sobre la tecnología de inteligencia artificial, lo que permite a las empresas abordar estos problemas de manera proactiva. Este enfoque colaborativo para el desarrollo de la IA da como resultado la creación de soluciones de IA éticamente sólidas y socialmente responsables, que pueden impulsar la reputación y la competitividad de una empresa.

Priorizar la privacidad y la seguridad de los datos

Las soluciones de IA responsables permiten a las empresas centrarse significativamente en proteger la privacidad y la seguridad de los datos. Esto significa que los datos personales o sensibles se manejan con cuidado, salvaguardando los derechos de las personas y evitando violaciones de datos. Cuando las empresas siguen los principios de la IA responsable, reducen las posibilidades de hacer un uso indebido de los datos, violar las regulaciones y dañar su reputación. Es una forma inteligente de mantener los datos seguros y mantener la confianza del cliente.

Gestión eficaz de riesgos

Las prácticas responsables de IA establecen reglas éticas y legales claras para los sistemas de IA, lo que ayuda a reducir las posibilidades de resultados dañinos. Esta reducción de riesgos beneficia a múltiples entidades, como empresas, empleados y la sociedad. Las organizaciones pueden evitar costosas demandas y dañar su reputación al abordar posibles problemas éticos y legales.

Ejemplos de implementación exitosa de IA responsable

A continuación se muestran algunos ejemplos notables del mundo real de organizaciones que están priorizando prácticas de IA éticas e imparciales:

La confiable herramienta de reclutamiento de IA de IBM

Una importante corporación estadounidense colaboró con IBM para automatizar los procesos de contratación y priorizar la equidad en los procesos de contratación impulsados por IA. Su objetivo era facilitar la diversidad y la inclusión manteniendo intacta la integridad de sus modelos de aprendizaje automático. Al utilizar IBM Watson Studio, una herramienta de gestión y monitoreo de IA, identificaron y abordaron con éxito el sesgo de contratación y al mismo tiempo obtuvieron información valiosa sobre la toma de decisiones de IA.

Marco de IA responsable de State Farm

State Farm, una de las principales compañías de seguros de EE. UU., incorporó la IA en su proceso de gestión de reclamaciones e implementó una estrategia de IA responsable. Crearon un sistema de gobernanza para asignar responsabilidades a la IA, lo que resultó en una toma de decisiones más rápida e informada. El modelo de IA del Modelo dinámico de evaluación de vehículos (DVAM) de State Farm predice eficazmente las pérdidas totales y aporta transparencia al procesamiento de reclamaciones de seguros.

Lista de control y equipo de IA responsable del grupo H&M

H&M Group, un minorista de moda global, ha integrado la IA en sus operaciones para impulsar la sostenibilidad, optimizar las cadenas de suministro y mejorar las experiencias personalizadas de los clientes. La empresa estableció un equipo de IA responsable dedicado en 2018 para garantizar el uso responsable de la IA. Este equipo desarrolló una lista de verificación práctica que identifica y mitiga los posibles daños relacionados con la IA y se adhiere incondicionalmente a los principios de IA responsable.

La equidad de Google en el aprendizaje automático

Google también ha trabajado activamente para incluir medidas de equidad en la inteligencia artificial y el aprendizaje automático. Han desarrollado herramientas y recursos para ayudar a los desarrolladores a identificar y mitigar los sesgos en sus modelos de aprendizaje automático.

GPT-3 de OpenAI

OpenAI, la empresa detrás de GPT-3, también ha sido un líder clave en la adopción de un enfoque responsable para la implementación de la IA. Han implementado mecanismos de ajuste para evitar resultados dañinos y sesgados que demuestran aún más su compromiso con la IA ética, incluso en modelos avanzados de PNL.

El futuro de la IA responsable con Appinventiv

El futuro de la IA responsable es un viaje continuo, con organizaciones en distintas etapas de desarrollo ético con respecto a la tecnología y el uso de datos. Es un campo dinámico enfocado en establecer pautas estandarizadas para diversas industrias. Para navegar por los principios de IA responsable para su empresa, asociarse con Appinventiv es la mejor elección que puede tomar una empresa. Podemos ayudarlo a crear soluciones de IA éticas, imparciales y precisas adaptadas a sus necesidades.

Al ser una empresa dedicada al desarrollo de IA, nuestros desarrolladores tienen años de experiencia en el desarrollo de soluciones de IA, priorizando la ética y la responsabilidad. Con un historial comprobado de proyectos exitosos de IA que abarcan numerosos dominios industriales, entendemos la importancia de alinear las soluciones de IA con los valores fundamentales y los principios éticos requeridos. Podemos ayudarlo a implementar medidas de equidad para garantizar que sus soluciones comerciales basadas en IA tomen decisiones imparciales.

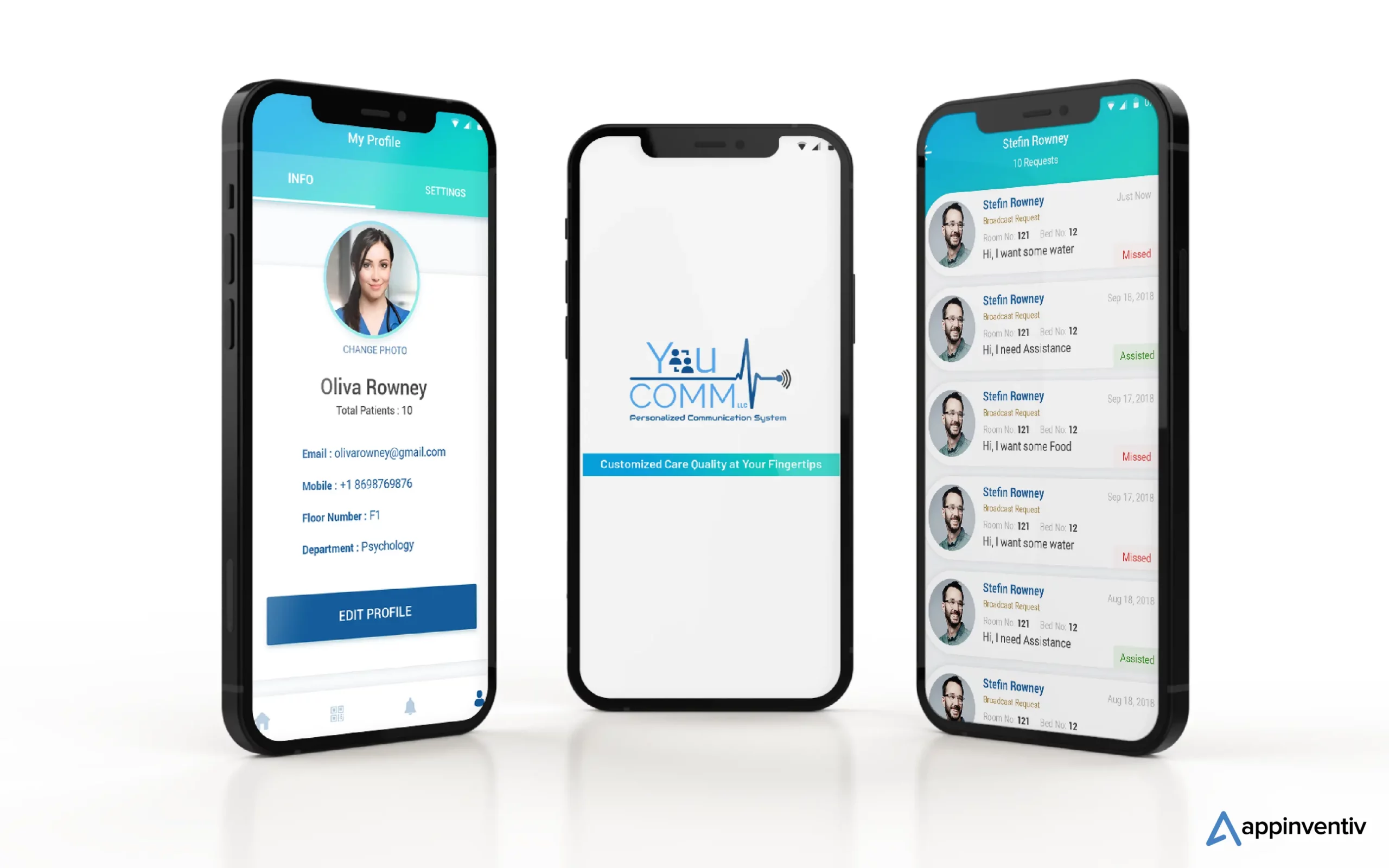

Recientemente desarrollamos YouComm, una aplicación de atención médica basada en inteligencia artificial que conecta a los pacientes con las enfermeras del hospital mediante gestos con las manos y comandos de voz. La solución ahora se implementa en más de cinco cadenas de hospitales en los EE. UU.

Póngase en contacto con nuestros expertos en IA para crear soluciones de IA que brinden resultados precisos y cumplan con estándares éticos.

Preguntas frecuentes

P. ¿Cuáles son algunos ejemplos de IA responsable?

R. A continuación se muestran algunos ejemplos de IA responsable en múltiples dominios industriales:

- Algoritmos justos: sistemas de IA diseñados para ser justos, reduciendo los sesgos de decisión.

- IA explicable (XAI): hacer que las decisiones de IA sean comprensibles.

- Mitigación de sesgos: monitorear y reducir continuamente los sesgos en la IA.

- Comités de ética de la IA: establecimiento de juntas de revisión interna para la IA ética.

- IA que preserva la privacidad: protege los datos confidenciales mientras los usas para la IA.

- Informes de transparencia: compartir cómo funcionan los sistemas de IA y toman decisiones.

- Educación en IA responsable: Capacitar a los profesionales de la IA en ética y responsabilidad.

P. ¿Cuáles son algunos casos de uso exitosos de IA responsable?

R. A continuación se muestran algunos casos de uso exitosos de IA responsable:

- Diagnóstico sanitario: se utiliza para mejorar los resultados médicos con equidad y privacidad del paciente.

- Servicios Financieros: Es capaz de eliminar los riesgos asociados al fraude y al malware. Las soluciones responsables basadas en inteligencia artificial pueden salvaguardar aún más los datos de los clientes y garantizar préstamos equitativos.

- Reclutamiento: ayuda a reducir los prejuicios y allana el camino para la adopción de la diversidad y la igualdad de oportunidades entre los usuarios.

- Vehículos Autónomos: Ayuda a priorizar la seguridad y cumplir con estándares éticos.

P. ¿Es la IA responsable un proceso continuo o las empresas pueden implementarla una vez y olvidarse de ella?

R. La IA responsable es un proceso continuo que requiere monitoreo, actualización y adaptación continuos a estándares y regulaciones éticas cambiantes. Por lo tanto, es recomendable asociarse con una empresa dedicada al desarrollo de IA que pueda ayudarlo a atravesar las aguas con cuidado.