¿Qué es el SEO técnico?

Publicado: 2023-09-01Cuando comiences a aprender SEO, pronto te darás cuenta de que hay muchas facetas diferentes que debes comprender para tener éxito.

Del SEO on-page al SEO on-page y creación de contenidos. Debe tener una comprensión firme de todo, sin importar su función específica dentro del SEO, para que su sitio web se clasifique donde debe estar.

En este artículo, exploraremos el SEO técnico. Aprenderá exactamente qué es, por qué es importante para los sitios web y las características de un sitio web que está bien optimizado desde un punto de vista técnico.

También le brindaremos información detallada sobre cómo funciona el SEO técnico, desde el rastreo y la indexación hasta la clasificación, y lo que necesita para que estos tres pasos funcionen bien en conjunto.

Crédito de la imagen: https://tsh.io/

¿Qué es el SEO técnico?

El SEO técnico es el proceso de optimizar los elementos "detrás de escena" de un sitio web para mejorar su rendimiento en motores de búsqueda como Google y Bing. Este proceso incluye pasos como mejorar el marcado y la estructura del sitio web para garantizar un fácil rastreo, indexación y clasificación (hablaremos más sobre esto más adelante) por parte de robots de motores de búsqueda como Googlebot. Las tareas abarcan refinar la velocidad del sitio web, crear una arquitectura de sitio simple y fácil de entender, usar URL "compatibles con SEO" y aplicar marcado de esquema para resultados de búsqueda enriquecidos.

Básicamente, el SEO técnico crea una base sólida que ayuda a los motores de búsqueda en el proceso de elevar la clasificación de un sitio web. En última instancia, esto conducirá a un mayor tráfico orgánico y una mejor experiencia de usuario.

Piense en su sitio web como una biblioteca bien organizada. El SEO técnico es el paso de colocar libros en estanterías ordenadas con etiquetas claras (su estructura de URL), configurar señales para una navegación fluida (sus enlaces internos) y crear un ambiente acogedor (velocidad del sitio). Cuando la biblioteca está ordenada y es acogedora, más visitantes pueden localizar los libros que necesitan (los usuarios descubren el contenido) y los bibliotecarios (robots de los motores de búsqueda) pueden categorizar y sugerir libros (indexación y clasificación).

¿Por qué es importante el SEO técnico?

El SEO técnico es increíblemente importante para la gran mayoría de los sitios web, ya que constituye la base de la visibilidad del sitio web en los motores de búsqueda y del rendimiento general. Por supuesto, el contenido que usted publica es crucial, pero la falta de una optimización técnica adecuada podría impedir que los motores de búsqueda descubran, indexen y clasifiquen ese contenido de manera efectiva.

La importancia del SEO técnico se puede resumir de la siguiente manera:

En primer lugar, garantiza que los motores de búsqueda puedan rastrear e indexar su contenido de forma eficaz. Al optimizar elementos como la estructura y la navegación de su sitio web, el SEO técnico facilita el rastreo fluido de su sitio web por parte de los robots de los motores de búsqueda. Esta accesibilidad es vital para garantizar que su contenido sea notado e indexado adecuadamente.

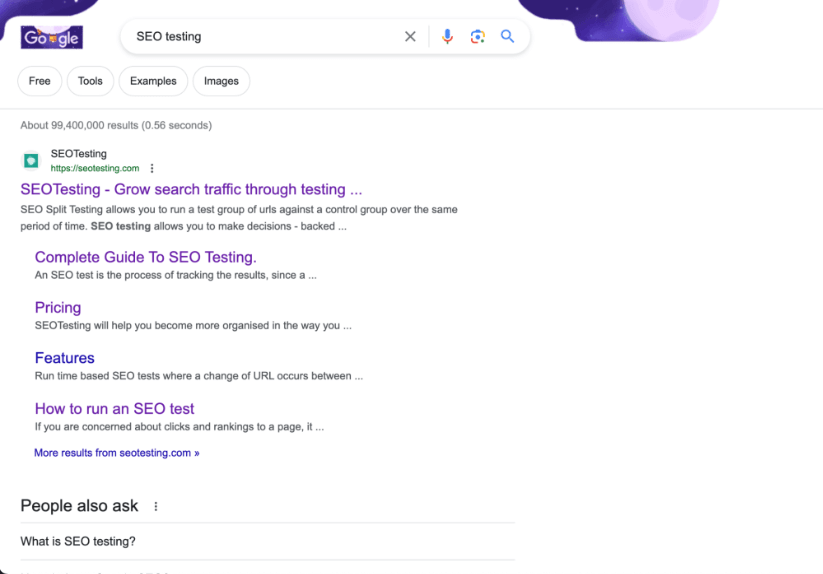

Puede que seamos un poco parciales, pero creemos que nuestro sitio web es un gran ejemplo de un sitio que tiene una excelente arquitectura.

En segundo lugar, el SEO técnico influye directamente en su clasificación en los motores de búsqueda. La velocidad del sitio web y la capacidad de respuesta móvil son factores de clasificación confirmados dentro del algoritmo de búsqueda de Google y, más allá de eso, tener un marcado HTML bien estructurado juega un papel vital en la forma en que los motores de búsqueda evalúan la calidad y relevancia de su sitio web. Es más probable que un sitio web bien optimizado tenga una clasificación más alta en los motores de búsqueda.

Finalmente, el SEO técnico contribuye a que tu sitio web tenga una gran experiencia de usuario. Mientras trabaja en su SEO técnico, prácticas como optimizar los tiempos de carga de la página y mejorar las URL también mejorarán la satisfacción del usuario. Una experiencia de usuario mejorada conduce a tasas de rebote reducidas y mayores tasas de participación, lo que mejorará indirectamente el rendimiento de su sitio web en la búsqueda.

En última instancia, el SEO técnico sirve como la piedra angular sobre la que se construyen estrategias de SEO efectivas. Esto garantiza que su contenido no sólo sea de primera categoría, sino que también sea reconocible y accesible. Esto atraerá tanto a los motores de búsqueda como, lo que es más importante, a los usuarios.

¿Cuáles son las características de un sitio web técnicamente optimizado?

No importa el sitio web, ya sea un sitio web de comercio electrónico que genera millones de libras en ingresos o un sitio web con folletos que muestra los servicios de una empresa de plomería local, todos los sitios web tienen las mismas características cuando se trata de estar bien optimizados desde un punto de vista técnico de SEO. .

Es rápido

Un sitio web bien optimizado se cargará rápidamente en todos los dispositivos (computadoras de escritorio, tabletas y dispositivos móviles) y condiciones de red. Las páginas de carga rápida mejoran la experiencia que tiene un usuario en su sitio web y son favorecidas por los motores de búsqueda, lo que potencialmente conduce a clasificaciones más altas.

Sabemos que Google incluye la aprobación de las pruebas principales de Web Vitals como un factor de clasificación confirmado, lo cual es poco común en ellos, por lo que es crucial asegurarse de que su sitio web sea rápido y pase las pruebas CWV.

Es rastreable

Esto debería ser una obviedad, pero los motores de búsqueda deberían poder rastrear los sitios web. Si un robot de motor de búsqueda (como Googlebot) no puede rastrear su sitio web de manera efectiva, encontrará problemas con la clasificación de su página en las SERP.

Los archivos Robots.txt y las metaetiquetas de robots deben configurarse correctamente. Esto ayudará a guiar a los robots de los motores de búsqueda sobre qué páginas rastrear e indexar, y qué páginas dejar en paz. No se deben rastrear todas las páginas de su sitio web. Especialmente páginas de administración y páginas que contienen datos de clientes.

Preserva la equidad del enlace

Los sitios web que están bien optimizados técnicamente hacen todo lo posible para preservar la mayor equidad de enlaces posible.

En primer lugar, el sitio web utilizará enlaces internos que guían a los usuarios (y a los robots de los motores de búsqueda) a contenido relevante dentro del sitio. Esto mejora la navegación del sitio web, ayuda a distribuir la equidad de los enlaces a otras páginas y mantiene a los usuarios en el sitio web por más tiempo.

En segundo lugar, el sitio web estará completamente libre (idealmente) de enlaces rotos y cadenas de redireccionamiento innecesarias. Esto garantiza una experiencia de usuario perfecta y un rastreo eficiente por parte de los motores de búsqueda.

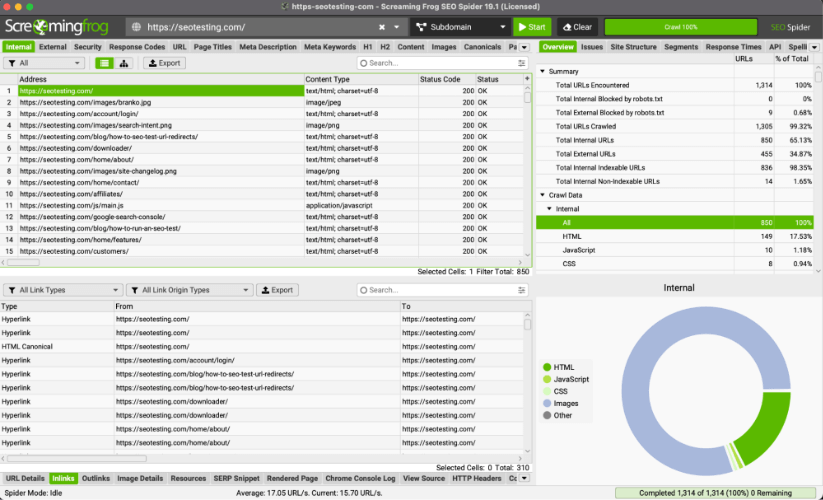

Consejo profesional: puedes utilizar ScreamingFrog para identificar enlaces rotos y redirigir cadenas que no necesitan estar ahí.

Es compatible con dispositivos móviles

Todos los sitios web deben estar diseñados para ser responsivos y funcionales en dispositivos móviles. Con el uso cada vez mayor de teléfonos inteligentes para navegar (a partir de 2023, el 63% del tráfico de búsqueda orgánica de Google en EE. UU. se origina en dispositivos móviles), la compatibilidad con dispositivos móviles es un factor crucial tanto en la experiencia del usuario como en las clasificaciones.

es seguro

Todos los sitios web deben asegurarse de que utilicen el protocolo HTTPS seguro.

Lo que esto hace es garantizar que su sitio web cuente con un cifrado de datos adecuado y aumentará la confianza que los usuarios tienen cuando utilizan su sitio web. Esta confianza es especialmente importante cuando se entregan datos financieros en sitios web, como información de tarjetas de crédito.

Google también ha confirmado que el uso del protocolo HTTPS es un factor de clasificación. No sabemos qué peso le da el algoritmo a esto, pero podemos suponer que esto es más un factor cuando se trata de sitios web YMYL (Your Money Your Life).

Utiliza datos estructurados

El marcado de esquema se implementa en los sitios web para proporcionar contexto adicional sobre el contenido. Esto permitirá a los motores de búsqueda mostrar fragmentos enriquecidos dentro de las SERP cuando muestren su sitio web, mejorando las tasas de clics y atrayendo más tráfico a su sitio.

Arrastrándose

Cubrimos este tema brevemente en nuestro artículo sobre cómo aprender SEO en 2023, pero ahora repasaremos las cuatro etapas dentro del SEO técnico que llevan su sitio web desde páginas HTML, CSS y JavaScript hasta clasificaciones en SERP. Rastreo, renderizado, indexación y clasificación.

El primer paso en este viaje es gatear.

El rastreo se refiere al proceso mediante el cual los motores de búsqueda como Google y Bing navegan sistemáticamente y aprenden más sobre el contenido de los sitios web en Internet. El objetivo del rastreo es recopilar información sobre páginas web, esto incluye:

- Su contenido.

- Su estructura.

- Otra información relevante.

Luego, los motores de búsqueda pueden usar estos datos para indexar y clasificar de manera efectiva (hablaremos de esto más adelante) y mostrar sus páginas web dentro de las SERP.

Los motores de búsqueda utilizan robots, llamados rastreadores, para navegar a través de la gran cantidad de páginas web en línea. Los rastreadores comienzan visitando algunas páginas web conocidas, a menudo páginas populares o que se actualizan con frecuencia. A partir de ahí, siguen los enlaces que se encuentran en estas páginas para "descubrir" nuevas páginas que luego pueden representar, indexar y clasificar.

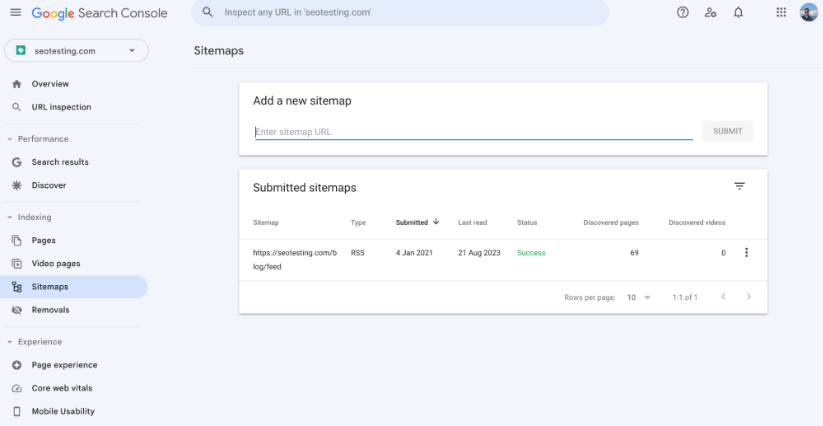

Mapa del sitio XML

Un mapa de sitio XML es un archivo que proporciona a los motores de búsqueda una lista estructurada de todas las URL de su sitio web. Es una herramienta que ayuda a los rastreadores de los motores de búsqueda a comprender la organización del contenido de su sitio web y garantiza que puedan descubrir e indexar todas sus páginas importantes de manera efectiva.

Asegurarse de tener un mapa del sitio XML en su sitio web es esencial cuando se trata de SEO técnico, ya que ayuda a rastrear sus páginas de varias maneras diferentes:

Tener un mapa del sitio XML en su sitio proporciona a los robots de los motores de búsqueda una lista centralizada de URL que le gustaría que rastreen e indexen. Esto le ayudará a garantizar que todas sus páginas esenciales, como las páginas de listado de productos y las páginas de visualización de productos, estén incluidas en los índices de los motores de búsqueda y, con suerte, en las páginas de resultados de los motores de búsqueda.

También puede utilizar su mapa de sitio para especificar la prioridad y cambiar la frecuencia de cada URL en su sitio. Es importante tener en cuenta que es posible que los motores de búsqueda no sigan estas reglas exactamente, pero hacerlo puede dar a los rastreadores una idea de la importancia de las diferentes páginas de su sitio web y con qué frecuencia se actualizan.

Si bien los motores de búsqueda utilizan varios factores para decidir qué páginas rastrear e indexar primero, su mapa de sitio puede ayudar a resaltar páginas importantes (o recientemente actualizadas). Esto puede guiar a los robots de los motores de búsqueda a estas páginas y puede ayudar a rastrearlas e indexarlas rápidamente. Si no tuviera un mapa del sitio, dependería de los rastreadores para encontrar estas páginas automáticamente, mediante el uso de enlaces internos y externos, etc., lo cual es un proceso mucho más largo.

Los sitios grandes, con cientos de miles (o incluso millones de URL), mapas de sitio (y múltiples mapas de sitio) ayudarán a los rastreadores a descubrir cada página que desee indexar de manera más eficiente. Esto es excelente, ya que le ayuda a administrar su presupuesto de rastreo de manera mucho más eficiente. Esto no es un problema para los sitios web más pequeños, ya que estos sitios pequeños no tendrán problemas con su presupuesto de rastreo.

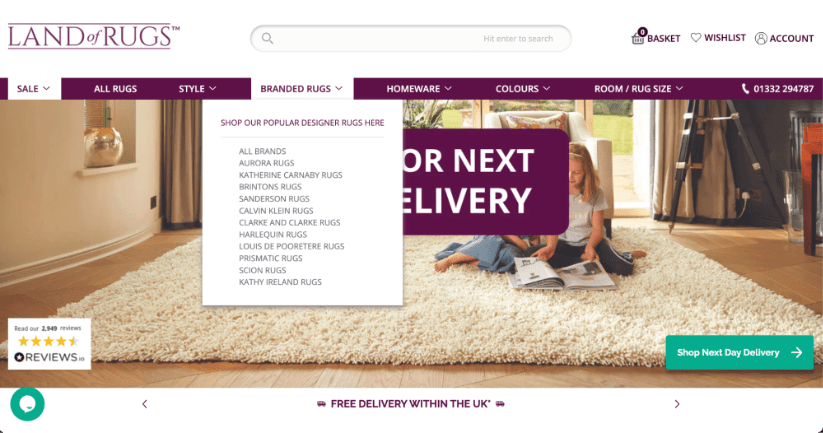

Estructura del sitio

La estructura de su sitio web desempeñará un papel crucial a la hora de determinar cómo los robots de los motores de búsqueda navegan e indexan su contenido. Una estructura de sitio bien organizada no sólo facilitará el rastreo eficiente por parte de los robots de los motores de búsqueda, sino que también mejorará la experiencia general que los usuarios reales tienen en su sitio web.

A continuación se muestra un ejemplo de un sitio web de comercio electrónico con una buena estructura. Se puede acceder fácilmente a todas las páginas importantes (páginas de listado de productos) en este ejemplo desde la barra de navegación de la página de inicio, lo que transmite la mayor equidad de enlaces posible a estas páginas y garantiza que los rastreadores puedan encontrarlas fácilmente.

Cuando las páginas se organizan en categorías y subcategorías simples y fáciles de entender, resulta mucho más fácil para los rastreadores seguir enlaces e indexar contenido sistemáticamente. Esta disposición jerárquica garantiza que las páginas cruciales estén más cerca de la página de inicio, lo que aumenta sus posibilidades de ser descubiertas e indexadas rápidamente.

Los enlaces internos dentro de la estructura de un sitio web guiarán a los rastreadores de los motores de búsqueda a través de diferentes secciones de su sitio de manera más efectiva. Los enlaces internos relevantes y bien ubicados ayudan a distribuir la equidad de los enlaces entre las páginas, lo que permite a los rastreadores descubrir una gama mucho más amplia de contenido de lo que podrían hacerlo sin que se colocaran enlaces internos en todo el contenido.

Se deben evitar las páginas huérfanas (páginas sin enlaces que apunten a ellas), ya que presentan un gran desafío para los rastreadores. Una estructura de sitio sólida, con enlaces internos adecuados, evita esto.

En general, la estructura de su sitio web servirá como un marco crucial que dará forma a la forma en que los motores de búsqueda rastrean e indexan su contenido. Al implementar una jerarquía de sitios clara, agregar enlaces contextuales relevantes y optimizar la asignación del presupuesto de rastreo (si es necesario), los propietarios de sitios web y los especialistas en marketing pueden influir positivamente en la forma en que los motores de búsqueda rastrean sus sitios web.

Estructura de URL

La estructura de URL de su sitio web tendrá un impacto directo en el rastreo de su sitio web. Asegurarse de tener una estructura de URL bien organizada (y descriptiva) mejorará la eficiencia de los rastreadores a la hora de comprender el contenido de cada página. Las URL claras (y cortas) brindan un contexto valioso sobre el tema y la jerarquía de la ubicación de la página dentro del sitio web.

Por ejemplo, una URL parecida a: https://example.com/blog/head-topic-1 le indicará al rastreador de un motor de búsqueda que esta página es una página esencial dentro del blog, sobre uno de los temas clave del sitio web.

Por otro lado, las URL que son complicadas o sin sentido (un buen ejemplo es https://example.com/12642/test-category/test-page125253/) pueden confundir a los rastreadores cuando navegan por su sitio web. Esto obstaculizará su capacidad para interpretar el contenido, así como la relevancia e importancia de la página dentro de su sitio web. Una estructura de URL limpia, sin parámetros ni símbolos innecesarios, aumentará las posibilidades de que sus páginas se rastreen de forma eficaz.

Además, aunque no está directamente relacionado con el rastreo, la estructura de su URL tendrá un impacto directo en la experiencia del usuario de su sitio web y en las tasas de clics. Es mucho más probable que una URL concisa y relevante atraiga clics de los usuarios en los resultados de búsqueda, lo que puede afectar (indirectamente) la clasificación general de su sitio web en los motores de búsqueda.

Archivos Robots.txt

Su archivo robots.txt tiene un enorme poder sobre cómo los motores de búsqueda navegan y rastrean su sitio web. Este documento, situado en el centro de su sitio, detalla las pautas para los rastreadores de motores de búsqueda y dicta cómo se debe rastrear su sitio web. Incluyendo qué páginas se pueden rastrear y qué páginas se deben dejar en paz.

Vale la pena señalar en esta etapa que, si bien su archivo robots.txt puede detener la entrada de los rastreadores a páginas o secciones específicas de su sitio web, no garantiza que sus páginas no serán rastreadas por vías alternativas. Algunos motores de búsqueda aún pueden registrar páginas que están excluidas del rastreo si se encuentran a través de otras formas, por ejemplo, enlaces internos en su sitio.

Si su archivo robots.txt está plagado de errores o reglas rígidas, es posible que esto impida que los motores de búsqueda rastreen contenido importante, lo que puede "proyectar una sombra" en el rendimiento de su sitio web en las SERP. Es importante vigilar periódicamente su archivo robots.txt para asegurarse de que todas las reglas funcionen correctamente.

Análisis de archivos de registro

Analizar los archivos de registro de su sitio web puede tener un gran impacto en la forma en que los motores de búsqueda rastrean su sitio web, ¡y esto es algo que los especialistas en marketing pueden hacer ellos mismos con las herramientas adecuadas! Los archivos de registro son, esencialmente, registros que muestran qué partes de su sitio web visitan los motores de búsqueda y con qué frecuencia los rastreadores de los motores de búsqueda visitan estas partes de su sitio web. Básicamente, esto le permite determinar qué páginas de su sitio web son consideradas importantes por los motores de búsqueda, lo que le permite utilizar esto para obtener una ventaja.

Esto ayuda a los especialistas en marketing a decidir en qué páginas vale la pena dedicar más tiempo (y potencialmente dinero), asegurándose de que los motores de búsqueda presten atención a lo correcto. Además, el análisis de archivos de registro puede mostrar si los motores de búsqueda encuentran que su sitio web es fácil de entender y navegar, o si tienen problemas. Esto puede guiar cambios, como arreglar cómo se conectan las páginas (a través de enlaces internos, generalmente) u organizar mejor las direcciones web.

Una de mis charlas favoritas sobre esto es la de Matthew Barby, de 2018, cuando era vicepresidente de crecimiento orgánico en HubSpot. Encuentre el segmento exacto de la charla en el minuto 25:07:

Representación

El renderizado se refiere al proceso mediante el cual los motores de búsqueda analizan y comprenden el contenido y la estructura de su sitio web, para determinar su clasificación en las SERP. Este proceso implica dos pasos principales, rastreo (que hemos cubierto) e indexación (del que hablaremos pronto).

Durante el rastreo, los robots de los motores de búsqueda atraviesan la web, visitan páginas web y recopilan datos HTML. Sin embargo, no todo el contenido es visible inmediatamente en el formato HTML. Aquí es donde entra en juego el renderizado.

El renderizado va más allá del análisis HTML básico, teniendo en cuenta los elementos dinámicos que a menudo aparecen en los sitios web modernos y que pueden no ser visibles en el HTML sin formato. Esto incluye contenido cargado a través de JavaScript, AJAX u otros lenguajes de programación, así como la hoja de estilo CSS de la página. Los robots de los motores de búsqueda, en su intento de simular la experiencia del usuario, ejecutan JavaScript y recopilan el contenido completamente renderizado. Este contenido luego se utiliza para crear un índice, una base de datos de información sobre la página web.

Para obtener resultados óptimos de SEO, es fundamental asegurarse de que los robots de los motores de búsqueda puedan reproducir fácilmente su sitio web. Esto implica el uso de técnicas como la renderización del lado del servidor (SSR) o la renderización previa para sitios web con mucho JavaScript. Proporcionar metadatos (como metaetiquetas y descripciones) ayudará a los motores de búsqueda a comprender el contexto y el significado del contenido. El manejo adecuado de las etiquetas canónicas y las redirecciones también es importante para evitar problemas de contenido duplicado.

Indexación

La indexación se refiere al proceso de recopilar, organizar y almacenar información sobre páginas web para que puedan recuperarse rápidamente y mostrarse en los resultados de búsqueda cuando un usuario realiza una consulta relevante. Una vez que un rastreador web ha rastreado una página web y ha mostrado su contenido, la información se agrega al índice del motor de búsqueda.

El índice, esencialmente, es una enorme base de datos que contiene información sobre el contenido del sitio web y la estructura de las páginas web en Internet. Tener acceso a esta amplia base de datos de información permite a los motores de búsqueda responder rápidamente a las consultas de los usuarios encontrando páginas relevantes en el índice y mostrándolas en las SERP.

Durante el proceso de indexación, los motores de búsqueda extraen información clave de las páginas web rastreadas y representadas, como contenido, metadatos, imágenes y enlaces. Luego, esta información se almacena de manera estructurada, lo que permite a los motores de búsqueda relacionar rápidamente las consultas de los usuarios con páginas relevantes.

Hay algunas cosas que debería intentar hacer para ayudar a que sus páginas se indexen de manera eficiente.

Abordar problemas de canibalización de palabras clave y contenido duplicado

Abordar los problemas de contenido duplicado y canibalización de palabras clave ofrecerá importantes beneficios a la hora de indexar sus páginas rápidamente.

Al deshacerse del contenido duplicado, evita cualquier confusión para los motores de búsqueda, permitiéndole identificar con precisión la versión principal de su contenido.

Es más, resolver los problemas de canibalización de palabras clave (donde varias páginas apuntan a las mismas palabras clave) proporciona señales claras a los motores de búsqueda sobre el enfoque de cada página. Esta claridad ayuda a una indexación y clasificación eficientes, ya que los motores de búsqueda pueden comprender el propósito exacto de todas sus páginas.

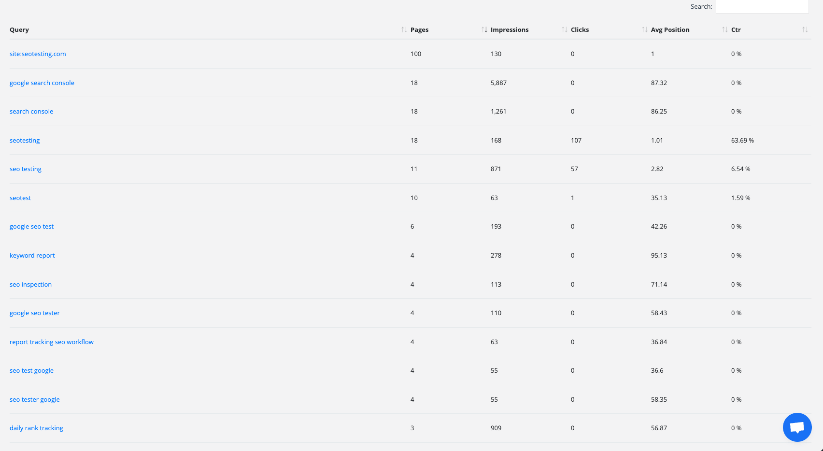

Una imagen que muestra el Informe de canibalización de palabras clave dentro de SEOTesting. Este informe puede ayudarle a identificar y solucionar rápidamente cualquier problema de canibalización de palabras clave en su sitio web.

La optimización de los metadatos (como las etiquetas de título y las metadescripciones), así como el ajuste de las estructuras de enlaces internos, también ayudarán a contribuir a una indexación rápida y sencilla. Estas acciones, cuando se realizan correctamente, guían a los motores de búsqueda a las páginas más relevantes e importantes.

Además, consolidar el contenido y evitar la canibalización de palabras clave concentrará la autoridad de su contenido en una sola página. Esto dará como resultado una mayor autoridad de la página, lo que alentará a los motores de búsqueda a priorizar y clasificar esa página autorizada de manera más destacada en las SERP.

Redirecciones de auditoría

Examinar cómo funcionan las redirecciones de su sitio web puede ayudar a mejorar la rapidez con la que los motores de búsqueda indexan su contenido. También puede ayudar a mejorar el rendimiento general de su sitio web. Los redireccionamientos actúan como mercados, guiando tanto a los usuarios como a los motores de búsqueda a diferentes páginas cuando es necesario. Si no se gestionan bien, pueden ralentizar el proceso de indexación o impedir que las páginas se indexen por completo. Al realizar una "auditoría de redireccionamiento", puede mejorar la indexación de varias maneras significativas.

En primer lugar, abordar los redireccionamientos excesivos ayudará a los motores de búsqueda a trabajar de manera más efectiva al indexar su sitio web. En ocasiones, pueden encontrar múltiples redireccionamientos, lo que puede ralentizar la indexación de su contenido. Al encontrar y eliminar redireccionamientos innecesarios, puede ayudar a los motores de búsqueda a acceder a su contenido rápidamente, brindándoles también una mejor oportunidad de ser indexados (y, por lo tanto, clasificados) rápidamente.

Completar una auditoría de redireccionamiento también le permitirá abordar un problema técnico común de SEO. Cadenas de redireccionamiento. Estas cadenas pueden ocurrir cuando una redirección conduce a otra, que conduce a otra, que conduce a otra, y así sucesivamente. Pueden confundir a los motores de búsqueda y consumir demasiado tiempo. Sabemos que cuando el robot de un motor de búsqueda tarda demasiado en indexar una página, seguirá adelante y no indexará esa página. Una auditoría le permitirá encontrar y corregir estas cadenas, permitiendo que los motores de búsqueda accedan a su contenido sin problemas.

Finalmente, una auditoría como esta ayudará a los motores de búsqueda a comprender con precisión su sitio web. Cuando los redireccionamientos están bien estructurados, los motores de búsqueda pueden interpretar mejor la importancia de su contenido. Cuando los motores de búsqueda comprenden mejor la importancia de su contenido, sus páginas importantes tienen más posibilidades de ser indexadas rápidamente.

Solucionar errores HTTP y HTTPS

Corregir los errores HTTP y HTTPS es vital para garantizar que sus páginas estén indexadas correctamente. Cuando los robots de los motores de búsqueda encuentran este tipo de errores, les resulta difícil acceder y comprender su contenido. Cuando un robot de motor de búsqueda no puede acceder o comprender su contenido, no puede indexarlo.

Abordar estos problemas mejora la indexación de las siguientes maneras:

En primer lugar, resolver errores HTTP como "404 No encontrado" garantiza que sus páginas sean accesibles tanto para los usuarios como para los motores de búsqueda. Cuando las páginas arrojan estos errores, los motores de búsqueda los interpretarán como contenido faltante, lo que provocará su exclusión de los resultados de búsqueda. La corrección de estos errores brinda a los rastreadores un "camino claro" para indexar su contenido, lo que aumenta las posibilidades de indexarlo y clasificarlo.

En segundo lugar, la transición de HTTP a HTTPS es crucial para la seguridad y la indexación. Los motores de búsqueda dan mucha prioridad a los sitios web seguros (HTTPS) sobre los sitios web no seguros (HTTP) en sus algoritmos de clasificación. ¡Google incluso lo confirmó! Al migrar a HTTPS y garantizar una experiencia de navegación segura para los usuarios, mejora la credibilidad de su sitio, mejorando indirectamente su capacidad para ser indexado y clasificado.

Por último, la implementación coherente de HTTPS y la resolución de errores relacionados con HTTPS evitan que los usuarios y los motores de búsqueda encuentren problemas de "contenido mixto". El contenido mixto ocurre cuando se cargan elementos seguros y no seguros en la misma página. Esto podría provocar advertencias de seguridad y afectar negativamente a la experiencia del usuario.

En esencia, abordar los errores HTTP y HTTPS elimina las barreras que impiden que los motores de búsqueda accedan y comprendan su contenido. Este enfoque altamente proactivo optimiza el proceso de indexación, aumenta la visibilidad en los resultados de búsqueda y mejora la experiencia del usuario en su sitio.

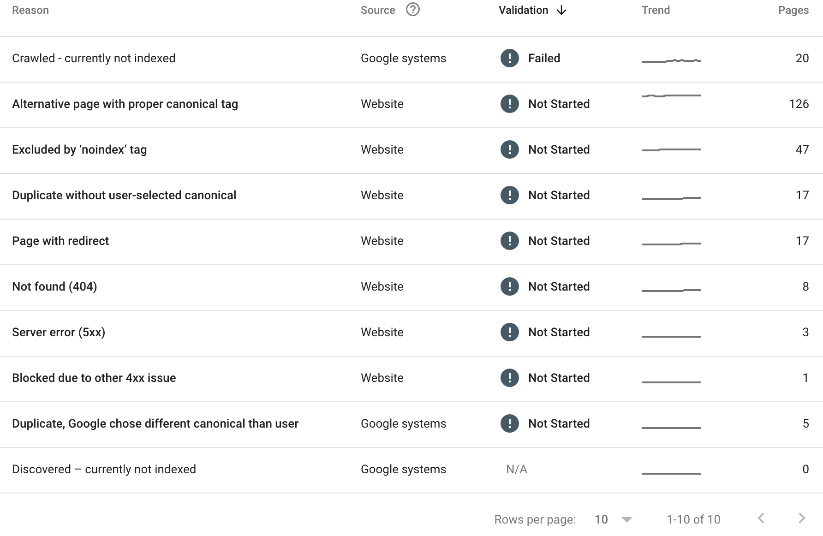

Mire su "Informe de indexación de páginas" en Google Search Console

Google Search Console es una mina de oro para evaluar cómo se indexa su contenido. Dentro de su Informe de indexación de páginas, podrá ver todas las páginas de su sitio web que no han sido indexadas. También podrá ver el motivo por el que la página no ha sido indexada.

He aquí un ejemplo:

En lo anterior (Informe de indexación de páginas de SEOTesting), podemos ver que:

- Se han rastreado 20 páginas pero actualmente no están indexadas.

- 126 páginas tienen una etiqueta canónica adecuada.

- 47 páginas han sido excluidas por la etiqueta 'noindex'.

- Se encuentra que 17 páginas estaban duplicadas, sin ningún canónico seleccionado por el usuario.

- 17 páginas tienen una redirección.

- 8 páginas han devuelto un error 404.

- 3 páginas han devuelto un error de servidor 5xx.

- Se ha bloqueado 1 página debido a otro problema 4xx.

- Se han encontrado 5 páginas duplicadas y Google ha elegido una canónica diferente.

No todas las razones anteriores son problemas, pero vale la pena para nosotros, como equipo de marketing, descubrir por qué ciertas páginas no se han indexado y solucionar tantos problemas como podamos.

Clasificación

La clasificación de los motores de búsqueda es la culminación de los procesos de rastreo, representación e indexación, donde los motores de búsqueda determinan el orden en que aparecen las páginas web en las SERP. El objetivo es presentar a los usuarios el contenido más relevante y valioso, según sus consultas de búsqueda.

En esencia, la clasificación se basa en algoritmos complejos que evalúan una variedad de factores para determinar la relevancia y autoridad de una página web. Uno de los aspectos fundamentales es la relevancia de las palabras clave: qué tan bien coincide el contenido con las palabras y frases que los usuarios ingresan en sus búsquedas. Las páginas con alta relevancia de palabras clave tienden a tener una mejor clasificación.

Sin embargo, la relevancia de las palabras clave por sí sola no es suficiente. Los motores de búsqueda también consideran la calidad y autoridad del sitio web. Los vínculos de retroceso de sitios acreditados, autorizados y relevantes (esto es crucial) son un fuerte indicador de la credibilidad de una página. Cuantos más vínculos de retroceso de alta calidad tenga una página, es más probable que tenga una clasificación más alta.

La experiencia que tienen los usuarios en su sitio web también juega un papel muy importante en la clasificación. Los motores de búsqueda prefieren las páginas que se cargan rápidamente, son compatibles con dispositivos móviles y brindan una experiencia de navegación fluida al usuario. El contenido atractivo y valioso que mantiene a los usuarios en su sitio, navegando, por más tiempo, también indica a los motores de búsqueda que su sitio web podría valer la pena en una clasificación más alta.

La personalización es otro aspecto de la clasificación. Los motores de búsqueda tendrán en cuenta la ubicación del usuario, el historial de búsqueda y las preferencias para adaptar los resultados de la búsqueda y brindarle al usuario la mejor experiencia posible. Esto significa que lo más probable es que la misma consulta produzca resultados diferentes para diferentes usuarios.

Es importante recordar que, independientemente de lo que mencionen otras publicaciones de blog, no sabemos qué peso otorga Google (y otros motores de búsqueda) a diferentes factores para diferentes consultas. Para una pregunta, es posible que deba depender más de vínculos de retroceso relevantes y autorizados. Por otro lado, es posible que deba asegurarse de que su experiencia de usuario sea perfecta. Todo esto se reduce al tiempo en la industria, a aprender el algoritmo y mejorar a medida que avanza.

Comprender diversos aspectos de SEO es vital para el éxito en las SERP. Este artículo exploró la importancia del SEO técnico, las características de los sitios optimizados y la mecánica del SEO técnico desde el rastreo hasta la clasificación.

El SEO técnico construye una base sólida para su sitio web, optimizando elementos para una mejor velocidad y estructura. Esto mejora la navegación, la comprensión del contenido y la experiencia del usuario.

En resumen, el SEO técnico es clave. Al corregir errores y optimizar la estructura del sitio, podrá mejorar su presencia en línea.

¿Quiere potenciar su uso de Google Search Console y llevar su SEO al siguiente nivel implementando pruebas de SEO en su rutina? Prueba SEOTesting. Actualmente estamos realizando una prueba gratuita de 14 días, sin necesidad de tarjeta de crédito para registrarse. Pruebe la herramienta hoy y díganos lo que piensa.