Un guide complet du Web Scraping

Publié: 2023-09-14À l’ère du numérique, où une multitude d’informations sont disponibles sur Internet, il peut s’avérer une tâche ardue de rassembler et de collecter manuellement des données à partir de divers sites Web. C’est là que le web scraping s’avère utile.

Qu’est-ce que le Web Scraping ?

Le web scraping fait référence à l’extraction automatisée de données à partir de sites Web. À l'aide de logiciels spécialisés, communément appelés web scrapers ou web crawlers, les entreprises peuvent collecter des données à partir de diverses sources en ligne et les convertir dans un format structuré.

Le Web scraping consiste à naviguer sur des sites Web et à extraire des points de données spécifiques correspondant aux besoins de votre entreprise. En utilisant des outils et des services de web scraping, les entreprises peuvent automatiser le processus de collecte et d'extraction de données, économisant ainsi du temps et des ressources.

Imaginez que vous dirigiez une entreprise de commerce électronique et que vous souhaitiez suivre les prix de vos concurrents. Au lieu de visiter manuellement le site Web de chaque concurrent et de noter les prix, vous pouvez utiliser un web scraper pour extraire automatiquement les prix. Cela vous fait non seulement gagner du temps, mais garantit également que vous disposez d’informations précises et à jour. Les services de web scraping peuvent être utilisés à diverses fins, telles que les études de marché, la génération de leads, l'analyse des sentiments et bien plus encore. Les possibilités sont infinies.

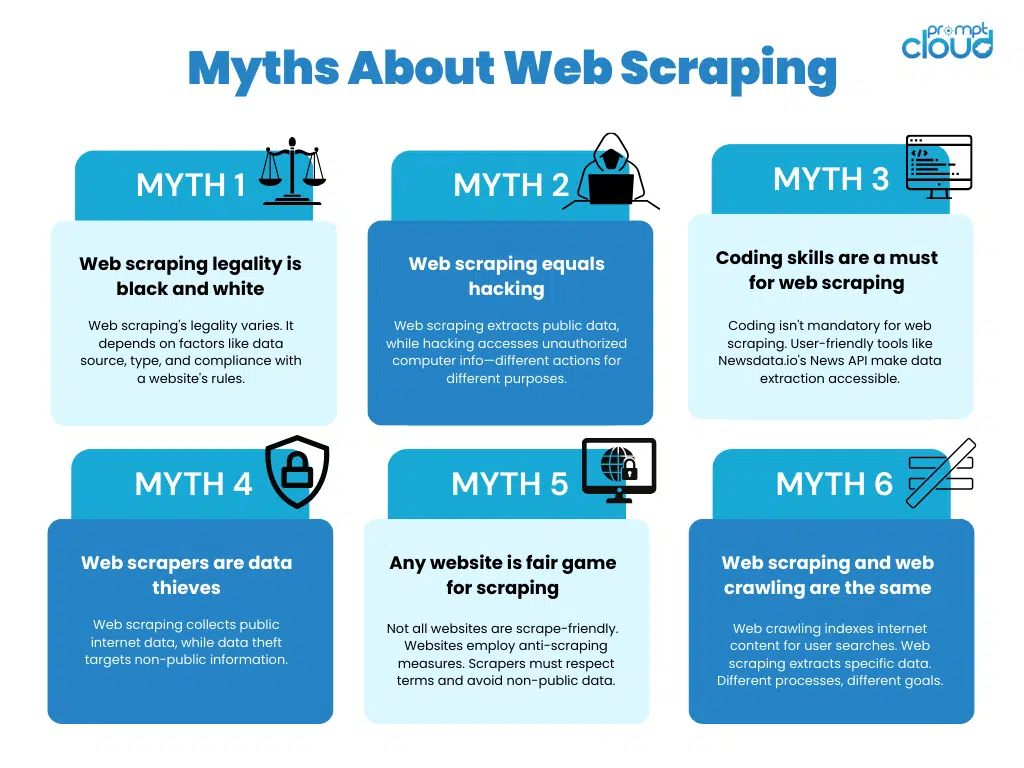

Le Web Scraping est-il légal ?

Bien que le web scraping offre de nombreux avantages, il est crucial pour les entreprises de comprendre et de respecter les directives juridiques et éthiques entourant son utilisation. L'ignorance ou la mauvaise utilisation de ces directives peuvent entraîner des répercussions juridiques ou nuire à la réputation d'une entreprise. Explorons les principales considérations en détail.

Considérations juridiques liées au Web Scraping

Lorsque vous vous engagez dans des activités de web scraping, il est essentiel de respecter les lois applicables, telles que celles régissant les droits de propriété intellectuelle, les conditions d'utilisation des sites Web et les réglementations en matière de protection des données. Ne pas le faire peut entraîner des conséquences juridiques pouvant aller d’avertissements et d’amendes à des poursuites judiciaires.

Les droits de propriété intellectuelle protègent les créations de l’esprit humain, telles que les inventions, les œuvres littéraires et artistiques ainsi que les symboles, noms et images utilisés dans le commerce. Le web scraping doit respecter ces droits en ne portant pas atteinte au matériel ou aux marques déposées protégés par le droit d'auteur. Il est essentiel de comprendre la portée de l'utilisation équitable et de s'assurer que le contenu récupéré ne viole aucune loi sur la propriété intellectuelle.

Les conditions d'utilisation du site Web sont des accords juridiques entre le propriétaire du site Web et ses utilisateurs. Ces termes incluent souvent des dispositions qui interdisent explicitement le web scraping ou imposent des restrictions spécifiques sur son utilisation. Il est crucial de revoir les conditions d’utilisation de chaque site Web avant de le supprimer pour garantir sa conformité. La violation de ces conditions peut entraîner des poursuites judiciaires, notamment des lettres de cessation et d'abstention ou même des poursuites pour rupture de contrat.

Les réglementations en matière de protection des données , telles que le Règlement général sur la protection des données (RGPD) de l'Union européenne, régissent la collecte et le traitement des données personnelles. Les activités de web scraping doivent respecter ces réglementations en obtenant le consentement nécessaire des utilisateurs avant de collecter leurs informations personnelles. De plus, les entreprises doivent gérer et stocker les données récupérées en toute sécurité pour empêcher tout accès non autorisé ou toute violation de données.

Lignes directrices éthiques pour le Web Scraping

L’éthique joue un rôle essentiel dans le web scraping. Les entreprises doivent veiller à respecter les droits des propriétaires de sites Web et donner la priorité à la confidentialité des utilisateurs. Il est essentiel d’obtenir le consentement, lorsque cela est nécessaire, et d’éviter de supprimer des informations sensibles ou protégées par le droit d’auteur.

La transparence et la responsabilité devraient être les principes directeurs lors de l’utilisation du web scraping à des fins commerciales. Communiquer clairement l’objectif de l’activité de scraping et offrir aux utilisateurs la possibilité de se désinscrire peut contribuer à instaurer la confiance et à maintenir les normes éthiques. De plus, les entreprises doivent mettre en œuvre des mesures pour protéger les données récupérées et empêcher leur utilisation abusive ou leur accès non autorisé.

De plus, les entreprises devraient tenir compte de l’impact du web scraping sur les performances du site Web. Un scraping excessif peut mettre le serveur à rude épreuve et affecter négativement l’expérience utilisateur des autres visiteurs. La mise en œuvre de techniques de scraping qui minimisent l'impact sur les performances du site Web, telles que l'utilisation d'intervalles de scraping appropriés et le respect des fichiers robots.txt, est essentielle pour maintenir des pratiques éthiques.

En adhérant aux exigences légales et aux directives éthiques, les entreprises peuvent garantir que leurs activités de web scraping sont menées de manière responsable et sans causer de préjudice à autrui. Il est toujours conseillé de consulter des professionnels du droit pour s'assurer du respect des lois et réglementations spécifiques applicables à la juridiction dans laquelle le scraping a lieu.

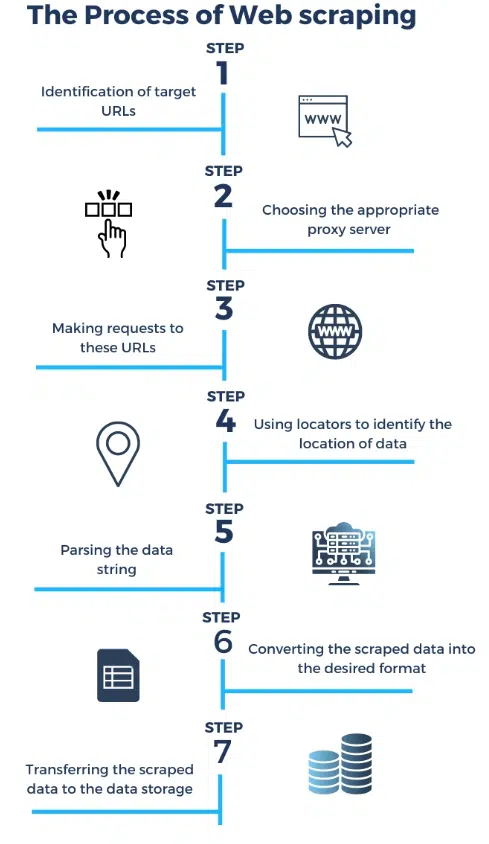

Comment fonctionne un Web Scraper ?

Source : https://research.aimultiple.co

Le web scraping suit un processus structuré. La première étape consiste à envoyer une requête au serveur d'un site Web cible. Cette requête est similaire à celle envoyée par votre navigateur lorsque vous visitez un site Web. Le serveur répond ensuite à la requête en renvoyant le code HTML de la page Web.

Une fois que le web scraper reçoit le code HTML, il commence à l'analyser pour extraire les données souhaitées . L'analyse implique d'analyser la structure du code HTML et d'identifier les éléments spécifiques qui contiennent les données qui vous intéressent. Cela peut aller du prix des produits aux avis des clients.

Après avoir extrait les données, le web scraper peut les stocker dans un format structuré , tel qu'une feuille de calcul ou une base de données. Cela permet aux entreprises d’accéder et d’analyser facilement les données collectées.

Le web scraping peut être un processus complexe, en particulier lorsqu'il s'agit de sites Web dont le contenu est dynamique ou qui nécessitent une authentification. Cependant, avec les outils et services de web scraping appropriés, les entreprises peuvent surmonter ces défis et exploiter la puissance des services de web scraping pour obtenir des informations précieuses et garder une longueur d'avance sur la concurrence.

Types de grattoirs Web

Les Web scrapers sont des outils logiciels conçus pour extraire des données de sites Web. Il en existe différents types et peuvent être classés en fonction de leur fonctionnalité, de leur objectif et de la manière dont ils accèdent et analysent le contenu Web. Voici quelques différents types de web scrapers :

Grattoirs de base :

- HTML Scrapers : ceux-ci récupèrent les données des pages HTML en analysant le balisage. Ils peuvent extraire du texte, des liens et d’autres éléments des pages Web.

- Text Scrapers : ceux-ci se concentrent sur l'extraction de contenu textuel à partir de pages Web, tels que des articles, des billets de blog ou des articles d'actualité.

Grattoirs avancés :

- Dynamic Content Scrapers : ceux-ci peuvent supprimer des sites Web avec du contenu piloté par JavaScript. Ils utilisent des navigateurs sans tête ou des outils d'automatisation comme Selenium pour interagir avec les pages Web et extraire des données.

- API Scrapers : ceux-ci interagissent directement avec les API Web pour récupérer des données structurées. De nombreux sites Web proposent des API pour accéder à leurs données dans un format structuré.

Grattoirs à usage spécifique :

- Scrapers de commerce électronique : conçus pour extraire des informations sur les produits, les prix et les avis des sites Web de commerce électronique.

- Social Media Scrapers : ils récupèrent les données des plateformes de médias sociaux comme Twitter, Facebook ou Instagram, y compris les publications, les commentaires et les profils d'utilisateurs.

- News Scrapers : axés sur l'extraction d'articles d'actualité, de titres et d'informations connexes à partir de sites Web d'actualités.

- Job Scrapers : collectez des offres d'emploi et des données associées à partir de sites Web de recherche d'emploi.

- Scrapers immobiliers : extrayez les listes de propriétés, les prix et les détails des sites Web immobiliers.

Grattoirs d'images et de médias :

- Image Scrapers : téléchargez des images à partir de sites Web, souvent utilisées pour des ensembles de données d'images ou des collections de photos.

- Video Scrapers : collectez le contenu vidéo et les métadonnées de sites Web comme YouTube ou Vimeo.

Scrapers de surveillance et d’alerte :

- Scrapers de détection de changements : surveillez en permanence les sites Web pour détecter les modifications et informez les utilisateurs lorsque des critères spécifiques sont remplis (par exemple, baisses de prix, mises à jour de contenu).

Grattoirs sur mesure :

- Grattoirs sur mesure développés pour des cas d'utilisation spécifiques et uniques. Ceux-ci sont souvent créés par des fournisseurs de services de web scraping pour répondre à des exigences spécifiques d’extraction de données.

Python : l'outil ultime pour le Web Scraping

Python est devenu le langage incontournable pour le web scraping, et ce n'est pas un hasard. Sa popularité dans ce domaine repose sur plusieurs raisons impérieuses.

Polyvalence et facilité d'apprentissage

La simplicité et la lisibilité de Python en font un choix idéal pour le web scraping, quelle que soit votre expérience en programmation. Son code s'apparente à un anglais simple, le rendant accessible aussi bien aux débutants qu'aux développeurs chevronnés.

Riche écosystème de bibliothèques

Python possède un trésor de bibliothèques conçues explicitement pour le web scraping. Parmi eux, BeautifulSoup et Scrapy se démarquent. Ces bibliothèques résument des tâches complexes, telles que l'analyse HTML et l'envoi de requêtes HTTP, rationalisant ainsi considérablement le processus de scraping.

Soutien communautaire actif

Python est soutenu par une communauté de développeurs dynamique et enthousiaste. D'innombrables ressources, didacticiels et forums en ligne sont disponibles pour vous aider à relever les défis du web scraping, garantissant que vous ne serez jamais coincé sans conseils.

Compatibilité multiplateforme

Python fonctionne de manière transparente sur différents systèmes d'exploitation, de Windows à macOS et Linux. Cette compatibilité multiplateforme signifie que vos scripts de web scraping peuvent fonctionner de manière cohérente dans différents environnements.

Analyse de données robuste

Grâce à ses capacités de manipulation de chaînes, Python excelle dans la navigation et l'extraction de données à partir de pages Web, même lorsqu'il s'agit de structures de pages complexes. BeautifulSoup, en particulier, simplifie l'analyse des documents HTML et XML.

Gestion des requêtes HTTP

La bibliothèque « requests » de Python rationalise le processus de création de requêtes HTTP, ce qui est fondamental pour le web scraping. Il gère les tâches courantes telles que les requêtes GET et POST, la gestion des cookies et les redirections, ce qui rend vos efforts de scraping sans tracas. Le web scraping Python est largement utilisé de nos jours.

Intégration avec les outils d'automatisation

Pour les sites Web au contenu dynamique, Python fonctionne bien avec des outils d'automatisation comme Selenium. Cela vous permet d'interagir avec les pages comme le ferait un utilisateur humain, garantissant ainsi l'accès au contenu qui nécessite une interaction de l'utilisateur.

Traitement et analyse des données

Les bibliothèques de traitement et d'analyse des données de Python, telles que Pandas et NumPy, facilitent le nettoyage, la transformation et l'analyse des données extraites lors du web scraping. Cela signifie que vous pouvez transformer les données brutes en informations exploitables.

Pratiques de grattage éthiques

La flexibilité de Python permet la mise en œuvre de pratiques de scraping éthiques. Vous pouvez respecter les conditions d'utilisation du site Web, adhérer aux directives robots.txt et gérer les taux de requêtes pour minimiser le risque de blocage IP.

Intégration avec des bases de données et des API

La polyvalence de Python s'étend à sa capacité à se connecter à diverses bases de données et API Web. Cela vous permet de stocker et de récupérer des données récupérées pour une analyse plus approfondie ou une intégration dans vos applications.

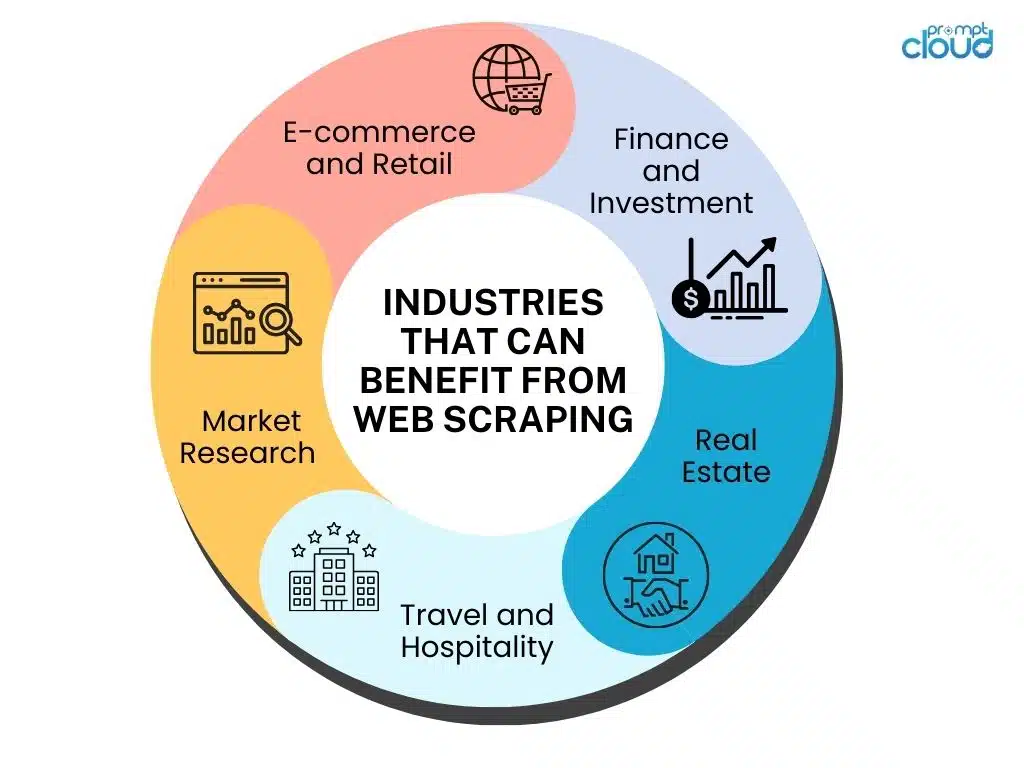

Avantages commerciaux du Web Scraping

Le Web scraping offre de nombreux avantages qui peuvent avoir un impact significatif sur les entreprises de divers secteurs. Explorons quelques domaines clés dans lesquels le web scraping peut s'avérer inestimable.

Améliorer les études de marché – Les études de marché constituent la base de toute entreprise prospère. Grâce au web scraping, les entreprises peuvent recueillir une multitude d'informations sur leurs concurrents, les tendances du marché, les stratégies de tarification et les préférences des clients. En analysant ces données, les entreprises peuvent prendre des décisions plus éclairées et concevoir des stratégies efficaces pour garder une longueur d'avance sur la concurrence.

Par exemple, le web scraping peut aider les entreprises à suivre les stratégies de tarification de leurs concurrents en temps réel. En surveillant les prix de produits ou de services similaires, les entreprises peuvent ajuster leurs propres stratégies de tarification pour rester compétitives. De plus, le web scraping peut fournir des informations sur le sentiment des clients en analysant les avis en ligne et les publications sur les réseaux sociaux. Ces informations peuvent aider les entreprises à comprendre les préférences des clients et à adapter leurs produits ou services en conséquence.

Stimuler la génération de leads – Générer des leads de qualité est crucial pour la croissance de l’entreprise. Le web scraping permet aux entreprises d'extraire des informations de contact, telles que des adresses e-mail et des numéros de téléphone, à partir de sites Web et d'annuaires. Ces données peuvent ensuite être utilisées pour des campagnes marketing ciblées, augmentant ainsi les chances d'atteindre des clients potentiels et de générer des prospects.

En outre, le web scraping peut aider les entreprises à identifier des prospects potentiels en surveillant les forums en ligne, les plateformes de médias sociaux et les sites Web spécifiques à un secteur. En analysant les discussions et les interactions, les entreprises peuvent identifier les individus ou les organisations qui expriment un besoin ou un intérêt pour leurs produits ou services. Cette approche proactive de la génération de leads peut améliorer considérablement les taux de conversion et stimuler la croissance de l'entreprise.

Rationalisation de la collecte de données – Les données font partie intégrante de la prise de décision et le web scraping simplifie le processus de collecte de données. Au lieu de visiter manuellement plusieurs sites Web et de copier des informations, les entreprises peuvent automatiser le processus d'extraction des données. Le web scraping permet aux entreprises de collecter de gros volumes de données rapidement et efficacement, permettant ainsi une analyse plus précise et des informations plus rapides.

Par exemple, le web scraping peut être utilisé pour collecter des données sur des sites Web de commerce électronique afin d'analyser les tendances des produits, le comportement des clients et les modèles de prix. Ces informations peuvent aider les entreprises à optimiser leurs offres de produits, à améliorer la satisfaction des clients et à identifier de nouvelles opportunités de marché. De plus, le web scraping peut être utilisé pour collecter des données à partir de sites Web d'actualités, de blogs et de publications industrielles, fournissant ainsi aux entreprises des informations à jour sur les développements et les tendances du secteur.

Les services de web scraping jouent un rôle crucial dans l’amélioration des études de marché, la génération de leads et la rationalisation de la collecte de données pour les entreprises. En exploitant la puissance du web scraping, les entreprises peuvent acquérir un avantage concurrentiel, prendre des décisions éclairées et stimuler la croissance dans le paysage numérique actuel.

Premiers pas avec le Web Scraping

Examinons quelques aspects clés à prendre en compte lors de l'intégration du web scraping dans vos opérations.

Choisir les meilleurs outils de scraping Web

En matière de web scraping, vous avez deux options principales : utiliser des outils de web scraping ou externaliser la tâche à des fournisseurs de services de web scraping. Commençons par explorer les différents aspects des outils de web scraping :

Il existe une large gamme d’outils de web scraping disponibles sur le marché. Il est essentiel d'évaluer les besoins de votre entreprise et de sélectionner un outil offrant les fonctionnalités, l'évolutivité et la facilité d'utilisation requises. Effectuez des recherches approfondies et tenez compte de facteurs tels que les capacités d’extraction de données, les options de personnalisation et le support client avant de prendre une décision. Certains facteurs à considérer sont :

- Facilité d'utilisation : les outils de scraping Web sont dotés d'interfaces conviviales et nécessitent des connaissances minimales en codage. Ils offrent une fonction de grattage visuel qui vous permet de sélectionner facilement les données dont vous avez besoin sur un site Web. Certains outils de scraping Web populaires incluent Beautiful Soup, Scrapy et Octoparse.

- Flexibilité : avec les outils de scraping Web, vous pouvez personnaliser vos scripts de scraping en fonction de vos besoins spécifiques. Ils offrent la flexibilité nécessaire pour extraire simultanément des données de plusieurs sites Web, gérer des pages Web complexes et extraire des données dans divers formats tels que CSV, JSON ou XML.

- Coût : les outils de web scraping sont généralement plus rentables que l’externalisation de la tâche à des prestataires de services. La plupart des outils proposent des versions gratuites avec des fonctionnalités limitées, tandis que les versions payantes offrent des fonctionnalités et une assistance avancées.

- Maintenance et mises à jour : À mesure que la technologie évolue, les sites Web changent souvent de structure, ce qui rend nécessaire la mise à jour des scripts de scraping. Les outils de scraping Web nécessitent une maintenance et des mises à jour régulières pour garantir une extraction de données précise et continue.

Évaluation des fournisseurs de services de Web Scraping

Bien que les outils de web scraping puissent constituer un excellent choix pour les particuliers ou les projets à petite échelle, ils ne constituent pas toujours la meilleure solution pour les entreprises ayant des besoins de scraping complexes. Pour prendre une décision éclairée, tenez compte des facteurs suivants lors de l’évaluation des fournisseurs de services de web scraping :

- Évolutivité : les fournisseurs de services disposent de l’infrastructure et des ressources nécessaires pour gérer efficacement les projets de web scraping à grande échelle. Ils peuvent gérer les grattages simultanés, fournir un accès à plusieurs serveurs proxy pour contourner les restrictions des sites Web et garantir une extraction ininterrompue des données.

- Qualité des données : les fournisseurs de services de web scraping se spécialisent dans la fourniture de données précises et de haute qualité. Ils peuvent relever plus efficacement des défis tels que CAPTCHA, les sites Web dynamiques et les structures de pages changeantes, ce qui permet d'obtenir des données fiables et cohérentes.

- Conformité juridique : le web scraping peut être une zone grise juridique, et les fournisseurs de services maîtrisent parfaitement les complexités juridiques. Ils garantissent le respect des conditions d’utilisation du site Web, des lois sur les droits d’auteur et des réglementations sur la protection des données, réduisant ainsi le risque de conséquences juridiques.

- Personnalisation et support : les prestataires de services proposent des solutions sur mesure pour répondre à vos besoins spécifiques en matière de scraping. Ils peuvent gérer des tâches complexes d’extraction de données, fournir un formatage de données personnalisé et offrir une assistance technique continue.

Pourquoi choisir les fournisseurs de services de Web Scraping plutôt que les outils

Bien que les outils de web scraping aient leurs mérites, il existe des raisons impérieuses pour lesquelles les entreprises devraient envisager de confier le web scraping à des prestataires de services :

- Expertise et expérience : les fournisseurs de services de scraping Web sont spécialisés dans l'extraction de données et possèdent une vaste expérience dans la gestion d'un large éventail de projets de scraping. Ils possèdent l’expertise nécessaire pour surmonter les défis et fournir des résultats fiables.

- Concentration sur les compétences de base : L'externalisation du web scraping permet aux entreprises de se concentrer sur leurs compétences de base au lieu d'investir du temps et des ressources dans la maîtrise des outils et techniques de scraping. Cela permet aux entreprises de prioriser leurs activités clés et de stimuler leur croissance.

- Rentable : contrairement à la croyance populaire, les fournisseurs de services de web scraping peuvent souvent offrir des économies à long terme. Ils peuvent fournir des données précises et pertinentes plus rapidement, permettant aux entreprises de prendre rapidement des décisions fondées sur les données, ce qui se traduit par une efficacité opérationnelle améliorée.

- Gain de temps et d'efforts : les fournisseurs de services de web scraping s'occupent de l'ensemble du processus de web scraping, de l'extraction des données à la gestion de la maintenance et des mises à jour. Cela libère du temps et des efforts de votre équipe, leur permettant de se concentrer sur l'analyse des données extraites et d'en tirer des informations précieuses.

Le Web scraping est un outil précieux pour les entreprises qui cherchent à exploiter la puissance des données. Bien que les outils de web scraping puissent être utiles pour les projets à petite échelle, l'externalisation vers des fournisseurs de services de web scraping offre de nombreux avantages, notamment l'évolutivité, la qualité des données, la conformité légale, la personnalisation et l'assistance professionnelle. En évaluant soigneusement vos besoins et en tenant compte de ces facteurs, vous pouvez prendre une décision éclairée qui correspond le mieux aux besoins de votre entreprise.