Prévenir l'effondrement des modèles d'IA : gérer le risque inhérent aux ensembles de données synthétiques

Publié: 2023-10-05L'intelligence artificielle (IA) a considérablement transformé notre vie quotidienne en suggérant des contenus personnalisés sur les plateformes de streaming et en activant les assistants numériques sur les smartphones. Aujourd’hui, ces avancées sont rendues possibles grâce à des modèles d’IA sophistiqués qui apprennent à partir de grandes quantités de données.

Selon divers rapports, le contenu généré par l’IA est de plus en plus répandu sur Internet, représentant potentiellement jusqu’à 90 % des informations en ligne dans les années à venir.

Avec un tel afflux d’informations, on peut facilement dire que dans le monde actuel riche en données, l’IA est confrontée à un défi unique, celui de s’étouffer avec son abondance de données.

Les rapports suggèrent en outre que la quantité importante de contenu généré par l’IA peut submerger les gens d’informations excessives, ce qui rend difficile pour eux de déterminer ce qui est fiable et généré par l’homme. En outre, la perte potentielle d’emplois dans des domaines créatifs tels que l’art, le journalisme et l’écriture suscite des inquiétudes, tout cela parce que l’IA est de plus en plus capable de produire du contenu traditionnellement créé par des humains.

En ce qui concerne les systèmes d'IA eux-mêmes, des problèmes émergents tels que «l'effondrement du modèle», qui fait référence à un problème dans lequel les modèles d'IA formés sur de grands ensembles de données produisent des résultats de moindre qualité en donnant la priorité aux choix de mots courants plutôt qu'aux alternatives créatives. Le « trouble de l'autophagie des modèles » ou « IA des Habsbourg » est une autre préoccupation dans laquelle les systèmes d'IA excessivement entraînés sur les résultats d'autres modèles d'IA peuvent présenter des caractéristiques indésirables ou des biais.

Ces défis peuvent potentiellement nuire à la qualité et à la fiabilité du contenu généré par l’IA, détruisant la confiance dans ces systèmes et aggravant la surcharge d’informations.

Notre blog vous aidera à comprendre tout ce qui concerne la prévention de l'effondrement des modèles d'IA. À mesure que la révolution de l’IA générative progresse, elle engendre des défis et des incertitudes importants pour le paysage de l’information en ligne. Alors, entrons de front dans les détails.

Comprendre l'effondrement du modèle d'IA

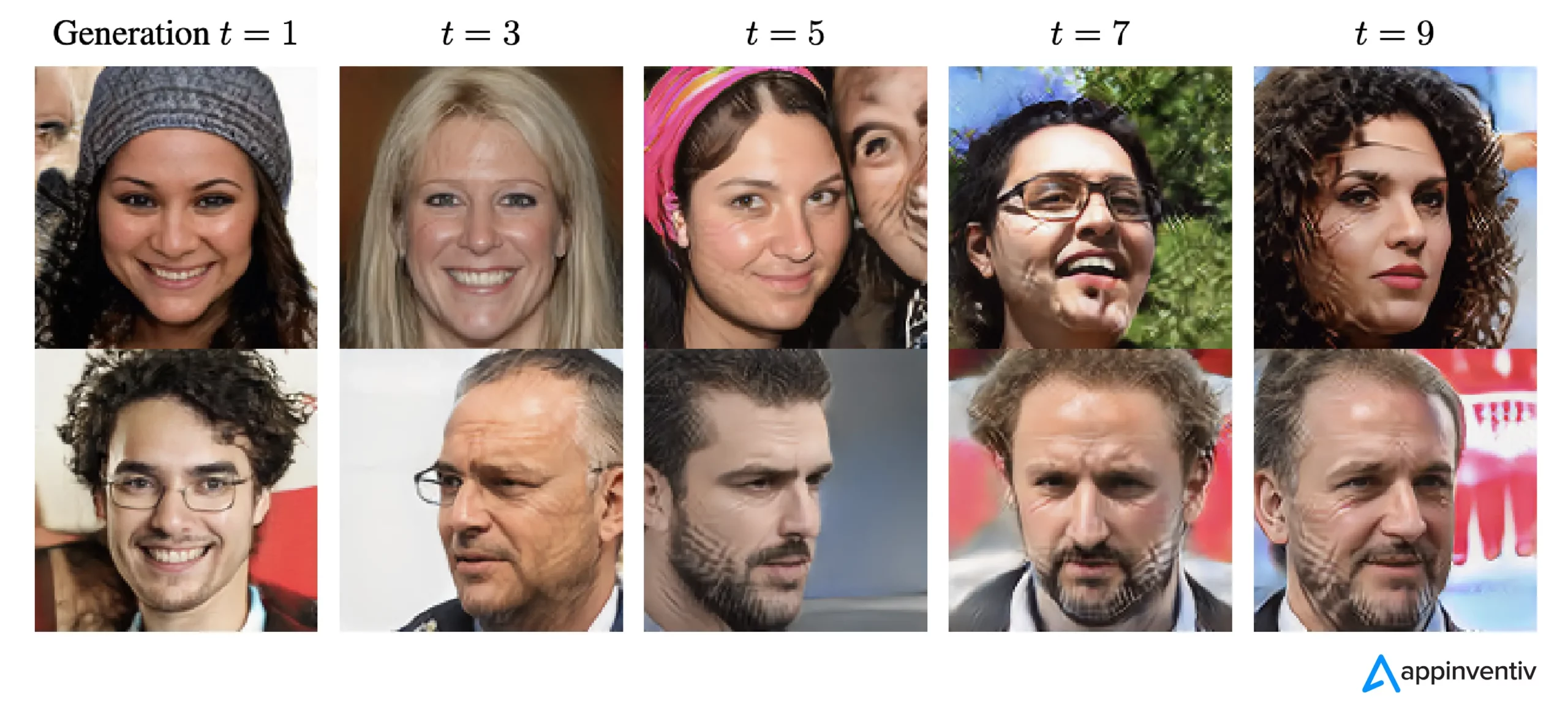

En apprentissage automatique, « l’effondrement du modèle » fait référence à une situation dans laquelle le modèle d’IA ne parvient pas à fournir une variété de résultats utiles. Au lieu de cela, il produit un ensemble restreint de résultats répétitifs ou de mauvaise qualité. Ce problème peut survenir dans divers modèles, mais il est souvent observé lors de la formation de modèles complexes tels que les réseaux contradictoires génératifs (GAN). L'effondrement du modèle peut entraver la capacité du modèle à générer des résultats divers et précieux, ce qui a un impact sur ses performances globales.

Illustrons un exemple de réduction de modèle. Imaginez un étudiant en art très enthousiaste représentant notre modèle d'IA, chargé de créer des peintures de zèbres. Au début, leurs œuvres sont impressionnantes et ressemblent distinctement à des zèbres. Cependant, leurs peintures perdent progressivement leur ressemblance avec les zèbres au fur et à mesure qu'elles avancent, et leur qualité diminue. Ceci est similaire à « l’effondrement du modèle » dans l’apprentissage automatique, où le modèle d’IA, comme notre étudiant en art, fonctionne initialement bien mais a ensuite du mal à conserver les caractéristiques essentielles pour lesquelles il a été conçu.

Conformément aux récents progrès de l’IA, les chercheurs sont devenus très intéressés par l’utilisation de données artificielles ou synthétiques pour former de nouveaux modèles d’IA lorsqu’il s’agit de générer des images et du texte. Cependant, un concept appelé « trouble de l'autophagie modèle » (MAD) compare ce processus à une boucle autodestructrice.

À moins que nous continuions à ajouter régulièrement de nouvelles données du monde réel, la qualité et la variété des modèles d’IA que nous créons à l’aide de données synthétiques pourraient se détériorer avec le temps. Il est donc essentiel de trouver un équilibre entre les données synthétiques et réelles pour que les modèles d’IA restent performants.

Cet équilibre est crucial pour éviter une baisse de la qualité et de la diversité des modèles au fur et à mesure de leur apprentissage. Découvrir comment utiliser efficacement les données synthétiques pour prévenir l’effondrement des modèles d’IA est un défi permanent lorsqu’il s’agit de l’évolution de l’IA générative et de l’utilisation de données synthétiques.

Selon The New Yorker, si ChatGPT est considéré comme une version compacte d'Internet, similaire à celle d'un fichier JPEG compressant une photographie, alors former les futurs chatbots sur les résultats de ChatGPT équivaut numériquement à faire des photocopies de photocopies à plusieurs reprises, tout comme le vieux jours. Simplement, la qualité de l’image est vouée à se détériorer à chaque itération.

Ainsi, pour relever ce défi, les organisations doivent se concentrer sur l’affinement de leurs approches afin de garantir que ces produits d’IA générative continuent de fournir des réponses précises dans ce paysage numérique.

[Lire aussi : IA responsable – Relever les défis de l’adoption grâce à des principes directeurs et des stratégies]

Comment l’effondrement du modèle d’IA se produit-il ?

L’effondrement du modèle se produit lorsque de nouveaux modèles d’IA sont entraînés à l’aide de données générées par des modèles plus anciens. Ces nouveaux modèles s'appuient sur les modèles observés dans les données générées. L’effondrement des modèles repose sur l’idée selon laquelle les modèles génératifs ont tendance à répéter des modèles qu’ils ont déjà appris, et qu’il existe une limite aux informations qu’ils peuvent extraire de ces modèles.

En cas d’effondrement du modèle, les événements susceptibles de se produire sont exagérés, tandis que les événements moins probables sont sous-estimés. Sur plusieurs générations, les événements probables dominent les données, et les parties les moins courantes mais néanmoins cruciales des données, appelées queues, diminuent. Ces queues sont essentielles au maintien de la précision et de la diversité des sorties du modèle. Au fur et à mesure que les générations progressent, les erreurs envahissent les données et le modèle les interprète de plus en plus mal.

Selon la recherche, il existe deux types d’effondrement de modèle : précoce et tardif. L’effondrement précoce du modèle implique que le modèle perde des informations sur des événements rares. En cas d'effondrement tardif du modèle, le modèle brouille les modèles distincts dans les données, ce qui donne lieu à des résultats qui ressemblent peu aux données d'origine.

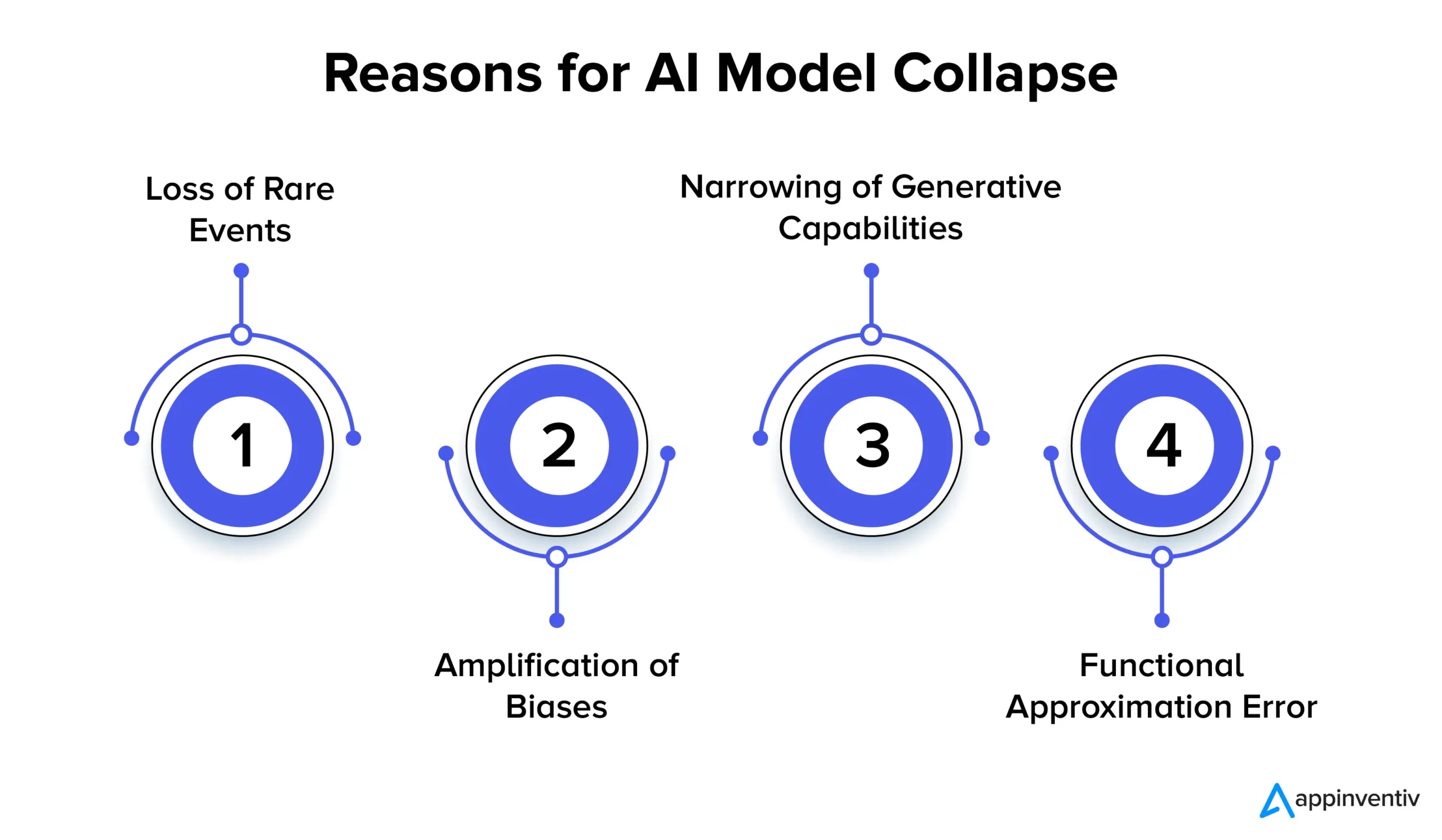

Examinons en détail ci-dessous les multiples raisons de l'effondrement du modèle d'IA :

Perte d'événements rares

Lorsque les modèles d’IA sont entraînés à plusieurs reprises sur les données générées par leurs versions précédentes, ils tentent de se concentrer sur des modèles communs et d’oublier les événements rares. Ce phénomène est similaire à celui des modèles qui perdent leur mémoire à long terme. Les événements rares revêtent souvent une importance considérable, comme l’identification d’anomalies dans les processus de fabrication ou la détection de transactions frauduleuses. Par exemple, lorsqu’il s’agit de détection de fraude, des modèles de langage spécifiques peuvent signaler un comportement frauduleux, ce qui rend crucial la conservation et l’apprentissage de ces modèles rares.

Amplification des biais

Chaque itération d'entraînement sur les données générées par l'IA peut amplifier les biais existants dans les données d'entraînement. Étant donné que les résultats du modèle reflètent généralement les données sur lesquelles il a été formé, tout biais contenu dans ces données peut être exagéré avec le temps. Cela peut conduire à une amplification des biais dans diverses applications d’IA. Par exemple, les résultats peuvent conduire à des problèmes tels que la discrimination, les préjugés raciaux et le contenu biaisé des médias sociaux. Ainsi, la mise en œuvre de contrôles pour détecter et atténuer les biais est extrêmement essentielle.

Rétrécissement des capacités génératives

À mesure que les modèles d’IA continuent d’apprendre à partir des données générées, leurs capacités génératives peuvent se réduire. Le modèle devient plutôt influencé par ses propres interprétations de la réalité, produisant des contenus de plus en plus similaires, manquant de diversité et de représentation d’événements rares. Cela peut entraîner une perte d’originalité. Par exemple, lorsqu'il s'agit de grands modèles linguistiques (LLM), la variation confère à chaque écrivain ou artiste son ton et son style distincts.

La recherche suggère simplement que si de nouvelles données ne sont pas ajoutées régulièrement au cours du processus de formation, les futurs modèles d’IA pourraient finir par devenir moins précis ou produire des résultats moins variés au fil du temps.

Erreur d'approximation fonctionnelle

Une erreur d’approximation fonctionnelle peut survenir lorsque les approximateurs de fonctions utilisés dans le modèle ne sont pas suffisamment expressifs. Bien que cette erreur puisse être atténuée en utilisant des modèles plus expressifs, elle peut également introduire du bruit et conduire à un surapprentissage. Trouver le bon équilibre entre l’expressivité du modèle et le contrôle du bruit est crucial pour éviter ces erreurs.

Implications de l’effondrement du modèle : pourquoi la stabilité du modèle d’IA est-elle importante ?

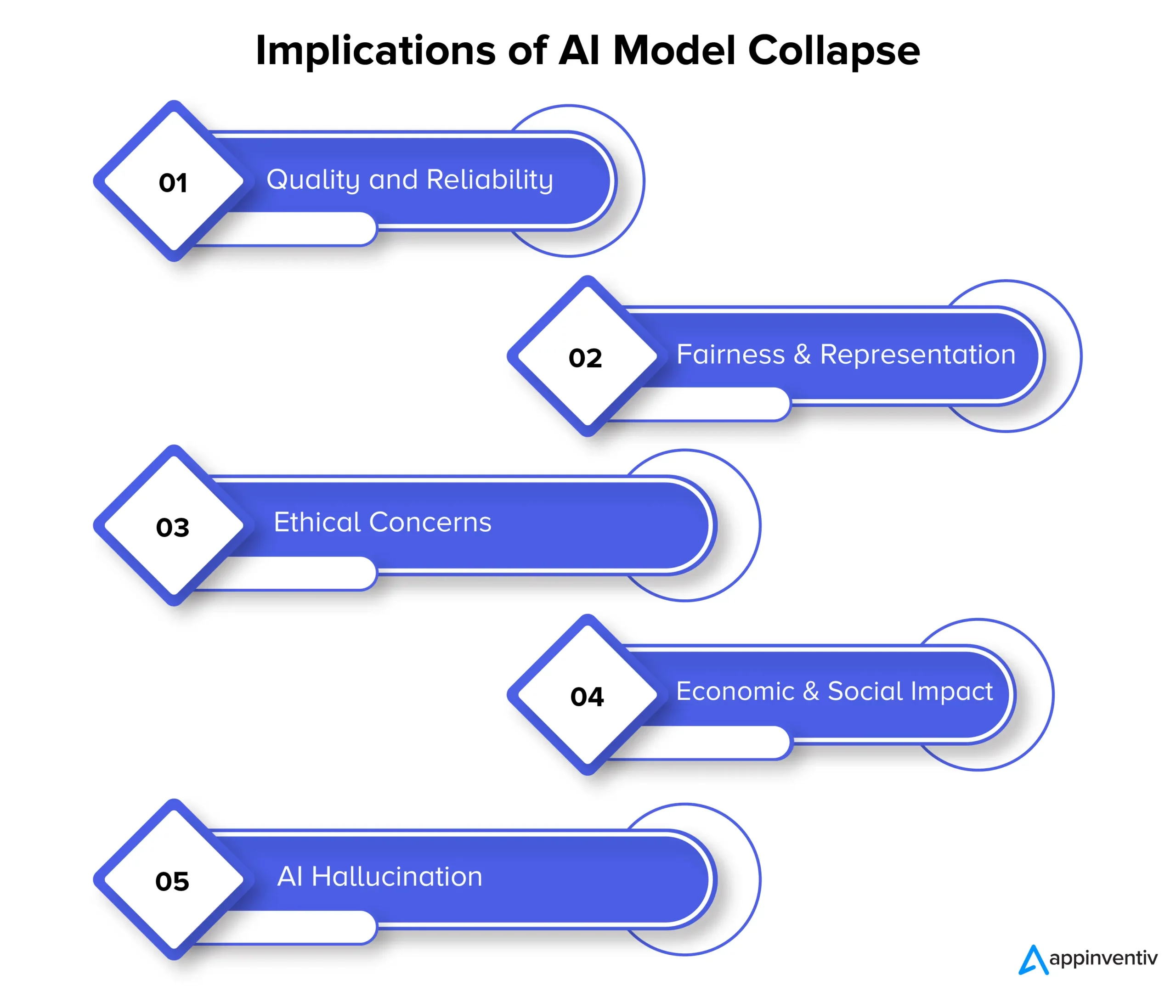

L’effondrement du modèle peut à terme avoir un impact sur la qualité, la fiabilité et l’équité du contenu généré par l’IA, ce qui peut en outre présenter plusieurs risques pour les organisations. Examinons en détail ci-dessous les implications de l'effondrement du modèle :

Qualité et fiabilité

À mesure que les modèles d’IA dégénèrent au cours de leur apprentissage, le contenu qu’ils génèrent devient moins fiable et leur qualité se dégrade. Cela se produit lorsque les modèles se détachent de la distribution originale des données et s’appuient davantage sur leurs propres interprétations de la réalité. Par exemple, un modèle d’IA conçu pour la génération d’informations peut produire des articles d’actualité inexacts, voire complètement fabriqués.

Équité et représentation

L'effondrement du modèle est également une source de préoccupation en matière d'équité et de représentation du contenu généré. Lorsque les modèles oublient des événements rares et limitent leurs capacités génératives, le contenu lié à des sujets moins courants peut être insuffisamment représenté. Cela conduit à des préjugés, des stéréotypes et à l’exclusion de certaines perspectives.

Préoccupations éthiques

L’effondrement du modèle soulève d’importantes préoccupations éthiques, en particulier lorsque le contenu généré par l’IA a le pouvoir d’influencer la prise de décision. Les conséquences de l'effondrement du modèle incluent la diffusion de contenus biaisés et inexacts, qui peuvent avoir un impact significatif sur la vie, les opinions et l'accès aux opportunités des gens.

Impact économique et social

À l’échelle économique et sociale, l’effondrement du modèle peut influencer la confiance et l’adoption des technologies d’IA. Si le contenu généré par l’IA n’est pas fiable, les entreprises et les consommateurs pourraient hésiter à adopter ces technologies. Cela peut avoir des implications économiques, et la confiance dans les technologies d’IA peut en conséquence être entravée.

Hallucination de l'IA

L'hallucination de l'IA se produit lorsque les modèles d'IA créent un contenu imaginatif ou irréaliste qui ne correspond pas aux faits ou n'est en aucun cas cohérent. Cela peut donner lieu à des informations inexactes, susceptibles de provoquer des informations erronées ou de la confusion. C'est particulièrement problématique dans des applications telles que la génération d'actualités, le diagnostic de problèmes médicaux ou la création de documents juridiques où l'exactitude et la fiabilité sont extrêmement vitales.

Expliquons le contexte avec un exemple d'hallucination d'IA. Supposons qu’il existe un modèle d’IA entraîné pour générer des images d’animaux. Désormais, en demandant une photo d’un animal, le modèle pourrait produire l’image d’un « zèbre », un hybride entre un zèbre et un cheval. Bien que cette image puisse sembler visuellement réaliste, il est essentiel de comprendre qu'il ne s'agit que d'une création de l'imagination du modèle d'IA, car aucun animal de ce type n'existe dans le monde réel.

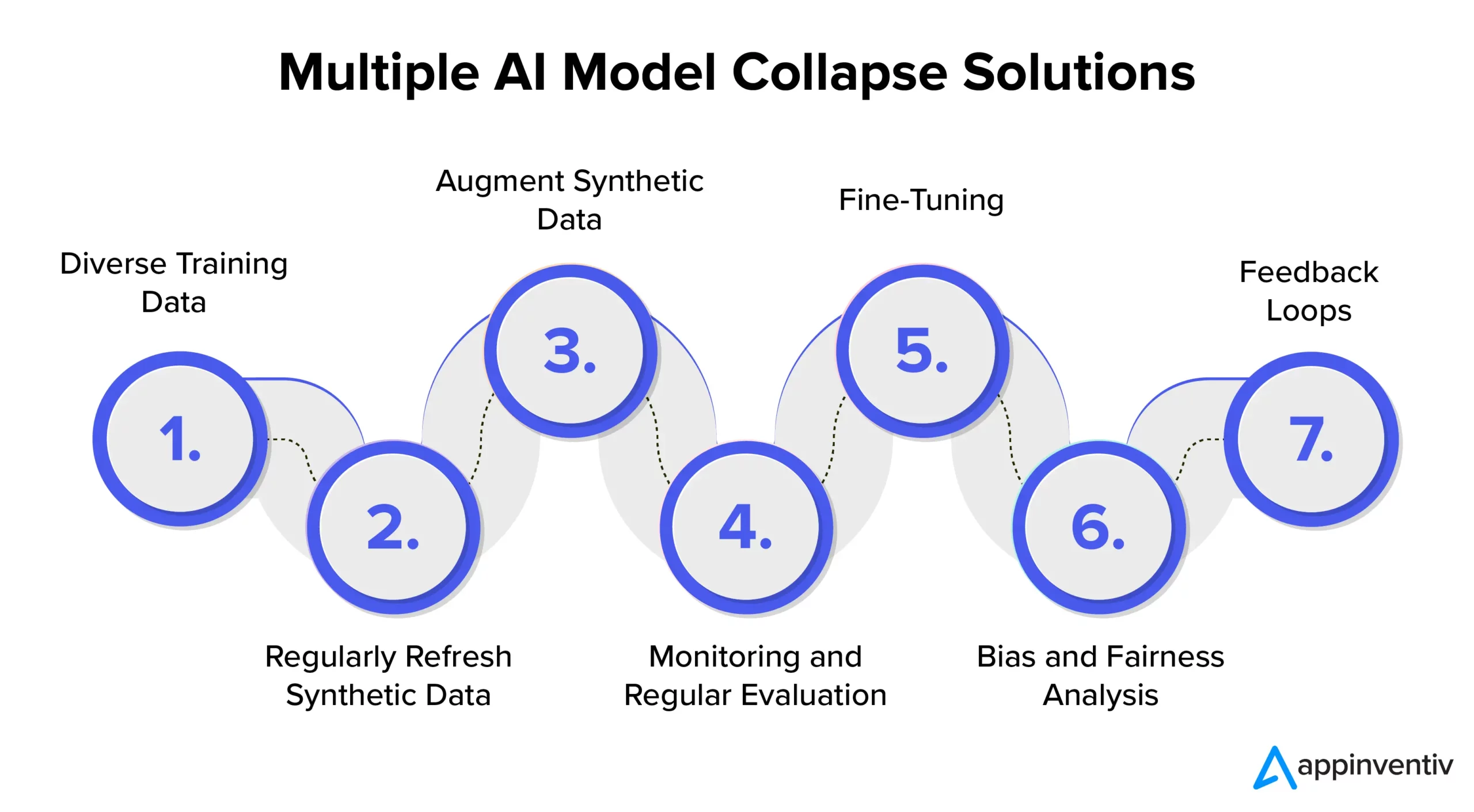

Prévention de l'effondrement des modèles d'IA : comprendre les solutions d'effondrement des modèles d'IA

Pour garantir la stabilité et la fiabilité du modèle d’IA, il est essentiel d’explorer des stratégies et des bonnes pratiques pour lutter efficacement contre l’effondrement du modèle d’IA. Ainsi, il est recommandé de s'associer à une société de développement d'IA dédiée comme Appinventiv qui peut fournir une expertise et des conseils dans la mise en œuvre de ces mesures préventives tout en garantissant que vos systèmes d'IA fournissent systématiquement des résultats de haute qualité.

Données de formation diverses

Pour lutter efficacement contre l’effondrement du modèle d’IA et éviter les résultats indésirables, il est crucial de conserver un ensemble de données de formation comprenant une variété de sources et de types de données. Cet ensemble de données doit être composé à la fois de données synthétiques générées par le modèle et de données réelles qui représentent avec précision la complexité du problème. Il est important de mettre régulièrement à jour cet ensemble de données avec des informations nouvelles et pertinentes. Le modèle est exposé à un large éventail de modèles en incorporant diverses données de formation. Cela aide à éviter la stagnation des données.

Actualiser régulièrement les données synthétiques

L’effondrement des modèles constitue un risque lorsque les modèles d’IA s’appuient fortement sur leurs propres données générées. Pour atténuer efficacement les risques liés à l’IA, il est important d’introduire régulièrement de nouvelles données authentiques et réelles dans le pipeline de formation. Cette pratique garantit que le modèle reste adaptatif et évite de rester coincé dans une boucle répétitive. Cela peut aider à générer des résultats divers et pertinents.

Augmentez les données synthétiques

L'amélioration des données synthétiques grâce à des techniques d'augmentation des données est une méthode éprouvée pour empêcher l'effondrement du modèle. Ces techniques introduisent de la variabilité dans les données synthétiques en utilisant les variations naturelles des données du monde réel. L'ajout de bruit contrôlé aux données générées encourage le modèle à apprendre un plus large éventail de modèles, réduisant ainsi les risques de génération de sorties répétitives.

Suivi et évaluation régulière

La surveillance et l'évaluation régulières des performances des modèles d'IA sont cruciales pour la détection précoce de l'effondrement du modèle. La mise en œuvre d'un cadre MLOps garantit une surveillance continue et un alignement avec les objectifs d'une organisation, permettant ainsi des interventions et des ajustements en temps opportun.

[Lire aussi : Comment éviter les violations de conformité lors du développement de produits d'IA]

Réglage fin

Il est important d’envisager la mise en œuvre de stratégies de réglage fin pour maintenir la stabilité du modèle et éviter son effondrement. Ces stratégies de prévention des défaillances du modèle d'IA permettent au modèle de s'adapter aux nouvelles données tout en préservant ses connaissances antérieures.

Analyse de biais et d’équité

Une analyse rigoureuse des biais et de l’équité est cruciale pour prévenir l’effondrement du modèle et les problèmes éthiques. Il est essentiel d'identifier et de corriger les biais dans les résultats du modèle. Vous pouvez maintenir des résultats de modèle fiables et impartiaux en répondant activement à ces préoccupations.

Boucles de rétroaction

La mise en œuvre de boucles de rétroaction intégrant les commentaires des utilisateurs est cruciale pour éviter l’effondrement du modèle. En collectant systématiquement les informations des utilisateurs, des ajustements éclairés peuvent être apportés aux résultats du modèle. Ce processus de raffinement garantit que le modèle reste pertinent, fiable et aligné sur les attentes des utilisateurs.

Comment Appinventiv peut-il contribuer à l'atténuation des risques dans les modèles d'IA ?

Dans le paysage en évolution de l’IA, les défis posés par l’effondrement des modèles préoccupent à la fois les géants de la technologie et les innovateurs. La détérioration à long terme des ensembles de données des modèles linguistiques et la manipulation des contenus ont laissé leur marque sur cet écosystème numérique.

À mesure que l’IA progresse, il est essentiel de faire la différence entre les données générées artificiellement et le contenu généré par l’homme. La frontière entre le contenu authentique et ce qui est généré par une machine devient de plus en plus floue.

Désormais, face à ces défis et pour éviter l'échec des modèles d'IA, un partenariat avec une société de développement d'IA dédiée comme Appinventiv peut vous apporter le réconfort dont vous avez tant besoin. Grâce à notre expertise dans le développement de modèles d’IA et à notre engagement envers des pratiques éthiques en matière d’IA, nous pouvons vous aider à naviguer dans les complexités de l’IA tout en garantissant la fiabilité et l’intégrité de vos systèmes d’IA.

Nos experts peuvent travailler avec vous pour lutter efficacement contre l'effondrement des modèles d'IA, promouvoir la transparence et construire un avenir avec un contenu authentique qui ne compromet pas l'authenticité du contenu généré par l'homme.

Nous comprenons que la formation des modèles d’IA avec des données récentes et diversifiées est essentielle pour éviter la dégradation des modèles. L'évaluation des modèles d'IA est une étape cruciale dans notre processus de développement de modèles qui utilise des métriques pour évaluer les performances, identifier les faiblesses et garantir des prévisions futures efficaces.

Notre équipe d’experts peut vous aider à garantir que vos systèmes d’IA continuent d’apprendre et de s’adapter à l’évolution du paysage numérique. Contactez nos experts pour atténuer les risques associés à l’effondrement des modèles et garantir leur efficacité.

FAQ

Q. Qu'est-ce que l'effondrement du modèle d'IA ?

A. L'effondrement du modèle d'IA dans l'apprentissage automatique fait référence à l'incapacité du modèle d'IA à produire une gamme diversifiée de résultats utiles. Au lieu de cela, cela génère des résultats répétitifs ou de mauvaise qualité. Ce problème peut survenir dans différents types de modèles, mais il est particulièrement observé lors de la formation de modèles complexes comme les réseaux contradictoires génératifs (GAN).

Q. Quelles sont les causes courantes de l’effondrement du modèle d’IA ?

R. Les causes courantes de l'effondrement des modèles d'IA comprennent la perte d'événements rares, l'amplification des biais, le rétrécissement des capacités génératives, les erreurs d'approximation fonctionnelle, etc. Ces facteurs peuvent conduire à des modèles produisant des résultats sous-optimaux.

Q. Comment puis-je empêcher l’effondrement du modèle d’IA ?

R. Pour prévenir efficacement l'effondrement des modèles d'IA, il est essentiel d'utiliser des données d'entraînement différentes et similaires au monde réel, de surveiller et d'évaluer en permanence les données, de corriger tout biais et de mettre en œuvre des tests et un contrôle qualité rigoureux. Le partenariat avec les experts en IA d'Appinventiv peut vous offrir des informations et des solutions précieuses pour atténuer les risques d'effondrement du modèle.