Le « pourquoi » derrière les baisses majeures du trafic SERP dans le SaaS et au-delà

Publié: 2024-05-31Contenu de l'article

Les baisses de trafic sur un site Web peuvent provenir de diverses causes, notamment les tendances des mots clés, les efforts de rebranding et les pénalités.

Cependant, certains déclins sont déclenchés par des changements insaisissables dans les algorithmes de recherche qui obligent les entreprises à chercher des réponses, en particulier dans le domaine SaaS. Ces mises à jour d’algorithmes peuvent avoir un impact profond, ébranlant la stabilité des stratégies de marketing biologique. Des discussions récentes, comme ce Tweet soulignant la baisse notable du trafic de ClickUp au cours des derniers mois, soulignent ces préoccupations.

Selon Ahrefs, @clickup a perdu environ 50 % de son trafic organique en deux mois.

Ils sont passés de 1,9M début février à 900K désormais.

pic.twitter.com/xUDOKkNieo

– Nico Cerdeira (Failory.com) (@nicocerdeira) 2 mai 2024

Les entreprises SaaS et autres doivent rester vigilantes et adaptatives pour faire face à ces changements imprévisibles dans les algorithmes des moteurs de recherche et maintenir leur visibilité en ligne. Comprendre les subtilités de ces baisses de trafic est crucial pour soutenir la croissance et éviter les pièges des baisses induites par les algorithmes.

Incertitude (et controverse) dans SEOland

Il y a beaucoup d'incertitude et plus qu'une petite controverse dans SEOland ces jours-ci. Cela est dû en grande partie au fait qu’il existe une baisse notable du trafic Web total dans tous les secteurs.

Selon le rapport de référence sur l'expérience numérique 2024 de Contentsquare , la variation totale du trafic d'une année sur l'autre était de -3,6 % l'année dernière. La baisse a été encore plus prononcée dans des secteurs tels que les services (-9,4 %), l'énergie, les services publics et la construction (-8,3 %) et les logiciels (-7,8 %).

![Changement de trafic d'une année sur l'autre par secteur [Contentsquare]](/uploads/article/23621/NXsGWAwvlNFBBqzK.png)

Des plateformes sociales et forums aux événements industriels, les spécialistes du marketing sont particulièrement préoccupés par la poule aux œufs d’or de la croissance du trafic Web : la recherche organique.

Les analystes de marché et les sociétés de recherche estiment la valorisation de l'industrie mondiale du référencement entre 70 et 80 milliards de dollars . De grands éditeurs de logiciels, des agences et d'innombrables professionnels opèrent dans cet espace, sans parler de toutes les entreprises qui s'appuient sur cette pratique.

Il est compréhensible que les gens soient si préoccupés par la trajectoire de cette industrie.

Examiner le « pourquoi » derrière les pertes de trafic majeures dans le secteur technologique et au-delà

L’un des défis majeurs pour l’industrie du référencement (et pour toute entreprise ayant besoin d’une empreinte numérique) est que les moteurs de recherche comme Google sont une boîte noire.

Nous pouvons analyser les entrées (les requêtes, les sites Web et les pages Web) et suivre les sorties (la position SERP), mais il n'y a aucun moyen pour quiconque de l'extérieur de savoir pleinement tout ce qui entre dans les décisions de classement. Et, selon des milliers de documents divulgués sur l'API de recherche Google , les facteurs de classement sont quelque chose sur lequel le géant de la technologie n'est pas honnête.

Google tente de clarifier les choses avec les commentaires de Search Central ou les déclarations de son agent de liaison de recherche et de ses porte-parole comme John Mueller. Mais il y a encore tellement de choses que nous ne savons pas. Heureusement, avec des centaines de milliers de référenceurs, il est possible de collecter des informations en crowdsourcing.

Il existe plusieurs raisons principales pour lesquelles les principaux sites des secteurs de la technologie, des médias et d'autres secteurs subissent des perturbations aussi importantes en termes de trafic Web organique et global, qui sont toutes liées soit aux mesures prises par Google, soit à l'émergence de l'IA :

- Contenu utile, abus de réputation et mises à jour de Google Core

- La présence croissante de discussions et de contenus de forum générés par les utilisateurs

- L’essor du contenu généré par l’IA

- L'expérience générative de recherche

Jetons un coup d'œil à chacun d'eux maintenant.

Mises à jour principales de Google

Selon Seach Central , Google apporte plusieurs « changements importants et importants à [leurs] algorithmes et systèmes de recherche » au cours d'une année. Il n'est pas rare que des sites Web de haut rang subissent une volatilité SERP après une mise à jour principale, même s'ils « n'ont pas violé les politiques anti-spam [de Google], ni été soumis à une action manuelle ou algorithmique ».

Les référenceurs expérimentés savent depuis plus d'une décennie qu'il existe une période de correction après une mise à jour principale ou tout autre changement important et qu'il ne faut pas réagir de manière excessive. Les dommages collatéraux se corrigent généralement avec le temps (du moins en théorie).

Mais les mises à jour de ces dernières années ont été une autre histoire.

Mise à jour du contenu utile

La première mise à jour du contenu utile (HCU) a été lancée en août 2022 dans le but d'identifier et de cibler automatiquement le contenu créé principalement pour être bien classé dans les moteurs de recherche au lieu d'aider les utilisateurs. Cette mise à jour a été étendue au-delà des sites Web anglais à toutes les langues fin 2022.

En septembre 2023, Google a de nouveau mis à jour le HCU au cours d’un déploiement de deux semaines qui a aidé un « classificateur amélioré » avec peu de détails. Cette mise à jour a entraîné une baisse significative du classement des sites Web dans tous les secteurs, dont beaucoup ne se sont pas encore rétablis.

Mise à jour rapide sur les sites impactés par le HCU(X) de septembre : maintenant que nous en sommes à deux semaines de la mise à jour principale de mars, j'ai analysé les chiffres de visibilité de plusieurs centaines de sites impactés par le HCU(X) de septembre. Je n'en ai pas encore vu un qui ait récupéré. En fait, la plupart étaient encore plus en baisse (voir… pic.twitter.com/MPFPGZdu9u

– Glenn Gabe (@glenngabe) 21 mars 2024

En mars dernier, Google a intégré le HCU dans ses principaux systèmes de classement dans le but de réduire de 40 % le contenu inutile et de mauvaise qualité. Google aurait atteint ce critère, mais il est clair que de nombreux spectateurs innocents sont également impliqués dans le mélange.

Mise à jour anti-spam

Pour rendre l'analyse du problème encore plus complexe, l'intégration de HCU en mars 2024 a coïncidé avec un autre changement connexe apporté à l'algorithme de Google : la mise à jour anti-spam. Google a déployé cette mise à jour pour lutter contre le « contenu spammé de mauvaise qualité » en ciblant trois tactiques manipulatrices :

- Abus de contenu à grande échelle : utiliser l'automatisation (c'est-à-dire l'IA ou les usines de contenu) pour produire en masse du contenu ciblant les requêtes de recherche populaires.

- Abus de domaine expiré : acheter des domaines expirés et les réutiliser pour améliorer la visibilité du contenu de mauvaise qualité.

- Abus de réputation de site : tirer parti de l'autorité élevée du site et de la réputation de la marque pour héberger du contenu de moindre qualité provenant d'un tiers à des fins de classement.

La mise à jour sur l'abus de réputation de site a reçu beaucoup d'attention au cours du mois dernier, notamment parce qu'elle a touché un certain nombre de sites Web très respectés comme Reuters, le Washington Post, GQ et le Wall Street Journal.

Glen Allsopp a souligné l'étendue de l'impact initial de la mise à jour dans ce Tweet :

Depuis mars, j'ai surveillé 2 500 termes axés sur les coupons pour voir ce que Google change avec sa mise à jour sur l'abus de réputation de site.

Aujourd’hui, les actions manuelles ont commencé, et voici quelques premiers aperçus.

J'ai suivi beaucoup de contenu tiers sans coupon que j'allais… pic.twitter.com/dCbPgOTD9Q

–Glen Allsopp (@ViperChill) 7 mai 2024

Alors que la volatilité post-mise à jour a atteint de nouveaux sommets au cours des dernières années, il est crucial que les marques soient vigilantes dans la surveillance des performances Web et SERP.

Discussions et contenu du forum

Construire une présence sur des plateformes de forum comme Reddit et Quora est un élément clé des activités marketing telles que la recherche, la distribution de contenu et l'engagement communautaire. Eh bien, vous pouvez maintenant ajouter une visibilité SERP à cette liste.

Au cours des dernières années, Reddit et Quora ont commencé à dominer les premières positions SERP pour plusieurs requêtes différentes. Alors que le trafic organique des sites professionnels et médiatiques a chuté au cours de la dernière année, Reddit et Quora ont connu une augmentation exponentielle du trafic.

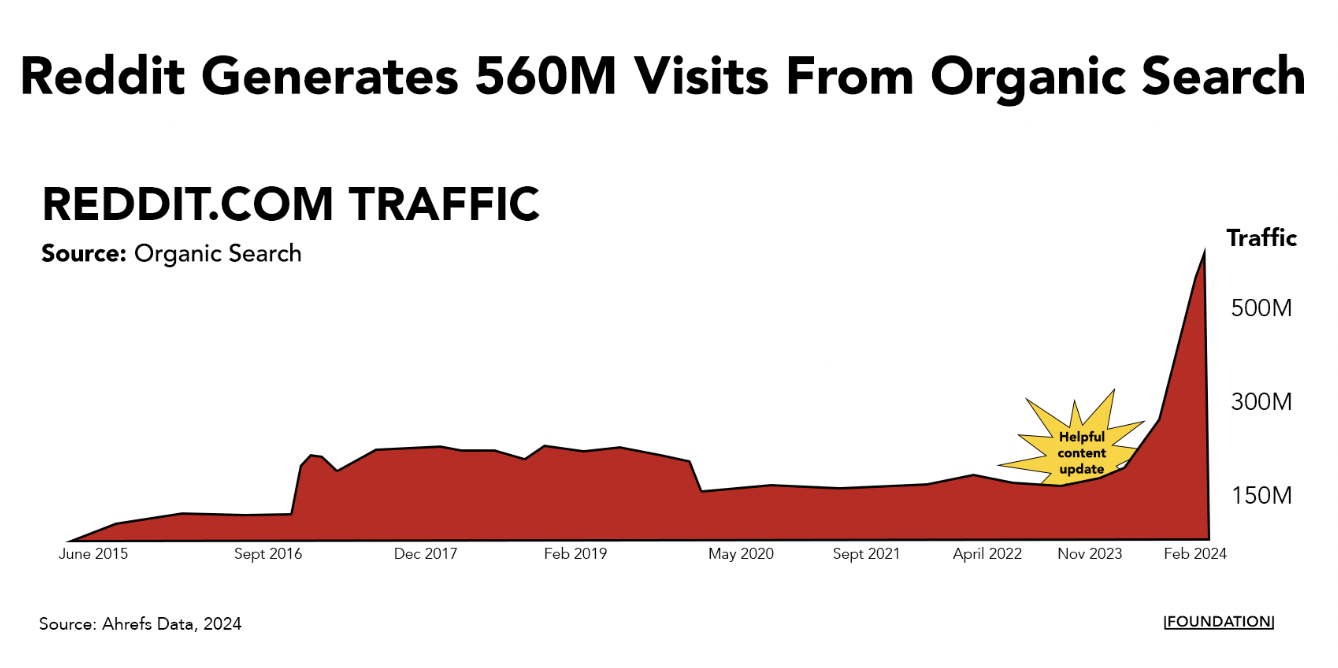

Reddit génère à lui seul plus de 560 millions de visites de recherche organique chaque mois et se classe désormais parmi les trois premières positions pour près de 11 millions de mots-clés.

Ce type de forte pente suggère qu'il existe un avantage algorithmique en jeu pour ces types de forums populaires. Mike Sullivan, responsable de la recherche Google, l'a admis lors d'un échange avec Lily Ray sur X :

Cette unité apparaît automatiquement si les systèmes pensent qu'elle pourrait être pertinente et utile. Je ne suis pas comme si quelqu'un disait « mettez-le en premier pour cette requête particulière » – ce que je sais que vous comprenez, mais d'autres qui liront ceci pourraient ne pas le faire. Cela dit, je peux comprendre l'inquiétude et le problème, et j'ai…

– Google SearchLiaison (@searchliaison) 3 avril 2024

Il est certainement vrai que les gens sont attirés par les discussions sur les forums sur ces plateformes, en particulier lorsqu'ils recherchent des opinions non filtrées sur des produits et des services. (J'utilise Reddit et Quora de cette manière tout le temps.)

Cela dit, il existe de nombreux exemples de cas où le sujet en question mérite une réponse plus expérimentée que celle que vous obtenez lors de discussions Reddit (principalement) anonymes. Des requêtes Your Money or Your Life (YMYL) sur des sujets importants en matière de santé et de finance, par exemple.

Il est également possible que de petits ajustements de l'algorithme donnant la priorité à ce type de contenu profitent à Reddit et Quora, car ils disposent de sites Web et de niveaux d'autorité de domaine très volumineux.

Quelle que soit la raison, il ne semble pas que Google se détournera des forums de si tôt : ils viennent d'annoncer un accord majeur avec Reddit dans le cadre duquel ils utiliseront les données de la plateforme pour entraîner leur IA. Ce n'est qu'une autre des nombreuses raisons pour lesquelles vous devez établir une présence sur la plateforme.

Contenu généré par l'IA

Le contenu généré par l'IA a pris d'assaut le monde peu de temps après que ChatGPT ait lancé le boom de l'IA générative il y a quelques années. Même certaines grandes marques SaaS comme CNET ont utilisé cette stratégie.

À cette époque, toutes sortes de gourous du marketing et des affaires cherchaient à l’utiliser comme tactique de piratage de croissance en produisant en masse du contenu SEO. Sur LinkedIn et X, il y a eu de nombreux exemples très médiatisés de personnes se vantant des résultats qu'elles ont obtenus en produisant une quantité massive de contenu généré par l'IA.

L'un des plus grands exemples est le SEO Heist, où quelqu'un a pris le plan du site d'un site Web appelé Exceljet, a transformé la liste d'URL en titres d'articles, puis a utilisé l'IA pour générer plus de 1 800 pages sur exactement les mêmes sujets. Cette stratégie a étonnamment bien fonctionné, le site de braquage générant des centaines de milliers de visites mensuelles aux dépens d'Exceljet.

Cependant, les experts qui ont suivi cette stratégie ont constaté que les gains initiaux que les entreprises tirent du contenu de l’IA disparaissent souvent.

Mark Williams-Cook , par exemple, a suivi la montée et la chute d'un certain nombre de sites Web qui se sont engagés dans des stratégies de SEO Heist ou de mise à l'échelle de l'IA. La plupart de ces sites constatent une forte augmentation du trafic organique à court terme – généralement quelques mois, mais cela peut être plus long dans certains cas – avant de connaître une forte baisse qui indique que l’algorithme a fait son chemin.

Belle mise à jour @sistrix du site Web « SEO Heist » qui utilisait l'IA pour créer du contenu. On dirait que c’est sur le point de se retrouver dans un endroit pire qu’au début. pic.twitter.com/SKY2ViXiwV

– Mark Williams-Cook (@markcandour) 4 décembre 2023

Ainsi, si vous constatez une baisse significative du trafic de recherche, considérez les éléments suivants :

- Votre entreprise utilise-t-elle l'IA pour générer beaucoup de contenu SEO (probablement de mauvaise qualité) à grande échelle ?

- Y a-t-il de nouveaux sites Web qui apparaissent dans les SERP exacts que vous essayez de cibler ?

Si c’est le premier cas et que vous investissez déjà dans la création de contenu de qualité, cela se résoudra probablement avec le temps. Si c'est le dernier cas, il est temps d'améliorer votre flux de travail de contenu IA .

Vous pouvez faire évoluer la production de contenu avec l’IA, mais il doit s’agird’augmenteret non de remplacer votre équipe. Les écrivains peuvent utiliser des outils tels que ChatGPT, Jasper ou Gemini pour rationaliser l'idéation, la recherche et les étapes intermédiaires, laissant ainsi plus de temps pour la narration créative.

Pour éviter les pénalités potentielles et soutenir la croissance du trafic à long terme, assurez-vous que votre contenu assisté par l'IA ajoute une réelle valeur, offre des informations uniques et maintient un niveau de qualité élevé.

Consultez notre liste de contrôle pour l'élévation du contenu assistée par l'IA pour un guide étape par étape sur la création de contenu de grande valeur à grande échelle.

Expérience générative de recherche

Le contenu spam et les braquages SEO ne sont pas le seul impact que l’IA a sur les SERP. L'optimisation générative des moteurs est sur le point d'avoir un impact sur les chiffres du trafic à mesure que les gens commencent à utiliser l'IA au lieu des moteurs de recherche traditionnels.

Google s'y est déjà préparé. La société a annoncé une nouvelle fonctionnalité de résumé générée par l'IA, AI Overviews, optimisée par son propre LLM. Il est actuellement déployé aux États-Unis et suscite des critiques très mitigées .

Un premier rapport de Tomasz Rudzki et Ziptie.dev montre que les aperçus de l'IA de Google apparaissent en moyenne dans plus de 80 % des requêtes.

En particulier, l’étude souligne que certaines niches, comme la FinTech, peuvent être plus à l’abri des AIO que d’autres. Mais pour la plupart, les réponses du SGE sont dominantes. Ces réponses générées par l’IA apparaissent automatiquement dans environ un tiers des SERP, tandis que le reste du temps, les utilisateurs doivent cliquer pour les générer.

Alors, qu’est-ce que tout cela signifie pour les marques ? Il est temps de donner la priorité à l'expérience générative de recherche (SGE) : des parcours de recherche plus immersifs et personnalisés que les parcours traditionnels, grâce à l'IA.

Bien qu'ils soient très différents des SERP Google traditionnels, des outils tels que ChatGPT, Gemini et Perplexity incluent les URL des sites qu'ils utilisent pour générer des résultats.

Il est encore trop tôt pour dire exactementen quoile SGE/GEO sera différent du référencement traditionnel, mais il existe certainement certaines similitudes. Pour optimiser la SGE, les entreprises doivent se concentrer sur la fourniture d’informations claires, concises et précises qui peuvent être facilement analysées par les systèmes d’IA. Cela inclut des données structurées, des réponses bien formatées aux questions courantes et un contenu qui répond directement à l'intention de l'utilisateur.

Rassurez-vous, c'est quelque chose que nous, à la Fondation, et le reste de l'industrie, surveillerons de près à l'avenir.

Élargissez votre portée au-delà de la recherche avec un moteur de distribution

Le paysage de la recherche organique subit des changements importants en raison des mises à jour des algorithmes et de l’essor de l’IA – et l’inquiétude est compréhensible. Mais ce qui est plus important, c'est l'action.

D’une part, les entreprises doivent s’adapter en se concentrant sur un contenu de haute qualité centré sur l’utilisateur et en tirant parti des nouvelles opportunités présentées par les technologies d’IA. Même si l'impact des nouvelles présentations de l'IA commence tout juste à se faire sentir, il est important d'étendre votre portée au-delà des méthodes de recherche traditionnelles.

Investissez dans un manuel de distribution complet pour vous assurer que vous pouvez maintenir et développer votre présence en ligne dans cet environnement en évolution.