Comment l’IA explicable peut débloquer le développement responsable et éthique de l’intelligence artificielle

Publié: 2023-09-01Avec des moments de transformation alliant innovation et ingéniosité, comme le lancement de ChatGPT d'OpenAI en novembre 2022, la vision d'une IA contrôlant nos vies n'est plus de la science-fiction.

Le moment décisif du lancement de ChatGPT a marqué le début de ce que l'industrie appelle « l'explosion cambrienne de l'IA ».

Cependant, il ne s’agit pas seulement d’utiliser l’IA à des fins commerciales, ce qui constitue actuellement le point central de cette explosion. Au cœur de cette évolution se trouve un appel à se concentrer sur l’explicabilité de l’IA. Cela garantira que les progrès de l’IA soient à la fois puissants et transparents, ce qui est fondamental pour le développement éthique de l’IA.

L’intelligence artificielle prend déjà des décisions à notre place dans de nombreux domaines. Mais ne pas comprendre comment l’IA parvient à ces décisions reste un goulot d’étranglement. Il s’agit d’un avantage explicable de l’IA que les entrepreneurs et les experts en technologie ne peuvent se permettre d’ignorer.

À mesure que la technologie progresse, le défi des experts en technologie est double : repousser les limites de ce que l’IA peut réaliser tout en garantissant que son fonctionnement est transparent, responsable et éthiquement sain. Cela met en évidence le rôle de l’IA explicable dans la technologie moderne.

Le potentiel économique de l’IA

Le potentiel de l’IA générative à révolutionner la productivité n’est pas seulement théorique ; cela devrait avoir des ramifications économiques tangibles à l’échelle mondiale. Selon un rapport de juin 2023 intitulé « Le potentiel économique de l’IA générative : la prochaine frontière de productivité » publié par McKinsey, l’IA générative pourrait ajouter une valeur allant de 2 600 milliards à 4 400 milliards de dollars par an dans les 63 cas d’utilisation analysés. Il existe également des cas d’utilisation explicables de l’IA qui peuvent profiter aux industries de plusieurs manières nouvelles.

Lisez aussi : Comment l’IA générative pour les entreprises façonne les industries

Le Washington Post a rapporté que plus de 11 000 entreprises ont utilisé les outils OpenAI fournis par la division cloud de Microsoft, soulignant les tendances d'adoption qui accompagnent ce potentiel. Ces chiffres représentent des opportunités et des responsabilités pour les leaders technologiques qui évoluent dans ce paysage en évolution.

À mesure que le potentiel de transformation de l’IA devient évident, l’accent est de plus en plus mis sur les principes explicables de l’IA, garantissant que ces outils puissants fonctionnent avec clarté, surveillance et considérations éthiques. Les applications d’IA explicables devraient devenir la pierre angulaire de l’industrie technologique.

Pourtant, comprendre les avantages explicables de l’IA et d’autres facettes connexes n’est qu’un début. Par conséquent, avant de discuter en détail des nuances du développement de l’IA explicable, nous devons d’abord comprendre pourquoi il est essentiel.

Le mystère des modèles d'IA : naviguer dans la « boîte noire »

Comme toute avancée significative, l’IA pose des défis, dont certains sont profondément liés à sa structure. L'une des facettes de ce mystère est la « boîte noire ». Il s'agit d'un modèle opérationnel fermé qui fonctionne, mais même les développeurs sont parfois incapables d'expliquer son fonctionnement. C’est ce qu’on appelle l’énigme de la boîte noire dans l’industrie de l’IA.

Ce manque de transparence est inacceptable pour beaucoup, en particulier pour ceux qui sont responsables de décisions commerciales ou sociétales cruciales. Une IA qui fonctionne sans explicabilité risque d’éroder la confiance, surtout lorsque des pertes physiques et matérielles sont possibles.

Conséquences imprévues : quand l’IA déraille

Les conséquences de décisions inexpliquées en matière d’IA peuvent aller d’inefficacités mineures à des implications sociétales importantes. Prenons le cas du secteur financier : un système d’IA pourrait refuser un prêt à un particulier sans fournir de justification claire.

Une telle décision, dépourvue de transparence, peut entraîner des complications juridiques et nuire à la réputation. À plus grande échelle, dans le domaine des soins de santé, une IA impénétrable pourrait donner la priorité à un patient plutôt qu’à un autre pour le traitement, avec des conséquences qui changeront la vie, voire y mettront fin.

Exemples concrets de résultats et d'incidents inattendus de l'IA

Plusieurs incidents mettent en évidence les conséquences imprévues de l’IA. L’incident tragique de 2018 impliquant la voiture autonome d’Uber souligne les conséquences désastreuses d’une mauvaise interprétation de son environnement par l’IA. Un algorithme de soins de santé de premier plan qui s’est révélé avoir des préjugés raciaux rappelle brutalement que l’IA, aussi avancée soit-elle, peut perpétuer par inadvertance les préjugés humains si elle n’est pas correctement comprise et surveillée.

La liste est longue, depuis Tay de Microsoft, qui a tweeté des choses telles que « Hitler avait raison », à un ressortissant américain recevant des factures de carte de crédit exubérantes. Sans garde-fous et sans capacité à interpréter les décisions prises par l’IA, de tels cas continueront de se produire, d’où l’appel à l’explicabilité.

L’analyse de rentabilisation : avantages explicables de l’IA

Alors que les systèmes d’IA stimulent de plus en plus les ambitions, leur opacité inhérente a suscité des discussions autour de l’impératif de transparence. Au-delà du simple discours technique, il existe une solide justification commerciale qui sous-tend l’adoption de l’IA explicable. Voici les différents avantages explicables de l’IA pour les entreprises de tous les secteurs.

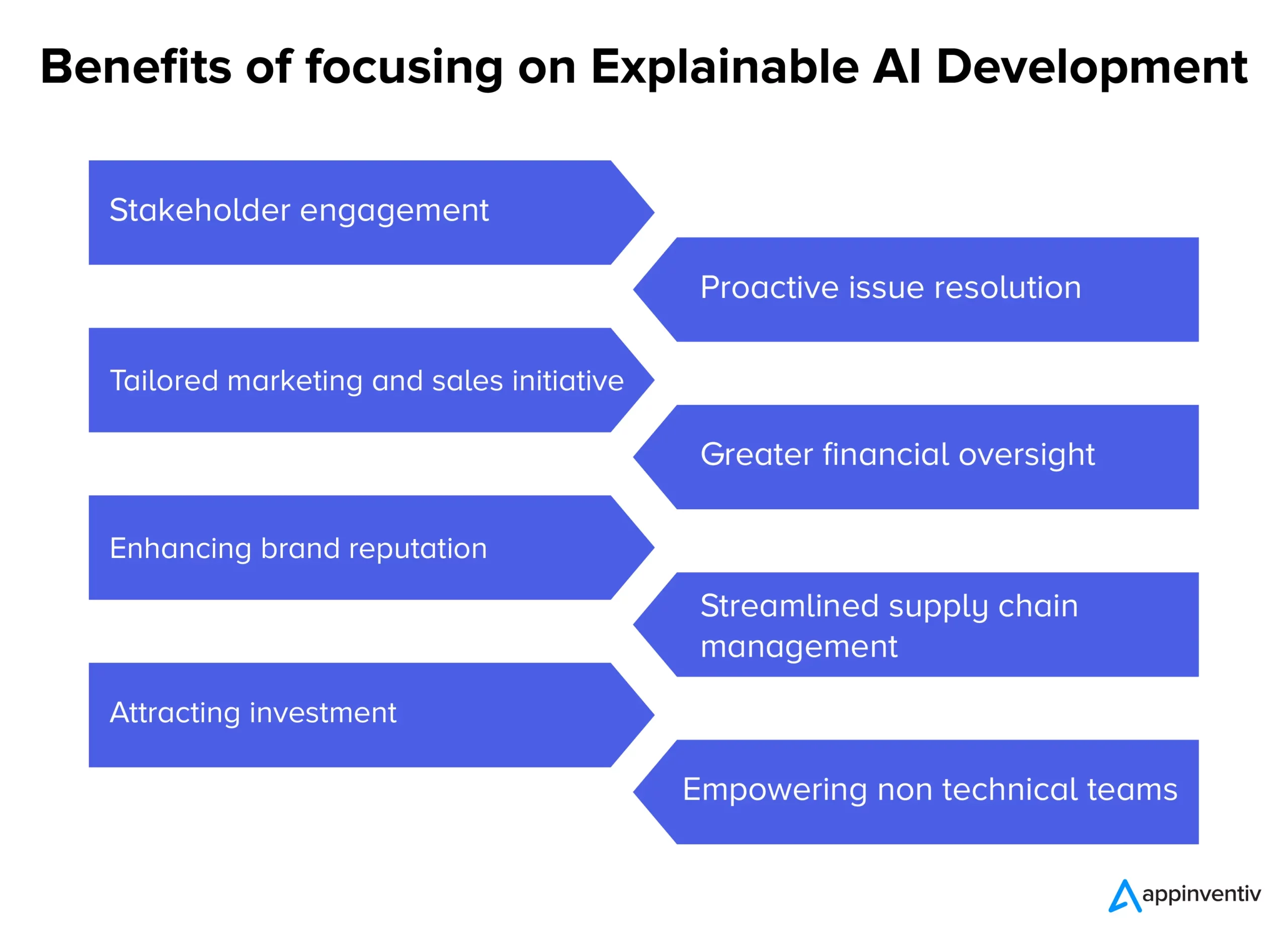

- Engagement et confiance des parties prenantes : des processus décisionnels transparents en matière d'IA peuvent favoriser un sentiment d'implication et d'assurance plus profond parmi les équipes internes et les partenaires externes.

- Résolution proactive des problèmes : avant que les problèmes ne s'aggravent, l'IA explicable peut mettre en évidence les domaines de préoccupation potentiels, permettant ainsi des interventions et des solutions rapides.

- Initiatives de marketing et de vente sur mesure : les entreprises peuvent créer des campagnes plus personnalisées et plus efficaces en comprenant le « pourquoi » derrière les informations sur les consommateurs basées sur l'IA.

- Une meilleure surveillance financière : lorsque les modèles et les prévisions financiers basés sur l'IA sont transparents, les anomalies potentielles ou les domaines de croissance peuvent être plus facilement identifiés et traités.

- Améliorer la réputation de la marque : les entreprises connues pour leurs déploiements d'IA éthiques et transparents bénéficieront probablement d'une réputation de marque accrue.

- Gestion rationalisée de la chaîne d'approvisionnement : grâce à des informations claires basées sur l'IA, les processus de la chaîne d'approvisionnement peuvent être optimisés plus efficacement, de la gestion des stocks à la logistique.

- Attirer les investissements : pour les investisseurs, la transparence de l'IA peut signifier l'engagement d'une entreprise en faveur de l'innovation responsable, ce qui en fait une proposition d'investissement plus attrayante.

- Autonomiser les équipes non techniques : l'IA explicable garantit que les informations et les décisions basées sur l'IA sont accessibles et exploitables pour les équipes ne disposant pas d'une expertise technique approfondie, favorisant ainsi la collaboration interdépartementale.

Alors que les entreprises évoluent dans le paysage complexe de l’ère moderne, s’appuyer sur des solutions de type boîte noire peut s’avérer un pari. L’infusion de transparence dans les processus d’IA n’est pas seulement une mise à niveau technologique ; il s'agit d'une nécessité commerciale, garantissant que chaque mouvement soutenu par l'IA s'aligne sur des objectifs et des valeurs organisationnelles plus larges, ce qui signifie le rôle de l'IA explicable. Il s’agit également de cas d’utilisation explicables de l’IA sur lesquels les entrepreneurs et les développeurs d’IA se concentrent généralement.

Le modèle d’un modèle d’IA explicable

Maintenant que l’impact de l’IA dans notre vie quotidienne devient chaque jour plus évident, il devient crucial de garantir que les machines auxquelles nous confions les décisions critiques sont précises et transparentes dans leur fonctionnement.

Développer un modèle d’IA explicable ne consiste pas seulement à coder ; il s'agit d'un processus qui implique une planification stratégique, des tests rigoureux et un raffinement itératif basé sur des principes d'IA explicables et des outils d'IA explicables. Voici un guide étape par étape et des techniques d'IA explicables qui garantissent que les modèles d'IA que nous développons sont explicables et interprétables tout en étant conformes à la loi.

- Comprendre le domaine du problème : avant de plonger dans le développement du modèle, nous comprenons clairement le domaine du problème et les parties prenantes impliquées. Qu’attendent les utilisateurs ? Quelles décisions l’IA prendra-t-elle et quel impact ces décisions auront-elles sont quelques-unes des questions auxquelles nous trouvons des réponses.

- Sélection des données appropriées : la qualité et la pertinence des données influencent directement la capacité de l'IA à être précise et explicable. Lors du développement de notre modèle d’IA, nous veillons à ce que les données soient propres, diversifiées et exemptes de biais.

- Choisir le bon modèle : si certains modèles, comme les réseaux de neurones profonds, sont plus complexes et plus difficiles à interpréter, d'autres, comme les arbres de décision ou la régression linéaire, peuvent offrir plus de transparence. Nous choisissons un équilibre entre complexité et clarté tout en développant des modèles d’IA explicables.

- Tests itératifs : nous testons régulièrement le modèle avec des ensembles de données variés pour garantir des performances cohérentes. Les commentaires de ces tests peuvent éclairer les améliorations et les améliorations.

- Intégration d'outils d'explicabilité : des outils tels que LIME ou SHAP aident à décomposer les prédictions du modèle, offrant un aperçu des fonctionnalités qui ont influencé une décision particulière.

- Documentation : une documentation complète nous aide à vérifier, valider et déployer le modèle. Il garantit que toutes les parties prenantes comprennent le fonctionnement et les limites de l'IA, des développeurs aux utilisateurs finaux.

Équilibrer les performances du modèle et l’interprétabilité

L’un des défis les plus importants du développement de logiciels d’IA explicable consiste à équilibrer les performances et l’interprétabilité d’un modèle. Même si les modèles complexes peuvent offrir une plus grande précision, ils le font souvent au détriment de la transparence. À l’inverse, des modèles plus simples peuvent être plus faciles à comprendre, mais risquent de ne pas capturer efficacement les nuances des données. Pour trouver le bon équilibre, nous considérons les éléments suivants :

- Simplicité du modèle vs complexité : nous déterminons le niveau minimum de complexité requis pour obtenir des performances satisfaisantes. Si un modèle plus simple suffit, il pourrait s’avérer un meilleur choix pour garantir l’explicabilité.

- Utilisation de techniques d'explicabilité : des techniques telles que le classement par importance des fonctionnalités ou des méthodes indépendantes du modèle peuvent aider à rendre les modèles complexes plus interprétables.

- Boucle de rétroaction : nous maintenons une boucle de rétroaction continue avec les utilisateurs finaux pour comprendre si les décisions de l'IA sont claires et s'il est possible d'améliorer la transparence.

Même si le cheminement vers une IA explicable peut sembler complexe, il est nécessaire. À mesure que nous intégrons davantage l’IA dans nos systèmes et processus, il sera crucial de garantir ces modèles transparents et performants pour une confiance et une efficacité durables.

Comment Appinventiv peut-il vous aider à développer des modèles d'IA explicables ?

Ayant près de neuf ans d'expérience dans le développement de produits d'IA, chez Appinventiv, nous comprenons les différentes subtilités liées au développement de modèles d'IA et les avantages explicables de l'IA. Ayant développé de nombreuses plates-formes et applications basées sur l'IA, notamment Mudra (une application de finances personnelles basée sur l'IA), nos ingénieurs possèdent l'expertise dans le domaine et la supervision nécessaires pour évoluer vers un développement d'IA explicable.

Quel que soit votre projet d'IA, nous, en tant que société leader en développement d'IA, pouvons débloquer l'interprétabilité et l'explicabilité de votre modèle d'IA afin que vous puissiez faire confiance en toute confiance aux décisions prises par les modèles. Entrer en contact

aujourd’hui pour nous lancer sur la voie d’une IA responsable.

Questions fréquemment posées

Q. Qu’est-ce que l’IA explicable ?

A. L'IA explicable est un changement de paradigme dans le développement de l'IA qui nécessite le développement de modèles d'IA de telle manière que les décisions prises par le modèle d'IA puissent être retracées et que les utilisateurs puissent comprendre comment le modèle d'IA prend des décisions.

Q. Comment fonctionne l'IA explicable ?

A. L'IA explicable fonctionne en intégrant des éléments clés d'explicabilité dans les modèles d'IA pendant le développement qui peuvent aider à déterminer comment un modèle d'IA a atteint une décision particulière.

Q. Pourquoi l’IA explicable est-elle importante ?

R. L’IA explicable est importante car ne pas comprendre comment un modèle d’IA prend des décisions à notre place peut entraîner des conséquences désastreuses et, dans le pire des cas, peut entraîner un préjudice tangible pour les entreprises ou les utilisateurs du modèle d’IA en question.