Très visible et de faible qualité (ou inutile) – Une combinaison de référencement des plus dangereuses

Publié: 2024-01-08

Alors que j'ai aidé des entreprises qui ont été fortement touchées par la « Chute des mises à jour d'algorithmes insensées en 2023 », j'ai une fois de plus entendu plusieurs propriétaires de sites qui avaient leurs niveaux de trafic les plus élevés juste avant d'être martelés. J'en parlerai bientôt, mais c'est quelque chose que je vois depuis longtemps. Et maintenant que nous avons lu le témoignage de Google sur Navboost et les signaux d'interaction des utilisateurs lors du dernier procès antitrust, plusieurs idées me viennent à l'esprit.

Tout en aidant les entreprises touchées par des mises à jour majeures d'algorithmes (telles que des mises à jour générales), il est extrêmement important d'exécuter ce que j'appelle un « rapport delta » pour identifier les principales requêtes et pages de destination qui ont été supprimées lors de ces mises à jour. Les rapports Delta peuvent être puissants et aider les propriétaires de sites à déterminer si une baisse est due à des ajustements de pertinence, à des changements d'intention ou à des problèmes généraux de qualité du site. Et si la qualité était le problème, fouiller dans les requêtes et les pages de destination qui ont le plus chuté peut souvent donner des résultats importants. Et ces résultats pourraient aider à identifier le contenu de mauvaise qualité, le contenu léger, le contenu IA de mauvaise qualité, les obstacles à l'expérience utilisateur, la publicité agressive, une configuration d'affiliation trompeuse ou agressive, et bien plus encore.

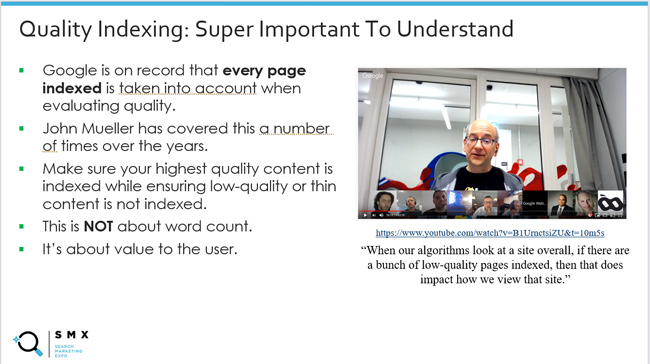

Cela m'a également fait réfléchir une fois de plus à « l'indexation de qualité », dont j'ai parlé à plusieurs reprises dans mes articles et présentations sur les mises à jour majeures des algorithmes. Cela garantit que votre contenu de la plus haute qualité est indexé, tout en garantissant que le contenu de mauvaise qualité ou mince ne soit pas indexé. Ce rapport compte. En effet, nous savons que Google prend en compte chaque page indexée lors de l'évaluation de la qualité. John Mueller de Google l'a expliqué à plusieurs reprises et j'ai partagé ces clips vidéo au fil des ans.

Mais toutes choses créées sont-elles égales du point de vue de la qualité ? En d’autres termes, si vous trouvez sur votre site un lot de contenus de moindre qualité qui n’apparaissent pas souvent dans les résultats de recherche, est-ce la même chose qu’un contenu de moindre qualité (ou inutile) très visible dans les résultats de recherche ?

Les commentaires de John Mueller sur la suppression des contenus de mauvaise qualité ont légèrement changé au fil des années sur ce point. Je l’ai remarqué au fil du temps et cela a toujours piqué ma curiosité. John est passé d'une explication selon laquelle si un élément de contenu est indexé, sa qualité peut être évaluée à une explication qu'il se concentrerait d'abord sur ce qui est très visible et de mauvaise qualité . Je vais expliquer davantage pourquoi cela est tout à fait logique (en particulier avec les nouvelles informations du dernier procès antitrust de Google).

Ci-dessous, je couvrirai rapidement quelques informations générales sur les signaux d'engagement des utilisateurs et le référencement, puis je couvrirai quelques commentaires intéressants de John Mueller de Google au fil des ans sur la suppression du contenu de mauvaise qualité, puis je relierai cela avec Le récent témoignage de Google sur l'exploitation des signaux d'interaction des utilisateurs pour faciliter le classement (c'est-à-dire Navboost).

Tout d’abord, parcourons l’historique et discutons des signaux d’interaction des utilisateurs et de l’impact sur le référencement.

Signaux d'interaction des utilisateurs, référencement et capacité étrange de Google à comprendre le bonheur des utilisateurs :

Avec le dernier procès antitrust de Google, nous avons beaucoup appris sur la manière dont Google exploite les signaux d'interaction des utilisateurs pour influencer les classements. Par exemple, Pandu Nayak de Google a parlé de Navboost, de la manière dont Google collecte 13 mois de données de clics (au lieu de 18 mois auparavant) et de la manière dont ces données peuvent aider Google à comprendre le bonheur des utilisateurs (utilisateurs de recherche satisfaits).

Bien que l'apprentissage de Navboost ait époustouflé de nombreuses personnes (à juste titre), il y avait toujours des signes que Google faisait quelque chose avec les données d'engagement des utilisateurs du point de vue des classements. Personne n'en était vraiment sûr, mais il était difficile d'ignorer le concept en fouillant dans de nombreux sites qui tombaient au fil du temps en raison de mises à jour majeures d'algorithmes (en particulier de mises à jour générales).

Par exemple, j’ai écrit un article en 2014 sur la sinistre augmentation trompeuse du trafic avant l’arrivée d’un algorithme majeur. Notez que Search Engine Watch rencontre des problèmes avec les publications plus anciennes, j'ai donc créé un lien vers la version Wayback Machine de mon message. J'ai écrit cet article après que de nombreuses entreprises m'ont contacté au sujet des énormes succès de Panda et m'ont expliqué qu'elles venaient de connaître leurs niveaux de trafic les plus élevés jusqu'à ce qu'elles tombent en panne avec la prochaine mise à jour.

Pour moi, il semblait que Google obtenait tellement d'informations sur la façon dont les utilisateurs interagissaient avec le contenu des SERP qu'il a fini par contribuer à la baisse. En d’autres termes, Google pourrait constater des utilisateurs mécontents à grande échelle pour ces sites. Et puis boum, ils ont tanké.

Voici une citation de mon article SEW :

En outre, AJ Kohn a également écrit un article en 2015 sur le CTR en tant que facteur de classement. AJ a également travaillé sur de nombreux sites au fil des ans et avait le pressentiment sérieux que les signaux d'interaction des utilisateurs jouaient un rôle dans les classements. Voici une capture d'écran du message d'AJ faisant référence aux commentaires implicites des utilisateurs.

J'ai également beaucoup écrit sur le danger d'un faible temps d'attente et sur la façon dont la mise en œuvre d'un taux de rebond ajusté pourrait aider les propriétaires de sites à avoir une meilleure idée du contenu qui ne répond pas ou ne dépasse pas les attentes des utilisateurs. Cet article date de 2012. Et j'ai développé cette idée avec un autre article en 2018 sur l'utilisation de plusieurs mécanismes de suivi comme proxy du bonheur des utilisateurs (y compris le taux de rebond ajusté, le suivi de la profondeur de défilement et le temps passé sur la page). Notez que c'était pour GA3, pas GA4.

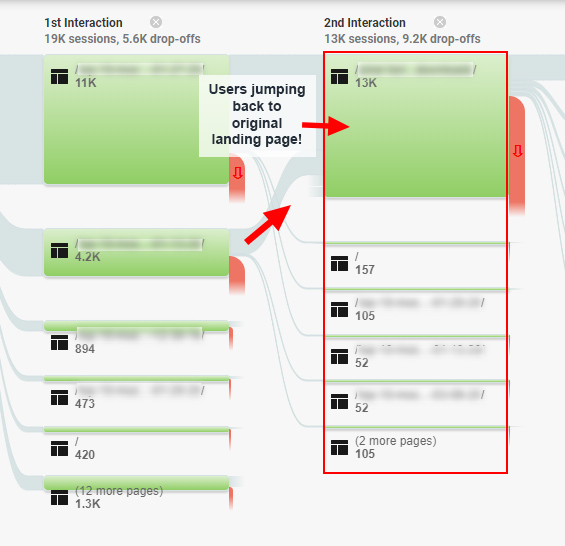

Et comme excellent exemple de la façon dont les problèmes d'engagement des utilisateurs pourraient avoir un impact sur le référencement, il y a une étude de cas que j'ai écrite en 2020 sur le « piège de l'engagement SEO », dans laquelle j'ai trouvé des utilisateurs qui tournaient en rond autour d'un site, et j'en suis sûr qu'en fin de compte, je reviens à les SERP, pour de meilleures réponses. Ce site a été frappé par une vaste mise à jour de base et récupéré après avoir résolu bon nombre de ces problèmes. Alors oui, des signaux d'interaction utilisateur plus négatifs que Google doit évaluer.

Voici une capture d'écran de cet article montrant les rapports de flux de comportement pour les utilisateurs frustrés :

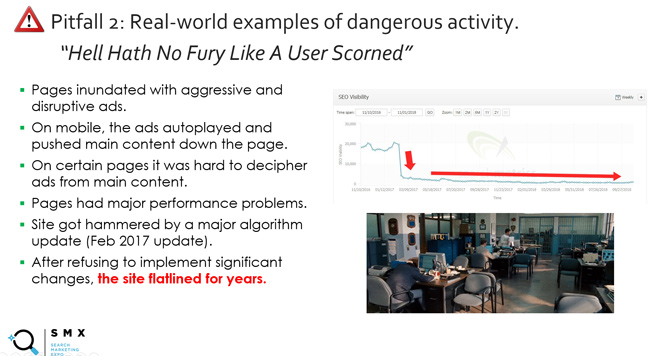

Et il y a la diapositive (et la devise) que j'utilise depuis longtemps dans mes présentations sur les mises à jour générales intitulées « L'enfer n'a pas de fureur comme un utilisateur méprisé ». Cela ne concerne pas seulement la qualité du contenu et inclut la publicité agressive, les obstacles à l'expérience utilisateur, etc. En gros, ne dérangez pas les utilisateurs. Vous paierez un lourd tribut. Et au fait, quel est le meilleur moyen pour Google de comprendre les utilisateurs agacés ? Eh bien, en suivant les signaux d'interaction des utilisateurs comme un faible temps d'arrêt (quelqu'un revient rapidement aux SERP après avoir visité un site de Google).

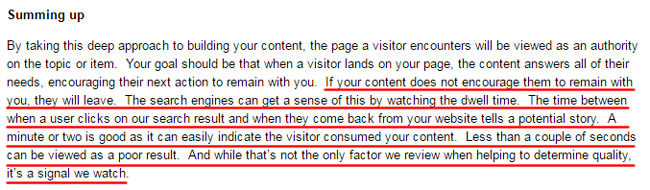

Et sur le thème du temps d'attente, l'une de mes citations préférées date d'il y a des années, lorsque Duane Forrester de Bing a écrit un article de blog expliquant à quel point un temps d'attente faible pouvait avoir un impact sur la visibilité de la recherche. Duane ne travaille plus pour Bing, mais il a été le Matt Cutts de Bing pendant plusieurs années. Dans ce message, qui a maintenant été supprimé (mais peut être trouvé via la Wayback Machine), Duane a expliqué ce qui suit :

« Si votre contenu ne les incite pas à rester avec vous, ils partiront. Les moteurs de recherche peuvent en avoir une idée en surveillant le temps d’attente. Le temps entre le moment où un utilisateur clique sur notre résultat de recherche et le moment où il revient de votre site Web raconte une histoire potentielle. Une minute ou deux suffisent car cela peut facilement indiquer que le visiteur a consommé votre contenu. Moins de quelques secondes peuvent être considérées comme un mauvais résultat. Et même si ce n'est pas le seul facteur que nous examinons pour déterminer la qualité, c'est un signal que nous surveillons.

Puis dans un autre article sur SEJ, Duane a poursuivi en disant :

"Le temps d'attente était l'un de ces concepts qui prenait tout son sens une fois expliqué, et il était immédiatement évident qu'une telle mesure pouvait être très importante pour déterminer la satisfaction des chercheurs."

Et enfin, Duane a expliqué que cela a été pris en compte « dans un mélange de facteurs », ce qui est important à comprendre. Il a expliqué que courir après le temps d'arrêt était une mauvaise idée. Il a expliqué qu'il fallait se concentrer sur des améliorations plus larges pour un site qui augmente l'engagement des utilisateurs (et le temps d'attente peut augmenter grâce à ce travail). C’est également pourquoi je crois que l’approche « évier de cuisine » en matière d’assainissement est une voie efficace à suivre. Résolvez autant de problèmes de qualité que possible et de grandes choses peuvent se produire en fin de compte.

Notez qu'il ne faut pas se concentrer sur le temps accordé par Duane en 2011 pour un « court engagement »… Je suis sûr que c'est l'une des raisons pour lesquelles le message a été supprimé. Pour certains types de contenu, une période de temps plus courte est tout à fait acceptable du point de vue de l'engagement des utilisateurs. Mais le point principal concernant le faible temps de séjour, en particulier lorsqu'il est observé sur de nombreux éléments de contenu d'un site, est extrêmement important à comprendre. C’était le cas à l’époque, et c’est sûrement le cas maintenant.

Le point principal que j'essaie de transmettre est que l'interaction de l'utilisateur a toujours semblé être un facteur d'une manière ou d'une autre… nous ne savions tout simplement pas exactement comment. C'était jusqu'à ce que Navboost soit exposé. J'en parlerai bientôt davantage.

Pourquoi « très visible » est important : commentaires de John Mueller de Google.

OK, regardons maintenant de plus près ce que j'appelle « l'indexation de qualité ». Encore une fois, cela garantit que seul votre contenu de la plus haute qualité qui peut répondre ou dépasser les attentes des utilisateurs est indexé, tout en garantissant que le contenu de mauvaise qualité ou léger n'est pas indexé.

Google a expliqué au fil du temps que toutes les pages indexées étaient prises en compte lors de l'évaluation de la qualité. J'en ai parlé à plusieurs reprises dans mes articles de blog et dans mes présentations sur les mises à jour majeures des algorithmes (en particulier lorsqu'il s'agit de mises à jour générales).

Voici John de 2017 expliquant que :

Mais au fil du temps, j'ai remarqué un changement dans la réponse de John lorsqu'on lui a demandé de supprimer du contenu de moindre qualité. John a commencé à expliquer qu'il se concentrerait sur un contenu « très visible » et de moindre qualité. J'ai entendu cela dans plusieurs vidéos de Hangout Search Central, et il en a également parlé dans une interview avec Marie Haynes.

Voici plusieurs exemples :

Tout d’abord, voici John expliquant que toutes choses ne sont pas égales en termes de contenu. Google essaiera de déterminer les pages les plus importantes et se concentrera sur celles-ci :

Voici John expliquant que Google peut comprendre le contenu principal d'un site, où vont les visiteurs, etc.

Et voici John expliquant que si vous savez que les gens visitent certaines pages, il serait alors logique de s'attaquer d'abord à ces pages de moindre qualité (afin que les gens puissent rester dans les parages.) :

Donc pourquoi est-ce important? Eh bien, maintenant que nous en savons plus sur Google qui exploite les signaux d'interaction des utilisateurs pour avoir un impact sur la visibilité et les classements via Navboost, cette déclaration de John a beaucoup de sens. Plus Google dispose de données d’interaction utilisateur pour les combinaisons de requêtes et de pages de destination, plus il peut comprendre le bonheur des utilisateurs. Si une page est de mauvaise qualité et n'est pas visible, Google ne dispose d'aucune donnée d'interaction avec l'utilisateur. Bien sûr, Google peut utiliser d'autres signaux, le traitement du langage naturel, etc. pour mieux comprendre le contenu, mais les signaux d'interaction des utilisateurs sont incroyables pour comprendre la satisfaction des chercheurs.

Notez qu'avant de continuer, je voulais être clair sur le fait que je m'attaquerais toujours à tous les problèmes de qualité de contenu sur un site (même ceux qui ne sont pas « très visibles »), mais je commencerais par les plus visibles. C'est un point important pour les propriétaires de sites confrontés à une baisse importante des mises à jour de base générales, des mises à jour de contenu utiles ou des mises à jour d'avis.

Le procès antitrust de Google et les signaux d'engagement des utilisateurs influencent les classements.

J'ai mentionné Navboost à plusieurs reprises dans cet article et je voulais en parler dans cette section. Je n'entrerai pas dans les détails car cela a été abordé récemment dans un certain nombre d'autres articles de l'industrie, mais il est important de comprendre.

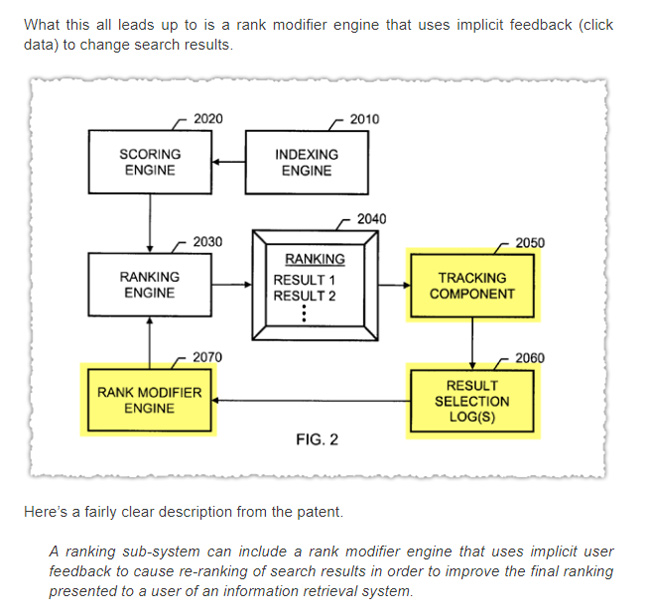

Dans le témoignage antitrust de Google, Pandu Nayak a expliqué l'utilisation de Navboost, un système permettant d'exploiter les données d'interaction des utilisateurs pour aider Google à comprendre le bonheur des utilisateurs. Cela permet essentiellement à Google d'apprendre de ses utilisateurs au fil du temps et d'ajuster les classements en fonction de ces apprentissages. Navboost n'est évidemment pas le seul facteur en jeu, mais c'est un facteur important pour déterminer les classements.

Voici Pandu Nayak sur l'importance de Navboost :

« Je veux dire, il est difficile de donner une sorte de classement comme celui-ci. Je dirai que navboost est important, n'est-ce pas. Je ne veux donc en aucun cas le minimiser. Mais je dirai aussi qu’il existe de nombreux autres signaux qui sont également importants, comme ceux que j’ai mentionnés. Et vous ne pouvez pas vraiment désactiver certaines de ces choses. Je ne sais pas ce que cela signifierait de désactiver l'index des documents. C'est d'une certaine manière la chose la plus importante, les mots sur la page, etc., n'est-ce pas. C'est donc un peu difficile de juger de cette façon. Je dirais donc que navboost est l’un des signaux importants dont nous disposons. »

Ainsi, si les pages sont très visibles pour une requête, Google collecte activement des signaux d'engagement des utilisateurs pour ces URL et combinaisons de requêtes (collectant désormais 13 mois de données de clics). Et Navboost peut utiliser ces signaux d'interaction utilisateur pour aider les systèmes de Google à comprendre le bonheur des utilisateurs (y compris la compréhension du temps d'arrêt, des clics longs, des défilements, des survols, etc.).

Et d’un autre côté, si les pages ne sont pas très visibles pour les requêtes, alors Google ne peut pas exploiter ces signaux d’interaction des utilisateurs… ou pas assez de signaux pour avoir un impact. Cela ne signifie pas que Google ne peut pas comprendre la qualité des pages, mais il lui manquera de véritables signaux utilisateur pour ces combinaisons de requêtes et de pages de destination. Et c'est extrêmement important.

Notez que si vous souhaitez en savoir plus sur les signaux d'interaction des utilisateurs issus du procès antitrust de Google, AJ Kohn a écrit un excellent article couvrant ces informations sur la base du témoignage de Pandu Nayak. Je vous recommande de lire l'article d'AJ si vous ne l'avez pas déjà fait, car il traite davantage de Navboost, des signaux d'interaction des utilisateurs, du CTR en tant que facteur de classement, etc.

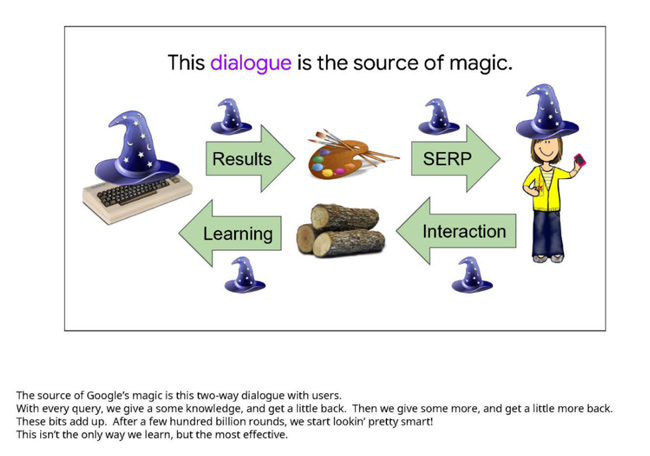

Voici une diapositive d'une présentation de Google qui a servi de preuve lors du procès. Cela souligne l’importance des signaux d’interaction des utilisateurs pour déterminer la satisfaction des chercheurs. Gardez à l’esprit que cette diapositive date d’il y a plusieurs années. Il s'agit de la « source de la magie de Google » :

Et n'oubliez pas les algorithmes de qualité au niveau du site :

Encore une fois, je ne veux pas enliser cet article avec trop d'informations sur le procès antitrust, mais mon point principal est que le contenu « très visible » dans les SERP peut générer une tonne de signaux d'interaction des utilisateurs, que Google peut utiliser comme un facteur de classement. Il est également possible que Google puisse également utiliser ces données de manière globale pour influencer les algorithmes de qualité au niveau du site. Et ces algorithmes au niveau du site peuvent jouer un rôle énorme dans la façon dont les sites se comportent lors des mises à jour générales (et d’autres mises à jour majeures d’algorithmes). J'en parle également depuis longtemps.

Ce que cela signifie pour vous. Ma recommandation pour les propriétaires de sites touchés par des mises à jour majeures d’algorithmes :

Pour les propriétaires de sites fortement impactés par les mises à jour majeures des algorithmes, il est important de prendre du recul et d'analyser globalement un site sous l'angle de la qualité. Et comme John Mueller de Google l'a expliqué précédemment, la « qualité » ne se limite pas au contenu. Il s'agit également de problèmes d'UX, de situation publicitaire, de présentation des choses, etc.

Et maintenant, avec la confirmation que Google exploite les signaux d'interaction des utilisateurs pour avoir un impact sur la visibilité et les classements via Navboost, je pousserais les URL « très visibles » vers le haut de la liste pour décider quoi aborder. Oui, vous devez vous attaquer à tous les problèmes de qualité que vous rencontrez, même les plus grossiers qui pourraient ne pas être très visibles, mais je donnerais la priorité aux URL les plus visibles avant une mise à jour majeure de l'algorithme. Alors oui, l'exécution d'un rapport delta est devenue encore plus importante.

Résumé : affichez tous les contenus de mauvaise qualité, mais commencez par ce qui est « hautement visible ».

Au fil des années, j'ai toujours expliqué que le contenu devait répondre ou dépasser les attentes des utilisateurs en fonction des requêtes. Aujourd'hui, avec le dernier témoignage du procès antitrust de Google, nous disposons de preuves tangibles que Google exploite effectivement les signaux d'interaction des utilisateurs pour ajuster les classements (et éventuellement influencer les algorithmes de qualité au niveau du site). En tant que propriétaire de site, ne laissez pas du contenu de mauvaise qualité, léger ou inutile rester dans les SERP avec lequel les utilisateurs peuvent interagir. Comme je l’ai vu au fil des années avec les mises à jour majeures des algorithmes, cela ne se terminera pas bien. Abordez définitivement tous les problèmes de qualité potentiels sur un site, mais ne négligez pas ce qui est très visible. C’est un excellent point de départ pour améliorer la qualité globale du site.

GG