IA responsable – Relever les défis de l’adoption grâce à des principes directeurs et des stratégies

Publié: 2023-09-08À une époque dominée par l’adoption généralisée de solutions d’IA, il est devenu vital de donner la priorité à un processus de développement responsable tout en adhérant aux principes de sécurité et d’éthique. Alors que ces systèmes d'IA continuent de gagner en capacité et de trouver des applications dans diverses niches industrielles, garantir que leur création s'aligne sur des mesures de sécurité rigoureuses doit être l'une des principales priorités de l'organisation.

Alors, comment peut-on garantir que leurs systèmes basés sur l’IA sont éthiques et n’entraîneront pas de conséquences inattendues ? La réponse simple à cette énigme est le respect des principes de l’IA responsable.

L'IA responsable (RAI) fait référence à un cadre complet en matière d'intelligence artificielle, où les considérations éthiques et le bien-être sociétal occupent une place centrale. Il présente le développement et l’application responsables de systèmes d’IA conçus pour s’harmoniser avec les principes fondamentaux.

Les principes d’IA responsable permettent aux organisations de se concentrer fortement sur la transparence, permettant aux utilisateurs et aux parties prenantes de comprendre le fonctionnement interne des systèmes d’IA. Cette transparence ouvre la voie à une confiance et une responsabilité accrues, permettant aux individus de comprendre comment les décisions en matière d’IA sont prises. La RAI gère également activement les biais au sein des algorithmes d’IA en gérant intelligemment les données et en intégrant des mesures d’équité pour garantir que les résultats sont impartiaux et impartiaux.

Ce blog vous aidera à comprendre les cinq principes de l'IA responsable et comment leur respect peut rendre votre système d'IA juste et juste pour les utilisateurs. En plus d’examiner les avantages de l’adoption d’une IA responsable pour les entreprises, nous vous aiderons également à comprendre les différents défis qui peuvent être relevés en adoptant l’approche rationalisée.

La nécessité d’adopter des stratégies d’IA responsables : atténuer les risques liés à l’IA

En mars 2016, Microsoft a lancé un chatbot IA appelé Tay sur Twitter. L'objectif de Tay était d'apprendre de ses interactions avec les utilisateurs. Malheureusement, certaines personnes ont commencé à publier du contenu offensant sur le robot, ce qui a amené Tay à répondre avec un langage offensant. En quelques heures, Tay s’est transformé en un robot promouvant les discours de haine et la discrimination. Microsoft a rapidement mis Tay hors ligne et s'est excusé pour les tweets inappropriés du robot. Cet incident est un exemple clair de la façon dont l’IA peut mal tourner, et de nombreux cas similaires se sont produits depuis lors.

L’IA recèle un énorme potentiel pour le bénéfice de la société, mais comme le dit Oncle Ben, « un grand pouvoir implique de grandes responsabilités ».

Lorsque vous utilisez l'IA pour prendre des décisions commerciales importantes impliquant des données sensibles, il est essentiel de savoir :

- Que fait l’IA et pourquoi ?

- Fait-il des choix précis et équitables ?

- Est-ce que cela respecte la vie privée des gens ?

- Pouvez-vous contrôler et garder un œil sur cette puissante technologie ?

Les organisations du monde entier réalisent l’importance des stratégies d’IA responsable, mais elles en sont à différents stades de leur parcours pour les adopter. Adopter les principes de l’IA responsable (RAI) est la stratégie la plus efficace pour atténuer les risques associés à l’IA.

Il est donc temps d’évaluer vos pratiques actuelles et de garantir que les données sont utilisées de manière responsable et éthique. L'adoption précoce du RAI réduira non seulement les risques associés à ces pratiques, mais positionnera également les organisations avant leurs concurrents, leur offrant ainsi un avantage concurrentiel qu'il pourrait être difficile de surpasser à l'avenir.

Selon une enquête du MIT Sloan, 52 % des entreprises prennent des mesures pour adopter des pratiques responsables en matière d'IA. Cependant, plus de 79 % de ces entreprises admettent que leurs efforts sont limités en termes d’ampleur et de portée. Le rapport souligne l'importance croissante pour les entreprises de relever les défis et de donner la priorité à l'IA responsable (RAI) à mesure que le rôle de l'IA dans les entreprises continue de croître. Pour façonner un avenir durable et responsable basé sur l’IA, l’établissement d’un cadre éthique solide n’est pas seulement un choix mais est essentiel.

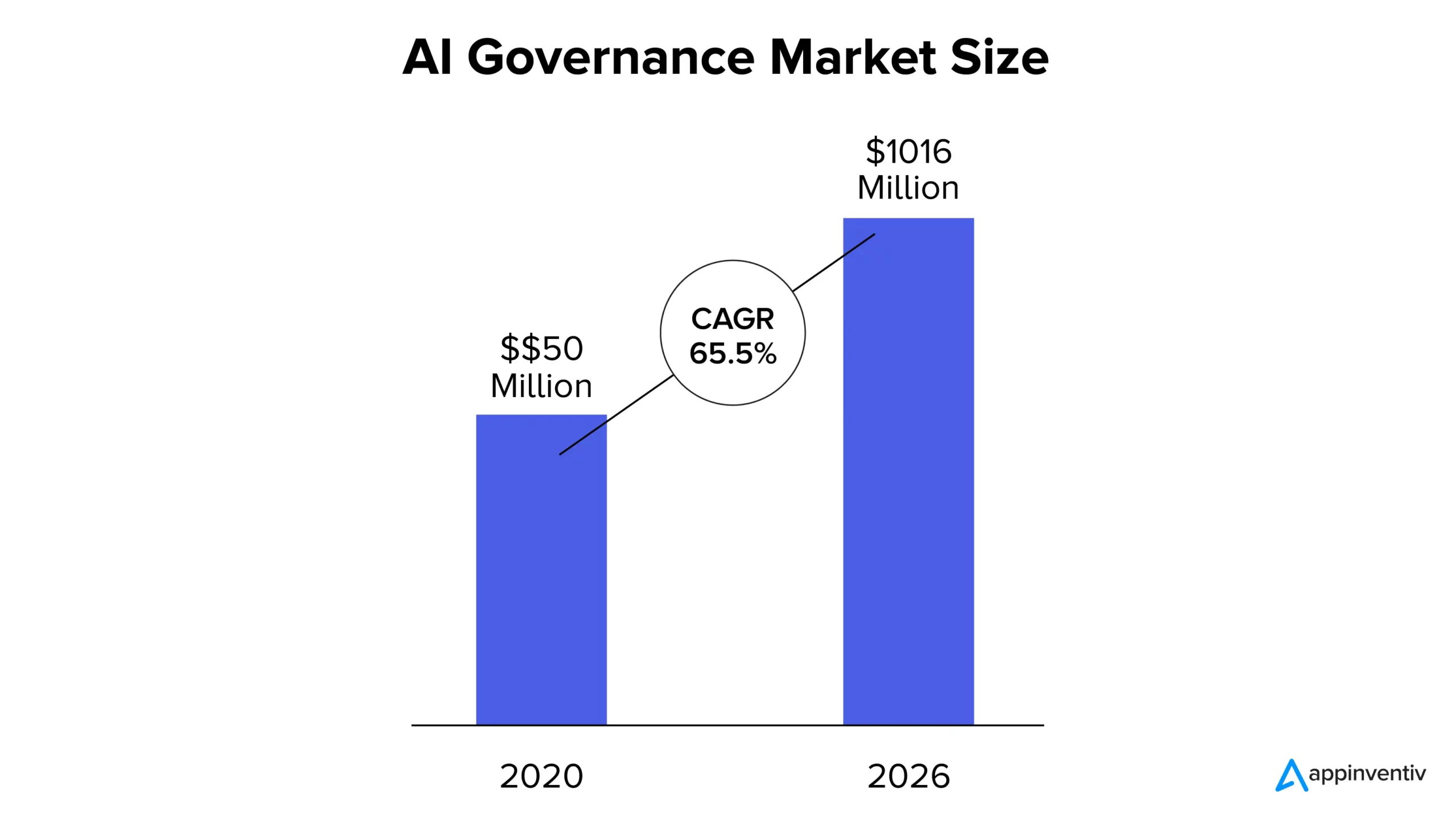

Désormais, selon le rapport MarketsandMarkets, le marché de la gouvernance de l'IA était évalué à 50 millions de dollars en 2020 et devrait atteindre 1 016 millions de dollars d'ici 2026, soit un TCAC de 65,5 %. La part de marché croissante peut être attribuée à la croissance croissante de la transparence dans les systèmes d’IA, au respect des conformités réglementaires et au besoin croissant de confiance dans les solutions basées sur l’IA.

Que sont les principes de l’IA responsable ?

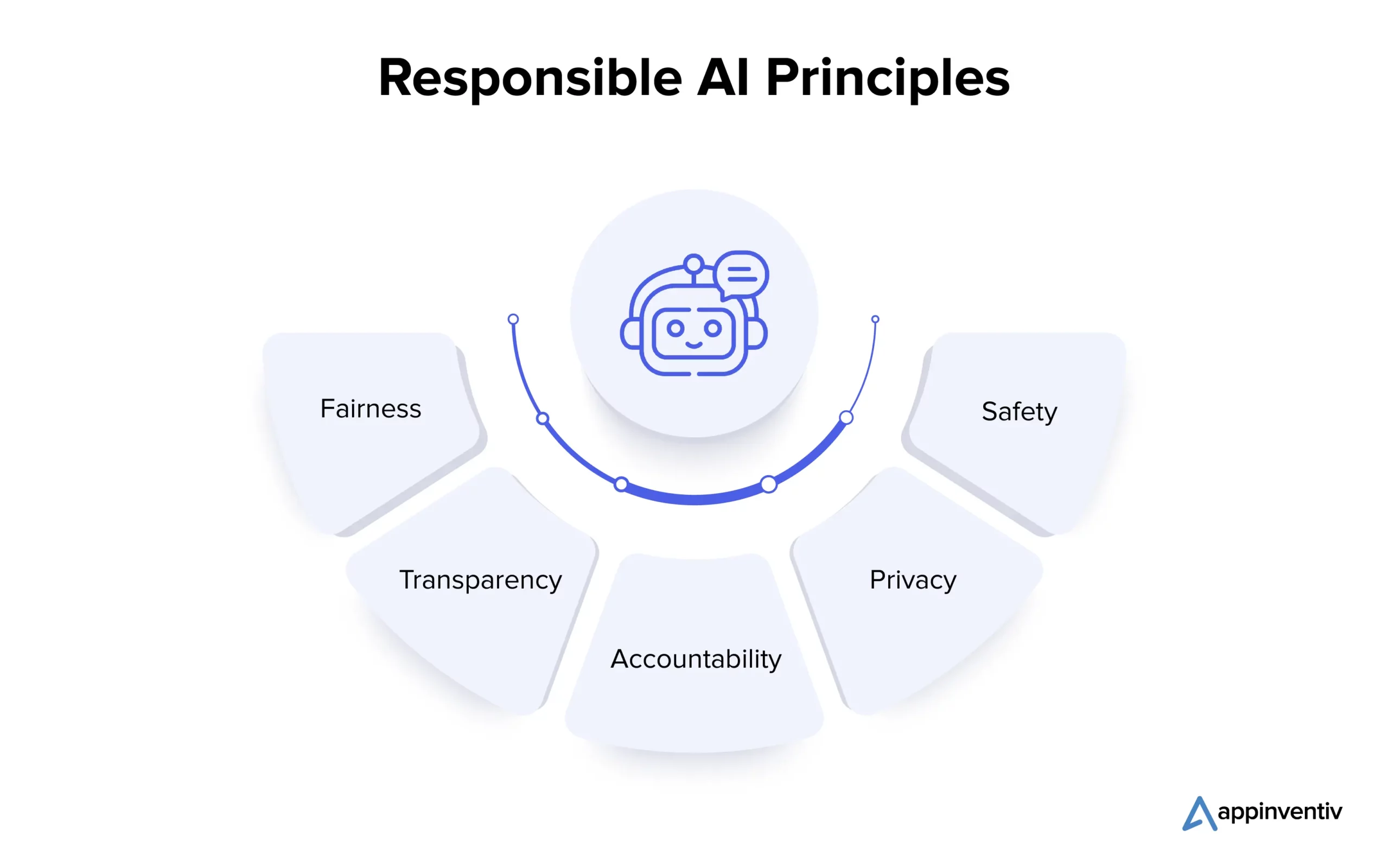

Comprendre les principes fondamentaux de l’IA responsable est essentiel pour les organisations qui cherchent à naviguer de manière éthique dans le paysage complexe de l’IA. Examinons les multiples principes en détail ci-dessous :

1. Équité

L’équité dans l’IA est un principe fondamental qui s’attaque aux préjugés dans les systèmes d’IA. Des biais peuvent survenir lors de la création de l'algorithme ou en raison de données d'entraînement déformées. Les data scientists utilisent des techniques telles que l'analyse des données pour détecter et corriger les biais, garantissant ainsi que les systèmes d'IA prennent des décisions impartiales et favorisent l'égalité des résultats.

2. Transparence

La transparence de l'IA implique de documenter et d'expliquer les étapes suivies dans son développement et son déploiement, la rendant compréhensible pour les parties prenantes. Des techniques telles que l’apprentissage automatique interprétable révèlent la logique derrière les décisions liées à l’IA, tandis que la surveillance humaine garantit l’alignement éthique et la justification.

3. Responsabilité

La responsabilité est étroitement liée à la transparence et englobe la mise en place de mécanismes permettant de tenir les développeurs et les utilisateurs d’IA responsables des résultats et des impacts des systèmes d’IA. Cela passe par la mise en œuvre de directives éthiques, l’utilisation d’outils de contrôle et l’audit réalisé. Ces mesures garantissent que les systèmes d’IA fournissent les résultats souhaités, préviennent les dommages involontaires et maintiennent leur fiabilité.

4. Confidentialité

La confidentialité est cruciale pour protéger les informations personnelles des individus. L'écosystème de l'IA implique d'obtenir le consentement pour la collecte de données, de collecter uniquement les données nécessaires et de les utiliser uniquement aux fins prévues. Des techniques de préservation de la confidentialité, telles que la confidentialité différentielle et les techniques cryptographiques, sont utilisées pour protéger les données personnelles lors du développement et de la production de modèles d'IA.

5. Sécurité

Les développeurs doivent donner la priorité à la sécurité dans une IA responsable, y compris le bien-être physique et non physique. Pour y parvenir, les considérations de sécurité doivent être intégrées à chaque étape du développement du système d’IA. Lors de la phase de conception, il est crucial d’impliquer diverses parties prenantes pour identifier et comprendre les risques potentiels. Les évaluations des risques, les tests dans différentes conditions, la surveillance humaine, ainsi que la surveillance et l'amélioration continues pendant la production sont essentiels pour prévenir les dommages et maintenir la fiabilité des systèmes d'IA.

Après avoir examiné les multiples principes de l’IA responsable, allons de l’avant et comprenons les défis associés à l’adoption de la solution.

Quels sont les défis liés à l’adoption de solutions d’IA responsables ?

L’adoption d’une IA responsable est une démarche prometteuse et très gratifiante pour les entreprises, mais ses défis critiques nécessitent un examen attentif et des solutions proactives. Examinons-les en détail ci-dessous :

Explicabilité et transparence

Les systèmes d’IA doivent être capables de clarifier comment et pourquoi ils produisent des résultats spécifiques pour maintenir la confiance. Un manque de transparence peut réduire la confiance dans ces systèmes.

Sécurité personnelle et publique

Les systèmes autonomes tels que les voitures et les robots autonomes peuvent présenter des risques pour la sécurité humaine. Garantir le bien-être humain dans de tels contextes est crucial.

Automatisation et contrôle humain

Si l’IA peut améliorer la productivité, elle peut réduire l’implication et l’expertise humaines. Trouver un équilibre pour garantir le contrôle et la surveillance humains est un défi.

Préjugés et discrimination

Même si les systèmes d’IA sont conçus pour être neutres, ils peuvent néanmoins hériter des biais des données d’entraînement, conduisant potentiellement à une discrimination involontaire. Il est vital de prévenir de tels préjugés.

Responsabilité et réglementation

Avec la croissance de la présence globale de l’IA, des questions de responsabilité peuvent se poser. Déterminer qui est responsable de l’utilisation ou de la mauvaise utilisation du système d’IA est complexe.

Sécurité et confidentialité

L’IA nécessite un accès étendu aux données, ce qui peut susciter davantage d’inquiétudes quant à la confidentialité des données et aux failles de sécurité. La protection des données utilisées pour la formation en IA est essentielle pour protéger la vie privée globale d’un individu.

Désormais, un partenariat avec une société de développement d'applications d'IA réputée (comme Appinventiv) qui adhère aux principes d'IA responsable pendant le processus de développement peut aider les entreprises à atténuer efficacement les défis et les risques associés.

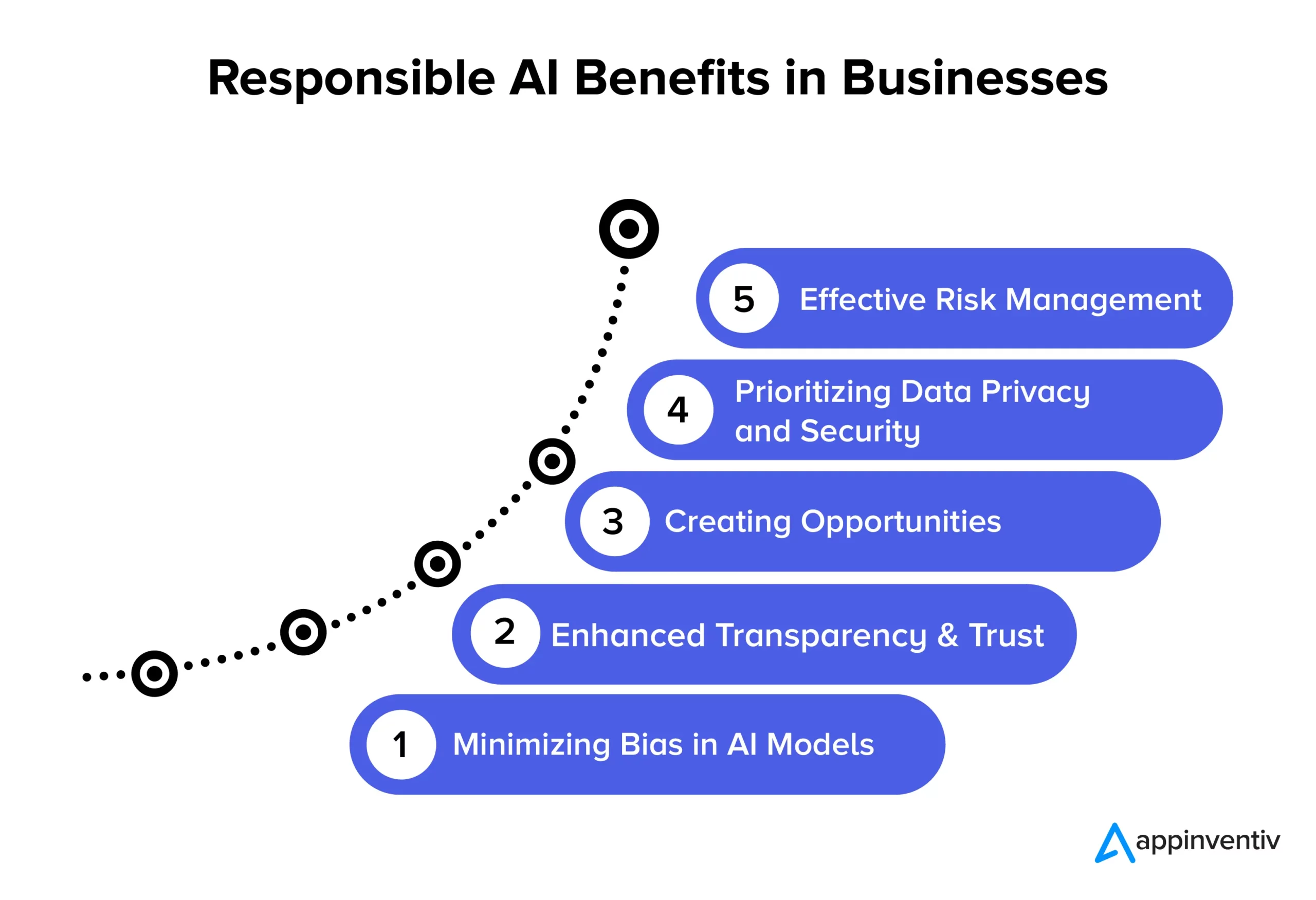

Avantages de l’IA responsable pour les entreprises

L’adoption des principes de l’IA responsable ouvre la voie à de multiples avantages significatifs pour les entreprises et la société. Explorons-les en détail ci-dessous :

Minimiser les biais dans les modèles d'IA

En adhérant aux principes de l'IA responsable, les entreprises peuvent réduire efficacement les biais dans leurs modèles d'IA et les données sous-jacentes utilisées pour les former. Cette réduction des biais garantit que les systèmes d’IA fournissent des résultats plus précis et plus équitables, qui sont éthiquement corrects et réduisent le risque de modification des données au fil du temps. En outre, minimiser les biais aide les organisations à éviter les dommages potentiels aux utilisateurs qui pourraient résulter de résultats biaisés des modèles d’IA, améliorant ainsi leur réputation et réduisant leur responsabilité.

Transparence et confiance améliorées

Des pratiques d’IA responsables améliorent la clarté et la transparence des modèles d’IA. Cela contribue à renforcer la confiance entre les entreprises et leurs clients. En outre, l’IA devient plus disponible et compréhensible pour un public plus large, ce qui profite aux organisations et aux utilisateurs finaux en permettant une plus large gamme d’applications et en améliorant l’utilisation efficace des technologies d’IA.

Créer des opportunités

L'adhésion aux principes de l'IA responsable permet aux développeurs et aux utilisateurs d'avoir des conversations ouvertes sur les systèmes d'IA. Il s’agit de l’un des avantages de l’IA responsable les plus recherchés par les entreprises. Cela crée un espace où les gens peuvent exprimer leurs questions et leurs inquiétudes concernant la technologie de l’IA, permettant ainsi aux entreprises de s’attaquer à ces problèmes de manière proactive. Cette approche collaborative du développement de l'IA aboutit à la création de solutions d'IA éthiquement saines et socialement responsables, qui peuvent renforcer la réputation et la compétitivité d'une entreprise.

Donner la priorité à la confidentialité et à la sécurité des données

Les solutions d’IA responsable permettent aux entreprises de se concentrer considérablement sur la protection de la confidentialité et de la sécurité des données. Cela signifie que les données personnelles ou sensibles sont traitées avec soin, en protégeant les droits des individus et en empêchant les violations de données. Lorsque les entreprises suivent les principes de l’IA responsable, elles réduisent les risques d’utilisation abusive des données, de violation des réglementations et de atteinte à leur réputation. C'est un moyen intelligent de protéger les données et de maintenir la confiance des clients.

Gestion efficace des risques

Des pratiques responsables en matière d’IA établissent des règles éthiques et juridiques claires pour les systèmes d’IA, ce qui contribue à réduire les risques de conséquences néfastes. Cette réduction des risques profite à plusieurs entités, telles que les entreprises, les employés et la société. Les organisations peuvent éviter des poursuites judiciaires coûteuses et nuire à leur réputation lorsqu’elles traitent d’éventuels problèmes éthiques et juridiques.

Exemples de mise en œuvre réussie de l’IA responsable

Voici quelques exemples concrets remarquables d’organisations qui donnent la priorité à des pratiques d’IA éthiques et impartiales :

L'outil de recrutement IA digne de confiance d'IBM

Une grande entreprise américaine a collaboré avec IBM pour automatiser les processus de recrutement et donner la priorité à l'équité dans les processus de recrutement basés sur l'IA. Leur objectif était de faciliter la diversité et l’inclusion tout en préservant l’intégrité de leurs modèles d’apprentissage automatique. En utilisant IBM Watson Studio, un outil de surveillance et de gestion de l'IA, ils ont réussi à identifier et à remédier aux biais d'embauche tout en obtenant des informations précieuses sur la prise de décision en matière d'IA.

Cadre d'IA responsable de State Farm

State Farm, l'une des principales compagnies d'assurance aux États-Unis, a intégré l'IA dans son processus de traitement des réclamations et a mis en œuvre une stratégie d'IA responsable. Ils ont créé un système de gouvernance pour attribuer des responsabilités en matière d’IA, ce qui a permis une prise de décision plus rapide et plus éclairée. Le modèle d'IA DVAM (Dynamic Vehicle Assessment Model) de State Farm prédit efficacement les pertes totales et apporte de la transparence au traitement des réclamations d'assurance.

Équipe d'IA responsable et liste de contrôle du groupe H&M

Le groupe H&M, un détaillant mondial de mode, a intégré l'IA dans ses opérations pour favoriser le développement durable, optimiser les chaînes d'approvisionnement et améliorer les expériences client personnalisées. L’entreprise a créé une équipe dédiée à l’IA responsable en 2018 pour garantir une utilisation responsable de l’IA. Cette équipe a élaboré une liste de contrôle pratique qui identifie et atténue les dommages potentiels liés à l’IA et adhère sans réserve aux principes de l’IA responsable.

L'équité de Google dans l'apprentissage automatique

Google a également travaillé activement à l'inclusion de mesures d'équité dans l'IA et l'apprentissage automatique. Ils ont développé des outils et des ressources pour aider les développeurs à identifier et à atténuer les biais dans leurs modèles d'apprentissage automatique.

GPT-3 d'OpenAI

OpenAI, la société à l'origine de GPT-3, a également été un leader clé dans l'adoption d'une approche responsable du déploiement de l'IA. Ils ont mis en œuvre des mécanismes de réglage fin pour éviter des résultats préjudiciables et biaisés qui prouvent encore davantage leur engagement en faveur d’une IA éthique, même dans les modèles avancés de PNL.

L'avenir de l'IA responsable avec Appinventiv

L’avenir de l’IA responsable est un voyage continu, avec des organisations à différents stades de développement éthique en ce qui concerne la technologie et l’utilisation des données. Il s'agit d'un domaine dynamique axé sur l'établissement de lignes directrices standardisées pour diverses industries. Pour appliquer les principes de l'IA responsable à votre entreprise, un partenariat avec Appinventiv est le meilleur choix qu'une entreprise puisse faire. Nous pouvons vous aider à créer des solutions d’IA éthiques, impartiales et précises, adaptées à vos besoins.

En tant que société dédiée au développement de l'IA, nos développeurs possèdent des années d'expertise dans le développement de solutions d'IA, en privilégiant l'éthique et la responsabilité. Forts d’une expérience avérée de projets d’IA réussis couvrant de nombreux domaines industriels, nous comprenons l’importance d’aligner les solutions d’IA sur les valeurs fondamentales et les principes éthiques requis. Nous pouvons vous aider à mettre en œuvre des mesures d’équité pour garantir que vos solutions commerciales basées sur l’IA prennent des décisions impartiales.

Nous avons récemment développé YouComm, une application de soins de santé basée sur l'IA qui connecte les patients aux infirmières hospitalières grâce à des gestes manuels et des commandes vocales. La solution est désormais mise en œuvre dans plus de 5 chaînes d’hôpitaux aux États-Unis.

Contactez nos experts en IA pour créer des solutions d’IA qui fournissent des résultats précis et respectent les normes éthiques.

FAQ

Q. Quels sont quelques exemples d’IA responsable ?

A. Voici quelques exemples d’IA responsable dans plusieurs domaines industriels :

- Algorithmes équitables : systèmes d'IA conçus pour être équitables, réduisant les biais décisionnels.

- IA explicable (XAI) : Rendre les décisions d'IA compréhensibles.

- Atténuation des biais : surveiller et réduire en permanence les biais dans l'IA.

- Comités d’éthique de l’IA : création de comités d’examen internes pour l’IA éthique.

- IA préservant la confidentialité : protéger les données sensibles tout en les utilisant pour l'IA.

- Rapports de transparence : partager la manière dont les systèmes d'IA fonctionnent et prennent des décisions.

- Éducation responsable en IA : former les professionnels de l’IA à l’éthique et à la responsabilité.

Q. Quels sont quelques cas d’utilisation réussis de l’IA responsable ?

A. Voici quelques cas d’utilisation réussis de l’IA responsable :

- Diagnostics de santé : ils sont utilisés pour améliorer les résultats médicaux avec équité et confidentialité des patients.

- Services financiers : il est capable d'éliminer les risques associés à la fraude et aux logiciels malveillants. Les solutions responsables basées sur l'IA peuvent protéger davantage les données des clients et garantir des prêts équitables.

- Recrutement : il contribue à réduire les préjugés tout en ouvrant la voie à l'adoption de la diversité et de l'égalité des chances entre les utilisateurs.

- Véhicules autonomes : cela aide à donner la priorité à la sécurité et à respecter les normes éthiques.

Q. L’IA responsable est-elle un processus continu, ou les entreprises peuvent-elles la mettre en œuvre une fois et l’oublier ?

A. L’IA responsable est un processus continu qui nécessite une surveillance, une mise à jour et une adaptation continues à l’évolution des normes et réglementations éthiques. Par conséquent, il est conseillé de s’associer à une société de développement d’IA dédiée qui peut vous aider à traverser les eaux avec précaution.