Le véritable coût de la construction de votre propre robot d'exploration Web

Publié: 2023-08-09Le scraping Web est devenu le moyen le plus courant d'agréger des données provenant de plusieurs sources et de tirer des informations vitales d'Internet. Ce processus est utilisé pour activer des solutions basées sur les données pour tout, de la comparaison des prix sur les sites Web de commerce électronique à la prise de décisions sur le marché boursier. Avec l'augmentation de la demande de grattage de données sur le Web, des outils et des services pouvant faciliter le grattage Web ont également inondé Internet. Cependant, tous appartiennent à l'une des 3 sous-catégories -

- Création d'un outil de scraping Web interne à l'aide de bibliothèques telles que BeautifulSoup en Python et déploiement dans un service cloud tel qu'AWS.

- Utilisation d'un logiciel de grattage semi-automatisé qui peut être utilisé pour saisir des parties de l'écran. Une intervention humaine est nécessaire pour la configuration initiale, mais les tâches répétées peuvent être automatisées. Cependant, le degré d'automatisation est limité, l'équipe produit ou commerciale peut être confrontée à une courbe d'apprentissage abrupte pour utiliser l'outil, et tous les sites Web ne peuvent pas être récupérés à l'aide de ces outils. Vous rencontrerez des difficultés supplémentaires dans la gestion des sites Web qui génèrent du contenu dynamique à l'aide de technologies telles que javascript.

- Les fournisseurs DaaS comme PromptCloud vous fournissent un flux de données personnalisé basé sur les sites Web et les points de données que vous soumettez comme exigences. Ces services vous facturent généralement en fonction de la quantité de données que vous consommez. Votre facture mensuelle est donc uniquement basée sur la quantité de données récupérées et convient aux entreprises de toutes tailles.

Aujourd'hui, de nombreuses entreprises peuvent imaginer que le coût associé aux points b ou c est trop élevé et décider de créer elles-mêmes un robot d'indexation Web. Pourquoi pas? Juste googler "Comment créer un robot d'indexation ?" vous donnerait des centaines de résultats. Certains d'entre eux peuvent même fonctionner pour votre cas d'utilisation. Mais quel est le coût réel de la création d'un robot d'exploration Web de niveau entreprise, de son déploiement dans le cloud, de sa maintenance et de sa mise à jour au fil du temps ? Découvrons-le.

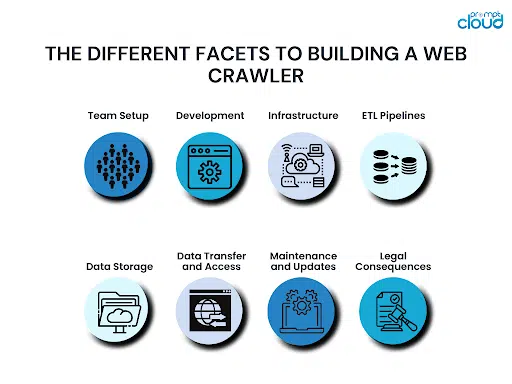

Les différentes facettes de la construction d'un robot d'indexation Web

Lors de la création d'un robot d'exploration Web, il y a plusieurs aspects à garder à l'esprit. À moins que vous ne teniez compte de tout cela, vous risquez de mordre plus que vous ne pouvez mâcher. Cela finirait par vous coûter trop cher avant même d'avoir atteint la ligne d'arrivée, et vous seriez alors coincé entre continuer ou abandonner.

Configuration de l'équipe :

Les principales exigences pour la construction d'un robot d'exploration Web seraient des connaissances en programmation et une expérience antérieure de la construction d'un robot d'exploration Web. Même si vous avez une équipe technique, il se peut que vous manquiez de quelqu'un ayant des connaissances préalables pour diriger le peloton. Sans quelqu'un d'expérimenté, vous risquez de commettre des erreurs critiques et de ne pas vous en rendre compte avant qu'il ne soit trop tard.

Développement:

Une fois que l'équipe est prête, elle doit se mettre au développement de votre robot d'exploration Web. Ce robot d'exploration doit être capable d'explorer tous les points de données requis à partir de tous les sites Web de votre liste. Par conséquent, il faudra un temps considérable non seulement pour construire le crawler, mais aussi pour tester les cas extrêmes et s'assurer qu'il ne se casse à aucun moment. Selon la taille et l'expérience de votre équipe, la création d'un nouveau robot d'exploration Web à partir de zéro peut prendre de quelques mois à quelques trimestres.

Infrastructure:

Construire le robot d'indexation parfait est difficile. Décider d'une infrastructure cloud à haute disponibilité qui sera également optimisée en termes de coût est encore plus difficile. Votre infra devra également être évolutive de manière à pouvoir évoluer au fur et à mesure que votre entreprise se développe et lorsque vous devez extraire des données de plusieurs sources.

Canalisations ETL :

Gratter les points de données dont vous avez besoin sur les sites Web de votre choix peut ne pas suffire. Habituellement, les données doivent également être normalisées, formatées, nettoyées et triées avant d'être stockées sur un support de stockage. Tout cela nécessiterait plus de puissance de calcul. Étant donné que ces pipelines ajouteraient un décalage dans le flux de données, il serait vital d'obtenir la bonne infra pour configurer vos pipelines ETL sur le cloud.

Stockage de données:

Une fois vos données récupérées, nettoyées et prêtes, vous devrez les placer sur un support de stockage approprié. Il peut s'agir d'une base de données SQL ou NoSQL. Il pourrait également s'agir d'une solution d'entreposage de données telle que Redshift. Le choix de la base de données dépend de la quantité de données que vous souhaitez stocker, de la fréquence à laquelle vous souhaitez mettre à jour ou récupérer les données, si le nombre de colonnes peut changer à l'avenir, etc. Comme le reste des ressources, la base de données doit également être hébergée sur le cloud, de sorte que la tarification doit également être prise en compte.

Transfert et accès aux données :

Maintenant que vous avez récupéré les données et que vous les avez stockées dans une base de données, vous souhaiterez peut-être les récupérer à certains intervalles, voire en continu. Vous pouvez créer des API REST pour accorder au monde extérieur l'accès à vos données. La création et la maintenance de la couche d'accès aux données prendraient du temps et vous serez facturé en fonction de la quantité de données transférées.

Maintenance et mises à jour :

Un robot d'indexation n'est jamais définitif. Ce n'est qu'une version. Une version plus récente doit être créée dès qu'un site Web dont il récupère les données est modifié ou mis à jour. L'ajout de sites Web complexes à la liste des sites Web à gratter peut également nécessiter une mise à jour de votre robot d'exploration. La maintenance et la surveillance régulières de vos ressources cloud sont également essentielles pour garantir qu'aucune erreur n'apparaît dans le système et que vos ressources de calcul cloud sont saines.

Conséquences juridiques:

Lorsque vous récupérez des données sur le Web, vous devez respecter certaines lois du pays. Il s'agirait des lois sur la protection des données du pays dans lequel vous opérez ainsi que des lois des pays dont vous récupérez les données. Toute erreur peut signifier des poursuites coûteuses. Parfois, les paiements, les règlements ou les frais juridiques sont suffisants pour faire tomber une entreprise.

La meilleure solution de scraping Web de niveau entreprise

Le coût le plus élevé que vous payez pour créer votre propre solution de grattage Web n'est même pas de l'argent. Il est temps - votre entreprise doit attendre que la solution soit opérationnelle, que de nouvelles sources soient ajoutées, etc. Au lieu de cela, opter pour une solution DaaS entièrement fonctionnelle qui vous fournit des données propres et prêtes à l'emploi et des options d'intégration faciles serait un choix judicieux. C'est pourquoi notre équipe de PromptCloud fournit à nos utilisateurs des solutions de grattage Web entièrement gérées hébergées sur le cloud.

Vous pouvez commencer à utiliser des données de n'importe où sur le Web en seulement 3 étapes au cours desquelles vous nous fournissez une liste de sites Web et de points de données, validez les résultats d'un robot d'exploration de démonstration, puis passez à l'intégration finale. Étant une solution basée sur le cloud, nous vous facturons uniquement en fonction de la quantité de données que vous consommez. La solution est donc abordable pour les entreprises de toutes tailles. Un calcul détaillé vous montrera comment vous économisez réellement de l'argent lorsque vous optez pour une solution DaaS gérée par rapport à la création de votre propre robot d'indexation Web.

Pour plus de détails, contactez notre équipe commerciale à [email protected]