Mencegah Keruntuhan Model AI: Mengatasi Risiko Inheren dari Kumpulan Data Sintetis

Diterbitkan: 2023-10-05Kecerdasan Buatan (AI) telah mengubah kehidupan kita sehari-hari secara signifikan dengan menyarankan konten yang dipersonalisasi pada platform streaming dan mengaktifkan asisten digital di ponsel cerdas. Kini, kemajuan ini dimungkinkan oleh model AI canggih yang belajar dari sejumlah besar data.

Berdasarkan berbagai laporan, konten yang dihasilkan AI menjadi semakin lazim di internet, dan berpotensi mencakup hingga 90% informasi online di tahun-tahun mendatang.

Dengan banyaknya informasi yang masuk, kita dapat dengan mudah mengatakan bahwa di dunia yang kaya akan data saat ini, AI menghadapi tantangan unik, yaitu menghambat banyaknya data.

Laporan tersebut lebih lanjut menunjukkan bahwa sejumlah besar konten yang dihasilkan oleh AI dapat membuat orang kewalahan dengan informasi yang berlebihan, sehingga menyulitkan mereka untuk menentukan konten mana yang dapat dipercaya dan dihasilkan oleh manusia. Selain itu, terdapat kekhawatiran mengenai potensi hilangnya lapangan kerja di bidang kreatif seperti seni, jurnalisme, dan menulis, semua karena AI menjadi lebih mampu menghasilkan konten yang secara tradisional dibuat oleh manusia.

Mengenai sistem AI itu sendiri, ada masalah yang muncul seperti “Model Collapse,” yang mengacu pada masalah ketika model AI yang dilatih pada kumpulan data besar menghasilkan keluaran berkualitas rendah dengan memprioritaskan pilihan kata umum dibandingkan alternatif kreatif. “Model Autophagy Disorder” atau “Habsburg AI” adalah kekhawatiran lain di mana sistem AI yang dilatih secara berlebihan berdasarkan keluaran model AI lain dapat menunjukkan fitur yang tidak diinginkan atau mungkin memiliki bias.

Tantangan-tantangan ini berpotensi membahayakan kualitas dan keandalan konten yang dihasilkan AI, menghancurkan kepercayaan terhadap sistem tersebut, dan memperburuk kelebihan informasi.

Blog kami akan membantu Anda memahami segala sesuatu yang berkaitan dengan penanganan pencegahan keruntuhan model AI. Seiring dengan kemajuan revolusi AI generatif, hal ini menimbulkan tantangan dan ketidakpastian yang signifikan dalam lanskap informasi online. Jadi, mari selami detailnya secara langsung.

Memahami Keruntuhan Model AI

Dalam pembelajaran mesin, “keruntuhan model” mengacu pada situasi ketika model AI gagal memberikan berbagai keluaran yang berguna. Sebaliknya, ini menghasilkan serangkaian hasil yang berulang atau berkualitas rendah. Masalah ini dapat terjadi di berbagai model, namun sering kali terjadi selama pelatihan model kompleks seperti generative adversarial network (GAN). Keruntuhan model dapat menghambat kemampuan model untuk menghasilkan keluaran yang beragam dan berharga, sehingga berdampak pada kinerjanya secara keseluruhan.

Mari kita ilustrasikan contoh keruntuhan model. Bayangkan seorang mahasiswa seni yang sangat antusias mewakili model AI kami, yang bertugas membuat lukisan zebra. Pada awalnya, karya seni mereka sangat mengesankan dan sangat mirip dengan zebra. Namun, seiring berjalannya waktu, lukisan mereka perlahan-lahan kehilangan kemiripannya dengan zebra, dan kualitasnya pun menurun. Hal ini mirip dengan “keruntuhan model” dalam pembelajaran mesin, di mana model AI, seperti halnya mahasiswa seni kita, pada awalnya memiliki performa yang baik, namun kemudian kesulitan mempertahankan karakteristik penting yang dirancang untuk dapat berfungsi.

Sesuai dengan kemajuan AI baru-baru ini, para peneliti menjadi sangat tertarik untuk menggunakan data buatan atau sintetis untuk melatih model AI baru dalam menghasilkan gambar dan teks. Namun, sebuah konsep yang disebut 'Model Autophagy Disorder' (MAD) membandingkan proses ini dengan putaran yang merusak diri sendiri.

Kecuali kita terus menambahkan data dunia nyata yang baru secara rutin, kualitas dan variasi model AI yang kita buat menggunakan data sintetis dapat memburuk seiring berjalannya waktu. Oleh karena itu, penting untuk mencapai keseimbangan antara data sintetis dan nyata agar model AI tetap berkinerja baik.

Keseimbangan ini sangat penting untuk mencegah penurunan kualitas dan keragaman model seiring mereka terus belajar. Mencari tahu cara menggunakan data sintetis secara efektif untuk mencegah keruntuhan model AI merupakan tantangan berkelanjutan terkait evolusi AI generatif dan penggunaan data sintetis.

Menurut The New Yorker, jika ChatGPT dianggap sebagai versi internet yang ringkas, mirip dengan file JPEG yang mengompresi foto, maka melatih chatbot masa depan berdasarkan hasil ChatGPT secara digital setara dengan berulang kali membuat fotokopi dari fotokopi seperti halnya jaman dulu. Sederhananya, kualitas gambar pasti akan semakin buruk setiap kali diulang.

Oleh karena itu, untuk mengatasi tantangan ini, organisasi perlu fokus pada penyempurnaan pendekatan mereka guna memastikan produk AI generatif ini terus memberikan respons yang akurat dalam lanskap digital ini.

[Baca Juga: AI yang Bertanggung Jawab – Mengatasi Tantangan Adopsi Dengan Prinsip dan Strategi Panduan]

Bagaimana Keruntuhan Model AI Terjadi?

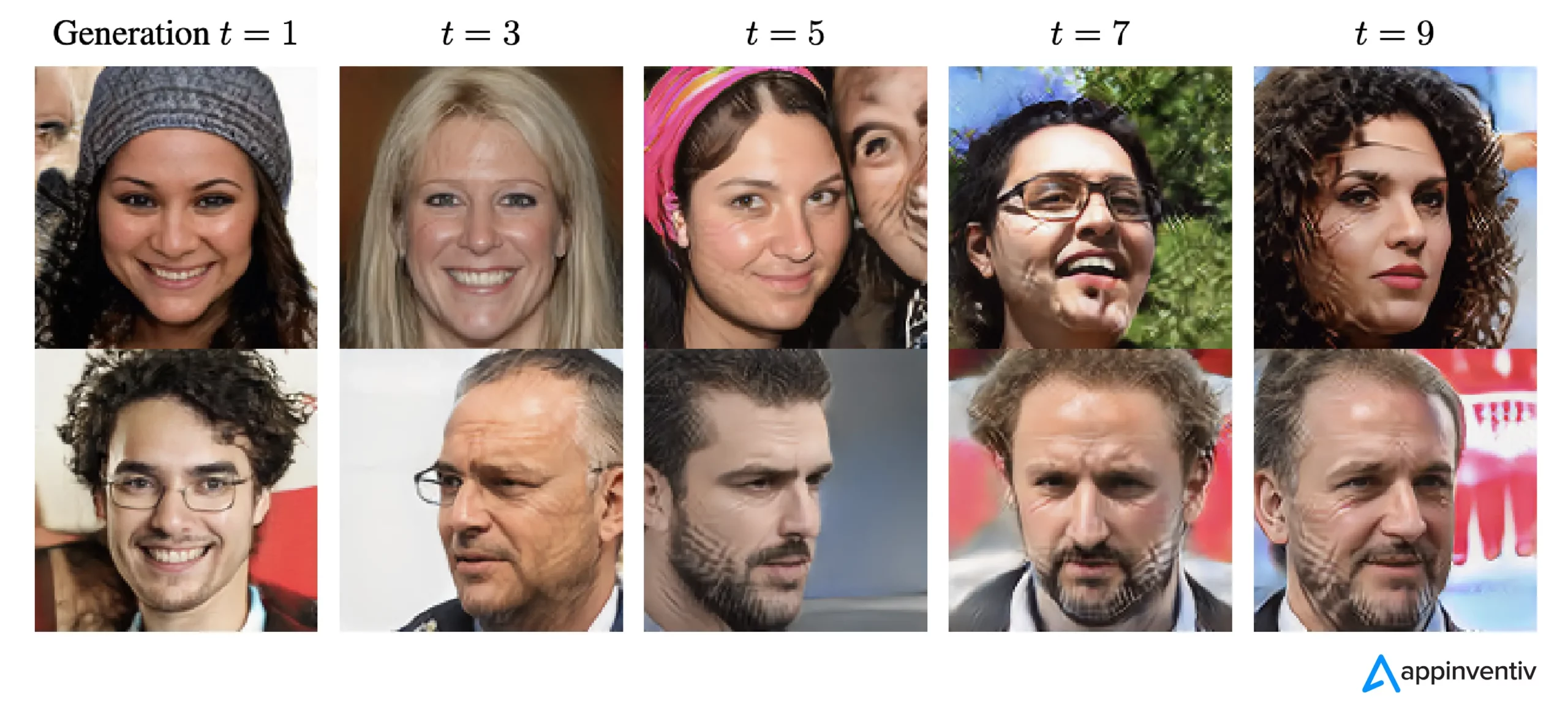

Keruntuhan model terjadi ketika model AI baru dilatih menggunakan data yang dihasilkan oleh model lama. Model-model baru ini mengandalkan pola-pola yang terlihat pada data yang dihasilkan. Keruntuhan model berakar pada gagasan bahwa model generatif cenderung mengulangi pola yang telah dipelajari, dan terdapat batasan pada informasi yang dapat diambil dari pola tersebut.

Dalam kasus keruntuhan model, kejadian-kejadian yang mungkin terjadi dilebih-lebihkan, sedangkan kejadian-kejadian yang kecil kemungkinannya diremehkan. Selama beberapa generasi, peristiwa-peristiwa yang mungkin terjadi mendominasi data, dan bagian-bagian data yang kurang umum namun tetap penting, yang disebut ekor, semakin berkurang. Ekor ini penting untuk menjaga keakuratan dan keragaman keluaran model. Seiring kemajuan generasi, kesalahan menguasai data, dan model semakin salah menafsirkannya.

Menurut penelitian, ada dua jenis keruntuhan model: awal dan akhir. Keruntuhan model awal melibatkan model yang kehilangan informasi tentang peristiwa langka. Pada keruntuhan model akhir, model mengaburkan pola-pola berbeda dalam data, sehingga menghasilkan keluaran yang memiliki sedikit kemiripan dengan data asli.

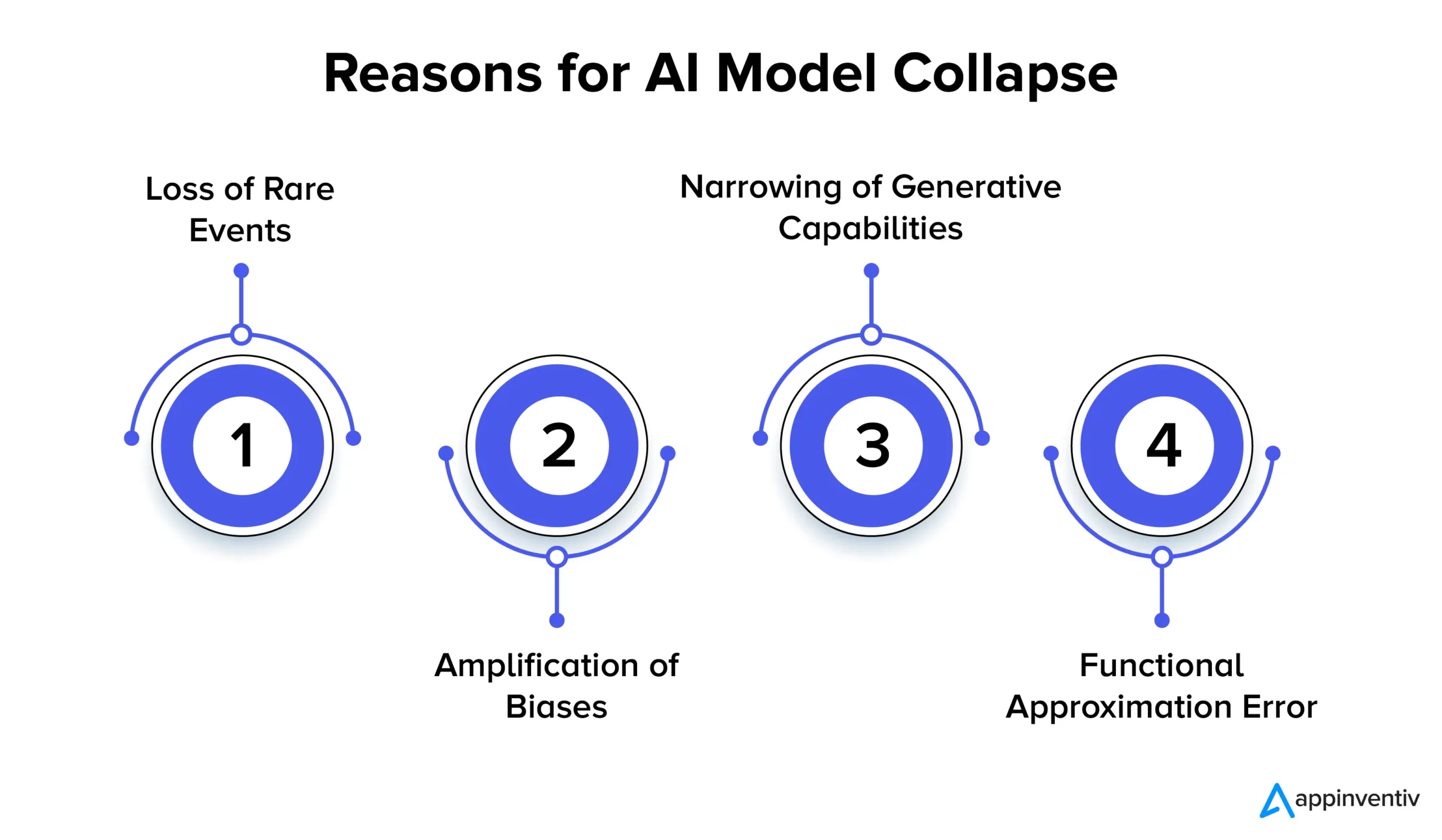

Mari kita lihat beberapa alasan runtuhnya model AI secara mendetail di bawah:

Hilangnya Peristiwa Langka

Ketika model AI berulang kali dilatih berdasarkan data yang dihasilkan oleh versi sebelumnya, model tersebut mencoba untuk fokus pada pola umum dan melupakan kejadian yang jarang terjadi. Fenomena ini mirip dengan model yang kehilangan memori jangka panjangnya. Peristiwa langka sering kali memiliki arti penting, seperti mengidentifikasi anomali dalam proses produksi atau mendeteksi transaksi penipuan. Misalnya, dalam hal deteksi penipuan, pola bahasa tertentu mungkin menandakan perilaku penipuan, sehingga sangat penting untuk mempertahankan dan mempelajari pola-pola langka ini.

Amplifikasi Bias

Setiap iterasi pelatihan pada data yang dihasilkan AI dapat memperkuat bias yang ada pada data pelatihan. Karena keluaran model biasanya mencerminkan data tempat model dilatih, bias apa pun dalam data tersebut dapat dilebih-lebihkan seiring berjalannya waktu. Hal ini dapat menyebabkan amplifikasi bias dalam berbagai aplikasi AI. Misalnya, dampaknya dapat menimbulkan masalah seperti diskriminasi, bias rasial, dan konten media sosial yang bias. Oleh karena itu, penerapan pengendalian untuk mendeteksi dan memitigasi bias sangatlah penting.

Penyempitan Kemampuan Generatif

Ketika model AI terus belajar dari data yang dihasilkan, kemampuan generatifnya dapat menyempit. Model tersebut menjadi lebih dipengaruhi oleh penafsirannya sendiri terhadap realitas, sehingga menghasilkan konten yang semakin serupa namun tidak memiliki keragaman dan representasi peristiwa langka. Hal ini dapat menyebabkan hilangnya orisinalitas. Misalnya, ketika berbicara tentang Model Bahasa Besar (LLM), variasinya memberikan nada dan gaya yang berbeda kepada setiap penulis atau seniman.

Penelitian menunjukkan bahwa jika data baru tidak ditambahkan secara teratur selama proses pelatihan, model AI di masa depan bisa menjadi kurang akurat atau memberikan hasil yang kurang bervariasi seiring berjalannya waktu.

Kesalahan Pendekatan Fungsional

Kesalahan perkiraan fungsional dapat terjadi ketika perkiraan fungsi yang digunakan dalam model tidak cukup ekspresif. Meskipun kesalahan ini dapat dikurangi dengan menggunakan model yang lebih ekspresif, kesalahan ini juga dapat menimbulkan noise dan menyebabkan overfitting. Mencapai keseimbangan yang tepat antara ekspresi model dan kontrol noise sangat penting untuk mencegah kesalahan ini.

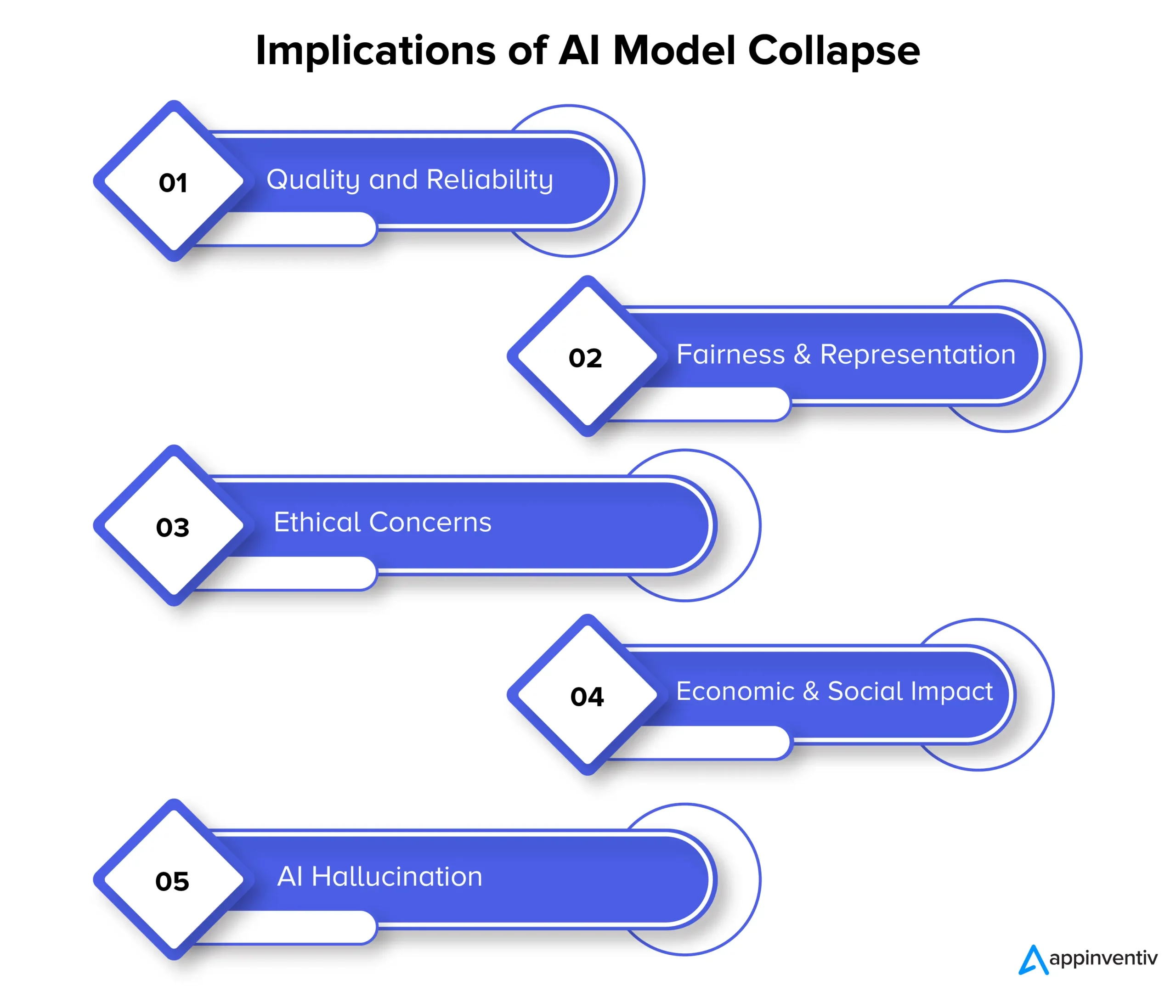

Implikasi Keruntuhan Model: Mengapa Stabilitas Model AI Penting?

Runtuhnya model pada akhirnya dapat berdampak pada kualitas, keandalan, dan keadilan konten yang dihasilkan AI, yang selanjutnya dapat menimbulkan beberapa risiko bagi organisasi. Mari kita lihat implikasi keruntuhan model secara detail di bawah ini:

Kualitas dan Keandalan

Ketika model AI mengalami kemunduran dalam pembelajarannya, konten yang mereka hasilkan menjadi kurang dapat diandalkan, dan kualitasnya menurun. Hal ini terjadi ketika model melepaskan diri dari distribusi data asli dan lebih mengandalkan interpretasi mereka sendiri terhadap realitas. Misalnya, model AI yang dirancang untuk menghasilkan berita mungkin menghasilkan artikel berita yang tidak akurat atau bahkan sepenuhnya palsu.

Keadilan dan Keterwakilan

Runtuhnya model juga menimbulkan kekhawatiran terkait keadilan dan keterwakilan konten yang dihasilkan. Ketika model melupakan peristiwa langka dan membatasi kemampuan generatifnya, konten yang terkait dengan topik yang kurang umum mungkin tidak terwakili secara memadai. Hal ini mengarah pada bias, stereotip, dan pengecualian terhadap perspektif tertentu.

Kekhawatiran Etis

Runtuhnya model menimbulkan masalah etika yang signifikan, khususnya ketika konten yang dihasilkan AI memiliki kekuatan untuk memengaruhi pengambilan keputusan. Konsekuensi dari keruntuhan model mencakup penyebaran konten yang bias dan tidak akurat, yang dapat berdampak signifikan terhadap kehidupan, opini, dan akses masyarakat terhadap peluang.

Dampak Ekonomi dan Sosial

Pada skala ekonomi dan sosial, keruntuhan model dapat memengaruhi kepercayaan dan adopsi teknologi AI. Jika konten yang dihasilkan AI tidak dapat diandalkan, dunia usaha dan konsumen mungkin akan ragu untuk menggunakan teknologi ini. Hal ini dapat menimbulkan implikasi ekonomi, dan akibatnya kepercayaan terhadap teknologi AI dapat menghambat.

Halusinasi AI

Halusinasi AI terjadi ketika model AI membuat konten imajinatif atau tidak realistis yang tidak sejalan dengan fakta atau koheren dengan cara apa pun. Hal ini dapat mengakibatkan informasi tidak akurat, berpotensi menyebabkan kesalahan informasi atau kebingungan. Ini sangat bermasalah dalam aplikasi seperti menghasilkan berita, mendiagnosis kondisi medis, atau membuat dokumen hukum yang mengutamakan akurasi dan keandalan.

Mari kita jelaskan konteksnya dengan contoh halusinasi AI. Misalkan ada model AI yang dilatih untuk menghasilkan gambar binatang. Kini, saat meminta gambar binatang, model tersebut mungkin menghasilkan gambar “zebroid”, hasil persilangan antara zebra dan kuda. Meskipun gambar ini mungkin terasa realistis secara visual, penting untuk dipahami bahwa ini hanyalah kreasi imajinasi model AI, karena tidak ada hewan seperti itu di dunia nyata.

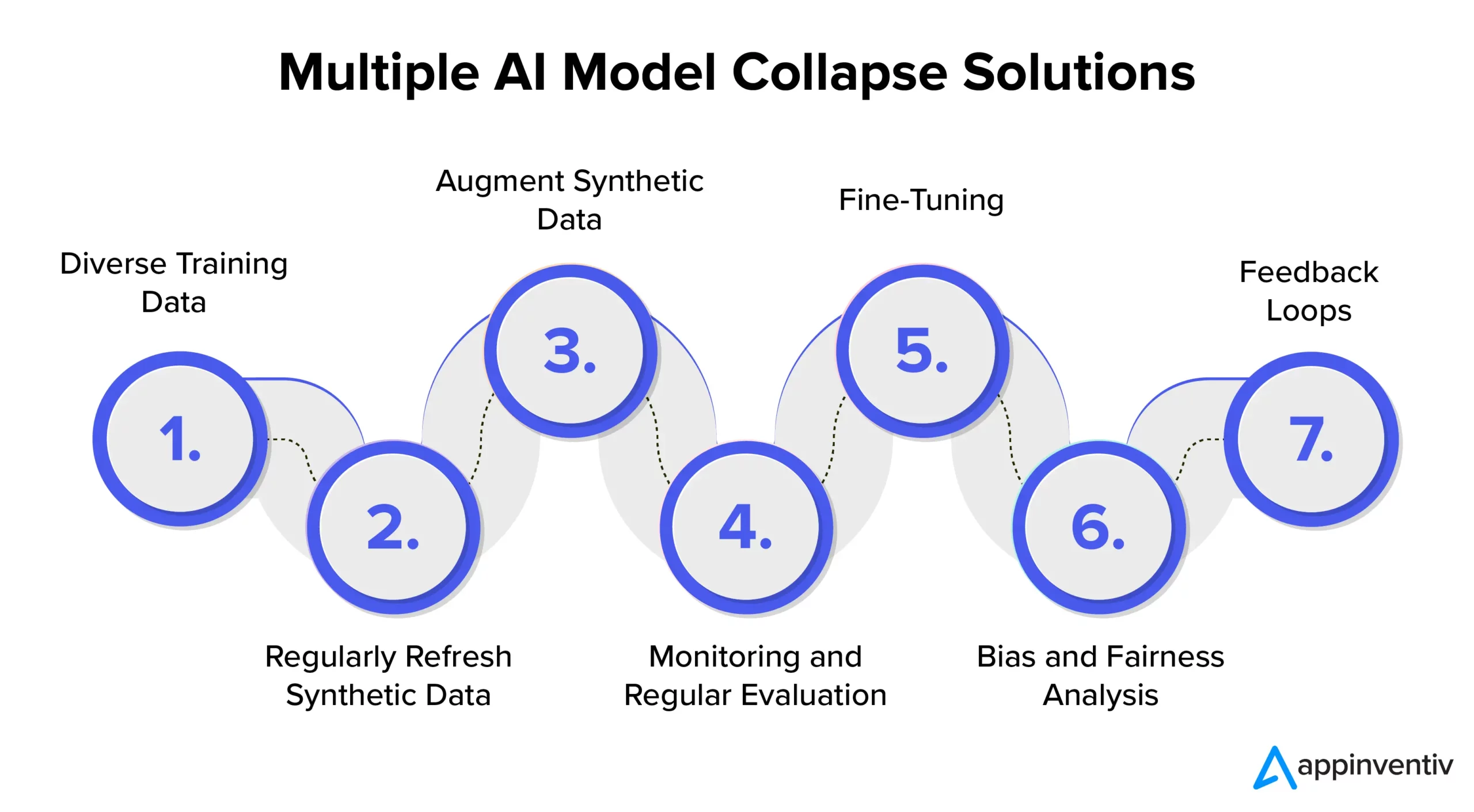

Pencegahan Keruntuhan Model AI: Memahami Solusi Keruntuhan Model AI

Untuk memastikan stabilitas dan keandalan model AI, penting untuk mengeksplorasi strategi dan praktik terbaik untuk mengatasi pencegahan keruntuhan model AI secara efektif. Oleh karena itu, disarankan untuk bermitra dengan perusahaan pengembangan AI khusus seperti Appinventiv yang dapat memberikan keahlian dan panduan dalam menerapkan langkah-langkah pencegahan ini sekaligus memastikan sistem AI Anda secara konsisten memberikan hasil berkualitas tinggi.

Data Pelatihan Beragam

Untuk mengatasi keruntuhan model AI secara efektif dan mencegah keluaran yang tidak diinginkan, penting untuk menyusun kumpulan data pelatihan yang mencakup berbagai sumber dan jenis data. Kumpulan data ini harus terdiri dari data sintetik yang dihasilkan oleh model dan data dunia nyata yang secara akurat mewakili kompleksitas masalah. Penting untuk memperbarui kumpulan data ini secara rutin dengan informasi baru dan relevan. Model ini dihadapkan pada berbagai pola dengan menggabungkan beragam data pelatihan. Ini membantu mencegah stagnasi data.

Segarkan Data Sintetis Secara Teratur

Keruntuhan model merupakan risiko ketika model AI sangat bergantung pada data yang dihasilkannya sendiri. Untuk mitigasi risiko yang efektif dalam AI, penting untuk secara rutin memasukkan data dunia nyata yang baru dan autentik ke dalam jalur pelatihan. Praktik ini memastikan model tetap adaptif dan menghindari terjebak dalam putaran yang berulang. Hal ini dapat membantu menghasilkan keluaran yang beragam dan relevan.

Tingkatkan Data Sintetis

Meningkatkan data sintetik melalui teknik augmentasi data adalah metode yang terbukti mencegah keruntuhan model. Teknik-teknik ini memperkenalkan variabilitas ke dalam data sintetik menggunakan variasi alami dalam data dunia nyata. Menambahkan gangguan terkontrol ke data yang dihasilkan akan mendorong model mempelajari pola yang lebih luas, sehingga mengurangi kemungkinan menghasilkan keluaran yang berulang.

Pemantauan dan Evaluasi Berkala

Memantau dan mengevaluasi performa model AI secara berkala sangat penting untuk mendeteksi dini keruntuhan model. Penerapan kerangka MLOps memastikan pemantauan berkelanjutan dan keselarasan dengan tujuan organisasi, sehingga memungkinkan intervensi dan penyesuaian tepat waktu.

[Baca Juga: Cara Menghindari Pelanggaran Kepatuhan Saat Mengembangkan Produk AI]

Mencari setelan

Penting untuk mempertimbangkan penerapan strategi penyesuaian untuk menjaga stabilitas model dan mencegah keruntuhan. Strategi untuk mencegah kegagalan model AI ini memungkinkan model beradaptasi dengan data baru sambil mempertahankan pengetahuan sebelumnya.

Analisis Bias dan Kewajaran

Analisis bias dan keadilan yang ketat sangat penting dalam mencegah keruntuhan model dan masalah etika. Penting untuk mengidentifikasi dan mengatasi bias dalam keluaran model. Anda dapat mempertahankan keluaran model yang andal dan tidak memihak dengan secara aktif mengatasi permasalahan ini.

Putaran Umpan Balik

Menerapkan putaran umpan balik yang menggabungkan umpan balik pengguna sangat penting dalam mencegah keruntuhan model. Dengan mengumpulkan wawasan pengguna secara konsisten, penyesuaian yang tepat dapat dilakukan terhadap keluaran model. Proses penyempurnaan ini menjamin bahwa model tetap relevan, andal, dan selaras dengan harapan pengguna.

Bagaimana Appinventiv Dapat Membantu Mitigasi Risiko dalam Model AI?

Dalam lanskap AI yang terus berkembang, tantangan yang ditimbulkan oleh keruntuhan model telah menjadi kekhawatiran baik bagi raksasa teknologi maupun inovator. Kemunduran jangka panjang pada kumpulan data model bahasa dan manipulasi konten telah berdampak pada ekosistem digital ini.

Seiring kemajuan AI, sangat penting untuk membedakan antara data buatan dan konten buatan manusia. Batas antara konten asli dan konten yang dihasilkan oleh mesin menjadi semakin kabur.

Kini, di tengah tantangan-tantangan ini dan mencegah kegagalan model AI, bermitra dengan perusahaan pengembang AI khusus seperti Appinventiv dapat memberi Anda pelipur lara yang sangat dibutuhkan. Dengan keahlian dalam pengembangan model AI dan komitmen khusus terhadap praktik AI yang etis, kami dapat membantu Anda menavigasi kompleksitas AI sekaligus memastikan keandalan dan integritas sistem AI Anda.

Pakar kami dapat bekerja sama dengan Anda dalam mengatasi pencegahan keruntuhan model AI secara efektif, mendorong transparansi, dan membangun masa depan dengan konten autentik yang tidak membahayakan keaslian konten buatan manusia.

Kami memahami bahwa melatih model AI dengan data baru dan beragam sangat penting untuk mencegah degradasi model. Evaluasi model AI adalah langkah penting dalam proses pengembangan model kami yang menggunakan metrik untuk menilai kinerja, menunjukkan kelemahan, dan memastikan prediksi masa depan yang efektif.

Tim ahli kami dapat membantu memastikan sistem AI Anda terus belajar dan beradaptasi dengan lanskap digital yang terus berkembang. Hubungi pakar kami untuk memitigasi risiko yang terkait dengan keruntuhan model dan memastikan efektivitasnya.

FAQ

T. Apa yang dimaksud dengan keruntuhan model AI?

A. Runtuhnya Model AI dalam pembelajaran mesin mengacu pada kegagalan model AI dalam menghasilkan beragam keluaran yang bermanfaat. Sebaliknya, ini menghasilkan hasil yang berulang atau berkualitas rendah. Masalah ini dapat terjadi pada berbagai jenis model, tetapi masalah ini terutama terlihat selama pelatihan model kompleks seperti generative adversarial network (GAN).

T. Apa penyebab umum runtuhnya model AI?

A. Penyebab umum keruntuhan model AI mencakup hilangnya kejadian langka, penguatan bias, penyempitan kemampuan generatif, kesalahan perkiraan fungsional, dll. Faktor-faktor ini dapat menyebabkan model menghasilkan keluaran yang kurang optimal.

T. Bagaimana cara mencegah keruntuhan model AI?

A. Untuk mencegah keruntuhan model AI yang efektif, penggunaan data pelatihan yang berbeda dan serupa dengan dunia nyata sangatlah penting, terus memantau dan mengevaluasi data, memperbaiki bias apa pun, dan menerapkan pengujian dan kontrol kualitas yang ketat. Bermitra dengan pakar AI di Appinventiv dapat memberi Anda wawasan dan solusi berharga untuk memitigasi risiko keruntuhan model.