Menskalakan Operasi Pengikisan Data: Tip Ahli untuk Menangani Volume Data Besar

Diterbitkan: 2024-05-25Seiring dengan meningkatnya permintaan akan data, tantangan yang terkait dengan penskalaan operasi pengumpulan data juga meningkat. Pengikisan web skala besar bukan hanya tentang meningkatkan jumlah data yang dikumpulkan; ini tentang menjaga kualitas, memastikan efisiensi, dan mengatasi hambatan teknis dan hukum.

Bayangkan sebuah perusahaan ritel memulai dengan operasi pengikisan data sederhana, mengumpulkan informasi harga dan produk dari beberapa situs pesaing. Awalnya, pengaturan ini berjalan lancar, memberikan wawasan berharga untuk pengambilan keputusan strategis. Namun, ketika perusahaan berkembang dan mulai menargetkan pasar yang lebih luas, kebutuhan akan web scraping dalam skala besar dari ratusan atau bahkan ribuan situs web menjadi jelas. Infrastruktur awal, yang memadai untuk operasi skala kecil, kini mengalami kesulitan dalam menghadapi beban yang meningkat, yang menyebabkan kinerja lebih lambat dan potensi ketidakakuratan data.

Selain itu, menangani sumber web yang beragam dan dinamis menambah lapisan kompleksitas. Situs web sering kali memperbarui strukturnya, menerapkan tindakan anti-scraping, atau memerlukan ekstraksi data dari konten kompleks yang dirender dengan JavaScript. Tantangan-tantangan ini memerlukan solusi yang kuat dan mudah beradaptasi serta dapat berkembang dengan lancar tanpa mengorbankan kualitas atau legalitas data.

Pengikisan web skala besar bukan hanya tentang menangani lebih banyak data tetapi melakukannya dengan cara yang efisien, andal, dan mematuhi standar hukum. Hal ini melibatkan pemilihan alat dan teknologi yang tepat, membangun infrastruktur yang kuat, dan menerapkan jalur pemrosesan data yang efisien. Memahami tantangan web scraping berskala besar dan mengembangkan strategi untuk mengatasinya sangat penting bagi bisnis yang ingin memanfaatkan potensi penuh dari data scraping.

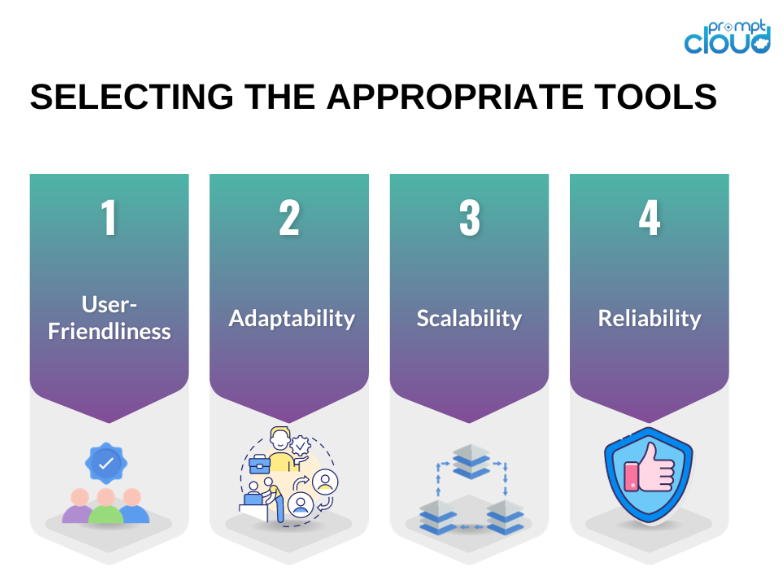

#1: Memilih Alat dan Teknologi yang Tepat

Memilih alat dan teknologi yang tepat adalah dasar dari operasi web scraping skala besar. Kerangka kerja pengikisan tingkat lanjut seperti Scrapy, Beautiful Soup, dan Selenium menawarkan fungsionalitas tangguh yang dapat menangani tugas pengikisan yang rumit. Alat-alat ini sangat baik untuk proyek yang lebih kecil dan lebih mudah dikelola, namun seiring dengan meningkatnya skala dan kompleksitas operasi pengumpulan data, diperlukan solusi yang lebih kuat dan fleksibel.

Di sinilah penyedia layanan web scraping seperti PromptCloud berperan. PromptCloud menawarkan solusi ekstraksi data komprehensif dan menyeluruh yang dirancang untuk disesuaikan dengan kebutuhan bisnis. Tidak seperti alat tradisional, PromptCloud menyediakan layanan terkelola sepenuhnya yang menangani semuanya mulai dari menyiapkan infrastruktur scraping hingga pengiriman data.

#2: Membangun Infrastruktur yang Kuat

Infrastruktur yang kuat sangat penting untuk mendukung operasi web scraping skala besar. Ini termasuk server yang kuat, solusi penyimpanan yang luas, dan koneksi internet berkecepatan tinggi. Memanfaatkan layanan infrastruktur cloud seperti Amazon Web Services (AWS), Google Cloud Platform (GCP), atau Microsoft Azure memastikan skalabilitas dan keandalan, sehingga memungkinkan bisnis untuk meningkatkan skala operasi mereka sesuai kebutuhan.

Menyiapkan dan mengelola infrastruktur Anda sendiri dapat memakan banyak sumber daya dan rumit. PromptCloud menawarkan solusi efisien yang menghilangkan tantangan ini. Dengan menyediakan layanan pengikisan data yang terkelola sepenuhnya, PromptCloud menangani kebutuhan infrastruktur, memastikan operasi Anda berjalan lancar dan efisien.

#3: Memastikan Kualitas dan Akurasi Data dalam Skala Besar

Menjaga kualitas dan akurasi data merupakan tantangan yang signifikan ketika berhadapan dengan kumpulan data yang besar. Seiring bertambahnya volume data, potensi kesalahan dan inkonsistensi meningkat, sehingga penerapan prosedur validasi dan pembersihan data yang kuat menjadi sangat penting. Memastikan bahwa data yang dikumpulkan dapat diandalkan dan dapat digunakan sangat penting untuk membuat keputusan bisnis yang tepat dan menjaga integritas analisis Anda.

Situs web sering kali mengubah strukturnya, sehingga dapat mengganggu operasi pengumpulan data dan menyebabkan ketidakakuratan. Memantau dan memperbarui skrip scraping Anda secara teratur sangat penting untuk beradaptasi dengan perubahan ini dan memastikan keakuratan data yang dikumpulkan.

PromptCloud memberikan solusi komprehensif untuk menjaga kualitas dan akurasi data dalam skala besar. Dengan memanfaatkan layanan pengikisan web skala besar dan pengikisan data terkelola, Anda dapat memastikan bahwa proses pengumpulan data Anda tetap kuat dan andal.

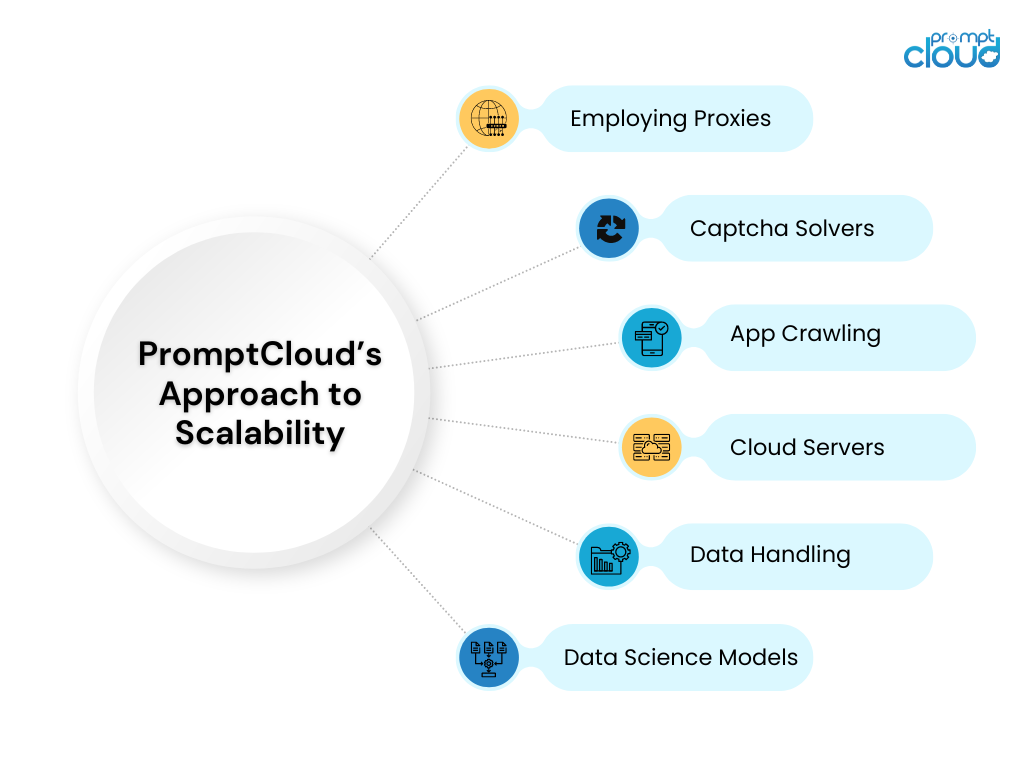

#4: Memanfaatkan Solusi Cloud untuk Skalabilitas

Solusi cloud menawarkan skalabilitas yang tak tertandingi untuk operasi pengumpulan data. Layanan seperti AWS EC2 dan Google Cloud Compute Engine memungkinkan bisnis meningkatkan atau menurunkan skala sumber daya komputasi mereka berdasarkan permintaan. Fleksibilitas ini memastikan bahwa operasi pengumpulan data dapat menangani berbagai beban kerja tanpa mengurangi kinerja.

PromptCloud memanfaatkan sepenuhnya solusi cloud untuk menawarkan layanan web scraping skala besar yang skalabel dan efisien. Dengan berintegrasi dengan platform cloud terkemuka, PromptCloud memastikan bahwa operasi pengumpulan data Anda dapat menangani volume data berapa pun dengan mudah.

#5: Menangani Penyimpanan dan Pengelolaan Data

Solusi penyimpanan dan pengelolaan data yang efektif sangat penting untuk menangani data bekas dalam jumlah besar. Seiring bertambahnya jumlah data, memastikan bahwa data disimpan dengan aman dan dapat diakses dengan cepat menjadi semakin penting.

PromptCloud menawarkan solusi penyimpanan dan manajemen data yang komprehensif sebagai bagian dari layanan pengikisan data terkelola. Dengan memanfaatkan solusi penyimpanan terukur dan menerapkan praktik terbaik dalam pengelolaan data, PromptCloud memastikan data Anda disimpan dengan aman dan dapat diakses secara efisien.

Menskalakan Operasi Scraping Web dengan PromptCloud

Menskalakan operasi web scraping untuk menangani data dalam jumlah besar menghadirkan banyak tantangan, mulai dari menjaga kualitas data dan mengelola penyimpanan hingga memastikan pengambilan dan pemrosesan yang efisien. Namun, dengan strategi dan alat yang tepat, tantangan-tantangan ini dapat diatasi secara efektif, sehingga memungkinkan bisnis untuk memanfaatkan potensi penuh dari web scraping untuk keunggulan kompetitif dan pengambilan keputusan yang tepat.

PromptCloud menawarkan serangkaian solusi komprehensif yang dirancang untuk mengatasi kompleksitas web scraping skala besar. Dengan memanfaatkan teknologi canggih dan infrastruktur yang kuat, kami memastikan bahwa operasi pengikisan data Anda dapat diskalakan, efisien, dan andal. Siap untuk menskalakan operasi pengikisan web Anda dan membuka potensi penuh dari data Anda? Bermitra dengan PromptCloud untuk memanfaatkan solusi mutakhir dan layanan ahli kami. Hubungi kami hari ini untuk menjadwalkan demo dan melihat solusi kami diterapkan.