Tantangan dan Solusi Pengikisan Web: Menavigasi Kompleksitas

Diterbitkan: 2023-09-13Pengikisan web telah menjadi teknik yang sangat berharga untuk mengekstraksi data dari situs web. Baik Anda perlu mengumpulkan informasi untuk tujuan penelitian, melacak harga atau tren, atau mengotomatiskan tugas online tertentu, web scraping dapat menghemat waktu dan tenaga Anda. Menavigasi seluk-beluk situs web dan mengatasi berbagai tantangan web scraping bisa menjadi tugas yang menakutkan. Pada artikel ini, kita akan mempelajari cara menyederhanakan proses web scraping dengan memperoleh pemahaman yang komprehensif tentangnya. Kami akan membahas langkah-langkah yang terlibat, memilih alat yang sesuai, mengidentifikasi data target, menavigasi struktur situs web, menangani otentikasi dan captcha, dan menangani konten dinamis.

Memahami Pengikisan Web

Pengikisan web adalah prosedur mengekstraksi data dari situs web melalui analisis dan penguraian kode HTML dan CSS. Ini mencakup pengiriman permintaan HTTP ke halaman web, mengambil konten HTML, dan kemudian mengekstraksi informasi terkait. Meskipun pengikisan web secara manual dengan memeriksa kode sumber dan menyalin data merupakan suatu pilihan, hal ini sering kali tidak efisien dan memakan waktu, terutama untuk pengumpulan data yang ekstensif.

Untuk mengotomatiskan proses pengikisan web, bahasa pemrograman seperti Python dan perpustakaan seperti Beautiful Soup atau Selenium, serta alat pengikisan web khusus seperti Scrapy atau Beautiful Soup dapat digunakan. Alat-alat ini menawarkan fungsionalitas untuk berinteraksi dengan situs web, mengurai HTML, dan mengekstraksi data secara efisien.

Tantangan Pengikisan Web

Memilih Alat yang Sesuai

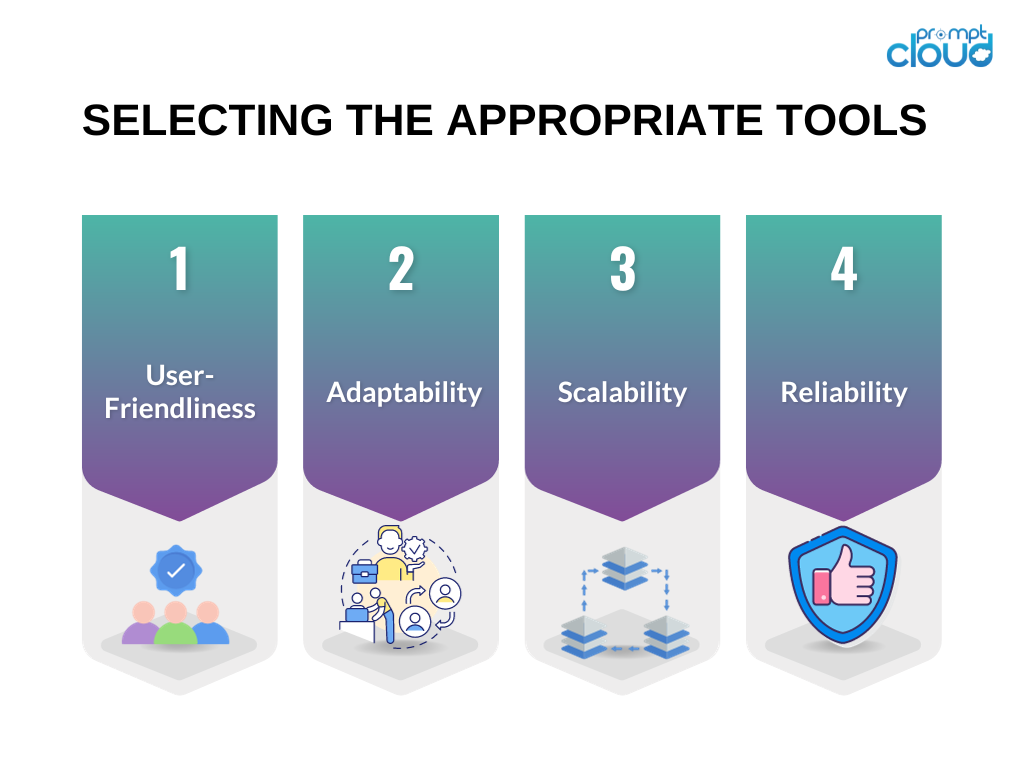

Memilih alat yang tepat sangat penting untuk keberhasilan upaya web scraping Anda. Berikut adalah beberapa pertimbangan ketika memilih alat untuk proyek web scraping Anda:

Keramahan Pengguna : Prioritaskan alat dengan antarmuka yang ramah pengguna atau yang memberikan dokumentasi yang jelas dan contoh praktis.

Kemampuan beradaptasi : Pilih alat yang mampu menangani beragam jenis situs web dan beradaptasi terhadap perubahan struktur situs web.

Skalabilitas : Jika tugas pengumpulan data Anda melibatkan sejumlah besar data atau memerlukan kemampuan pengikisan web tingkat lanjut, pertimbangkan alat yang dapat menangani volume tinggi dan menawarkan fitur pemrosesan paralel.

Keandalan : Pastikan alat dilengkapi untuk mengelola berbagai jenis kesalahan, seperti waktu tunggu koneksi habis atau kesalahan HTTP, dan dilengkapi dengan mekanisme penanganan kesalahan bawaan.

Berdasarkan kriteria ini, alat yang banyak digunakan seperti Beautiful Soup, dan Selenium sering direkomendasikan untuk proyek web scraping.

Mengidentifikasi Data Sasaran

Sebelum memulai proyek web scraping, penting untuk mengidentifikasi data target yang ingin Anda ekstrak dari situs web. Ini bisa berupa informasi produk, artikel berita, postingan media sosial, atau jenis konten lainnya. Memahami struktur situs web target sangat penting untuk mengekstraksi data yang diinginkan secara efektif.

Untuk mengidentifikasi data target, Anda dapat menggunakan alat pengembang browser seperti Chrome DevTools atau Alat Pengembang Firefox. Alat-alat ini memungkinkan Anda memeriksa struktur HTML halaman web, mengidentifikasi elemen spesifik yang berisi data yang Anda perlukan, dan memahami pemilih CSS atau ekspresi XPath yang diperlukan untuk mengekstrak data tersebut.

Menavigasi Struktur Situs Web

Situs web dapat memiliki struktur kompleks dengan elemen HTML bersarang, konten JavaScript dinamis, atau permintaan AJAX. Menavigasi struktur ini dan mengekstraksi informasi yang relevan memerlukan analisis dan strategi yang cermat.

Berikut beberapa teknik untuk membantu Anda menavigasi struktur situs web yang kompleks:

Gunakan pemilih CSS atau ekspresi XPath : Dengan memahami struktur kode HTML, Anda dapat menggunakan pemilih CSS atau ekspresi XPath untuk menargetkan elemen tertentu dan mengekstrak data yang diinginkan.

Tangani penomoran halaman : Jika data target tersebar di beberapa halaman, Anda perlu menerapkan penomoran halaman untuk mengikis semua informasi. Hal ini dapat dilakukan dengan mengotomatiskan proses mengklik tombol “berikutnya” atau “muat lebih banyak” atau dengan membuat URL dengan parameter berbeda.

Berurusan dengan elemen bersarang : Terkadang, data target disarangkan dalam beberapa level elemen HTML. Dalam kasus seperti itu, Anda perlu menelusuri elemen bertumpuk menggunakan hubungan induk-anak atau hubungan saudara untuk mengekstrak informasi yang diinginkan.

Menangani Otentikasi dan Captcha

Beberapa situs web mungkin memerlukan autentikasi atau menampilkan captcha untuk mencegah pengikisan otomatis. Untuk mengatasi tantangan web scraping ini, Anda dapat menggunakan strategi berikut:

Manajemen sesi : Pertahankan status sesi dengan cookie atau token untuk menangani persyaratan autentikasi.

Spoofing Agen-Pengguna : Meniru agen pengguna yang berbeda agar tampil sebagai pengguna biasa dan menghindari deteksi.

Layanan penyelesaian captcha : Gunakan layanan pihak ketiga yang dapat menyelesaikan captcha secara otomatis atas nama Anda.

Ingatlah bahwa meskipun autentikasi dan captcha dapat dilewati, Anda harus memastikan bahwa aktivitas web scraping Anda mematuhi persyaratan layanan situs web dan batasan hukum.

Berurusan dengan Konten Dinamis

Situs web sering kali menggunakan JavaScript untuk memuat konten secara dinamis atau mengambil data melalui permintaan AJAX. Metode pengikisan web tradisional mungkin tidak menangkap konten dinamis ini. Untuk menangani konten dinamis, pertimbangkan pendekatan berikut:

Gunakan browser tanpa kepala : Alat seperti Selenium memungkinkan Anda mengontrol browser web sebenarnya secara terprogram dan berinteraksi dengan konten dinamis.

Memanfaatkan perpustakaan web scraping : Perpustakaan tertentu seperti Puppeteer atau Scrapy-Splash dapat menangani rendering JavaScript dan ekstraksi konten dinamis.

Dengan menggunakan teknik ini, Anda dapat memastikan bahwa Anda dapat menghapus situs web yang sangat bergantung pada JavaScript untuk pengiriman konten.

Menerapkan Penanganan Kesalahan

Pengikisan web tidak selalu merupakan proses yang mulus. Situs web dapat mengubah strukturnya, mengembalikan kesalahan, atau menerapkan batasan pada aktivitas pengikisan. Untuk memitigasi risiko yang terkait dengan tantangan web scraping ini, penting untuk menerapkan mekanisme penanganan kesalahan:

Pantau perubahan situs web : Periksa secara teratur apakah struktur atau tata letak situs web telah berubah, dan sesuaikan kode scraping Anda.

Mekanisme coba ulang dan batas waktu : Menerapkan mekanisme coba ulang dan batas waktu untuk menangani kesalahan intermiten seperti batas waktu koneksi atau kesalahan HTTP dengan baik.

Catat dan tangani pengecualian : Tangkap dan tangani berbagai jenis pengecualian, seperti kesalahan penguraian atau kegagalan jaringan, untuk mencegah proses pengikisan Anda gagal sepenuhnya.

Dengan menerapkan teknik penanganan kesalahan, Anda dapat memastikan keandalan dan ketahanan kode pengikisan web Anda.

Ringkasan

Kesimpulannya, tantangan web scraping dapat dipermudah dengan memahami prosesnya, memilih alat yang tepat, mengidentifikasi data target, menavigasi struktur situs web, menangani otentikasi dan captcha, menangani konten dinamis, dan menerapkan teknik penanganan kesalahan. Dengan mengikuti praktik terbaik ini, Anda dapat mengatasi kompleksitas web scraping dan mengumpulkan data yang Anda perlukan secara efisien.