Pengikisan Data Web di Era Big Data: Peluang dan Dilema Etis

Diterbitkan: 2024-05-29Pengikisan Data Web dan Analisis Big Data

Pengikisan data web telah muncul sebagai mekanisme penting untuk mengumpulkan data online. Proses ini melibatkan pengambilan informasi secara otomatis dari situs web, mengubah web yang tidak terstruktur menjadi banyak data terstruktur yang siap untuk dianalisis.

Sumber Gambar: https://www.sas.com/

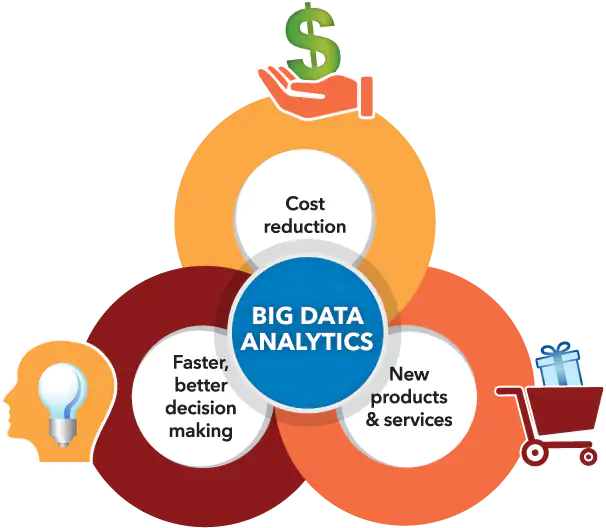

Pada saat yang sama, analisis big data telah menciptakan peluang dalam memahami pola, tren, dan wawasan dari kumpulan data besar yang terakumulasi, sering kali melalui pengumpulan data web. Ketika volume data yang sangat besar (sekitar 2,5 triliun byte data dihasilkan setiap hari) menjadi lebih mudah diakses, sintesis data web dengan analisis big data membuka banyak sekali kemungkinan bagi dunia usaha, peneliti, dan pembuat kebijakan.

Dengan menggabungkan kemampuan teknologi ini secara terampil, mereka memposisikan diri untuk memanfaatkan pengambilan keputusan berdasarkan data, memacu inovasi layanan, dan membentuk upaya strategis yang disesuaikan dengan tujuan mereka. Namun demikian, penting untuk mengakui munculnya dilema etika yang diakibatkan oleh hubungan sinergis antara alat-alat canggih ini.

Garis tipis harus diambil dengan hati-hati mengenai keseimbangan penting antara memaksimalkan nilai data dan menjaga hak privasi individu, memastikan tidak ada aspek yang menutupi aspek lainnya.

Manfaat Pengikisan Data Web untuk Proyek Big Data

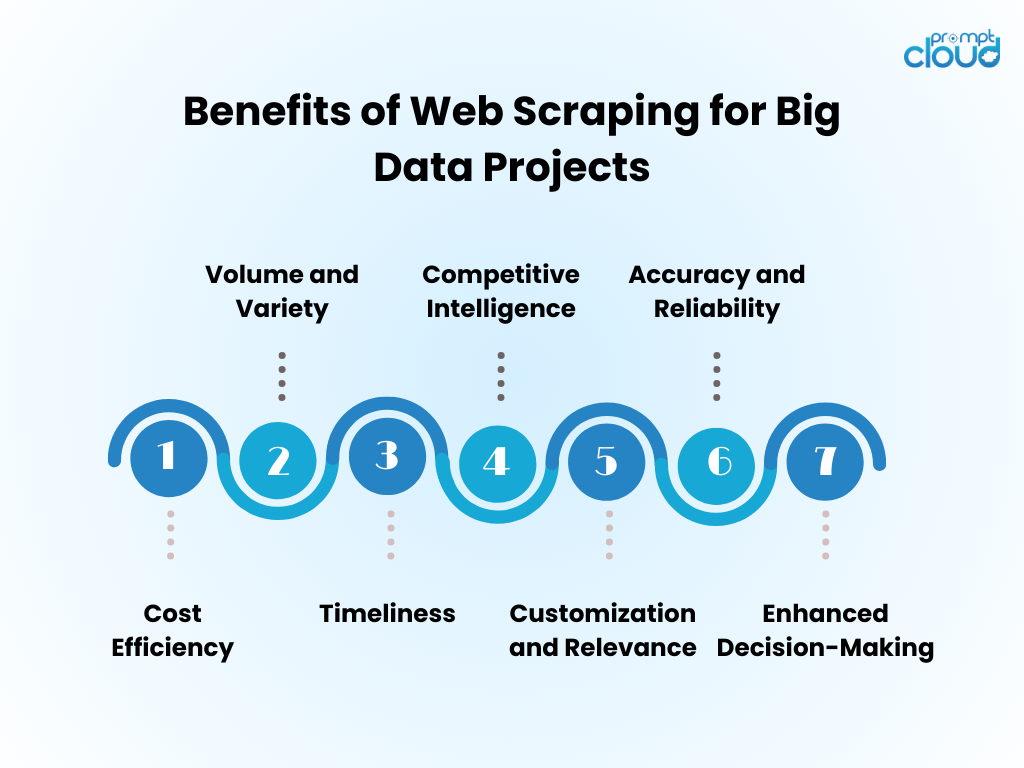

- Efisiensi Biaya : Mengotomatiskan pengumpulan data melalui web scraping secara signifikan mengurangi biaya tenaga kerja manusia dan mempercepat waktu untuk mendapatkan wawasan.

- Volume dan Keanekaragaman : Memungkinkan pengambilan data dalam jumlah besar dari berbagai sumber, yang penting untuk mendukung analisis big data.

- Ketepatan waktu : Web scraping menyediakan data real-time atau hampir real-time, memungkinkan respons yang lebih tangkas terhadap tren pasar.

- Kecerdasan Kompetitif : Ini memberdayakan organisasi dengan kemampuan untuk memantau pesaing dan perubahan industri secara dekat.

- Penyesuaian dan Relevansi : Data dapat disesuaikan dengan kebutuhan spesifik, memastikan bahwa analisis relevan dan fokus.

- Akurasi dan Keandalan : Pengikisan otomatis meminimalkan kesalahan manusia, sehingga menghasilkan kumpulan data yang lebih akurat.

- Peningkatan Pengambilan Keputusan : Akses terhadap data yang relevan dan tepat waktu mendukung pengambilan keputusan dan perencanaan strategis.

Teknik Pengikisan Web: Dari Dasar hingga Lanjutan

Sumber Gambar: loginworks

Pengikisan data web telah berkembang seiring dengan perkembangan teknologi, dimulai dengan teknik dasar yang berkembang seiring dengan meningkatnya kompleksitas data.

- Teknik Dasar : Awalnya, scraper mengambil data menggunakan permintaan HTTP sederhana untuk mendapatkan halaman HTML, menguraikan konten melalui perpustakaan seperti Beautiful Soup dengan Python. Alat-alat ini cukup dapat menangani situs web yang tidak rumit.

- Teknik Menengah : Untuk konten dinamis, teknik berkembang dengan menyertakan alat otomatisasi seperti Selenium, yang dapat berinteraksi dengan JavaScript dan meniru perilaku browser.

- Teknik Tingkat Lanjut : Beralih ke pengikisan tingkat lanjut, metode ini menggabungkan browser tanpa kepala, dan server proxy untuk menavigasi tindakan anti-pengikisan. Ekstraksi data menjadi canggih dengan algoritma pembelajaran mesin, memproses bahasa alami dan gambar untuk mengambil informasi.

- Pertimbangan Etis : Terlepas dari kompleksitas teknik, dilema etika tetap ada, sehingga memerlukan keseimbangan antara akses data dan penghormatan terhadap privasi dan kepemilikan.

Memasukkan Data yang Digores Web ke dalam Analisis Big Data

Data yang diambil dari web, ketika diintegrasikan ke dalam analisis big data, dapat mengungkap wawasan pasar dan tren konsumen yang komprehensif. Analis menggabungkan informasi yang diambil dari web dengan kumpulan data yang ada, sehingga meningkatkan kedalaman dan keluasan hasil analisis. Penggabungan ini menghasilkan model prediktif yang lebih baik, strategi pemasaran yang disesuaikan, dan profil konsumen yang lebih baik.

- Pembersihan Data: Data yang tergores memerlukan pembersihan yang cermat untuk memastikan akurasi dalam analisis.

- Integrasi Data: Menggabungkan data bekas dengan sumber lain memerlukan teknik integrasi data tingkat lanjut.

- Peningkatan Analisis: Dengan data tambahan, algoritme pembelajaran mesin dapat mengungkap pola yang lebih beragam.

- Pertimbangan Etis: Analis harus memastikan penggunaan data web mematuhi standar hukum dan etika.

Kumpulan data yang diperluas mendorong inovasi, namun menuntut metodologi yang ketat dan pengawasan etis.

Praktik Terbaik untuk Pengikisan Web yang Efisien

- Hormati protokol robots.txt; jangan mengikis situs yang melarangnya melalui file robots mereka.

- Jadwalkan aktivitas scraping selama waktu di luar jam sibuk untuk meminimalkan dampak pada kinerja server target.

- Memanfaatkan caching untuk menghindari pengikisan ulang konten yang sama, menghormati data situs web, dan menghemat bandwidth.

- Terapkan penanganan kesalahan yang tepat untuk mencegah scraper Anda mogok dan untuk menghindari pengiriman terlalu banyak permintaan jika terjadi kesalahan.

- Putar agen pengguna dan alamat IP untuk mencegah pemblokiran, menyimulasikan perilaku penjelajahan yang lebih alami.

- Tetap terinformasi tentang praktik web scraping yang sah dan etis, pastikan aktivitas scraping Anda tidak melanggar undang-undang hak cipta atau privasi.

- Optimalkan kode agar efisien dan kurangi beban pada sistem scraping dan situs web target.

- Perbarui kode scraping secara berkala untuk beradaptasi dengan perubahan apa pun dalam tata letak atau teknologi situs web, menjaga kemanjuran dan keakuratan pengambilan data Anda.

- Simpan data yang dikumpulkan dengan aman dan kelola sesuai dengan semua peraturan perlindungan data yang relevan.

Masa Depan Web Scraping di Era Big Data

Seiring dengan berkembangnya Big Data, pengambilan data web siap menjadi lebih integral dalam analisis data dan intelijen bisnis. Masa depan kemungkinan besar akan terlihat:

- Model pembelajaran mesin yang ditingkatkan dilatih dengan kumpulan data besar yang diperoleh melalui scraping, meningkatkan akurasi dan wawasan.

- Meningkatnya permintaan akan pengambilan data secara real-time, memungkinkan bisnis mengambil keputusan lebih cepat dan berdasarkan data.

- Pengembangan alat scraping yang lebih canggih untuk menavigasi teknologi anti-scraping dan mempertahankan praktik pengumpulan data yang etis.

- Peraturan yang lebih ketat dan undang-undang privasi membentuk metodologi pengumpulan data web, memastikan bahwa data dikumpulkan secara bertanggung jawab dan dengan persetujuan.

- Munculnya platform scraping-as-a-service, yang menawarkan ekstraksi data yang disesuaikan untuk semua ukuran bisnis.

Dengan kemajuan ini, web scraping akan terus menjadi alat penting dalam perangkat Big Data.

Jika pengikisan web manual terasa sulit atau jika bantuan diperlukan untuk mengatasi tantangan rumit terkait perolehan data berharga, yakinlah bahwa PromptCloud siap membantu!

Kami mengkhususkan diri dalam memberikan solusi web scraping komprehensif yang dirancang secara eksplisit untuk inisiatif data besar, memastikan ekstraksi data berskala besar yang dapat diandalkan.

Percayakan pada kami untuk mengatasi aspek-aspek yang menuntut, sehingga Anda dapat berkonsentrasi dalam menghasilkan pilihan yang tepat dengan menggunakan kumpulan data yang kuat dan bermakna. Hubungi kami di sales@promptcloud.com untuk mengetahui bagaimana keahlian kami dapat meningkatkan rencana permainan big data Anda!