Prevenire il collasso del modello di intelligenza artificiale: affrontare il rischio intrinseco dei set di dati sintetici

Pubblicato: 2023-10-05L’Intelligenza Artificiale (AI) ha trasformato in modo significativo la nostra vita quotidiana suggerendo contenuti personalizzati sulle piattaforme di streaming e abilitando assistenti digitali sugli smartphone. Ora, questi progressi sono resi possibili da sofisticati modelli di intelligenza artificiale che imparano da grandi quantità di dati.

Secondo vari rapporti, i contenuti generati dall’intelligenza artificiale stanno diventando sempre più diffusi su Internet e nei prossimi anni potrebbero comprendere fino al 90% delle informazioni online.

Con un tale afflusso di informazioni, si può facilmente affermare che nel mondo odierno, ricco di dati, l’intelligenza artificiale deve affrontare una sfida unica, e che sta soffocando con la sua abbondanza di dati.

I rapporti suggeriscono inoltre che la quantità significativa di questi contenuti generati dall’intelligenza artificiale può sopraffare le persone con informazioni eccessive, rendendo loro difficile determinare cosa sia affidabile e generato dall’uomo. Inoltre, ci sono preoccupazioni per la potenziale perdita di posti di lavoro in campi creativi come l’arte, il giornalismo e la scrittura, tutto perché l’intelligenza artificiale sta diventando sempre più capace di produrre contenuti tradizionalmente creati dagli esseri umani.

Venendo agli stessi sistemi di intelligenza artificiale, stanno emergendo problemi come il “Collapse del modello”, che si riferisce a un problema in cui i modelli di intelligenza artificiale addestrati su set di dati di grandi dimensioni producono risultati di qualità inferiore dando priorità alle scelte di parole comuni rispetto ad alternative creative. Il “disturbo dell’autofagia modello” o “IA asburgica” è un’altra preoccupazione in cui i sistemi di intelligenza artificiale eccessivamente addestrati sui risultati di altri modelli di intelligenza artificiale possono mostrare caratteristiche indesiderabili o avere pregiudizi.

Queste sfide possono potenzialmente danneggiare la qualità e l’affidabilità dei contenuti generati dall’intelligenza artificiale, distruggendo la fiducia in tali sistemi e peggiorando il sovraccarico di informazioni.

Il nostro blog ti aiuterà a comprendere tutto ciò che riguarda la prevenzione del collasso del modello di intelligenza artificiale. Il progredire della rivoluzione dell’intelligenza artificiale generativa comporta sfide e incertezze significative per il panorama dell’informazione online. Quindi, tuffiamoci nei dettagli a testa alta.

Comprendere il collasso del modello AI

Nell’apprendimento automatico, il “collasso del modello” si riferisce a una situazione in cui il modello di intelligenza artificiale non riesce a fornire una varietà di risultati utili. Produce invece un insieme ristretto di risultati ripetitivi o di bassa qualità. Questo problema può verificarsi in vari modelli, ma viene spesso osservato durante l'addestramento di modelli complessi come le reti generative avversarie (GAN). Il collasso del modello può ostacolare la capacità del modello di generare output diversificati e preziosi, incidendo sulle sue prestazioni complessive.

Illustriamo un esempio di collasso del modello. Immagina uno studente d'arte molto entusiasta che rappresenta il nostro modello di intelligenza artificiale, che ha il compito di creare dipinti di zebre. All'inizio, le loro opere d'arte sono impressionanti e ricordano distintamente le zebre. Tuttavia, man mano che si procede, i loro dipinti perdono gradualmente la somiglianza con le zebre e la qualità diminuisce. Questo è simile al “collasso del modello” nell’apprendimento automatico, dove il modello di intelligenza artificiale, come il nostro studente d’arte, inizialmente funziona bene ma poi fatica a mantenere le caratteristiche essenziali per le quali è stato progettato.

Secondo i recenti progressi nel campo dell’intelligenza artificiale, i ricercatori sono diventati molto interessati all’utilizzo di dati artificiali o sintetici per addestrare nuovi modelli di intelligenza artificiale quando si tratta di generare immagini e testo. Tuttavia, un concetto chiamato "Disturbo dell'autofagia modello" (MAD) paragona questo processo a un ciclo autodistruttivo.

A meno che non continuiamo ad aggiungere regolarmente nuovi dati del mondo reale, la qualità e la varietà dei modelli di intelligenza artificiale che creiamo utilizzando dati sintetici potrebbero peggiorare nel tempo. Pertanto, è essenziale trovare un equilibrio tra dati sintetici e reali per garantire che i modelli di intelligenza artificiale funzionino bene.

Questo equilibrio è fondamentale per prevenire un declino nella qualità e nella diversità dei modelli mentre continuano ad apprendere. Scoprire come utilizzare in modo efficace i dati sintetici per la prevenzione del collasso dei modelli di intelligenza artificiale è una sfida continua quando si tratta dell’evoluzione dell’intelligenza artificiale generativa e dell’uso di dati sintetici.

Secondo il New Yorker, se ChatGPT è considerata una versione compatta di Internet, simile a quella di un file JPEG che comprime una fotografia, allora addestrare i futuri chatbot sui risultati di ChatGPT equivale digitalmente a fare ripetutamente fotocopie di fotocopie proprio come il vecchi tempi. Semplicemente, la qualità dell'immagine è destinata a peggiorare ad ogni iterazione.

Pertanto, per superare questa sfida, le organizzazioni devono concentrarsi sull’affinamento dei propri approcci per garantire che questi prodotti di intelligenza artificiale generativa continuino a fornire risposte accurate in questo panorama digitale.

[Leggi anche: IA responsabile – Affrontare le sfide dell’adozione con principi guida e strategie]

Come avviene il collasso del modello di intelligenza artificiale?

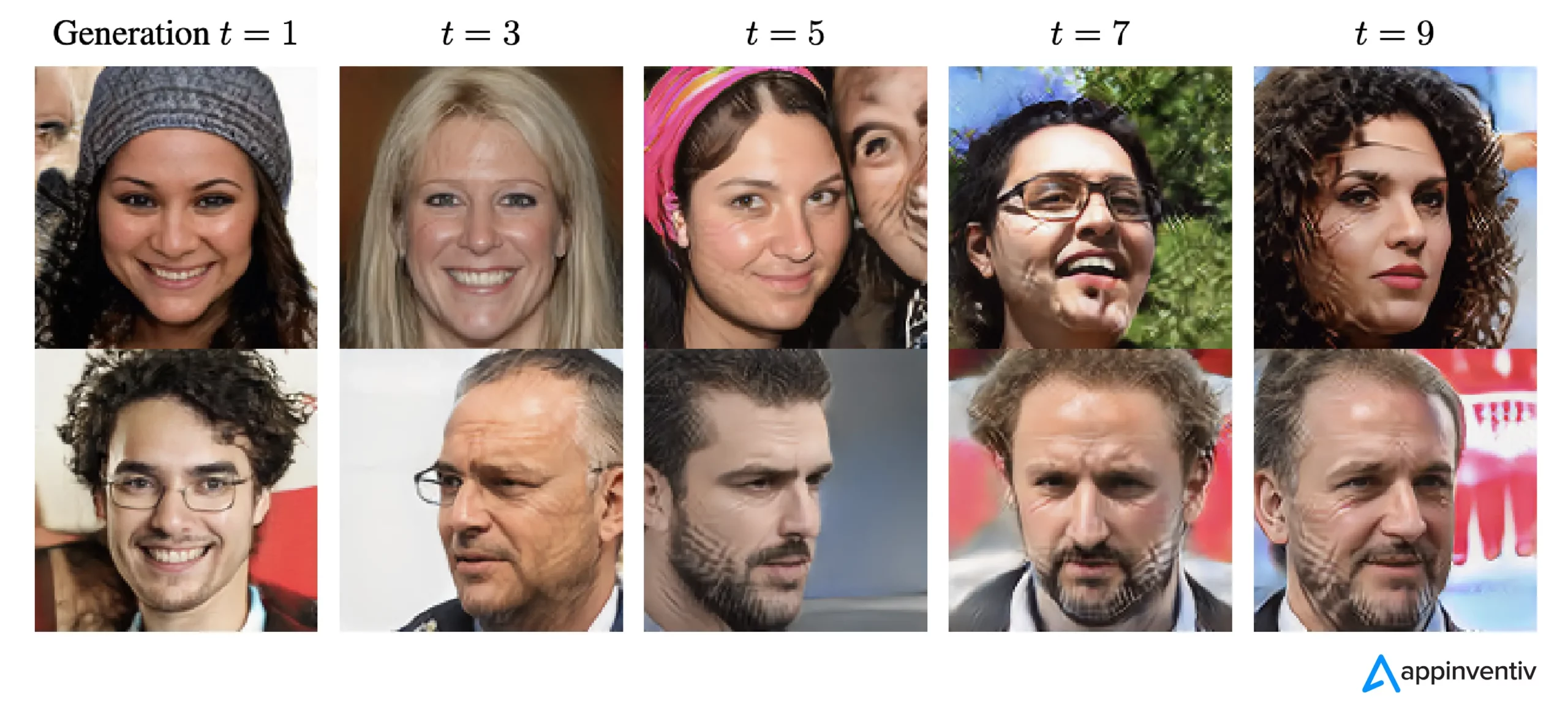

Il collasso del modello si verifica quando i nuovi modelli di intelligenza artificiale vengono addestrati utilizzando i dati generati da modelli precedenti. Questi nuovi modelli si basano sui modelli osservati nei dati generati. Il collasso del modello affonda le sue radici nell'idea che i modelli generativi tendono a ripetere modelli che hanno già appreso e c'è un limite alle informazioni che possono estrarre da questi modelli.

Nei casi di collasso del modello, gli eventi che potrebbero verificarsi vengono esagerati, mentre gli eventi meno probabili vengono sottovalutati. Nel corso di più generazioni, gli eventi probabili dominano i dati e le parti meno comuni ma comunque cruciali dei dati, chiamate code, diminuiscono. Queste code sono essenziali per mantenere l'accuratezza e la diversità degli output del modello. Man mano che le generazioni avanzano, gli errori prendono il sopravvento sui dati e il modello li interpreta sempre più erroneamente.

Secondo la ricerca esistono due tipi di collasso del modello: precoce e tardivo. Il collasso precoce del modello comporta la perdita di informazioni su eventi rari da parte del modello. Nel collasso finale del modello, il modello confonde modelli distinti nei dati, producendo risultati che hanno poca somiglianza con i dati originali.

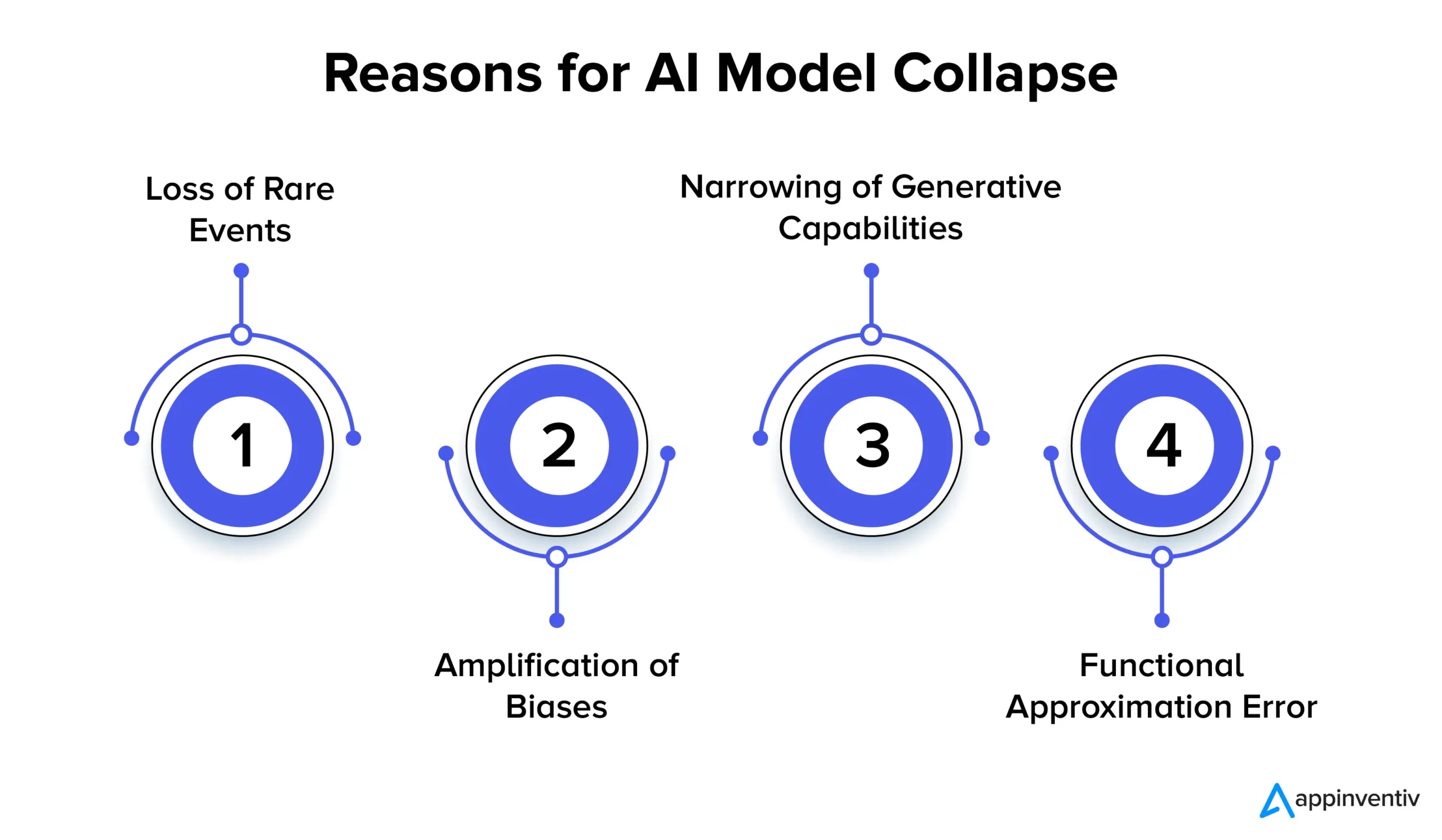

Esaminiamo in dettaglio le molteplici ragioni del collasso del modello AI di seguito:

Perdita di eventi rari

Quando i modelli di intelligenza artificiale vengono addestrati ripetutamente sui dati generati dalle versioni precedenti, cercano di concentrarsi su modelli comuni e dimenticare eventi rari. Questo fenomeno è simile alla perdita della memoria a lungo termine da parte dei modelli. Gli eventi rari spesso rivestono un'importanza significativa, come l'identificazione di anomalie nei processi di produzione o il rilevamento di transazioni fraudolente. Ad esempio, quando si tratta di rilevamento delle frodi, modelli linguistici specifici possono segnalare comportamenti fraudolenti, rendendo fondamentale conservare e apprendere questi modelli rari.

Amplificazione dei bias

Ogni iterazione di addestramento sui dati generati dall'intelligenza artificiale può amplificare i pregiudizi esistenti nei dati di addestramento. Poiché l'output del modello riflette solitamente i dati su cui è stato addestrato, eventuali distorsioni all'interno di tali dati possono essere esagerate con il tempo. Ciò può portare ad un’amplificazione dei bias in varie applicazioni di intelligenza artificiale. Ad esempio, i risultati possono portare a problemi come discriminazione, pregiudizi razziali e contenuti distorti dei social media. Pertanto, l’implementazione di controlli per rilevare e mitigare i bias è estremamente essenziale.

Restringimento delle capacità generative

Man mano che i modelli di intelligenza artificiale continuano ad apprendere dai dati generati, le loro capacità generative possono ridursi. Il modello viene piuttosto influenzato dalle proprie interpretazioni della realtà, producendo contenuti sempre più simili, privi di diversità e di rappresentazione di eventi rari. Ciò può portare ad una perdita di originalità. Ad esempio, quando si tratta di Large Language Models (LLM), la variazione conferisce a ogni scrittore o artista il proprio tono e stile distinti.

La ricerca suggerisce semplicemente che se nuovi dati non vengono aggiunti regolarmente durante il processo di formazione, i futuri modelli di intelligenza artificiale potrebbero finire per diventare meno accurati o produrre risultati meno diversificati nel tempo.

Errore di approssimazione funzionale

Un errore di approssimazione funzionale può verificarsi quando gli approssimatori di funzioni utilizzati nel modello non sono sufficientemente espressivi. Sebbene questo errore possa essere mitigato impiegando modelli più espressivi, può anche introdurre rumore e portare a un overfitting. Trovare il giusto equilibrio tra l’espressività del modello e il controllo del rumore è fondamentale per prevenire questi errori.

Implicazioni del collasso del modello: perché la stabilità del modello AI è importante?

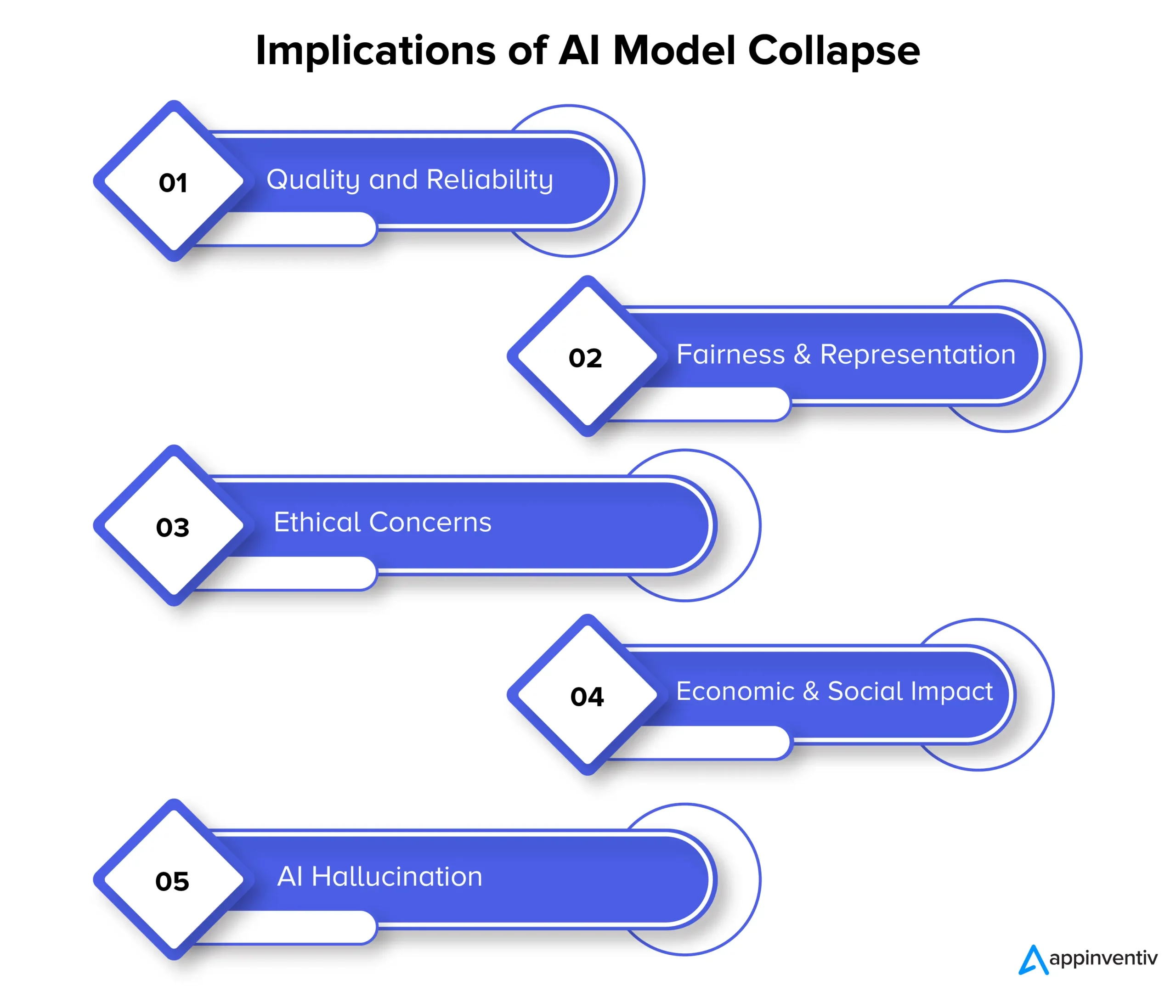

Il collasso del modello può in definitiva avere un impatto sulla qualità, sull’affidabilità e sull’equità dei contenuti generati dall’intelligenza artificiale, il che può comportare ulteriori rischi per le organizzazioni. Esaminiamo in dettaglio le implicazioni del collasso del modello di seguito:

Qualità e affidabilità

Man mano che i modelli di intelligenza artificiale degenerano nel loro apprendimento, i contenuti che generano diventano meno affidabili e la loro qualità peggiora. Ciò accade quando i modelli si discostano dalla distribuzione originale dei dati e si affidano maggiormente alle proprie interpretazioni della realtà. Ad esempio, un modello di intelligenza artificiale progettato per la generazione di notizie può produrre articoli di notizie imprecisi o addirittura completamente inventati.

Equità e rappresentanza

Il collasso del modello è anche motivo di preoccupazione quando si tratta di equità e rappresentazione del contenuto generato. Quando i modelli dimenticano eventi rari e limitano le loro capacità generative, i contenuti relativi ad argomenti meno comuni potrebbero essere rappresentati in modo inadeguato. Ciò porta a pregiudizi, stereotipi e all’esclusione di determinate prospettive.

Preoccupazioni etiche

Il collasso del modello pone notevoli preoccupazioni etiche, in particolare quando i contenuti generati dall’intelligenza artificiale hanno il potere di influenzare il processo decisionale. Le conseguenze del collasso del modello includono la diffusione di contenuti distorti e imprecisi, che possono avere un impatto significativo sulla vita, sulle opinioni e sull’accesso alle opportunità delle persone.

Impatto economico e sociale

Su scala economica e sociale, il collasso del modello può influenzare la fiducia e l’adozione delle tecnologie di intelligenza artificiale. Se non si può fare affidamento sui contenuti generati dall’intelligenza artificiale, le aziende e i consumatori potrebbero esitare ad abbracciare queste tecnologie. Ciò può avere implicazioni economiche e la fiducia nelle tecnologie di intelligenza artificiale può ostacolare di conseguenza.

Allucinazione dell'IA

L'allucinazione dell'IA si verifica quando i modelli di intelligenza artificiale creano contenuti fantasiosi o non realistici che non sono in linea con i fatti o coerenti in alcun modo. Ciò può comportare informazioni imprecise, causando potenzialmente disinformazione o confusione. È particolarmente problematico in applicazioni come la generazione di notizie, la diagnosi di condizioni mediche o la creazione di documenti legali in cui l'accuratezza e l'affidabilità sono estremamente vitali.

Spieghiamo il contesto con un esempio di allucinazione AI. Supponiamo che esista un modello di intelligenza artificiale addestrato a generare immagini di animali. Ora, dopo aver richiesto l’immagine di un animale, il modello potrebbe produrre l’immagine di uno “zebroide”, un ibrido tra una zebra e un cavallo. Anche se questa immagine può sembrare visivamente realistica, è fondamentale capire che è solo una creazione dell'immaginazione del modello AI, poiché nessun animale simile esiste nel mondo reale.

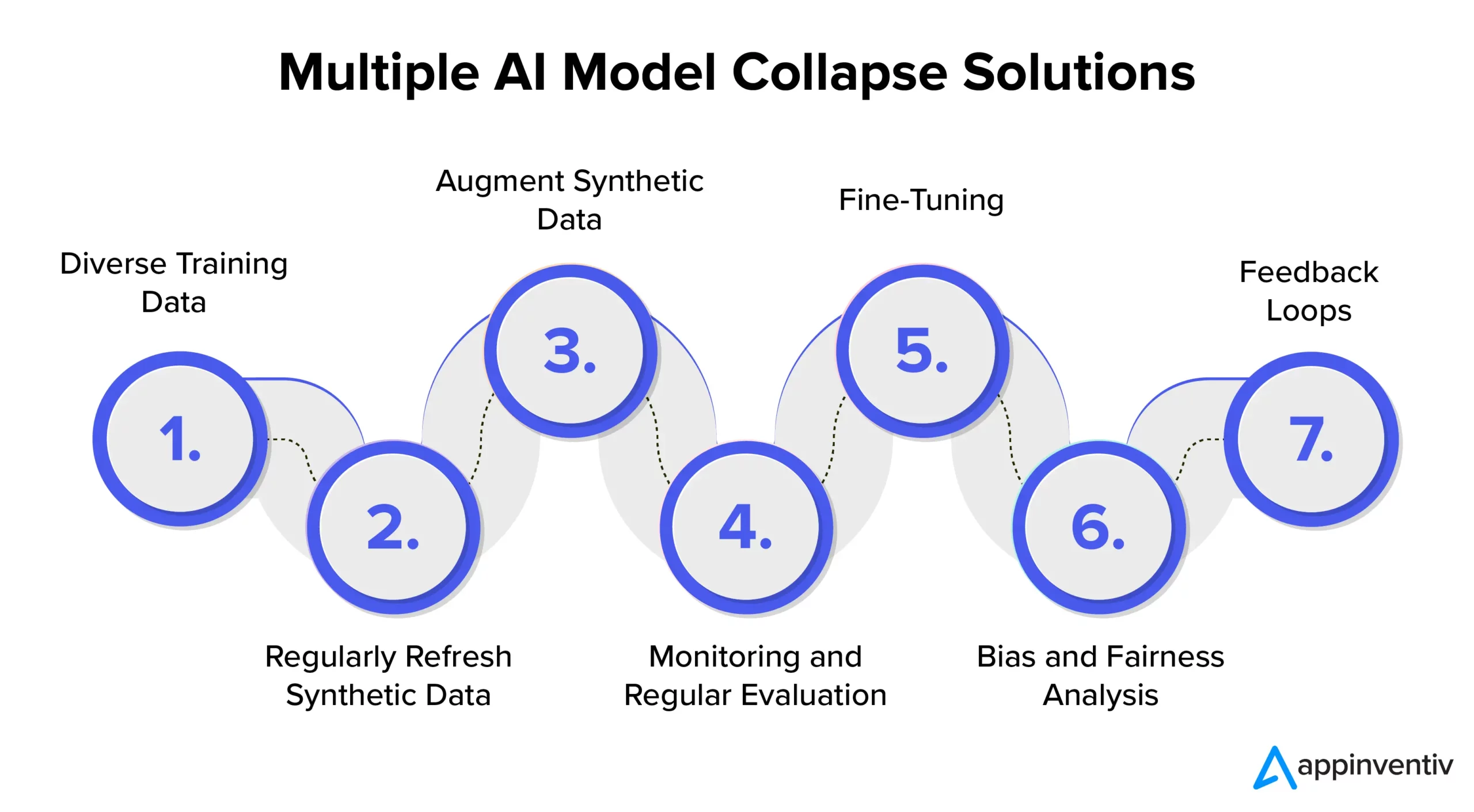

Prevenzione del collasso del modello di intelligenza artificiale: comprensione delle soluzioni di collasso del modello di intelligenza artificiale

Per garantire la stabilità e l’affidabilità del modello di intelligenza artificiale, è essenziale esplorare strategie e migliori pratiche per affrontare in modo efficace la prevenzione del collasso del modello di intelligenza artificiale. Pertanto, si consiglia di collaborare con un’azienda dedicata allo sviluppo dell’intelligenza artificiale come Appinventiv che possa fornire competenze e guida nell’implementazione di queste misure preventive, garantendo al contempo che i sistemi di intelligenza artificiale forniscano costantemente risultati di alta qualità.

Diversi dati di formazione

Per affrontare in modo efficace il collasso del modello di intelligenza artificiale e prevenire risultati indesiderati, è fondamentale curare un set di dati di addestramento che includa una varietà di origini e tipologie di dati. Questo set di dati dovrebbe essere costituito sia da dati sintetici generati dal modello che da dati del mondo reale che rappresentano accuratamente la complessità del problema. È importante aggiornare regolarmente questo set di dati con informazioni nuove e pertinenti. Il modello è esposto a un'ampia gamma di modelli incorporando diversi dati di addestramento. Questo aiuta a prevenire la stagnazione dei dati.

Aggiorna regolarmente i dati sintetici

Il collasso del modello è un rischio quando i modelli di intelligenza artificiale fanno molto affidamento sui propri dati generati. Per un’efficace mitigazione del rischio nell’intelligenza artificiale, è importante introdurre regolarmente dati nuovi, autentici e reali nella pipeline di formazione. Questa pratica garantisce che il modello rimanga adattivo ed eviti di rimanere bloccato in un ciclo ripetitivo. Ciò può aiutare a generare risultati diversificati e pertinenti.

Aumentare i dati sintetici

Il miglioramento dei dati sintetici attraverso tecniche di data augmentation è un metodo collaudato per prevenire il collasso del modello. Queste tecniche introducono variabilità nei dati sintetici utilizzando le variazioni naturali dei dati del mondo reale. L'aggiunta di rumore controllato ai dati generati incoraggia il modello ad apprendere una gamma più ampia di modelli, riducendo le possibilità di generare output ripetitivi.

Monitoraggio e valutazione regolare

Monitorare e valutare regolarmente le prestazioni del modello di intelligenza artificiale è fondamentale per individuare tempestivamente il collasso del modello. L'implementazione di un framework MLOps garantisce il monitoraggio continuo e l'allineamento con gli obiettivi di un'organizzazione, consentendo così interventi e aggiustamenti tempestivi.

[Leggi anche: Come evitare violazioni di conformità durante lo sviluppo di prodotti IA]

Ritocchi

È importante considerare l’implementazione di strategie di messa a punto per mantenere la stabilità del modello e prevenire il collasso. Queste strategie per prevenire il fallimento del modello di intelligenza artificiale consentono al modello di adattarsi ai nuovi dati preservando la conoscenza precedente.

Analisi dei bias e dell'equità

Un’analisi rigorosa dei pregiudizi e dell’equità sono cruciali per prevenire il collasso del modello e le questioni etiche. È essenziale identificare e affrontare i bias nei risultati del modello. È possibile mantenere risultati del modello affidabili e imparziali affrontando attivamente queste preoccupazioni.

Anelli di retroazione

L'implementazione di cicli di feedback che incorporino il feedback degli utenti è fondamentale per prevenire il collasso del modello. Raccogliendo costantemente le informazioni degli utenti, è possibile apportare modifiche informate ai risultati del modello. Questo processo di perfezionamento garantisce che il modello rimanga pertinente, affidabile e allineato alle aspettative degli utenti.

In che modo Appinventiv può aiutare a mitigare i rischi nei modelli di intelligenza artificiale?

Nel panorama in evoluzione dell’intelligenza artificiale, le sfide poste dal collasso dei modelli sono state una preoccupazione sia per i giganti della tecnologia che per gli innovatori. Il deterioramento a lungo termine dei set di dati dei modelli linguistici e la manipolazione dei contenuti hanno lasciato il segno in questo ecosistema digitale.

Con l’avanzare dell’intelligenza artificiale, è fondamentale distinguere tra dati generati artificialmente e contenuti generati dall’uomo. Il confine tra contenuto autentico e ciò che è generato da una macchina sta diventando sempre più sfumato.

Ora, in mezzo a queste sfide e prevenendo il fallimento del modello di intelligenza artificiale, la collaborazione con una società dedicata allo sviluppo di intelligenza artificiale come Appinventiv può fornirti il conforto tanto necessario. Con esperienza nello sviluppo di modelli di intelligenza artificiale e un impegno dedicato verso pratiche etiche di intelligenza artificiale, possiamo aiutarti a navigare nelle complessità dell'intelligenza artificiale garantendo al contempo l'affidabilità e l'integrità dei tuoi sistemi di intelligenza artificiale.

I nostri esperti possono collaborare con te per affrontare in modo efficace la prevenzione del collasso del modello di intelligenza artificiale, promuovere la trasparenza e costruire un futuro con contenuti autentici che non compromettano l'autenticità dei contenuti generati dall'uomo.

Comprendiamo che addestrare modelli di intelligenza artificiale con dati nuovi e diversificati è essenziale per prevenire il degrado del modello. La valutazione del modello AI è un passaggio fondamentale nel nostro processo di sviluppo del modello che utilizza metriche per valutare le prestazioni, individuare i punti deboli e garantire previsioni future efficaci.

Il nostro team di esperti può aiutarti a garantire che i tuoi sistemi di intelligenza artificiale continuino ad apprendere e ad adattarsi al panorama digitale in evoluzione. Mettiti in contatto con i nostri esperti per mitigare i rischi associati al collasso del modello e garantirne l'efficacia.

Domande frequenti

D. Cos'è il collasso del modello AI?

R. Il collasso del modello AI nell'apprendimento automatico si riferisce all'incapacità del modello AI di produrre una gamma diversificata di risultati utili. Invece, genera risultati ripetitivi o di bassa qualità. Questo problema può verificarsi in diversi tipi di modelli, ma è particolarmente osservato durante l'addestramento di modelli complessi come le reti generative avversarie (GAN).

D. Quali sono le cause più comuni del collasso del modello di intelligenza artificiale?

R. Le cause comuni del collasso del modello di intelligenza artificiale includono la perdita di eventi rari, l'amplificazione dei bias, il restringimento delle capacità generative, errori di approssimazione funzionale, ecc. Questi fattori possono portare a modelli che producono risultati non ottimali.

D. Come posso evitare il collasso del modello AI?

R. Per un'efficace prevenzione del collasso del modello di intelligenza artificiale, è fondamentale l'utilizzo di dati di addestramento diversi e realistici, il monitoraggio e la valutazione continui dei dati, la correzione di eventuali errori e l'implementazione di test e controlli di qualità rigorosi. La collaborazione con gli esperti di intelligenza artificiale di Appinventiv può offrirti preziosi spunti e soluzioni per mitigare i rischi di collasso del modello.