Al di là del codice: analisi dei rischi fondamentali dell'intelligenza artificiale e delle relative contromisure

Pubblicato: 2023-09-25Le organizzazioni si stanno rapidamente tuffando a capofitto nel mondo dell’intelligenza artificiale per potenziare i propri processi e ottenere un vantaggio competitivo. Tuttavia, è fondamentale comprendere che il loro percorso verso l’intelligenza artificiale non sarà sempre roseo e roseo e potrebbe essere accompagnato da alcuni rischi e sfide. Poiché la tecnologia AI si evolve rapidamente a una velocità senza precedenti, le organizzazioni devono essere preparate ad adattarsi a livello globale. Per avere successo in questo ecosistema digitale spietato, è fondamentale comprendere le potenziali insidie e adottare le migliori pratiche per navigare nel multiverso dell’IA.

Mentre l’intelligenza artificiale continua ad avanzare, cresce la preoccupazione sui suoi potenziali pericoli. Geoffrey Hinton, il “padrino dell’intelligenza artificiale”, noto per il lodevole lavoro nell’apprendimento automatico e nelle reti neurali, ha avvertito che i sistemi di intelligenza artificiale stanno avanzando a un ritmo senza precedenti e potrebbero rappresentare il rischio di prendere il controllo, se non gestiti con un’adeguata supervisione. Ha inoltre sottolineato la necessità vitale di affrontare tali questioni correlate in modo proattivo.

In un altro caso, Elon Musk ha anche chiesto una pausa negli esperimenti di intelligenza artificiale su larga scala. Queste preoccupazioni dei leader mondiali sui potenziali rischi dell’IA riflettono la necessità che la comunità tecnologica debba considerare attentamente le implicazioni e le sfide etiche che potrebbero sorgere con il progresso delle capacità dell’IA.

Ora, con l’avanzare del mondo, l’intelligenza artificiale generativa tende a diventare molto popolare. Poiché un grande potere spesso attrae responsabilità incondizionate, l’implementazione dell’IA generativa comporta anche un certo grado di rischio etico.

Quindi, come imprenditore, è giunto il momento di capire che l’intelligenza artificiale può apportare grandi vantaggi, ma comporta anche alcune sfide familiari che emergono quando si introduce una nuova tecnologia nelle operazioni quotidiane.

Le organizzazioni devono dare priorità all’uso responsabile garantendo accuratezza, sicurezza, onestà, responsabilizzazione e sostenibilità. Di fronte a determinate sfide e rischi, possono fare affidamento su best practice collaudate che si sono rivelate efficaci nell’adottare con successo altre tecnologie. Queste strategie possono fungere da solida base per integrare l’intelligenza artificiale nelle operazioni aziendali e mitigare i rischi legati all’intelligenza artificiale lungo il percorso.

Questo blog ti aiuterà a comprendere tutto ciò che riguarda i rischi dell'intelligenza artificiale per la tua azienda e come mitigarli. Quindi, senza ulteriori indugi, entriamo subito nei dettagli.

Comprendere i rischi dell’IA

Secondo AI RMF 1.0, il quadro di gestione dei rischi dell’intelligenza artificiale, pubblicato dal National Institute of Standards and Technology (NIST), i rischi legati all’intelligenza artificiale comprendono potenziali danni a individui, organizzazioni o sistemi derivanti dallo sviluppo e dall’implementazione di sistemi di intelligenza artificiale. Questi rischi possono derivare da vari fattori, tra cui i dati utilizzati per addestrare l’intelligenza artificiale, l’algoritmo dell’intelligenza artificiale, il suo utilizzo per molteplici scopi e le interazioni con le persone. Esempi di rischi e controlli dell’IA variano da strumenti di assunzione distorti ad algoritmi che causano crolli del mercato.

Il monitoraggio proattivo di prodotti e servizi basati sull’intelligenza artificiale è fondamentale per garantire la sicurezza e la protezione dei dati e delle persone. Pertanto, l'organizzazione crede nell'utilizzo di una soluzione di gestione del rischio che possa aiutare a classificare, verificare e mitigare questi rischi in modo efficace.

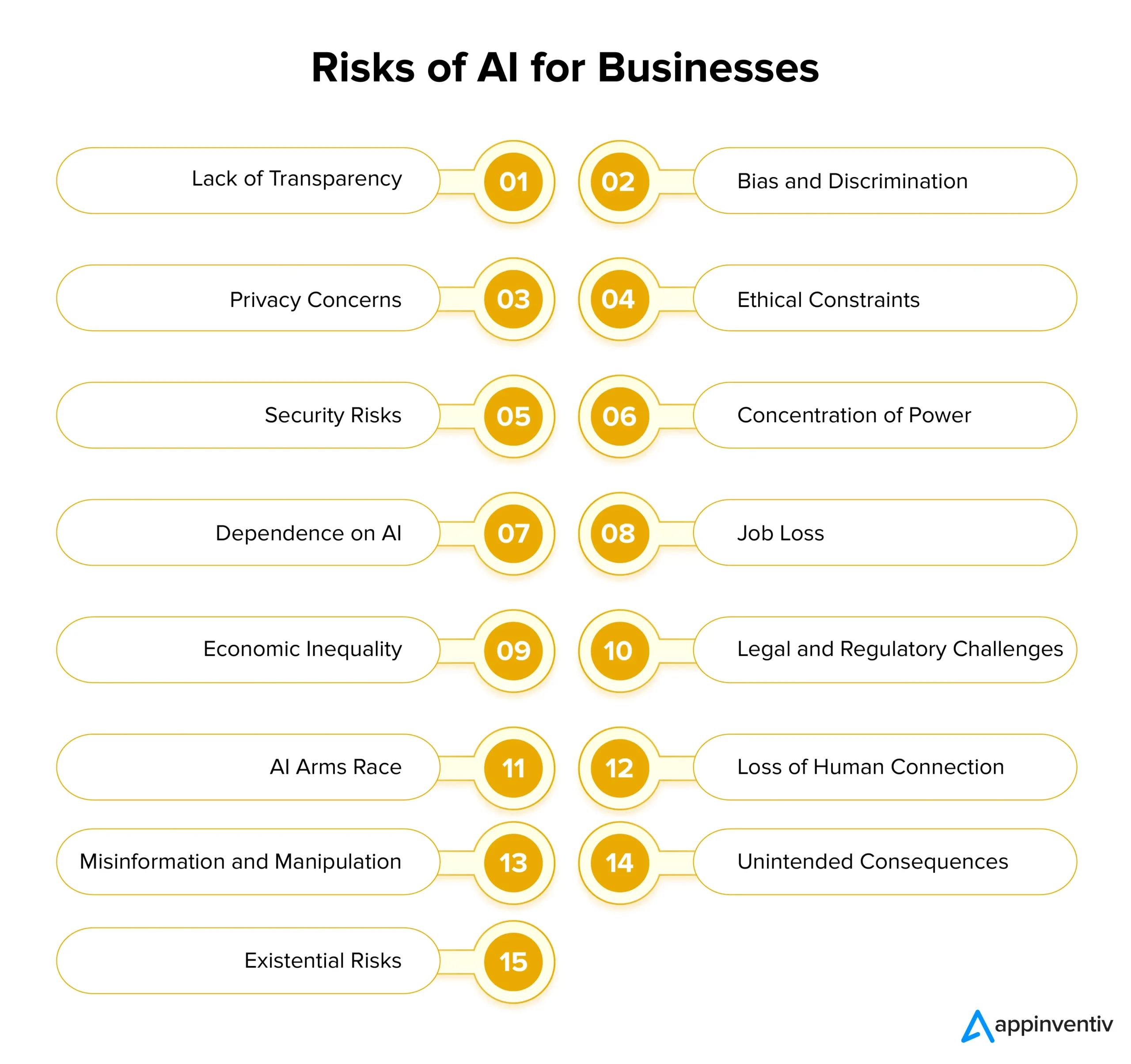

Identificare i rischi e le sfide dell’IA per le imprese

L’intelligenza artificiale offre un immenso potenziale alle imprese, ma comporta anche rischi significativi con la sua implementazione. Per garantire un’adozione responsabile dell’IA, è fondamentale comprendere e affrontare queste sfide al momento giusto. Di seguito esaminiamo in dettaglio i rischi e le soluzioni dell’IA per le aziende:

Mancanza di trasparenza

I sistemi di intelligenza artificiale spesso operano in modo non trasparente, rendendo difficile capire come prendono diverse decisioni. Questa mancanza di trasparenza può portare alla sfiducia tra gli utenti e le parti interessate. Per affrontare questo problema, le aziende dovrebbero dare priorità alla trasparenza progettando modelli e algoritmi di intelligenza artificiale che forniscano approfondimenti sui loro processi decisionali.

Ciò può essere facilitato semplicemente utilizzando una documentazione chiara, tecniche di intelligenza artificiale spiegabili e strumenti per visualizzare i risultati guidati dall’intelligenza artificiale. È importante comprendere che l’intelligenza artificiale trasparente migliora la fiducia generale tra le parti e le loro decisioni e aiuta nella conformità normativa.

Pregiudizi e discriminazioni

I sistemi di intelligenza artificiale hanno il potenziale per mantenere facilmente i pregiudizi sociali riscontrati nei loro dati di addestramento. Ciò può portare a processi decisionali distorti, discriminazione e trattamento ingiusto di alcuni gruppi. Per affrontare questi rischi dell’intelligenza artificiale, le organizzazioni dovrebbero dare priorità agli investimenti in dati di formazione diversificati e rappresentativi che possano analizzare.

Inoltre, l’implementazione di algoritmi di rilevamento e correzione dei bias e la conduzione di audit regolari dei modelli di intelligenza artificiale possono aiutare a identificare e rimuovere i bias dai sistemi esistenti. Lo sviluppo etico dell’IA deve dare priorità all’equità e all’imparzialità come principi fondamentali.

Preoccupazioni relative alla privacy

Uno dei maggiori rischi e sfide legati all’intelligenza artificiale è la minaccia alla privacy. L’intelligenza artificiale spesso richiede la raccolta e l’analisi di grandi quantità di dati personali, sollevando problemi di privacy e sicurezza. Le aziende devono dare priorità alla protezione dei dati aderendo a rigide normative sulla privacy, implementando solide misure di sicurezza informatica e adottando tecniche di crittografia dei dati. Ciò può aiutare a salvaguardare la privacy degli utenti e a mantenere la fiducia.

Vincoli etici

I sistemi di intelligenza artificiale coinvolti nei processi decisionali critici spesso si trovano ad affrontare dilemmi etici che potrebbero avere ulteriori impatti dannosi sulla società. Le organizzazioni dovrebbero stabilire linee guida e principi etici per lo sviluppo e la diffusione dell’IA per affrontare questo rischio. Le considerazioni etiche dovrebbero essere una delle componenti fondamentali dei progetti di intelligenza artificiale, garantendo che l’intelligenza artificiale sia in linea con i valori sociali e le norme etiche.

Rischi per la sicurezza

Con l’avanzare delle tecnologie di intelligenza artificiale, aumentano anche i rischi per la sicurezza. Le attività dannose possono sfruttare i sistemi di intelligenza artificiale e creare attacchi informatici più pericolosi, rappresentando una minaccia significativa per le aziende. Le organizzazioni dovrebbero implementare solide misure di sicurezza per mitigare i rischi per la sicurezza, tra cui crittografia, protocolli di autenticazione e sistemi di rilevamento delle minacce basati sull’intelligenza artificiale. Il monitoraggio continuo e i controlli regolari delle vulnerabilità sono fondamentali per salvaguardare l’implementazione dei sistemi di intelligenza artificiale.

Concentrazione del potere

Quando solo poche grandi aziende e governi controllano lo sviluppo dell’intelligenza artificiale, ciò può rendere le cose ingiuste e ridurre la varietà degli usi dell’intelligenza artificiale. Per evitare ciò, le aziende dovrebbero lavorare per condividere lo sviluppo dell’intelligenza artificiale in modo più ampio tra più gruppi. Possono farlo supportando piccole startup, incoraggiando nuove idee e aiutando progetti di intelligenza artificiale open source. In questo modo l’intelligenza artificiale diventa più accessibile a tutti.

Dipendenza dall'intelligenza artificiale

Un’eccessiva dipendenza dai sistemi di intelligenza artificiale può portare a una perdita di creatività, pensiero critico e intuizione umana. È fondamentale trovare un equilibrio tra il processo decisionale assistito dall’intelligenza artificiale e il giudizio umano. Ad esempio, i ricercatori hanno evidenziato il problema del “collasso del modello” in cui i modelli di intelligenza artificiale generativa addestrati su dati sintetici possono produrre risultati di qualità inferiore perché semplicemente danno priorità alle scelte di parole comuni rispetto alle alternative creative.

Le aziende devono formare i propri dipendenti a lavorare insieme all’intelligenza artificiale per evitare i potenziali rischi dell’intelligenza artificiale. Incoraggiare l’apprendimento continuo può aiutare le organizzazioni a sfruttare il potenziale dell’intelligenza artificiale preservando allo stesso tempo le competenze umane. Oltre a ciò, l’uso di diversi dati di addestramento e tecniche di regolarizzazione può anche aiutare a mitigare queste sfide associate al collasso del modello.

Perdita di posti di lavoro

L’automazione guidata dall’intelligenza artificiale ha il potenziale di spostare posti di lavoro in vari settori, con i lavoratori meno qualificati che rappresentano gli obiettivi principali. Le organizzazioni devono affrontare in modo proattivo questa sfida offrendo alla propria forza lavoro l’opportunità di apprendere nuove misure e crescere con i progressi tecnologici. Promuovere l’apprendimento permanente e l’adattabilità è essenziale per mitigare le preoccupazioni relative alla perdita di posti di lavoro in più settori.

Disuguaglianza economica

La disuguaglianza economica è un altro dei notevoli rischi e sfide dell’IA di cui le aziende devono essere consapevoli. L’intelligenza artificiale può potenzialmente peggiorare la disuguaglianza economica perché spesso avvantaggia i ricchi e le grandi aziende. Per rendere l’IA più equa, i politici e le imprese dovrebbero pensare a come includere più persone nello sviluppo dell’IA. Possono farlo creando programmi che consentano a più persone di utilizzare gli strumenti di intelligenza artificiale.

Sfide legali e normative

L’intelligenza artificiale introduce nuove complessità legali e normative, comprese le questioni relative alla responsabilità e ai diritti di proprietà intellettuale. I quadri giuridici devono evolversi in modo da poter procedere parallelamente ai progressi tecnologici. Le organizzazioni dovrebbero rimanere informate sulle normative relative all’IA e impegnarsi attivamente con i responsabili politici per definire una governance e pratiche responsabili dell’IA. Le aziende possono utilizzare l’intelligenza artificiale per soluzioni di rischio e conformità per analizzare facilmente grandi quantità di informazioni e dati identificando al contempo potenziali rischi associati alla conformità.

[Leggi anche: Come evitare violazioni di conformità durante lo sviluppo di prodotti IA]

Corsa agli armamenti dell'IA

Quando i paesi si lanciano in una corsa agli armamenti legati all’intelligenza artificiale, ciò può significare che la tecnologia dell’intelligenza artificiale si sviluppa troppo rapidamente e ciò potrebbe essere pericoloso. Per prevenire questi rischi dell’IA, è importante incoraggiare lo sviluppo responsabile dell’IA. I paesi dovrebbero lavorare insieme e stipulare accordi su come l’intelligenza artificiale può essere utilizzata nella difesa. In questo modo, possiamo ridurre il rischio che l’IA causi danni nella corsa verso una tecnologia più avanzata rispetto ad altri paesi.

Perdita di connessione umana

La crescente dipendenza dalla comunicazione e dalle interazioni guidate dall’intelligenza artificiale può portare a una diminuzione dell’empatia, delle abilità sociali e delle connessioni umane. Le organizzazioni dovrebbero dare priorità alla progettazione incentrata sull’uomo, sottolineando l’importanza di mantenere interazioni umane significative oltre all’integrazione dell’intelligenza artificiale.

Disinformazione e manipolazione

I contenuti generati dall’intelligenza artificiale come i deepfake rappresentano un rischio significativo poiché contribuiscono alla diffusione di informazioni false e alla manipolazione dell’opinione pubblica. L’implementazione di strumenti basati sull’intelligenza artificiale per individuare la disinformazione e campagne di sensibilizzazione del pubblico può aiutare a preservare l’integrità delle informazioni in questa era digitale in rapida evoluzione.

Conseguenze non volute

A causa della loro complessità, i sistemi di intelligenza artificiale possono mostrare comportamenti inaspettati o prendere decisioni con conseguenze impreviste. Test rigorosi, validazione e processi di monitoraggio continuo sono essenziali per identificare e affrontare questi problemi prima che si intensifichino e causino danni.

Rischi esistenziali

Creare un’intelligenza artificiale generale (AGI) più intelligente di quella umana solleva grandi preoccupazioni. Le organizzazioni devono assicurarsi che AGI condivida i suoi valori e obiettivi per evitare conseguenze terribili. Ciò richiede un’attenta pianificazione a lungo termine, forti regole etiche e una collaborazione a livello globale per gestire i grandi rischi che derivano dall’AGI.

Dopo aver esaminato le molteplici sfide e i rischi imposti dalla tecnologia dell’intelligenza artificiale e il modo in cui è possibile eseguire la gestione di determinati rischi dell’intelligenza artificiale, andiamo avanti e esaminiamo la governance dell’intelligenza artificiale in dettaglio.

Governance dell’intelligenza artificiale per la gestione dei rischi

Una governance efficace dell’IA implica l’identificazione e la gestione dei rischi dell’IA attraverso tre approcci chiave:

Principi: si tratta di linee guida che facilitano lo sviluppo dei sistemi di intelligenza artificiale e il loro utilizzo. Questi sono spesso allineati con gli standard legislativi e le norme sociali.

Processi: affrontare i rischi e i potenziali danni derivanti da difetti di progettazione e strutture di governance inadeguate.

Coscienza etica: questo approccio è guidato dal senso di ciò che è giusto e buono. Comprende il rispetto delle regole, l'assicurarsi che le cose siano fatte correttamente, la considerazione della propria reputazione, l'essere socialmente responsabili e il rispetto dei valori e delle convinzioni dell'organizzazione.

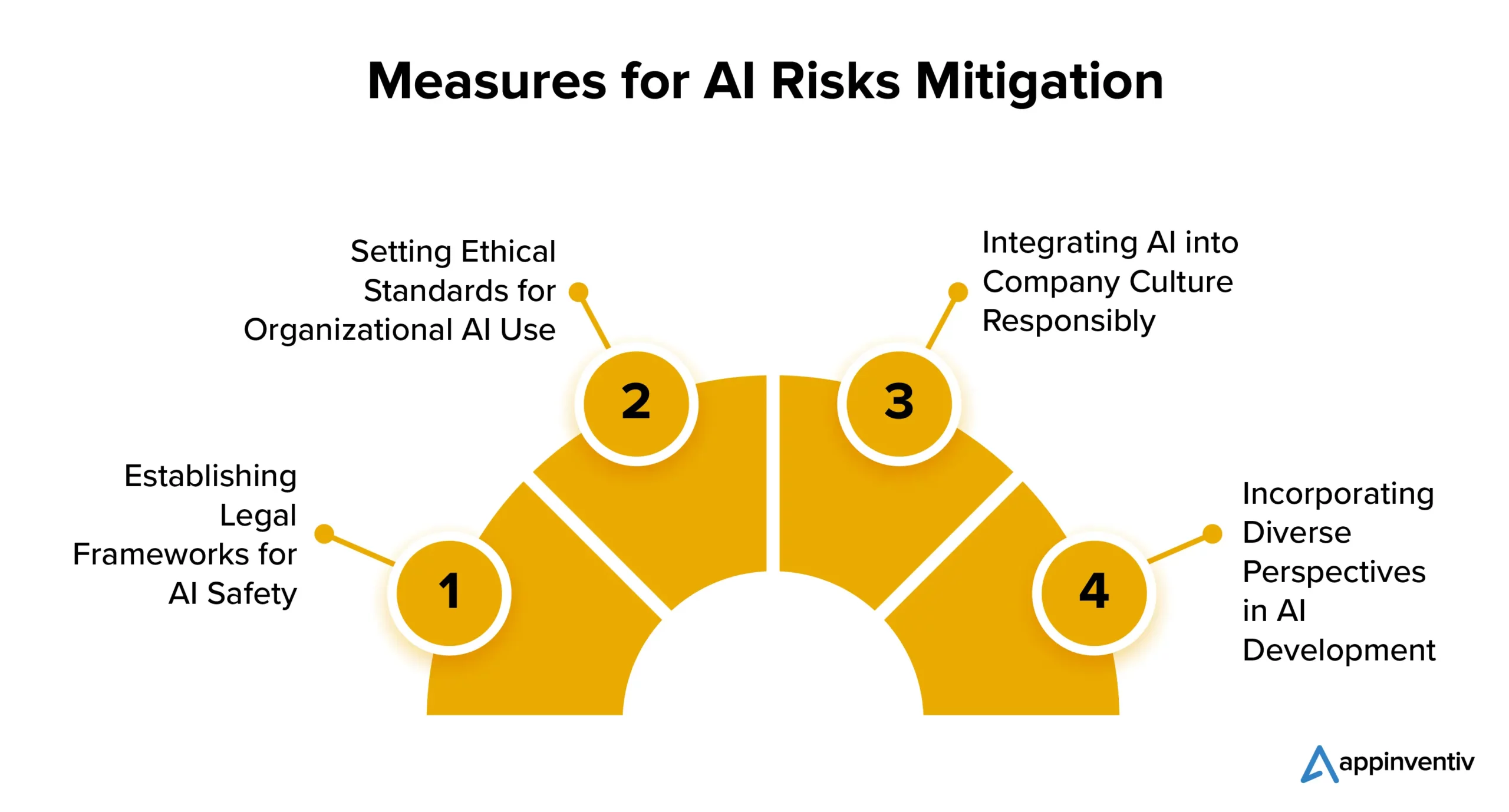

Mitigare i rischi dell'intelligenza artificiale: come rimanere al sicuro con l'intelligenza artificiale

Ecco diverse strategie che le aziende possono attuare per mitigare i rischi dell’implementazione dell’intelligenza artificiale:

Definizione di quadri giuridici per la sicurezza dell’intelligenza artificiale

Molti paesi si stanno concentrando sulle normative sull’IA. Gli Stati Uniti e l’Unione Europea stanno lavorando su una serie di regole chiare per controllare la diffusione e l’uso dell’intelligenza artificiale. Anche se alcune tecnologie di intelligenza artificiale potrebbero essere soggette a restrizioni, ciò non dovrebbe impedire alle aziende di esplorare il potenziale dell’intelligenza artificiale a proprio vantaggio.

Definizione di standard etici per l’uso dell’intelligenza artificiale nelle organizzazioni

È fondamentale bilanciare la regolamentazione con l’innovazione. L’intelligenza artificiale è vitale per il progresso, quindi le organizzazioni dovrebbero stabilire standard per lo sviluppo e l’uso etico dell’intelligenza artificiale. Ciò dovrebbe includere l’implementazione di algoritmi di monitoraggio, l’utilizzo di dati di alta qualità e la trasparenza sulle decisioni relative all’IA.

Integrare l’intelligenza artificiale nella cultura aziendale in modo responsabile

Una delle strategie più ricercate per la mitigazione dei rischi legati all’intelligenza artificiale include l’introduzione dell’intelligenza artificiale nella stessa cultura aziendale. Le aziende possono integrare l’intelligenza artificiale nella loro cultura stabilendo tecnologie di intelligenza artificiale accettabili e linee guida sui processi. Ciò garantisce che l’IA venga utilizzata in modo etico e responsabile all’interno dell’organizzazione, mitigando così i probabili rischi legati all’IA.

Incorporare diverse prospettive nello sviluppo dell’intelligenza artificiale

Gli sviluppatori di intelligenza artificiale dovrebbero considerare diverse prospettive, comprese quelle provenienti da contesti e campi diversi come diritto, filosofia e sociologia. Questo approccio inclusivo aiuta a creare un’intelligenza artificiale responsabile a vantaggio di tutti.

In che modo Appinventiv può contribuire a garantire le migliori pratiche per lo sviluppo dell'intelligenza artificiale

Anche se l’adozione dell’intelligenza artificiale continua ad aumentare, la gestione efficace del rischio è ancora in ritardo. La sfida risiede nel fatto che le aziende spesso non riconoscono la necessità di intervento e di pratiche di sviluppo dell’IA sostenibile.

Secondo un rapporto del MIT Sloan Management Review e del Boston Consulting Group, il 42% degli intervistati considera l’intelligenza artificiale una priorità strategica assoluta, mentre solo il 19% ha confermato che la propria organizzazione ha messo in atto un programma di intelligenza artificiale responsabile. Questo divario aumenta il rischio di fallimento e lascia le aziende vulnerabili a problemi normativi, finanziari e reputazionali causati dall’implementazione dell’intelligenza artificiale.

Sebbene la gestione del rischio IA possa iniziare in qualsiasi fase del progetto, è fondamentale stabilire un quadro di gestione del rischio il prima possibile. Ciò può aumentare la fiducia e consentire alle imprese di crescere con sicurezza.

In qualità di società dedicata allo sviluppo dell'intelligenza artificiale, il nostro team vanta anni di esperienza nella creazione di soluzioni AI supportate da una forte enfasi sull'etica e sulla responsabilità. La nostra comprovata esperienza in vari settori industriali dimostra il nostro impegno nell’allineare le soluzioni di intelligenza artificiale ai valori fondamentali e ai principi etici.

Siamo ben attrezzati per assistervi nell'implementazione di misure di equità per garantire che le vostre soluzioni aziendali basate sull'intelligenza artificiale prendano costantemente decisioni imparziali e imparziali.

Di recente abbiamo sviluppato YouComm, un'app sanitaria basata sull'intelligenza artificiale che consente ai pazienti di connettersi con il personale ospedaliero semplicemente con gesti delle mani e comandi vocali. La soluzione è ora implementata in oltre 5 catene ospedaliere negli Stati Uniti.

Mettiti in contatto con i nostri esperti per comprendere a fondo la gestione dei rischi associati all'intelligenza artificiale per il tuo progetto e come puoi mitigarli facilmente.

Domande frequenti

D. Quali sono i rischi dell’IA?

R. L’intelligenza artificiale comporta rischi intrinseci, tra cui pregiudizi, preoccupazioni sulla privacy, dilemmi etici e minacce alla sicurezza. Può anche portare allo spostamento di posti di lavoro, peggiorare la disuguaglianza economica e porre sfide legali e normative. Inoltre, il progresso dell’intelligenza artificiale superintelligente solleva preoccupazioni esistenziali sull’allineamento con i valori umani. Per garantire un uso responsabile e vantaggioso della tecnologia ed evitare i rischi associati all’intelligenza artificiale, è fondamentale attuare un’attenta gestione, considerazioni etiche e misure normative.

D. Come si può utilizzare l’intelligenza artificiale per mitigare i rischi legati all’intelligenza artificiale?

R. L’intelligenza artificiale svolge un ruolo significativo nella mitigazione dei rischi dell’intelligenza artificiale facilitando il rilevamento e la correzione dei pregiudizi, l’analisi predittiva, il monitoraggio della sicurezza, il supporto alle decisioni etiche, ecc. Vediamo come possiamo aiutare a mitigare i rischi dell’intelligenza artificiale in dettaglio:

- Gli algoritmi dell’intelligenza artificiale possono identificare e correggere le distorsioni nei dati, riducendo i risultati distorti dell’intelligenza artificiale.

- L’analisi predittiva può anticipare i rischi e consentire misure preventive.

- Gli strumenti di sicurezza informatica basati sull’intelligenza artificiale possono rilevare e contrastare le minacce basate sull’intelligenza artificiale.

- L’intelligenza artificiale può guidare nel fare scelte etiche.

- L’automazione può garantire la conformità alle normative, riducendo i rischi legati alla conformità.