Il “perché” dietro i principali cali di traffico SERP in SaaS e oltre

Pubblicato: 2024-05-31Contenuto dell'articolo

Il calo del traffico sul sito web può derivare da diverse cause, tra cui tendenze delle parole chiave, sforzi di rebranding e sanzioni.

Tuttavia, alcuni cali sono innescati da sfuggenti modifiche agli algoritmi di ricerca che lasciano le aziende alle prese con le risposte, in particolare nello spazio SaaS. Questi aggiornamenti degli algoritmi possono avere un impatto profondo, scuotendo la stabilità delle strategie di marketing organico. Discussioni recenti, come questo Tweet che evidenzia il notevole calo del traffico di ClickUp negli ultimi mesi, sottolineano queste preoccupazioni.

Secondo Ahrefs, @clickup ha perso circa il 50% del suo traffico organico in due mesi.

Sono passati da 1,9 milioni all'inizio di febbraio a 900.000 attualmente.

pic.twitter.com/xUDOKkNieo

— Nico Cerdeira (Failory.com) (@nicocerdeira) 2 maggio 2024

Le aziende SaaS e altri devono rimanere vigili e adattivi per affrontare questi cambiamenti imprevedibili negli algoritmi dei motori di ricerca e mantenere la propria visibilità online. Comprendere le complessità che si celano dietro questi cali di traffico è fondamentale per sostenere la crescita ed evitare le insidie dei cali indotti dagli algoritmi.

Incertezza (e controversia) a SEOland

Al giorno d'oggi a SEOland regnano molte incertezze e non poche controversie. Ciò è dovuto in gran parte al fatto che si verifica un notevole calo nel traffico web totale in tutti i settori.

Secondo il Digital Experience Benchmark Report 2024 di Contentsquare , la variazione totale del traffico anno su anno lo scorso anno è stata del -3,6%. Il calo è stato ancora più pronunciato in settori come servizi (-9,4%), energia, servizi pubblici ed edilizia (-8,3%) e software (-7,8%).

![Variazione del traffico su base annua per settore [Contentsquare]](/uploads/article/23621/NXsGWAwvlNFBBqzK.png)

Dalle piattaforme social e forum agli eventi di settore, gli esperti di marketing sono particolarmente preoccupati per la gallina dalle uova d'oro della crescita del traffico web: la ricerca organica.

Gli analisti di mercato e le società di ricerca stimano la valutazione del settore SEO globale intorno ai 70-80 miliardi di dollari . In questo ambito operano le principali società di software, agenzie e innumerevoli professionisti, per non parlare di tutte le aziende che si affidano a questa pratica.

È comprensibile che le persone siano così preoccupate per la traiettoria di questo settore.

Scavare nel "perché" dietro le principali perdite di traffico nel settore tecnologico e non solo

Una delle maggiori sfide per il settore SEO (e in realtà per qualsiasi azienda che abbia bisogno di un’impronta digitale) è che i motori di ricerca come Google sono una scatola nera.

Possiamo analizzare gli input (le query, i siti Web e le pagine Web) e tracciare gli output (la posizione SERP), ma nessuno all'esterno può in alcun modo conoscere appieno tutto ciò che riguarda le decisioni di posizionamento. E, secondo migliaia di documenti trapelati sull'API di ricerca di Google , i fattori di ranking sono qualcosa su cui il gigante della tecnologia non è onesto.

Google tenta di chiarire le cose con il feedback di Search Central o le dichiarazioni dei loro collegamenti e portavoce della ricerca come John Mueller. Ma c'è ancora così tanto che non sappiamo. Per fortuna, con centinaia di migliaia di SEO là fuori, è possibile raccogliere alcune informazioni in crowdsourcing.

Ci sono un paio di ragioni principali per cui i principali siti di tecnologia, media e altri settori stanno subendo interruzioni così importanti in termini di traffico web organico e complessivo, e tutte sono legate alle azioni intraprese da Google o all’emergere dell’intelligenza artificiale:

- Contenuti utili, abuso della reputazione e aggiornamenti di Google Core

- La crescente presenza di discussioni generate dagli utenti e di contenuti nei forum

- L’ascesa dei contenuti generati dall’intelligenza artificiale

- L'esperienza generativa della ricerca

Diamo un'occhiata a ciascuno di questi ora.

Aggiornamenti di Google Core

Secondo Seach Central , Google apporta diverse “cambiamenti significativi e ampi ai [loro] algoritmi e sistemi di ricerca” nel corso di un anno. Non è raro che i siti Web di alto livello subiscano volatilità nella SERP dopo un aggiornamento principale, anche se "non hanno violato le politiche sullo spam [di Google], né sono stati sottoposti ad azioni manuali o algoritmiche".

I SEO esperti sanno ormai da oltre un decennio che c'è un periodo di correzione dopo un aggiornamento del Core o altri cambiamenti significativi e che non devono reagire in modo eccessivo. Il danno collaterale in genere si corregge nuovamente nel tempo (almeno in teoria).

Ma gli aggiornamenti degli ultimi anni hanno raccontato una storia diversa.

Aggiornamento dei contenuti utili

Il primo Helpful Content Update (HCU) è stato lanciato nell'agosto del 2022 come tentativo di identificare e indirizzare automaticamente i contenuti creati principalmente per posizionarsi bene nei motori di ricerca invece di aiutare gli utenti. Questo aggiornamento è stato esteso oltre ai siti Web inglesi a tutte le lingue alla fine del 2022.

Nel settembre 2023, Google ha aggiornato nuovamente l’HCU in un lancio di due settimane che ha aiutato un “classificatore migliorato” con pochi dettagli in termini di dettagli. Questo aggiornamento ha causato un calo significativo del ranking dei siti web di tutti i settori, molti dei quali devono ancora riprendersi.

Aggiornamento rapido sui siti interessati dall'HCU(X) di settembre: ora che sono trascorse due settimane dall'inizio dell'aggiornamento principale di marzo, ho analizzato i numeri di visibilità per diverse centinaia di siti interessati dall'HCU(X) di settembre. Non ne ho ancora visto uno che si sia ripreso. In realtà, la maggior parte è scesa ancora di più (vedi… pic.twitter.com/MPFPGZdu9u

– Glenn Gabe (@glenngabe) 21 marzo 2024

Lo scorso marzo, Google ha incorporato l'HCU nei principali sistemi di classificazione con l'obiettivo di ridurre del 40% i contenuti inutili e di bassa qualità. Secondo quanto riferito, Google ha raggiunto questo parametro, ma è chiaro che anche molti spettatori innocenti sono coinvolti nel mix.

Aggiornamento spam

Per rendere l'analisi della questione ancora più complessa, l'integrazione di HCU nel marzo 2024 ha coinciso con un'altra modifica correlata all'algoritmo di Google: l'aggiornamento sullo spam. Google ha lanciato questo aggiornamento per contrastare i "contenuti spam e di bassa qualità" prendendo di mira tre tattiche manipolative :

- Abuso di contenuti su scala : utilizzo dell'automazione (nota anche come AI o content mills) per produrre in serie contenuti mirati alle query di ricerca più frequenti.

- Abuso di domini scaduti : acquisto di domini scaduti e riutilizzarli per aumentare la visibilità di contenuti di bassa qualità.

- Abuso della reputazione del sito : sfruttare l'elevata autorità del sito e la reputazione del marchio per ospitare contenuti di qualità inferiore di terze parti a fini di classificazione.

L'aggiornamento sull'abuso della reputazione del sito ha ricevuto molta attenzione nell'ultimo mese, soprattutto perché ha avuto un impatto su numerosi siti Web di tutto rispetto come Reuters, The Washington Post, GQ e Wall Street Journal.

Glen Allsopp ha delineato la portata dell'impatto iniziale dell'aggiornamento in questo Tweet:

Da marzo ho monitorato 2.500 termini incentrati sui coupon per vedere cosa cambia Google con l'aggiornamento sull'abuso della reputazione del sito.

Oggi sono iniziate le azioni manuali ed ecco alcuni primi spunti.

Ho monitorato molti contenuti di terze parti senza coupon che stavo per... pic.twitter.com/dCbPgOTD9Q

– Glen Allsopp (@ViperChill) 7 maggio 2024

Con la volatilità post-aggiornamento che ha raggiunto nuovi livelli negli ultimi anni, è fondamentale che i marchi siano vigili nel monitorare le prestazioni web e SERP.

Discussioni e contenuti del forum

Costruire una presenza su piattaforme forum come Reddit e Quora è una parte fondamentale delle attività di marketing come la ricerca, la distribuzione dei contenuti e il coinvolgimento della comunità. Bene, ora puoi aggiungere la visibilità SERP a quell'elenco.

Negli ultimi anni, Reddit e Quora hanno iniziato a dominare le prime posizioni della SERP per diverse query. Mentre il traffico organico per i siti aziendali e dei media ha registrato un rallentamento nell’ultimo anno, Reddit e Quora hanno registrato aumenti esponenziali del traffico.

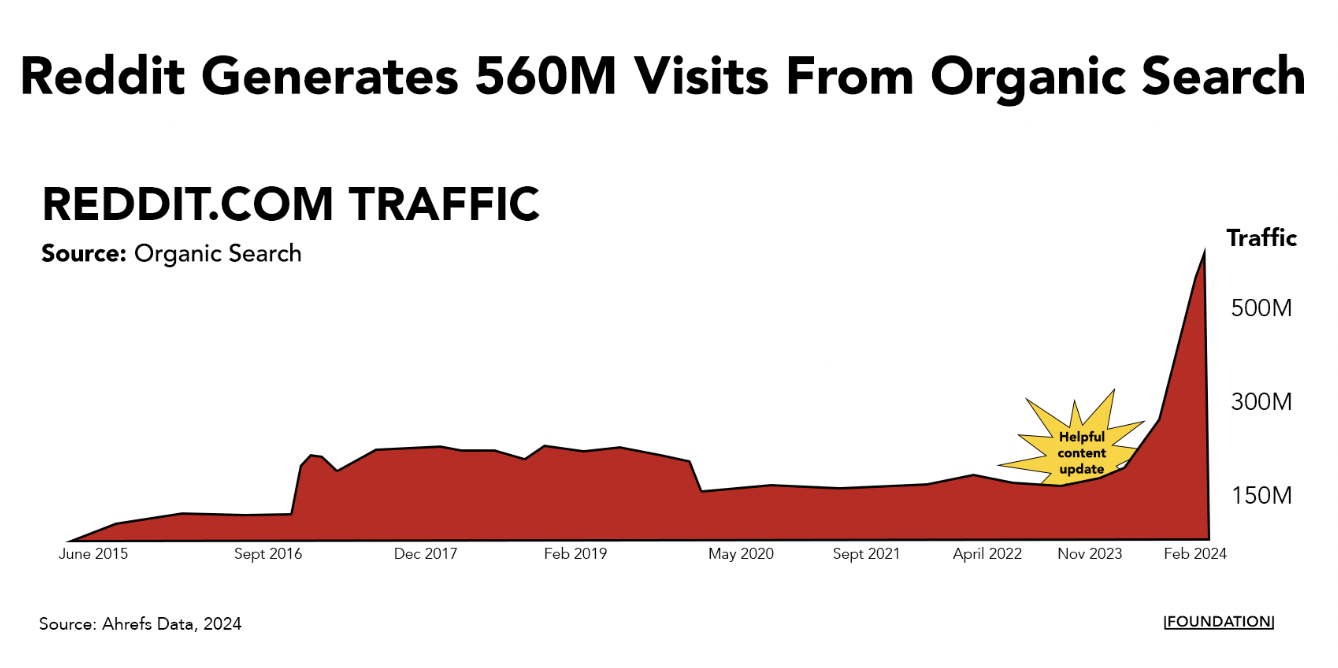

Il solo Reddit genera ogni mese oltre 560 milioni di visite dalla ricerca organica e ora si colloca tra le prime tre posizioni per quasi 11 milioni di parole chiave.

Questo tipo di pendenza ripida suggerisce che esiste un vantaggio algoritmico in gioco per questi tipi di forum popolari. Il collegamento di Google Search Mike Sullivan lo ha ammesso in uno scambio con Lily Ray su X:

Tale unità appare automaticamente se i sistemi ritengono che possa essere rilevante e utile. Non è come se qualcuno avesse detto "mettilo al primo posto per quella particolare domanda" - cosa che so che capisci, ma altri che leggono questo potrebbero non farlo. Detto questo, posso apprezzare la preoccupazione e il problema, e ho...

- Google SearchLiaison (@searchliaison) 3 aprile 2024

È certamente vero che le persone gravitano verso le discussioni nei forum di queste piattaforme, in particolare quando cercano opinioni non filtrate su prodotti e servizi. (Uso Reddit e Quora sempre in questo modo.)

Detto questo, ci sono molti esempi di casi in cui l'argomento in questione merita una risposta più esperta di quella che si ottiene dalle discussioni (per lo più) anonime su Reddit. Ad esempio, domande Your Money or Your Life (YMYL) su importanti argomenti di salute e finanza.

È anche possibile che piccoli aggiustamenti all'algoritmo che dà priorità a questo tipo di contenuti vadano a vantaggio di Reddit e Quora perché hanno siti Web e livelli di autorità di dominio così massicci.

Qualunque sia la ragione, non sembra che Google si allontanerà presto dai forum: hanno appena annunciato un importante accordo con Reddit in cui utilizzeranno i dati della piattaforma per addestrare la propria intelligenza artificiale. È solo un altro dei tanti motivi per cui è necessario stabilire una presenza sulla piattaforma.

Contenuti generati dall'intelligenza artificiale

I contenuti generati dall’intelligenza artificiale hanno preso d’assalto il mondo poco dopo che ChatGPT ha dato il via al boom dell’intelligenza artificiale generativa alcuni anni fa. Anche alcuni importanti marchi SaaS come CNET hanno utilizzato questa strategia.

A quel tempo, ci sono stati tutti i tipi di guru del marketing e degli affari che hanno cercato di usarlo come tattica di growth hacking producendo in massa contenuti SEO. Su LinkedIn e X, ci sono stati alcuni esempi di alto profilo di persone che si sono vantate dei risultati ottenuti sfornando un'enorme quantità di contenuti generati dall'intelligenza artificiale.

Uno dei più grandi esempi di ciò è stato il SEO Heist, in cui qualcuno ha preso la mappa del sito da un sito web chiamato Exceljet, ha trasformato l'elenco degli URL in titoli di articoli e quindi ha utilizzato l'intelligenza artificiale per generare oltre 1.800 pagine sugli stessi argomenti. Questa strategia ha funzionato sorprendentemente bene, con il sito della rapina che ha attirato centinaia di migliaia di visite mensili a scapito di Exceljet.

Tuttavia, gli esperti che hanno seguito questa strategia hanno scoperto che i guadagni iniziali che le aziende ottengono dai contenuti AI spesso scompaiono.

Mark Williams-Cook , ad esempio, ha monitorato l'ascesa e la caduta di numerosi siti Web che si sono impegnati in strategie di SEO Heist o di scalabilità dell'intelligenza artificiale. La maggior parte di questi siti registra un solido aumento del traffico organico nel breve termine – in genere alcuni mesi, ma in alcuni casi potrebbe essere più lungo – prima di sperimentare un forte calo che segnala che l’algoritmo ha preso piede.

Bel aggiornamento @sistrix del sito web "SEO heist" che utilizzava l'intelligenza artificiale per creare contenuti. Sembra che stia per finire in un posto peggiore di quando è iniziato. pic.twitter.com/SKY2ViXiwV

— Mark Williams-Cook (@markcandour) 4 dicembre 2023

Pertanto, se stai riscontrando un calo significativo nel traffico di ricerca, considera quanto segue:

- La tua azienda utilizza l’intelligenza artificiale per generare molti contenuti SEO (probabilmente di bassa qualità) su larga scala?

- Stanno spuntando nuovi siti web esattamente nelle SERP a cui stai cercando di rivolgerti?

Se è il primo caso e stai già investendo nella creazione di contenuti di qualità, molto probabilmente si risolverà da solo nel tempo. Se è quest'ultimo, è il momento di migliorare il flusso di lavoro dei contenuti AI .

Puoi ridimensionare la produzione di contenuti con l'intelligenza artificiale, ma l'obiettivo dovrebbe essere quello diaumentare, non di sostituire, il tuo team. Gli scrittori possono utilizzare strumenti come ChatGPT, Jasper o Gemini per semplificare l'ideazione, la ricerca e i passaggi intermedi, lasciando più tempo per la narrazione creativa.

Per evitare potenziali sanzioni e sostenere la crescita del traffico a lungo termine, assicurati che i tuoi contenuti assistiti dall'intelligenza artificiale aggiungano valore reale, offrano approfondimenti unici e mantengano un elevato standard di qualità.

Consulta la nostra lista di controllo per l'elevazione dei contenuti assistita dall'intelligenza artificiale per una guida passo passo alla creazione di contenuti di alto valore su larga scala.

Cerca esperienza generativa

I contenuti spam e i furti SEO non sono l'unico impatto che l'intelligenza artificiale sta avendo sulle SERP. L’ottimizzazione dei motori generativi è destinata ad avere un impatto sui numeri di traffico poiché le persone iniziano a utilizzare l’intelligenza artificiale anziché i motori di ricerca tradizionali.

Google si è già preparato per questo. La società ha annunciato una nuova funzionalità di riepilogo generata dall'intelligenza artificiale, AI Overviews, basata sul proprio LLM. Attualmente è in fase di lancio negli Stati Uniti con recensioni molto contrastanti .

Un primo rapporto di Tomasz Rudzki e Ziptie.dev mostra che le panoramiche AI di Google appaiono in media in oltre l'80% delle query.

In particolare, lo studio evidenzia che alcune nicchie, come quella fintech, potrebbero essere più sicure rispetto ad altre rispetto agli AIO. Ma nella maggior parte dei casi prevalgono le risposte SGE. Queste risposte generate dall'intelligenza artificiale appaiono automaticamente in circa un terzo delle SERP, mentre il resto del tempo gli utenti devono fare clic per generarle.

Cosa significa tutto questo per i brand? È tempo di dare priorità all'esperienza generativa della ricerca (SGE): percorsi di ricerca più coinvolgenti e personalizzati rispetto ai viaggi tradizionali, grazie all'intelligenza artificiale.

Sebbene sembrino molto diversi dalle tradizionali SERP di Google, strumenti come ChatGPT, Gemini e Perplexity includono gli URL dei siti che utilizzano per generare risultati.

È ancora troppo presto per dire esattamentequantosarà diverso il SGE/GEO dal SEO tradizionale, ma ci sono sicuramente alcune somiglianze. Per ottimizzare l’SGE, le aziende dovrebbero concentrarsi sulla fornitura di informazioni chiare, concise e accurate che possano essere facilmente analizzate dai sistemi di intelligenza artificiale. Ciò include dati strutturati, risposte ben formattate a domande comuni e contenuti che indirizzano direttamente le intenzioni dell'utente.

State tranquilli, è qualcosa che noi della Foundation e il resto del settore osserveremo attentamente in futuro.

Espandi la tua portata oltre la ricerca con un motore di distribuzione

Il panorama della ricerca organica sta subendo cambiamenti significativi a causa degli aggiornamenti degli algoritmi e dell’ascesa dell’intelligenza artificiale – e la preoccupazione è comprensibile. Ma ciò che è più importante è l'azione.

Da un lato, le aziende devono adattarsi concentrandosi su contenuti di alta qualità e incentrati sull’utente e sfruttando le nuove opportunità offerte dalle tecnologie di intelligenza artificiale. Anche se l'impatto delle nuove panoramiche sull'intelligenza artificiale inizia appena a farsi sentire, è importante espandere la tua portata oltre i metodi di ricerca tradizionali.

Investi in un playbook di distribuzione completo per assicurarti di poter mantenere e far crescere la tua presenza online in questo ambiente in evoluzione.