Tecniche di web crawling efficaci per applicazioni Big Data

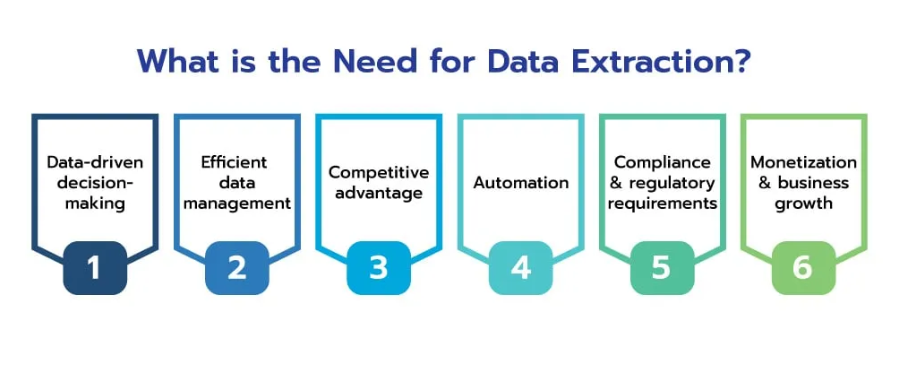

Pubblicato: 2024-06-06Nell’era dei big data, la scansione dei siti web è diventata un processo indispensabile per le aziende che desiderano sfruttare la vasta ricchezza di informazioni disponibili online. Raccogliendo, elaborando e analizzando in modo efficiente i dati web su larga scala, le aziende possono sbloccare informazioni preziose e ottenere un vantaggio competitivo in vari settori.

I dati web racchiudono un potenziale immenso, offrendo approfondimenti sulle tendenze del mercato, sul comportamento dei consumatori e sui panorami competitivi. La capacità di raccogliere e analizzare in modo efficiente questi dati può trasformare le informazioni grezze in informazioni fruibili, guidando il processo decisionale strategico e la crescita aziendale.

Fonte: scrapehero

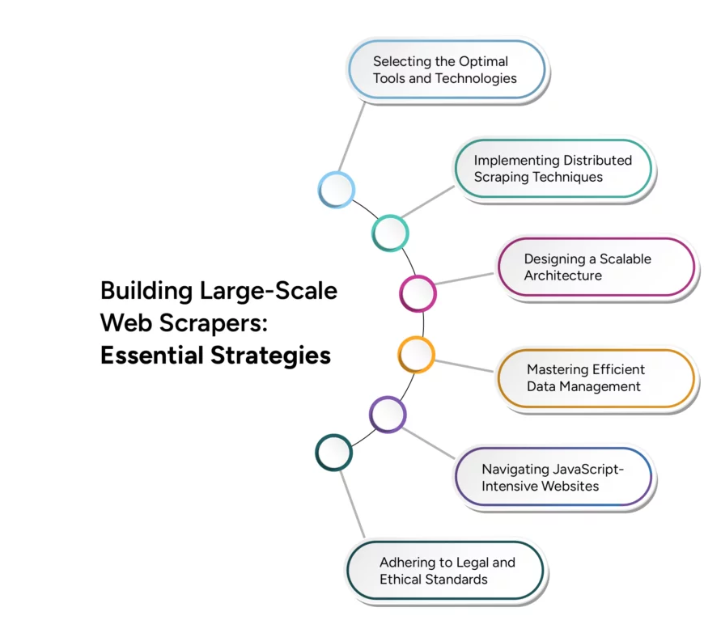

Tuttavia, la transizione dal web scraping su piccola scala al web crawling su larga scala presenta sfide tecniche significative. Una scalabilità efficace richiede un'attenta considerazione di vari fattori, tra cui infrastruttura, gestione dei dati ed efficienza di elaborazione. Questo articolo approfondisce le tecniche e le strategie avanzate necessarie per superare queste sfide, garantendo che le operazioni di scansione del Web possano crescere per soddisfare le esigenze delle applicazioni Big Data.

Sfide della scansione di siti Web per applicazioni Big Data

La scansione dei siti Web per applicazioni Big Data presenta diverse sfide significative che le aziende devono affrontare per sfruttare in modo efficace la potenza delle vaste informazioni online. Comprendere e superare queste sfide è fondamentale per costruire un'infrastruttura di web crawling solida e scalabile.

Una delle sfide principali è l’enorme volume e varietà di dati sul web, che continua a crescere in modo esponenziale. Inoltre, la diversità dei tipi di dati, da testo e immagini a video e contenuti dinamici, aggiunge complessità al processo di scansione dei siti web. I siti Web moderni utilizzano spesso contenuti dinamici generati da JavaScript e AJAX, rendendolo difficile

crawler tradizionali per acquisire tutte le informazioni rilevanti. Inoltre, i siti Web possono imporre limiti di velocità o bloccare indirizzi IP per impedire una scansione eccessiva, che può interrompere le attività di raccolta dei dati.

Garantire l'accuratezza e la coerenza dei dati raccolti da varie fonti può essere difficile, soprattutto quando si ha a che fare con set di dati di grandi dimensioni. Scalare le operazioni di scansione web per gestire carichi di dati crescenti senza compromettere le prestazioni rappresenta una sfida tecnica importante. Inoltre, aderire alle linee guida legali ed etiche per la scansione dei siti Web è fondamentale per evitare potenziali problemi legali e mantenere una buona reputazione. Anche la gestione efficiente delle risorse informatiche per bilanciare la velocità di scansione e il rapporto costo-efficacia è fondamentale.

Tecniche per un'estrazione efficiente dei dati

L'implementazione di tecniche avanzate di estrazione dei dati garantisce che i dati raccolti siano pertinenti, accurati e pronti per l'analisi. Ecco alcune tecniche chiave per migliorare l’efficienza dell’estrazione dei dati:

- Elaborazione parallela : utilizza l'elaborazione parallela per distribuire le attività di estrazione dei dati su più thread o macchine, aumentando la velocità di estrazione dei dati gestendo più richieste contemporaneamente e riducendo il tempo complessivo necessario per raccogliere i dati.

- Scansione incrementale : implementa la scansione incrementale per aggiornare solo le parti del set di dati che sono cambiate dall'ultima scansione, riducendo la quantità di dati elaborati e il carico sui server Web, rendendo il processo di scansione più efficiente e meno dispendioso in termini di risorse.

- Browser headless : utilizza browser headless come Puppeteer o Selenium per il rendering e l'interazione con contenuti Web dinamici, consentendo l'estrazione accurata di dati da siti Web che fanno molto affidamento su JavaScript e AJAX, garantendo una raccolta dati completa.

- Prioritizzazione dei contenuti : dare priorità ai contenuti in base alla pertinenza e all'importanza, concentrandosi innanzitutto sui dati di alto valore, garantendo che i dati più critici vengano raccolti tempestivamente e ottimizzando l'utilizzo delle risorse e la pertinenza dei dati.

- Politiche di pianificazione e cortesia degli URL : implementa politiche intelligenti di pianificazione e cortesia degli URL per gestire la frequenza delle richieste a un singolo server, prevenendo il sovraccarico dei server Web e riducendo il rischio di blocco IP, garantendo un accesso prolungato alle origini dati.

- Deduplicazione dei dati : impiega tecniche di deduplicazione dei dati per eliminare le voci duplicate durante il processo di estrazione, migliorando la qualità dei dati e riducendo i requisiti di archiviazione garantendo che vengano archiviati ed elaborati solo dati univoci.

Soluzioni di scansione web in tempo reale

Fonte: media

Nel frenetico panorama digitale di oggi, la capacità di estrarre ed elaborare dati in tempo reale è fondamentale

cruciale per le aziende che cercano di mantenere un vantaggio competitivo. Le soluzioni di scansione web in tempo reale consentono la raccolta dati continua e istantanea, consentendo analisi e azioni immediate. L'implementazione di un'architettura basata sugli eventi può migliorare significativamente le funzionalità in tempo reale, in cui i crawler vengono attivati da eventi o modifiche specifici sul Web, garantendo che i dati vengano raccolti non appena diventano disponibili.

Scalabilità nella scansione web multilingue

La natura globale di Internet richiede la capacità di eseguire la scansione ed elaborare i dati in più lingue, presentando sfide uniche che richiedono soluzioni specializzate. Le operazioni di scansione dei siti Web per gestire contenuti multilingue comportano l'implementazione di algoritmi di rilevamento della lingua per identificare automaticamente la lingua delle pagine Web e garantire che vengano applicate le tecniche di elaborazione appropriate specifiche della lingua. L'utilizzo di librerie e framework di analisi che supportano più linguaggi, come BeautifulSoup, fornisce strumenti affidabili per estrarre contenuti da diverse pagine Web. L'integrazione di servizi di traduzione scalabili come Google Cloud Translation nella pipeline di elaborazione dei dati consente la traduzione dei contenuti in tempo reale, consentendo un'analisi fluida in diverse lingue.

Conclusione

Fonte: gruppobwt

Man mano che ci muoviamo nell'era digitale, l'importanza della scansione dei siti Web per le applicazioni Big Data continua a crescere. Il futuro del web crawling risiede nella sua capacità di scalare in modo efficiente, adattarsi ad ambienti web dinamici e fornire approfondimenti in tempo reale. I progressi nell’intelligenza artificiale e nell’apprendimento automatico giocheranno un ruolo fondamentale nel migliorare le capacità dei web crawler, rendendoli più intelligenti ed efficienti nell’elaborazione di grandi quantità di dati.

L’integrazione di sistemi distribuiti e infrastrutture basate su cloud migliorerà ulteriormente la scalabilità, consentendo alle aziende di gestire con facilità set di dati sempre più grandi. Man mano che le tecnologie di web crawling continuano ad evolversi, non solo miglioreranno i processi di raccolta dei dati, ma garantiranno anche che le aziende possano mantenere un vantaggio competitivo in un panorama digitale in continua evoluzione.

Abbracciare questi progressi non è solo un’opzione, ma una necessità per le organizzazioni che mirano a sfruttare i big data in modo efficace. Il futuro del web crawling promette di essere una forza trasformativa, che guida l’innovazione e fornisce gli strumenti necessari per sbloccare tutto il potenziale del vasto ecosistema di dati web.

Porta le tue applicazioni Big Data a un livello superiore con i servizi di web scraping personalizzabili di PromptCloud con integrazione e scalabilità perfette. Contattaci oggi per sfruttare la potenza della scansione web avanzata per la tua azienda.