In che modo l'intelligenza artificiale può sbloccare uno sviluppo responsabile ed etico dell'intelligenza artificiale

Pubblicato: 2023-09-01Con momenti di trasformazione che combinano innovazione e ingegnosità, come il lancio di ChatGPT di OpenAI nel novembre 2022, la visione dell'intelligenza artificiale che controlla le nostre vite non è più fantascienza.

Il momento spartiacque del lancio di ChatGPT ha inaugurato quella che l'industria chiama "l'esplosione del Cambriano dell'intelligenza artificiale".

Tuttavia, si tratta di qualcosa di più del semplice utilizzo dell’intelligenza artificiale per guadagni aziendali, che è l’attuale punto focale di questa esplosione. Al centro di questa evoluzione c’è un appello a concentrarsi sulla spiegabilità dell’IA. Ciò garantirà che i progressi nel campo dell’intelligenza artificiale siano potenti e trasparenti, il che è fondamentale per lo sviluppo etico dell’intelligenza artificiale.

L’intelligenza artificiale sta già prendendo decisioni per noi in molti campi. Ma non capire come l’intelligenza artificiale raggiunga tali decisioni rimane un collo di bottiglia. Questo è uno dei vantaggi spiegabili dell’intelligenza artificiale che gli imprenditori e gli esperti di tecnologia non possono permettersi di ignorare.

Con il progredire della tecnologia, la sfida degli esperti tecnologici è duplice: ampliare i limiti di ciò che l’intelligenza artificiale può ottenere, garantendo al tempo stesso che il suo funzionamento sia trasparente, responsabile ed eticamente valido. Ciò evidenzia il ruolo dell’intelligenza artificiale spiegabile nella tecnologia moderna.

Il potenziale economico dell’intelligenza artificiale

Il potenziale dell’intelligenza artificiale generativa di rivoluzionare la produttività non è solo teorico; è destinato ad avere ramificazioni economiche tangibili su scala globale. Secondo un rapporto del giugno 2023 intitolato “Il potenziale economico dell’intelligenza artificiale generativa: la prossima frontiera della produttività” pubblicato da McKinsey, l’intelligenza artificiale generativa potrebbe aggiungere un valore che va da 2,6 trilioni di dollari a 4,4 trilioni di dollari all’anno nei 63 casi d’uso analizzati. Esistono anche casi d’uso dell’intelligenza artificiale spiegabili che possono avvantaggiare le industrie in molteplici modi nuovi.

Leggi anche: Come l'intelligenza artificiale generativa per le aziende sta plasmando i settori

Il Washington Post ha riferito che oltre 11.000 aziende hanno utilizzato gli strumenti OpenAI forniti dalla divisione cloud di Microsoft, evidenziando le tendenze di adozione che accompagnano questo potenziale. Questi numeri rappresentano opportunità e responsabilità per i leader tecnologici che si muovono in questo panorama in evoluzione.

Man mano che il potenziale trasformativo dell’intelligenza artificiale diventa evidente, c’è un’enfasi sempre crescente sui principi spiegabili dell’intelligenza artificiale, garantendo che questi potenti strumenti operino con chiarezza, supervisione e considerazioni etiche. Le applicazioni di intelligenza artificiale spiegabile sono destinate a diventare una pietra miliare nel settore tecnologico.

Tuttavia, comprendere i benefici spiegabili dell’intelligenza artificiale e altri aspetti correlati è solo l’inizio. Pertanto, prima di discutere in dettaglio le sfumature dello sviluppo dell’intelligenza artificiale spiegabile, dobbiamo prima capire perché è essenziale.

Il mistero dei modelli di intelligenza artificiale: navigare nella "scatola nera"

Come tutti i progressi significativi, l’intelligenza artificiale comporta sfide, alcune profondamente legate alla sua struttura. Uno di questi aspetti di questo mistero è una "scatola nera". Rappresenta un modello operativo chiuso che funziona, ma anche gli sviluppatori a volte non sono in grado di spiegare come funziona. Questo è noto come l’enigma della scatola nera nel settore dell’intelligenza artificiale.

Questa mancanza di trasparenza è inaccettabile per molti, soprattutto per coloro che sono responsabili di decisioni aziendali o sociali cruciali. Un’intelligenza artificiale che funziona senza spiegabilità rischia di erodere la fiducia, soprattutto quando è possibile una perdita fisica e materiale.

Conseguenze impreviste: quando l'intelligenza artificiale esce dai binari

Le conseguenze di decisioni inspiegabili legate all’intelligenza artificiale possono variare da piccole inefficienze a significative implicazioni sociali. Consideriamo il settore finanziario: un sistema di intelligenza artificiale potrebbe negare un prestito a un individuo senza fornire una chiara motivazione.

Una tale decisione, priva di trasparenza, può portare a complicazioni legali e danni alla reputazione. Su scala più ampia, nel settore sanitario, un’intelligenza artificiale imperscrutabile potrebbe dare priorità a un paziente rispetto a un altro per il trattamento, con conseguenze che alterano o addirittura mettono fine alla vita.

Esempi reali di risultati e contrattempi IA imprevisti

Numerosi incidenti evidenziano le conseguenze impreviste dell’intelligenza artificiale. Il tragico incidente del 2018 che ha coinvolto l’auto a guida autonoma di Uber sottolinea le terribili implicazioni quando l’intelligenza artificiale interpreta male il suo ambiente. Un importante algoritmo sanitario che ha riscontrato un pregiudizio razziale è un chiaro promemoria del fatto che l’intelligenza artificiale, per quanto avanzata, può inavvertitamente perpetuare i pregiudizi umani se non adeguatamente compresa e monitorata.

L'elenco potrebbe continuare, da Tay di Microsoft, che ha twittato cose come "Hitler aveva ragione", a un cittadino americano che riceveva fatture esuberanti dalla sua carta di credito. Senza guardrail e senza la capacità di interpretare le decisioni prese dall’intelligenza artificiale, tali casi continueranno a verificarsi, da qui la richiesta di spiegazione.

Il caso aziendale: vantaggi spiegabili dell'intelligenza artificiale

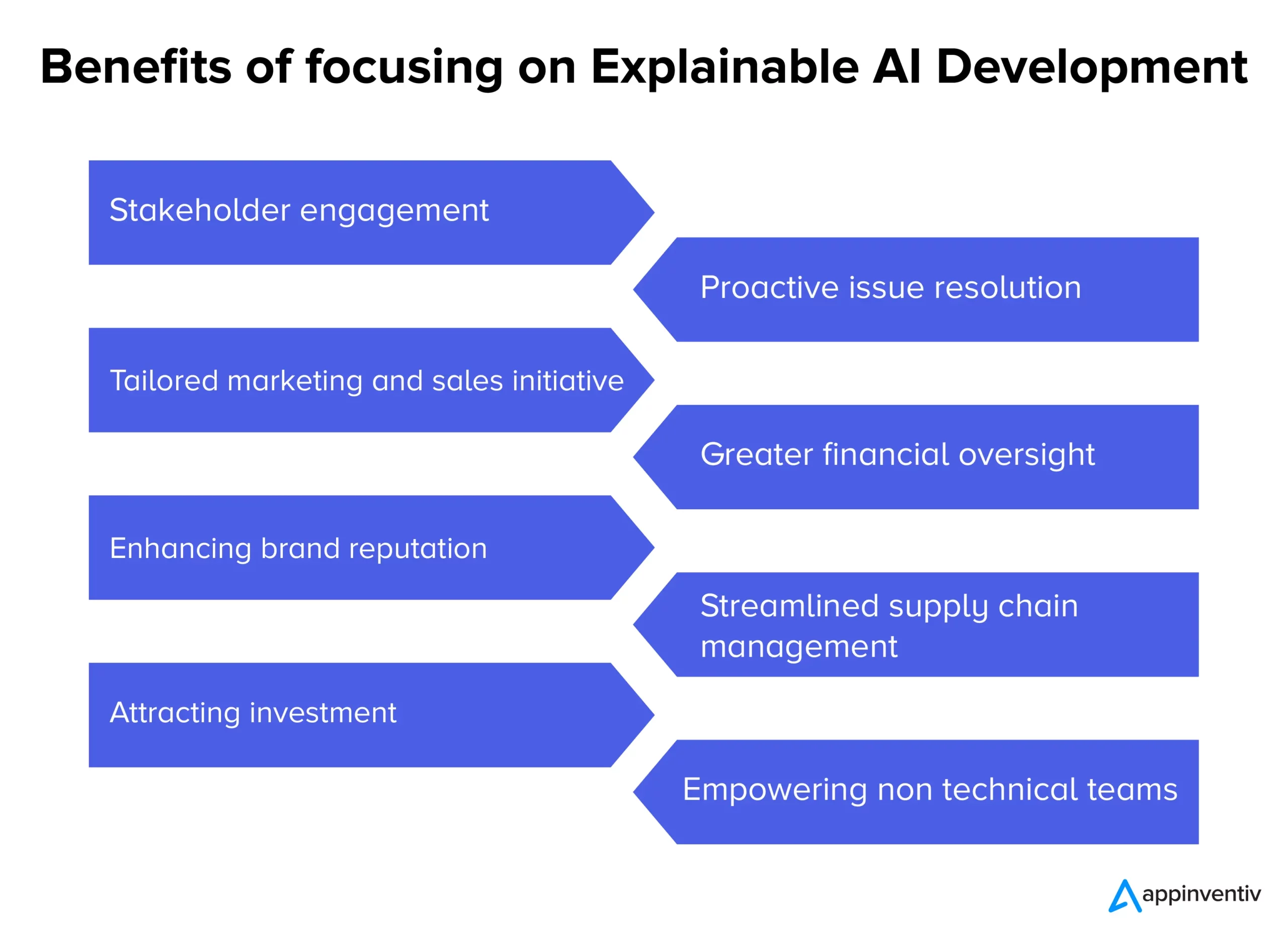

Poiché i sistemi di intelligenza artificiale guidano sempre più le ambizioni, la loro intrinseca opacità ha suscitato conversazioni sull’imperativo della trasparenza. Al di là del semplice discorso tecnico, esiste una solida logica aziendale alla base dell’adozione dell’intelligenza artificiale spiegabile. Ecco i vari vantaggi spiegabili dell’intelligenza artificiale per le aziende di tutti i settori.

- Coinvolgimento e fiducia degli stakeholder: processi decisionali trasparenti legati all’intelligenza artificiale possono favorire un più profondo senso di coinvolgimento e sicurezza tra i team interni e i partner esterni.

- Risoluzione proattiva dei problemi: prima che i problemi si aggravino, l’intelligenza artificiale spiegabile può evidenziare potenziali aree di preoccupazione, consentendo interventi e soluzioni tempestivi.

- Iniziative di marketing e vendita su misura: le aziende possono creare campagne più personalizzate ed efficaci comprendendo il "perché" dietro le informazioni sui consumatori basate sull'intelligenza artificiale.

- Maggiore supervisione finanziaria: quando i modelli e le previsioni finanziari basati sull’intelligenza artificiale sono trasparenti, potenziali anomalie o aree di crescita possono essere identificate e affrontate più facilmente.

- Migliorare la reputazione del marchio: le aziende note per l’implementazione etica e trasparente dell’intelligenza artificiale godranno probabilmente di una maggiore reputazione del marchio.

- Gestione semplificata della catena di fornitura: con informazioni chiare basate sull'intelligenza artificiale, i processi della catena di fornitura possono essere ottimizzati in modo più efficace, dalla gestione dell'inventario alla logistica.

- Attrarre investimenti: per gli investitori, la trasparenza nell’intelligenza artificiale può significare l’impegno di un’azienda verso l’innovazione responsabile, rendendola una proposta di investimento più attraente.

- Potenziamento dei team non tecnici: Explainable AI garantisce che le informazioni e le decisioni basate sull'intelligenza artificiale siano accessibili e utilizzabili per i team senza competenze tecniche approfondite, favorendo la collaborazione tra dipartimenti.

Mentre le aziende si muovono nel complesso panorama dell’era moderna, fare affidamento su soluzioni black-box può essere una scommessa. L’infusione di trasparenza nei processi di intelligenza artificiale non è solo un aggiornamento tecnologico; è una necessità aziendale, garantendo che ogni mossa supportata dall'intelligenza artificiale sia in linea con obiettivi e valori organizzativi più ampi, a significare il ruolo dell'intelligenza artificiale spiegabile. Questi sono anche casi d’uso dell’IA spiegabili su cui solitamente si concentrano gli imprenditori e gli sviluppatori di intelligenza artificiale.

Il progetto per un modello di intelligenza artificiale spiegabile

Ora che l’impatto dell’intelligenza artificiale nella nostra vita quotidiana sta diventando sempre più evidente ogni giorno che passa, diventa fondamentale garantire che le macchine a cui affidiamo le decisioni critiche siano accurate e trasparenti nel loro funzionamento.

Sviluppare un modello di intelligenza artificiale spiegabile non significa solo codificare; è un processo che prevede pianificazione strategica, test rigorosi e perfezionamento iterativo basato su principi e strumenti di intelligenza artificiale spiegabili. Ecco una guida passo passo e tecniche di intelligenza artificiale spiegabili che garantiscono che i modelli di intelligenza artificiale che sviluppiamo siano spiegabili e interpretabili pur essendo legalmente conformi.

- Comprendere l'ambito del problema: prima di immergerci nello sviluppo del modello, comprendiamo chiaramente l'ambito del problema e le parti interessate coinvolte. Cosa si aspettano gli utenti? Quali decisioni prenderà l’intelligenza artificiale e quale impatto avranno queste decisioni sono alcune delle domande a cui troviamo risposta.

- Selezione dei dati appropriati: la qualità e la pertinenza dei dati influenzano direttamente la capacità dell'intelligenza artificiale di essere accurata e spiegabile. Nello sviluppo del nostro modello di intelligenza artificiale, ci assicuriamo che i dati siano puliti, diversificati e privi di pregiudizi.

- Scegliere il modello giusto: mentre alcuni modelli, come le reti neurali profonde, sono più complessi e difficili da interpretare, altri, come gli alberi decisionali o la regressione lineare, possono offrire maggiore trasparenza. Scegliamo un equilibrio tra complessità e chiarezza sviluppando modelli di intelligenza artificiale spiegabili.

- Test iterativi: testiamo regolarmente il modello con diversi set di dati per garantire prestazioni costanti. Il feedback di questi test può informare perfezionamenti e miglioramenti.

- Integrazione di strumenti di spiegazione: strumenti come LIME o SHAP aiutano ad abbattere le previsioni del modello, offrendo approfondimenti su quali caratteristiche hanno influenzato una particolare decisione.

- Documentazione: una documentazione completa ci aiuta nella verifica, convalida e implementazione del modello. Garantisce che tutte le parti interessate comprendano il funzionamento e i limiti dell'intelligenza artificiale, dagli sviluppatori agli utenti finali.

Bilanciare le prestazioni del modello con l'interpretabilità

Una delle sfide più significative nello sviluppo di software di intelligenza artificiale spiegabile è bilanciare le prestazioni e l'interpretabilità di un modello. Sebbene i modelli complessi possano garantire una maggiore precisione, spesso lo fanno a scapito della trasparenza. Al contrario, i modelli più semplici potrebbero essere più facili da comprendere ma potrebbero non catturare in modo efficace le sfumature dei dati. Per trovare il giusto equilibrio, consideriamo quanto segue:

- Semplicità del modello rispetto alla complessità: determiniamo il livello minimo di complessità richiesto per ottenere prestazioni soddisfacenti. Se un modello più semplice fosse sufficiente, potrebbe essere una scelta migliore per garantire la spiegabilità.

- Uso di tecniche di spiegabilità: tecniche come la classificazione dell'importanza delle caratteristiche o metodi indipendenti dal modello possono aiutare a rendere i modelli complessi più interpretabili.

- Ciclo di feedback: manteniamo un ciclo di feedback continuo con gli utenti finali per capire se le decisioni dell'IA sono chiare e se c'è spazio per migliorare la trasparenza.

Sebbene il viaggio verso il raggiungimento di un'intelligenza artificiale spiegabile possa sembrare complicato, è necessario. Man mano che integriamo ulteriormente l’intelligenza artificiale nei nostri sistemi e processi, garantire questi modelli trasparenti e ad alte prestazioni sarà fondamentale per garantire fiducia ed efficienza durature.

In che modo Appinventiv può aiutarti a sviluppare modelli di intelligenza artificiale spiegabili?

Avendo quasi nove anni di esperienza nello sviluppo di prodotti IA, noi di Appinventiv comprendiamo le varie complessità legate allo sviluppo di modelli IA e i vantaggi spiegabili dell'IA. Avendo sviluppato numerose piattaforme e app basate sull'intelligenza artificiale, tra cui Mudra (un'app di finanza personale basata sull'intelligenza artificiale), i nostri ingegneri hanno l'esperienza nel settore e la supervisione per passare allo sviluppo di un'intelligenza artificiale spiegabile.

Qualunque sia il tuo progetto di intelligenza artificiale, noi, in qualità di azienda leader nello sviluppo di intelligenza artificiale, possiamo sbloccare l'interpretabilità e la spiegabilità del tuo modello di intelligenza artificiale in modo che tu possa fidarti con sicurezza delle decisioni prese dai modelli. Contattaci oggi stesso per intraprendere il viaggio verso un'intelligenza artificiale responsabile .

Domande frequenti

D. Cos’è l’IA spiegabile?

R. L' intelligenza artificiale spiegabile è un cambiamento di paradigma nello sviluppo dell'intelligenza artificiale che richiede lo sviluppo di modelli di intelligenza artificiale in modo tale che le decisioni prese dal modello di intelligenza artificiale possano essere ripercorse e gli utenti possano capire come il modello di intelligenza artificiale sta prendendo decisioni.

D. Come funziona l'intelligenza artificiale spiegabile?

R. L'intelligenza artificiale spiegabile funziona integrando elementi chiave di spiegabilità nei modelli di intelligenza artificiale durante lo sviluppo che possono aiutare a determinare come un modello di intelligenza artificiale ha raggiunto una particolare decisione.

D. Perché l’intelligenza artificiale spiegabile è importante?

R. L’intelligenza artificiale spiegabile è importante perché non capire come un modello di intelligenza artificiale prende decisioni per noi può portare a conseguenze disastrose e, nel peggiore dei casi, può significare un danno tangibile per le aziende o gli utenti del modello di intelligenza artificiale in questione.