Altamente visibile e di bassa qualità (o inutile): una combinazione SEO molto pericolosa

Pubblicato: 2024-01-08

Mentre aiutavo le aziende che sono state pesantemente colpite dagli "Aggiornamenti degli algoritmi folli dell'autunno 2023", ho sentito ancora una volta diversi proprietari di siti che avevano i livelli di traffico più alti proprio prima di essere martellati. Ne parlerò più approfonditamente presto, ma è qualcosa che vedo da molto tempo. E ora che abbiamo letto la testimonianza di Google su Navboost e i segnali di interazione dell'utente dall'ultimo processo antitrust, diverse idee mi sono passate per la testa.

Mentre si aiutano le aziende interessate dai principali aggiornamenti degli algoritmi (come gli aggiornamenti di base più ampi), è estremamente importante eseguire quello che io chiamo un "report delta" per identificare le principali query e pagine di destinazione che sono state eliminate durante tali aggiornamenti. I report Delta possono essere potenti e aiutare i proprietari dei siti a determinare se un calo è dovuto a aggiustamenti di pertinenza, cambiamenti di intenti o problemi generali di qualità del sito. E se il problema fosse la qualità, allora scavare nelle query e nelle pagine di destinazione che hanno perso di più può spesso portare a risultati importanti. E questi risultati potrebbero aiutare a identificare contenuti di bassa qualità, contenuti scarni, contenuti AI di bassa qualità, barriere nell’esperienza dell’utente, pubblicità aggressiva, una configurazione di affiliazione ingannevole o aggressiva e altro ancora.

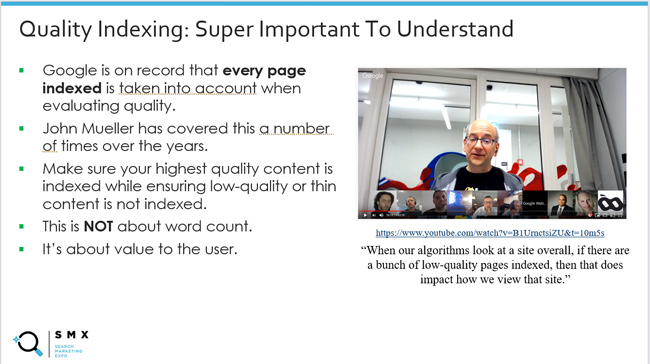

Ciò mi ha fatto pensare ancora una volta all '"indicizzazione della qualità", di cui ho parlato molte volte nei miei post e nelle mie presentazioni sui principali aggiornamenti degli algoritmi. Ciò significa garantire che i contenuti di massima qualità siano indicizzati, garantendo al tempo stesso che i contenuti di bassa qualità o scarni non vengano indicizzati. Questo rapporto è importante. Questo perché sappiamo che Google prende in considerazione ogni pagina indicizzata quando valuta la qualità. John Mueller di Google lo ha spiegato diverse volte e io abbiamo condiviso quei videoclip nel corso degli anni.

Ma tutte le cose sono uguali dal punto di vista della qualità? In altre parole, se trovi un lotto di contenuti di qualità inferiore sul tuo sito che non vengono visualizzati spesso nei risultati di ricerca, è lo stesso che contenuti di qualità inferiore (o contenuti non utili) che sono altamente visibili nei risultati di ricerca?

I commenti di John Mueller sulla rimozione di contenuti di bassa qualità sono leggermente cambiati nel corso degli anni su questo fronte. L'ho notato con il tempo e ha sempre stuzzicato la mia curiosità. John è passato dallo spiegare che se un contenuto viene indicizzato, la sua qualità può essere valutata allo spiegare che si concentrerà innanzitutto su ciò che è altamente visibile e di bassa qualità . Spiegherò di più sul motivo per cui questo ha perfettamente senso (soprattutto con le nuove informazioni provenienti dall'ultimo processo antitrust di Google).

Di seguito, tratterò rapidamente alcune informazioni di base sui segnali di coinvolgimento degli utenti e sulla SEO, quindi tratterò alcuni commenti interessanti di John Mueller di Google nel corso degli anni sulla rimozione di contenuti di bassa qualità, quindi li collegherò insieme a La recente testimonianza di Google sull'utilizzo dei segnali di interazione dell'utente per favorire il posizionamento (ad esempio Navboost).

Per prima cosa, facciamo un passo indietro nella storia e discutiamo dei segnali di interazione dell'utente e dell'impatto SEO.

Segnali di interazione dell'utente e SEO e la straordinaria capacità di Google di comprendere la felicità degli utenti:

Con l'ultimo processo antitrust di Google, abbiamo imparato molto su come Google sfrutta i segnali di interazione dell'utente per influenzare il posizionamento. Ad esempio, Pandu Nayak di Google ha parlato di Navboost, di come Google raccoglie 13 mesi di dati sui clic (in precedenza 18 mesi) e di come tali dati possano aiutare Google a comprendere la felicità degli utenti (utenti di ricerca soddisfatti).

Anche se conoscere Navboost ha lasciato senza parole molte persone (giustamente), c'erano sempre segnali che Google stesse facendo qualcosa con i dati sul coinvolgimento degli utenti dal punto di vista del ranking. Nessuno lo sapeva con certezza, ma era difficile ignorare il concetto mentre si scavava in molti siti che cadevano nel tempo a causa dei principali aggiornamenti dell'algoritmo (in particolare degli aggiornamenti core ampi).

Ad esempio, nel 2014 ho scritto un post sull’ingannevole e sinistro aumento del traffico prima che un importante algoritmo colpisse. Nota: Search Engine Watch sta riscontrando problemi con i post più vecchi, quindi mi sono collegato alla versione della Wayback Machine del mio post. Ho scritto quel post dopo che molte aziende mi hanno contattato riguardo agli enormi successi di Panda e mi hanno spiegato che avevano appena sperimentato i livelli di traffico più alti di sempre fino a quando... non si sono bloccati con l'aggiornamento successivo.

A me sembrava che Google stesse acquisendo così tanta intelligenza in base al modo in cui gli utenti interagivano con i contenuti delle SERP che alla fine ha contribuito al calo. In altre parole, Google potrebbe vedere utenti insoddisfatti su larga scala per quei siti. E poi boom, hanno fallito.

Ecco una citazione dal mio articolo SEW:

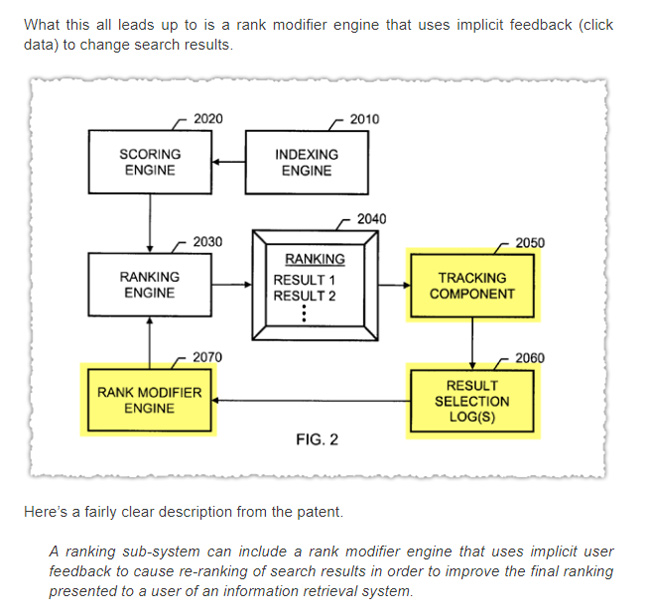

Inoltre, AJ Kohn ha scritto un pezzo nel 2015 sul CTR come fattore di ranking. AJ ha anche lavorato su molti siti nel corso degli anni e aveva la seria sensazione che i segnali di interazione dell'utente giocassero un ruolo nel posizionamento. Ecco uno screenshot del post di AJ che fa riferimento al feedback implicito degli utenti.

Ho anche scritto molto sul pericolo di un tempo di permanenza ridotto e su come l'implementazione di qualcosa come la frequenza di rimbalzo modificata potrebbe aiutare i proprietari dei siti a farsi un'idea migliore dei contenuti che non soddisfano o superano le aspettative degli utenti. Quel post è del 2012. E ho ampliato quell'idea con un altro post nel 2018 sull'utilizzo di diversi meccanismi di tracciamento come proxy per la felicità dell'utente (inclusa la frequenza di rimbalzo modificata, il monitoraggio della profondità di scorrimento e il tempo sulla pagina). Tieni presente che questo era per GA3, non GA4.

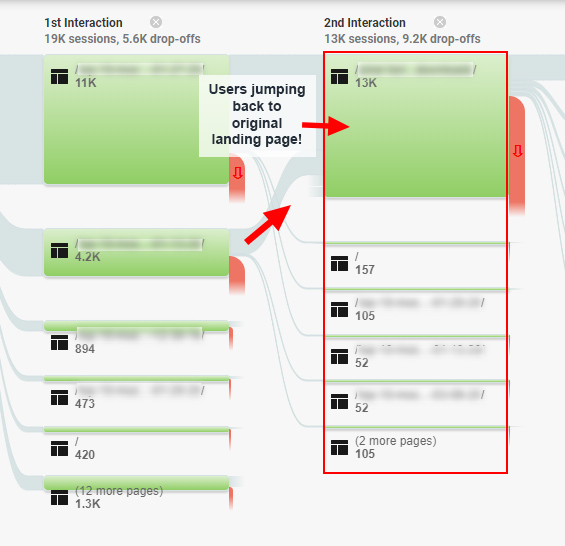

E come ottimo esempio di come i problemi di coinvolgimento degli utenti potrebbero avere un impatto sulla SEO, c'è stato un caso di studio che ho scritto nel 2020 sulla "trappola del coinvolgimento SEO", in cui ho trovato utenti che correvano in tondo attorno a un sito, e sono sicuro che alla fine tornerò a farlo. le SERP, per risposte migliori. Quel sito è stato colpito da un ampio aggiornamento di base e si è ripreso dopo aver risolto molti di questi problemi. Quindi sì, ci sono segnali più negativi di interazione dell'utente che Google deve valutare.

Ecco uno screenshot di quel post che mostra il reporting del flusso di comportamento per gli utenti frustrati:

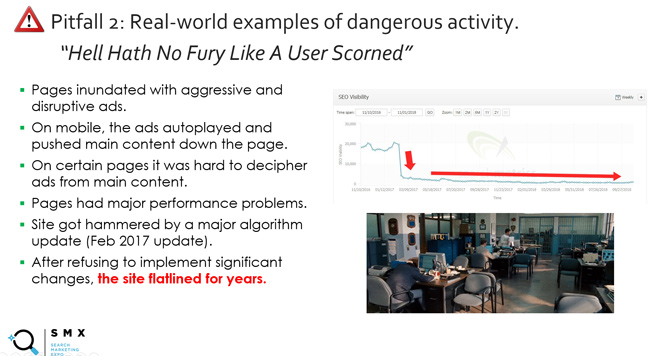

E c'è la diapositiva (e il motto) che utilizzo da molto tempo nelle mie presentazioni sugli aggiornamenti di base intitolati "L'inferno non ha furia quanto un utente disprezzato". Ciò non riguarda solo la qualità dei contenuti e include pubblicità aggressiva, barriere nell’esperienza dell’utente e altro ancora. Fondamentalmente, non infastidire gli utenti. Pagherai un prezzo pesante. E a proposito, qual è un ottimo modo per Google di comprendere gli utenti infastiditi? Bene, monitorando i segnali di interazione dell'utente come il tempo di permanenza basso (qualcuno che torna rapidamente alla SERP dopo aver visitato un sito di Google).

E riguardo al tempo di permanenza, una delle mie citazioni preferite risale a anni fa, quando Duane Forrester di Bing scrisse un post sul blog in cui spiegava come un tempo di permanenza basso potesse influire sulla visibilità della ricerca. Duane non lavora più per Bing, ma è stato il Matt Cutts di Bing per diversi anni. In quel post, che ora è stato cancellato (ma può essere trovato tramite la Wayback Machine), Duane ha spiegato quanto segue:

“Se i tuoi contenuti non li incoraggiano a rimanere con te, se ne andranno. I motori di ricerca possono capirlo osservando il tempo di permanenza. Il tempo che intercorre tra il momento in cui un utente fa clic sul nostro risultato di ricerca e il momento in cui ritorna dal tuo sito web racconta una potenziale storia. Un minuto o due vanno bene perché possono facilmente indicare che il visitatore ha consumato i tuoi contenuti. Meno di un paio di secondi può essere visto come un risultato scarso. E anche se questo non è l'unico fattore che esaminiamo per contribuire a determinare la qualità, è un segnale che teniamo d'occhio."

Poi in un altro post su SEJ, Duane ha continuato dicendo:

"Il tempo di permanenza era uno di quei concetti che avevano perfettamente senso una volta spiegati, ed è stato subito ovvio che tale metrica poteva essere molto importante nel determinare la soddisfazione degli utenti."

E infine, Duane ha spiegato che è stato considerato “in un mix di fattori”, che è importante capire. Ha spiegato che inseguire il tempo di permanenza era una cattiva idea. Ha spiegato di concentrarsi su miglioramenti più ampi per un sito che aumentino il coinvolgimento degli utenti (e il tempo di permanenza potrebbe aumentare come risultato di tale lavoro). Questo è anche il motivo per cui ritengo che l’approccio del “lavello della cucina” alla bonifica sia una strada efficace da percorrere. Affronta quanti più problemi di qualità possibile e in futuro potranno accadere grandi cose.

Nota, non concentrarti sulla quantità di tempo che Duane ha concesso nel 2011 per un "breve impegno"... sono sicuro che questo sia uno dei motivi per cui il post è stato rimosso. Per alcuni tipi di contenuti, un periodo di tempo più breve va benissimo dal punto di vista del coinvolgimento degli utenti. Ma il punto principale relativo al tempo di permanenza ridotto, soprattutto se visto su molti contenuti di un sito, è estremamente importante da comprendere. Lo era allora, e lo è sicuramente anche adesso.

Il punto principale che sto cercando di trasmettere è che l'interazione con l'utente è sempre sembrata un fattore in qualche modo... semplicemente non sapevamo esattamente come. Questo fino a quando Navboost non è stato smascherato. Ne parlerò più approfonditamente presto.

Perché "altamente visibile" è importante: commenti di John Mueller di Google.

OK, ora diamo uno sguardo più da vicino a ciò che chiamo “indicizzazione della qualità”. Ancora una volta, ciò significa assicurarsi che vengano indicizzati solo i contenuti di altissima qualità che possono soddisfare o superare le aspettative degli utenti, garantendo al tempo stesso che i contenuti di bassa qualità o scarni non vengano indicizzati.

Google ha spiegato nel tempo che tutte le pagine indicizzate vengono prese in considerazione nella valutazione della qualità. Ne ho parlato molte volte nei post del mio blog e nelle presentazioni sui principali aggiornamenti degli algoritmi (specialmente quando si tratta di aggiornamenti di base più ampi).

Ecco John del 2017 che spiega che:

Col passare del tempo, però, ho notato un cambiamento nella risposta di John quando gli è stato chiesto se fosse necessario rimuovere contenuti di qualità inferiore. John iniziò a spiegare che si sarebbe concentrato su contenuti “altamente visibili” e di qualità inferiore. L'ho sentito in diversi video di Hangout di Search Central e ne ha parlato anche in un'intervista con Marie Haynes.

Ecco alcuni esempi:

Innanzitutto, ecco John che spiega che tutte le cose non sono uguali dal punto di vista del contenuto. Google proverà a individuare le pagine più importanti e si concentrerà su quelle:

Ecco John che spiega che Google può comprendere i contenuti principali di un sito, dove stanno andando i visitatori, ecc.

Ed ecco John che spiega che se sai che le persone visitano determinate pagine, allora avrebbe senso occuparsi prima di quelle pagine di qualità inferiore (in modo che le persone possano restare):

Quindi perchè è importante? Bene, ora che sappiamo di più su come Google sfrutta i segnali di interazione dell'utente per influenzare la visibilità e il posizionamento tramite Navboost, l'affermazione di John ha molto senso. Maggiore è la quantità di dati sull'interazione dell'utente di cui dispone Google per le combinazioni di query e pagina di destinazione, maggiore sarà la sua capacità di comprendere la felicità dell'utente. Se una pagina è di bassa qualità e non è visibile, Google non dispone di dati sull'interazione dell'utente. Certo, Google può utilizzare altri segnali, l'elaborazione del linguaggio naturale, ecc. per comprendere meglio il contenuto, ma i segnali di interazione dell'utente sono sorprendenti per comprendere la soddisfazione degli utenti.

Nota: prima di proseguire, volevo fosse chiaro che avrei comunque affrontato tutti i problemi di qualità dei contenuti di un sito (anche quelli che non sono "altamente visibili"), ma avrei iniziato con quelli più visibili. Questo è un punto importante per i proprietari di siti che devono affrontare un forte calo da ampi aggiornamenti di base, aggiornamenti di contenuti utili o aggiornamenti di recensioni.

Il processo antitrust di Google e i segnali di coinvolgimento degli utenti influenzano le classifiche.

Ho menzionato Navboost più volte in questo post e volevo toccarlo in questa sezione. Non andrò molto in profondità poiché recentemente l'argomento è stato trattato in numerosi altri post del settore, ma è importante capire.

Nella testimonianza antitrust di Google, Pandu Nayak ha spiegato l'uso di Navboost, un sistema per sfruttare i dati di interazione dell'utente per aiutare Google a comprendere la felicità degli utenti. Fondamentalmente consente a Google di imparare dai suoi utenti nel tempo e di adattare le classifiche in base a tali apprendimenti. Navboost non è ovviamente l'unico fattore in gioco, ma è un fattore importante nel determinare la classifica.

Ecco Pandu Nayak sull'importanza di Navboost:

“Voglio dire, è difficile stabilire una sorta di classificazione in questo modo. Dirò che navboost è importante, giusto. Quindi non voglio minimizzarlo in alcun modo. Ma dirò anche che ci sono molti altri segnali altrettanto importanti, come quelli che ho citato. E non puoi davvero disattivare alcune di queste cose. Non so cosa significherebbe disattivare, ad esempio, l'indice dei documenti. In un certo senso questa è la cosa più importante, le parole sulla pagina e così via, giusto. Quindi è un po' difficile giudicare in questo modo. Quindi direi che navboost è uno dei segnali importanti che abbiamo. "

Pertanto, se le pagine sono altamente visibili per una query, Google raccoglie attivamente segnali di coinvolgimento degli utenti per tali URL e combinazioni di query (ora raccoglie 13 mesi di dati sui clic). E Navboost può utilizzare questi segnali di interazione dell'utente per aiutare i sistemi di Google a comprendere la felicità degli utenti (inclusa la comprensione del tempo di permanenza, dei clic lunghi, degli scorrimenti, del passaggio del mouse e altro).

D’altro canto, se le pagine non sono altamente visibili per le query, Google non può sfruttare questi segnali di interazione dell’utente… o non abbastanza segnali per avere un impatto. Ciò non significa che Google non sia in grado di comprendere la qualità della pagina, ma non avrà segnali utente reali per tali combinazioni di query e pagina di destinazione. E questo è incredibilmente importante.

Tieni presente che se sei interessato a saperne di più sui segnali di interazione dell'utente emersi dal processo antitrust di Google, AJ Kohn ha scritto un ottimo post che copre tali informazioni sulla base della testimonianza di Pandu Nayak. Ti consiglio di leggere il post di AJ se non l'hai già fatto poiché copre di più su Navboost, segnali di interazione dell'utente, CTR come fattore di ranking, ecc.

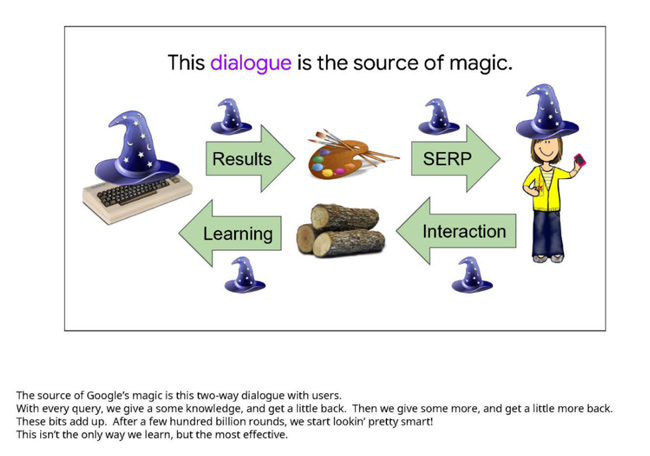

Ecco una diapositiva di una presentazione di Google che ha costituito la prova durante il processo. Sottolinea l’importanza dei segnali di interazione dell’utente per determinare la soddisfazione del ricercatore. Tieni presente che questa diapositiva risale a diversi anni fa. Si tratta della “fonte della magia di Google”:

E non dimenticare gli algoritmi di qualità a livello di sito:

Ancora una volta, non voglio impantanare questo post con troppe informazioni dal processo antitrust, ma il mio punto principale è che i contenuti "altamente visibili" nelle SERP possono ottenere moltissimi segnali di interazione dell'utente, che Google può utilizzare come fattore per la classifica. È anche possibile che Google possa utilizzare tali dati anche in forma aggregata per influenzare gli algoritmi di qualità a livello di sito. E questi algoritmi a livello di sito possono svolgere un ruolo enorme nel modo in cui i siti si comportano durante gli aggiornamenti principali (e altri importanti aggiornamenti degli algoritmi). Anche di questo mi occupo da molto tempo.

Cosa significa questo per te. Il mio consiglio per i proprietari di siti interessati dai principali aggiornamenti dell'algoritmo:

Per i proprietari di siti fortemente colpiti dai principali aggiornamenti degli algoritmi, è importante fare un passo indietro e analizzare il sito nel suo complesso dal punto di vista della qualità. E come ha spiegato in precedenza John Mueller di Google, la “qualità” è molto più che un semplice contenuto. Riguarda anche i problemi di UX, la situazione della pubblicità, il modo in cui vengono presentate le cose e altro ancora.

E ora, con la conferma che Google sfrutta i segnali di interazione dell'utente per influenzare la visibilità e il posizionamento tramite Navboost, inserirei gli URL "altamente visibili" nell'elenco quando decido a cosa indirizzarmi. Sì, dovresti affrontare tutti i problemi di qualità che emergono, anche i cruft che potrebbero non essere altamente visibili, ma darei la priorità agli URL più visibili che hanno portato a un importante aggiornamento dell'algoritmo. Quindi sì, eseguire un rapporto delta è diventato ancora più importante.

Riepilogo: fai emergere tutti i contenuti di bassa qualità, ma inizia con ciò che è "altamente visibile".

Nel corso degli anni, ho sempre spiegato che i contenuti devono soddisfare o superare le aspettative degli utenti in base alla query. Ora, con l'ultima testimonianza del processo antitrust di Google, abbiamo prove concrete che Google sta effettivamente sfruttando i segnali di interazione dell'utente per modificare le classifiche (e possibilmente influenzare gli algoritmi di qualità a livello di sito). In qualità di proprietario di un sito, non lasciare che contenuti di bassa qualità, scarni o inutili rimangano nelle SERP con cui gli utenti possano interagire. Come ho visto nel corso degli anni con i principali aggiornamenti dell'algoritmo, ciò non finirà bene. Affronta definitivamente tutti i potenziali problemi di qualità su un sito, ma non trascurare ciò che è altamente visibile. È un ottimo punto di partenza per migliorare la qualità complessiva del sito.

GG