Scalabilità delle operazioni di data scraping: suggerimenti degli esperti per la gestione di grandi volumi di dati

Pubblicato: 2024-05-25Con l’aumento della domanda di dati, crescono anche le sfide associate alla scalabilità delle operazioni di data scraping. Il web scraping su larga scala non significa solo aumentare la quantità di dati raccolti; si tratta di mantenere la qualità, garantire l'efficienza e superare gli ostacoli tecnici e legali.

Immagina un'azienda di vendita al dettaglio che inizia con una modesta operazione di raccolta dati, raccogliendo informazioni su prezzi e prodotti da alcuni siti Web della concorrenza. Inizialmente, questa configurazione funziona senza intoppi, fornendo preziose informazioni per il processo decisionale strategico. Tuttavia, man mano che l'azienda si espande e inizia a rivolgersi a un mercato più ampio, diventa evidente la necessità di web scraping su larga scala da centinaia o addirittura migliaia di siti Web. L’infrastruttura iniziale, adeguata per operazioni su piccola scala, ora fatica a sopportare l’aumento del carico, con conseguente rallentamento delle prestazioni e potenziali imprecisioni dei dati.

Inoltre, la gestione di fonti web diverse e dinamiche aggiunge un ulteriore livello di complessità. I siti web spesso aggiornano le proprie strutture, implementano misure anti-scraping o richiedono l'estrazione di dati da complessi contenuti renderizzati con JavaScript. Queste sfide richiedono soluzioni robuste e adattabili in grado di adattarsi perfettamente senza compromettere la qualità dei dati o la legalità.

Il web scraping su larga scala non significa solo gestire più dati, ma farlo in modo efficiente, affidabile e conforme agli standard legali. Implica la scelta degli strumenti e delle tecnologie giusti, la creazione di un’infrastruttura solida e l’implementazione di pipeline efficienti di elaborazione dei dati. Comprendere le sfide del web scraping su larga scala e sviluppare strategie per superarle è essenziale per le aziende che desiderano sfruttare tutto il potenziale del data scraping.

N. 1: scegliere gli strumenti e le tecnologie giusti

La selezione degli strumenti e delle tecnologie appropriati è la base delle operazioni di web scraping su larga scala. Framework di scraping avanzati come Scrapy, Beautiful Soup e Selenium offrono funzionalità robuste in grado di gestire attività di scraping complesse. Questi strumenti sono eccellenti per progetti più piccoli e più gestibili, ma con l'aumento della portata e della complessità delle operazioni di scraping dei dati, sono necessarie soluzioni più potenti e flessibili.

È qui che entrano in gioco i fornitori di servizi di web scraping come PromptCloud. PromptCloud offre una soluzione completa ed end-to-end per l'estrazione dei dati progettata per adattarsi perfettamente alle esigenze aziendali. A differenza degli strumenti tradizionali, PromptCloud fornisce un servizio completamente gestito che si occupa di tutto, dalla configurazione dell'infrastruttura di scraping alla consegna dei dati.

N. 2: costruire un'infrastruttura solida

Un’infrastruttura solida è fondamentale per supportare operazioni di web scraping su larga scala. Ciò include server potenti, ampie soluzioni di archiviazione e connessioni Internet ad alta velocità. Sfruttare servizi di infrastruttura cloud come Amazon Web Services (AWS), Google Cloud Platform (GCP) o Microsoft Azure garantisce scalabilità e affidabilità, consentendo alle aziende di adattare le proprie operazioni in base alle esigenze.

Configurare e gestire la propria infrastruttura può essere complesso e dispendioso in termini di risorse. PromptCloud offre una soluzione semplificata che elimina queste sfide. Fornendo un servizio di data scraping completamente gestito, PromptCloud si prende cura dei requisiti dell'infrastruttura, garantendo che le tue operazioni si svolgano in modo fluido ed efficiente.

N. 3: garantire la qualità e l'accuratezza dei dati su larga scala

Mantenere la qualità e l’accuratezza dei dati è una sfida significativa quando si ha a che fare con set di dati di grandi dimensioni. Man mano che il volume dei dati cresce, aumenta il rischio di errori e incoerenze, rendendo fondamentale implementare solide procedure di convalida e pulizia dei dati. Garantire che i dati raccolti siano affidabili e utilizzabili è essenziale per prendere decisioni aziendali informate e mantenere l'integrità delle analisi.

I siti web cambiano spesso la loro struttura, il che può interrompere le operazioni di raccolta dei dati e portare a imprecisioni. Monitorare e aggiornare regolarmente gli script di scraping è essenziale per adattarsi a questi cambiamenti e garantire la continua accuratezza dei dati raccolti.

PromptCloud fornisce una soluzione completa per mantenere la qualità e l'accuratezza dei dati su larga scala. Sfruttando i servizi di web scraping su larga scala e di data scraping gestito, puoi garantire che i tuoi processi di raccolta dati rimangano robusti e affidabili.

N. 4: sfruttare le soluzioni cloud per la scalabilità

Le soluzioni cloud offrono una scalabilità senza pari per le operazioni di data scraping. Servizi come AWS EC2 e Google Cloud Compute Engine consentono alle aziende di aumentare o ridurre le proprie risorse informatiche in base alla domanda. Questa flessibilità garantisce che le operazioni di scraping dei dati possano gestire carichi di lavoro variabili senza compromettere le prestazioni.

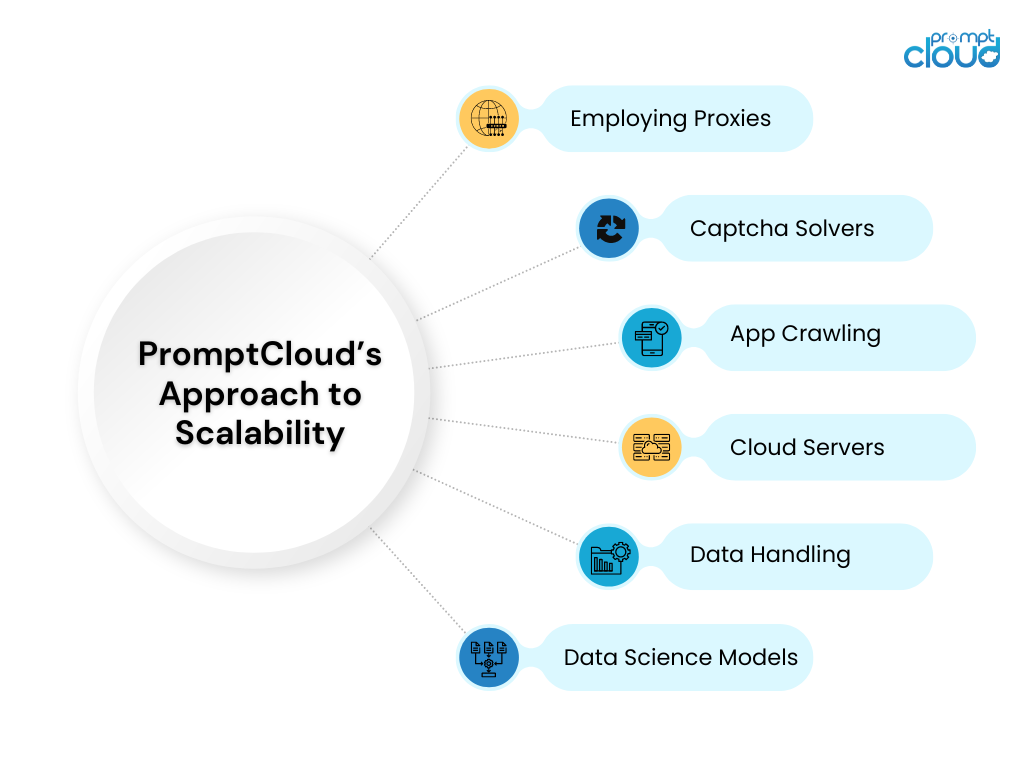

PromptCloud sfrutta appieno le soluzioni cloud per offrire un servizio di web scraping su larga scala scalabile ed efficiente. Integrandosi con le principali piattaforme cloud, PromptCloud garantisce che le tue operazioni di data scraping possano gestire facilmente qualsiasi volume di dati.

N. 5: Gestione dell'archiviazione e della gestione dei dati

Soluzioni efficaci di archiviazione e gestione dei dati sono fondamentali per gestire grandi volumi di dati raschiati. Man mano che la quantità di dati cresce, garantire che siano archiviati in modo sicuro e che sia possibile accedervi rapidamente diventa sempre più importante.

PromptCloud offre soluzioni complete di archiviazione e gestione dei dati come parte dei suoi servizi gestiti di scraping dei dati. Utilizzando soluzioni di archiviazione scalabili e implementando le migliori pratiche nella gestione dei dati, PromptCloud garantisce che i tuoi dati siano archiviati in modo sicuro e sia possibile accedervi in modo efficiente.

Scalabilità delle operazioni di web scraping con PromptCloud

La scalabilità delle operazioni di web scraping per gestire grandi volumi di dati presenta numerose sfide, dal mantenimento della qualità dei dati e la gestione dell'archiviazione alla garanzia di recupero ed elaborazione efficienti. Tuttavia, con le strategie e gli strumenti giusti, queste sfide possono essere affrontate in modo efficace, consentendo alle aziende di sfruttare tutto il potenziale del web scraping per ottenere un vantaggio competitivo e un processo decisionale informato.

PromptCloud offre una suite completa di soluzioni progettate per affrontare le complessità del web scraping su larga scala. Sfruttando tecnologie avanzate e un'infrastruttura solida, garantiamo che le tue operazioni di scraping dei dati siano scalabili, efficienti e affidabili. Sei pronto a ridimensionare le tue operazioni di web scraping e a sfruttare tutto il potenziale dei tuoi dati? Collabora con PromptCloud per sfruttare le nostre soluzioni all'avanguardia e i nostri servizi esperti. Contattaci oggi per programmare una demo e vedere le nostre soluzioni in azione.