IA responsabile: affrontare le sfide dell’adozione con principi guida e strategie

Pubblicato: 2023-09-08In un’era dominata dall’adozione diffusa di soluzioni di intelligenza artificiale, è diventato piuttosto vitale dare priorità a un processo di sviluppo responsabile nel rispetto dei principi etici e di sicurezza. Poiché questi sistemi di intelligenza artificiale continuano a crescere in capacità e a trovare applicazioni in varie nicchie industriali, garantire che la loro creazione sia in linea con rigorose misure di sicurezza deve essere una delle massime priorità dell’organizzazione.

Quindi, come si può garantire che i loro sistemi basati sull’intelligenza artificiale siano etici e non causino conseguenze indesiderate? La risposta semplice a questo enigma è l’adesione ai principi dell’IA responsabile.

L’intelligenza artificiale responsabile (RAI) si riferisce a un quadro completo nel campo dell’intelligenza artificiale, in cui le considerazioni etiche e il benessere sociale sono al centro dell’attenzione. Presenta lo sviluppo e l’applicazione responsabili di sistemi di intelligenza artificiale progettati per armonizzarsi con i principi fondamentali.

I principi di un’intelligenza artificiale responsabile consentono alle organizzazioni di concentrarsi fortemente sulla trasparenza, consentendo agli utenti e alle parti interessate di comprendere il funzionamento interno dei sistemi di intelligenza artificiale. Questa trasparenza apre la strada a una maggiore fiducia e responsabilità, consentendo alle persone di comprendere come vengono prese le decisioni sull’intelligenza artificiale. La RAI gestisce inoltre attivamente i bias all’interno degli algoritmi di intelligenza artificiale gestendo in modo intelligente i dati e incorporando misure di equità per garantire che i risultati siano imparziali e imparziali.

Questo blog ti aiuterà a comprendere i cinque principi dell'IA responsabile e in che modo rispettarli può rendere il tuo sistema di intelligenza artificiale giusto e giusto per gli utenti. Oltre a esaminare i vantaggi derivanti dall'adozione di un'intelligenza artificiale responsabile per le aziende, ti aiuteremo anche a comprendere le varie sfide che possono essere affrontate adottando l'approccio semplificato.

La necessità di adottare strategie di IA responsabili: mitigare i rischi dell’IA

Nel marzo 2016, Microsoft ha lanciato su Twitter un chatbot AI chiamato Tay. Lo scopo di Tay era imparare dalle sue interazioni con gli utenti. Sfortunatamente, alcuni individui hanno iniziato a pubblicare contenuti offensivi sul bot, con il risultato che Tay ha risposto con un linguaggio offensivo. Nel giro di poche ore, Tay si trasformò in un bot che promuoveva l'incitamento all'odio e la discriminazione. Microsoft ha rapidamente messo Tay offline e si è scusata per i tweet inappropriati del bot. Questo incidente è un chiaro esempio di come l’intelligenza artificiale possa andare storta e da allora si sono verificati molti casi simili.

L’intelligenza artificiale ha un enorme potenziale a vantaggio della società, ma come dice lo zio Ben, “da un grande potere derivano grandi responsabilità”.

Quando utilizzi l'intelligenza artificiale per importanti decisioni aziendali che coinvolgono dati sensibili, è fondamentale sapere:

- Cosa sta facendo l’intelligenza artificiale e perché?

- Sta facendo scelte accurate e giuste?

- Rispetta la privacy delle persone?

- Riuscirai a controllare e tenere d'occhio questa potente tecnologia?

Le organizzazioni di tutto il mondo stanno realizzando l’importanza delle strategie di intelligenza artificiale responsabile, ma si trovano in fasi diverse nel loro percorso verso la sua adozione. Abbracciare i principi dell’IA responsabile (RAI) è la strategia più efficace per mitigare i rischi associati all’IA.

Pertanto, è giunto il momento di valutare le vostre pratiche attuali e garantire che i dati vengano utilizzati in modo responsabile ed etico. L’adozione anticipata della RAI non solo ridurrà i rischi associati a queste pratiche, ma posizionerà anche le organizzazioni davanti alla concorrenza, fornendo loro un vantaggio competitivo che potrebbe essere difficile da superare in futuro.

Secondo un sondaggio del MIT Sloan, il 52% delle aziende sta adottando misure verso pratiche di intelligenza artificiale responsabili. Tuttavia, oltre il 79% di queste aziende ammette che i propri sforzi sono limitati in termini di portata e portata. Il rapporto evidenzia la crescente importanza per le aziende di affrontare le sfide e dare priorità all’IA responsabile (RAI), poiché il ruolo dell’IA nelle aziende continua ad aumentare. Per dare forma a un futuro sostenibile e responsabile basato sull’intelligenza artificiale, stabilire un solido quadro etico non è solo una scelta ma essenziale.

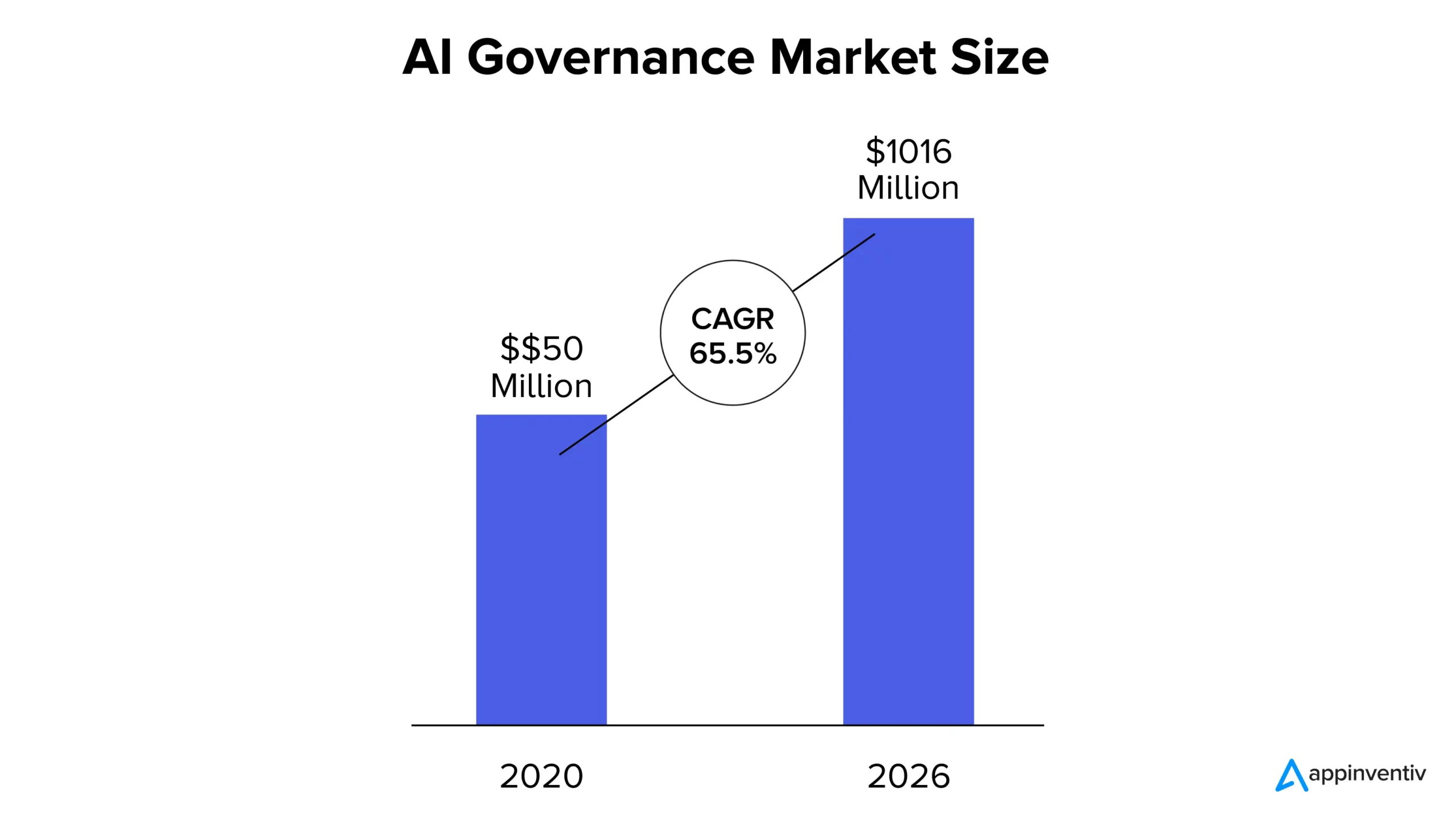

Ora, secondo il rapporto MarketsandMarkets, il mercato della governance dell’IA è stato valutato a 50 milioni di dollari nel 2020 e si prevede che raggiungerà 1.016 milioni di dollari entro il 2026, con un CAGR del 65,5%. La crescente quota di mercato può essere attribuita alla crescente trasparenza nei sistemi di intelligenza artificiale, al rispetto delle conformità normative e alla crescente necessità di fiducia nelle soluzioni basate sull’intelligenza artificiale.

Cosa sono i principi dell’IA responsabile?

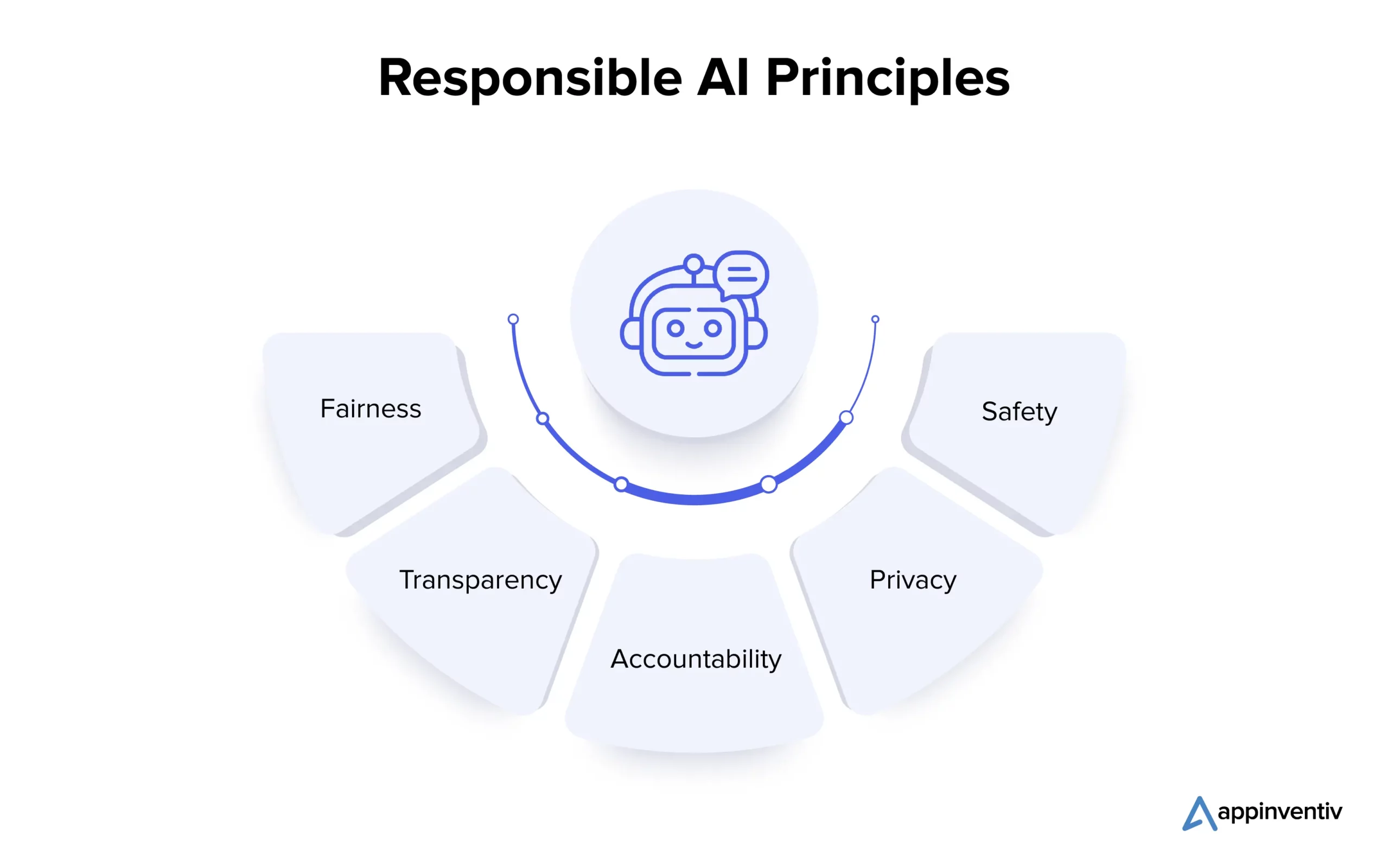

Comprendere i principi fondamentali dell’intelligenza artificiale responsabile è vitale per le organizzazioni che desiderano navigare eticamente nel complesso panorama dell’intelligenza artificiale. Esaminiamo i molteplici principi in dettaglio di seguito:

1. Equità

L’equità nell’intelligenza artificiale è un principio fondamentale che affronta i pregiudizi nei sistemi di intelligenza artificiale. Possono verificarsi distorsioni durante la creazione dell'algoritmo o a causa di dati di addestramento travisati. I data scientist utilizzano tecniche come l’analisi dei dati per rilevare e correggere i bias, garantendo che i sistemi di intelligenza artificiale prendano decisioni imparziali e promuovano risultati equi.

2. Trasparenza

La trasparenza nell’intelligenza artificiale implica la documentazione e la spiegazione delle fasi adottate nel suo sviluppo e implementazione, rendendola comprensibile alle parti interessate. Tecniche come l’apprendimento automatico interpretabile rivelano la logica alla base delle decisioni legate all’intelligenza artificiale, mentre la supervisione umana garantisce l’allineamento etico e la giustificabilità.

3. Responsabilità

La responsabilità è strettamente legata alla trasparenza e comprende la creazione di meccanismi per ritenere gli sviluppatori e gli utenti dell’IA responsabili dei risultati e degli impatti dei sistemi di intelligenza artificiale. Ciò comporta l’implementazione di linee guida etiche, l’uso di strumenti di monitoraggio e l’audit condotto. Queste misure garantiscono che i sistemi di intelligenza artificiale forniscano i risultati desiderati, prevengano danni involontari e mantengano l’affidabilità.

4. Privacy

La privacy è fondamentale per salvaguardare le informazioni personali degli individui. L’ecosistema AI prevede l’ottenimento del consenso per la raccolta dei dati, la raccolta solo dei dati necessari e il loro utilizzo esclusivamente per gli scopi previsti. Tecniche di preservazione della privacy come la privacy differenziale e le tecniche crittografiche vengono impiegate per proteggere i dati personali durante lo sviluppo e la produzione del modello di intelligenza artificiale.

5. Sicurezza

Gli sviluppatori devono dare priorità alla sicurezza nell’IA responsabile, compreso il benessere fisico e non fisico. Per raggiungere questo obiettivo, le considerazioni sulla sicurezza dovrebbero essere integrate in ogni fase dello sviluppo del sistema di IA. Nella fase di progettazione, è fondamentale coinvolgere le diverse parti interessate per identificare e comprendere i potenziali rischi. Le valutazioni del rischio, i test in condizioni diverse, la supervisione umana e il monitoraggio e il miglioramento continui durante la produzione sono essenziali per prevenire danni e mantenere l’affidabilità dei sistemi di intelligenza artificiale.

Dopo aver esaminato i molteplici principi dell’intelligenza artificiale responsabile, andiamo avanti e comprendiamo le sfide associate all’adozione della soluzione.

Quali sono le sfide nell’adozione di soluzioni di IA responsabile?

L’adozione dell’intelligenza artificiale responsabile è un viaggio promettente con grandi ricompense per le aziende, ma le sue sfide critiche richiedono un’attenta considerazione e soluzioni proattive. Vediamoli nel dettaglio di seguito:

Spiegabilità e trasparenza

I sistemi di intelligenza artificiale devono essere in grado di chiarire come e perché producono risultati specifici per mantenere la fiducia. Una mancanza di trasparenza può ridurre la fiducia in questi sistemi.

Sicurezza personale e pubblica

I sistemi autonomi come le auto e i robot a guida autonoma possono causare rischi per la sicurezza umana. Garantire il benessere umano in tali contesti è fondamentale.

Automazione e controllo umano

Sebbene l’intelligenza artificiale possa migliorare la produttività, può ridurre il coinvolgimento e le competenze umane. Trovare un equilibrio per garantire il controllo e la supervisione umana è una sfida.

Pregiudizi e discriminazioni

Anche se i sistemi di intelligenza artificiale sono progettati per essere neutrali, possono comunque ereditare pregiudizi dai dati di addestramento, portando potenzialmente a discriminazioni involontarie. Prevenire tali pregiudizi è vitale.

Responsabilità e regolamentazione

Con la crescita della presenza complessiva dell'intelligenza artificiale, possono sorgere questioni di responsabilità. Determinare chi è responsabile dell’utilizzo e dell’abuso del sistema di intelligenza artificiale è complesso.

Sicurezza e privacy

L’intelligenza artificiale richiede un ampio accesso ai dati che può sollevare ulteriormente preoccupazioni sulla privacy dei dati e sulle violazioni della sicurezza. La salvaguardia dei dati utilizzati per la formazione sull’intelligenza artificiale è essenziale per proteggere la privacy complessiva di un individuo.

Ora, la collaborazione con un’azienda rispettabile di sviluppo di app IA (come Appinventiv) che aderisce ai principi dell’IA responsabile durante il processo di sviluppo può aiutare le aziende a mitigare efficacemente le sfide e i rischi associati.

I vantaggi dell’intelligenza artificiale responsabile per le imprese

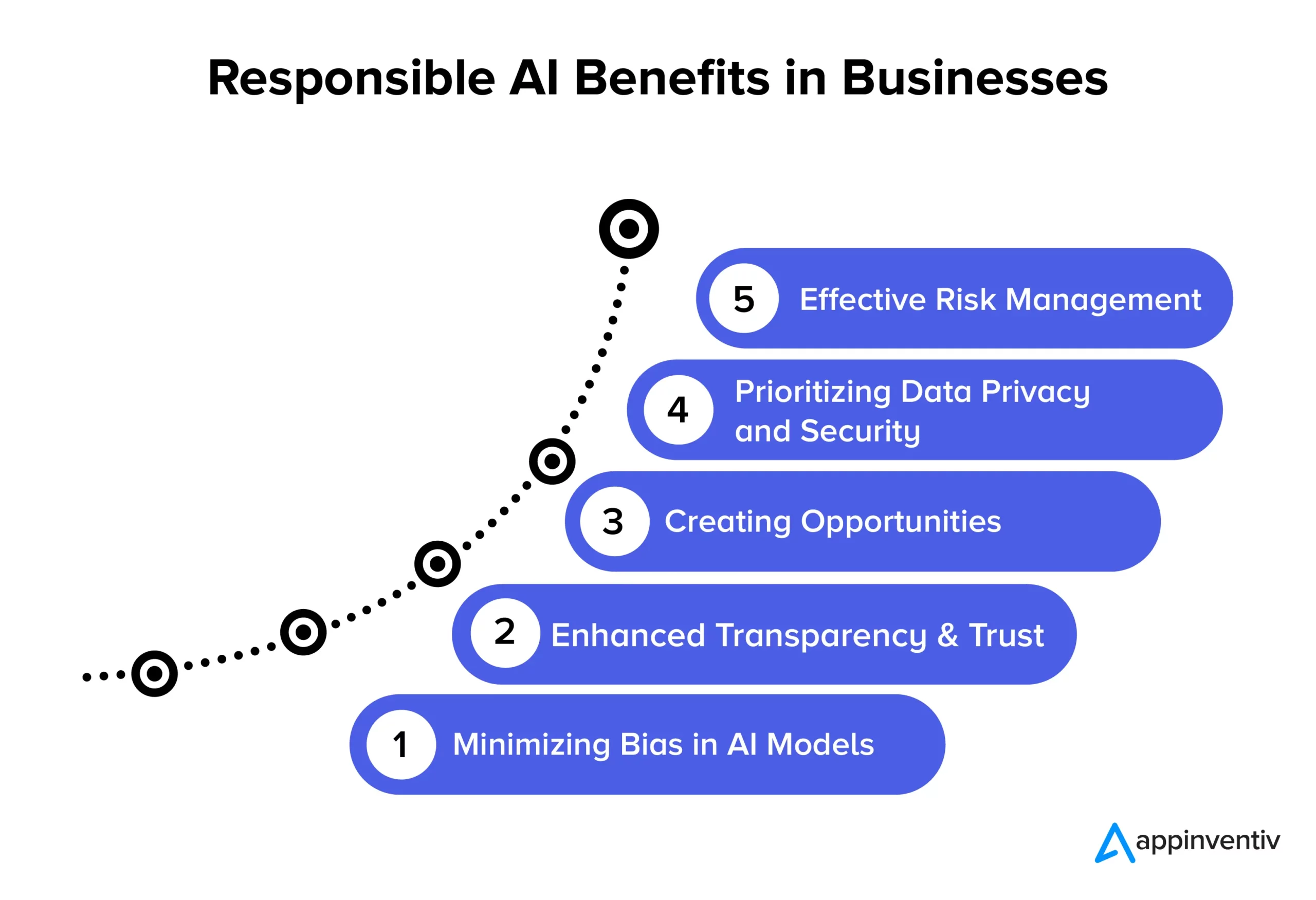

L’adozione dei principi dell’IA responsabile apre la strada a molteplici vantaggi significativi per le imprese e la società. Esploriamoli nel dettaglio di seguito:

Minimizzare i bias nei modelli di intelligenza artificiale

Aderendo ai principi dell’intelligenza artificiale responsabile, le aziende possono ridurre efficacemente i pregiudizi nei loro modelli di intelligenza artificiale e nei dati sottostanti utilizzati per formarli. Questa riduzione dei bias garantisce che i sistemi di intelligenza artificiale forniscano risultati più accurati ed equi, che siano eticamente corretti e riducano il rischio di modifiche dei dati nel tempo. Inoltre, ridurre al minimo i bias aiuta le organizzazioni a evitare potenziali danni agli utenti che potrebbero derivare da risultati distorti del modello di intelligenza artificiale, migliorando la loro reputazione e riducendo la responsabilità.

Maggiore trasparenza e fiducia

Le pratiche di intelligenza artificiale responsabile migliorano la chiarezza e la trasparenza dei modelli di intelligenza artificiale. Ciò aiuta a rafforzare la fiducia tra le imprese e i loro clienti. Inoltre, l’intelligenza artificiale diventa più disponibile e comprensibile per un pubblico più ampio, avvantaggiando le organizzazioni e gli utenti finali consentendo una gamma più ampia di applicazioni e migliorando l’utilizzo efficace delle tecnologie di intelligenza artificiale.

Creare opportunità

L’adesione ai principi dell’intelligenza artificiale responsabile consente agli sviluppatori e agli utenti di avere conversazioni aperte sui sistemi di intelligenza artificiale. È uno dei vantaggi dell’intelligenza artificiale responsabile più ricercati nelle aziende. Crea uno spazio in cui le persone possono esprimere le proprie domande e preoccupazioni sulla tecnologia AI, consentendo alle aziende di affrontare questi problemi in modo proattivo. Questo approccio collaborativo allo sviluppo dell’intelligenza artificiale si traduce nella creazione di soluzioni di intelligenza artificiale eticamente valide e socialmente responsabili, che possono rafforzare la reputazione e la competitività di un’azienda.

Dare priorità alla privacy e alla sicurezza dei dati

Le soluzioni di intelligenza artificiale responsabile consentono alle aziende di concentrarsi in modo significativo sulla protezione della privacy e della sicurezza dei dati. Ciò significa che i dati personali o sensibili sono gestiti con cura, salvaguardando i diritti delle persone e prevenendo violazioni dei dati. Quando le aziende seguono i principi dell’intelligenza artificiale responsabile, riducono le possibilità di utilizzare in modo improprio i dati, violare le normative e danneggiare la propria reputazione. È un modo intelligente per mantenere i dati al sicuro e mantenere la fiducia dei clienti.

Gestione efficace del rischio

Le pratiche responsabili di intelligenza artificiale stabiliscono chiare regole etiche e legali per i sistemi di intelligenza artificiale, il che aiuta a ridurre le possibilità di esiti dannosi. Questa riduzione del rischio avvantaggia molteplici entità, come aziende, dipendenti e società. Le organizzazioni possono evitare cause legali costose e danneggiare la propria reputazione quando affrontano possibili problemi etici e legali.

Esempi di implementazione di successo dell’IA responsabile

Ecco alcuni esempi reali degni di nota di organizzazioni che stanno dando priorità a pratiche di intelligenza artificiale etiche e imparziali:

L'affidabile strumento di reclutamento basato sull'intelligenza artificiale di IBM

Un’importante azienda statunitense ha collaborato con IBM per automatizzare i processi di assunzione e dare priorità all’equità nei processi di reclutamento basati sull’intelligenza artificiale. Il loro obiettivo era facilitare la diversità e l’inclusione mantenendo intatta l’integrità dei loro modelli di apprendimento automatico. Utilizzando IBM Watson Studio, uno strumento di monitoraggio e gestione dell'intelligenza artificiale, hanno identificato e affrontato con successo i pregiudizi in materia di assunzioni, ottenendo al contempo preziose informazioni sul processo decisionale dell'intelligenza artificiale.

Il quadro di intelligenza artificiale responsabile di State Farm

State Farm, una delle principali compagnie assicurative negli Stati Uniti, ha incorporato l’intelligenza artificiale nel suo processo di gestione dei sinistri e ha implementato una strategia di intelligenza artificiale responsabile. Hanno creato un sistema di governance per assegnare la responsabilità dell’intelligenza artificiale, con il risultato di un processo decisionale più rapido e informato. Il modello AI DVAM (Dynamic Vehicle Assessment Model) di State Farm prevede in modo efficace le perdite totali e garantisce trasparenza nell'elaborazione delle richieste di indennizzo assicurativo.

Team di intelligenza artificiale responsabile e lista di controllo del gruppo H&M

H&M Group, un rivenditore di moda globale, ha integrato l'intelligenza artificiale nelle sue operazioni per promuovere la sostenibilità, ottimizzare le catene di fornitura e migliorare le esperienze personalizzate dei clienti. Nel 2018 l’azienda ha istituito un team dedicato all’intelligenza artificiale responsabile per garantire un utilizzo responsabile dell’intelligenza artificiale. Questo team ha sviluppato una lista di controllo pratica che identifica e mitiga i potenziali danni legati all’intelligenza artificiale e aderisce pienamente ai principi dell’intelligenza artificiale responsabile.

L'equità di Google nel machine learning

Google ha anche lavorato attivamente per includere misure di equità nell’intelligenza artificiale e nell’apprendimento automatico. Hanno sviluppato strumenti e risorse per aiutare gli sviluppatori a identificare e mitigare i pregiudizi nei loro modelli di apprendimento automatico.

GPT-3 di OpenAI

OpenAI, l’azienda dietro GPT-3, è stata anche un leader chiave nell’adottare un approccio responsabile all’implementazione dell’IA. Hanno implementato meccanismi di messa a punto per evitare risultati dannosi e distorti che dimostrano ulteriormente il loro impegno verso un’intelligenza artificiale etica, anche nei modelli avanzati di PNL.

Il futuro dell'intelligenza artificiale responsabile con Appinventiv

Il futuro dell’intelligenza artificiale responsabile è un viaggio continuo, con le organizzazioni a diversi stadi di sviluppo etico per quanto riguarda la tecnologia e l’utilizzo dei dati. È un campo dinamico focalizzato sulla definizione di linee guida standardizzate per diversi settori. Per orientarsi verso i principi dell'intelligenza artificiale responsabile per la tua azienda, collaborare con Appinventiv è la scelta migliore che un'azienda possa fare. Possiamo aiutarti a creare soluzioni IA etiche, imparziali e accurate su misura per le tue esigenze.

Essendo una società dedicata allo sviluppo dell'intelligenza artificiale, i nostri sviluppatori hanno anni di esperienza nello sviluppo di soluzioni AI, dando priorità all'etica e alla responsabilità. Con una comprovata esperienza di progetti IA di successo in numerosi settori industriali, comprendiamo l’importanza di allineare le soluzioni IA ai valori fondamentali e ai principi etici richiesti. Possiamo aiutarvi a implementare misure di equità per garantire che le vostre soluzioni aziendali basate sull'intelligenza artificiale prendano decisioni imparziali.

Di recente abbiamo sviluppato YouComm, un'app sanitaria basata sull'intelligenza artificiale che mette in contatto i pazienti con gli infermieri ospedalieri tramite gesti delle mani e comandi vocali. La soluzione è ora implementata in oltre 5 catene ospedaliere negli Stati Uniti.

Mettiti in contatto con i nostri esperti di intelligenza artificiale per creare soluzioni di intelligenza artificiale che forniscano risultati accurati e rispettino gli standard etici.

Domande frequenti

D. Quali sono alcuni esempi di IA responsabile?

R. Ecco alcuni esempi di IA responsabile in più ambiti industriali:

- Algoritmi equi: sistemi di intelligenza artificiale progettati per essere equi, riducendo i pregiudizi decisionali.

- Explainable AI (XAI): rendere comprensibili le decisioni sull'intelligenza artificiale.

- Mitigazione dei bias: monitoraggio e riduzione continui dei bias nell'intelligenza artificiale.

- Comitati etici sull’intelligenza artificiale: istituzione di comitati di revisione interni per l’intelligenza artificiale etica.

- IA che preserva la privacy: protezione dei dati sensibili durante l'utilizzo per l'intelligenza artificiale.

- Rapporti sulla trasparenza: condividere il modo in cui funzionano i sistemi di intelligenza artificiale e come prendono decisioni.

- Educazione responsabile all’IA: formazione dei professionisti dell’IA su etica e responsabilità.

D. Quali sono alcuni casi d'uso di successo dell'IA responsabile?

R. Ecco alcuni casi d'uso di successo dell'IA responsabile:

- Diagnostica sanitaria: viene utilizzata per migliorare i risultati medici con equità e privacy del paziente.

- Servizi finanziari: è in grado di eliminare i rischi associati a frodi e malware. Le soluzioni responsabili basate sull’intelligenza artificiale possono salvaguardare ulteriormente i dati dei clienti e garantire prestiti equi.

- Reclutamento: aiuta a ridurre i pregiudizi aprendo la strada all'adozione della diversità e delle pari opportunità tra gli utenti.

- Veicoli autonomi: aiuta a dare priorità alla sicurezza e ad aderire agli standard etici.

D. L’intelligenza artificiale responsabile è un processo continuo oppure le aziende possono implementarla una volta e poi dimenticarsene?

R. L’intelligenza artificiale responsabile è un processo continuo che richiede monitoraggio, aggiornamento e adattamento continui ai mutevoli standard e regolamenti etici. Pertanto, è consigliabile collaborare con una società di sviluppo AI dedicata che possa aiutarti ad attraversare le acque con attenzione.