Il vero costo per costruire il tuo web crawler

Pubblicato: 2023-08-09Il web scraping è diventato il modo più comune per aggregare dati da più fonti e ricavare informazioni vitali da Internet. Questo processo viene utilizzato per abilitare soluzioni basate su dati per qualsiasi cosa, dalla corrispondenza dei prezzi nei siti Web di e-commerce al prendere decisioni nel mercato azionario. Con l'aumento della domanda di scraping di dati dal web, anche gli strumenti e i servizi che possono semplificare lo scraping del web hanno inondato Internet. Tuttavia, tutti questi appartengono a una delle 3 sottocategorie-

- Creazione di uno strumento di web scraping interno utilizzando librerie come BeautifulSoup in Python e distribuzione in un servizio cloud come AWS.

- Utilizzando un software di scraping semiautomatico che può essere utilizzato per afferrare parti dello schermo. Per la configurazione iniziale è necessario un intervento umano, ma le attività ripetute possono essere automatizzate. Tuttavia, il grado di automazione è limitato, il prodotto o il team aziendale potrebbe dover affrontare una ripida curva di apprendimento per utilizzare lo strumento e non tutti i siti Web possono essere raschiati utilizzando questi strumenti. Troverai ulteriori difficoltà nella gestione di siti Web che generano contenuti dinamici utilizzando tecnologie come javascript.

- I fornitori di DaaS come PromptCloud ti forniscono un feed di dati personalizzato basato sui siti Web e sui punti dati che invii come requisiti. Questi servizi di solito ti addebitano in base alla quantità di dati che consumi, quindi la tua fattura mensile si basa solo sulla quantità di dati raccolti e si adatta alle aziende di tutte le dimensioni.

Ora molte aziende potrebbero immaginare che il costo associato ai punti b o c sia troppo alto e decidere di creare un web crawler da soli. Perché no? Basta cercare su Google "Come costruire un web crawler?" ti darebbe centinaia di risultati. Alcuni di essi potrebbero persino funzionare per il tuo caso d'uso. Ma qual è il vero costo della creazione di un web crawler di livello aziendale, della sua distribuzione nel cloud e della sua manutenzione e aggiornamento nel tempo? Scopriamolo.

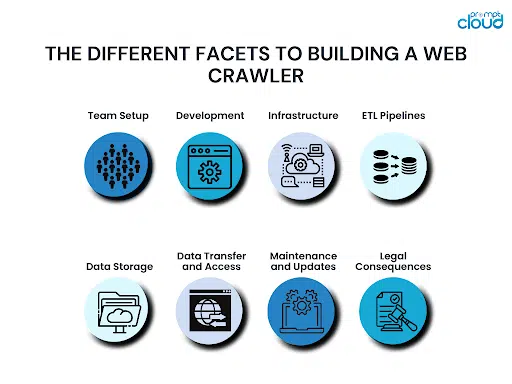

Le diverse sfaccettature della creazione di un web crawler

Quando si crea un web crawler, ci sono vari aspetti da tenere a mente. A meno che tu non tenga conto di tutto ciò, potresti finire per mordere più di quanto puoi masticare. Finirebbe per costarti troppo prima ancora di aver raggiunto il traguardo, e allora saresti bloccato tra continuare o rinunciare.

Configurazione della squadra:

I principali requisiti per la creazione di un web crawler sarebbero la conoscenza della programmazione e la precedente esperienza di aver creato un web crawler. Anche se hai un team tecnico, potresti non avere qualcuno con conoscenze precedenti per guidare il gruppo. Senza qualcuno con esperienza, potresti finire per commettere errori critici e non rendertene conto finché non è troppo tardi.

Sviluppo:

Una volta che il team è pronto, devono dedicarsi allo sviluppo del tuo web crawler. Questo crawler dovrebbe essere in grado di eseguire la scansione di tutti i punti dati richiesti da tutti i siti Web nel tuo elenco. Pertanto, ci vorrà molto tempo non solo per costruire il crawler, ma anche per testare i casi limite e assicurarsi che non si rompa in nessun momento. A seconda delle dimensioni e dell'esperienza del tuo team, la creazione di un nuovo web crawler da zero può richiedere da pochi mesi a qualche trimestre.

Infrastruttura:

Costruire il web crawler perfetto è difficile. Decidere su un'infrastruttura cloud ad alto tempo di attività che sarà anche ottimizzata per i costi è ancora più difficile. La tua infra dovrà anche essere scalabile in modo tale da poter essere scalata man mano che la tua azienda cresce e quando è necessario raccogliere dati da più fonti.

Pipeline ETL:

Raschiare i punti dati di cui hai bisogno dai siti Web di tua scelta potrebbe non essere sufficiente. Di solito, i dati devono anche essere normalizzati, formattati, puliti e ordinati prima di essere archiviati in un supporto di archiviazione. Tutto ciò richiederebbe più potenza di calcolo. Poiché queste pipeline aggiungerebbero un ritardo nel flusso di dati, sarebbe fondamentale ottenere l'infrastruttura corretta per configurare le pipeline ETL sul cloud.

Archivio dati:

Una volta che i tuoi dati sono stati raschiati, puliti e pronti, dovrai metterli in un supporto di archiviazione appropriato. Questo può essere un database SQL o NoSQL. Potrebbe anche essere una soluzione di data warehousing come Redshift. La scelta del database dipende dalla quantità di dati che si desidera archiviare, dalla frequenza con cui si desidera aggiornare o recuperare i dati, se il numero di colonne può cambiare in futuro e altro ancora. Come il resto delle risorse, anche il database deve essere ospitato sul cloud, quindi anche il prezzo deve essere preso in considerazione.

Trasferimento dati e accesso:

Ora che hai raschiato i dati e li hai archiviati in un database, potresti voler recuperarli a determinati intervalli o anche continuamente. Puoi creare API REST per concedere al mondo esterno l'accesso ai tuoi dati. La creazione e la manutenzione del livello di accesso ai dati richiederebbe tempo e ti verrà addebitato un importo in base alla quantità di trasferimento dati che effettui.

Manutenzione e aggiornamenti:

Un web crawler non è mai definitivo. È solo una versione. Una versione più recente deve essere creata non appena qualsiasi sito Web da cui sta raccogliendo dati viene modificato o aggiornato. Anche l'aggiunta di siti Web complessi all'elenco di siti Web da raschiare potrebbe richiedere l'aggiornamento del tuo crawler. Anche la manutenzione e il monitoraggio regolari delle tue risorse cloud sono fondamentali per garantire che gli errori non compaiano nel sistema e che le tue risorse di calcolo cloud siano integre.

Conseguenze legali:

Quando si estraggono dati dal Web, è necessario rispettare determinate leggi del paese. Queste sarebbero le leggi sulla protezione dei dati del paese in cui operi, nonché le leggi dei paesi di cui raccogli i dati. Eventuali errori possono significare cause legali costose. A volte, i pagamenti, gli accordi o le spese legali sono abbastanza buoni da far fallire un'azienda.

La migliore soluzione di web scraping di livello aziendale

Il costo maggiore che paghi per creare la tua soluzione di web scraping non è nemmeno il denaro. È giunto il momento: la tua azienda deve attendere che la soluzione sia attiva e funzionante, che vengano aggiunte nuove fonti e altro ancora. Sarebbe invece una scelta saggia optare per una soluzione DaaS completamente funzionale che fornisca dati puliti e pronti all'uso e opzioni di integrazione facili. Questo è il motivo per cui il nostro team di PromptCloud fornisce ai nostri utenti soluzioni di web scraping completamente gestite ospitate sul cloud.

Puoi iniziare a utilizzare i dati da qualsiasi punto del Web in un processo in soli 3 passaggi in cui ci fornisci un elenco di siti Web e punti dati, convalidi i risultati di un crawler demo e poi passi all'integrazione finale. Essendo una soluzione basata su cloud, ti addebitiamo solo in base alla quantità di dati che consumi, quindi la soluzione è conveniente per le aziende di tutte le dimensioni. L'esecuzione di un calcolo dettagliato ti mostrerà come risparmi effettivamente denaro quando scegli una soluzione DaaS gestita rispetto alla creazione del tuo web crawler.

Per maggiori dettagli, contatta il nostro team di vendita all'indirizzo sales@promptcloud.com