Web Data Scraping nell'era dei Big Data: opportunità e dilemmi etici

Pubblicato: 2024-05-29Web Data Scraping e analisi dei Big Data

Lo scraping dei dati web è emerso come un meccanismo fondamentale per la raccolta di dati online. Questo processo prevede il recupero automatizzato di informazioni dai siti Web, trasformando il Web non strutturato in una ricchezza di dati strutturati pronti per l'analisi.

Fonte immagine: https://www.sas.com/

Allo stesso tempo, l’analisi dei big data si è ritagliata una nicchia nel discernere modelli, tendenze e approfondimenti dagli enormi set di dati accumulati, spesso attraverso lo scraping dei dati web. Man mano che grandi volumi di dati (circa 2,5 quintilioni di byte generati ogni giorno) diventano più accessibili, la sintesi del web data scraping con l’analisi dei big data apre una miriade di possibilità per aziende, ricercatori e policy maker.

Combinando abilmente queste capacità tecnologiche, si posizionano per trarre vantaggio dal processo decisionale guidato dai dati, stimolare le innovazioni dei servizi e modellare iniziative strategiche su misura per i loro obiettivi. Tuttavia, è essenziale riconoscere l'emergere di dilemmi etici derivanti dalla relazione sinergica tra questi strumenti avanzati.

È necessario percorrere con attenzione una linea sottile per quanto riguarda l’equilibrio cruciale tra la massimizzazione del valore dei dati e la tutela dei diritti alla privacy degli individui, garantendo che nessuno dei due aspetti oscuri l’altro.

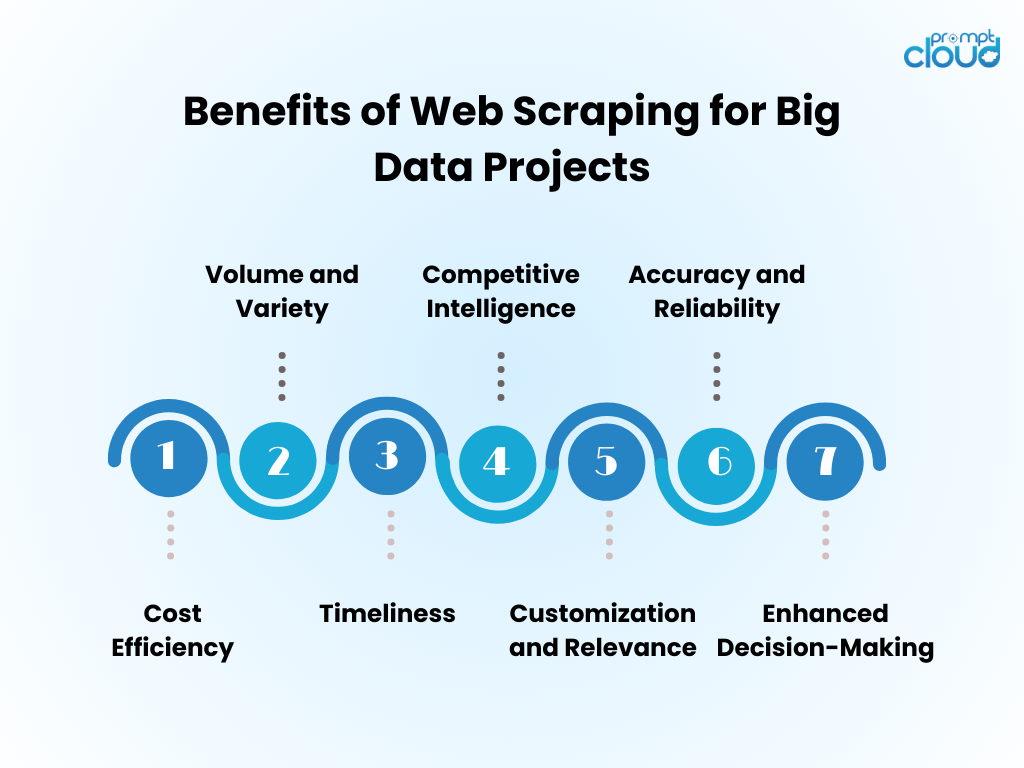

Vantaggi del Web Data Scraping per progetti Big Data

- Efficienza in termini di costi : l'automazione della raccolta dati tramite web scraping riduce significativamente i costi del lavoro umano e accelera i tempi di acquisizione delle informazioni.

- Volume e varietà : consente l'acquisizione di grandi quantità di dati da diverse fonti, fondamentali per alimentare l'analisi dei big data.

- Tempestività : il web scraping fornisce dati in tempo reale o quasi, consentendo risposte più agili alle tendenze del mercato.

- Competitive Intelligence : dà alle organizzazioni la capacità di monitorare da vicino i concorrenti e i cambiamenti del settore.

- Personalizzazione e pertinenza : i dati possono essere adattati a esigenze specifiche, garantendo che l'analisi sia pertinente e mirata.

- Precisione e affidabilità : lo scraping automatizzato riduce al minimo l'errore umano, garantendo set di dati più accurati.

- Processo decisionale migliorato : l'accesso a dati tempestivi e pertinenti supporta il processo decisionale informato e la pianificazione strategica.

Tecniche di Web Scraping: dal base all'avanzato

Fonte immagine: loginworks

Lo scraping dei dati Web si è evoluto con la tecnologia, a partire da tecniche di base che avanzano con la crescita della complessità dei dati.

- Tecniche di base : inizialmente, gli scraper recuperano i dati utilizzando semplici richieste HTTP per ottenere pagine HTML, analizzando il contenuto attraverso librerie come Beautiful Soup in Python. Questi strumenti possono gestire adeguatamente siti Web semplici.

- Tecniche intermedie : per i contenuti dinamici, le tecniche si evolvono per includere strumenti di automazione come Selenium, che può interagire con JavaScript e imitare il comportamento del browser.

- Tecniche avanzate : spostandosi verso lo scraping avanzato, i metodi incorporano browser headless e server proxy per aggirare le misure anti-scraping. L’estrazione dei dati diventa sofisticata con algoritmi di apprendimento automatico, che elaborano il linguaggio naturale e le immagini per recuperare informazioni.

- Considerazioni etiche : indipendentemente dalla complessità della tecnica, persistono dilemmi etici che richiedono un equilibrio tra accesso ai dati e rispetto della privacy e della proprietà.

Incorporazione di dati web-scraped nell'analisi dei Big Data

I dati raccolti dal web, se integrati nell’analisi dei big data, possono rivelare approfondimenti completi sul mercato e tendenze dei consumatori. Gli analisti fondono le informazioni recuperate dal web con i set di dati esistenti, migliorando la profondità e l'ampiezza dei risultati analitici. Questa fusione genera modelli predittivi migliorati, strategie di marketing su misura e profili di consumo raffinati.

- Pulizia dei dati: i dati raschiati richiedono una pulizia meticolosa per garantire l'accuratezza delle analisi.

- Integrazione dei dati: la combinazione di dati raschiati con altre fonti richiede tecniche avanzate di integrazione dei dati.

- Miglioramento dell'analisi: con dati aggiuntivi, gli algoritmi di apprendimento automatico possono rivelare modelli più sfumati.

- Considerazione etica: gli analisti devono garantire che l'utilizzo dei dati web sia conforme agli standard legali ed etici.

Il pool di dati aumentato guida l’innovazione, ma richiede una metodologia rigorosa e un controllo etico.

Migliori pratiche per un web scraping efficiente

- Rispettare i protocolli robots.txt; non raschiare siti che lo impediscono tramite il loro file robots.

- Pianifica le attività di scraping durante le ore non di punta per ridurre al minimo l'impatto sulle prestazioni del server di destinazione.

- Utilizza la memorizzazione nella cache per evitare di ripetere lo scraping dello stesso contenuto, rispettando i dati del sito Web e risparmiando larghezza di banda.

- Implementa un'adeguata gestione degli errori per evitare che il tuo scraper si blocchi ed eviti di inviare troppe richieste in caso di errori.

- Ruota gli user agent e gli indirizzi IP per evitare di essere bloccati, simulando un comportamento di navigazione più naturale.

- Rimani informato sulle pratiche legali ed etiche di web scraping, assicurandoti che le tue attività di scraping non violino i diritti d'autore o le leggi sulla privacy.

- Ottimizza il codice per essere efficiente e ridurre il carico sia sul sistema di scraping che sui siti Web di destinazione.

- Aggiorna regolarmente il codice di scraping per adattarlo a qualsiasi cambiamento nel layout o nella tecnologia del sito web, mantenendo l'efficacia e l'accuratezza del recupero dei dati.

- Archivia i dati raccolti in modo sicuro e gestiscili in conformità con tutte le normative pertinenti sulla protezione dei dati.

Il futuro del Web Scraping nell’era dei Big Data

Con la continua espansione dei Big Data, lo scraping dei dati web è destinato a diventare ancora più parte integrante dell’analisi dei dati e della business intelligence. Il futuro probabilmente vedrà:

- Modelli di machine learning avanzati addestrati con vasti set di dati ottenuti tramite scraping, migliorando la precisione e gli insight.

- Maggiore domanda di raccolta dati in tempo reale, che consente alle aziende di prendere decisioni più rapide e basate sui dati.

- Sviluppo di strumenti di scraping più sofisticati per navigare nelle tecnologie anti-scraping e mantenere pratiche etiche di raccolta dei dati.

- Regolamentazioni e leggi sulla privacy più rigorose che modellano le metodologie di scraping dei dati web, garantendo che i dati vengano raccolti in modo responsabile e con il consenso.

- L’emergere di piattaforme di scraping-as-a-service, che offrono un’estrazione di dati su misura per aziende di tutte le dimensioni.

Con questi progressi, il web scraping continuerà a essere uno strumento fondamentale nel toolkit dei Big Data.

Se lo scraping manuale del Web dovesse sembrare scoraggiante o se fosse necessaria assistenza per districare sfide complesse legate all'ottenimento di dati preziosi, stai certo che PromptCloud è pronto ad aiutarti!

Siamo specializzati nella fornitura di soluzioni complete di web scraping progettate esplicitamente per iniziative di big data, garantendo un'estrazione di dati affidabile e su larga scala.

Affidati a noi per affrontare gli aspetti impegnativi, permettendoti di concentrarti sulla generazione di scelte ben informate utilizzando set di dati solidi e significativi. Mettiti in contatto con noi all'indirizzo sales@promptcloud.com per scoprire come la nostra esperienza può potenziare il tuo piano di gioco per i big data!