AI モデルの崩壊を防ぐ: 合成データセットに固有のリスクに対処する

公開: 2023-10-05人工知能 (AI) は、ストリーミング プラットフォームでパーソナライズされたコンテンツを提案したり、スマートフォンでデジタル アシスタントを有効にしたりすることで、私たちの日常生活を大きく変えました。 現在、これらの進歩は、膨大な量のデータから学習する洗練された AI モデルによって可能になっています。

さまざまなレポートによると、AI によって生成されたコンテンツはインターネット上でますます普及しており、今後数年間でオンライン情報の最大 90% を占める可能性があります。

このような情報の流入により、今日のデータが豊富な世界では、AI がその豊富なデータを窒息させているという特有の課題に直面していると簡単に言えます。

報告書はさらに、この AI が生成した大量のコンテンツが過剰な情報で人々を圧倒し、何が信頼できるもので人間が生成したものかを判断するのを困難にする可能性があることを示唆しています。 さらに、AI が従来人間によって作成されていたコンテンツを作成できるようになってきているため、アート、ジャーナリズム、執筆などのクリエイティブな分野での雇用が失われる可能性についての懸念もあります。

AI システム自体に関しては、「モデル崩壊」のような新たな問題が発生しています。これは、大規模なデータセットでトレーニングされた AI モデルが、創造的な代替案よりも一般的な単語の選択を優先することにより、低品質の出力を生成する問題を指します。 「モデル オートファジー障害」または「ハプスブルク AI」も、他の AI モデルの出力に基づいて過度にトレーニングされた AI システムが望ましくない特徴を示したり、バイアスを持ったりする可能性があるという別の懸念事項です。

これらの課題は、AI によって生成されたコンテンツの品質と信頼性を損なう可能性があり、そのようなシステムへの信頼を破壊し、情報過負荷を悪化させる可能性があります。

私たちのブログは、AI モデルの崩壊防止への取り組みに関連するすべてを理解するのに役立ちます。 生成型 AI 革命が進むにつれて、オンライン情報環境に重大な課題と不確実性が生じます。 それでは、詳細を正面から見ていきましょう。

AI モデルの崩壊を理解する

機械学習における「モデルの崩壊」とは、AI モデルがさまざまな有用な出力を提供できない状況を指します。 代わりに、狭い範囲の反復的または低品質の結果が生成されます。 この問題はさまざまなモデルで発生する可能性がありますが、敵対的生成ネットワーク (GAN) などの複雑なモデルのトレーニング中によく観察されます。 モデルの崩壊は、多様で価値のある出力を生成するモデルの機能を妨げ、全体的なパフォーマンスに影響を与える可能性があります。

モデルの崩壊の例を示してみましょう。 シマウマの絵を作成するという任務を負った AI モデルを代表する非常に熱心な美大生を想像してください。 冒頭、彼らのアートワークは印象的で、明らかにシマウマに似ています。 しかし、彼らの絵は描き続けるうちに徐々にシマウマらしさを失い、クオリティが低下していきます。 これは、機械学習における「モデルの崩壊」に似ています。AI モデルは、私たちの美術学生と同様に、最初はうまく機能しますが、その後、実行するように設計された本質的な特性を維持するのに苦労します。

AI の最近の進歩に従って、研究者は画像やテキストを生成する際に人工または合成データを使用して新しい AI モデルをトレーニングすることに非常に興味を持っています。 しかし、「モデルオートファジー障害」(MAD)と呼ばれる概念は、このプロセスを自己破壊的なループに喩えています。

新しい現実世界のデータを定期的に追加し続けない限り、合成データを使用して作成する AI モデルの品質と多様性は時間の経過とともに悪化する可能性があります。 したがって、AI モデルのパフォーマンスを維持するには、合成データと実際のデータのバランスを取ることが重要です。

このバランスは、学習を続けるモデルの品質と多様性の低下を防ぐために重要です。 AI モデルの崩壊を防ぐために合成データを効果的に使用する方法を見つけることは、生成 AI の進化と合成データの使用に関して継続的な課題です。

The New Yorker によると、ChatGPT が写真を圧縮する JPEG ファイルと同様の、インターネットのコンパクト版であると考えられる場合、ChatGPT の結果に基づいて将来のチャットボットをトレーニングすることは、デジタル的には、同じようにコピーのコピーを繰り返し作成することと同等です。昔な日々。 単純に、反復するたびに画質は必ず悪化します。

したがって、この課題を克服するために、組織は、これらの生成 AI 製品がこのデジタル環境で正確な応答を提供し続けることを保証するために、アプローチを洗練することに重点を置く必要があります。

[こちらもお読みください: 責任ある AI – 指針となる原則と戦略を用いて導入の課題に対処する]

AIモデルの崩壊はどのようにして起こるのか?

モデルの崩壊は、古いモデルによって生成されたデータを使用して新しい AI モデルがトレーニングされるときに発生します。 これらの新しいモデルは、生成されたデータに見られるパターンに依存しています。 モデル崩壊は、生成モデルはすでに学習したパターンを繰り返す傾向があり、これらのパターンから抽出できる情報には限界があるという考えに基づいています。

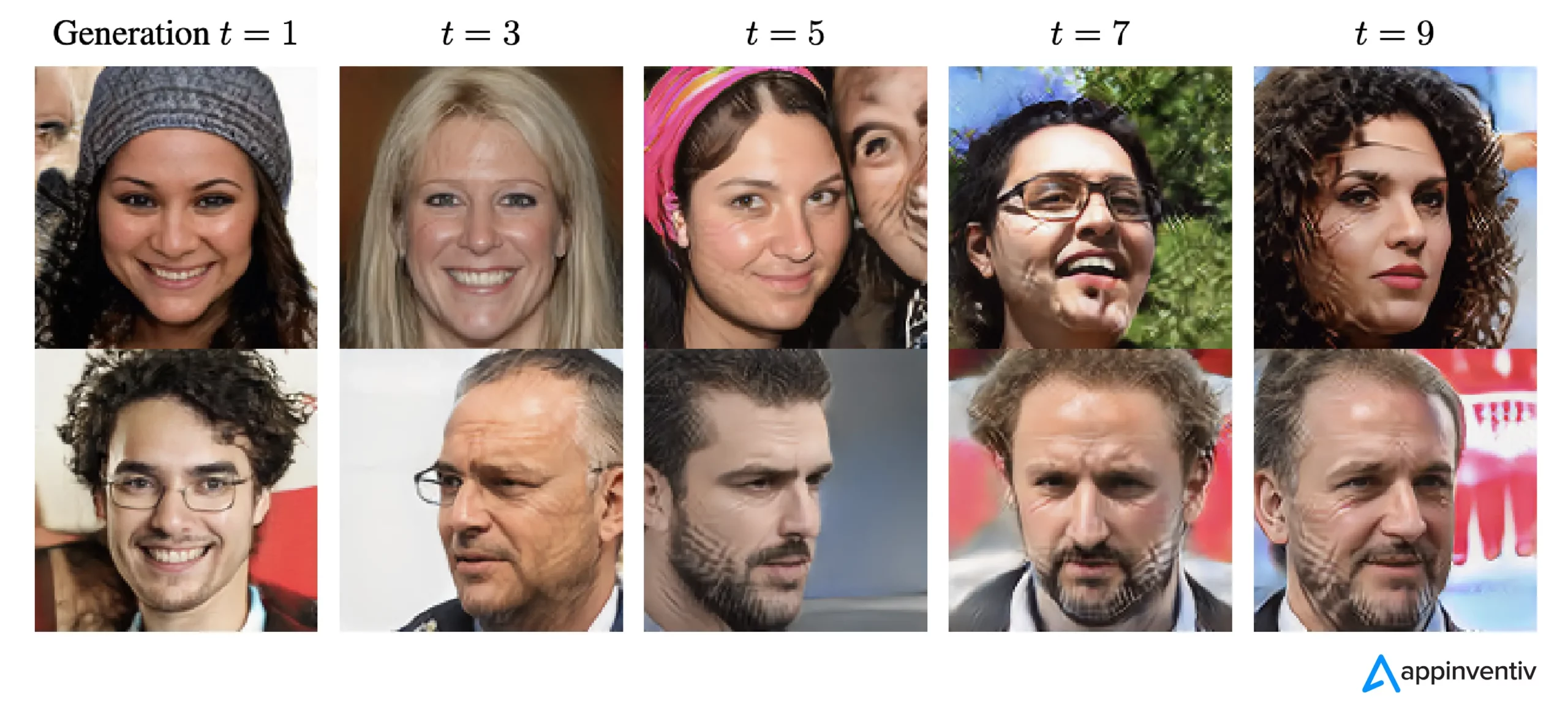

モデルが崩壊した場合、発生する可能性が高いイベントは誇張され、可能性の低いイベントは過小評価されます。 複数の世代にわたって、可能性の高いイベントがデータを支配し、一般的ではないが依然として重要なデータの部分 (テールと呼ばれる) が減少します。 これらのテールは、モデルの出力の精度と多様性を維持するために不可欠です。 世代が進むにつれて、エラーがデータを支配し、モデルはデータをますます誤って解釈します。

研究によると、モデル崩壊には初期と後期の 2 つのタイプがあります。 初期のモデル崩壊では、モデルがまれなイベントに関する情報を失います。 後期モデル崩壊では、モデルがデータ内の明確なパターンをぼやけ、元のデータとほとんど似ていない出力が得られます。

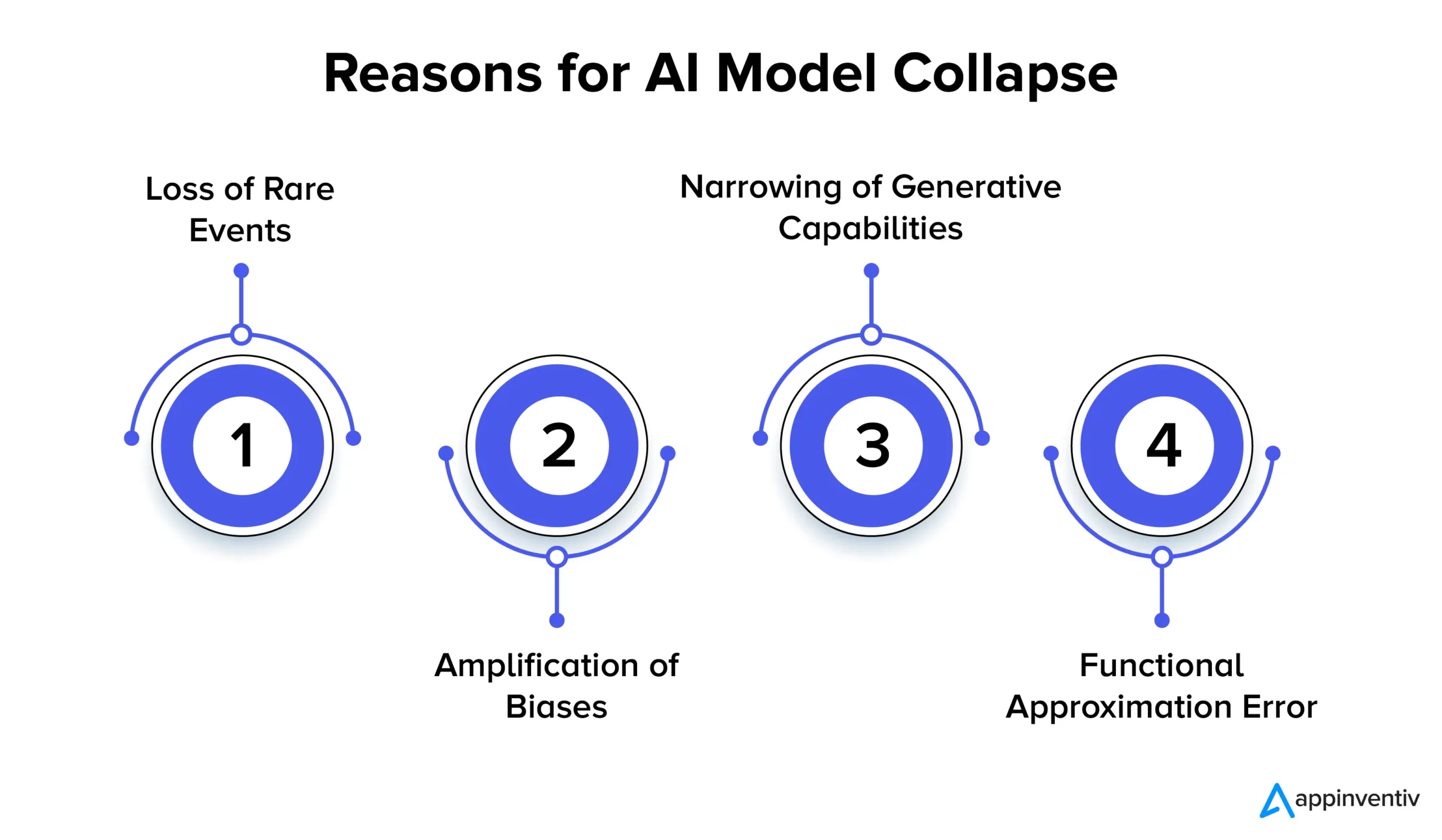

AI モデルが崩壊する複数の理由を以下で詳しく見てみましょう。

レアイベントの喪失

AI モデルが以前のバージョンで生成されたデータに基づいて繰り返しトレーニングされると、AI モデルは一般的なパターンに焦点を当て、まれなイベントを忘れようとします。 この現象は、モデルが長期記憶を失うのと似ています。 まれなイベントは、製造プロセスの異常の特定や不正取引の検出など、多くの場合非常に重要です。 たとえば、不正行為の検出に関しては、特定の言語パターンが不正行為を示す可能性があるため、これらのまれなパターンを保持して学習することが重要になります。

バイアスの増幅

AI が生成したデータに対するトレーニングを繰り返すたびに、トレーニング データ内の既存のバイアスが増幅される可能性があります。 モデルの出力は通常、トレーニングに使用されたデータを反映しているため、そのデータ内のバイアスは時間の経過とともに誇張される可能性があります。 これは、さまざまな AI アプリケーションでバイアスの増幅につながる可能性があります。 たとえば、その結果は、差別、人種的偏見、偏ったソーシャルメディアコンテンツなどの問題につながる可能性があります。 したがって、バイアスを検出して軽減するための制御を実装することは非常に重要です。

生成能力の絞り込み

AI モデルが生成されたデータから学習を続けると、その生成能力が狭まる可能性があります。 モデルはむしろ現実の独自の解釈に影響を受けるようになり、多様性やまれな出来事の表現を欠いた類似したコンテンツをますます生み出します。 そうなるとオリジナリティが失われる可能性があります。 たとえば、大規模言語モデル (LLM) に関しては、バリエーションによって各ライターやアーティストに独自のトーンとスタイルが与えられます。

研究では、トレーニング プロセス中に定期的に新しいデータが追加されないと、将来の AI モデルの精度が低下したり、時間の経過とともに生成される結果の多様性が低下したりする可能性があることが示唆されています。

関数近似誤差

モデルで使用されている関数近似器の表現力が十分でない場合、関数近似エラーが発生する可能性があります。 この誤差は、より表現力豊かなモデルを採用することで軽減できますが、ノイズが発生し、過学習につながる可能性もあります。 このようなエラーを防ぐには、モデルの表現力とノイズ制御の間で適切なバランスを取ることが重要です。

モデル崩壊の影響: AI モデルの安定性がなぜ重要なのか?

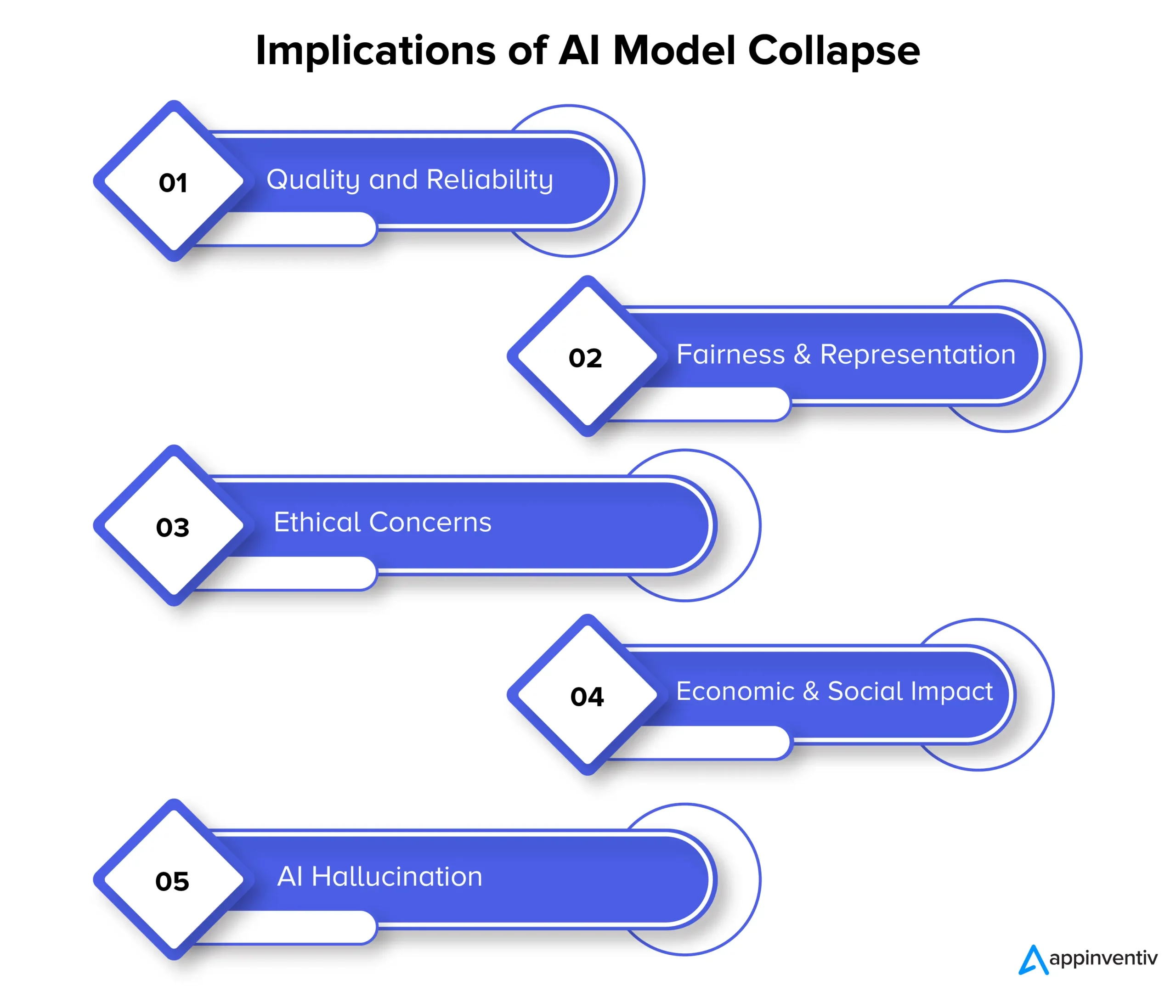

モデルの崩壊は最終的に AI 生成コンテンツの品質、信頼性、公平性に影響を与える可能性があり、組織にさらにいくつかのリスクをもたらす可能性があります。 以下でモデル崩壊の影響を詳しく見てみましょう。

品質と信頼性

AI モデルの学習が劣化すると、生成されるコンテンツの信頼性が低下し、品質が低下します。 これは、モデルが元のデータ分布から切り離され、現実の独自の解釈に依存する場合に発生します。 たとえば、ニュース生成用に設計された AI モデルは、不正確なニュース記事や完全に捏造されたニュース記事を生成する可能性があります。

公平性と表現

モデルの崩壊は、生成されたコンテンツの公平性と表現に関しても懸念の原因となります。 モデルがまれな出来事を忘れて生成能力を制限すると、あまり一般的ではないトピックに関連するコンテンツが不適切に表現される可能性があります。 これは偏見、固定観念、特定の視点の排除につながります。

倫理的懸念

モデルの崩壊は、特に AI によって生成されたコンテンツが意思決定に影響を及ぼす力を持っている場合に、重大な倫理的懸念を引き起こします。 モデルの崩壊の影響には、偏った不正確なコンテンツの拡散が含まれ、人々の生活、意見、機会へのアクセスに大きな影響を与える可能性があります。

経済的および社会的影響

経済的および社会的規模で、モデルの崩壊は AI テクノロジーの信頼と導入に影響を与える可能性があります。 AI によって生成されたコンテンツが信頼できない場合、企業や消費者はこれらのテクノロジーを採用することを躊躇する可能性があります。 これは経済的な影響を与える可能性があり、結果として AI テクノロジーへの信頼が妨げられる可能性があります。

AI幻覚

AI 幻覚とは、AI モデルが事実と一致しない、またはまったく一貫性のない想像的または非現実的なコンテンツを作成することです。 これにより、不正確な情報が得られ、誤った情報や混乱が生じる可能性があります。 ニュースの生成、病状の診断、正確性と信頼性が極めて重要な法的文書の作成などのアプリケーションでは、これは大きな問題となります。

AIの幻覚を例にその背景を説明しましょう。 動物の写真を生成するようにトレーニングされた AI モデルがあるとします。 さて、動物の写真をリクエストすると、モデルはシマウマと馬の雑種である「ゼブロイド」の画像を生成するかもしれません。 この画像は視覚的に現実的に見えるかもしれませんが、現実世界にはそのような動物は存在しないため、これは AI モデルの想像力の創造物にすぎないことを理解することが重要です。

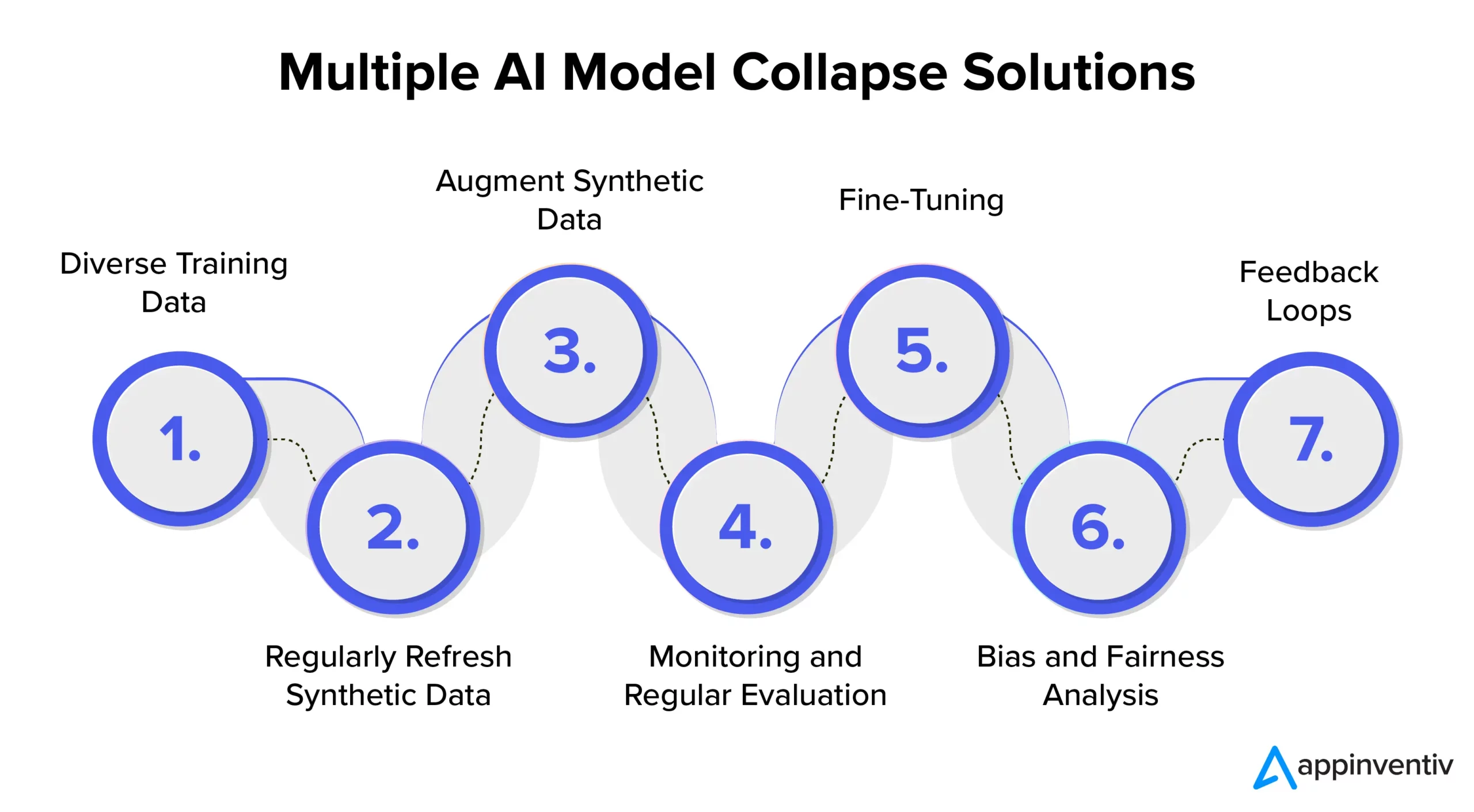

AI モデル崩壊の防止: AI モデル崩壊ソリューションを理解する

AI モデルの安定性と信頼性を確保するには、AI モデルの崩壊防止に効果的に対処するための戦略とベスト プラクティスを検討することが不可欠です。 したがって、AI システムが一貫して高品質の結果を提供できるようにしながら、これらの予防策の実装に関する専門知識とガイダンスを提供できる、Appinventiv のような専門の AI 開発会社と提携することをお勧めします。

多様な学習データ

AI モデルの崩壊に効果的に対処し、望ましくない出力を防止するには、さまざまなデータ ソースとタイプを含むトレーニング データセットを厳選することが重要です。 このデータセットは、モデルによって生成された合成データと、問題の複雑さを正確に表す現実世界のデータの両方で構成されている必要があります。 このデータセットを新しい関連情報で定期的に更新することが重要です。 モデルは、多様なトレーニング データを組み込むことで、幅広いパターンにさらされます。 これはデータの停滞を防ぐのに役立ちます。

合成データを定期的に更新する

AI モデルが独自に生成されたデータに大きく依存している場合、モデルの崩壊はリスクとなります。 AI におけるリスクを効果的に軽減するには、新しい本物の現実世界のデータをトレーニング パイプラインに定期的に導入することが重要です。 これにより、モデルの適応性が維持され、反復ループに陥ることが回避されます。 これは、多様で関連性のある出力を生成するのに役立ちます。

合成データを拡張する

データ拡張技術を通じて合成データを強化することは、モデルの崩壊を防ぐ実証済みの方法です。 これらの手法では、現実世界のデータの自然な変動を使用して、合成データに変動性を導入します。 生成されたデータに制御されたノイズを追加すると、モデルがより広範囲のパターンを学習することが促進され、反復的な出力が生成される可能性が減ります。

モニタリングと定期評価

AI モデルのパフォーマンスを定期的に監視して評価することは、モデルの崩壊を早期に検出するために重要です。 MLOps フレームワークを実装すると、継続的なモニタリングと組織の目標との調整が確保され、タイムリーな介入と調整が可能になります。

[こちらもお読みください: AI 製品の開発中にコンプライアンス違反を回避する方法]

微調整

モデルの安定性を維持し、崩壊を防ぐために、微調整戦略の実装を検討することが重要です。 AI モデルの失敗を防ぐためのこれらの戦略により、モデルは以前の知識を維持しながら新しいデータに適応できます。

バイアスと公平性の分析

モデルの崩壊や倫理的問題を防ぐには、厳密なバイアスと公平性の分析が不可欠です。 モデルの出力のバイアスを特定して対処することが重要です。 これらの懸念事項に積極的に対処することで、信頼性が高く偏りのないモデル出力を維持できます。

フィードバックループ

ユーザーのフィードバックを組み込んだフィードバック ループを実装することは、モデルの崩壊を防ぐために重要です。 ユーザーの洞察を一貫して収集することで、情報に基づいてモデルの出力を調整できます。 この改良プロセスにより、モデルの関連性と信頼性が維持され、ユーザーの期待に沿ったものであることが保証されます。

Appinventiv は AI モデルのリスク軽減にどのように役立ちますか?

AI の進化する状況において、モデルの崩壊によってもたらされる課題は、テクノロジー大手とイノベーターの両方にとって同様の懸念事項となっています。 言語モデル データセットの長期にわたる劣化とコンテンツの操作は、このデジタル エコシステムにその痕跡を残しています。

AI が進歩するにつれて、人工的に生成されたデータと人間が生成したコンテンツを区別することが重要になります。 本物のコンテンツと機械によって生成されたコンテンツとの間の境界線はますます曖昧になってきています。

こうした課題があり、AI モデルの失敗を防ぐ中、Appinventiv のような専用の AI 開発会社と提携することで、切望されていた安心感を得ることができます。 AI モデル開発の専門知識と倫理的な AI 実践への献身的な取り組みにより、当社は、AI システムの信頼性と整合性を確保しながら、AI の複雑さを乗り越えられるよう支援します。

当社の専門家は、お客様と協力して AI モデルの崩壊防止に効果的に取り組み、透明性を促進し、人間が生成したコンテンツの信頼性を損なうことのない本物のコンテンツによる未来を構築できます。

モデルの劣化を防ぐには、新鮮で多様なデータを使用して AI モデルをトレーニングすることが不可欠であることを理解しています。 AI モデルの評価は、メトリクスを使用してパフォーマンスを評価し、弱点を特定し、効果的な将来予測を保証するモデル開発プロセスの極めて重要なステップです。

当社の専門家チームは、お客様の AI システムが学習を継続し、進化するデジタル環境に確実に適応できるよう支援します。 モデルの崩壊に伴うリスクを軽減し、その有効性を確保するには、当社の専門家にご相談ください。

よくある質問

Q.AIモデル崩壊とは何ですか?

A.機械学習における AI モデルの崩壊とは、AI モデルがさまざまな有用な出力を生成できないことを指します。 代わりに、反復的な結果や低品質の結果が生成されます。 この問題はさまざまなタイプのモデルで発生する可能性がありますが、特に敵対的生成ネットワーク (GAN) のような複雑なモデルのトレーニング中に観察されます。

Q. AI モデルの崩壊の一般的な原因は何ですか?

A. AI モデルの崩壊の一般的な原因には、まれなイベントの喪失、バイアスの増幅、生成機能の狭小化、関数近似エラーなどが含まれます。これらの要因により、モデルが次善の出力を生成する可能性があります。

Q. AI モデルの崩壊を防ぐにはどうすればよいですか?

A. AI モデルの崩壊を効果的に防止するには、現実世界に似た異なるトレーニング データを使用し、データを継続的に監視および評価し、バイアスを修正し、厳格なテストと品質管理を実装することが不可欠です。 Appinventiv の AI 専門家と提携することで、モデル崩壊のリスクを軽減するための貴重な洞察とソリューションを提供できます。