コードの下に: AI の根本的なリスクとその対策の詳細を分析する

公開: 2023-09-25組織は、プロセスを強化して競争力を高めるために、AI の世界に急速に飛び込んでいます。 ただし、彼らの AI の旅は常に晴れや虹のようなものではなく、特定のリスクや課題を伴う可能性があることを理解することが重要です。 AI テクノロジーは前例のないスピードで急速に進化するため、組織はグローバルに適応する準備を整える必要があります。 この厳しいデジタル エコシステムで成功するには、潜在的な落とし穴を理解し、AI マルチバースをナビゲートするためのベスト プラクティスを採用することが重要です。

人工知能が進歩し続けるにつれて、その潜在的な危険性についての懸念が高まっています。 機械学習とニューラルネットワークにおける賞賛に値する業績で知られる「AIのゴッドファーザー」ジェフリー・ヒントン氏は、AIシステムは前例のないペースで進歩しており、適切な監督の下で扱われなければ制御を奪われる危険性があると警告した。 同氏はさらに、これらの関連問題に積極的に対処することが極めて重要であると強調した。

別の例では、イーロン・マスク氏も大規模なAI実験の一時停止を支持している。 AI の潜在的なリスクに対する世界のリーダーたちのこうした懸念は、テクノロジー コミュニティが AI 機能の進歩に伴って生じる可能性のある影響や倫理的課題を慎重に検討する必要があることを反映しています。

現在、世界の進歩に伴い、生成 AI が広く普及する傾向にあります。 大きな力には無条件の責任が伴うことが多いため、生成 AI の実装にはある程度の倫理的リスクも伴います。

したがって、ビジネスオーナーとして、AI が大きなメリットをもたらす可能性があることを理解する時期が来ていますが、日常業務に新しいテクノロジを導入する際には、よくある課題もいくつか発生します。

組織は、正確さ、安全性、誠実さ、権限付与、持続可能性を確保することにより、責任ある使用を優先する必要があります。 特定の課題やリスクに直面した場合、他のテクノロジーをうまく導入するのに効果的であることが実証された、実証済みのベスト プラクティスに頼ることができます。 これらの戦略は、AI をビジネス運営に統合し、途中で AI リスクを軽減するための強固な基盤として機能します。

このブログは、ビジネスにおける AI のリスクとその軽減方法に関連するすべてを理解するのに役立ちます。 それでは、さっそく詳細を見ていきましょう。

AI リスクを理解する

米国国立標準技術研究所 (NIST) が発表した人工知能リスク管理フレームワークである AI RMF 1.0 によると、AI リスクには、AI システムの開発と導入から生じる個人、組織、またはシステムへの潜在的な損害が含まれます。 これらのリスクは、AI のトレーニングに使用されるデータ、AI アルゴリズム、複数の目的での使用、人々との相互作用など、さまざまな要因から生じる可能性があります。 AI のリスクと制御の例は、偏った採用ツールから市場の暴落を引き起こすアルゴリズムまで多岐にわたります。

データと個人の安全性とセキュリティを確保するには、AI ベースの製品とサービスを積極的に監視することが重要です。 したがって、組織は、これらのリスクを効果的にトリアージ、検証、軽減するのに役立つリスク管理ソリューションを採用すると信じています。

AI のリスクとビジネスの課題を特定する

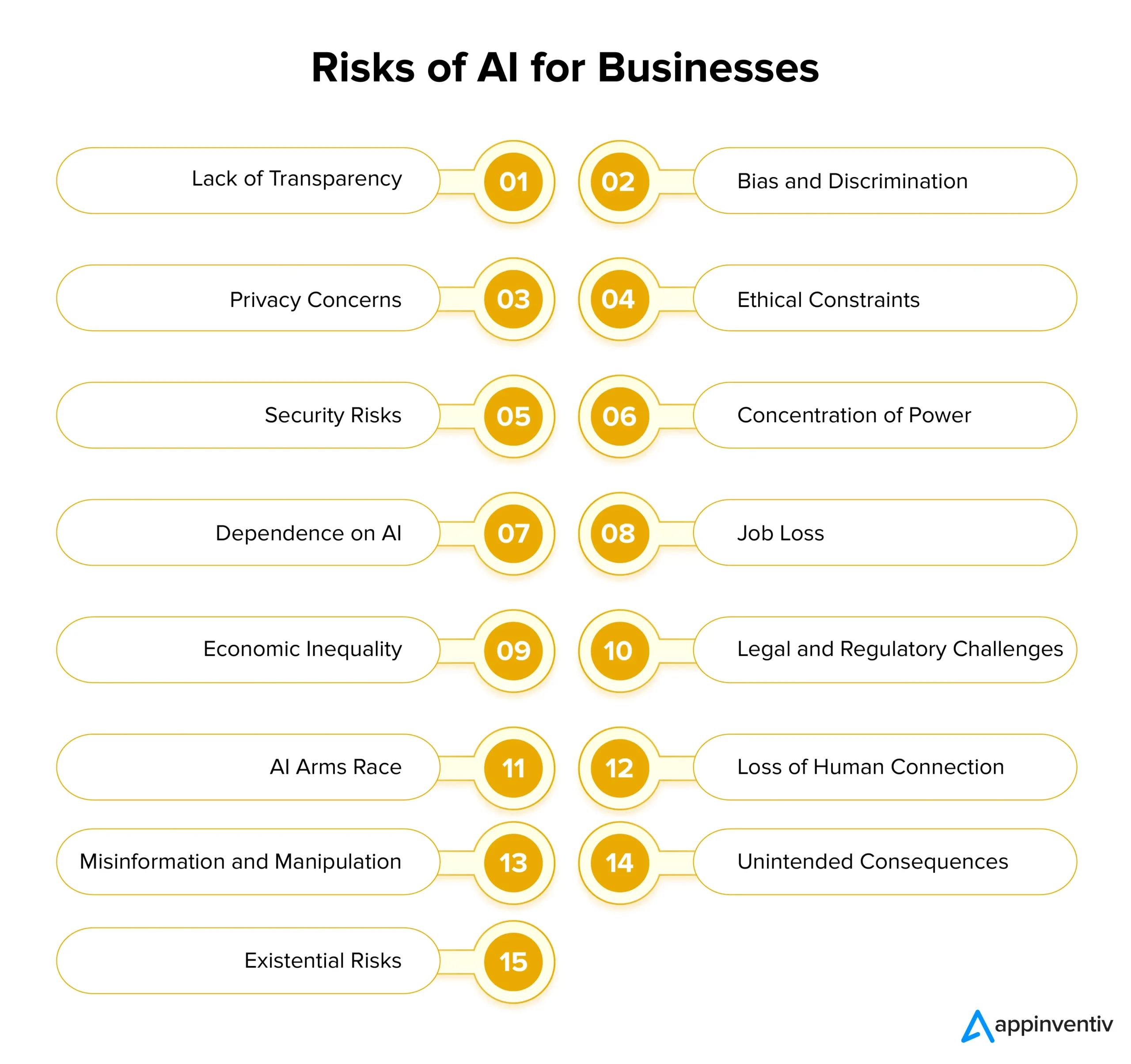

AI は企業に計り知れない可能性をもたらしますが、その導入には重大なリスクも伴います。 責任を持って AI を導入するには、これらの課題を理解し、適切なタイミングで対処することが重要です。 以下で、企業における AI のリスクとソリューションを詳しく見てみましょう。

透明性の欠如

AI システムは多くの場合非透過的に動作するため、AI システムがいくつかの決定をどのように行うかを理解することが困難になります。 この透明性の欠如は、ユーザーや関係者間の不信感につながる可能性があります。 これに対処するために、企業は意思決定プロセスへの洞察を提供する AI モデルとアルゴリズムを設計することで、透明性を優先する必要があります。

これは、明確なドキュメント、説明可能な AI テクニック、AI 主導の結果を視覚化するツールを使用することで簡単に促進できます。 透明性のある AI が当事者間の全体的な信頼を強化し、その意思決定を強化し、規制遵守を支援することを理解することが重要です。

偏見と差別

AI システムには、トレーニング データに含まれる社会的偏見を簡単に維持できる可能性があります。 これは、特定のグループに対する偏った意思決定、差別、不公平な扱いにつながる可能性があります。 AI のこうしたリスクに対処するには、組織は分析可能な多様で代表的なトレーニング データへの投資を優先する必要があります。

さらに、バイアスの検出および修正アルゴリズムを実装し、AI モデルの定期的な監査を実施することは、既存のシステムからバイアスを特定して除去するのに役立ちます。 倫理的な AI 開発では、中核原則として公平性と公平性を優先する必要があります。

プライバシーの問題

AI の最大のリスクと課題の 1 つはプライバシーへの脅威です。 AI では多くの場合、膨大な個人データの収集と分析が必要となり、プライバシーとセキュリティの懸念が生じます。 企業は、厳格なプライバシー規制を遵守し、堅牢なサイバーセキュリティ対策を導入し、データ暗号化技術を採用することにより、データ保護を優先する必要があります。 これは、ユーザーのプライバシーを保護し、信頼を維持するのに役立ちます。

倫理的制約

重要な意思決定に関与する AI システムは、社会にさらに悪影響を与える可能性がある倫理的ジレンマに直面することがよくあります。 組織は、このリスクに対処するために、AI の開発と導入に関する倫理ガイドラインと原則を確立する必要があります。 倫理的配慮は AI プロジェクトの中核要素の 1 つであり、AI が社会的価値観や倫理規範と確実に一致するようにする必要があります。

セキュリティリスク

AI テクノロジーが進歩するにつれて、セキュリティ リスクも増大します。 悪意のある活動によって AI システムが悪用され、より危険なサイバー攻撃が引き起こされる可能性があり、企業に重大な脅威をもたらす可能性があります。 組織は、セキュリティ リスクを軽減するために、暗号化、認証プロトコル、AI 主導の脅威検出システムなどの堅牢なセキュリティ対策を実装する必要があります。 AI システムの展開を保護するには、継続的な監視と定期的な脆弱性チェックが重要です。

力の集中

ほんの少数の大企業と政府が AI 開発を管理すると、物事が不公平になり、AI の利用の多様性が減少する可能性があります。 これを防ぐために、企業は AI 開発を複数のグループ間でより広範に共有するよう取り組む必要があります。 彼らは小規模なスタートアップをサポートし、新しいアイデアを奨励し、オープンソース AI プロジェクトを支援することでこれを実現できます。 このようにして、AI は誰にとってもよりアクセスしやすくなります。

AIへの依存

AI システムに過度に依存すると、創造性、批判的思考、人間の直観が失われる可能性があります。 AI による意思決定と人間の判断のバランスを取ることが重要です。 たとえば、研究者らは「モデルの崩壊」の問題を強調しています。合成データでトレーニングされた生成 AI モデルは、創造的な代替案よりも一般的な単語の選択を単に優先するため、低品質の結果が生成される可能性があります。

企業は、AI の潜在的なリスクを回避するために、AI と協力して働くように従業員を訓練する必要があります。 継続的な学習を奨励することで、組織は人間のスキルを維持しながら、同時に AI の可能性を活用することができます。 これに加えて、多様なトレーニング データと正則化手法の使用も、モデルの崩壊に関連するこれらの課題を軽減するのに役立ちます。

失業

AI 主導の自動化は、さまざまな業界で雇用を奪う可能性があり、最も熟練度の低い労働者が最もターゲットとなります。 組織は、従業員が新しい対策を学び、テクノロジーの進歩とともに成長する機会を提供することで、この課題に積極的に対処する必要があります。 複数のセクターにわたる雇用の喪失に関する懸念を軽減するには、生涯学習と適応力の促進が不可欠です。

経済的不平等

経済的不平等も、企業が認識する必要がある AI の注目すべきリスクと課題の 1 つです。 AIは富裕層や大企業に利益をもたらすことが多いため、経済格差を悪化させる可能性があります。 AIをより公平にするために、政策立案者や企業は、より多くの人をAI開発に参加させる方法を考える必要がある。 彼らは、より多くの人が AI ツールを使用できるようにするプログラムを作成することでこれを実現できます。

法的および規制上の課題

AI は、責任や知的財産権の問題など、新たな法的および規制上の複雑さをもたらします。 法的枠組みは、技術の進歩と並行して実行できるように進化する必要があります。 組織は AI 関連の規制に関する情報を常に入手し、政策立案者と積極的に連携して、責任ある AI ガバナンスと実践を形成する必要があります。 企業はリスクおよびコンプライアンスのソリューションに AI を使用して、潜在的なコンプライアンス関連のリスクを特定しながら、膨大な量の情報とデータを簡単に分析できます。

[こちらもお読みください: AI 製品の開発中にコンプライアンス違反を回避する方法]

AI 軍拡競争

各国が AI 軍拡競争に突入すると、AI テクノロジーの発展が早すぎて危険になる可能性があります。 こうした AI のリスクを防ぐには、責任ある AI 開発を奨励することが重要です。 各国は協力し、AIを防衛にどのように活用できるかについて合意を形成すべきだ。 こうすることで、他国よりも進んだテクノロジーを求める競争において、AI が害を及ぼすリスクを減らすことができます。

人間関係の喪失

AI 主導のコミュニケーションや交流への依存が高まると、共感力、社交スキル、人間関係の低下につながる可能性があります。 組織は人間中心の設計を優先し、AI の統合に加えて有意義な人間の対話を維持することの重要性を強調する必要があります。

誤った情報と操作

ディープフェイクのような AI 生成コンテンツは、誤った情報の拡散や世論操作に寄与するため、重大なリスクをもたらします。 誤った情報や国民の意識向上キャンペーンを検出するための AI 主導のツールを導入すると、急速に進化するデジタル時代において情報の完全性を維持するのに役立ちます。

意図しない結果

AI システムはその複雑さにより、予期しない動作を示したり、予期しない結果を伴う決定を下したりする可能性があります。 これらの問題がエスカレートして害を及ぼす前に特定して対処するには、厳格なテスト、検証、継続的な監視プロセスが不可欠です。

実存的リスク

人間よりも賢い汎用人工知能 (AGI) を作成するには、大きな懸念が生じます。 組織は、恐ろしい結果を避けるために、AGI がその価値観と目標を共有していることを確認する必要があります。 これには、慎重な長期計画、強力な倫理規則、そして AGI に伴う大きなリスクに対処するために世界中で協力する必要があります。

AI テクノロジーによって課せられる複数の課題とリスク、および特定の AI リスク管理をどのように実行できるかを検討した後、次に進んで AI ガバナンスについて詳しく見てみましょう。

リスク管理のための AI ガバナンス

効果的な AI ガバナンスには、次の 3 つの主要なアプローチを通じて AI のリスクを特定し、管理することが含まれます。

原則: AI システムの開発とその使用を促進するガイドラインが含まれます。 これらは多くの場合、法的基準や社会規範と一致しています。

プロセス:設計上の欠陥や不適切なガバナンス構造から生じるリスクや潜在的な損害に対処します。

倫理的意識:このアプローチは、何が正しくて良いのかという感覚によって動かされます。 それには、ルールに従うこと、物事が正しく行われることを確認すること、自分の評判について考えること、社会的責任を果たすこと、組織の価値観や信念と一致することが含まれます。

AI リスクの軽減: 人工知能で安全を保つ方法

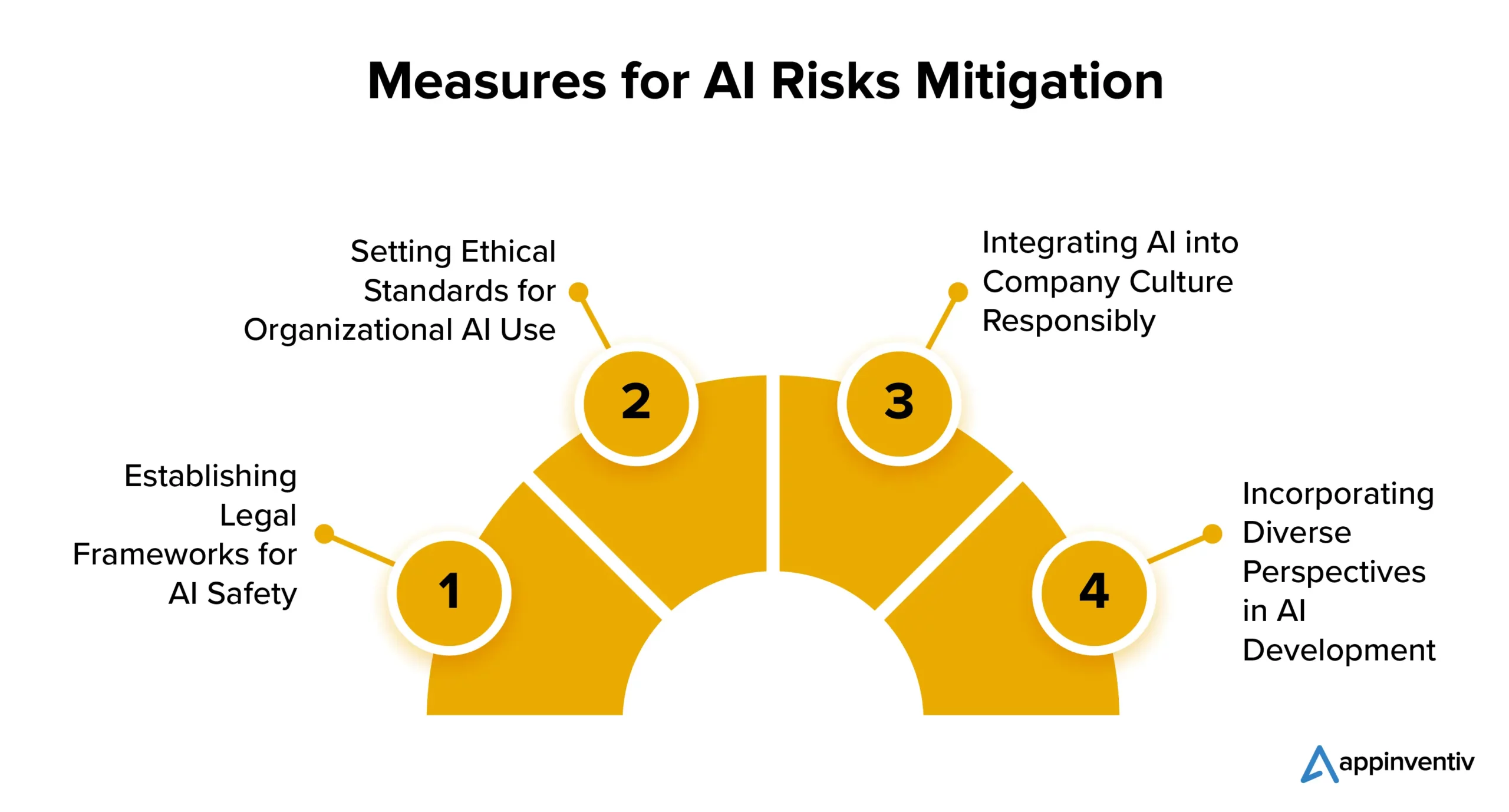

AI 導入のリスクを軽減するために企業が実行できる戦略をいくつか紹介します。

AIの安全性のための法的枠組みの確立

多くの国がAI規制に注目しています。 米国と欧州連合は、AI の普及と使用を制御するための明確なルールの策定に取り組んでいます。 一部の AI テクノロジーは制限に直面する可能性がありますが、企業が利益を得るために AI の可能性を探求することを妨げるものではありません。

組織における AI 使用の倫理基準の設定

規制とイノベーションのバランスをとることが重要です。 AI は進歩に不可欠であるため、組織は倫理的な AI の開発と使用に関する基準を設定する必要があります。 これには、監視アルゴリズムの実装、高品質のデータの使用、AI の決定に関する透明性が含まれる必要があります。

AIを責任を持って企業文化に統合する

AI リスクを軽減するために求められている戦略の 1 つに、企業文化そのものに AI を導入することが含まれます。 企業は、許容可能な AI テクノロジーとプロセスのガイドラインを確立することで、AI を自社の文化に統合できます。 これにより、AI が組織内で倫理的かつ責任を持って使用されるようになり、起こり得る AI リスクが軽減されます。

AI開発に多様な視点を取り入れる

AI 開発者は、法律、哲学、社会学などのさまざまな背景や分野の人々を含む、多様な視点を考慮する必要があります。 この包括的なアプローチは、すべての人に利益をもたらす責任ある AI の作成に役立ちます。

Appinventiv は AI 開発のベスト プラクティスの確保にどのように貢献できるか

AI の導入が増え続けているにもかかわらず、効果的なリスク管理は依然として遅れています。 課題は、多くの場合、企業が介入の必要性や持続可能な AI 開発実践の必要性を認識していないことにあります。

MIT Sloan Management Review と Boston Consulting Group のレポートによると、回答者の 42% が AI を戦略上の最優先事項とみなしている一方で、組織が責任ある AI プログラムを導入していると確認したのは 19% のみでした。 このギャップにより失敗のリスクが高まり、企業は AI の導入によって引き起こされる規制、財務、評判の問題に対して脆弱になります。

AI リスク管理はプロジェクトのどの段階からでも開始できますが、リスク管理フレームワークを早めに確立することが重要です。 これにより信頼が高まり、企業が自信を持って拡張できるようになります。

AI 開発専門会社として、当社のチームは倫理と責任を重視した AI ソリューションの作成に関する長年の専門知識を持っています。 さまざまな業界分野にわたる当社の実績は、AI ソリューションを核となる価値観と倫理原則に適合させるという当社の取り組みを表しています。

当社は、AI ベースのビジネス ソリューションが一貫して公平かつ公平な意思決定を行えるようにするための公平性対策の導入を支援する設備を備えています。

当社は最近、手のジェスチャーと音声コマンドだけで患者が病院スタッフとつながることを可能にする AI ベースのヘルスケア アプリである YouComm を開発しました。 このソリューションは現在、全米の 5 つ以上の病院チェーンに導入されています。

プロジェクトに関連する AI リスク管理とそれらを簡単に軽減する方法を完全に理解するには、当社の専門家に問い合わせてください。

よくある質問

Q. AI のリスクは何ですか?

A. AI には、偏見、プライバシーへの懸念、倫理的ジレンマ、セキュリティの脅威などの固有のリスクが伴います。 また、雇用の喪失、経済的不平等の悪化につながり、法的および規制上の課題を引き起こす可能性もあります。 さらに、超インテリジェント AI の進歩により、人間の価値観と一致するかどうかの実存的な懸念が生じます。 テクノロジーの責任ある有益な使用を保証し、AI に関連するリスクを回避するには、慎重な管理、倫理的配慮、規制措置を導入することが重要です。

Q. AI リスクを軽減するために AI をどのように使用できますか?

A. AI は、バイアスの検出と修正、予測分析、セキュリティ監視、倫理的意思決定のサポートなどを促進することにより、AI リスクの軽減に重要な役割を果たします。AI リスクの軽減にどのように貢献できるかを詳しく見てみましょう。

- AI アルゴリズムはデータの偏りを特定して修正し、偏った AI 結果を軽減します。

- 予測分析によりリスクを予測し、予防措置を可能にすることができます。

- AI 主導のサイバーセキュリティ ツールは、AI ベースの脅威を検出して対抗できます。

- AI は倫理的な選択をガイドできます。

- 自動化により規制へのコンプライアンスが確保され、コンプライアンス関連のリスクが軽減されます。