テクノロジーにおけるビッグデータの倫理的ジレンマに対する準備はできていますか?

公開: 2024-05-01広大なインターネット全体で、クリック、スワイプ、タップのたびにデジタル証跡が作成されます。 「ビッグ データ」と適切に呼ばれるこの豊富さは、現代テクノロジーの宝石であり、機能するすべての基盤です。 この膨大なデータリポジトリが解き明かした驚異に疑問を投げかける倫理的な難題により、技術の進歩に対する私たちの基本的な理解が試されています。

私たちがどのようなニュースを読むか、そして現実をどのように認識するかをアルゴリズムが決定する世界を想像してみてください。 私たちのデータは単なる商品ではなく、デジタル市場で取引される通貨です。 イノベーションの約束は、ビッグデータの逆説的な状況において、プライバシーの侵害、アルゴリズムの偏見、社会操作の危険と衝突します。

このデジタル時代の岐路に立つとき、私たちは自問しなければなりません。テクノロジーにおいてビッグデータが行使する前例のない力に伴う倫理的ジレンマに本当に直面する準備ができているのでしょうか?

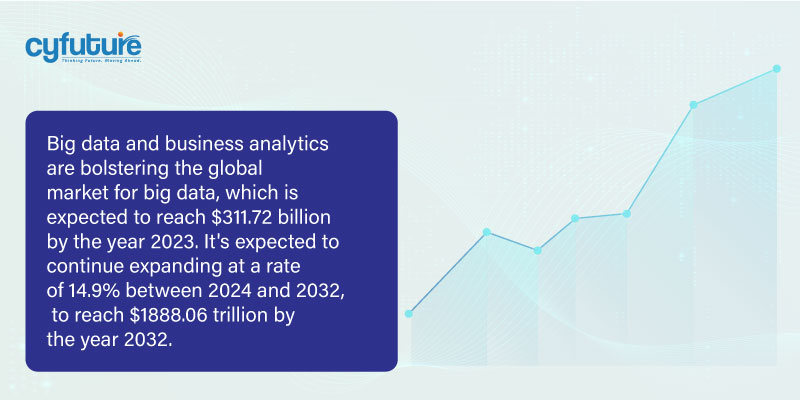

ただし、深く掘り下げる前に、いくつかの統計とデータを見てみましょう。

- 予測によれば、サービスとしてのビッグデータは 2033 年までに 4,749 億ドルを超えると予想されています。

- 2022 年に記録された数値と比較して、2027 年までに生成されるデータは 150 倍に増加し、2032 年までに 2027 年に記録された数値と比較して 300 倍に増加すると予想されます。

- Gartner によると、2026 年までに組織の 80% がデータ ファブリック内に複数のデータ ハブを導入する予定です。 統合されたデータおよび分析ガバナンス プラットフォームにより、大企業の 20% の個別のガバナンス プログラムが自動化および統合されます。

私たちは、倫理的困難の迷宮を旅しつつ、データ駆動型テクノロジーの領域で道徳の羅針盤に挑戦する紆余曲折を探っていきます。

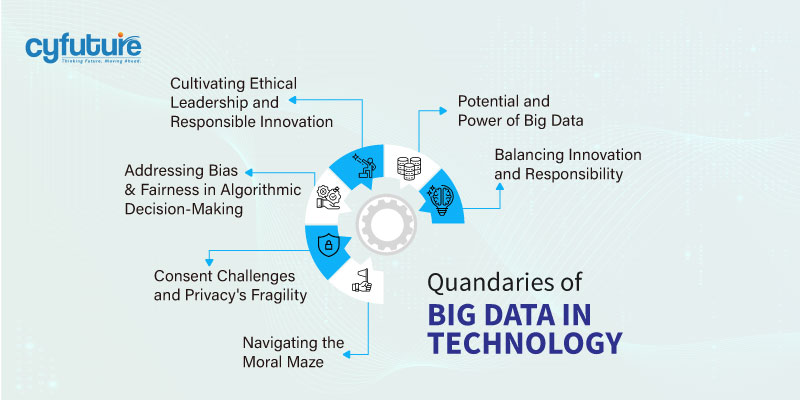

テクノロジーにおけるビッグデータの倫理的課題

1. ビッグデータの可能性と力:

道徳的な問題に取り組む前に、ビッグデータとは何なのかを調べてみましょう。 オンラインでのやり取りごとに、ソーシャル メディアの投稿や検索クエリからオンラインでの購入や位置データに至るまで、データの痕跡が残ります。 この情報の洪水は、産業を変革し、イノベーションを推進し、生活の質を向上させる可能性を秘めています。

私たちの生活のあらゆる側面がビッグデータによって変革され、有効性、容易さ、個別化が約束されています。 企業はこのテクノロジーを利用して、消費者の習慣についてこれまでにない洞察を得ることができ、製品やサービスを個別のニーズを満たすように調整できるようになります。 さらに、医療や研究などの分野では、ビッグデータは発見や病気の早期発見に役立ち、創薬を加速することで、より明るい未来への希望を呼び起こします。

2. 道徳的ジレンマ – 革新と責任のバランス:

テクノロジーにおけるビッグデータの広範な使用は、看過できない重大な倫理的懸念を引き起こします。 創意工夫と説明責任、進歩とプライバシーの間の対立が、このジレンマの原因です。 最も差し迫った問題は個人情報の商業化であり、個人が知らず知らずのうちにプライバシーをデジタル アクセスと引き換えに利用してしまうことになります。

ケンブリッジ・アナリティカのスキャンダルは、何百万人ものFacebookユーザーの身元が政治的目的で本人の同意なしに取得された事件であり、規制されていないデータ収集の危険性をはっきりと思い出させるものとなっている。 テクノロジー大手がターゲットを絞った広告や行動操作を促進するために大量のデータを蓄積する監視資本主義は、同意、自律性、人間の経験の商品化に関する根本的な疑問を引き起こしています。

説明責任と公平性は、アルゴリズムによる意思決定の不透明な性質によって妨げられています。 雇用、融資、刑事司法における既存の偏見は、偏ったアルゴリズムによってさらに強化されます。 アルゴリズムが私たちの生活に影響を与えるにつれ、透明性、説明責任、アルゴリズムの公平性の必要性が最も重要になります。

3. 道徳の迷路をナビゲートする: 倫理的解決に向けて

これらの倫理的ジレンマには、イノベーションと責任のバランスをとる多面的なアプローチが必要です。 個人がデジタル フットプリントについて情報に基づいた選択をできるようにするには、透明性と同意が必要です。

データ保護規制は、デジタル時代の創造性を妨げることなく個人情報を保護するために十分に堅牢でなければなりません。 テクノロジー企業は、倫理上の誤りを回避し、危害を最小限に抑えるために、倫理意識と説明責任の文化を持つ必要があります。

テクノロジーにおけるビッグデータの倫理的な使用には、テクノロジーの専門家、モラリスト、意思決定者、および社会の他の人々の間の分野を超えた協力が必要です。 自律型およびインテリジェント システムの倫理に関する IEEE グローバル イニシアチブや人工知能に関するパートナーシップなどのイニシアチブは、テクノロジーにおける倫理問題に関する対話と協力を促進することを目的としています。 これらの取り組みは、より倫理的で包括的なデジタルの未来への道を開くことを目的としています。

4. 同意の問題とプライバシーの脆弱性:

ビッグデータの普及により、プライバシーは希少かつ貴重なものになりました。 テクノロジー企業や広告主は、オンラインでのあらゆるやり取り、私たちが使用するデバイス、ダウンロードしたアプリから収集、分析し、収益を得ることができます。 個人のプライバシーが失われると、個人データの自律性、同意、商業化に関して根本的な懸念が生じます。

プライバシー ポリシーと同意書はデジタル領域のいたるところにありますが、多くの場合、データの収集と使用の本当の範囲は法律用語や細字の層の下に隠されています。 さらに、データ収集が普及し、ユーザーには見えないことが多い世界では、インフォームド・コンセントの概念はますます希薄になっています。 条件が不透明なアルゴリズムと複雑なデータエコシステムによって管理されている場合、個人はどのようにしてデータの利用に真に同意することができるのでしょうか?

プライバシーの脆弱性は、機密の個人情報が悪意のある攻撃者にさらされるデータ侵害やサイバー攻撃の蔓延によってさらに悪化しています。 デビットカードやクレジットカードの番号から医療記録や親密なやりとりに至るまで、さまざまなデータが悪用や悪用の危険にさらされています。 個人情報の盗難、経済的損害、個人の評判や生活への取り返しのつかない損害は、データ侵害の壊滅的な影響の一部です。

5. アルゴリズムによる意思決定におけるバイアスと公平性への対処:

信用スコアの決定から雇用決定への影響まで、アルゴリズムが私たちの生活にますます影響を与えるにつれて、バイアスと公平性の問題はますます重要になっています。 アルゴリズムはバイアスの影響を受けないわけではなく、意思決定プロセスにおける社会的不平等を反映し、さらには悪化させます。

例えば、予測警察は、少数派を不当にターゲットにする偏ったアルゴリズムを採用し、組織的な人種差別を永続させ、法執行機関と不利な立場にあるグループとの間の紛争を激化させることがわかっています。 同様に、誤った選考手順は、雇用の可能性における性差別的および人種的格差を永続させ、それによって職場における格差を拡大する可能性があります。

偏見に対抗し、コンピューターベースの意思決定における公平性を確保するには、アルゴリズムのオープン性、データ収集の多様性、厳格なテストと検証手順を含む、総合的なアプローチが必要です。 さらに、偏見が顕在化した場合には、それを発見して修正するために、継続的な監視と緩和の取り組みが必要です。

6. 倫理的リーダーシップと責任あるイノベーションを育成する:

テクノロジーにおけるビッグデータの道徳的迷路は、道徳的リーダーシップと責任あるイノベーションに対する道徳的責務の中心にあります。 倫理と誠実さは、テクノロジー企業や業界リーダーの意思決定プロセスの最前線に置かれるべきです。

倫理的なリーダーシップには、透明性、説明責任、積極的なリスク管理への確固たる取り組みが必要です。 さらに、従業員が非倫理的な慣行に対して声を上げ、現状に異議を唱えることが奨励される、組織内での倫理意識と権限付与の文化を育むことが重要です。 さらに、従業員が現状に対して声を上げることが奨励される、組織内での倫理意識とエンパワーメントの文化を育むことが重要です。

さらに、責任あるイノベーションには、技術者、倫理学者、政策立案者、市民社会のメンバーなど、多様な関係者間の協力と対話が必要です。 テクノロジーの道徳的影響について議論することは、障害を特定し、危険を特定し、すべての人に利益をもたらす戦略を立てるのに役立ちます。

まとめます!

結論として、テクノロジーにおけるビッグデータによって引き起こされる道徳的ジレンマは、迅速な注意と思慮深い解決策を必要とする複雑かつ多面的な問題を提示しています。 データ駆動型イノベーションという道徳的な地雷原を切り抜けるには、テクノロジーの進歩の約束と倫理的義務の要求のバランスをとらなければなりません。

プライバシー、同意、偏見、公平性などの重要な問題に対処するには、テクノロジー業界における強力な法的枠組み、オープンな手順、倫理文化が必要です。 一般利益を促進しながら個人の権利を尊重する倫理規範と原則を策定するには、さまざまな利害関係者が協力し、相互にコミュニケーションする必要があります。

今後は厳しい課題が待ち受けていますが、楽観視できる理由もあります。 テクノロジーの進歩における倫理的ジレンマの重要性についての理解は、AI に関するパートナーシップや自律型およびインテリジェント システムの倫理に関する IEEE グローバル イニシアチブなどの取り組みで示されています。 倫理的なリーダーシップ、責任あるイノベーション、透明性と説明責任への取り組みを受け入れることで、私たちはビッグデータの変革力を活用し、創造的であるだけでなく、道徳的に健全ですべての人を包含する未来を築くことができます。

この旅に出発するにあたり、過去の知識と現在の洞察を組み合わせて、テクノロジーが人類の最も賞賛すべき目標を前進させる未来を創造しましょう。 勇気、思いやり、信念を持って、テクノロジーのビッグデータによってもたらされる道徳的難題に立ち向かう日への道を切り開きましょう。

テクノロジーにおけるビッグデータの倫理に関する議論に参加し、より道徳的に健全なテクノロジーの未来のために取り組んでください。 私たちが協力すれば、データ主導のイノベーションによってもたらされる課題を克服し、テクノロジーがすべての人の利益になる未来を築くことができます。

よくある質問 –

テクノロジーにおけるビッグデータによって引き起こされる倫理的ジレンマの例にはどのようなものがありますか?

テクノロジーにおけるビッグデータは、広告のターゲティングや政治的操作のための個人情報の悪用、差別を永続させる偏ったアルゴリズムの普及、個人のプライバシー保護の悪化など、倫理的な課題を引き起こします。 これらの問題は、社会におけるテクノロジーの役割についての私たちの理解に疑問を投げかけており、思慮深い倫理的配慮が必要となります。 これらは、社会におけるテクノロジーの役割についての私たちの理解に疑問を投げかけます。

テクノロジーにおけるビッグデータの倫理的課題にどのように対処できるでしょうか?

ビッグデータの倫理的ジレンマには、政府の監視、業界のベストプラクティス、個人の責任を組み込んだ包括的な戦略が必要です。 倫理的かつ責任あるデータの収集と使用は、透明性、説明責任、同意を通じてのみ実現できます。 さらに、倫理意識の文化を育み、ユーザーが自分のデータについて情報に基づいた選択をできるようにすることは、テクノロジーにおけるビッグデータに関連するリスクを軽減するのに役立ちます。

企業やテクノロジー企業は、ビッグデータをめぐる倫理的懸念への対処にどのように貢献できるでしょうか?

企業やテクノロジー企業は、ビジネス慣行における倫理的配慮を優先することで、ビッグデータを取り巻く倫理的懸念への対処に貢献できます。 これには、従業員に対する定期的な倫理トレーニングや、倫理的課題を特定して対処するために利害関係者と積極的に関わることが含まれます。 企業は、倫理的な行動への取り組みを示すことで倫理と責任の文化を育むことで、顧客や利害関係者の信頼を獲得できます。

テクノロジーにおけるビッグデータの倫理的実践を促進することを目的とした新たなトレンドや取り組みにはどのようなものがありますか?

業界団体によって倫理ガイドラインと基準が作成され、テクノロジー企業内に倫理委員会が設立され、データ駆動型テクノロジーの設計と開発に倫理が組み込まれています。 さらに、技術者、モラリスト、意思決定者、市民社会の間の分野を超えたコラボレーションにより、ビッグデータ道徳の領域における対話と創造性が促進されています。