説明可能な AI が人工知能の責任ある倫理的な開発をどのように実現できるか

公開: 2023-09-012022 年 11 月の OpenAI の ChatGPT の開始など、イノベーションと創意工夫を組み合わせた変革の瞬間により、AI が私たちの生活を制御するというビジョンはもはや SF ではありません。

ChatGPT の立ち上げの転換点は、業界で「AI カンブリア爆発」と呼ばれるものの先駆けとなりました。

しかし、それはビジネス上の利益のために AI を使用するだけではなく、それがこの爆発の現在の焦点でもあります。 この進化の中心にあるのは、AI の説明可能性に焦点を当てるという呼びかけです。 これにより、AI の進歩は強力かつ透明性の高いものになります。これは、倫理的な AI 開発の基礎となります。

人工知能はすでに多くの分野で私たちの代わりに意思決定を行っています。 しかし、AI がどのようにしてこうした決定を下すのかを理解していないことが依然としてボトルネックとなっています。 これは、起業家やテクノロジー専門家にとって無視できない、説明可能な AI の利点の 1 つです。

テクノロジーが進歩するにつれ、テクノロジーの専門家にとっての課題は 2 つあります。それは、AI の仕組みの透明性、説明責任、倫理的健全性を確保しながら、AI が達成できる限界を押し上げることです。 これは、現代のテクノロジーにおける説明可能な AI の役割を浮き彫りにしています。

AI の経済的可能性

生産性を変革する生成 AI の可能性は、単なる理論上のものではありません。 それは地球規模で具体的な経済的影響を与えることになるだろう。 マッキンゼーが発行した「生成 AI の経済的可能性: 次の生産性フロンティア」と題した 2023 年 6 月のレポートによると、生成 AI は、分析された 63 のユースケース全体で年間 2 兆 6000 億ドルから 4 兆 4000 億ドルの範囲の価値を生み出す可能性があります。 複数の斬新な方法で業界に利益をもたらす、説明可能な AI のユースケースもあります。

こちらもお読みください: ビジネス向けの生成 AI が業界をどのように形成しているか

Washington Post は、Microsoft のクラウド部門が提供する OpenAI ツールを 11,000 社以上の企業が利用していると報じ、この可能性に伴う導入傾向を浮き彫りにしました。 これらの数字は、この進化する状況をナビゲートするテクノロジーリーダーの機会と責任を表しています。

AI の変革の可能性が明らかになるにつれ、説明可能な AI の原則がますます重視され、これらの強力なツールが明確さ、監視、倫理的配慮を持って動作することが保証されています。 説明可能な AI アプリケーションは、テクノロジー業界の基礎となる予定です。

しかし、説明可能な AI のメリットやその他の関連側面を理解することは、まだ始まりにすぎません。 したがって、Explainable AI 開発のニュアンスを詳しく説明する前に、まずそれがなぜ不可欠なのかを理解する必要があります。

AI モデルの謎: 「ブラック ボックス」をナビゲートする

すべての重要な進歩と同様に、AI も課題をもたらし、その一部はその構造に深く関係しています。 この謎のそのような側面の 1 つは「ブラック ボックス」です。 機能するクローズド運用モデルを表しますが、開発者ですらそれがどのように機能するかを説明できない場合があります。 これは、AI 業界ではブラックボックスの難題として知られています。

この透明性の欠如は、多くの人、特にビジネスや社会の重要な意思決定に責任を負う人々にとって受け入れがたいものです。 説明可能性なしに機能する AI は、特に物理的および物質的な損失が発生する可能性がある場合、信頼を損なうリスクがあります。

予期せぬ結果: AI が軌道から外れたとき

説明のつかない AI の決定がもたらす影響は、軽微な非効率から重大な社会的影響まで多岐にわたります。 金融セクターを考えてみましょう。AI システムは、明確な根拠を示さずに個人への融資を拒否する可能性があります。

透明性を欠いたこのような決定は、法的な問題や風評被害につながる可能性があります。 より大きな規模で言えば、医療の分野では、不可解な AI が、ある患者を別の患者よりも優先して治療を行い、人生を変えたり、人生を終わらせたりする影響をもたらす可能性があります。

AI の予期せぬ結果と事故の実例

いくつかの事件は、AI の予期せぬ影響を浮き彫りにしています。 ウーバーの自動運転車に関わる2018年の悲劇的な事件は、AIが環境を誤って解釈した場合の悲惨な影響を浮き彫りにしている。 人種的偏見があることが判明した著名な医療アルゴリズムは、AIがどれほど進歩していても、十分に理解され監視されていない場合、意図せずして人間の偏見を永続させる可能性があることをはっきりと思い出させます。

「ヒトラーは正しかった」などとツイートしたマイクロソフト社のテイ氏から、クレジットカードの請求書を高額で受け取ったアメリカ人まで、リストは続く。 ガードレールと AI による決定を解釈する能力がなければ、そのような事例は今後も起こり続けるため、説明可能性が求められます。

ビジネスケース: 説明可能な AI のメリット

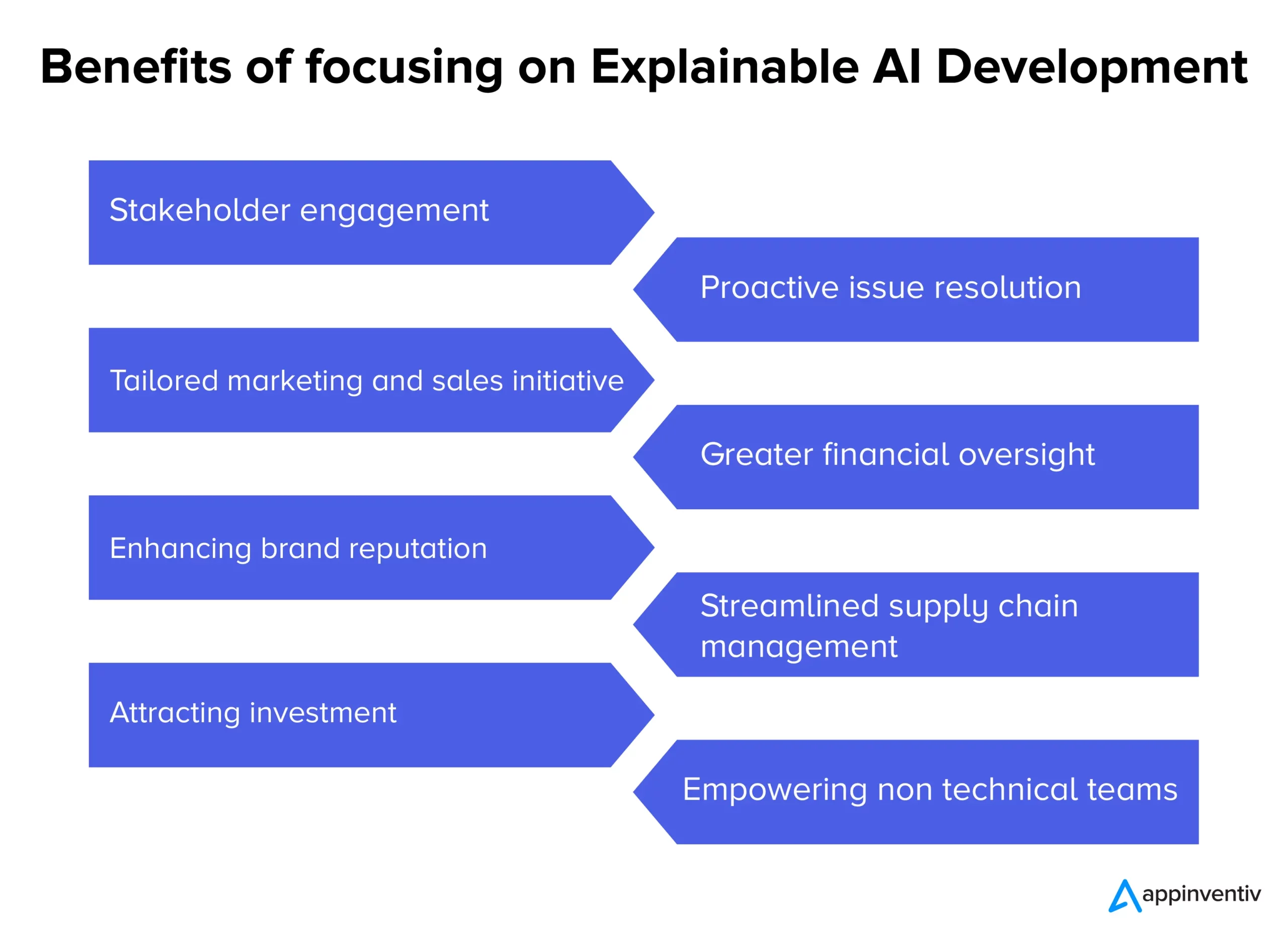

AI システムがますます野心を推進するにつれて、その固有の不透明性が透明性の不可欠性をめぐる議論を引き起こしています。 単なる技術的な議論を超えて、説明可能な AI の導入を支える強力なビジネス理論的根拠があります。 ここでは、さまざまな業界の企業にとって説明可能な AI のさまざまなメリットを紹介します。

- 利害関係者の関与と信頼:透明性のある AI 意思決定プロセスにより、社内チームと社外パートナーの間でより深い関与感と確信感が醸成されます。

- プロアクティブな問題解決:問題が拡大する前に、Explainable AI が潜在的な懸念領域を強調し、タイムリーな介入と解決策を可能にします。

- カスタマイズされたマーケティングと販売の取り組み:企業は、AI を活用した消費者インサイトの背後にある「理由」を理解することで、よりパーソナライズされた効果的なキャンペーンを作成できます。

- 財務監視の強化: AI を活用した財務モデルと予測が透明であれば、潜在的な異常領域や成長分野をより容易に特定して対処できるようになります。

- ブランドの評判の向上:倫理的で透明性のある AI 導入で知られる企業は、ブランドの評判も高まる可能性があります。

- 合理化されたサプライ チェーン管理: AI を活用した明確な洞察により、在庫管理から物流に至るサプライ チェーン プロセスをより効果的に最適化できます。

- 投資の魅力:投資家にとって、AI の透明性は企業が責任あるイノベーションに取り組んでいることを示し、AI をより魅力的な投資提案にすることができます。

- 非技術チームの強化: Explainable AI により、深い技術的専門知識を持たないチームでも AI 主導の洞察と意思決定がアクセス可能で実行可能になり、部門を超えたコラボレーションが促進されます。

企業が現代の複雑な状況を乗り切る中で、ブラックボックス ソリューションに依存することは賭けになる可能性があります。 AI プロセスに透明性を導入することは、単なる技術のアップグレードではありません。 これはビジネス上の必需品であり、AI に裏付けられたあらゆる動きをより広範な組織の目標と価値観に確実に一致させ、説明可能な AI の役割を示しています。 これらは、起業家や AI 開発者が通常注目する説明可能な AI ユースケースでもあります。

説明可能な AI モデルの青写真

私たちの日常生活における AI の影響が日を追うごとに明らかになっている現在、重要な決定を下すために私たちが信頼しているマシンの動作が正確かつ透明であることを保証することが重要になっています。

説明可能な AI モデルの開発は、コーディングだけではありません。 これは、説明可能な AI 原則と説明可能な AI ツールに基づいた戦略的計画、厳密なテスト、反復的な改良を伴うプロセスです。 ここでは、私たちが開発する AI モデルが説明可能かつ解釈可能でありながら、法的に準拠していることを保証する、ステップバイステップのガイドと説明可能な AI テクニックを紹介します。

- 問題領域の理解:モデル開発に入る前に、問題領域と関係者を明確に理解します。 ユーザーは何を期待していますか? AI がどのような決定を下すのか、そしてその決定がどのような影響を与えるのかは、私たちが答えを見つけることができる質問の一部です。

- 適切なデータの選択:データの品質と関連性は、AI の正確性と説明可能性の能力に直接影響します。 AI モデルの開発では、データがクリーンで多様性があり、バイアスがないことを保証します。

- 適切なモデルの選択:ディープ ニューラル ネットワークなど一部のモデルはより複雑で解釈が困難ですが、デシジョン ツリーや線形回帰などのモデルはより透明性が高くなります。 私たちは、説明可能な AI モデルを開発する際に、複雑さと明瞭さの間のバランスを選択します。

- 反復テスト:一貫したパフォーマンスを確保するために、さまざまなデータセットを使用してモデルを定期的にテストします。 これらのテストからのフィードバックは、改良と改善に役立ちます。

- 説明可能性ツールの統合: LIME や SHAP などのツールは、モデルの予測を分析するのに役立ち、どの機能が特定の決定に影響を与えたかについての洞察を提供します。

- ドキュメント:包括的なドキュメントは、モデルの検証、検証、展開に役立ちます。 これにより、開発者からエンドユーザーまで、すべての関係者が AI の仕組みと制限を理解できるようになります。

モデルのパフォーマンスと解釈可能性のバランスを取る

説明可能な AI ソフトウェア開発における最も重要な課題の 1 つは、モデルのパフォーマンスと解釈可能性のバランスを取ることです。 複雑なモデルはより高い精度を実現する可能性がありますが、多くの場合、透明性が犠牲になります。 逆に、単純なモデルは理解しやすいかもしれませんが、データ内のニュアンスを効果的に捉えられない可能性があります。 適切なバランスをとるために、次の点を考慮します。

- モデルの単純さと複雑さ:満足のいくパフォーマンスを達成するために必要な最小レベルの複雑さを決定します。 より単純なモデルで十分な場合は、説明可能性を確保するためにはそれがより良い選択となる可能性があります。

- 説明可能性テクニックの使用:特徴の重要度ランキングやモデルに依存しない手法などのテクニックは、複雑なモデルをより解釈しやすくするのに役立ちます。

- フィードバック ループ: AI の決定が明確かどうか、透明性を高める余地があるかどうかを理解するために、エンドユーザーとの継続的なフィードバック ループを維持しています。

説明可能な AI を実現するまでの道のりは複雑に見えるかもしれませんが、それは必要なことです。 AI をシステムやプロセスにさらに統合するにつれて、これらの高性能かつ透明性の高いモデルを確保することが、信頼性と効率性を維持するために非常に重要になります。

Appinventiv は説明可能な AI モデルの開発にどのように役立ちますか?

AI 製品の開発に 9 年近くの経験がある私たち Appinventiv は、AI モデルの開発と説明可能な AI の利点に関連するさまざまな複雑さを理解しています。 Mudra (AI を活用した個人金融アプリ) を含む、数多くの AI ベースのプラットフォームとアプリを開発してきた当社のエンジニアは、説明可能な AI 開発に向けて移行するための専門知識と監督を備えています。

お客様の AI プロジェクトがどのようなものであっても、AI 開発の大手企業として、お客様がモデルによって行われた決定を自信を持って信頼できるように、AI モデルの解釈可能性と説明可能性を解き放つことができます。 責任ある AIへの旅に乗り出すには、今すぐご連絡ください。

よくある質問

Q.説明可能なAIとは何ですか?

A.説明可能な AI は、AI 開発におけるパラダイム シフトであり、AI モデルによって行われた意思決定を遡ることができ、ユーザーが AI モデルがどのように意思決定を行っているかを理解できるような方法で AI モデルを開発する必要があります。

Q.説明可能な AI はどのように機能しますか?

A. Explainable AI は、開発中に説明可能性の主要な要素を AI モデルに統合することで機能し、AI モデルがどのように特定の決定に達したかを判断するのに役立ちます。

Q. 説明可能な AI はなぜ重要ですか?

A.説明可能な AI は重要です。AI モデルがどのように私たちに代わって意思決定を行っているのかを理解していないと、悲惨な結果につながる可能性があり、最悪の場合、問題の AI モデルの企業やユーザーに明白な損害を与える可能性があるからです。