AI 製品の開発中にコンプライアンス違反を回避する方法

公開: 2023-06-12人工知能は、製造、ヘルスケア、金融などのデータと機械集約型の分野での貢献を通じて、ここ数年トップのテクノロジートレンドであり続けています。 ただし、このテクノロジーがエンドユーザーから高い関心を集めるようになったのはここ 2 年間のことです。 画像ジェネレーターやテキストジェネレーターなどのアプリケーションを使用すると、ワンクリックでビジュアルやテキストを作成できるようになりました。

これらの AI プラットフォームは資料をゼロから作成しているように見えますが、実際はそうではありません。これらの AI プラットフォームは、インターネットからのテキストと画像のアーカイブを処理することで機能する質問のスニペットとデータ レイクでトレーニングされています。 エンド ユーザーにとっては便利ですが、このアプローチには著作権侵害、オープンソース ライセンスの不遵守、知的財産侵害などの法的リスクが伴います。生成 AI がもたらすこれらのリスクは、絶えず発生する世界中の政府によって認識されていないわけではありません。非倫理的な AI モデルに関する新しいルールと罰則が課せられます。

AI プロジェクトの立ち上げを準備している企業にとって、リスクを理解し、これらの倫理問題の背後にある法的なレーダーに引っかからないシステムを構築することが重要です。 この記事では、法的問題の種類、AI 規制に備える方法、さまざまな地域で施行されている AI 法など、ソフトウェア開発における AI コンプライアンスのさまざまな側面について詳しく説明します。

AI コンプライアンスとは何ですか?

これは、AI を利用したアプリケーションが、運用されている地域の規制や法律に準拠していることを確認するプロセスです。AI コンプライアンス チェックで構成されるさまざまな要素は次のとおりです。

人工知能に関する法的問題

ミクロレベルでは、エンドユーザーによる AI の使用に関する問題は、盗作や共有不可能なデータへのアクセスに限定されているように見えますが、マクロレベルでは、非 AI コンプライアンスがより大きな課題を引き起こします。

不適切に構築された AI システムの使用から生じる脅威は、公正な競争、サイバーセキュリティ、消費者保護、さらには公民権に影響を及ぼす可能性があります。 したがって、企業と政府にとって、公正で倫理的なモデルを構築することが重要です。

著作権

生成 AI の出現により、企業はテクノロジーを利用して著作権素材を作成し始めました。 この問題は、データが作成者の創造性によって生成されたのか、それとも AI が作成者なのかを理解できないことです。

これを法的に遵守するために、著作権局は AI で生成された素材を含む作品の審査と登録に関するガイダンスを発行しました。 次のように述べられています –

- 著作権は人間の創造性によって生み出された素材のみを保護できます。

- AI ベースの素材を使用した作品の場合、AI の貢献が「機械的な複製」から生じたものであるか、または作者の「独自の構想を AI によって目に見える形にしたもの」であるかが考慮されます。

- 申請者には、登録のために提出された資料に AI ベースのコンテンツが含まれていることを開示する義務があります。

こちらもお読みください: 2023 年の AI コンテンツ検出ツールの開発コスト

オープンソース

AI 駆動のコード ジェネレーターは、多くの場合、AI を使用して、開発者テストや入力の最後に自動補完やコードの提案を行う開発者を支援します。 コード ジェネレーターを中心とした準拠 AI モデルの開発に関連するいくつかの課題を以下に示します。

- オープンソース コードを使用した AI モデルのトレーニングは侵害を意味しますか?

- オープンソースのコンプライアンス基準を満たす責任は開発者とユーザーのどちらにありますか?

- 新しいソフトウェアを作成する開発者が AI ベースのコードを使用するには、オープンソースに基づいてアプリケーションのライセンスを取得する必要がありますか?

知的財産権の侵害

世界中で、AI ツールがサードパーティの IP で保護されたコンテンツに基づいてモデルをトレーニングしたり、出力を生成したりしているという事実を告発して、複数の侵害訴訟が起こされています。

倫理的偏見

AIの顔認識技術が人種差別につながる事件はこれまでに数多く起きている。 2020年にコンピューターエラーで黒人が逮捕された事件や、Googleフォトが黒人を「ゴリラ」とラベル付けした事件など。 テクノロジーがどれほど賢くても、人間が偏見を持って構築したものであることを無視することはできません。

同様のソリューションの構築を検討している企業にとって、これらのバイアスがシステムに入らないようにすることが重要です。

AI プロジェクトの GDPR 準拠

そうは言っても、企業が厳しい規制にもかかわらず、準拠した AI モデルの構築に失敗する理由を理解することが重要です。 その背後には、コンプライアンスを把握できないこと、開発者の理解不足、場合によっては単純な無知など、さまざまな理由が考えられます。 ただし、その背後には機能的な理由がいくつかある可能性もあります。

AI プロジェクトの GDPR 準拠の見通しから、そのうちのいくつかを見てみましょう。

目的の限定

GDPR 原則により、企業は情報が収集および処理される目的をデータ主体に通知する必要があります。 この問題の課題は、このテクノロジーがパターンを見つけて新しい洞察を得るためにデータを使用することですが、それがそのデータの本当の目的ではない可能性があることです。

差別

GDPR では、AI 開発者に対し、テクノロジーがもたらす差別的な影響に対して対策を講じることを義務付けています。 これは時代の倫理的ニーズではありますが、急速に変化する社会シナリオを運用する開発者にとって、あらゆる差別や不道徳な出力に対して AI モデルを準備することは困難になる可能性があります。

データの最小化

GDPR では、収集される情報は「適切、限定的、関連性のある」ものでなければならないとしています。 これは、AI 開発チームがモデルにデータを使用する際には細心の注意を払う必要があり、プロジェクトに必要なデータの量を明確にする必要があることを意味します。

ただし、これは予測できないため、チームはデータ最小化要件に対処するために必要なデータの種類と量を定期的に評価する必要があります。

透明性

最後に、ユーザーは自分のデータがサードパーティによってどのように使用されるかについて発言権を持つ必要があります。そのためには、企業はどのデータをどのように使用しているかを明確にする必要があります。

これの問題は、AI モデルの大部分がブラック ボックスで動作し、特に高度なソフトウェアについて話す場合、AI モデルがどのように意思決定を行うかが明確ではないことです。

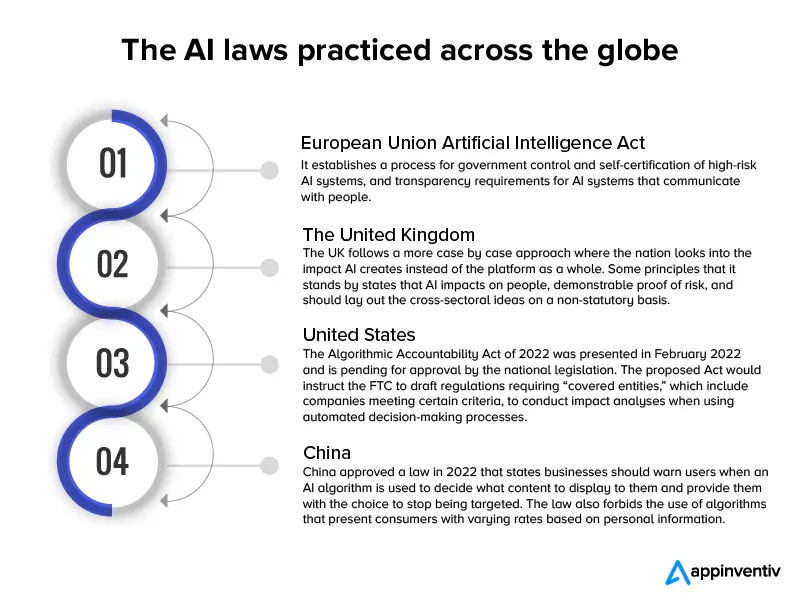

これらはすべて本物の技術的問題ではありますが、IT 倫理に関して言えば、企業が欠陥のある AI モデルを開発するための盾としてそれらを使用しないことが重要です。 この慣行が主流にならないようにするために、いくつかの AI 法が世界規模で制定されました。

2017 年以来、約 60 か国が人工知能に関する法規制を導入しています。これは、新しい AI モデルの実装のスピードに合わせた一連の行動です。

これらの法律を簡単に説明したインフォグラフィックを次に示します。

法的な観点から AI 開発の課題と、世界レベルで適用される法律の草案を検討したところで、準拠した AI アプリケーションを構築する方法について説明します。

こちらもお読みください: ChatGPT のような法的に準拠したチャットボットの開発にはどれくらいの費用がかかりますか

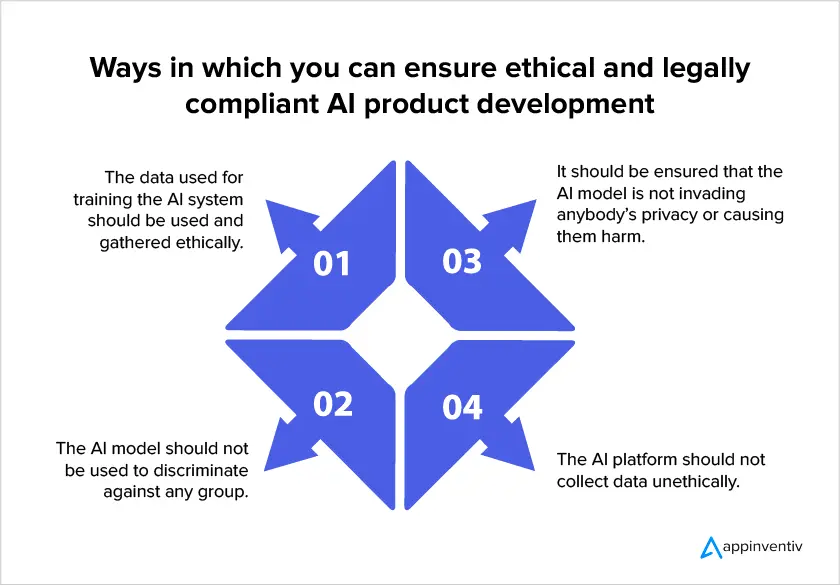

コンプライアンスに配慮した AI モデルを開発する方法

世界レベルでの AI 規制の高まりにより、企業が AI モデルを構築する際に法令順守に重点を置くことが重要になっています。 企業が AI 開発サービスに投資する際に、プロジェクトが法的に準拠していることを確認できる方法をいくつか紹介します。

- データの使用が許可されていることを確認してください

AI コンプライアンスでは、ユーザーのプライバシーがモデル設計の指針となるべきであると規定されています。 これは、収集する必要があるデータの量を最小限に抑え、データ収集の正確な理由とデータを使用するまでの期間を指定する必要があることを意味します。 最終的には、ユーザーがデータ収集に同意する必要があることに注意することが重要です。

- 説明可能な AI 手法

このアプローチは、人間が AI システムの内部に何があるのか、モデルがどのように意思決定を行うのかを理解できるようにすることで、ブラック ボックス効果の解決に役立ちます。 これは、研究者がデータ最小化要件を満たすためにモデルの精度を向上させるために必要な正確なデータ量を知るのに役立ちます。

- 収集されたデータを追跡する

AI コンプライアンスでは、企業は収集された PII の場所と使用法を把握する必要があります。 保護された情報に対するユーザーの権利を遵守するには、正しいデータ分類が必要です。 さらに、企業は正確なセキュリティ対策を準備するために、どの情報がどのデータセットに保存されているかを把握するアプローチを持たなければなりません。

- 国間のデータ送信ルールを理解する

AI システムで国境を越えたデータ転送がある場合、開発者は受信国に適用される規制を考慮し、それに応じて適切なデータ転送メカニズムを構築する必要があります。 たとえば、GDPR がデータ処理に適用され、個人データが非 EEA 国に転送される場合は、適切な転送影響評価を実施する必要があります。

AI アプリケーションの開発時にこのようなアプローチを使用することは、テクノロジーに関連するリスクに適切に対処するために非常に役立ちます。 ただし、企業や規制当局は、業界の状況がケースバイケースのモデルに基づいて機能するため、アプリケーションをあらゆる潜在的なリスクから保護することは不可能であるという事実に留意する必要があります。 このため、いつ介入が必要かを判断できる AI リスクマネージャーの役割は引き続き重要です。

この記事が、今後 AI テクノロジーを取り巻く法的構造に何が期待されるか、また、準拠する AI モデルに備える方法を理解するのに役立つことを願っています。

よくある質問

Q. 人工知能には法的な問題はありますか?

A.はい。 人工知能モデルの構築が不十分であると、法的および倫理的な問題が多数発生する可能性があります。

- 著作権

- オープンソースライセンスの悪用

- 知的財産権の侵害

- 人種差別などの倫理的偏見。

Q. 法に準拠した AI モデルを作成するのが難しいのはなぜですか?

A.技術的な面では、法律に準拠した AI を構築するのが難しい場合があります。テクノロジーは顧客のデータを使用してパターンを見つけ、新しい洞察を得る一方で、そのデータの本当の目的を確認することが困難になるためです。 次に、AI 開発チームは、プロジェクトに必要なデータの量を決して確信できません。 最後に、AI モデルの大部分はブラック ボックスで動作しており、特に高度なソフトウェアについて話す場合、AI モデルがどのように意思決定を行うかは明らかではありません。

Q. AI における法的コンプライアンスを確保するにはどうすればよいですか?

A. AI の法的コンプライアンスに関する法律や規制は常に進化していますが、モデルがコンプライアンスに最も近い状態にあることを確認するためにできることがいくつかあります。

- データの使用が許可されていることを確認してください

- 説明可能な AI 手法

- 収集されたデータを追跡する

- 国間のデータ送信ルールを理解する