責任ある AI – 指針となる原則と戦略を用いて導入の課題に対処する

公開: 2023-09-08AI ソリューションの普及が主流となっている時代では、安全性と倫理原則を遵守しながら、責任ある開発プロセスを優先することが非常に重要になっています。 これらの AI システムは機能が向上し続けており、さまざまな産業分野での応用が見出されているため、その作成が厳格な安全対策と一致していることを確認することは、組織の最優先事項の 1 つである必要があります。

では、AI ベースのシステムが倫理的であり、意図しない結果を引き起こさないようにするにはどうすればよいでしょうか? この難題に対する簡単な答えは、責任ある AI 原則を遵守することです。

Responsible AI (RAI) とは、倫理的配慮と社会福祉が中心となる人工知能の包括的なフレームワークを指します。 基本原則と調和するように設計された AI システムの責任ある開発と適用が特徴です。

責任ある AI の原則により、組織は透明性に重点を置くことができ、ユーザーや関係者が AI システムの内部動作を理解できるようになります。 この透明性により、信頼と説明責任の向上への道が開かれ、AI による意思決定がどのように行われるかを個人が理解できるようになります。 また、RAI は、データをインテリジェントに管理し、結果が公平かつ公平であることを保証する公平性措置を組み込むことにより、AI アルゴリズム内のバイアスにも積極的に対処します。

このブログは、責任ある AI の 5 つの原則と、それらを遵守することで AI システムがユーザーにとってどのように公平かつ公正になるかを理解するのに役立ちます。 責任ある AI を企業に導入するメリットに加えて、合理化されたアプローチを採用することで対処できるさまざまな課題についても理解できるように支援します。

責任ある AI 戦略を採用する必要性: AI リスクの軽減

2016 年 3 月、Microsoft は Twitter 上で Tay と呼ばれる AI チャットボットを開始しました。 Tay の目的は、ユーザーとのやり取りから学ぶことでした。 残念ながら、一部の個人が攻撃的なコンテンツをボットに投稿し始めたため、Tay は攻撃的な言葉で応答しました。 数時間以内に、テイはヘイトスピーチと差別を助長するボットに変身しました。 MicrosoftはすぐにTay氏をオフラインにし、ボットの不適切なツイートについて謝罪した。 この事件はAIがいかに誤った方向に進むかを示す明らかな例であり、その後も同様の事件が数多く発生している。

AI は社会に利益をもたらす大きな可能性を秘めていますが、ベンおじさんが言うように、「大きな力には大きな責任が伴います」。

機密データを含む重要なビジネス上の意思決定に AI を使用する場合、次のことを理解しておくことが重要です。

- AI は何をしているのか、またその理由は何ですか?

- 正確かつ公正な選択をしているでしょうか?

- それは人々のプライバシーを尊重していますか?

- この強力なテクノロジーを制御し、監視することができますか?

世界中の組織が責任ある AI 戦略の重要性を認識していますが、それを導入するまでの段階はそれぞれ異なります。 責任ある AI (RAI) の原則を採用することは、AI に関連するリスクを軽減する最も効果的な戦略です。

したがって、現在の慣行を評価し、データが責任を持って倫理的に使用されていることを確認する時期が来ています。 RAI を早期に導入すると、その慣行に関連するリスクが軽減されるだけでなく、組織が競合他社よりも優位に立つことができ、将来的には追い越すのが難しい競争力を得ることができます。

MIT Sloan の調査によると、52% の企業が責任ある AI の実践に向けた措置を講じています。 しかし、これらの企業の 79% 以上は、自社の取り組みが規模と範囲に関して限定的であることを認めています。 このレポートは、企業における AI の役割が増大し続ける中、企業が課題に対処し、責任ある AI (RAI) を優先することの重要性が高まっていることを強調しています。 AI を活用した持続可能で責任ある未来を形作るには、堅牢な倫理的枠組みを確立することが単なる選択ではなく、不可欠です。

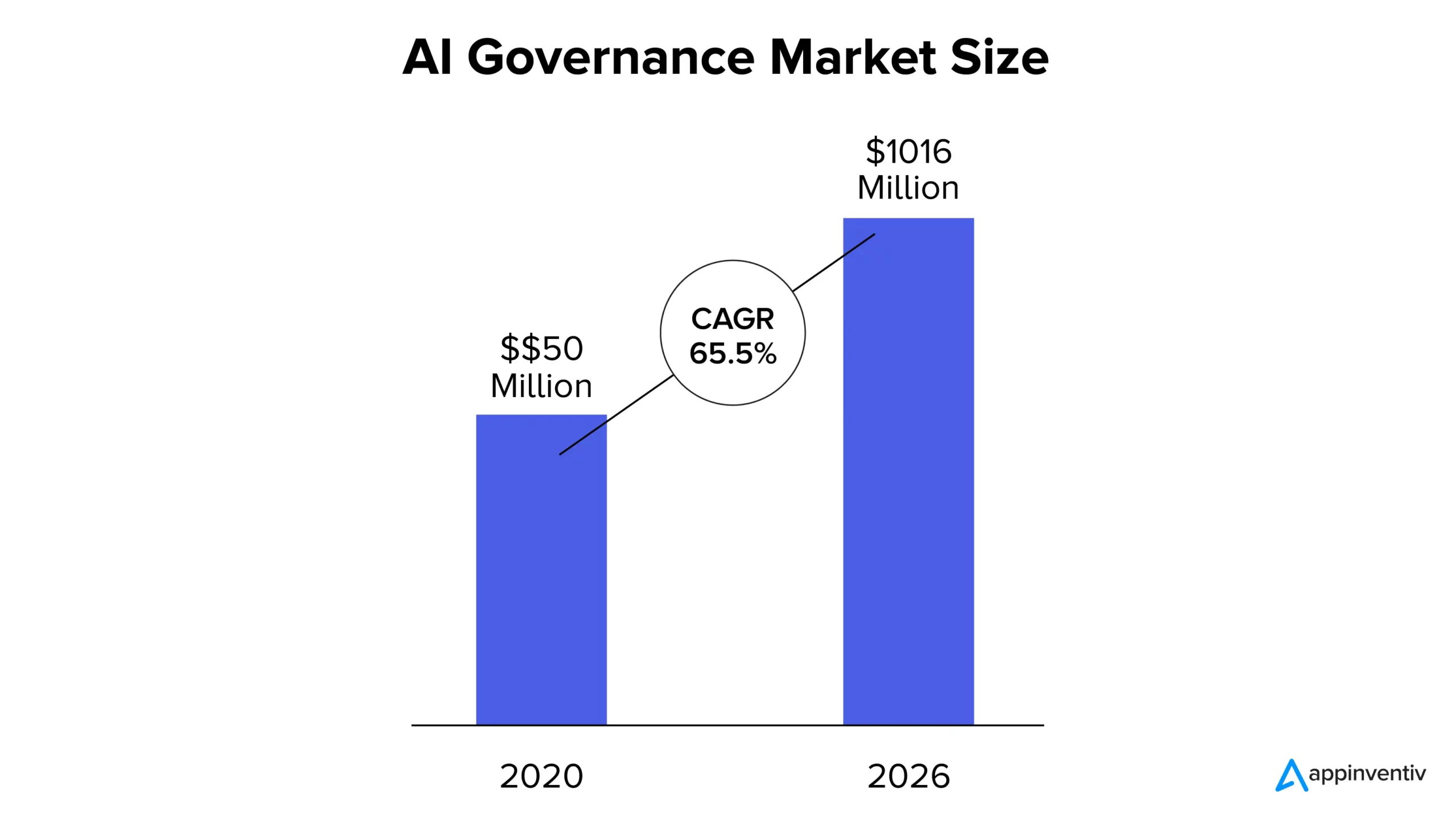

MarketsandMarkets のレポートによると、AI ガバナンス市場は 2020 年に 5,000 万ドルと評価され、2026 年までに 10 億 1,600 万ドルに達すると予想されており、CAGR は 65.5% です。 市場シェアの拡大は、AI システムの透明性の高まり、規制遵守の遵守、および AI ベースのソリューションに対する信頼のニーズの高まりに起因すると考えられます。

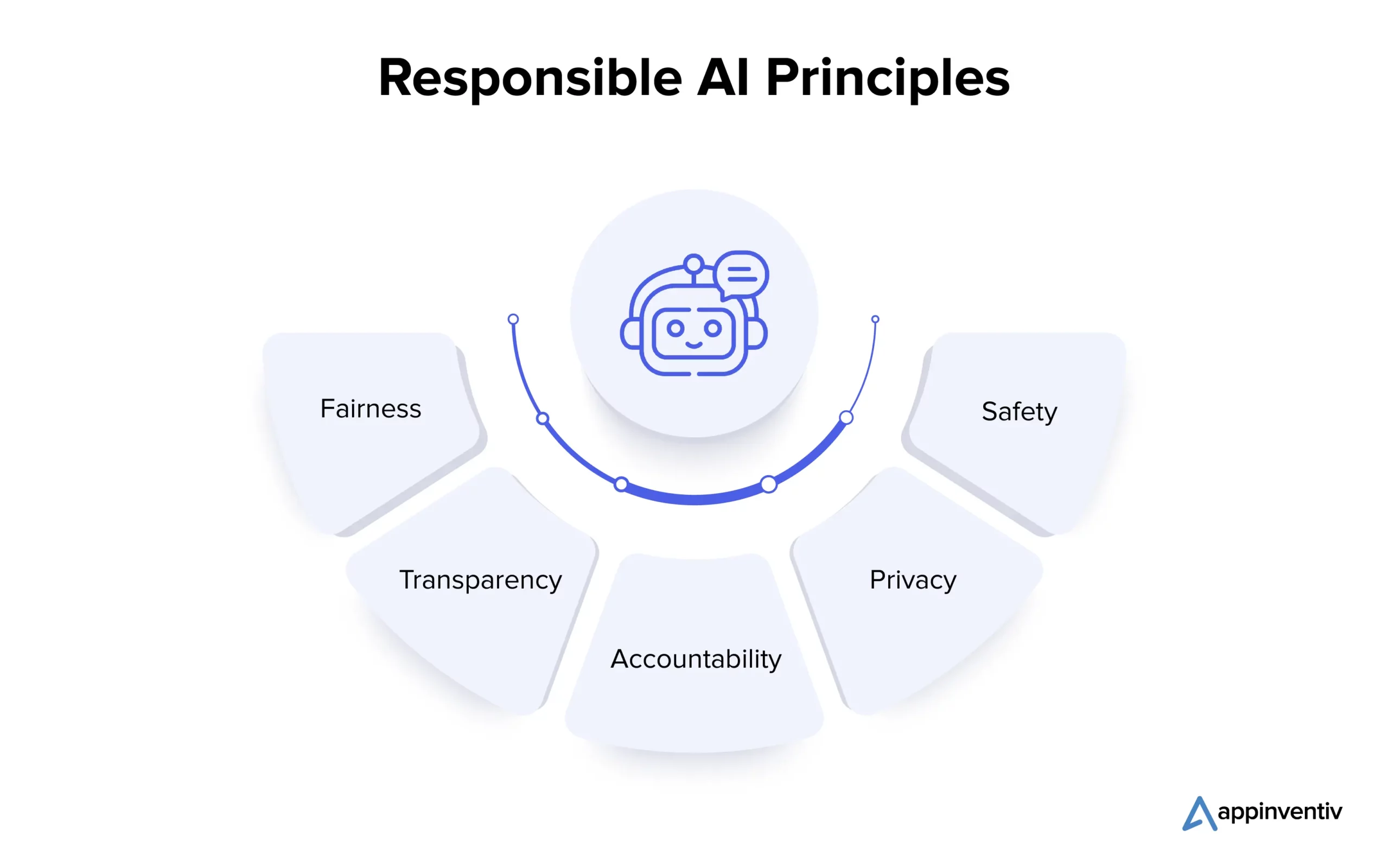

責任ある AI 原則とは何ですか?

Responsible AI の中核原則を理解することは、複雑な AI 環境を倫理的に乗り越えようとしている組織にとって不可欠です。 以下で複数の原則を詳しく見てみましょう。

1. 公平性

AI の公平性は、AI システムのバイアスに対処する基本原則です。 バイアスは、アルゴリズムの作成中、またはトレーニング データの誤った表現によって発生する可能性があります。 データ サイエンティストは、データ分析などの手法を使用してバイアスを検出して修正し、AI システムがバイアスのない決定を下して平等な結果を促進できるようにします。

2. 透明性

AI の透明性には、AI の開発と展開で実行される手順を文書化して説明し、関係者が理解できるようにすることが含まれます。 解釈可能な機械学習などの技術により、AI の意思決定の背後にあるロジックが明らかになり、人間の監視により倫理的な整合性と正当性が確保されます。

3. 説明責任

説明責任は透明性と密接に関連しており、AI システムの結果と影響について AI 開発者とユーザーに責任を負わせるメカニズムの確立を含みます。 これには、倫理ガイドラインの導入、監視ツールの使用、および監査の実施が含まれます。 これらの対策により、AI システムが望ましい結果を確実に提供し、意図しない危害を防止し、信頼性を維持できます。

4. プライバシー

プライバシーは個人の個人情報を保護するために非常に重要です。 AI エコシステムには、データ収集の同意を得て、必要なデータのみを収集し、意図された目的にのみ使用することが含まれます。 AI モデルの開発および製造中に個人データを保護するために、差分プライバシーや暗号化技術などのプライバシー保護技術が採用されています。

5. 安全性

開発者は、物理的および非物理的な健康を含む、責任ある AI の安全性を優先する必要があります。 これを達成するには、AI システム開発のあらゆる段階に安全性への考慮を組み込む必要があります。 設計段階では、潜在的なリスクを特定し、理解するために多様な関係者を関与させることが重要です。 AI システムにおける危害を防止し信頼性を維持するには、リスク評価、さまざまな条件下でのテスト、人間による監視、生産中の継続的な監視と改善が不可欠です。

Responsible AI の複数の原則を確認した後、次に進んで、ソリューションの導入に伴う課題を理解しましょう。

責任ある AI ソリューションを導入する際の課題は何ですか?

Responsible AI の導入は、企業にとって大きな利益をもたらす前途有望な取り組みですが、その重要な課題には慎重な検討と積極的な解決策が必要です。 以下で詳しく見てみましょう。

説明可能性と透明性

AI システムは信頼を維持するために、特定の結果を生み出す方法と理由を明確にできなければなりません。 透明性の欠如により、これらのシステムに対する信頼が低下する可能性があります。

個人および公衆の安全

自動運転車やロボットなどの自律システムは、人間の安全にリスクを引き起こす可能性があります。 このような状況において人間の幸福を確保することは極めて重要です。

自動化と人間による制御

AI は生産性を向上させることができますが、人間の関与や専門知識が減少する可能性があります。 人間による制御と監視を確保するためにバランスをとることは困難です。

偏見と差別

AI システムは中立になるように設計されていますが、トレーニング データからバイアスを継承する可能性があり、意図しない差別につながる可能性があります。 このような偏見を防ぐことが重要です。

説明責任と規制

AI 全体の存在感が高まるにつれて、責任と法的責任の問題が生じる可能性があります。 AI システムの使用と誤用について誰が責任を負うのかを判断するのは複雑です。

セキュリティとプライバシー

AI は広範なデータ アクセスを必要とするため、データ プライバシーとセキュリティ侵害に関する懸念がさらに高まる可能性があります。 AI トレーニングに使用されるデータを保護することは、個人のプライバシー全体を保護するために不可欠です。

現在、開発プロセス中に責任ある AI 原則を遵守している評判の良い AI アプリ開発会社 (Appinventiv など) と提携することで、企業が関連する課題やリスクを効果的に軽減できるようになります。

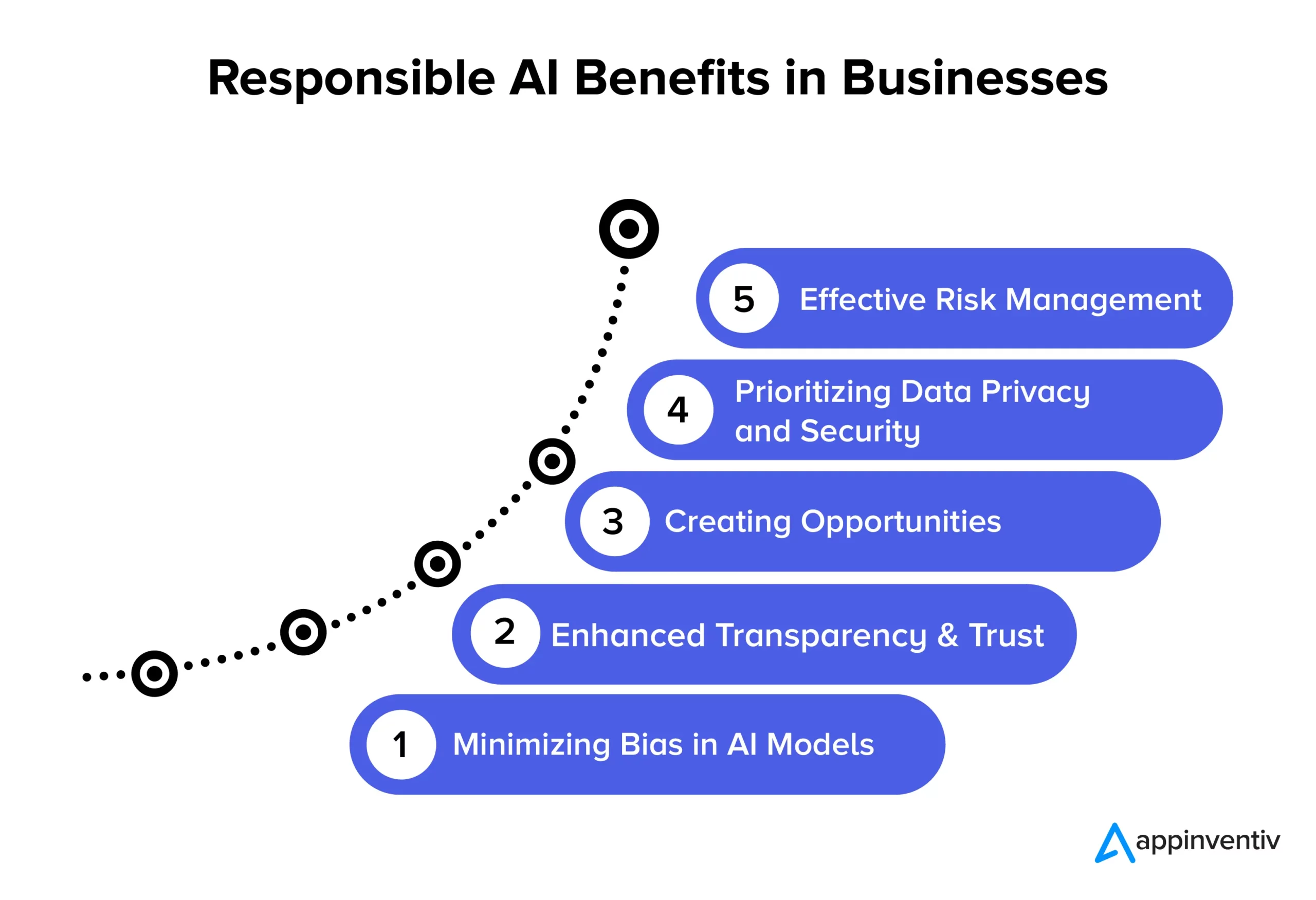

責任ある AI が企業にもたらすメリット

責任ある AI 原則を採用すると、ビジネスと社会にとって複数の重要な利点が得られます。 以下で詳しく見てみましょう。

AI モデルのバイアスを最小限に抑える

責任ある AI 原則に従うことで、企業は AI モデルとそのトレーニングに使用される基礎となるデータのバイアスを効果的に軽減できます。 このバイアスの削減により、AI システムは倫理的に正しく、時間の経過とともにデータが変更されるリスクを軽減する、より正確で公平な結果を提供することが保証されます。 さらに、バイアスを最小限に抑えることで、組織は、バイアスされた AI モデルの結果から生じる可能性のあるユーザーへの潜在的な損害を回避し、評判を高め、責任を軽減することができます。

透明性と信頼性の向上

責任ある AI 実践により、AI モデルの明確さと透明性が高まります。 これは、企業と顧客の間の信頼を強化するのに役立ちます。 さらに、AI はより広範な利用者にとってより利用しやすくなり、より広範囲のアプリケーションを可能にし、AI テクノロジーの効果的な利用を強化することで、組織とエンドユーザーに利益をもたらします。

機会の創出

責任ある AI 原則を遵守することで、開発者とユーザーが AI システムについてオープンに会話できるようになります。 これは、企業において最も求められている責任ある AI の利点の 1 つです。 これにより、人々が AI テクノロジーに関する質問や懸念を表明できるスペースが生まれ、企業がこれらの問題に積極的に取り組むことができるようになります。 AI 開発に対するこの協力的なアプローチにより、倫理的に健全で社会的に責任のある AI ソリューションが作成され、企業の評判と競争力を高めることができます。

データのプライバシーとセキュリティを優先する

責任ある AI ソリューションにより、企業はデータのプライバシーとセキュリティの保護に重点を置くことができます。 これは、個人データや機密データが慎重に扱われ、個人の権利が保護され、データ侵害が防止されることを意味します。 企業が責任ある AI 原則に従うと、データの悪用、規制違反、評判の低下の可能性が減ります。 これはデータを安全に保ち、顧客の信頼を維持するための賢い方法です。

効果的なリスク管理

責任ある AI の実践により、AI システムに明確な倫理的および法的ルールが設定され、有害な結果が生じる可能性を低くすることができます。 このリスク軽減は、企業、従業員、社会などの複数の主体に利益をもたらします。 組織は、起こり得る倫理的および法的問題に対処する際に、多額の費用がかかる訴訟を回避し、評判を傷つけることができます。

責任ある AI 導入の成功例

ここでは、倫理的で偏りのない AI 実践を優先している組織の注目すべき実例をいくつか紹介します。

IBMの信頼できるAI採用ツール

米国の大手企業は、採用プロセスを自動化し、AI を活用した採用プロセスの公平性を優先するために IBM と協力しました。 彼らの目標は、機械学習モデルの完全性を維持しながら、多様性と包括性を促進することでした。 AI の監視および管理ツールである IBM Watson Studio を利用することで、AI の意思決定に関する貴重な洞察を得ると同時に、採用バイアスを特定して対処することに成功しました。

State Farm の責任ある AI フレームワーク

米国トップの保険会社である State Farm は、AI を保険金請求処理プロセスに組み込み、責任ある AI 戦略を導入しました。 彼らは AI に説明責任を割り当てるためのガバナンス システムを構築し、その結果、より迅速でより多くの情報に基づいた意思決定が可能になりました。 State Farm の動的車両評価モデル (DVAM) AI モデルは、総損失を効果的に予測し、保険請求処理に透明性をもたらします。

H&M グループの責任ある AI チームとチェックリスト

世界的なファッション小売業者である H&M グループは、持続可能性を推進し、サプライ チェーンを最適化し、パーソナライズされた顧客エクスペリエンスを向上させるために、自社の業務に AI を統合しました。 同社は、責任ある AI の使用を保証するために、2018 年に専門の責任ある AI チームを設立しました。 このチームは、AI 関連の潜在的な危害を特定して軽減し、責任ある AI 原則を心から遵守する実用的なチェックリストを開発しました。

Google の機械学習における公平性

GoogleはAIや機械学習における公平性対策を盛り込むことにも積極的に取り組んでいる。 彼らは、開発者が機械学習モデルのバイアスを特定して軽減するのに役立つツールとリソースを開発しました。

OpenAIのGPT-3

GPT-3 の背後にある OpenAI は、AI の導入に対して責任あるアプローチをとる重要なリーダーでもあります。 彼らは、有害で偏った結果を回避するための微調整メカニズムを実装しており、高度な NLP モデルであっても、倫理的な AI への取り組みをさらに証明しています。

Appinventiv による責任ある AI の未来

Responsible AI の未来は、テクノロジーとデータの使用に関する倫理的開発のさまざまな段階にある組織とともに進行中の旅です。 これは、さまざまな業界向けの標準化されたガイドラインの確立に焦点を当てたダイナミックな分野です。 ビジネスに責任ある AI 原則を適用するには、Appinventiv と提携することが企業にとって最良の選択です。 私たちは、お客様のニーズに合わせた、倫理的で公平かつ正確な AI ソリューションの作成をお手伝いします。

AI 開発専門会社である当社の開発者は、倫理と責任を優先して AI ソリューションを開発する長年の専門知識を持っています。 数多くの産業分野にわたる AI プロジェクトの成功実績により、当社は AI ソリューションを必要な核心的価値観と倫理原則に適合させることの重要性を理解しています。 AI ベースのビジネス ソリューションが公平な意思決定を行えるようにするための公平性対策の導入を支援します。

当社は最近、手のジェスチャーや音声コマンドで患者と病院の看護師を結び付ける、AI ベースのヘルスケア アプリである YouComm を開発しました。 このソリューションは現在、全米の 5 つ以上の病院チェーンに導入されています。

当社の AI 専門家に連絡して、正確な結果を提供し、倫理基準を遵守する AI ソリューションを構築してください。

よくある質問

Q. 責任ある AI の例にはどのようなものがありますか?

A.複数の産業ドメインにわたる責任ある AI の例をいくつか示します。

- 公平なアルゴリズム: 公平になるように設計された AI システムにより、意思決定のバイアスが軽減されます。

- Explainable AI (XAI): AI の意思決定を理解できるようにします。

- バイアスの軽減: AI のバイアスを継続的に監視し、軽減します。

- AI 倫理委員会: 倫理的な AI に関する社内審査委員会を設立します。

- プライバシー保護 AI: AI に使用する際に機密データを保護します。

- 透明性レポート: AI システムがどのように動作し、意思決定を行うかを共有します。

- 責任ある AI 教育: AI 専門家に倫理と責任についてトレーニングします。

Q. Responsible AI の成功事例にはどのようなものがありますか?

A. Responsible AI の成功事例をいくつか紹介します。

- 医療診断: 公平性と患者のプライバシーを確保しながら医療結果を向上させるために使用されます。

- 金融サービス: 詐欺やマルウェアに関連するリスクを排除できます。 責任ある AI ベースのソリューションにより、顧客データをさらに保護し、公平な融資を保証できます。

- 採用活動: ユーザー間の多様性と機会均等の導入への道を切り開きながら、偏見を軽減するのに役立ちます。

- 自動運転車: 安全性を優先し、倫理基準を遵守するのに役立ちます。

Q. Responsible AI は継続的なプロセスですか、それとも企業は一度実装すれば忘れることができますか?

A.責任ある AI は継続的なプロセスであり、継続的な監視、更新、変化する倫理基準や規制への適応が必要です。 したがって、海域を注意深く横断するのに役立つ専門の AI 開発会社と提携することをお勧めします。