Web スクレイピング テクニック 2023 – 完全ガイド

公開: 2023-07-06オンライン宝探しの広大な世界において、Web スクレイピングは貴重な情報を抽出するための究極のツールとなっています。 あなたが孤独な冒険者であっても、データに飢えた企業であっても、Web スクレイピングはデジタル ツールキットの信頼できるつるはしです。

ただし、すべての Web スクレイピング技術が同じように作成されているわけではありません。 それは目の前の課題に最適な釣り竿を選ぶようなものです。 結局のところ、白鯨のような巨大な生き物を捕まえるために小さな釣り針を持ってくるはずはありませんよね? このブログでは、手動、自動、および高度な Web スクレイピング技術の背後にある秘密を明らかにします。

それぞれが独自の特別な力と弱点を持ったスーパーヒーローのチームを編成することを想像してみてください。 同様に、各スクレイピング手法には長所と限界があります。

ただし、Web スクレイピングにおける責任ある行動の重要性を忘れないでください。 騎士が決して誓いを破らないのと同じように、スクレイピングを倫理的に行い、スクレイピングする Web サイトの利用規約を尊重することが重要です。

自動化された Web スクレイピング技術

自動 Web スクレイピングとは、ソフトウェアまたはツールを使用して Web サイトからデータを自動的に抽出するプロセスを指します。 この自動化されたアプローチにより、データを手動でコピーして貼り付ける必要がなくなり、さまざまなオンライン ソースから効率的かつ大規模なデータ収集が可能になります。

1. Webスクレイピングライブラリ

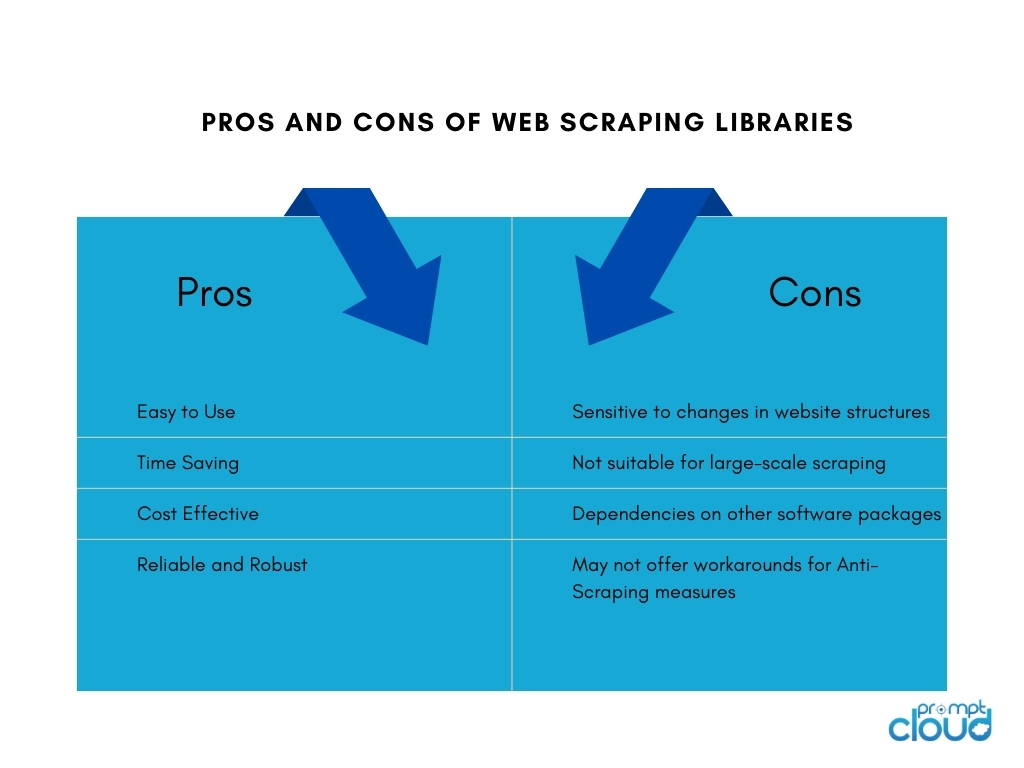

Web スクレイピング ライブラリは、Web スクレイピング タスクを容易にする事前構築された機能とユーティリティを提供するソフトウェア ツールまたはフレームワークです。 これらは、すべてを最初から作成する必要がなく、Web スクレイピングを実行するための簡素化された効率的な方法を提供します。 時間を節約し、生産性を向上させ、さまざまなオンライン ソースからのより効率的なデータ収集を可能にします。

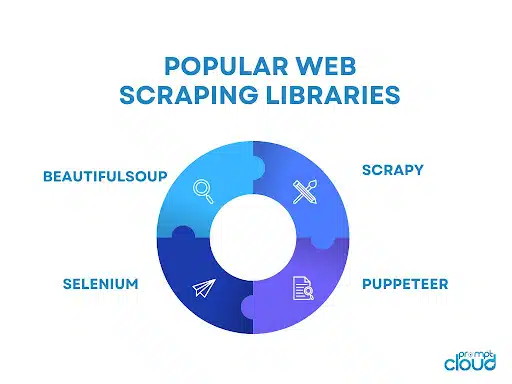

人気のある Web スクレイピング ライブラリには次のようなものがあります。

- BeautifulSoup: Web スクレイピング用に広く使用されている Python ライブラリで、HTML および XML ドキュメントを解析するための直感的な API を提供し、ユーザーが簡単にデータをナビゲートして抽出できるようにします。

- Scrapy: Web スクレイピング用の強力な Python フレームワークで、自動リクエスト スロットル、アイテム パイプライン、ページ分割処理の組み込みサポートなどの機能を備えた、スケーラブルで効率的な Web クローラーを構築するための包括的なツール セットを提供します。

- Selenium: Web スクレイピングのためのブラウザー操作の自動化を可能にする多用途ライブラリ。動的コンテンツや JavaScript を多用する Web サイトを扱う場合に特に役立ちます。

- Puppeteer:ヘッドレス Chrome または Chromium ブラウザを制御する高レベル API を提供する Node.js ライブラリ。これにより、JavaScript を使用した Web スクレイピングと Web ページとの対話が可能になります。

2. Webスクレイピングツールとサービス

Webスクレイピングツール

Web スクレイピング ツールは、Web スクレイピングのプロセスを自動化および簡素化するために特別に設計されたソフトウェア アプリケーションまたはプラットフォームです。 これらのツールは、多くの場合、ユーザーが広範なプログラミング知識を必要とせずに、Web サイトから抽出するデータを指定できるユーザーフレンドリーなインターフェイスを提供します。

通常、ポイント アンド クリックによるデータ要素の選択、スケジュール設定および監視機能、データ エクスポート オプションなどの機能が提供されます。 Web スクレイピング ツールは、大規模なコーディングや開発リソースを必要とせずにデータ抽出を必要とする個人や企業にとって有益です。

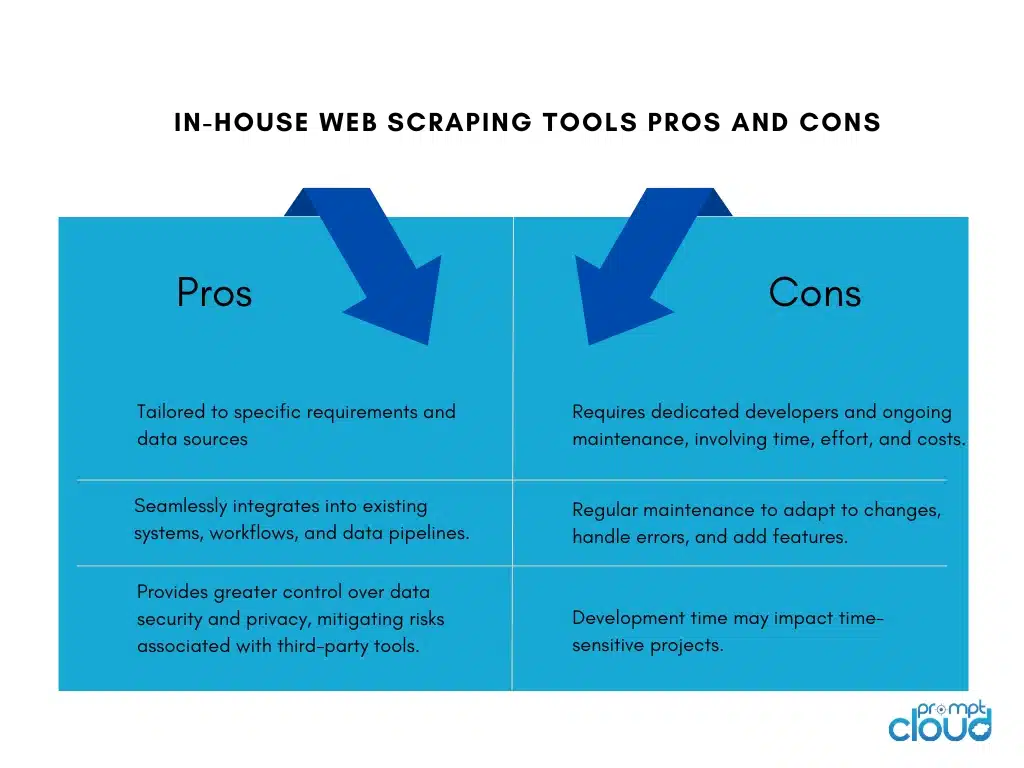

社内 Web スクレイピング ツールの構築

企業向けに社内 Web スクレイピング ツールを構築することには、次のような長所と短所があります。

Webスクレイピングサービス

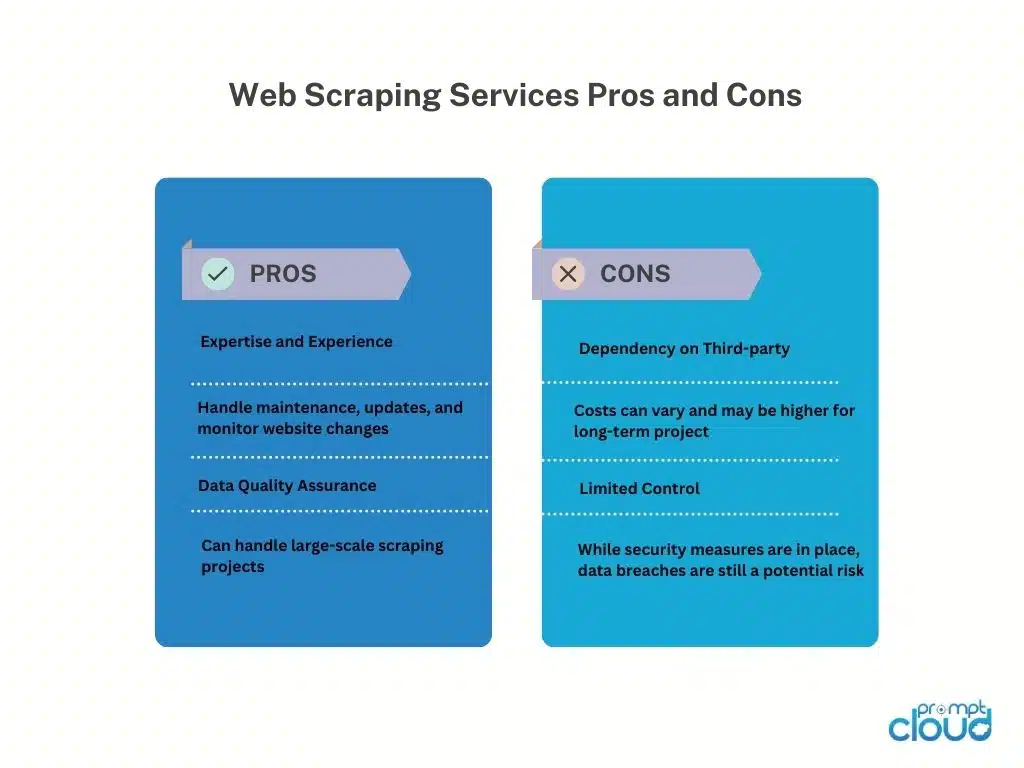

Web スクレイピング サービス プロバイダーは、Web サイトからのデータ抽出に特化したサービスを提供します。 これらのプロバイダーは通常、クライアントに代わって Web スクレイピング タスクを処理するための専用のインフラストラクチャ、ツール、専門知識を備えています。

Web スクレイピング サービス プロバイダーを使用するメリットとデメリットは次のとおりです。

WebスクレイピングAPI

Web スクレイピング API は、開発者が標準化された方法を使用して Web サイトにアクセスし、Web サイトからデータを取得できるようにするプログラム インターフェイスを提供します。 これらの API は、従来のスクレイピング技術と比較して、Web スクレイピングに対してより構造化され制御されたアプローチを提供します。 開発者は、必要なデータを指定して API にリクエストを送信し、スクレイピングされたデータを JSON や XML などの構造化された形式で受け取ることができます。

長所

Web スクレイピング API によりスクレイピング プロセスが簡素化され、開発者は API の統合とデータの処理に集中できるようになります。 プロバイダーのメンテナンスにより信頼性とパフォーマンスが提供され、認証やレート制限などの機能が含まれる場合があります。 API は、サービス利用規約や法的要件への準拠にも役立ちます。

短所

Web スクレイピング API の使用には制限があります。 データの可用性と機能は API プロバイダーによって異なり、サポートされる Web サイトやスクレイピングの制限に制限が生じる可能性があります。 外部 API への依存により、プロバイダーの可用性とパフォーマンスへの依存が生じ、データの取得に影響します。 さらに、大量使用または商用使用に関連する費用が発生する場合があります。

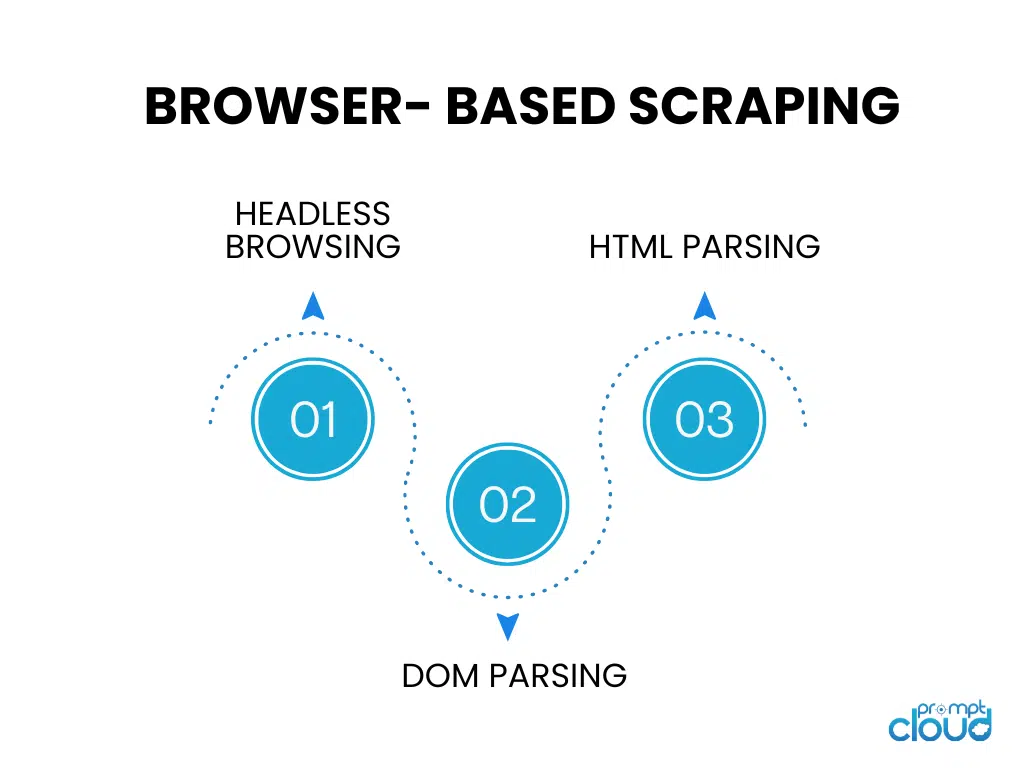

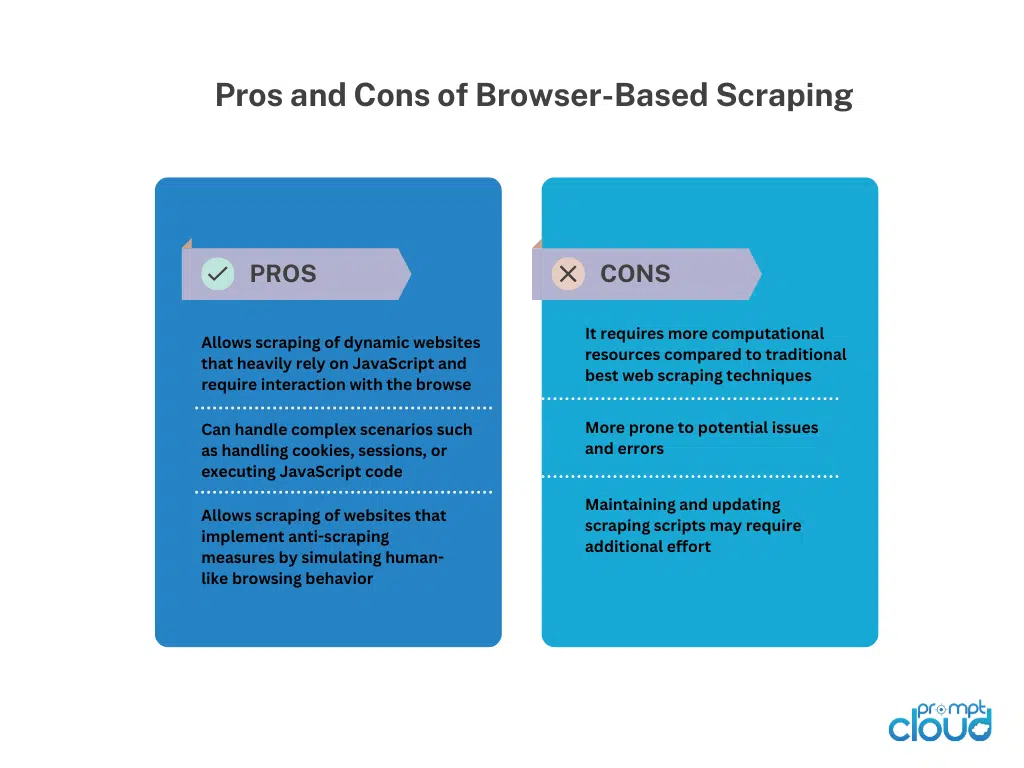

ブラウザベースのスクレイピング

ヘッドレスブラウジング

ヘッドレス ブラウジングでは、グラフィカル ユーザー インターフェイスなしで Web ブラウザが実行され、コードを使用した自動ブラウジングと Web サイトとの対話が可能になります。 クライアント側のレンダリングに大きく依存する動的な Web サイトをスクレイピングするのに最適です。

DOM の解析

DOM 解析には、ドキュメント オブジェクト モデルにアクセスして Web ページの HTML 構造を操作することが含まれます。 これにより、プログラムによる要素、属性、またはテキストのターゲットを絞った抽出が可能になります。

HTMLの解析

HTML 解析では、Web ページの HTML ソース コードを分析して、必要なデータを抽出します。 ライブラリまたはパーサーを使用して HTML 構造を解釈し、データ抽出用の特定のタグ、属性、またはパターンを識別します。 HTML 解析は、JavaScript を実行せずに静的 Web ページをスクレイピングするためによく使用されます。

手動 Web スクレイピング テクニック

手動 Web スクレイピング テクニック

手動 Web スクレイピングとは、自動ツールやスクリプトを使用せずに、Web サイトからデータを手動で抽出するプロセスを指します。 Web サイトの移動、関連情報の検索、さまざまな技術を使用したデータの抽出には人間の介入が必要です。

手動 Web スクレイピングのテクニック:

スクリーン キャプチャ:この手法には、Web ページのスクリーンショットやビデオをキャプチャして、プログラムによる解析が難しい画像、グラフ、表などの視覚データを抽出することが含まれます。キャプチャしたメディアから手動で抽出すると、データを取得できます。

データ入力:データ入力では、必要な情報を Web ページから手動でコピーし、スプレッドシートやデータベースなどの希望の形式に入力します。これには、Web ページをナビゲートし、データを選択し、目的の宛先にデータを入力することが含まれます。 データ入力は、簡単にコピーして貼り付けることができる構造化データに適しています。

手動 Web スクレイピングにより、複雑な Web サイト、JavaScript の対話性、またはスクレイピング対策に柔軟に対応できます。 ただし、時間がかかり、大規模なタスクにはあまり適しておらず、人的ミスが発生しやすいです。 それには人間の努力、細部への注意、慎重な実行が必要です。

ハイブリッド Web スクレイピング技術

ハイブリッド Web スクレイピングは、自動ツールと手動介入を組み合わせて、Web サイトから効率的かつ正確なデータを抽出します。 自動ツールはナビゲーションや構造化データ抽出などの反復的なタスクを処理しますが、画面キャプチャやデータ入力などの手動技術は複雑なシナリオや視覚的/非構造化データに対処します。

ハイブリッド Web スクレイピングは、人間の判断による柔軟性に加えて、自動化のスケーラビリティと速度を提供します。 多様な構造、動的なコンテンツ、またはスクレイピング対策を持つ Web サイトに適しています。 選択は Web サイトの複雑さ、データの種類、利用可能なリソースに応じて行われ、包括的なデータ抽出のためのバランスの取れたアプローチが提供されます。